Maison >Périphériques technologiques >IA >ChiQA - un ensemble de données de questions et réponses illustrées basé sur 200 000 questions d'utilisateurs réels

ChiQA - un ensemble de données de questions et réponses illustrées basé sur 200 000 questions d'utilisateurs réels

- PHPzavant

- 2023-04-12 10:43:021188parcourir

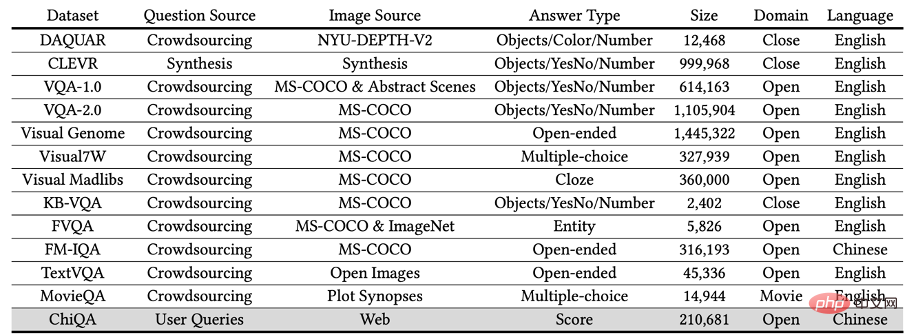

Ces dernières années, avec le développement vigoureux de la technologie de réponse aux questions et de la technologie de compréhension multimodale, la tâche de réponse visuelle aux questions (Visual Question Answering) est devenue de plus en plus populaire. Des ensembles de données de réponses visuelles à des questions à grande échelle tels que VQA, CLEVER et Visual-7W ont été publiés les uns après les autres, ce qui a grandement favorisé le développement itératif de tâches de réponses visuelles à des questions. Cependant, la plupart des données de réponse visuelles actuelles sont des questions synthétisées artificiellement, telles que « De quelle couleur sont ses yeux ? », qui sont fictivement conçues par l'annotateur après avoir vu l'image. Les données générées manuellement seront relativement simples, de mauvaise qualité et même biaisées. Par conséquent, dans ce travail, nous proposons un ensemble de données de questions et réponses d'images à grande échelle basé sur le chinois : ChiQA, basé sur de vraies questions posées par les utilisateurs du navigateur QQ.

ChiQA contient plus de 40 000 requêtes d'utilisateurs réels et plus de 200 000 paires question-image. Les données et certains modèles de base ont été publiés sur GitHub. Des recherches pertinentes ont été acceptées dans le long article du CIKM2022.

Adresse papier : https://arxiv.org/abs/2208.03030

Adresse Github : https://github.com/benywon/ChiQA

Comparaison des singles modalité Tâche de questions et réponses

Trois caractéristiques saillantes de ChiQA

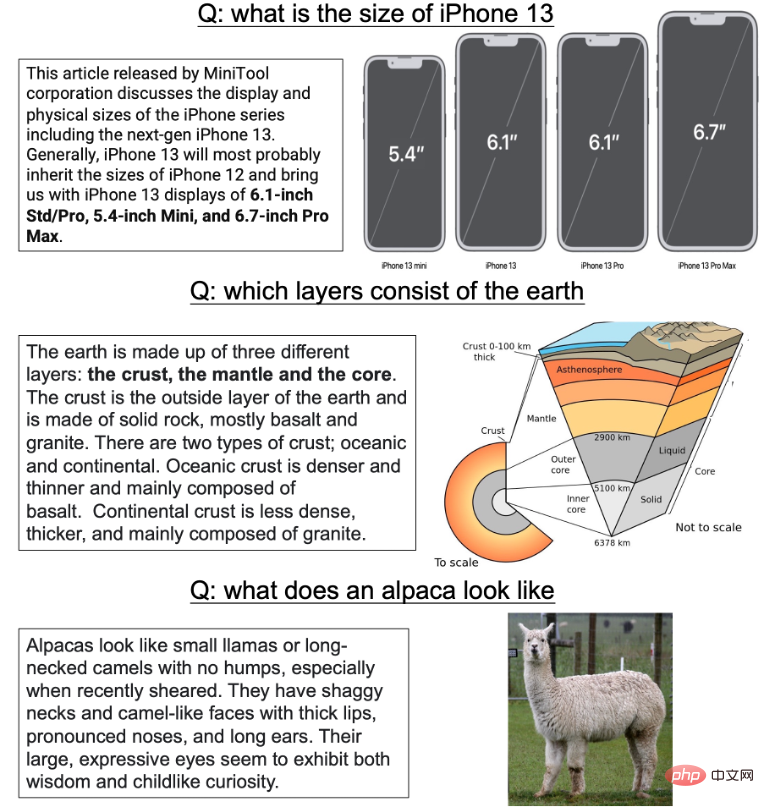

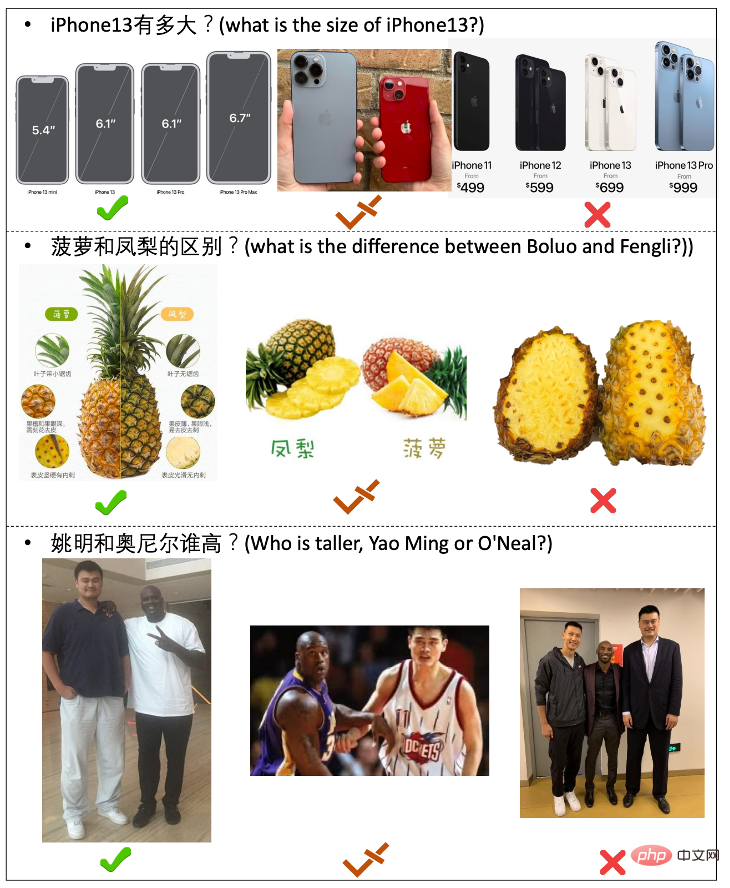

La réponse aux questions est l'une des tâches très importantes de l'intelligence artificielle et du traitement intelligent du langage. Ces dernières années, avec la publication d'ensembles de données à grande échelle (tels que SQuAD, NaturalQuestions) et l'introduction de modèles linguistiques pré-entraînés à grande échelle (tels que BERT, GPT), les tâches de questions et réponses se sont développées rapidement. Cependant, la plupart des tâches actuelles de réponse aux questions sont unimodales, c'est-à-dire que les questions, les ressources et les réponses sont toutes basées sur du texte. Cependant, du point de vue de l’intelligence cognitive et des applications pratiques, les ressources multimodales telles que les images peuvent souvent fournir des informations et des réponses plus riches. Par exemple, pour une question : Quelles sont les dimensions de l’iPhone13 ? Un tableau comparatif des tailles pour différents modèles d’iPhone 13 sera plus clair et intuitif. Il existe également quelques exemples, comme le montre la figure ci-dessous :

Figure 1 : Quelques exemples adaptés à l'utilisation d'images pour répondre aux questions des utilisateurs

Ces dernières années, des données de questions et réponses et des tâches pour plusieurs -La compréhension modale a été successivement développée proposer. Tels que VQA1.0 et 2.0, CLEVR, GQA, etc. Dans la plupart des ensembles de données de questions et réponses d'images, le système fournit des images générées artificiellement ou réelles aux annotateurs, et les annotateurs doivent rédiger manuellement certaines questions ciblant des attributs ou des entités spécifiques. Cependant, ce processus de collecte de données présente inévitablement de nombreux défauts :

1) Toutes les questions dépendent de l'image, c'est-à-dire que l'annotateur pose des questions après avoir vu l'image. Dans le processus de construction de données à grande échelle, les questions générées artificiellement manquent souvent de diversité et sont souvent biaisées en raison des facteurs subjectifs des annotateurs. Les modèles formés sur ce type de données qui examinent d'abord les ressources puis posent des questions peuvent souvent facilement obtenir de très bons résultats en examinant les questions sans examiner les ressources d'arrière-plan

2) Deuxièmement, dans les données VQA traditionnelles, le La réponse est souvent une simple entité, une relation ou une simple description d'un domaine spécifique. Cependant, pour les tâches de questions et réponses sur les images, de nombreuses réponses textuelles sont inutiles. Par exemple, pour la question : « À quoi ressemble un alpaga ? », il est très redondant de fournir une longue réponse décrivant l’apparence d’un alpaga. Deuxièmement, ce type de description courte de l'entité amène souvent les annotateurs à ne prêter attention qu'aux relations locales et à accorder peu d'attention à certaines informations sur la structure globale réelle

3) Enfin, la plupart des ressources précédentes ont tendance à se concentrer sur l'anglais. très peu de données de questions et réponses d’images dans le domaine chinois.

Dans ce travail, en réponse aux problèmes ci-dessus, nous proposons un ensemble de données de réponse aux questions d'images chinoises à grande échelle - ChiQA (Chinese Image Question Answering). Nous avons commencé avec les termes de recherche réels de l'utilisateur dans le navigateur QQ mobile, récupéré plusieurs images associées via une API spécifique, puis transmis les images à des annotateurs professionnellement formés pour une annotation à trois niveaux afin d'indiquer si l'image peut répondre parfaitement à la question ( 2 points ), partiellement répondu (1 point) et incapable de répondre (0 point) à la question de l'utilisateur. Pour ChiQA, il existe trois fonctionnalités notables :

- De vraies questions, de vraies images : les images dans ChiQA proviennent de requêtes aléatoires d'utilisateurs. Ces requêtes sont des requêtes utilisateur aléatoires dans le domaine ouvert. Ces requêtes sont très diverses et la répartition des domaines des requêtes est très large. Une telle requête de diversité aléatoire garantit que les questions contenues dans nos données ne seront pas biaisées ;

- Réponse : pour les tâches de questions et réponses, la capacité de répondre est un aspect très important. Dans ChiQA, nous n’exigeons pas que l’annotateur donne la réponse finale : cela introduit souvent des biais supplémentaires, comme le bon sens de l’annotateur. Au lieu de cela, nous nous concentrons sur la capacité de répondre, c'est-à-dire si l'image peut répondre à la question. Cette capacité de réponse permet aux annotateurs ChiQA de comprendre à la fois la requête et l'image ;

- Impartial : car il existe également la loi de 28 dans les requêtes aléatoires, c'est-à-dire que certaines questions à haute fréquence ou uniques ont tendance à apparaître. Plusieurs fois, des problèmes avec ce modèle simple dominera les données, créant un biais vers une véritable compréhension intermodale des données. Par conséquent, nous avons introduit un processus d'apprentissage actif en deux étapes dans le processus de collecte de données.Une fois l'annotation de requête aléatoire terminée dans la première étape, nous avons formé un modèle simple, puis utilisé ce modèle pour sélectionner des modèles « plus difficiles », créant ainsi la richesse et la difficulté des données dans les données d'annotation de deuxième étape sont relativement plus élevées.

Figure 2 : Comparaison entre ChiQA et d'autres données de questions et réponses sur les images dans l'industrie

Au final, nous avons collecté plus de 40 000 questions, chaque question comporte environ 5 images associées , C'est-à-dire que le nombre total de questions dépasse 200 000 paires d'images. Chaque question comporte plusieurs images et nous notons chaque image sur une échelle en trois étapes de 2-1-0.

Quelques exemples dans ChiQA sont présentés dans la figure ci-dessous :

Figure 3 : Exemples de quelques échantillons dans ChiQA.

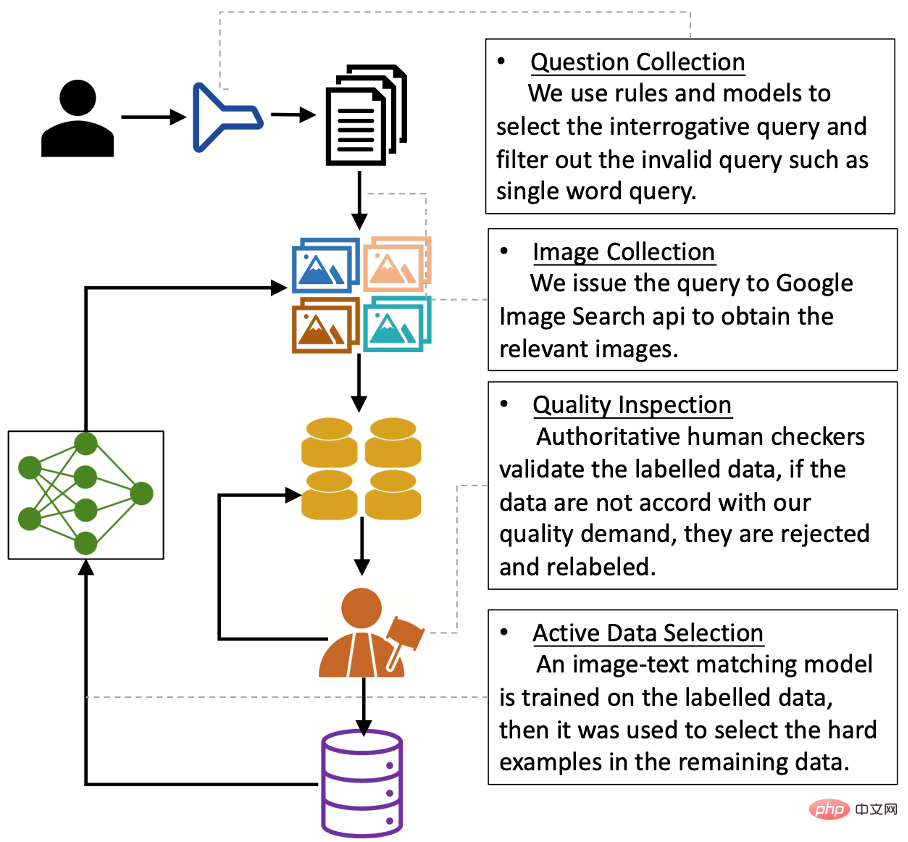

Collecte de données : toutes les questions proviennent de requêtes d'utilisateurs réels

L'ensemble du processus de collecte de données peut être divisé en quatre étapes. L'organigramme global est le suivant :

Figure. 4 : Processus de collecte de données

Une caractéristique majeure de ChiQA est que toutes les questions proviennent de requêtes d'utilisateurs réels. Cependant, si nous échantillonnons de manière aléatoire les requêtes des utilisateurs à partir des journaux de recherche des utilisateurs des moteurs de recherche, la plupart des requêtes n'ont aucune intention de question-réponse.

Nous devons donc d'abord filtrer les requêtes avec une intention de question et de réponse. Dans ce travail, nous utilisons une méthode de supervision faible construite en interne pour entraîner un classificateur binaire afin de déterminer si une requête a une intention de réponse à des questions. L'évaluation humaine de ce modèle d'intention a permis d'atteindre une précision de 90 % et un rappel de 80 %. Nous avons utilisé ce modèle pour échantillonner les requêtes des utilisateurs et obtenu environ 75 000 requêtes d'utilisateurs qui ont été jugées par le modèle comme ayant des intentions de questions-réponses et sont entrées dans le tour suivant.

Processus et expérience de collecte et d'annotation d'images

Après avoir reçu les questions, nous envoyons ces questions à l'API ouverte fournie par Google (API Google Images - SerpApi) pour la récupération d'images associées. L'API Google renvoie les 100 images les plus pertinentes pour chaque requête. Afin de garantir la qualité des données finales, nous avons supprimé les requêtes dont la longueur ou la largeur était inférieure à 200 pixels et les images trop longues ou trop larges.

Après avoir obtenu l'image originale, nous prenons les 5 premières images filtrées et demandons à l'annotateur d'annoter cette requête et les 5 images correspondantes. Nous avons conçu une interface d'annotation spécifiquement pour cette tâche, comme le montre la figure ci-dessous.

Figure 5 : Interface d'annotation ChiQA

Pendant le processus d'annotation, nous demandons aux annotateurs de marquer trois aspects :

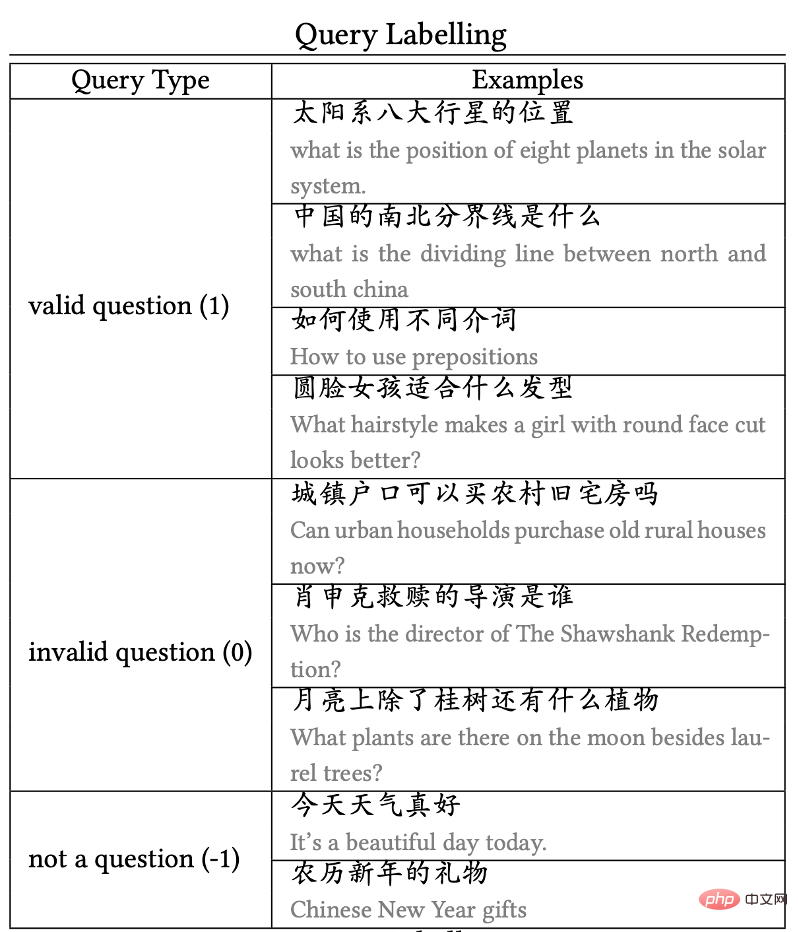

1) Annotation des questions

Merci à Ben The le travail se concentre principalement sur les questions et réponses en images, mais en fait, de nombreuses questions courantes des utilisateurs n'ont rien à voir avec les questions et réponses en images (ou sont difficiles à répondre avec des images). Par conséquent, nous demandons d’abord à l’annotateur d’indiquer si cette question peut être considérée comme une question et une question à réponse d’image. Par exemple :

Si une question est "la différence entre xxx et xxx", alors cette question sera considérée comme une question avec une intention de question et de réponse image

Si une question est vague, ambiguë ou contient S'il y a ; S'il n'y a pas de faits basés sur le point de vue déduit, alors cette question sera classée comme n'ayant aucune intention de question et de réponse d'image et ne participera pas au processus d'annotation d'image ultérieur.

Quelques exemples d'annotation de requête sont présentés dans la Figure 6 :

Figure 6 : Exemples d'annotation de requête

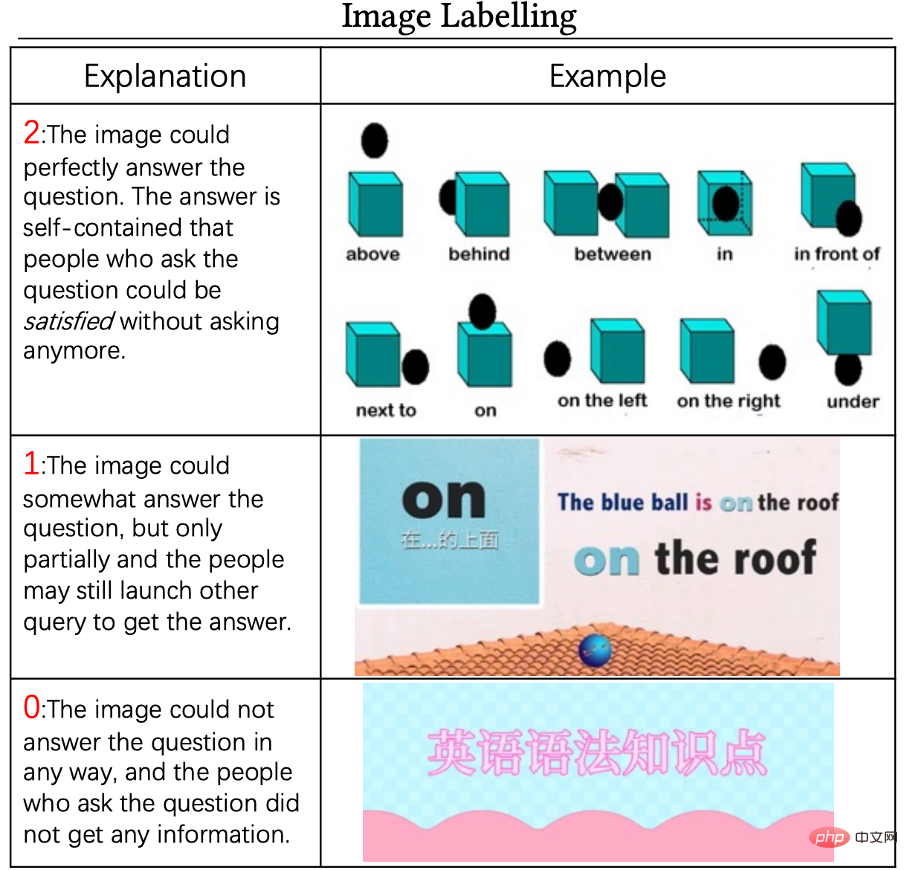

2) Annotation d'image

pour Valable dans le précédent requête étape, nous étiquetons ses cinq requêtes candidates. La norme d'annotation est une annotation à trois niveaux 0-1-2, dans laquelle :

Un score de 0 signifie que l'image ne peut pas du tout être utilisée pour répondre à cette question, et un score de 2 signifie que l'image est de haute qualité et peut répondre à cette question en toute indépendance. L'image avec un score de 1 se situe quelque part entre les deux, ce qui signifie que l'image est liée à la requête, mais qu'on ne peut pas y répondre directement. L'utilisateur peut avoir besoin de plus de requêtes ou de raisonnements pour obtenir la réponse finale. Quelques exemples de 0 point, 1 point et 2 points sont présentés ci-dessous :

Figure 7 : Pour la question "Comment utiliser différentes prépositions", exemples d'annotation et de notation d'image

3) Contrôle qualité

Nous adoptons un système de contrôle qualité strict tout au long du processus d'étiquetage. Plus précisément, nous inviterons d'abord 3 équipes qualité à effectuer un essai d'annotation et sélectionnerons l'équipe avec la meilleure qualité d'annotation pour annoter toutes les données restantes. Deuxièmement, au cours du processus d'annotation, nous diviserons les données annotées en lots. Pour chaque lot de données, nous échantillonnerons un cinquième des données pour une vérification manuelle. Si le taux de réussite des données est inférieur à 90 %, alors ceci. lot Les données seront renvoyées et ré-étiquetées jusqu'à ce que l'exactitude des données atteigne 90 %.

L'annotation des données d'apprentissage actif

rend les résultats plus impartiaux

Après le travail de collecte de données, nous avons constaté que si les données sont échantillonnées et annotées au hasard, il y aura souvent des modèles simples dans les données, et il y a un grand nombre de la présence de modèles aussi simples dans les données peut biaiser le modèle final. Par conséquent, nous concevons un processus d’annotation d’apprentissage actif. Plus précisément, nous demanderons d'abord aux annotateurs d'annoter un lot de données. Une fois l'annotation de ce lot de données terminée, nous utiliserons ce lot de données pour former un modèle de correspondance transmembranaire texte-image. Une fois le modèle entraîné, nous commençons à utiliser ce modèle pour « sélectionner » de nouveaux échantillons : si le modèle est très incertain quant à la prédiction de ce nouvel échantillon (c'est-à-dire que l'entropie de la prédiction de classification finale est particulièrement grande), alors nous Je pense que cet échantillon est relativement difficile pour le modèle. Par conséquent, il y a une plus grande probabilité de le conserver jusqu'au milieu du prochain tour. Sinon, cela signifie que le modèle est très confiant dans les données, donc le modèle les conservera avec un. probabilité plus faible jusqu'au prochain tour.

Nous avons constaté que le processus de sélection active des données d'apprentissage rend effectivement l'ensemble de données plus impartial. Nous avons constaté que les données étiquetées de la première étape contenaient des biais imperceptibles. Par exemple, les questions contenant le mot « Conseils » sont marquées comme des questions valides, mais presque toutes les images correspondantes sont marquées comme sans réponse (c'est-à-dire 0 point). Par conséquent, le modèle est susceptible de prédire la question finale directement sur la base des questions du message. requête sans regarder le résultat de l’image. Ce processus d’apprentissage actif réduit la possibilité que ce raccourci à haute confiance et biaisé soit difficile à sélectionner lors du prochain tour, réduisant ainsi l’impact de ce modèle.

Annotation de l'ensemble de tests

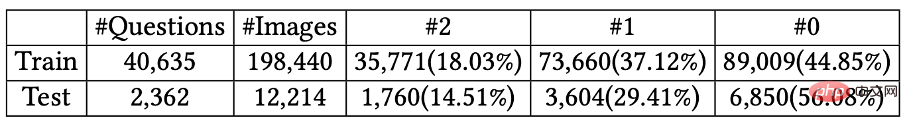

Nous avons filtré au hasard 2 500 éléments de données des données annotées et avons demandé à différents annotateurs de les ré-annoter. Si le résultat de l'annotation est le même que le résultat précédent, les données sont conservées comme ensemble de test. S'il est différent, nous demandons à un "expert" qui connaît très bien la tâche de ré-annoter les données, et finalement d'obtenir 2362 tests. données et plus de 40 000 données de formation. Les informations statistiques de l'ensemble d'entraînement et de l'ensemble de test sont présentées dans la figure ci-dessous :

Figure 8 : Les informations statistiques de l'ensemble d'entraînement et de l'ensemble de test dans ChiQA

Inférence et analyse de les données

Une fois les données annotées Après cela, nous avons effectué des statistiques et des analyses sur les données dans ChiQA.

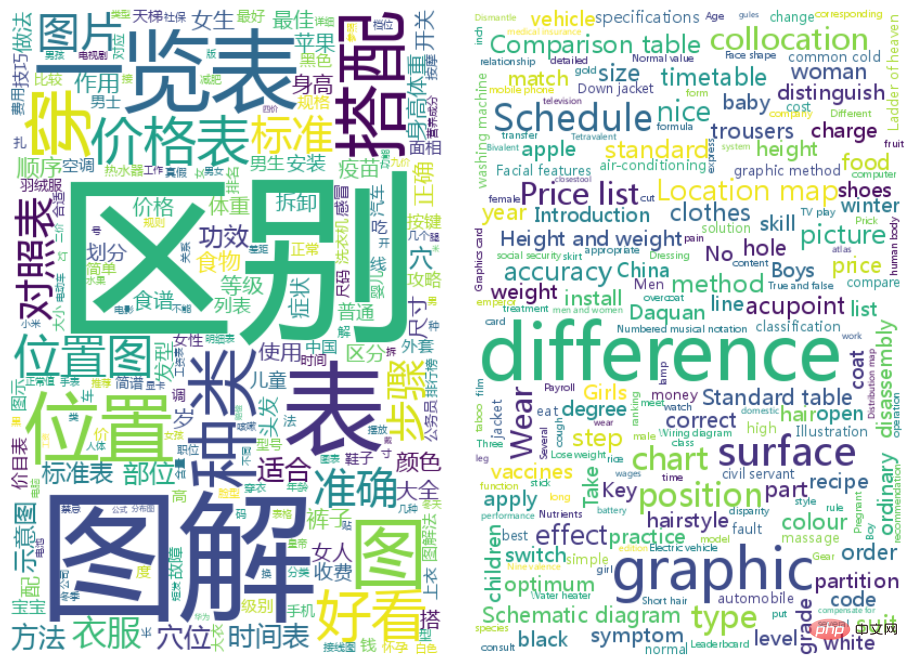

1) Analyse des mots courants de la requête :

Nous utilisons la segmentation des mots bégayants pour segmenter la requête et affichons les mots de la requête sur le graphique nuageux ci-dessous en fonction de la fréquence :

Vous pouvez voir que les requêtes les plus courantes dans ChiQA sont la différence, l'illustration, l'emplacement, etc. Cela est conforme à notre intuition, car ces mots sont en effet des questions très appropriées auxquelles des images peuvent répondre.

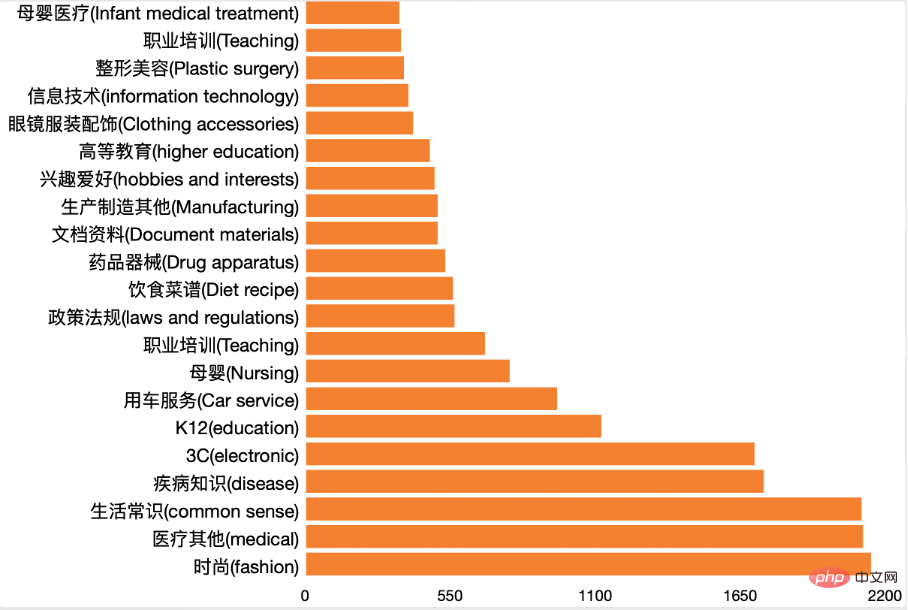

2) Analyse de domaine

Nous utilisons un classificateur de classification de domaine interne pour classer toutes les requêtes. Le résultat final est comme indiqué dans la figure ci-dessous :

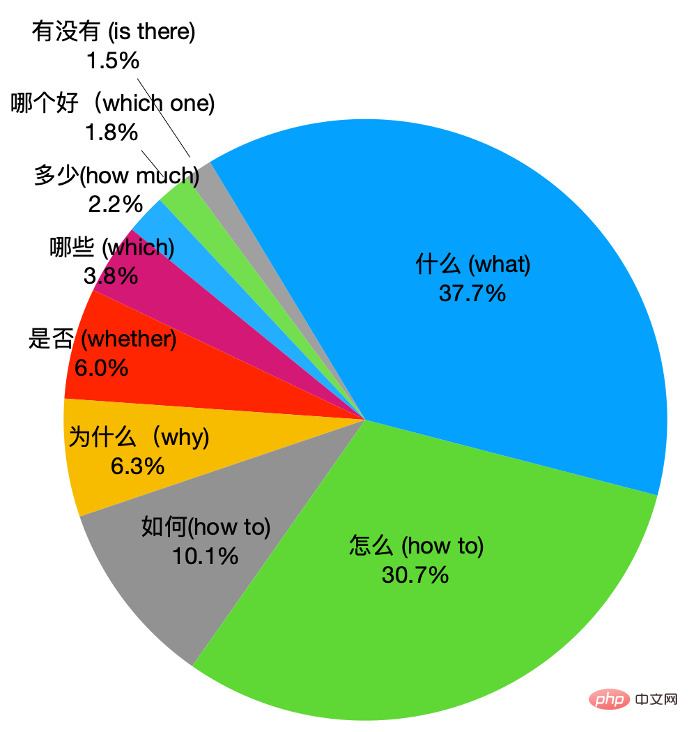

Vous pouvez voir que nos données contiennent. des données provenant de nombreux domaines, et aucun domaine n’a la majorité absolue. Cela garantit que notre distribution de données est uniforme. Deuxièmement, nous avons également compté les mots interrogatifs dans les questions, et les résultats sont comme le montre la figure ci-dessous :

On peut voir que dans ChiQA, quel type et comment taper les questions représente la majorité, et quelques autres questions ont également de grandes proportions.

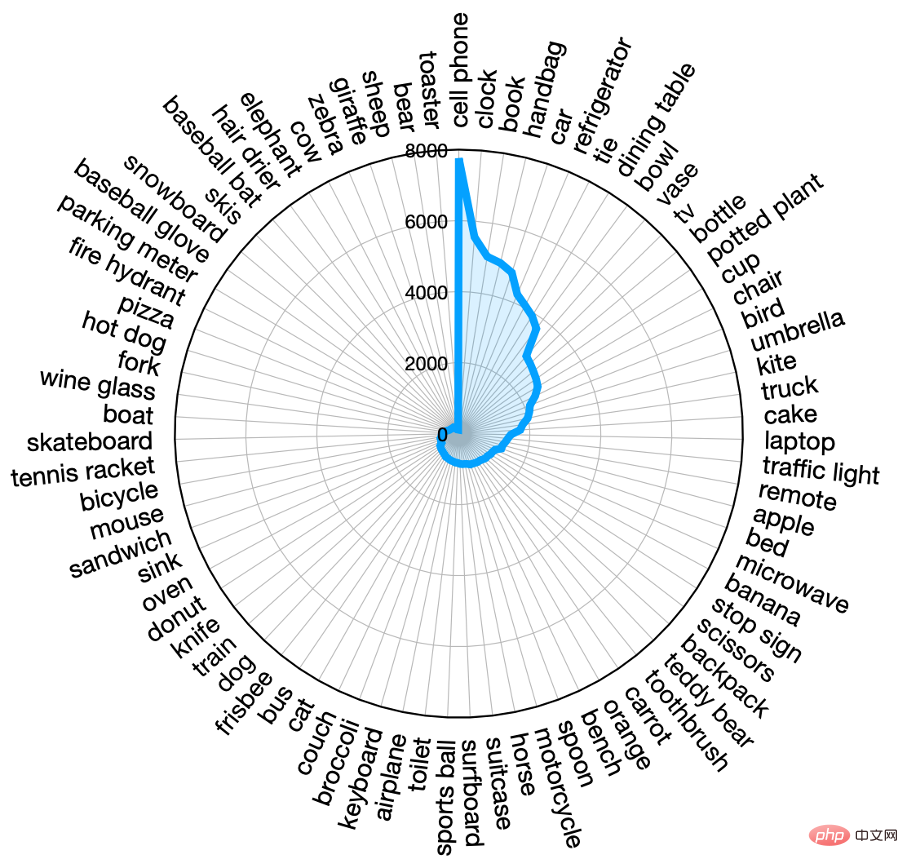

3) Analyse d'images

En plus des questions, nous avons également effectué une analyse des images dans ChiQA. Étant donné que la plupart des images sont indépendantes de la langue, nous utilisons un modèle de détection de cible DETR reconnu comme ayant d'excellentes performances dans l'industrie pour extraire les entités de l'image. DETR peut mapper des entités de l'image vers des entités définies par la norme MS-COCO, telles que « personne », « chien », etc. Nous extrayons des entités pour chaque image dans ChiQA et affichons la distribution des entités les plus fréquentes dans la figure ci-dessous :

On peut voir que plus de 30 entités apparaissent au moins 1000 fois dans ChiQA, ce qui montre que ChiQA est une donnée image très uniformément répartie et couvrant la plupart des domaines. Les entités qui apparaissent le plus souvent sont les « personnes », les « téléphones portables », les « voitures », etc. Ceci est similaire à la répartition des questions.

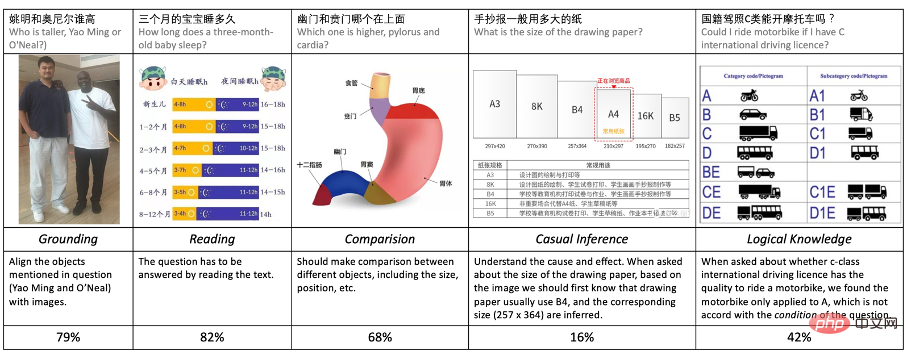

4) Compétences de raisonnement

Afin de mieux analyser les données, nous avons également analysé les compétences de raisonnement requises dans les données ChiQA. Axé sur l'analyse de 5 compétences qui nécessitent un raisonnement :

- Grouding : Des modèles et des systèmes sont nécessaires pour comprendre et localiser les entités mentionnées dans la question

- Lecture : Des modèles sont nécessaires pour comprendre le texte qui apparaît dans l'image

- Comparaison : le modèle doit comparer différents attributs et contenus, tels que la taille, la taille, etc.

- Raisonnement causal : le modèle doit avoir une compréhension approfondie du problème et de la partie causale de l'image ( c'est-à-dire la raison pour laquelle quelque chose s'est produit ou le résultat)

- Raisonnement logique : le modèle doit comprendre certains facteurs de comparaison logiques dans la question ou l'image, tels que la négation, les conditions, etc.

Nous avons échantillonné au hasard 200 éléments de données ChiQA et les étiquetés selon les 5 normes ci-dessus, parmi lesquelles certaines données peuvent nécessiter plus d'une compétence de raisonnement. Le résultat est présenté ci-dessous.

On peut constater qu'en plus du Grouding, plus de 80 % des données ChiQA nécessitent une compréhension approfondie des relations entre le texte et les contrastes dans les images. Ceci est très différent de la plupart des données VQA précédentes. Deuxièmement, de nombreuses questions nécessitent de la logique et des comparaisons, ce qui indique que les données de ChiQA sont assez difficiles. Nous pensons que l’analyse des capacités de raisonnement dans ChiQA peut nous aider à mieux comprendre ces données et fournir des conseils a priori pour la conception ultérieure du modèle.

Indicateurs d'évaluation expérimentale

Dans l'ensemble de données ChiQA, le score d'annotation a trois niveaux : 0, 1, 2, donc dans l'expérience, nous testons les indicateurs de classement du modèle et les indicateurs de classification générale. Divisé en trois catégories :

- NDCG@N : Gain cumulatif actualisé normalisé

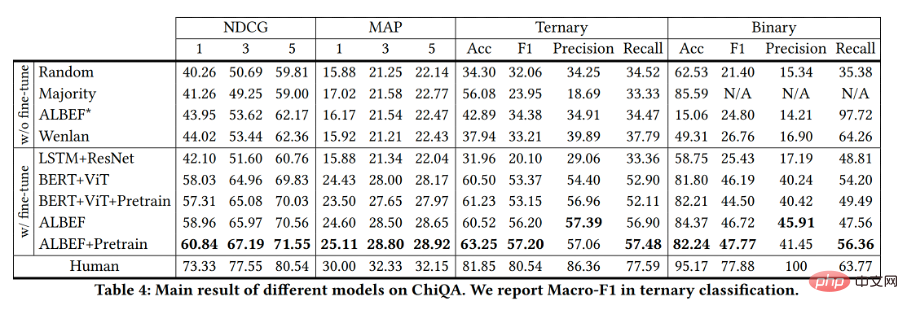

- Nous avons expérimenté plusieurs modèles couramment utilisés sur l'ensemble de données ChiQA. Suite au travail précédent de correspondance image-texte, nous encodons d'abord l'image et le texte à l'aide d'encodeurs respectivement, puis effectuons une fusion intermodale de leurs représentations, et enfin utilisons une couche de prédiction pour obtenir le score de correspondance. Dans les modèles répertoriés ci-dessous, l'ajout de ♣ signifie que le modèle a été pré-entraîné, et l'ajout de ♦ signifie qu'il n'a pas été pré-entraîné.

-

- Aléatoire♦ : Pour chaque élément de données de l'ensemble de test, sélectionnez au hasard un score de prédiction parmi 0, 1 et 2. Le modèle aléatoire est utilisé comme modèle de base sur ChiQA.

- Majorité♦ : sélectionnez l'étiquette qui apparaît le plus dans l'ensemble d'entraînement comme score de prédiction de toutes les données de l'ensemble de test.

- LSTM+ResNet♦ : Avant l'émergence de modèles pré-entraînés à grande échelle pour le texte et la vision, LSTM et ResNet étaient respectivement l'un des modèles les plus couramment utilisés dans les domaines du texte et de la vision.

- Bert+ViT♣ : Nous utilisons le modèle Bert pour encoder le texte de la requête et le modèle ViT pour encoder les images, où les modèles Bert et ViT sont pré-entraînés sur des données non supervisées à grande échelle. Enfin, le vecteur de représentation de est utilisé pour faire correspondre la prédiction du score.

- ALBEF♣ : ALBEF est un apprentissage de représentation visuelle et linguistique à grande échelle qui a démontré de grandes améliorations sur diverses tâches de langage visuel.

- +Pretrain♣ : Pour la pré-formation intermodale chinoise, nous effectuons une pré-formation sur l'état trans-membranaire sur Bert-ViT et ALBEF sur l'ensemble de données Wukong. La méthode de pré-formation est similaire à ALBEF. L'ensemble de données Wukong est une donnée multimodale open source contenant 100 millions de paires image-texte.

- Wenlan♣ : Wenlan est un modèle pré-entraîné multimodal à grande échelle formé sur 30 millions de paires texte-image avec près d'un milliard de paramètres. Nous utilisons leur service API public pour obtenir les vecteurs de représentation du texte et des images, et utilisons la similarité CoS des deux vecteurs comme score de correspondance prédit.

- Humain : en plus des modèles ci-dessus, nous évaluons également le niveau de prédiction des humains sur l'ensemble de test. En raison de la grande quantité de données dans l'ensemble de test, nous avons échantillonné manuellement 100 éléments de données de manière aléatoire pour la prédiction et l'évaluation des indicateurs de prédiction.

Voici l'affichage des résultats :

Les indicateurs du modèle ci-dessus sur l'ensemble de test sont illustrés dans la figure. Nous pouvons constater que l’application directe des précédentes méthodes multimodales de pointe fonctionne mal, avec des métriques à peine meilleures que celles des modèles de notation aléatoire. Cela signifie que les données ChiQA sont difficiles et que les modèles qui utilisent uniquement un apprentissage contrastif faiblement supervisé à grande échelle, comme ALBEF*, Wenlan, peuvent ne pas être en mesure de distinguer les informations fines requises pour répondre visuellement aux questions. En outre, les mauvaises performances de ces modèles illustrent que l'ensemble de données ChiQA est différent des précédentes données de correspondance image-texte faiblement supervisées, car la correspondance image-texte faiblement supervisée se concentre sur la corrélation, tandis que les données ChiQA nécessitent également la responsabilité des images.

Enfin, le modèle affiné sur ChiQA a fait de grands progrès par rapport à la ligne de base, mais est encore loin de la performance humaine, le modèle a donc encore beaucoup de marge d'amélioration sur l'ensemble de données ChiQA.

Application de ChiQA dans les produits

Avec le développement d'Internet, les utilisateurs ont des exigences plus élevées en matière de questions et de réponses, et le système doit fournir des réponses plus intuitives et plus pratiques. Ces dernières années en particulier, le contenu multimédia est devenu de plus en plus abondant et de plus en plus de contenus de questions-réponses basés sur des images et des vidéos sont apparus devant le public. L'équipe QQ Browser Lab Lizhi a été la première du secteur à lancer un projet de questions et réponses en images en avril de cette année. Par exemple, si un utilisateur recherche la différence entre le kiwi et le kiwi, les résultats seront affichés intuitivement devant. de l'utilisateur sous forme d'images. Comme le montre l'image ci-dessous :

Actuellement, ce genre de problème qui peut être directement résolu par des images a obtenu de bons résultats après sa mise en ligne. Nous avons observé que le comportement de ses utilisateurs (tel que le CTR, le taux de change de mots, etc.) a été considérablement amélioré par rapport aux résultats traditionnels, ce qui indique que les « nouvelles questions et réponses » actuelles basées sur des images, etc., sont une entreprise de produits qui peut mieux répondre aux besoins des utilisateurs.

Présentation de l'équipe des auteurs

L'équipe du QQ Browser Search Technology Center est l'équipe responsable de la recherche et du développement des technologies de recherche de la plate-forme d'information et de la gamme de services Tencent PCG. S'appuyant sur l'écologie du contenu Tencent, elle stimule l'innovation des produits grâce à la recherche sur les utilisateurs, en fournissant aux utilisateurs des graphiques, des informations, des romans, des vidéos longues et courtes, des services et d'autres besoins d'information à multiples facettes sont satisfaits. En termes d'algorithmes, basés sur le traitement du langage naturel, l'apprentissage en profondeur, la compréhension et la génération multimodales, le calcul et l'application des connaissances et d'autres technologies, nous construisons la compréhension, la corrélation et le tri du contenu, la recherche multimodale, les questions et réponses intelligentes, le multi- traduction linguistique, recherche recommandée et autres orientations techniques, explorer et appliquer les technologies avancées de l'industrie pour créer une meilleure expérience de recherche utilisateur en termes d'ingénierie, construire un système industrialisé de stade intermédiaire pour la technologie de recherche et peaufiner une haute performance et une haute disponibilité ; , un système de récupération de dizaines de milliards à faible coût pour fournir à Tencent PCG fournit des services de moteur de recherche de base pour les scénarios de recherche de diverses entreprises de contenu. Il prend actuellement en charge plusieurs gammes de produits PCG telles que QQ Browser, Tencent Video, Tencent News et Tencent. Weishi.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI