Maison >Périphériques technologiques >IA >Idéalement formé le plus grand ViT de l'histoire ? Google met à niveau le modèle de langage visuel PaLI : prend en charge plus de 100 langues

Idéalement formé le plus grand ViT de l'histoire ? Google met à niveau le modèle de langage visuel PaLI : prend en charge plus de 100 langues

- 王林avant

- 2023-04-12 09:31:061491parcourir

Les progrès du traitement du langage naturel ces dernières années proviennent en grande partie de modèles linguistiques à grande échelle. Chaque nouveau modèle publié poussera la quantité de paramètres et de données d'entraînement vers de nouveaux sommets, et améliorera également les classements de référence existants. !

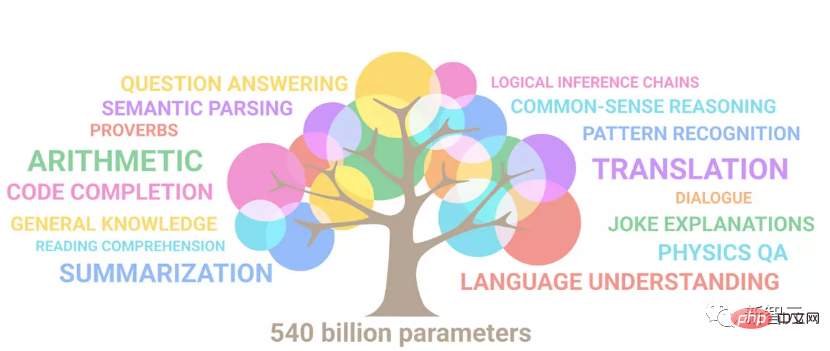

Par exempleEn avril de cette année, Google a publié le modèle de langage de 540 milliards de paramètres PaLM (Pathways Language Model), qui a surpassé avec succès les humains dans une série de tests de langage et de raisonnement, en particulier dans les quelques- shot Les excellentes performances dans l'exemple de scénario d'apprentissage font également de PaLM la direction de développement du modèle de langage de nouvelle génération.

De la même manière, le modèle de langage visuelen faitfonctionne également à merveille, et les performances peuvent être améliorées en augmentant l'échelle du modèle.

Bien sûr, si n'est qu'un modèle de langage visuel pour le multitâche , il n'est évidemment pas très universel, et il doit prendre en charge l'entrée et la sortie dans plusieurs langues .

Récemment, Google a mis à niveau l'extension PaLM vers PALI (Pathways Language and Image model), qui possède à la fois des capacités de compréhension multilingue et d'image et prend en charge plus de 100 langues pour effectuer diverses opérations cross-visuelles, langage et applications multimodales d'images et de langage, telles que la réponse visuelle aux questions, la légende d'image, la détection d'objets, la classification d'images, l'OCR, le raisonnement textuel, etc.

Lien papier : https://arxiv.org/abs/2209.06794

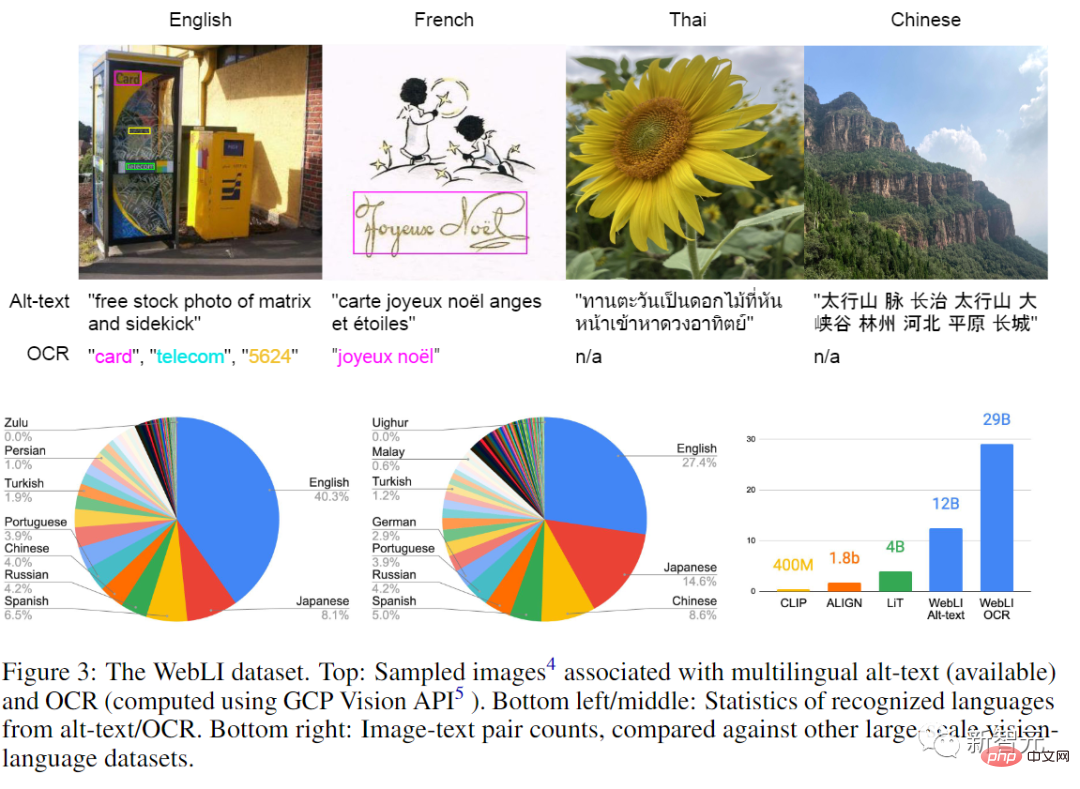

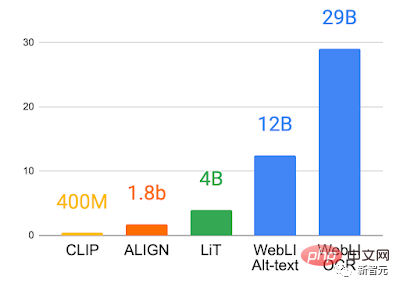

Le modèle est entraîné à l'aide d'une collection d'images publique, qui comprend 109 images automatiquement explorées. L'annotation du langage est également appelé WebLIdataset dans cet article.

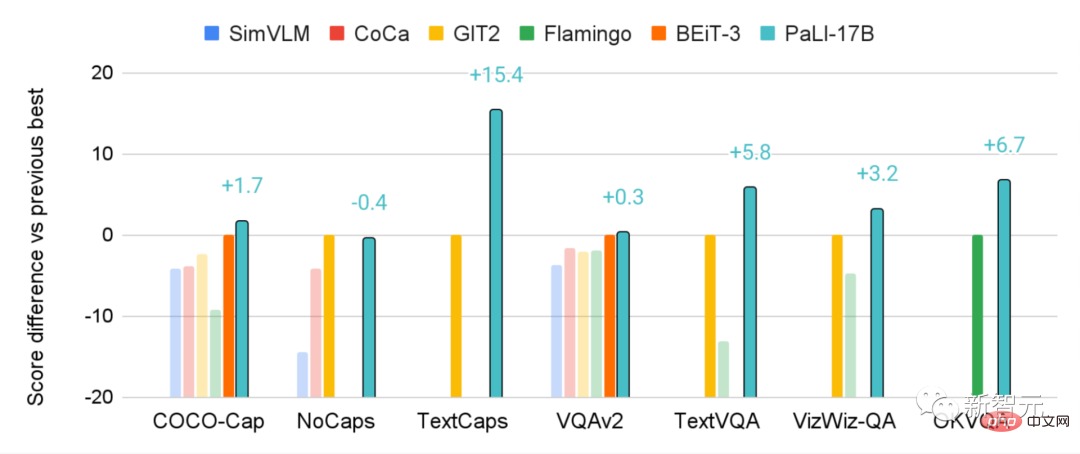

Le modèle PaLI pré-entraîné sur WebLI atteint des performances de pointe sur plusieurs benchmarks d'images et de langues, tels que COCO-Captions, TextCaps, VQAv2, OK-VQA, TextVQA, etc., dépassant également les performances des modèles précédents. Une référence en matière de sous-titrage visuel multilingue et de réponse visuelle aux questions.Architecture des modèles

L'un des objectifs de PALI est d'étudier si la relation entre les modèleslangage et visuel est la même en termes de performance et d'échelle, en particulier l'évolutivité des modèles langage-image.

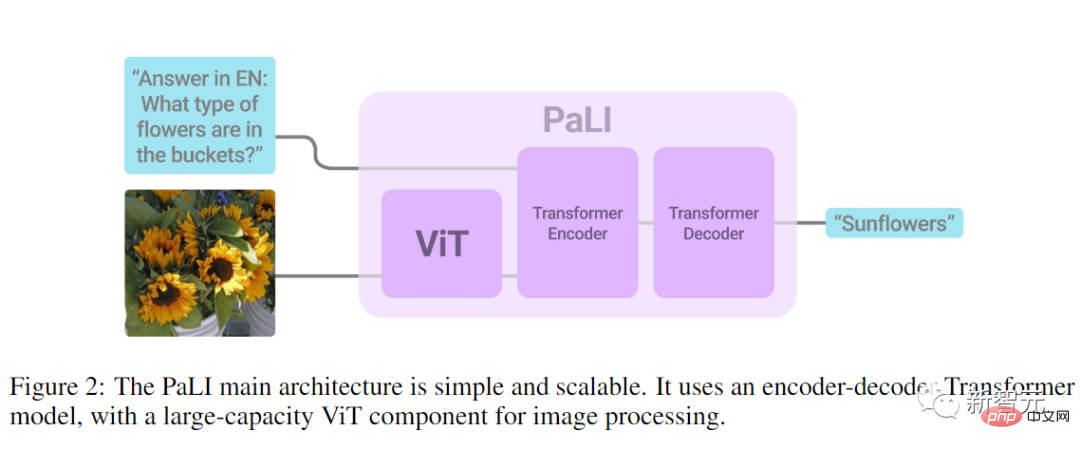

La conception architecturale du modèle est donc très simple, principalement pour la commodité des expériences, notamment pour la réutilisabilité et l'évolutivité.

Lors du traitement des images, l'entrée de l'encodeur Transformer comprend également des mots visuels représentant les images traitées par ViT.

Une conception clé du modèle PaLI est la réutilisation. Les chercheurs ont utilisé les poids de modèles de vision et de langage monomodaux préalablement formés (tels que mT5-XXL et les grands ViT) comme germes du modèle. rend le monomodal La capacité de formation dynamique est migrée et les coûts informatiques peuvent également être économisés.

Le composant visuel du modèle utilise

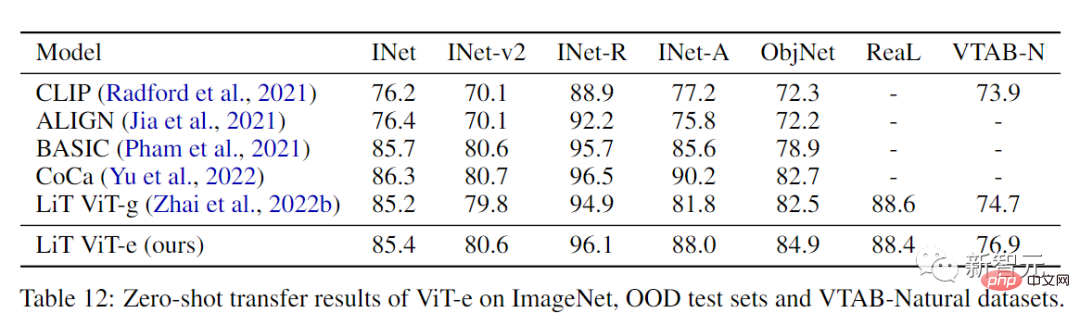

ViT-e, la plus grande architecture ViT à ce jour, qui a la même structure que le modèle ViT-G à 1,8 milliard de paramètres et utilise les mêmes paramètres d'entraînement. est étendu à 4 milliards de paramètres .

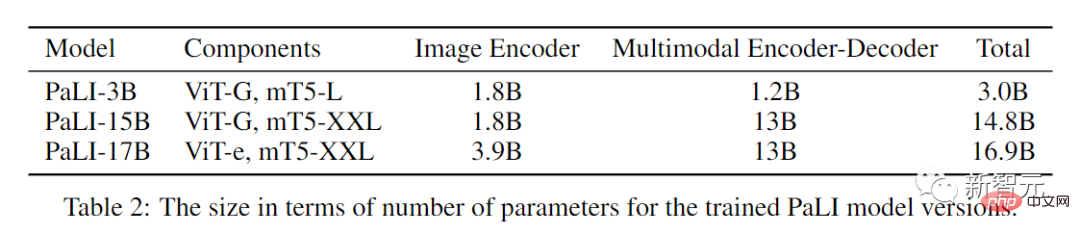

Bien que les lois de mise à l'échelle aient été étudiées dans les domaines visuel et linguistique, le comportement de mise à l'échelle a été moins exploré dans les modèles combinés de vision et de langage. L'élargissement de l'échelle du modèle de base visuelle peut entraîner des problèmes dans les tâches de classification. .Les chercheurs l'ont également confirmé, et on peut observer que ViT-e n'est que légèrement meilleur que ViT-G sur ImageNet, mais ViT-e a une grande amélioration par rapport à la tâche de langage visuel de PaLI. Par exemple, ViT-e surpasse ViT-G de près de 3 points CIDEr sur la tâche de sous-titre COCO. 3 points de plus que ViT-G dans les tâches. Cela laisse également entrevoir la possibilité d'utiliser à l'avenir des modèles de squelette ViT plus grands dans des tâches de langage visuel. Les chercheurs ont adopté le mT5 backbone comme composant de modélisation du langage, en utilisant mT5-Large (1 milliard de paramètres) et mT5-XXL (13 milliards de paramètres) pré-entraînés pour initialiser l'encodeur-décodeur de langage de PaLI. est ensuite continué à être formé de manière mixte sur de nombreuses tâches linguistiques, y compris des tâches de compréhension pure du langage, ce qui permet également d'éviter un oubli catastrophique des capacités de compréhension et de production du langage de mT5. J'ai enfin reçu trois modèles PALI de tailles différentes. Des recherches approfondies liées à l'apprentissage profond montrent que plus le modèle est grand, plus l'ensemble de données de formation requis est grand. Ainsi, afin d'étudier de manière approfondie et de libérer le potentiel des modèles de pré-formation langage-image, les chercheurs ont exploré une grande quantité de données d'images et de texte sur Internet et ont construit un nouvel ensemble de données WebLI, qui comprend 120 images en 109 langues. Des milliards de textes alternatifs et 10 milliards d'images. En plus d'utiliser le texte Web pour l'annotation, les chercheurs ont également appliqué l'API Cloud Vision pour effectuer la reconnaissance OCR sur les images, obtenant ainsi 29 milliards de paires image-données OCR. Les images des parties de formation, de validation et de test de 68 ensembles de données visuelles et de langage visuel courants ont été dédupliquées en utilisant la quasi-duplication pour éviter les fuites de données dans les tâches d'évaluation en aval. Afin d'améliorer encore la qualité des données, les chercheurs évalueront également en fonction de la similarité intermodale de « l'image et du texte alternatif », ajusteront le seuil et ne conserveront finalement que 10 % des images, un total de 1 milliard d'images sont utilisées pour entraîner PaLI Étant donné que la tâche de langage visuel est multimodale, le modèle doit avoir plusieurs capacités de traitement sémantique et aura des objectifs différents. Par exemple, certaines tâches nécessitent une localisation locale des objets pour résoudre la tâche avec précision, tandis que d'autres tâches peuvent nécessiter des informations sémantiques plus globales. De même, certaines tâches linguistiques peuvent nécessiter des réponses longues, tandis que d'autres peuvent nécessiter des réponses compactes. Pour répondre à tous ces objectifs incohérents, les chercheurs exploitent la richesse des données de pré-formation WebLI et introduisent un mélange de tâches de pré-formation pour préparer des modèles pour diverses applications en aval. Afin de rendre le modèle plus polyvalent pour résoudre une variété de tâches, l'auteur a classé toutes les tâches dans une seule API commune (entrée : image + texte ; sortie : texte), permettant d'effectuer plusieurs tâches d'image et de langage. le partage des connaissances, qui est également partagé avec des paramètres pré-entraînés. Les cibles utilisées pour la pré-formation sont projetées dans la même API sous forme de mix pondéré, dans le but à la fois de maintenir la capacité de réutiliser les composants du modèle tout en entraînant le modèle à effectuer de nouvelles tâches. Le modèle utilise les frameworks open source T5X et Flaxformer et est formé avec Flax en JAX. La partie visuelle de ViT-e utilise le framework open source BigVision pour mettre en cascade les vecteurs de mots de la partie langage et les vecteurs de patch générés par. la partie visuelle. Ensemble, En entrée du codeur-décodeur multimodal, l'encodeur est initialisé à l'aide du pré-entraînement mT5-XXL. Pendant le processus de formation de PaLI, les poids des composants visuels sont figés et seuls les poids de l'encodeur-décodeur multimodal sont mis à jour. Dans la partie expérimentale, les chercheurs ont comparé PaLI sur des critères de langage visuel courants, et le modèle PaLI a obtenu des résultats de pointe sur ces tâches, dépassant même les très grands modèles proposés dans la littérature précédente. Par exemple, le PALI à 17 milliards de paramètres fonctionne mieux que le modèle Flamingo à 80 milliards de paramètres sur certaines tâches VQA et de sous-titrage d'images. Et PALI maintient également de bonnes performances sur des tâches monolingues ou visuelles, bien que ce ne soit pas l'objectif principal de formation de PALI. Nous examinons également comment les composants du modèle d'image et de langage interagissent en termes de mise à l'échelle du modèle, et où le modèle génère les gains les plus importants. La conclusion finale est que la mise à l'échelle conjointe (mise à l'échelle) de ces deux composants donne les meilleures performances. Plus précisément, la mise à l'échelle du composant visuel qui nécessite relativement peu de paramètres est la plus critique, tandis que la mise à l'échelle est également importante pour améliorer les performances sur les tâches multilingues. . Après avoir évalué PaLI sur le benchmark Crossmodal-3600 en 35 langues, nous pouvons constater que la tâche de titre multilingue bénéficie davantage de l'extension du modèle PaLI. Pour éviter de créer ou de renforcer des préjugés injustes dans les grands modèles de langage et d'images, il est nécessaire d'être transparent sur les données utilisées et sur la manière dont les modèles utilisent ces données, ainsi que de tester l'équité des modèles. et effectuez une analyse responsable des données, l'article fournit donc à la fois une carte de données et une carte modèle

Ensemble de données en 109 langues

Formation de grands modèles

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI