Maison >Périphériques technologiques >IA >Chercheur OpenAI : Comment mettre en œuvre l'apprentissage supervisé lorsque les données sont insuffisantes

Chercheur OpenAI : Comment mettre en œuvre l'apprentissage supervisé lorsque les données sont insuffisantes

- 王林avant

- 2023-04-12 08:58:091262parcourir

Cet article est reproduit à partir de Lei Feng.com Si vous avez besoin de réimprimer, veuillez vous rendre sur le site officiel de Lei Feng.com pour demander une autorisation.

Dans les applications réelles, les données sont faciles à obtenir, mais les données étiquetées sont rares.

D'une manière générale, lorsqu'une tâche d'apprentissage supervisé est confrontée au problème de données étiquetées insuffisantes, les quatre solutions suivantes peuvent être envisagées :

1. Pré-formation + mise au point : Tout d'abord, former un apprentissage non supervisé à grande échelle. corpus de données sur un pré-entraînement de modèles puissants indépendants des tâches (par exemple, pré-entraînement d'un modèle de langage sur du texte libre via un apprentissage auto-supervisé, ou pré-entraînement d'un modèle de vision sur des images non étiquetées) avant d'utiliser un petit ensemble d'échantillons étiquetés sur des tâches en aval. le modèle.

2. Apprentissage semi-supervisé : Apprendre simultanément à partir d'échantillons étiquetés et non étiquetés Les chercheurs ont utilisé cette méthode pour mener de nombreuses recherches sur des tâches visuelles.

3. Apprentissage actif : Le coût de l'étiquetage est élevé Même si le budget de coût est limité, nous espérons toujours collecter autant de données d'étiquetage que possible. L'apprentissage actif apprend à sélectionner les échantillons non étiquetés les plus précieux et collecte ces données lors du processus de collecte ultérieur, aidant ainsi le modèle à obtenir autant que possible l'effet souhaité avec un budget limité.

4. Pré-entraînement + génération automatique d'ensembles de données : Grâce à un modèle pré-entraîné puissant, le modèle peut être utilisé pour générer automatiquement beaucoup plus d'échantillons étiquetés. Portée par le succès de l’apprentissage en quelques étapes, cette méthode est particulièrement appréciée dans le domaine linguistique.

Cet article présente de manière exhaustive la méthode d'apprentissage semi-supervisé. L'auteur est la chercheuse OpenAI Lilian Weng Adresse du blog : https://lilianweng.github.io/

1 Qu'est-ce que l'apprentissage semi-supervisé ?

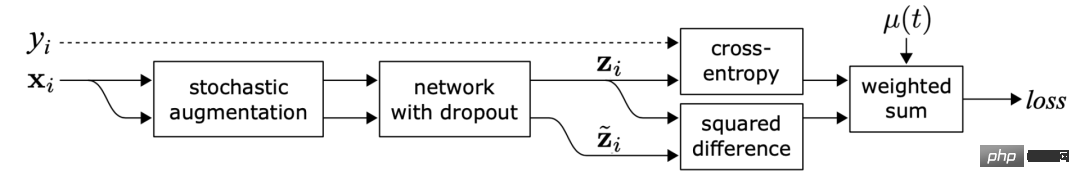

L'apprentissage semi-supervisé utilise à la fois des données étiquetées et non étiquetées pour entraîner le modèle. Il est intéressant de noter que la plupart de la littérature existante sur l’apprentissage semi-supervisé se concentre sur les tâches de vision. La méthode pré-formation + mise au point est le paradigme le plus courant dans les tâches linguistiques. Les pertes de toutes les méthodes mentionnées dans cet article se composent de deux parties :  . La perte de supervision

. La perte de supervision est très facile à calculer lorsque tous les échantillons sont des échantillons étiquetés. Nous devons nous concentrer sur la manière de concevoir des pertes non supervisées

est très facile à calculer lorsque tous les échantillons sont des échantillons étiquetés. Nous devons nous concentrer sur la manière de concevoir des pertes non supervisées  . Le terme pondéré

. Le terme pondéré  choisit généralement d'utiliser la fonction de pente, où t est le nombre d'étapes d'entraînement. À mesure que le nombre de temps d'entraînement augmente, la proportion de

choisit généralement d'utiliser la fonction de pente, où t est le nombre d'étapes d'entraînement. À mesure que le nombre de temps d'entraînement augmente, la proportion de  augmente. Avertissement : cet article ne couvre pas toutes les méthodes semi-supervisées, mais se concentre uniquement sur le réglage de l'architecture du modèle. Pour plus d'informations sur la façon d'utiliser des modèles génératifs et des méthodes basées sur des graphiques dans l'apprentissage semi-supervisé, vous pouvez vous référer à l'article « Un aperçu de l'apprentissage profond semi-supervisé ».

augmente. Avertissement : cet article ne couvre pas toutes les méthodes semi-supervisées, mais se concentre uniquement sur le réglage de l'architecture du modèle. Pour plus d'informations sur la façon d'utiliser des modèles génératifs et des méthodes basées sur des graphiques dans l'apprentissage semi-supervisé, vous pouvez vous référer à l'article « Un aperçu de l'apprentissage profond semi-supervisé ».

2 tableau d'explication des symboles

symbole |

signification |

|

Nombre de balises uniques. |

|

ensemble de données d'étiquette, où |

|

Ensemble de données non étiqueté. |

|

L'ensemble des données, y compris les échantillons étiquetés et les échantillons non étiquetés. |

|

peut représenter des échantillons non étiquetés ou des échantillons étiquetés. |

|

Échantillons améliorés sans étiquette ou échantillons étiquetés. |

|

i-ième échantillon. |

|

représentent respectivement la perte, la perte supervisée et la perte non supervisée |

| Perte de poids non supervisée, avec le nombre d'étapes d'entraînement augmentation par augmentation. |

|

La probabilité conditionnelle d'étiqueter l'ensemble de données en fonction de l'entrée. |

|

Le réseau neuronal généré à l'aide de θ pondéré est le modèle qui devrait être formé. |

|

Un vecteur de valeurs de sortie de la fonction logique f. |

|

Distribution prévue des étiquettes. La fonction de distance entre deux distributions, telle que l'erreur quadratique moyenne, l'entropie croisée, la divergence KL, etc. |

|

Enseignant Hyperparamètres pondérés à moyenne mobile pour les poids du modèle. |

|

α est le coefficient de l'échantillon mixte, |

|

Aiguiser la température de la distribution prédite . |

|

Sélectionnez le seuil de confiance pour les résultats de prédiction qualifiés. |

3 Hypothèses

Dans la littérature de recherche existante, les hypothèses suivantes sont discutées pour soutenir certaines décisions de conception dans les méthodes d'apprentissage semi-supervisé.

Hypothèse 1 : Hypothèses de fluidité

Si deux échantillons de données sont proches dans une zone à haute densité del'espace des fonctionnalités, leurs étiquettes doivent être identiques ou très similaires.

Hypothèse 2 : Hypothèses de cluster

L'espace des fonctionnalités comporte à la fois des zones denses et clairsemées. Les points de données densément regroupés forment naturellement des clusters. Les échantillons du même cluster doivent avoir la même étiquette. Il s’agit d’une petite extension de l’hypothèse 1.

Hypothèse 3 : Hypothèses de séparation à faible densité

Les limites de décision entre les classes ont tendance à être situées dans des zones clairsemées à faible densité, car sinon les limites de décision seront élevées. à deux clusters respectivement, ce qui conduira à l’échec de l’hypothèse 1 et de l’hypothèse 2.

Hypothèse 4 : Hypothèses multiples

Les données de haute dimension ont tendance à être situées sur des variétés de faible dimension. Bien que les données du monde réel puissent être observées à des dimensions très élevées (par exemple, des images d'objets/scènes du monde réel), elles peuvent en réalité être capturées par des variétés de dimensions inférieures. Elles capturent certaines propriétés des données et regroupent étroitement certains points de données similaires. (par exemple, les images d'objets/scènes du monde réel ne sont pas dérivées d'une distribution uniforme de toutes les combinaisons de pixels). Cela permet au modèle d'apprendre une méthode de représentation plus efficace pour découvrir et évaluer les similitudes entre les points de données non étiquetés. C’est aussi la base de l’apprentissage de la représentation. Pour une explication plus détaillée de cette hypothèse, veuillez vous référer à l'article « Comment comprendre les hypothèses populaires dans l'apprentissage semi-supervisé ».

Lien : https://stats.stackexchange.com/questions/66939/what-is-the-manifold-assumption-in-semi-supervised-learning

4 Régularisation de cohérence)

Cohérence la régularisation, également appelée entraînement à la cohérence, suppose qu'avec la même entrée, le caractère aléatoire du réseau neuronal (comme l'utilisation de l'algorithme Dropout) ou la transformation d'augmentation des données ne modifiera pas la prédiction du modèle. Chaque méthode de cette section a une perte de régularisation de cohérence :  . Plusieurs méthodes d'apprentissage auto-supervisé telles que SimCLR, BYOL et SimCSE ont adopté cette idée. Différentes versions améliorées du même échantillon produisent la même représentation. Les motivations de recherche pour la formation multi-vues en modélisation linguistique et l’apprentissage multi-vues en apprentissage auto-supervisé sont les mêmes.

. Plusieurs méthodes d'apprentissage auto-supervisé telles que SimCLR, BYOL et SimCSE ont adopté cette idée. Différentes versions améliorées du même échantillon produisent la même représentation. Les motivations de recherche pour la formation multi-vues en modélisation linguistique et l’apprentissage multi-vues en apprentissage auto-supervisé sont les mêmes.

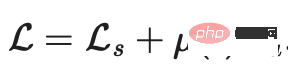

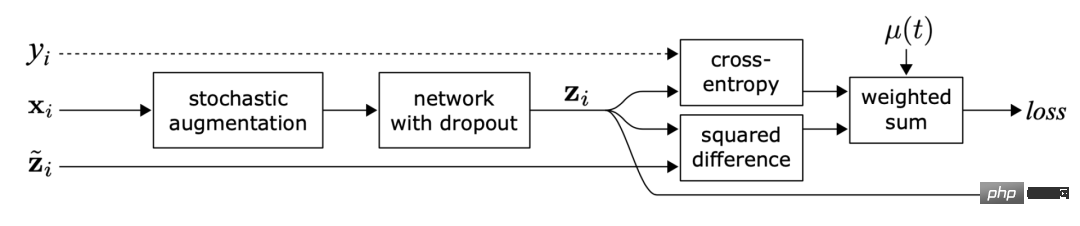

(1).Modèle Π

Figure 1 : Présentation du modèle Π. La même entrée est perturbée avec différentes améliorations aléatoires et masques de suppression pour produire deux versions, et deux sorties sont obtenues via le réseau. Le modèle Π prédit que les deux sorties sont cohérentes. (Source de l'image : article de Laine et Aila "Sequential Integration of Semi-supervised Learning" publié en 2017)

Sajjadi et al. ont proposé une perte d'apprentissage non supervisée dans l'article "Regularization With Stochastic Transformations and Perturbations for Deep Semi-Supervised Learning" publié en 2016, qui peut générer deux versions du même point de données par transformation aléatoire (telle qu'un abandon). , pooling maximum aléatoire) et minimiser la différence entre les deux résultats de sortie après passage à travers le réseau. Cette perte peut être appliquée aux ensembles de données non étiquetés puisque leurs étiquettes ne sont pas explicitement utilisées. Laine et Aila ont ensuite donné un nom à cette méthode de traitement dans l'article « Temporal Ensembling for Semi-Supervised Learning » publié en 2017, appelé modèle Π.  Parmi eux,

Parmi eux,  fait référence aux valeurs de différents masques d'amélioration ou d'abandon aléatoires appliqués au même réseau neuronal. Cette perte utilise l'intégralité de l'ensemble de données.

fait référence aux valeurs de différents masques d'amélioration ou d'abandon aléatoires appliqués au même réseau neuronal. Cette perte utilise l'intégralité de l'ensemble de données.

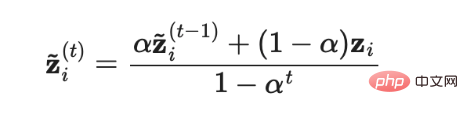

(2) Intégration temporelle (Assemblage temporel)

Figure 2 : Aperçu de l'intégration temporelle. Son objectif d'apprentissage est de faire des prédictions d'étiquettes sur la moyenne mobile exponentielle (EMA) de chaque échantillon. (Source de l'image : article de Laine et Aila de 2017 « Intégration séquentielle de l'apprentissage semi-supervisé »)

Le modèleΠ nécessite que chaque échantillon traverse deux fois le réseau neuronal, ce qui double le coût de calcul. Afin de réduire les coûts, le modèle d'ensemble temporel utilise en permanence la moyenne mobile exponentielle (EMA) des prédictions du modèle en temps réel pour chaque échantillon d'entraînement  comme objectif d'apprentissage, et l'EMA ne doit être calculée et mise à jour qu'une fois à chaque itération. . Puisque la sortie

comme objectif d'apprentissage, et l'EMA ne doit être calculée et mise à jour qu'une fois à chaque itération. . Puisque la sortie  du modèle d'intégration séquentielle est initialisée à 0, elle est normalisée en divisant par

du modèle d'intégration séquentielle est initialisée à 0, elle est normalisée en divisant par  pour corriger ce biais de démarrage. L'optimiseur Adam dispose également d'un tel terme de correction de biais pour la même raison.

pour corriger ce biais de démarrage. L'optimiseur Adam dispose également d'un tel terme de correction de biais pour la même raison.  où

où  est la prédiction d'ensemble dans la t-ème itération et

est la prédiction d'ensemble dans la t-ème itération et  est la prédiction du modèle dans le tour en cours. Il convient de noter que puisque

est la prédiction du modèle dans le tour en cours. Il convient de noter que puisque  =0, après correction du biais,

=0, après correction du biais,  est exactement égal à la valeur de prédiction du modèle

est exactement égal à la valeur de prédiction du modèle  dans la première itération.

dans la première itération.

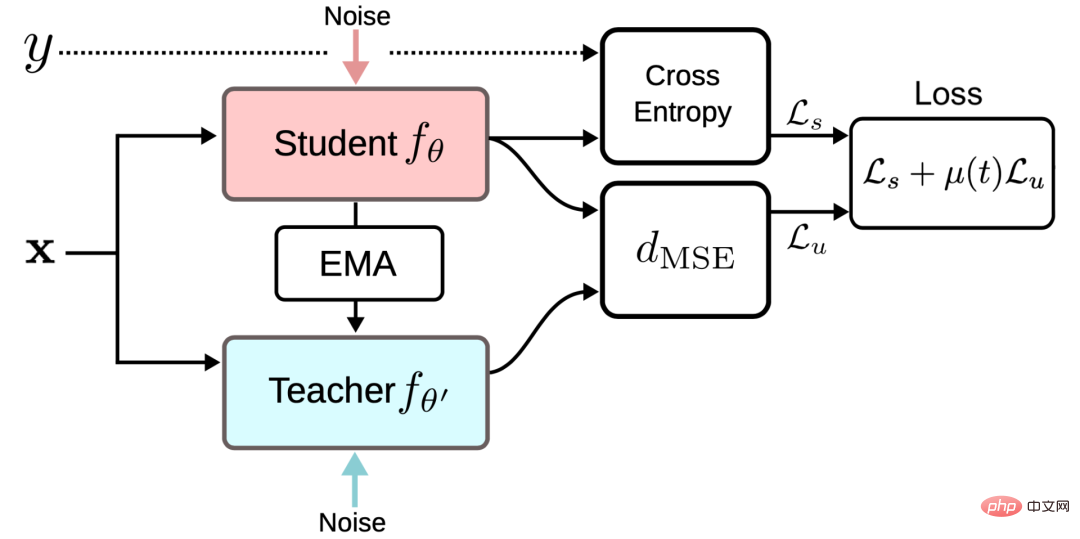

(3) Mean Teachers

Figure 3 : Aperçu du cadre Mean Teacher (Source de l'image : Tarvaninen, article de Valpola de 2017 « Le modèle Mean Teacher est meilleur Modèle exemplaire : optimisation des objectifs de cohérence moyenne pondérée résultats d'apprentissage profond semi-supervisé》)

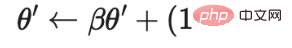

Le modèle d'ensemble temporel suit la moyenne mobile exponentielle des prédictions d'étiquettes pour chaque échantillon d'entraînement comme objectif d'apprentissage. Cependant, cette prédiction d'étiquette ne change qu'à chaque itération, ce qui rend cette approche lourde lorsque l'ensemble de données d'entraînement est volumineux. Afin de surmonter le problème de la lenteur de mise à jour des cibles, Tarvaninen et Valpola ont publié l'article « Les enseignants moyens sont de meilleurs modèles de rôle : optimisation des cibles de cohérence moyenne pondérée, résultats d'apprentissage profond semi-supervisés » en 2017 (Les enseignants moyens sont de meilleurs modèles de rôle : poids- (les objectifs de cohérence moyennés améliorent les résultats de l'apprentissage profond semi-supervisé), l'algorithme Mean Teacher est proposé, qui met à jour la cible en suivant la moyenne mobile des poids du modèle au lieu de la sortie du modèle. Le modèle original avec un poids de θ est appelé modèle Student, et un modèle dont le poids est le poids moyen mobile de plusieurs modèles Student consécutifs θ′ est appelé modèle Mean Teacher :

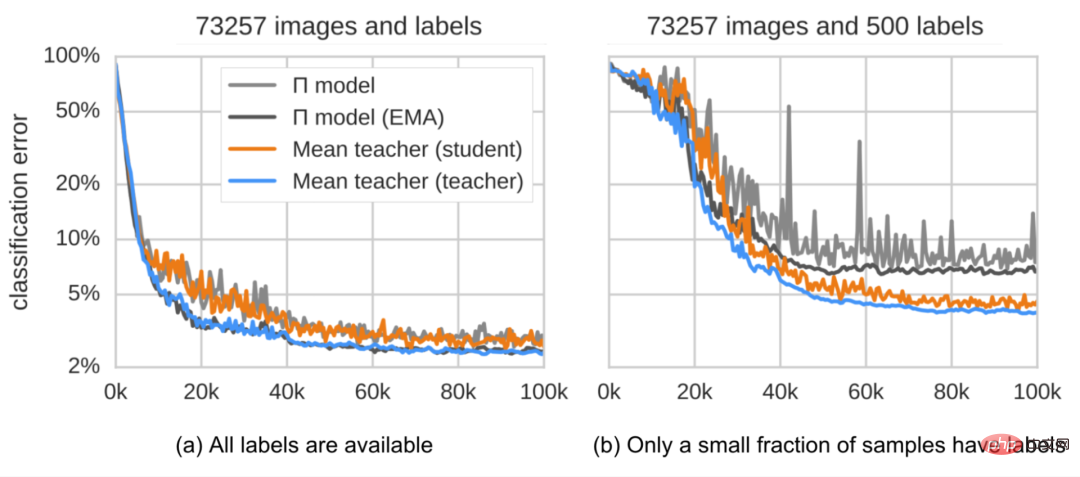

La perte de régularisation de cohérence est la distance entre les prédictions du modèle Student et du modèle Teacher, et cet écart doit être minimisé. Le modèle Mean Teacher peut fournir des prédictions plus précises que le modèle Student. Cette conclusion est confirmée par l’expérience empirique, comme le montre la figure 4.

Figure 4 : Erreur de classification du modèle Π et du modèle Mean Teacher sur l'ensemble de données SVHN. Le modèle Mean Teacher (représenté par la ligne orange) est plus performant que le modèle Student (représenté par la ligne bleue). (Source de l'image : article de 2017 de Tarvaninen et Valpola « Le modèle d'enseignant moyen est un modèle exemplaire plus performant : optimisation des objectifs de cohérence moyenne pondérée, résultats d'apprentissage profond semi-supervisé »)

Selon ses recherches sur l'ablation :

- Les méthodes d'amélioration des entrées (par exemple, retournement aléatoire des images d'entrée, bruit gaussien) ou le traitement des abandons du modèle Student sont nécessaires pour que le modèle obtienne de bonnes performances. Le mode Enseignant ne nécessite pas de traitement d’abandon.

- La performance est sensible à l'hyperparamètre de décroissance β de la moyenne mobile exponentielle. Une meilleure stratégie consiste à utiliser un β=0,99 plus petit au cours de la phase de croissance et un β=0,999 plus grand dans les étapes ultérieures, lorsque l'amélioration du modèle de Student ralentit.

- Il a été constaté que l'erreur quadratique moyenne (MSE) de la fonction de coût de cohérence fonctionnait mieux que d'autres fonctions de coût telles que la divergence KL.

(4) Prendre des échantillons bruyants comme cibles d'apprentissage

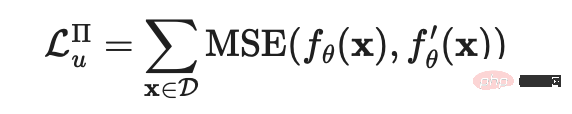

Plusieurs méthodes récentes d'entraînement à la cohérence apprennent à minimiser la différence de prédiction entre l'échantillon original non étiqueté et sa version améliorée correspondante. Cette idée est très similaire au modèle Π, mais sa perte de régularisation de cohérence ne fonctionne que sur des données non étiquetées.

Figure 5 : Entraînement à la cohérence à l'aide d'échantillons bruyants

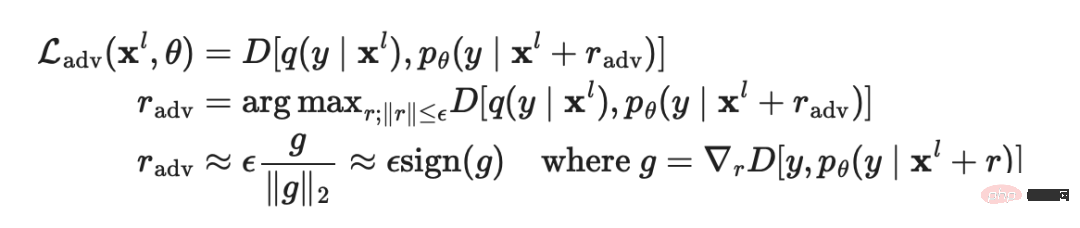

Dans l'article « Expliquer et exploiter les exemples contradictoires » publié par Goodfellow et al. l'entrée et le modèle sont formés pour être robustes à de telles attaques contradictoires.

La formule d'application de cette méthode en apprentissage supervisé est la suivante :

où  est la vraie distribution, un codage unique qui se rapproche de l'étiquette de vérité terrain,

est la vraie distribution, un codage unique qui se rapproche de l'étiquette de vérité terrain,  est la prédiction du modèle et

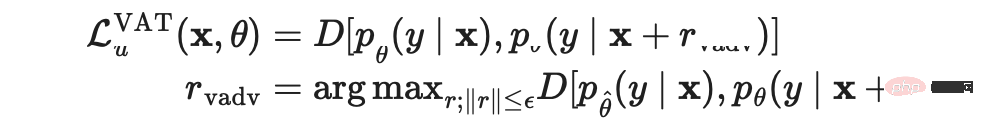

est la prédiction du modèle et  est la fonction de distance qui calcule la différence entre les deux distributions. Miyato et al. ont proposé une formation contradictoire virtuelle dans l'article « Virtual Adversarial Training : A Regularization Method for Supervised and Semi-Supervised Learning » publié en 2018 (Virtual Adversarial Training, TVA), cette méthode est une extension de l'idée de formation contradictoire dans le domaine de l’apprentissage semi-supervisé. Puisque

est la fonction de distance qui calcule la différence entre les deux distributions. Miyato et al. ont proposé une formation contradictoire virtuelle dans l'article « Virtual Adversarial Training : A Regularization Method for Supervised and Semi-Supervised Learning » publié en 2018 (Virtual Adversarial Training, TVA), cette méthode est une extension de l'idée de formation contradictoire dans le domaine de l’apprentissage semi-supervisé. Puisque  est inconnu, la TVA remplace le terme inconnu par la prédiction du modèle actuel concernant l'entrée d'origine lorsque les pondérations actuelles sont définies sur

est inconnu, la TVA remplace le terme inconnu par la prédiction du modèle actuel concernant l'entrée d'origine lorsque les pondérations actuelles sont définies sur  . Il convient de noter que

. Il convient de noter que  est une valeur fixe du poids du modèle, donc les mises à jour du dégradé ne seront pas effectuées sur

est une valeur fixe du poids du modèle, donc les mises à jour du dégradé ne seront pas effectuées sur  .

.

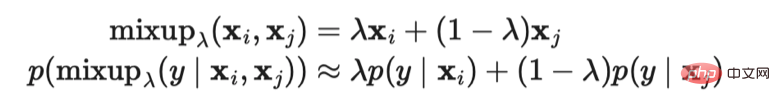

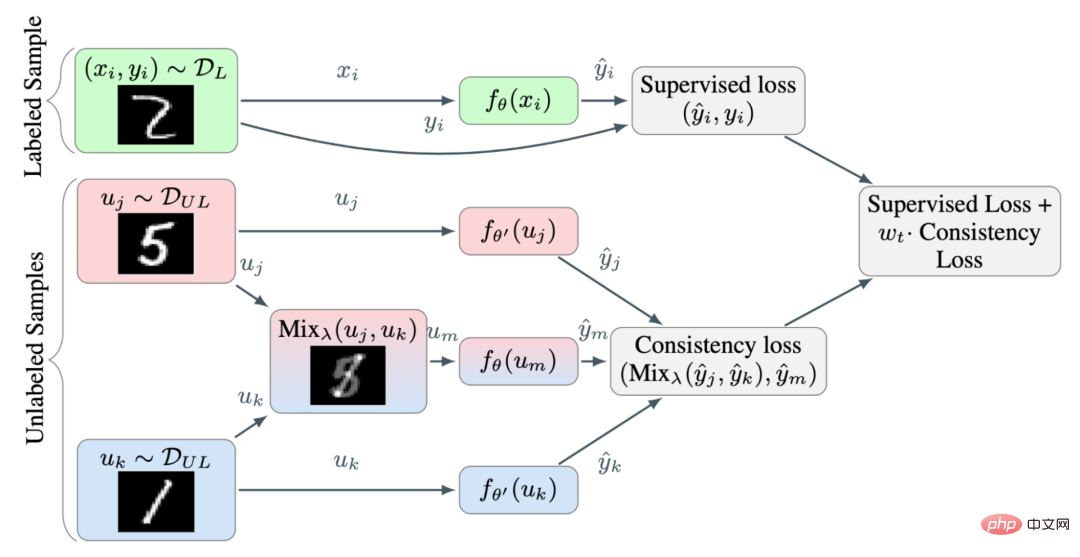

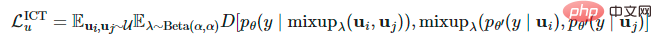

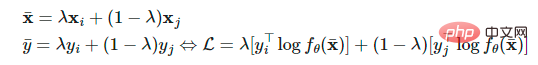

La perte de TVA s'applique aux échantillons étiquetés et non étiquetés. Il calcule la régularité négative de la variété de prédiction du modèle actuel à chaque point de données. L’optimisation de cette perte peut rendre le collecteur de prédiction plus fluide. Verma et al. ont proposé une formation à la cohérence d'interpolation (ICT) dans l'article de 2019 « Formation à la cohérence d'interpolation pour l'apprentissage semi-supervisé » en ajoutant l'interpolation de plus de points de données. Renforcez l'ensemble de données afin que les prédictions du modèle et l'interpolation des étiquettes correspondantes soient les mêmes. cohérent que possible. Hongyi Zhang et al. ont proposé la méthode MixUp dans l'article de 2018 « Mixup : Beyond Empirical Risk Minimization », qui mélange deux images via une simple somme pondérée. L'entraînement à la cohérence d'interpolation est basé sur cette idée, permettant au modèle de prédiction de générer des étiquettes pour un échantillon mixte afin de correspondre à l'interpolation prédite de l'entrée correspondante :

où  représente la moyenne mobile de θ de la valeur du modèle Mean Teacher.

représente la moyenne mobile de θ de la valeur du modèle Mean Teacher.

Figure 6 : Aperçu de l'entraînement à la cohérence d'interpolation. Utilisez la méthode MixUp pour générer davantage d’échantillons d’interpolation avec des étiquettes d’interpolation comme cible d’apprentissage. (Source de l'image : article 2019 de Verma et al. « Formation à la cohérence d'interpolation pour l'apprentissage semi-supervisé »)

Étant donné que la probabilité que deux échantillons non étiquetés sélectionnés au hasard appartiennent à des catégories différentes est très élevée (par exemple, il y a 1000 dans la catégorie cible ImageNet), donc l'application de la méthode Mixup entre deux échantillons aléatoires non étiquetés est susceptible de générer une interpolation proche de la limite de décision. Selon l’hypothèse de séparation de faible densité, les limites de décision sont souvent situées dans des zones de faible densité.

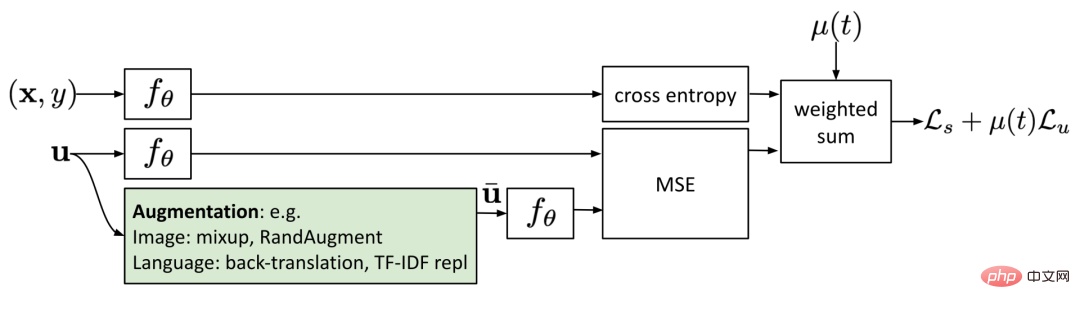

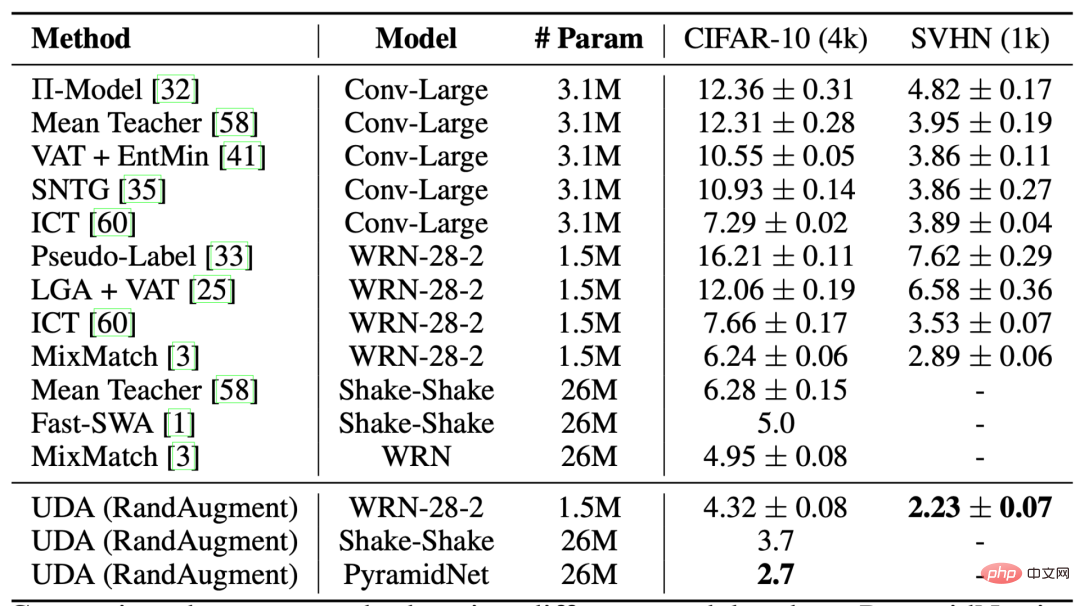

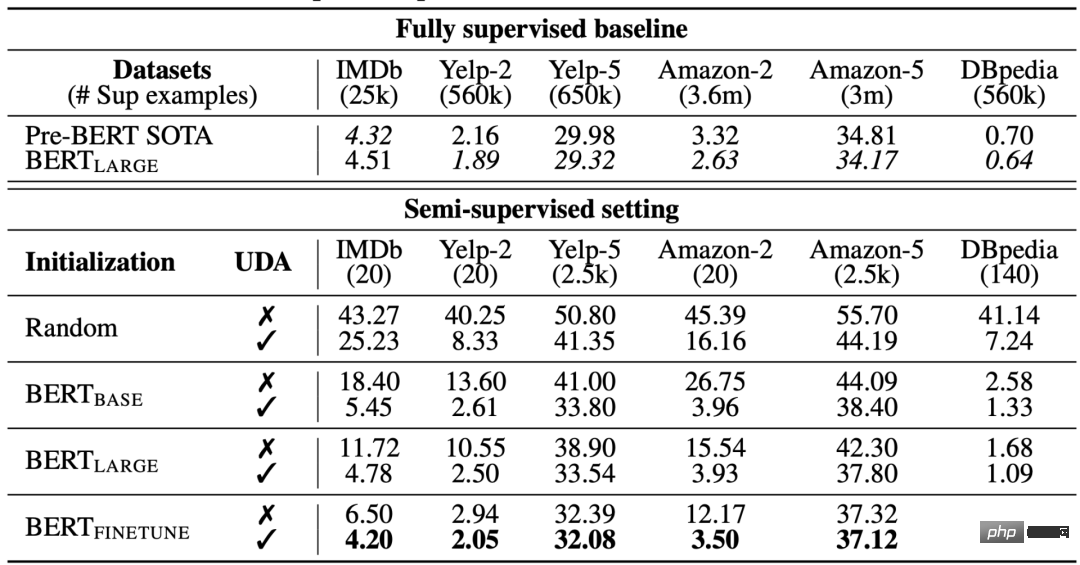

où  représente la moyenne mobile de θ. Semblable à la TVA, l'augmentation des données non supervisée (UDA) proposée par Xie et al dans l'article de 2020 « Augmentation des données non supervisées pour la formation à la cohérence » apprend à donner aux échantillons non étiquetés le même résultat que celui prédit par l'échantillon augmenté. L'UDA se concentre spécifiquement sur l'étude de la manière dont la « qualité » du bruit affecte les performances de l'apprentissage semi-supervisé grâce à une formation cohérente. Pour générer des échantillons de bruit significatifs et efficaces, il est crucial d’utiliser des méthodes avancées d’augmentation des données. Une bonne méthode d’augmentation des données devrait être capable de générer un bruit efficace (c’est-à-dire ne pas changer les étiquettes) et diversifié avec des biais inductifs ciblés.

représente la moyenne mobile de θ. Semblable à la TVA, l'augmentation des données non supervisée (UDA) proposée par Xie et al dans l'article de 2020 « Augmentation des données non supervisées pour la formation à la cohérence » apprend à donner aux échantillons non étiquetés le même résultat que celui prédit par l'échantillon augmenté. L'UDA se concentre spécifiquement sur l'étude de la manière dont la « qualité » du bruit affecte les performances de l'apprentissage semi-supervisé grâce à une formation cohérente. Pour générer des échantillons de bruit significatifs et efficaces, il est crucial d’utiliser des méthodes avancées d’augmentation des données. Une bonne méthode d’augmentation des données devrait être capable de générer un bruit efficace (c’est-à-dire ne pas changer les étiquettes) et diversifié avec des biais inductifs ciblés.

Pour le champ image, UDA utilise la méthode RandAugment, qui a été proposée par Cubuk et al. Il échantillonne uniformément les opérations d'augmentation disponibles dans la bibliothèque de traitement d'image Python PIL sans nécessiter d'apprentissage ni d'optimisation, ce qui le rend beaucoup moins coûteux que l'utilisation de la méthode AutoAugment.

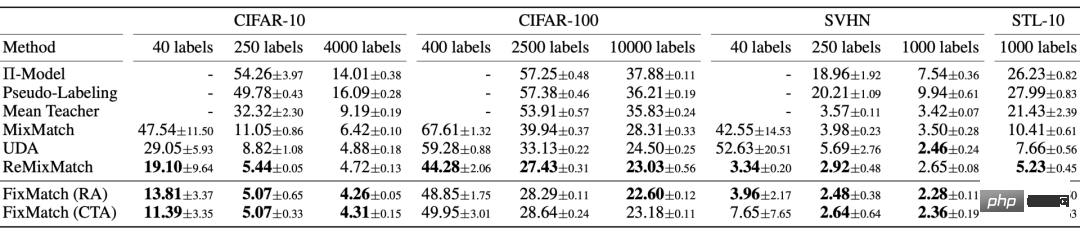

Figure 7 : Comparaison de différentes méthodes d'apprentissage semi-supervisé dans la classification CIFAR-10. Lors d'un entraînement sur 50 000 échantillons sans traitement RandAugment, les taux d'erreur de Wide-ResNet-28-2 et PyramidNet+ShakeDrop sous supervision complète sont respectivement de **5,4** et **2,7**.

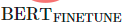

Pour le domaine linguistique, UDA utilise une combinaison de rétro-traduction et de remplacement de mots basée sur TF-IDF. La rétro-traduction conserve une signification de haut niveau mais ne conserve pas certains mots eux-mêmes, tandis que le remplacement de mots basé sur TF-IDF supprime les mots non informatifs avec de faibles scores TF-IDF. Lors d'expériences sur des tâches linguistiques, les chercheurs ont découvert que l'UDA est complémentaire de l'apprentissage par transfert et de l'apprentissage par représentation ; par exemple, le réglage fin du modèle BERT sur des données non étiquetées dans le domaine (c'est-à-dire dans la figure 8) peut encore améliorer les performances.

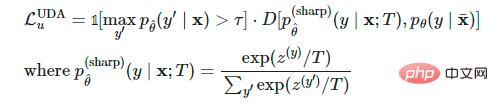

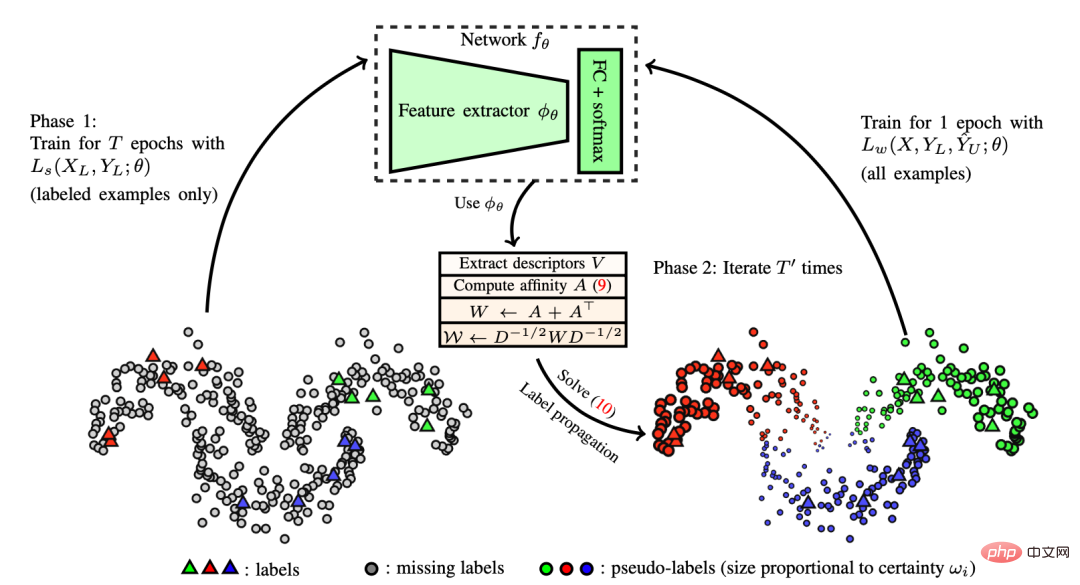

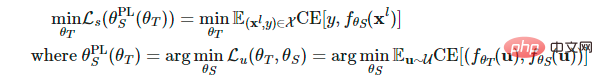

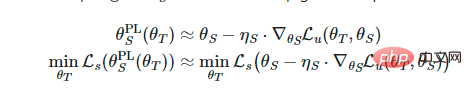

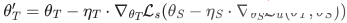

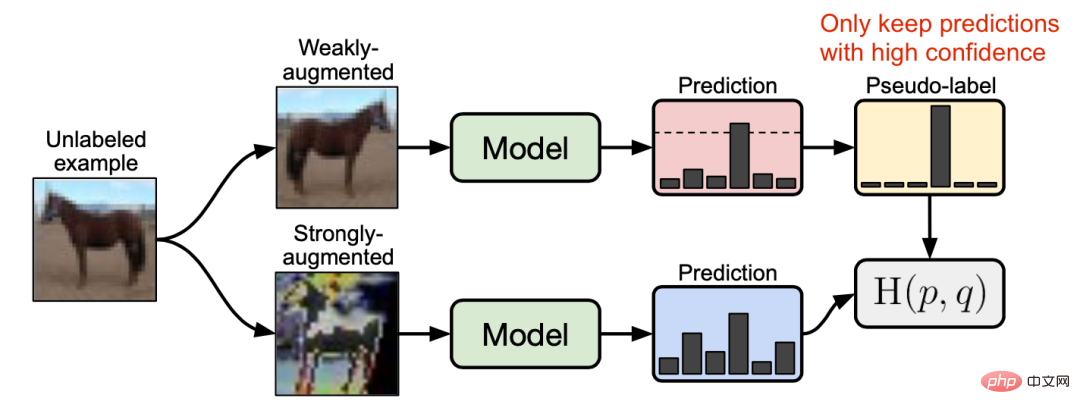

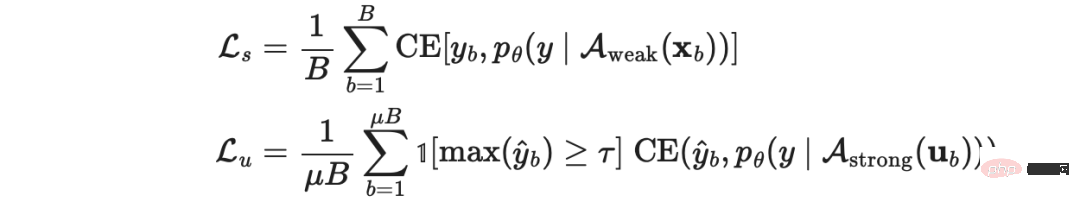

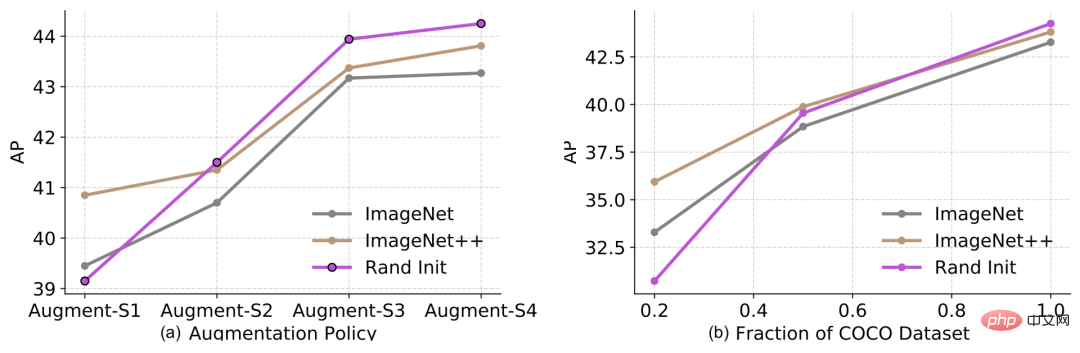

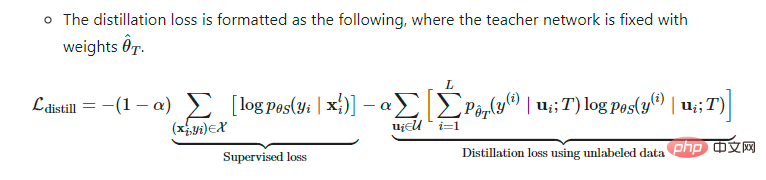

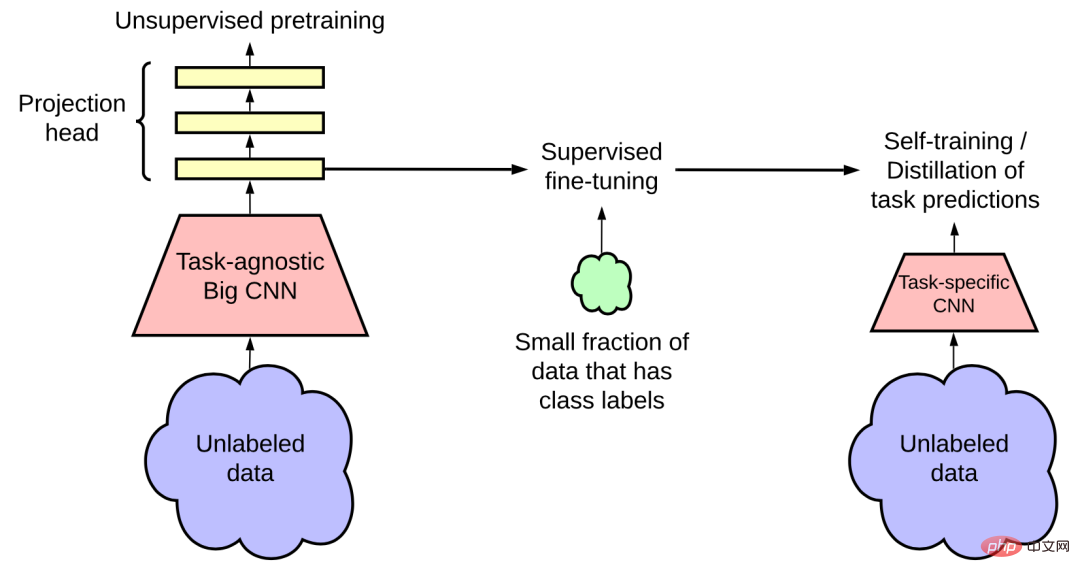

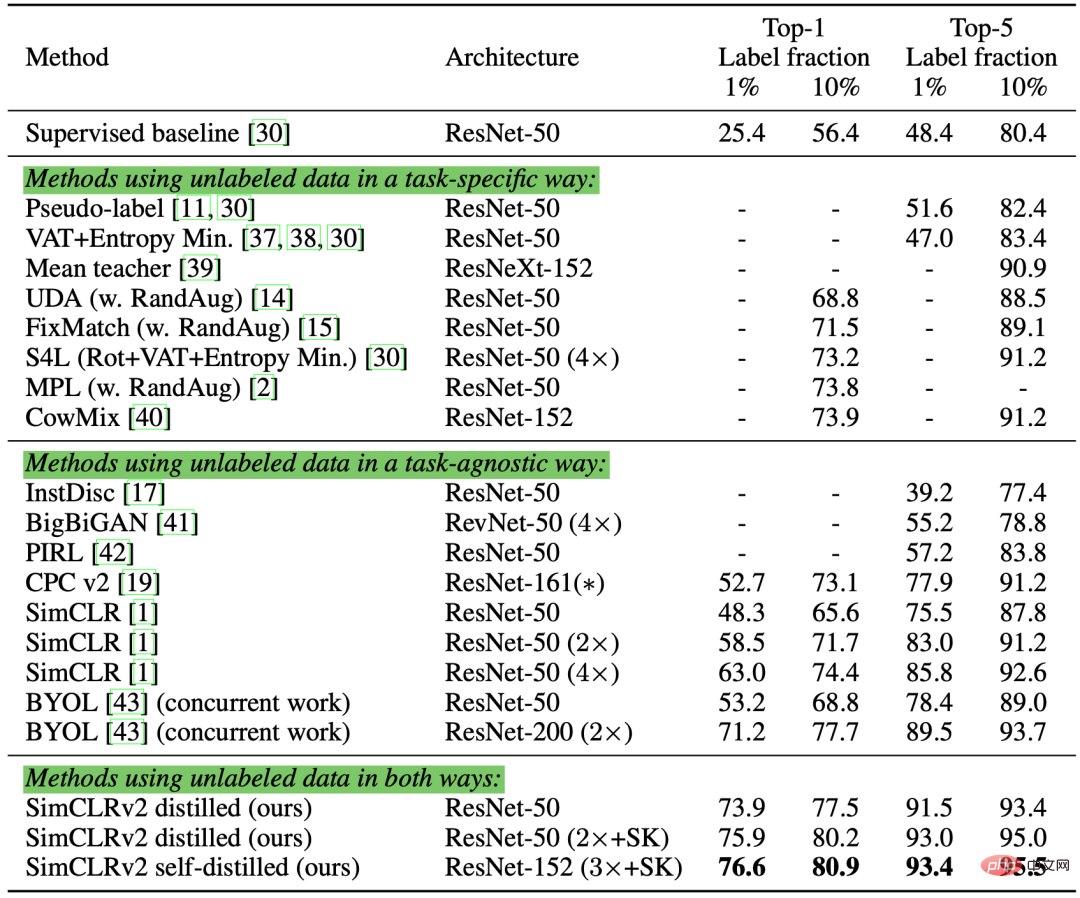

Figure 8 : Comparaison des méthodes d'amélioration des données non supervisées utilisant différents paramètres d'initialisation sur différentes tâches de classification de texte. (Source de l'image : article 2020 de Xie et al. « Augmentation des données non supervisées pour l'entraînement à la cohérence ») Lors du calcul de où, L'article de Lee et al. de 2013 "Pseudo-Label : le pseudo-étiquetage semi-supervisé simple et efficace est proposé dans la méthode d'apprentissage pour les réseaux de neurones profonds, qui attribue des pseudo-étiquettes aux échantillons non étiquetés sur la base de la probabilité softmax maximale prédite par le modèle actuel, puis entraîne le modèle simultanément sur des échantillons étiquetés et non étiquetés dans un cadre entièrement supervisé. Pourquoi les pseudo tags fonctionnent-ils ? Le pseudo-étiquetage est en fait équivalent à la régularisation de l'entropie, qui minimise l'entropie conditionnelle de la probabilité de classe des données non étiquetées, obtenant ainsi une séparation de faible densité entre les classes. En d’autres termes, les probabilités de classe prédites calculent en fait le chevauchement des classes, et minimiser l’entropie équivaut à réduire le chevauchement des classes et donc la séparation des densités. Figure 9 : (a) montre les résultats de visualisation t-SNE de la sortie du test sur l'ensemble de test MINIST après avoir entraîné le modèle en utilisant seulement 600 données étiquetées, (b) montre en utilisant 600 données étiquetées après l'entraînement le modèle avec 60 000 pseudo-étiquettes de données non étiquetées, les résultats de visualisation t-SNE de la sortie du test sont testés sur l'ensemble de test MINIST. Les pseudo-étiquettes permettent à l'espace d'intégration appris d'obtenir une meilleure séparation. (Source de l'image : article de Lee et al. de 2013 « Pseudo-étiquettes : une méthode d'apprentissage semi-supervisée simple et efficace pour les réseaux de neurones profonds ») La formation à l'aide de pseudo-étiquettes est naturellement un processus itératif. Ici, le modèle qui génère des pseudo-étiquettes est appelé modèle Enseignant, et le modèle qui utilise des pseudo-étiquettes pour l'apprentissage est appelé modèle Étudiant. Iscen et al. ont proposé le concept de propagation d'étiquettes dans l'article "Label Propagation for Deep Semi-supervised Learning" publié en 2019, qui est une idée pour construire des graphiques de similarité entre des échantillons basés sur intégrations de fonctionnalités. Les pseudo-étiquettes sont ensuite « diffusées » à partir d’échantillons connus vers des échantillons non étiquetés avec des poids de propagation proportionnels aux scores de similarité par paire dans le graphique. Conceptuellement, il est similaire au classificateur k-NN, qui souffrent tous deux du problème de ne pas bien s'adapter aux grands ensembles de données. Figure 10 : Diagramme schématique du principe de fonctionnement de la propagation des étiquettes. (Source de l'image : L'article « Label Propagation for Deep Semi-supervised Learning » publié par Iscen et al. en 2019) L'auto-formation n'est pas un concept nouveau, Scudder et al. Dans l'article "Probabilité d'erreur de certaines machines de reconnaissance de formes adaptatives" publié en 1965, Nigram & Ghani et al. ont publié l'article "Analyse de l'efficacité et de l'applicabilité de la formation collaborative" au CIKM 2000 "Analyse de l'efficacité et de l'applicabilité de". La co-formation implique toutes ce concept. Il s'agit d'un algorithme itératif qui effectue tour à tour les deux étapes suivantes jusqu'à ce que chaque échantillon non étiqueté corresponde à une étiquette : Dans l'article « L'auto-formation avec Noisy Student améliore la classification ImageNet » publié en 2020 par Xie et al., l'auto-formation est appliquée à l'apprentissage en profondeur et d'excellents résultats ont été obtenus. Dans la tâche de classification ImageNet, les chercheurs ont d’abord formé un modèle EfficientNet en tant que modèle Teacher pour générer des pseudo-étiquettes pour 300 millions d’images non étiquetées, puis ont formé un modèle EfficientNet plus grand en tant que modèle Student pour apprendre de vraies images étiquetées et des pseudo-étiquettes. Dans leur configuration expérimentale, un élément clé est l'ajout de bruit lors de la formation du modèle Student, tandis que le modèle Teacher n'ajoute pas de bruit pendant le processus de génération de pseudo-étiquettes. Par conséquent, leur méthode s'appelle "Noisy Student", qui utilise les méthodes de profondeur aléatoire, d'abandon et RandAugment pour ajouter du bruit au modèle Student. Le modèle Étudiant fonctionne mieux que le modèle Enseignant, en grande partie grâce aux avantages de l'ajout de bruit. Le bruit ajouté a pour effet cumulatif de lisser les limites de décision produites par le modèle sur les données étiquetées et non étiquetées. Il existe plusieurs autres paramètres techniques importants pour l'auto-formation du modèle Student, notamment : L'ajout de bruit au modèle Student améliore également la robustesse contradictoire contre FGSM (attaque de signe à gradient rapide, qui utilise le gradient de perte des données d'entrée et ajuste les données d'entrée pour maximiser la perte), même si le modèle n'est pas ciblé contre les adversaires. Optimiser la robustesse. Du et al. ont proposé la méthode SentAugment dans l'article de 2020 "L'auto-formation améliore la pré-formation pour la compréhension du langage naturel", visant à résoudre le problème de l'auto-formation dans le domaine des langues. données d'étiquette insuffisantes dans le domaine. Il s'appuie sur des vecteurs de phrases pour trouver des échantillons non étiquetés dans le domaine à partir de grands corpus et utilise les phrases récupérées pour l'auto-formation. Le biais de confirmation est le problème de fournir de mauvais pseudo-étiquettes parce que le modèle Enseignant n'est pas assez mature. Le surajustement avec les mauvaises étiquettes peut ne pas aboutir à un meilleur modèle Student. Afin de réduire le biais de confirmation, Eric Arazo et d'autres ont proposé deux méthodes dans l'article "Pseudo-Labeling and Confirmation Bias in Deep Semi-Supervised Learning" Nouvelles méthodes. L'une est la méthode Mixup utilisant des étiquettes souples. Étant donné S'il y a trop peu d'échantillons étiquetés, utiliser la méthode Mixup ne suffit pas. Par conséquent, les auteurs de l’article ont suréchantillonné les échantillons d’étiquettes pour définir un nombre minimum d’échantillons d’étiquettes dans chaque mini-lot. Cela fonctionne mieux que la compensation du poids pour les échantillons étiquetés, car elle sera mise à jour plus fréquemment, plutôt que des mises à jour moins fréquentes et plus volumineuses - qui sont en réalité plus instables. Tout comme la régularisation de cohérence, les méthodes d'augmentation et d'abandon des données sont également importantes pour jouer le rôle de pseudo-étiquettes. Hieu Pham et al. ont proposé des méta pseudo-étiquettes dans l'article de 2021 "Meta Pseudo Labels", et ont continuellement ajusté le modèle Teacher en fonction des commentaires du modèle Student sur ses performances sur l'ensemble de données d'étiquette. Le modèle Enseignant et le modèle Étudiant sont formés simultanément, le modèle Enseignant apprend à générer de meilleures pseudo-étiquettes et le modèle Étudiant apprend à partir des pseudo-étiquettes. Réglez les poids du modèle Enseignant et du modèle Étudiant sur Cependant, optimiser l'équation ci-dessus n'est pas une tâche facile. Empruntant l'idée deMAML (Model-Agnostic Meta-Learnin), cela revient à effectuer une mise à jour du gradient en une étape sur En raison de l'utilisation de pseudo-étiquettes souples, la fonction objectif ci-dessus est une fonction différentiable. Cependant, si des pseudo-étiquettes dures sont utilisées, ce sont des fonctions non différenciables, des méthodes d'apprentissage par renforcement telles que REINFORCE sont donc nécessaires. Le processus d'optimisation s'effectue en alternance entre deux modèles : Figure 11 : Comparaison des performances du méta-pseudo-étiquetage et d'autres méthodes d'apprentissage semi-supervisé ou auto-supervisé dans des tâches de classification d'images. (Source de l'image : article 2021 de Hieu Pham et al. "Meta Pseudo Labels") peut combiner les deux méthodes de régularisation de cohérence et les pseudo-étiquettes et les appliquer à des semi-supervisés. apprentissage. La méthode MixMatch proposée par Berthelot et al. dans l'article de 2019 « MixMatch : A Holistic Approach to Semi-Supervised Learning », est une approche holistique appliquée à l'apprentissage semi-supervisé qui utilise des données non étiquetées. en intégrant les méthodes suivantes : Étant donné un lot de données étiquetées où Figure 12 : Le processus de « devinette d'étiquette » dans MixMatch : faire la moyenne des K échantillons non étiquetés augmentés, corriger la distribution marginale prédite et enfin affiner la distribution. (Source de l'image : article 2019 de Berthelot et al. « MixMatch : A Holistic Method for Semi-supervised Learning ») Selon la recherche sur l'ablation de cet article, l'amélioration MixUp des données non étiquetées est particulièrement importante. La suppression de l’accentuation de la température sur la distribution des pseudo-étiquettes peut avoir un impact important sur les performances. Pour deviner les étiquettes, il est également essentiel de calculer la moyenne de plusieurs versions augmentées de données non étiquetées. Dans l'article de 2020 « ReMixMatch : Semi-Supervised Learning with Distribution Alignment and Augmentation Anchoring » (ReMixMatch : Semi-Supervised Learning with Distribution Alignment and Augmentation Anchoring), Berthelot et al ont en outre proposé la méthode ReMixMatch, en introduisant les deux nouveaux mécanismes suivants. pour améliorer la méthode MixMatch : Figure 13 : Illustration de deux améliorations de la méthode MixMatch par la méthode ReMixMatch. (Source de l'image : article 2020 de Berthelot et al. « ReMixMatch : Apprentissage semi-supervisé utilisant l'alignement de distribution et l'ancrage amélioré ») 1. Cette méthode rend la distribution marginale Il convient de noter que la minimisation de l'entropie n'est pas un objectif utile si la distribution marginale est incohérente. De plus, l’hypothèse selon laquelle les distributions de classes sur les données étiquetées et non étiquetées correspondent est en effet trop absolue et n’est pas nécessairement correcte dans des contextes réels. 2. Ancrage d'augmentation. Étant donné un échantillon non étiqueté, une version « ancrée » faiblement améliorée est d'abord générée, puis la méthode CTAugment (Control Theory Augment) est utilisée pour calculer la moyenne de K versions fortement améliorées. CTAugment échantillonne uniquement les versions améliorées du modèle de réseau d'ordres dont les prédictions restent dans la tolérance du réseau. La perte ReMixMatch comprend les éléments suivants : d'étiquettes propres, noté ici c. Si la probabilité a posteriori du modèle de mélange gaussien (c'est-à-dire la probabilité que l'échantillon appartienne à l'ensemble d'échantillons propres) est supérieure au seuil, l'échantillon est considéré comme un échantillon propre, sinon il est considéré comme un échantillon de bruit. Le processus de regroupement de données est appelé co-division. Pour éviter les biais de confirmation, la méthode DividImax entraîne simultanément deux réseaux croisés, où chaque réseau utilise une partie distincte de l'ensemble de données de l'autre réseau, de la même manière que fonctionne le Double Q-Learning. avec la prédiction du réseau , où est la probabilité qu'un autre réseau produise un ensemble de données propre Conditions, Moyenne de plusieurs versions améliorées. Co-devination d'étiquettes : elle fait la moyenne des prédictions de deux modèles sur des échantillons de données non étiquetés. Figure 15 : Algorithme DivideMix. (Source de l'image : article 2020 de Junnan Li et al. "DivideMix : Utilisation de l'apprentissage par étiquettes bruyantes pour mettre en œuvre un apprentissage semi-supervisé") Sohn et al. "FixMatch : Utilisation de la cohérence La méthode FixMatch proposée dans « FixMatch : Simplifying Semi-Supervised Learning with Consistency and Confidence » génère des pseudo-étiquettes sur des échantillons non étiquetés via une méthode d'amélioration faible et ne maintient que des prédictions de haute confiance. Ici, à la fois une faible amélioration et un filtrage de haute confiance aident à générer des cibles de pseudo-étiquette crédibles de haute qualité. FixMatch prédit ensuite ces pseudo-étiquettes à partir d'un échantillon fortement amélioré. Figure 16 : Illustration du fonctionnement de la méthode FixMatch. (Source de l'image : article 2020 de Sohn et al. "FixMatch : Simplifier l'apprentissage semi-supervisé en utilisant la cohérence et la confiance") où Figure 17 : Performance de FixMatch et de plusieurs autres méthodes d'apprentissage semi-supervisé sur des tâches de classification d'images. (Source de l'image : article 2020 de Sohn et al. « FixMatch : Simplifier l'apprentissage semi-supervisé en utilisant la cohérence et la confiance ») Selon l'étude sur l'ablation de FixMatch, Cette approche pré-entraîne un modèle indépendant des tâches sur un vaste corpus de données non supervisées grâce à un apprentissage auto-supervisé, puis entraîne le modèle sur des tâches en aval à l'aide d'un petit ensemble de données étiquetées. . Le réglage fin, qui est un paradigme courant, notamment dans les tâches linguistiques. La recherche montre que les modèles peuvent obtenir des gains supplémentaires s’ils combinent apprentissage semi-supervisé et pré-formation. L'article de 2020 de Zoph et al. "Rethinking Pre-training and Self-training" a étudié à quel point l'auto-formation est bien plus efficace que la pré-formation. Leur configuration expérimentale consiste à utiliser ImageNet pour la pré-formation ou l'auto-formation afin d'améliorer les résultats COCO. Il est important de noter que lors de l'utilisation d'ImageNet pour l'auto-formation, il supprime les étiquettes et utilise uniquement les échantillons ImageNet comme points de données non étiquetés. He Kaiming et d'autres ont prouvé dans l'article de 2018 « Rethinking ImageNet Pre-training » que si les tâches en aval (telles que la détection de cibles) sont très différentes, l'effet de la pré-formation à la classification ImageNet n'est pas très bon. Figure 18 : (a) Résultats de l'augmentation des données (de faible à forte) et (b) impact de la taille de l'ensemble de données d'étiquettes sur les performances de détection d'objets. Dans la légende : "Rand Init" représente un modèle initialisé avec des poids aléatoires ; "ImageNet" est initialisé à l'aide d'un modèle pré-entraîné avec une précision Top-1 de 84,5 % sur l'ensemble de données ImageNet ; "ImageNet++" est initialisé à l'aide d'un modèle Top- ; 1, un taux de précision de 84,5 % sur l'ensemble de données ImageNet -1 est initialisé avec un modèle pré-entraîné avec une précision de 86,9 %. (Source de l'image : article 2020 de Zoph et al. "Rethinking Pre-training and Self-Training") Cette expérience a obtenu une série de résultats intéressants : Dans l'article de 2020 « Les grands modèles auto-supervisés sont des apprenants forts semi-supervisés » (Les grands modèles auto-supervisés sont des apprenants forts semi-supervisés), Ting Chen et al. procédure par étapes), qui combine les avantages de la pré-formation auto-supervisée, du réglage fin supervisé et de l'auto-formation : 1 Utiliser des méthodes non supervisées ou sous-supervisées pour former un grand modèle ; .Effectuer un réglage fin supervisé du modèle sur certains exemples étiquetés, où l'utilisation d'un réseau neuronal étendu (profond et large) est cruciale, car plus le modèle est grand, meilleures sont les performances avec moins d'exemples étiquetés. 3. Utilisez des pseudo-étiquettes en auto-formation pour distiller des exemples non étiquetés. a. La connaissance d'un grand modèle peut être distillée dans un petit modèle car cette utilisation spécifique à une tâche ne nécessite pas la capacité supplémentaire de la représentation apprise. b. La formule de perte de distillation est la suivante, où le réseau Enseignant est fixe et le poids est de Figure 19 : Le cadre d'apprentissage semi-supervisé utilise le sans étiquette via une pré-formation non supervisée indépendante des tâches (à gauche) et une auto-formation et une distillation spécifiques à une tâche (à droite) Corpus de données. (Source de l'image : article 2020 de Ting Chen et al. « Les modèles auto-supervisés à grande échelle sont de puissants apprenants semi-supervisés ») Les auteurs de l'article ont mené des expériences sur la tâche de classification ImageNet. Le pré-entraînement auto-supervisé utilise SimCLRv2, une amélioration directe de SimCLR. Leurs observations dans l'étude empirique ont confirmé certains des résultats proposés par Zoph et al. en 2020 : Figure 20 : Comparaison des performances de SimCLRv2 + distillation semi-supervisée sur classification ImageNet. (Source de l'image : article 2020 de Ting Chen et al. « Les modèles auto-supervisés à grande échelle sont de puissants apprenants semi-supervisés ») En résumant les récentes méthodes d'apprentissage semi-supervisé, nous pouvons constater que de nombreuses méthodes visent pour réduire le biais de confirmation :

, l'UDA peut optimiser les résultats en utilisant les trois techniques d'entraînement suivantes :

, l'UDA peut optimiser les résultats en utilisant les trois techniques d'entraînement suivantes :

, il est masqué.

, il est masqué.

dans Softmax pour affiner la distribution de probabilité de prédiction.

dans Softmax pour affiner la distribution de probabilité de prédiction.

est la valeur fixe du poids du modèle, la même que

est la valeur fixe du poids du modèle, la même que  en TVA, donc il n'y a pas de mise à jour du gradient,

en TVA, donc il n'y a pas de mise à jour du gradient,  est le point de données amélioré,

est le point de données amélioré,  est le seuil de confiance de la prédiction,

est le seuil de confiance de la prédiction,  est la répartition de la température d'affûtage.

est la répartition de la température d'affûtage. 5 Pseudo-étiquetage

(1) Propagation d'étiquettes

(2) Auto-formation

(3) Réduire le biais de confirmation (Confirmation Bias)

deux échantillons et leurs vraies étiquettes et pseudo-étiquettes correspondantes

deux échantillons et leurs vraies étiquettes et pseudo-étiquettes correspondantes , l'équation d'étiquette d'interpolation peut être transformée en perte d'entropie croisée de la sortie softmax :

, l'équation d'étiquette d'interpolation peut être transformée en perte d'entropie croisée de la sortie softmax :

et

et  respectivement. La perte du modèle Étudiant sur les échantillons étiquetés est définie en fonction de

respectivement. La perte du modèle Étudiant sur les échantillons étiquetés est définie en fonction de

, et elle tend à minimiser cette perte en conséquence en optimisant le modèle Enseignant. .

, et elle tend à minimiser cette perte en conséquence en optimisant le modèle Enseignant. .

tout en effectuant des calculs

tout en effectuant des calculs

en plusieurs étapes.

en plusieurs étapes.

, nous pouvons générer des pseudo-étiquettes via la fonction

, nous pouvons générer des pseudo-étiquettes via la fonction  et optimiser

et optimiser  en utilisant la descente de gradient stochastique en une étape :

en utilisant la descente de gradient stochastique en une étape :  .

.  , nous réutilisons les mises à jour du modèle Étudiant pour optimiser

, nous réutilisons les mises à jour du modèle Étudiant pour optimiser  :

:  . De plus, les objets UDA sont appliqués au modèle Teacher pour incorporer une régularisation cohérente.

. De plus, les objets UDA sont appliqués au modèle Teacher pour incorporer une régularisation cohérente.

6 Régularisation de cohérence + pseudo-étiquettes

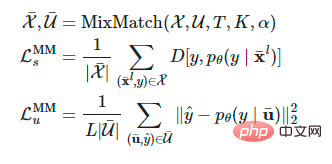

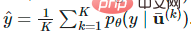

(1) MixMatch

et de données non étiquetées

et de données non étiquetées  , la version améliorée est obtenue par l'opération

, la version améliorée est obtenue par l'opération  ,

,  et

et  représentent respectivement l'échantillon amélioré et l'étiquette prédite pour l'échantillon non étiqueté.

représentent respectivement l'échantillon amélioré et l'étiquette prédite pour l'échantillon non étiqueté.

est la température de netteté, utilisée pour réduire le chevauchement des étiquettes deviné ; K est le nombre de versions améliorées générées pour chaque échantillon non étiqueté

est la température de netteté, utilisée pour réduire le chevauchement des étiquettes deviné ; K est le nombre de versions améliorées générées pour chaque échantillon non étiqueté  est un paramètre de la fonction MixMatch ; Pour chaque

est un paramètre de la fonction MixMatch ; Pour chaque  , MixMatch génère K versions améliorées,

, MixMatch génère K versions améliorées,  égales à k avec 1, ...., K versions améliorées de

égales à k avec 1, ...., K versions améliorées de  , et le modèle devine le pseudo label en fonction de la moyenne

, et le modèle devine le pseudo label en fonction de la moyenne  .

.

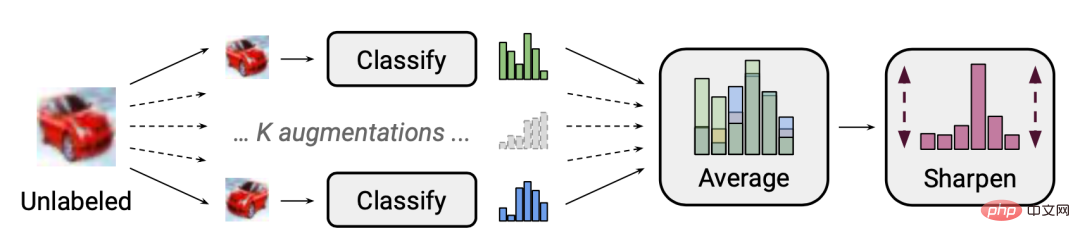

proche de la distribution marginale des étiquettes de vérité terrain. Soit

proche de la distribution marginale des étiquettes de vérité terrain. Soit  la distribution de classes des étiquettes de vérité terrain, et

la distribution de classes des étiquettes de vérité terrain, et  la moyenne mobile de la distribution de classes prédite sur des données non étiquetées. Les prédictions du modèle pour les échantillons non étiquetés

la moyenne mobile de la distribution de classes prédite sur des données non étiquetées. Les prédictions du modèle pour les échantillons non étiquetés  sont normalisées à

sont normalisées à  pour correspondre à la véritable distribution marginale.

pour correspondre à la véritable distribution marginale.

Suite à l'idée proposée par Arazo et al. . Les échantillons propres devraient subir des pertes plus faibles plus rapidement que les échantillons bruyants. Le modèle de mélange gaussien avec une moyenne plus petite correspond au regroupement

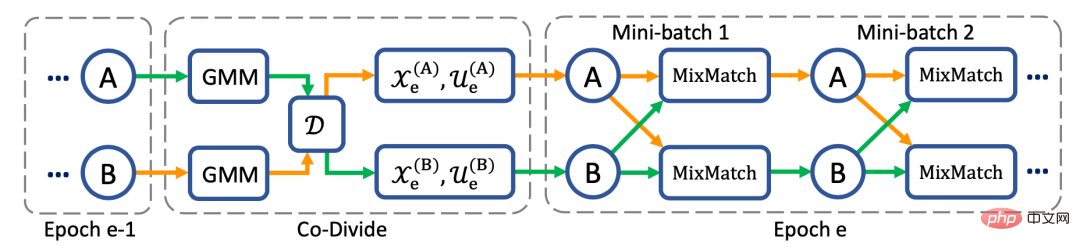

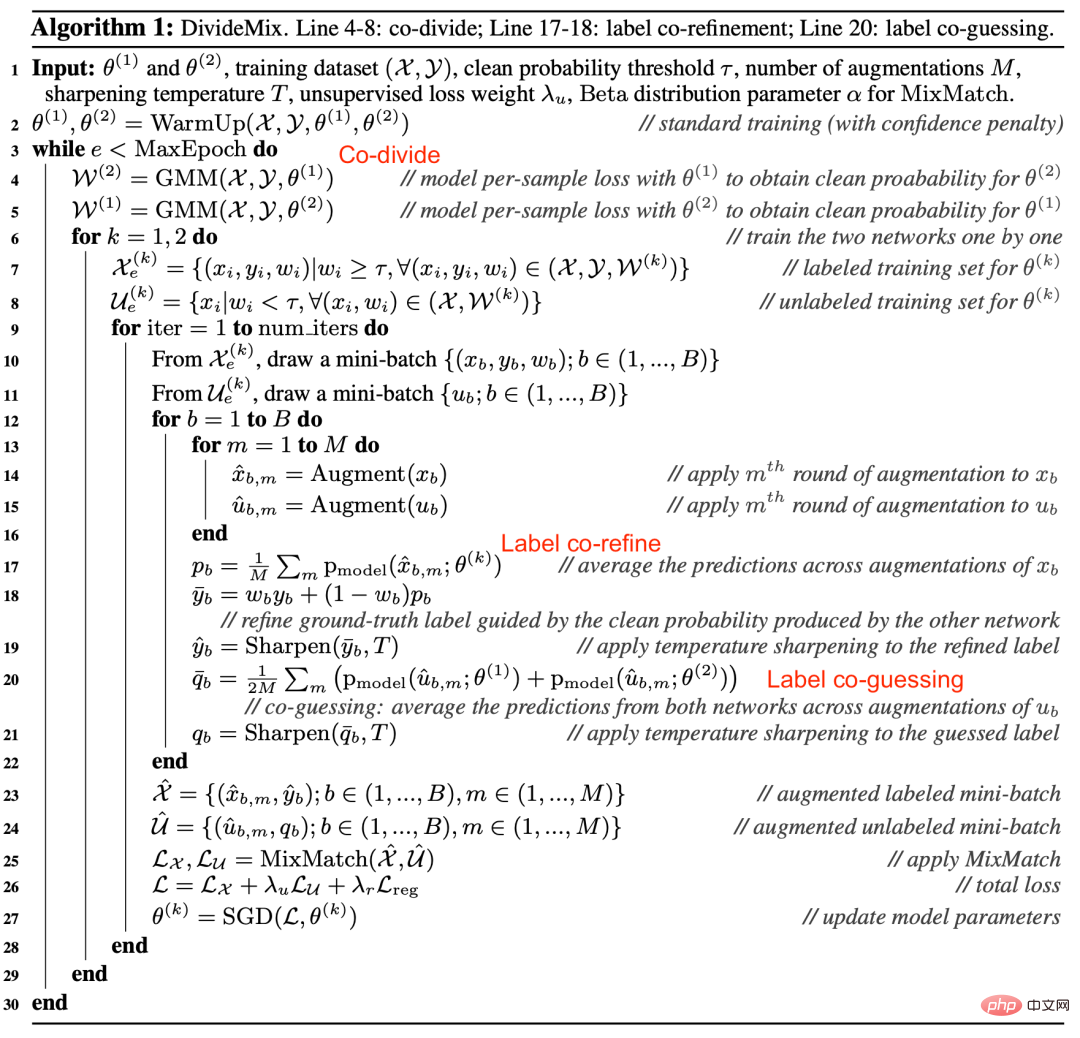

Figure 14 : DivideMix entraîne deux réseaux indépendamment pour réduire le biais de confirmation. Les deux réseaux exécutent simultanément un partitionnement collaboratif, un raffinement collaboratif et une estimation collaborative. (Source de l'image : article 2020 de Junnan Li et al. "DivideMix : Using Noisy Label Learning to Implement Semi-supervised Learning")

Figure 14 : DivideMix entraîne deux réseaux indépendamment pour réduire le biais de confirmation. Les deux réseaux exécutent simultanément un partitionnement collaboratif, un raffinement collaboratif et une estimation collaborative. (Source de l'image : article 2020 de Junnan Li et al. "DivideMix : Using Noisy Label Learning to Implement Semi-supervised Learning")

(3) Article 2020 de FixMatch

est la pseudo-étiquette de l'échantillon non étiqueté

est la pseudo-étiquette de l'échantillon non étiqueté  est le ; décision Hyperparamètres de tailles relatives de

est le ; décision Hyperparamètres de tailles relatives de  et

et  . Faible amélioration

. Faible amélioration : amélioration standard de la traduction et de la transformation. Forte amélioration

: amélioration standard de la traduction et de la transformation. Forte amélioration : méthodes d'amélioration des données telles que AutoAugment, Cutout, RandAugment et CTAugment.

: méthodes d'amélioration des données telles que AutoAugment, Cutout, RandAugment et CTAugment.

7 Combinée à un pré-entraînement puissant

.

.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI

est la représentation unique de la véritable étiquette.

est la représentation unique de la véritable étiquette.