Maison >Périphériques technologiques >IA >Dernières avancées dans les modèles clairsemés ! Ma Yi + LeCun unissent leurs forces : apprentissage non supervisé « boîte blanche »

Dernières avancées dans les modèles clairsemés ! Ma Yi + LeCun unissent leurs forces : apprentissage non supervisé « boîte blanche »

- WBOYavant

- 2023-04-12 08:34:02923parcourir

Récemment, le professeur Ma Yi et Yann LeCun, lauréat du prix Turing, ont publié conjointement un article à l'ICLR 2023, décrivant une méthode d'apprentissage non supervisé minimaliste et interprétable qui ne nécessite pas de recourir à l'amélioration des données, à l'ajustement d'hyperparamètres ou à d'autres conceptions techniques, vous pouvez atteindre des performances proches de la méthode SOTA SSL.

Lien papier : https://arxiv.org/abs/2209.15261

Cette méthode utilise la transformation multiple clairsemée pour combiner le codage clairsemé, l'apprentissage multiple et l'analyse de fonctionnalités lentes (lent analyse des caractéristiques) combinées.

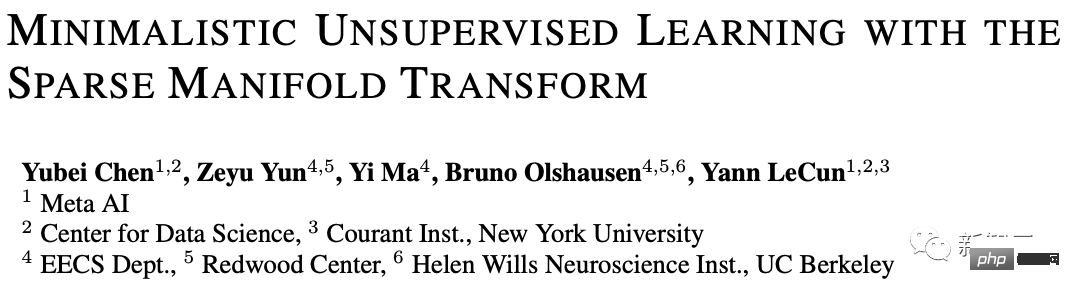

En utilisant la transformation de variété déterministe clairsemée monocouche, il peut atteindre une précision KNN top-1 de 99,3 % sur MNIST, 81,1 % de précision KNN top-1 sur CIFAR-10 et 81,1 % de précision KNN top-1 sur CIFAR-100. . A atteint une précision top-1 de 53,2 %.

Grâce à une simple amélioration des niveaux de gris, la précision du modèle sur CIFAR-10 et CIFAR-100 a atteint respectivement 83,2 % et 57 %. Ces résultats ont considérablement réduit l'écart entre la méthode simple « boîte blanche » et la méthode SOTA. .

De plus, l'article fournit également une explication visuelle de la façon de former une transformation de représentation non supervisée. Cette méthode est étroitement liée à la méthode auto-supervisée d'intégration latente et peut être considérée comme la méthode VICReg la plus simple.

Bien qu'il existe encore un petit écart de performance entre notre modèle constructif simple et l'approche SOTA, il est prouvé qu'il s'agit d'une direction prometteuse pour parvenir à un apprentissage non supervisé en boîte blanche fondé sur des principes.

Le premier auteur de l'article, Yubei Chen, est assistant postdoctoral au Center for Data Science (CDS) et Meta Basic Artificial Intelligence Research (FAIR) de l'Université de New York. Son superviseur est le professeur Yann LeCun. avec un doctorat en neurologie théorique du Redwood Center de l'Université de Californie à Berkeley et du Berkeley Artificial Intelligence Institute (BAIR), avec un baccalauréat de l'Université Tsinghua.

La principale direction de recherche est l'intersection de l'apprentissage des neurosciences computationnelles et de l'apprentissage profond non supervisé (auto-supervisé). Les résultats de la recherche améliorent la compréhension des principes informatiques de l'apprentissage des représentations non supervisé dans le cerveau et la machine, et le remodeler Une compréhension des statistiques des signaux naturels.

Le professeur Ma Yi a obtenu une double licence en automatisation et mathématiques appliquées de l'Université Tsinghua en 1995, une maîtrise en EECS de l'Université de Californie à Berkeley en 1997, ainsi qu'une maîtrise en mathématiques et un doctorat en EECS en 2000. Il est actuellement professeur au Département de génie électrique et d'informatique de l'Université de Californie à Berkeley, et est également membre de l'IEEE, de l'ACM et du SIAM.

L'œuvre la plus célèbre de Yann LeCun est l'utilisation des réseaux de neurones convolutifs (CNN) dans la reconnaissance optique de caractères et la vision par ordinateur. Il est également connu comme le père des réseaux convolutifs en 2019, lui, Bengio et Hinton ont remporté conjointement le prix le plus élevé. honneur en informatique Prix Turing Award.

Commencez par l'apprentissage non supervisé le plus simple

L'apprentissage des représentations non supervisé a fait d'énormes progrès au cours des dernières années et devrait offrir une forte évolutivité dans l'apprentissage automatique basé sur les données.

Cependant, ce qu'est une représentation apprise et comment exactement elle est formée de manière non supervisée ne sont toujours pas clairs. De plus, il n'est toujours pas clair s'il existe un ensemble commun de principes qui sous-tendent toutes ces représentations non supervisées ;

De nombreux chercheurs ont réalisé l'importance d'améliorer la compréhension des modèles et ont pris des mesures pionnières pour tenter de simplifier la méthode SOTA, d'établir des liens avec les méthodes classiques, d'unifier différentes méthodes et de visualiser les représentations, et d'analyser ces méthodes d'un point de vue théorique. , dans l'espoir de développer une théorie informatique différente : une théorie qui nous permette de construire des modèles de « boîte blanche » simples et entièrement interprétables à partir de données basées sur les premiers principes, qui peuvent également fournir un aperçu des principes de l'apprentissage non supervisé dans le cerveau humain. .

Dans ce travail, les chercheurs ont fait un petit pas de plus vers cet objectif, en essayant de construire le modèle d'apprentissage non supervisé de « boîte blanche » le plus simple qui ne nécessite pas de réseaux profonds, de têtes de projection, d'augmentation de données ou d'autres conceptions techniques diverses.

En utilisant deux principes classiques d'apprentissage non supervisé, à savoir la parcimonie et l'intégration spectrale, un modèle à deux couches est établi et obtient des résultats sur plusieurs ensembles de données standard obtenus des résultats de base non significatifs.

Les résultats expérimentaux montrent que le modèle à deux couches basé sur la transformation de variété clairsemée a le même objectif que la méthode auto-supervisée à intégration latente et atteint les meilleures performances sur MNIST sans aucune augmentation de données. La précision de niveau 1 la plus élevée de KNN est de 99,3 %, et la précision de niveau 1 la plus élevée de KNN est de 81,1 % sur CIFAR-10, et la précision est de 53,2 % sur CIFAR-100.

Grâce à une simple amélioration des niveaux de gris, nous avons en outre atteint une précision KNN top-1 de 83,2 % sur CIFAR-10 et une précision KNN top-1 de 57 % sur CIFAR-100.

Ces résultats franchissent une étape importante vers la réduction de l'écart entre les modèles de « boîte blanche » et les modèles SOTA auto-supervisés (SSL). Bien que l'écart soit encore important, les chercheurs pensent qu'en le réduisant davantage, il est possible de l'améliorer. la représentation non supervisée. Apprendre à mieux comprendre est également une voie de recherche prometteuse menant à l’application pratique de cette théorie.

Trois questions fondamentales

Qu'est-ce qu'une re-présentation non supervisée (auto-supervisée)

Essentiellement, toute transformation non identitaire du signal original est On pourrait l'appeler une re-présentation, mais les universitaires sont plus intéressés par les transformations utiles.

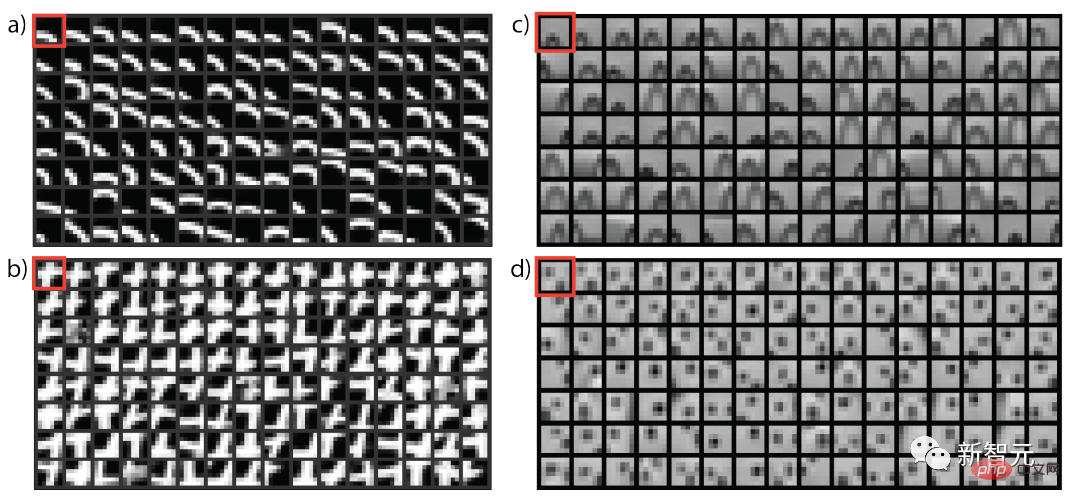

Un objectif macro de l'apprentissage par re-présentation non supervisé est de trouver une fonction qui transforme les données originales en un nouvel espace afin que les éléments « similaires » soient rapprochés en même temps, le nouvel espace ne doit pas être réduit et ; trivial, c'est-à-dire que la structure géométrique ou aléatoire des données doit être préservée.

Si cet objectif est atteint, alors les contenus « différents » seront naturellement placés loin dans l'espace de représentation.

D'où vient la similitude ?

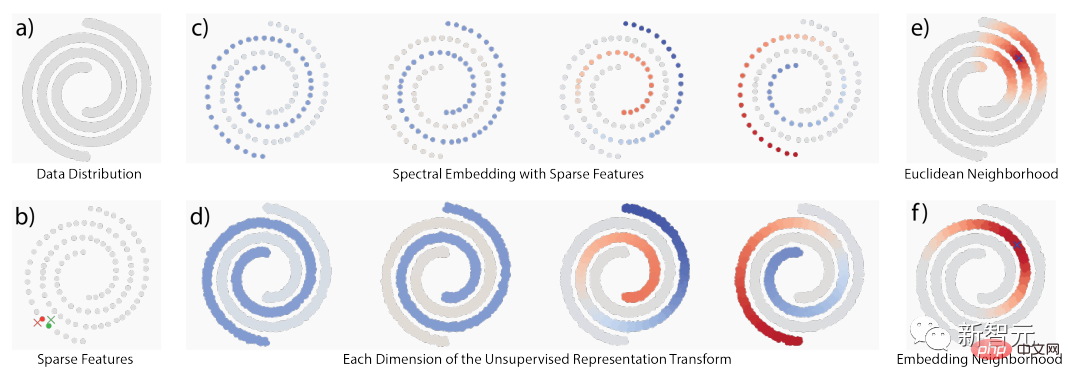

La similitude vient principalement de trois idées classiques : 1) la cooccurrence temporelle, 2) la cooccurrence spatiale et 3) les voisinages locaux dans l'espace du signal d'origine ;

Lorsque la structure sous-jacente est une structure géométrique, ces idées se chevauchent dans une mesure considérable ; mais lorsque la structure est une structure aléatoire, elles sont également conceptuellement différentes. La figure ci-dessous montre la structure multiple et la cooccurrence stochastique. structure.

En utilisant la localité, des travaux connexes proposent deux méthodes d'apprentissage non supervisé : l'apprentissage multiple et la modélisation statistique de cooccurrence Beaucoup de ces idées ont atteint la formulation d'une décomposition de lignée ou de matrices étroitement liées Décomposer l'expression.

Le concept d'apprentissage multiple est que seuls les quartiers locaux dans l'espace de signal d'origine sont crédibles. En considérant globalement tous les quartiers locaux, une géométrie globale émergera, c'est-à-dire une « pensée globale, adaptation locale » (penser globalement, s'adapter localement). ).

En revanche, la modélisation statistique de cooccurrence suit un concept probabiliste, car certaines structures ne peuvent pas être modélisées avec des variétés continues, elle est donc également complémentaire au concept de variété.

L'un des exemples les plus évidents vient du langage naturel, où les données originales ne proviennent fondamentalement pas d'une géométrie lisse. Par exemple, dans les intégrations de mots, les intégrations de "Seattle" et "Dallas" peuvent même être très similaires. bien qu’ils ne le soient pas, la raison fondamentale de leur cooccurrence fréquente est qu’ils ont des modèles de contexte similaires.

Les perspectives de probabilité et de variété sont complémentaires dans la compréhension de la « similarité ». Une fois qu'il existe une définition de la similarité, une transformation peut être construite pour rapprocher les concepts similaires.

Comment établir la transformation des représentations dans cet article ? Principes de base : parcimonie et rang bas

De manière générale, la parcimonie peut être utilisée pour gérer la localité et la décomposition dans l'espace de données afin d'établir un support, puis les fonctions basse fréquence sont utilisées pour construire des transformations de représentation pour transformer des valeurs similaires. affecté au point de similarité sur support.

L'ensemble du processus peut également être appelé transformation de variété clairsemée.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI