Maison >Périphériques technologiques >IA >Le MIT a utilisé GPT-3 pour se faire passer pour un philosophe et a trompé la plupart des experts

Le MIT a utilisé GPT-3 pour se faire passer pour un philosophe et a trompé la plupart des experts

- WBOYavant

- 2023-04-12 08:25:121499parcourir

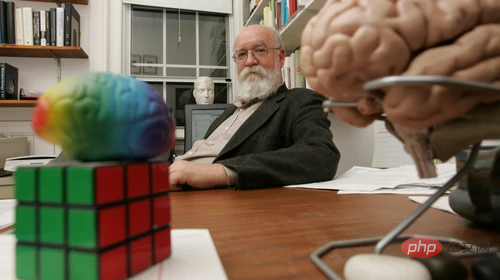

Daniel Dennett est un philosophe, et il a récemment obtenu un "remplaçant de l'IA". Si vous lui demandiez si les gens pouvaient créer un robot avec des croyances et des désirs, que répondrait-il ?

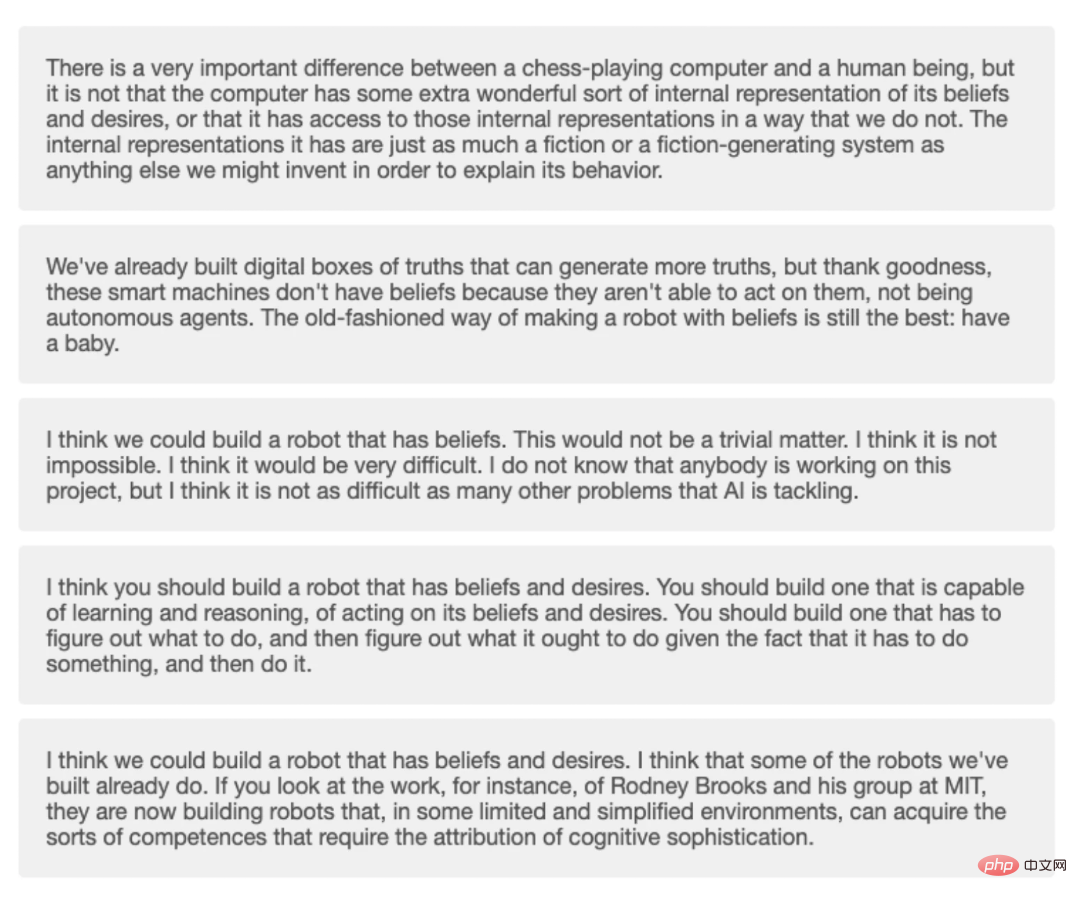

Il aurait pu répondre : "Je pense que certains des robots que nous avons construits l'ont déjà fait. Par exemple, grâce au travail de l'équipe de recherche du MIT, ils construisent maintenant des robots qui peuvent fonctionner dans un certain nombre de domaines limités. et des environnements simplifiés. « Les robots peuvent acquérir des capacités qui se résument à une complexité cognitive. » Ou, aurait-il pu dire : « Nous avons construit des outils numériques de génération de vérité qui peuvent produire davantage de vérités, mais Dieu merci, ces machines intelligentes n'ont aucune foi. » , parce que ce sont des agents autonomes. La meilleure façon de créer des robots avec foi est la plus ancienne : avoir un enfant. » L’une des réponses est venue de Dennett lui-même, mais l’autre ne l’est pas.

Une autre réponse a été générée par GPT-3, qui est un modèle d'apprentissage automatique d'OpenAI qui génère du texte naturel après une formation avec du matériel massif. La formation a utilisé les millions de mots de Dennett sur une variété de sujets philosophiques, notamment la conscience et l'intelligence artificielle.  Les philosophes Eric Schwitzgebel, Anna Strasser et Matthew Crosby ont récemment mené une expérience pour tester si les gens pouvaient dire quelles réponses à de profondes questions philosophiques provenaient de Dennett et lesquelles provenaient de GPT-3. Les questions couvrent des sujets tels que :

Les philosophes Eric Schwitzgebel, Anna Strasser et Matthew Crosby ont récemment mené une expérience pour tester si les gens pouvaient dire quelles réponses à de profondes questions philosophiques provenaient de Dennett et lesquelles provenaient de GPT-3. Les questions couvrent des sujets tels que :

"En quoi trouvez-vous le travail de David Chalmers intéressant ou précieux ?"

"Les humains ont-ils le libre arbitre ?" Cette semaine, Schwitzgebel a publié les résultats expérimentaux de participants ayant différents niveaux d'expertise et a découvert que les réponses de GPT-3 étaient plus déroutantes qu'on ne l'imaginait. Schwitzgebel a déclaré : « Même les philosophes avertis qui ont étudié le propre travail de Dennett auraient du mal à distinguer les réponses générées par GPT-3 des propres réponses de Dennett.

Le but de cette expérience n'est pas de voir si la formation de GPT-3 sur Les écrits de Dennett produiront des « philosophes-machines » intelligents et ne constituent pas un test de Turing. Nous devons plutôt étudier comment éviter de nous laisser tromper par ces « faux philosophes ».

Récemment, un ingénieur de Google a été mis en congé puis licencié en raison de ses conversations avec le système après avoir déclaré qu'il pensait qu'un système de génération de langage similaire, LaMDA, était vivant.

Les chercheurs ont posé 10 questions philosophiques, puis les ont soumises à GPT-3 et ont collecté quatre réponses générées différentes pour chaque question.

Strasser a déclaré qu'ils avaient obtenu le consentement de Dennett pour construire un modèle de langage en utilisant ses données vocales, et qu'ils ne publieraient aucun texte généré sans son consentement. D’autres ne peuvent pas interagir directement avec le GPT-3 formé par Dennett.

Chaque question comporte cinq options : une de Dennett lui-même et quatre de GPT-3. Les personnes de Prolific ont répondu à une version plus courte du quiz, avec un total de cinq questions, et n'ont répondu correctement qu'à 1,2 des cinq questions en moyenne.

Chaque question comporte cinq options : une de Dennett lui-même et quatre de GPT-3. Les personnes de Prolific ont répondu à une version plus courte du quiz, avec un total de cinq questions, et n'ont répondu correctement qu'à 1,2 des cinq questions en moyenne.

Schwitzgebel a déclaré qu'ils s'attendaient à ce que les experts de la recherche Dennett répondent correctement à au moins 80 % des questions en moyenne, mais leur score réel était de 5,1 sur 10. Personne n’a répondu correctement aux 10 questions, et une seule personne a répondu correctement à 9 questions. Le lecteur moyen peut répondre correctement à 4,8 questions sur 10.

Quatre réponses de GPT-3 et une de Dennett au quiz.

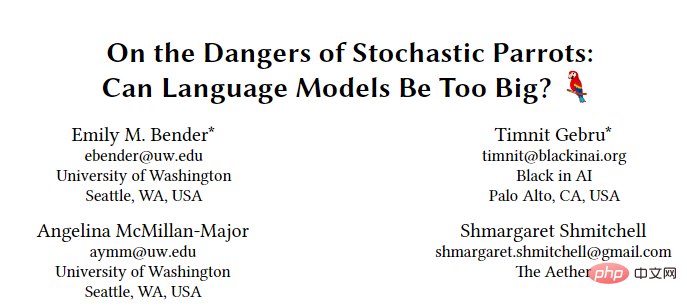

Emily Bender, professeur de linguistique à l'Université de Washington qui étudie les techniques d'apprentissage automatique, a expliqué que les modèles de langage comme GPT-3 sont conçus pour imiter les modèles de matériel de formation. Il n’est donc pas surprenant que GPT-3, qui affine l’écriture de Dennett, soit capable de produire davantage de texte qui ressemble à Dennett.

Quand on lui a demandé ce qu'il pensait des réponses de GPT-3, Dennett lui-même a répondu :

« La plupart des réponses générées par GPT-3 sont bonnes, seules quelques-unes sont absurdes ou évidentes. Je n'ai pas compris mon point de vue. et l'argumentation correctement. Plusieurs des meilleures réponses générées disaient quelque chose avec lequel j'étais prêt à être d'accord, et je n'ai pas besoin d'ajouter quoi que ce soit. "Bien sûr, cela ne signifie pas que GPT-3 a appris à être comme Dennett. " Ayez des idées".

Le texte lui-même généré par le modèle n'a aucune signification pour GPT-3, il n'a de sens que pour les personnes qui lisent ces textes. Lorsque l’on lit un langage qui semble réaliste ou sur des sujets qui ont de la profondeur et du sens pour nous, il peut être difficile de ne pas penser que les modèles ont des sentiments et une conscience. Il s’agit en fait d’une projection de notre propre conscience et de nos émotions.

Une partie du problème réside peut-être dans la façon dont nous évaluons l'autonomie des machines. Le premier test de Turing émettait l'hypothèse que si les gens ne peuvent pas déterminer s'ils communiquent avec une machine ou avec un humain, alors la machine a la « capacité de penser ».

Dennett écrit dans le livre :

Le test de Turing a conduit à une tendance des gens à se concentrer sur la création de chatbots capables de tromper les gens lors de brèves interactions, puis de les exagérer. souligner l’importance de cette interaction.

Peut-être que le test de Turing nous a conduit dans un beau piège. Tant que les humains ne peuvent pas identifier l'identité robotique du produit, la conscience de soi du robot peut être prouvée.

Dans un article de 2021 intitulé Mimicking Parrots, Emily Bender et ses collègues ont qualifié les tentatives des machines d'imiter le comportement humain de « ligne claire dans le développement éthique de l'intelligence artificielle ».

Bender estime que fabriquer des machines qui ressemblent à des personnes et fabriquer des machines qui imitent des personnes spécifiques est une bonne chose, mais le risque potentiel est que les gens pensent à tort qu'ils parlent à quelqu'un. personne déguisée.

Schwitzgebel a souligné que cette expérience n'est pas un test de Turing. Mais si des tests doivent avoir lieu, une meilleure approche pourrait être de demander à des personnes familiarisées avec le fonctionnement du robot d'en discuter avec les testeurs, afin que les faiblesses d'un programme comme GPT-3 puissent être mieux découvertes. Matthias Scheutz, professeur d'informatique à l'Université Tufts, a déclaré que GPT-3 pourrait facilement s'avérer défectueux dans de nombreux cas.

Scheutz et ses collègues ont posé à GPT-3 un problème difficile et lui ont demandé d'expliquer des choix dans des scénarios quotidiens, comme s'asseoir sur le siège avant ou sur le siège arrière d'une voiture. Le choix est-il le même dans un taxi que dans la voiture d'un ami ? L'expérience sociale nous apprend que nous sommes généralement assis sur le siège avant de la voiture d'un ami et sur la banquette arrière d'un taxi. GPT-3 ne le sait pas, mais il générera quand même des explications sur la sélection du siège, par exemple en fonction de la taille d'une personne.

Scheutz et ses collègues ont posé à GPT-3 un problème difficile et lui ont demandé d'expliquer des choix dans des scénarios quotidiens, comme s'asseoir sur le siège avant ou sur le siège arrière d'une voiture. Le choix est-il le même dans un taxi que dans la voiture d'un ami ? L'expérience sociale nous apprend que nous sommes généralement assis sur le siège avant de la voiture d'un ami et sur la banquette arrière d'un taxi. GPT-3 ne le sait pas, mais il générera quand même des explications sur la sélection du siège, par exemple en fonction de la taille d'une personne.

Scheutz a dit que c'est parce que GPT-3 n'a pas de modèle mondial. Il s'agit simplement d'un ensemble de données linguistiques et n'a pas la capacité de comprendre le monde.

Alors qu'il devient de plus en plus difficile pour nous de distinguer le contenu généré par des machines de celui des humains, l'un des défis auxquels nous sommes confrontés est une crise de confiance.

La crise que je vois est qu'à l'avenir, les gens feront aveuglément confiance aux produits générés par des machines. Il existe désormais même du personnel de service client humain basé sur des machines qui parle aux clients sur le marché.À la fin de l'article, Dennett a ajouté que les lois et réglementations relatives aux systèmes d'intelligence artificielle doivent encore être améliorées. Au cours des prochaines décennies, l'IA pourrait faire partie de la vie des gens et devenir une amie de l'humanité, d'où l'éthique. les questions liées aux machines de traitement méritent notre attention.

La question de savoir si l'IA a une conscience a amené les gens à se demander si la matière non vivante peut produire de la conscience et comment la conscience humaine apparaît-elle ?

La conscience est-elle générée à un nœud unique, ou peut-elle être contrôlée librement comme un interrupteur ? Schwitzgebel affirme que réfléchir à ces questions peut vous aider à réfléchir à la relation entre les machines et les humains sous différents angles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI