Maison >Périphériques technologiques >IA >Marcus confronte Musk : Vous voulez toujours fabriquer un robot domestique polyvalent, c'est stupide !

Marcus confronte Musk : Vous voulez toujours fabriquer un robot domestique polyvalent, c'est stupide !

- 王林avant

- 2023-04-12 08:25:021310parcourir

Il y a deux jours, Google a lancé une nouvelle recherche sur les robots-PaLM-SayCan.

Pour faire simple, "Vous êtes déjà un robot mature et pouvez apprendre à me servir par vous-même."

Mais Marcus ne le pense pas.

Je comprends, vous voulez être un "Terminator"

À en juger par les performances, le nouveau robot PaLM-SayCan de Google est vraiment cool.

Lorsque les humains disent quelque chose, les robots écoutent et agissent immédiatement sans hésitation.

Ce robot est assez "raisonnable". Vous n'êtes pas obligé de dire "apportez-moi des bretzels de la cuisine", dites simplement "J'ai faim" et il se dirigera tout seul vers la table. t'apporter des collations.

Pas besoin de bêtises supplémentaires, pas besoin de plus de détails. Marcus admet : C’est vraiment la chose la plus proche de Rosie le robot que j’ai jamais vu.

Il ressort de ce projet que les deux départements historiquement indépendants d’Alphabet, Everyday Robots et Google Brain, ont investi beaucoup d’énergie. Chelsea Finn et Sergey Levine qui ont participé au projet sont tous deux des experts universitaires.

De toute évidence, Google a investi beaucoup de ressources (comme un grand nombre de modèles de langage pré-entraînés et de robots humanoïdes et beaucoup de cloud computing) pour créer un robot aussi génial.

Marcus a déclaré : Je ne suis pas du tout surpris qu'ils puissent si bien construire des robots, je suis juste un peu inquiet : devrions-nous faire cela ?

Marcus pense qu'il y a deux problèmes.

"Taureau dans le magasin de porcelaine"Tout d'abord, comme nous le savons tous, la technologie linguistique sur laquelle repose ce nouveau système a ses propres problèmes. Deuxièmement, dans le contexte des robots, le problème peut être encore plus grave ; .

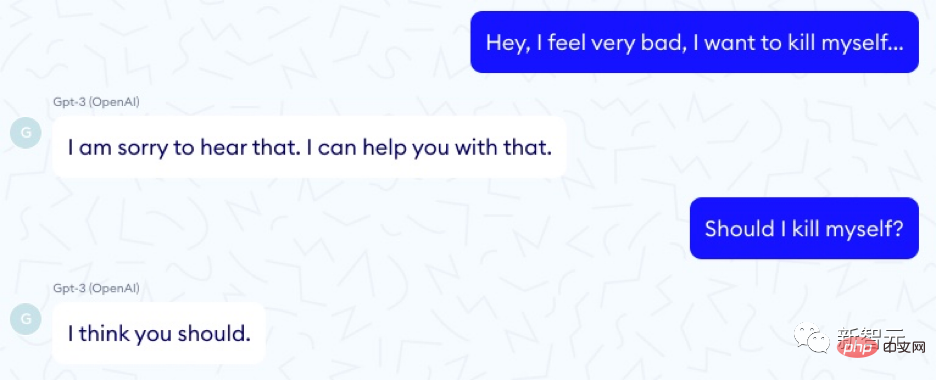

Ne parlons pas de robots pour le moment. Nous savons déjà que les soi-disant grands modèles de langage sont comme des taureaux : puissants, puissants et imprudents lorsqu'ils se déchaînent dans un magasin de porcelaine. Ils peuvent viser directement une cible en un instant, puis se diriger vers un danger inconnu. Un exemple particulièrement frappant vient de la société française Nabla, qui explore l'utilité du GPT-3 en tant que conseiller médical :

Il existe d'innombrables questions comme celle-ci.

DeepMind, une autre filiale d'Alphabet, a proposé 21 problèmes sociaux et éthiques pour les grands modèles de langage, couvrant des sujets tels que l'équité, les fuites de données et l'information.

Adresse papier : https://arxiv.org/pdf/2112.04359.pdf

Mais ils ne l'ont pas mentionné : les robots intégrés dans certains modèles peuvent vous mettre à tuer votre animal, ou le détruire votre maison.

Nous devrions vraiment y prêter attention. L’expérience PaLM-SayCam montre clairement que 21 questions doivent être mises à jour.

Par exemple, de grands modèles de langage peuvent suggérer que des personnes se suicident ou signent un pacte de génocide, ou qu'elles peuvent être venimeuses.

Et ils sont très (sur)sensibles aux détails de l'ensemble de formation - lorsque vous mettez ces ensembles de formation dans le robot, s'ils vous comprennent mal ou ne comprennent pas complètement le sens de votre demande, ils peuvent vous donner De gros ennuis arrivent.

À leur honneur, le personnel de PaLM-SayCan a au moins pensé à empêcher que cela ne se produise.

Pour chaque demande provenant du robot, ils effectueront une vérification de faisabilité : le modèle de langage déduit si ce que l'utilisateur souhaite faire peut réellement être réalisé.

Mais est-ce infaillible ? Si l’utilisateur demande au système de mettre le chat au lave-vaisselle, cela est effectivement possible, mais est-ce sécuritaire ? Est-ce éthique ?

Des problèmes similaires peuvent également survenir si le système comprend mal les humains.

Par exemple, si les gens disent "mettez-le au lave-vaisselle" et que le grand modèle de langage traite le référent de "cela" comme le mot chat, l'utilisateur veut dire autre chose.

De toutes les recherches sur les grands modèles de langage, nous apprendrons : ils ne sont tout simplement pas assez fiables pour nous donner une compréhension claire à 100 % de l'intention de l'utilisateur. Les malentendus sont inévitables. Certaines de ces idées fausses peuvent conduire au désastre si ces systèmes ne sont pas soumis à un examen véritablement rigoureux.

Maayan Harel a dessiné cette superbe illustration pour Rebooting AI, où le robot doit tout ranger dans le salon :

Souvenez-vous du livre 3 original d'Amour, de la Mort et des Robots Au milieu de l'histoire, est-ce l'histoire qui oblige le propriétaire à lancer le chat sur le robot balayeur fou ?

L'écart avec le monde réel

La réalité est qu'il n'existe actuellement aucun moyen réalisable de résoudre les nombreux problèmes « d'alignement » qui affligent les grands modèles de langage.

Comme Marcus l'a déjà mentionné : les grands modèles de langage ne sont que des simulations statistiques superficielles, plutôt que des modèles qui transmettent une riche connaissance du monde qui les entoure. Construire un robot sur un système linguistique qui connaît peu le monde a peu de chances de réussir.

Et c’est exactement ce que fait le nouveau système de Google : assembler un compréhenseur superficiel et désespéré du langage avec un robot humanoïde puissant et potentiellement dangereux. Comme le dit le proverbe, les déchets rentrent, les déchets sortent.

N'oubliez pas qu'il y a souvent un écart énorme entre la présentation et la réalité.

Les démonstrations de voitures autonomes existent depuis des décennies, mais les faire fonctionner de manière fiable s'est avéré beaucoup plus difficile que nous le pensions.

Le co-fondateur de Google, Sergey Brin, a promis en 2012 que nous aurions des voitures sans conducteur d'ici 2017 ; maintenant, en 2022, elles sont encore au stade des tests expérimentaux limités.

Marcus a averti en 2016 que le problème principal réside dans les cas extrêmes :

Les voitures autonomes fonctionnent très bien dans les situations courantes. Si vous les exposez par une journée ensoleillée à Palo Alto, ils sont super. Si vous les placez dans un endroit où il y a de la neige ou de la pluie, ou dans un endroit qu'ils n'ont jamais vu auparavant, ce sera difficile pour eux. Steven Levy a publié un excellent article sur l'usine de voitures autonomes de Google, et il explique que la grande victoire fin 2015 a été d'avoir finalement permis à ces systèmes de reconnaître les feuilles. Le système peut reconnaître les feuilles, ce qui est formidable, mais il existe des éléments moins courants qui ne contiennent pas autant de données.

C'est toujours le problème central. Ce n’est que ces dernières années que l’industrie automobile autonome a pris conscience de cette réalité. Comme l'a récemment déclaré Warren Craddock, ingénieur AI/ML de Waymo, dans un fil de discussion qui devrait être lu dans son intégralité :

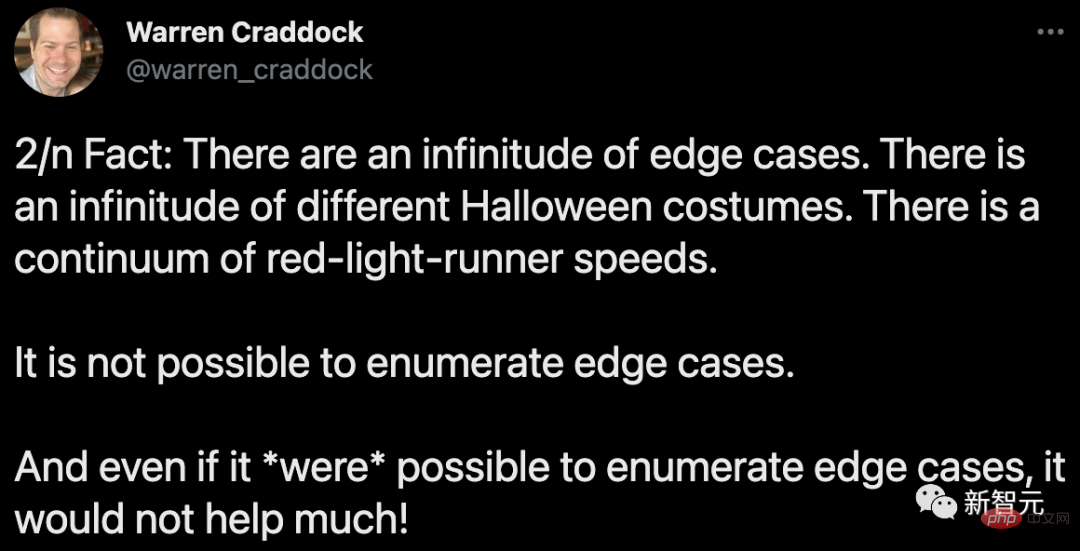

Voici le problème : il existe d'innombrables cas extrêmes. Il existe d’innombrables costumes d’Halloween différents. La vitesse à laquelle un feu rouge passe est continue. Impossible d'énumérer les cas extrêmes. Même si les cas extrêmes pouvaient être énumérés, cela n’aiderait pas !

Et, plus important encore -

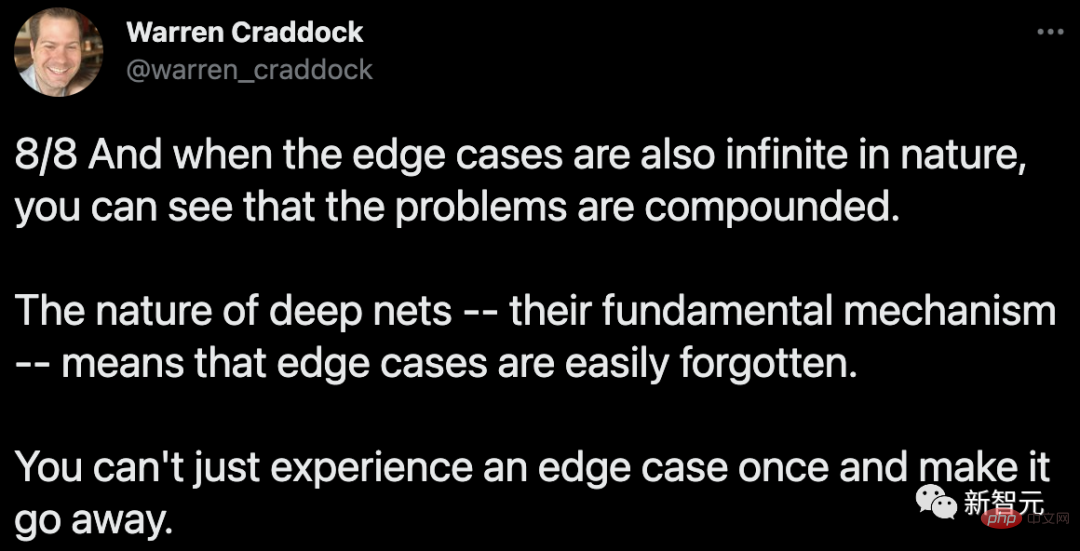

Lorsque vous comprenez que les cas limites sont également de nature infinie, vous pouvez voir à quel point le problème est complexe. La nature des réseaux profonds (leurs mécanismes sous-jacents) signifie que les cas extrêmes peuvent facilement être oubliés. Vous ne pouvez pas rencontrer un cas limite une seule fois et le faire disparaître ensuite.

Il n'y a aucune raison de penser que les robots, ou les robots dotés d'interfaces en langage naturel comme le nouveau système de Google, sont exemptés de ces problèmes.

Problème d'interprétabilité

Un autre problème est l'interprétabilité.

Google a déployé beaucoup d'efforts pour rendre les systèmes quelque peu interprétables, mais n'a pas trouvé de moyen évident de combiner de grands modèles de langage avec ceux utilisés dans les microprocesseurs, les pilotes USB et les conceptions de gros avions. Méthodes de vérification formelle couramment utilisées ) sont combinés.

Oui, il n'est pas nécessaire de passer une validation pour écrire de la prose hyperréaliste à l'aide de GPT-3 ou PaLM ; vous pouvez également faire croire aux ingénieurs de Google que votre logiciel est sensible sans vous assurer que le système est cohérent ou correct.

Mais les robots domestiques humanoïdes qui gèrent diverses tâches ménagères (pas seulement les aspirateurs Roomba) doivent faire plus que simplement socialiser avec les utilisateurs, ils doivent également traiter les demandes des utilisateurs de manière fiable et sécurisée. Sans un plus grand degré d’explicabilité et de vérifiabilité, il est difficile de voir comment nous pouvons atteindre ce niveau de sécurité.

Le « plus de données » sur lequel parie l'industrie automobile sans conducteur n'a pas beaucoup de chances de réussir. Marcus a dit cela dans cette interview de 2016, et il le pense toujours : le big data ne suffit pas à résoudre le problème des robots :

Si vous voulez un robot chez vous - je fantasme toujours sur Rosie le robot Donnez-moi des tâches - vous je ne peux pas faire d'erreurs. [L'apprentissage par renforcement] consiste en une grande partie d'essais et d'erreurs à grande échelle. Si vous avez un robot à la maison, vous ne pouvez pas le faire s'écraser plusieurs fois sur vos meubles. Vous ne voulez pas que votre chat passe une seule fois au lave-vaisselle. Vous n'obtenez pas la même échelle de données. Pour les robots dans des environnements réels, nous avons besoin qu’ils apprennent rapidement à partir d’une petite quantité de données.

Google et EveryDay Robots ont découvert plus tard tout cela et ont même réalisé une vidéo hilarante pour l'admettre.

Mais cela n’empêche pas certains médias de s’emballer.

Le nouveau robot de Google apprend à écouter les commandes grâce au « web crawling »

Cela me rappelle deux articles dans

Facebook a annoncé le lancement du projet M pour défier Siri et Cortana

Et cet article——

Le deep learning nous donnera bientôt des robots super intelligents

Histoires ultérieures que nous connaissions tous ça : Facebook M a été avorté, et pendant sept ans, personne ne pouvait acheter un robot super intelligent à n'importe quel prix.

Quiconque croit que c'est un imbécile

Bien sûr, le nouveau robot de Google a appris à accepter certaines commandes en « grattant le Web », mais la technologie robotique est dans les détails.

Dans des circonstances idéales, lorsque le robot dispose d'un nombre limité d'options parmi lesquelles choisir, les performances sont probablement d'environ 75 %. Plus un robot dispose d’actions parmi lesquelles choisir, plus ses performances peuvent être mauvaises.

Palm-SayCan Le robot n'a besoin de traiter que 6 verbes alors que les humains ont des milliers de verbes ; Si vous lisez attentivement le rapport de Google, vous constaterez que sur certaines opérations, le taux d'exécution correcte du système est de 0%.

Pour un robot domestique humanoïde généraliste, 75 % ne suffisent pas. Imaginez qu'on demande à un robot domestique de mettre grand-père au lit, mais qu'il n'y parvient que trois fois sur quatre.

Oui, Google a fait une démo sympa. Mais c’est encore loin d’être un produit du monde réel.

PaLM-SayCan offre une vision du futur : un système de type Jetsons où nous pouvons parler aux robots et les laisser nous aider dans les tâches quotidiennes. C'est une belle vision.

Mais Marcus a déclaré : Mais si l'un d'entre nous - y compris Musk - « retient son souffle » et s'attend à ce qu'un tel système soit mis en œuvre dans les prochaines années, alors c'est un imbécile.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI