Maison >Périphériques technologiques >IA >En utilisant CNN comme modèle de base, la convolution déformable InternImage réalise un nouveau record en matière de détection et de segmentation !

En utilisant CNN comme modèle de base, la convolution déformable InternImage réalise un nouveau record en matière de détection et de segmentation !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-12 08:19:081957parcourir

Le développement fulgurant des transformateurs visuels à grande échelle ces dernières années a repoussé les limites des performances dans le domaine de la vision par ordinateur. Les modèles Vision Transformer battent les réseaux de neurones convolutifs en augmentant le nombre de paramètres du modèle et de données d'entraînement. Des chercheurs du laboratoire d'intelligence artificielle de Shanghai, de l'université Tsinghua, de Nanda, de SenseTime et de Hong Kong chinois ont résumé les écarts entre les réseaux neuronaux convolutifs et les transformateurs visuels. Au niveau de l'opérateur, les opérateurs de CNN traditionnels manquent de dépendances longue distance et de capacités d'agrégation spatiale adaptative. Au niveau structurel, les structures de CNN traditionnelles manquent de composants avancés ;

Compte tenu des problèmes techniques ci-dessus, Des chercheurs du laboratoire Pujiang, de l'université Tsinghua et d'autres institutions ont proposé de manière innovante un modèle à grande échelle basé sur des réseaux neuronaux convolutifs, appelé InternImage, qui utilise la convolution dynamique clairsemée comme sous-calcul de base. , réalisant une agrégation spatiale adaptative en saisissant des informations pertinentes comme condition. InternImage permet d'apprendre des modèles de paramètres à grande échelle plus puissants et plus robustes à partir de données massives en réduisant le biais inductif strict des CNN traditionnels. Son efficacité a été vérifiée sur des tâches visuelles incluant la classification d'images, la détection d'objets et la segmentation sémantique. Il a obtenu des résultats compétitifs dans des ensembles de données de référence exigeants, notamment ImageNet, COCO et ADE20K. Au même niveau de paramètres, il a dépassé la structure visuelle du Transformer et a fourni une nouvelle direction pour les grands modèles d'images.

- Lien papier : https://arxiv.org/abs/2211.05778

- Code source ouvert : https://github.com/OpenGVLab/InternImage

Limitations des réseaux de neurones convolutifs traditionnels

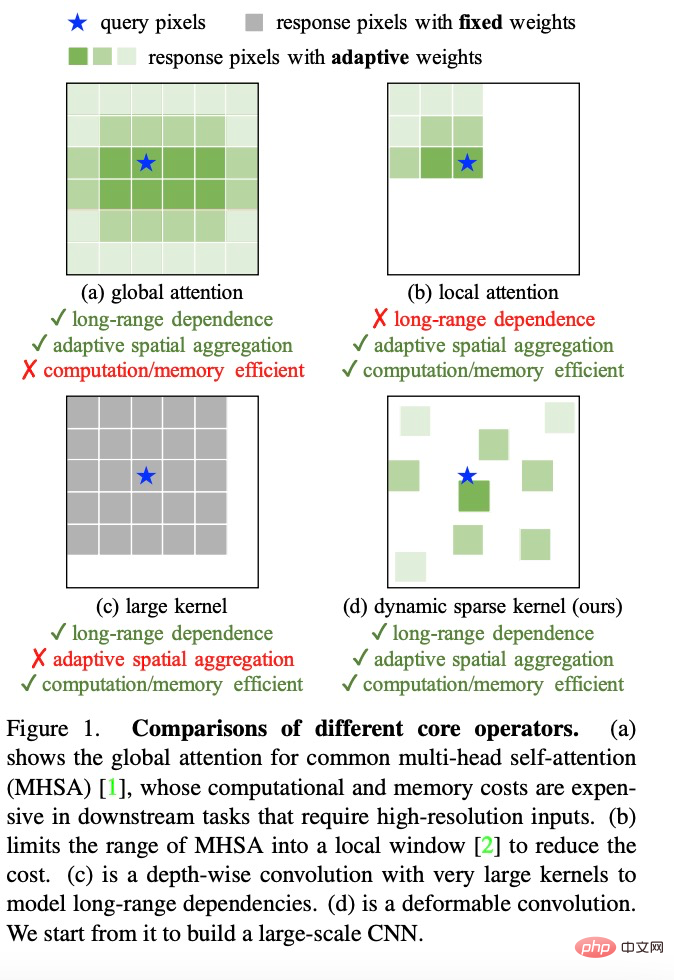

L'expansion de l'échelle du modèle est une stratégie importante pour améliorer la qualité de la représentation des caractéristiques. Dans le domaine de la vision par ordinateur, l'augmentation du nombre de paramètres du modèle peut non seulement améliorer efficacement. la capacité d'apprentissage des représentations des modèles profonds, mais aussi Réaliser l'apprentissage et l'acquisition de connaissances à partir de données massives. ViT et Swin Transformer ont étendu pour la première fois le modèle de profondeur à 2 milliards et 3 milliards de niveaux de paramètres. La précision de classification de leurs modèles uniques dans l'ensemble de données ImageNet a également dépassé 90 %, dépassant de loin le réseau CNN traditionnel et les modèles à petite échelle. briser le goulot d'étranglement technique. Cependant, en raison du manque de capacités de modélisation de dépendances à longue distance et de relations spatiales, les modèles CNN traditionnels ne peuvent pas atteindre des capacités d'expansion à l'échelle du modèle similaires à la structure Transformer. Les chercheurs ont résumé les différences entre le réseau neuronal convolutif traditionnel et le transformateur visuel :

(1) Au niveau de l'opérateur, le mécanisme d'attention multi-têtes du transformateur visuel a des dépendances à longue distance et des capacités d'agrégation spatiale adaptatives, bénéficiant À partir d'ici, le transformateur visuel peut apprendre des représentations plus puissantes et plus robustes à partir de données massives que le réseau CNN.

(2) Du point de vue de l'architecture du modèle, en plus du mécanisme d'attention multi-têtes, le transformateur visuel dispose de modules plus avancés que le réseau CNN ne possède pas, tels que la normalisation des couches (LN), le réseau neuronal à action directe FFN, GELU, etc.

Bien que certains travaux récents tentent d'utiliser de grandes convolutions du noyau pour obtenir des dépendances longue distance, ils sont encore loin des transformateurs visuels de pointe en termes d'échelle et de précision du modèle.

Poursuite de l'expansion des réseaux convolutifs déformables

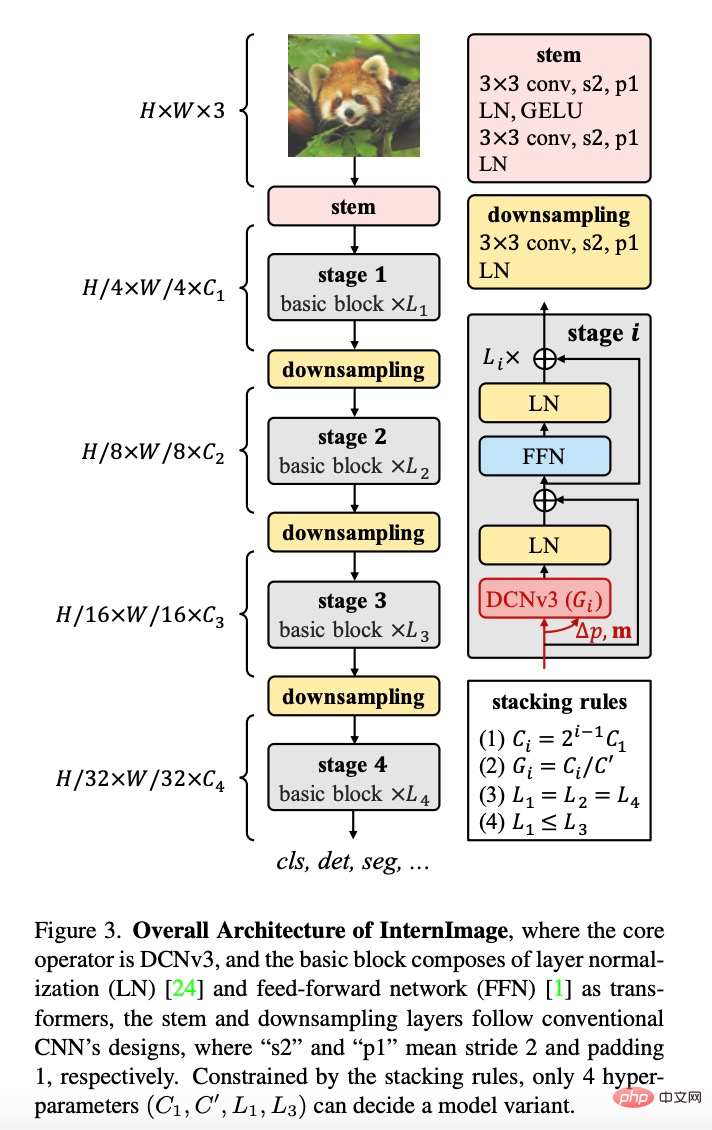

InternImage améliore l'évolutivité des modèles convolutifs et atténue le biais inductif en repensant les opérateurs et les structures de modèle, y compris (1) l'opérateur DCNv3, basé sur l'opérateur DCNv2. Sub-introduit des poids de projection partagés, multi- mécanismes de groupe et modulation de points d'échantillonnage. (2) Module de base, intégrant des modules avancés comme unité de module de base pour la construction de modèles (3) Règles d'empilement de modules, standardisant la largeur, la profondeur, le nombre de groupes et d'autres hyper-paramètres du modèle lors de l'expansion du modèle.

Ce travail se concentre sur la construction d'un modèle CNN capable de s'adapter efficacement à des paramètres à grande échelle. Premièrement, l'opérateur de convolution déformable DCNv2 est repensé pour s'adapter aux dépendances à longue distance et affaiblir le biais inductif ; puis, l'opérateur de convolution ajusté est combiné avec des composants avancés pour enfin établir un module unitaire de base, explorer et mettre en œuvre des règles d'empilement et de mise à l'échelle des modules ; construire un modèle de base avec des paramètres à grande échelle et des représentations puissantes peut être appris à partir de données massives.

Au niveau de l'opérateur, cette étude résume d'abord les principales différences entre l'opérateur de convolution et les autres opérateurs grand public. Les modèles actuels de la série Transformer s'appuient principalement sur le mécanisme d'auto-attention multi-têtes pour réaliser une construction de modèles à grande échelle. Ses opérateurs ont des dépendances longue distance, qui sont suffisantes pour construire des relations de connexion entre les entités longue distance, et disposent également d'une agrégation adaptative spatiale. capacités pour réaliser une relation de construction au niveau du pixel. Cependant, ce mécanisme d'attention mondial nécessite d'énormes besoins en matière de calcul et de stockage, ce qui rend difficile une formation efficace et une convergence rapide. De même, les mécanismes d’attention locale ne dépendent pas des caractéristiques à longue portée. La convolution dense à grand noyau n'a pas de capacité d'agrégation spatiale, il est donc difficile de surmonter le biais inductif naturel de la convolution, qui n'est pas propice à l'expansion du modèle. Par conséquent, InternImage conçoit des opérateurs de convolution dynamiques et clairsemés pour obtenir des effets d'attention globale sans gaspiller trop de ressources de calcul et de stockage, permettant ainsi une formation efficace.

Sur la base de l'opérateur DCNv2, les chercheurs ont repensé, ajusté et proposé l'opérateur DCNv3. Les améliorations spécifiques incluent les parties suivantes.

(1) Poids de projection partagé. Semblable à la convolution conventionnelle, différents points d'échantillonnage dans DCNv2 ont des poids de projection indépendants, de sorte que la taille de son paramètre est linéairement liée au nombre total de points d'échantillonnage. Afin de réduire la complexité des paramètres et de la mémoire, nous nous appuyons sur l'idée de convolution séparable et utilisons des poids indépendants de la position pour remplacer les poids de regroupement. Les poids de projection sont partagés entre différents points d'échantillonnage et toutes les dépendances de position d'échantillonnage sont conservées.

(2) Présentation de plusieurs ensembles de mécanismes. La conception multigroupe a été introduite pour la première fois dans la convolution groupée et est largement utilisée dans l'auto-attention multi-têtes de Transformer. Elle peut être associée à une agrégation spatiale adaptative pour améliorer efficacement la diversité des fonctionnalités. Inspirés par cela, les chercheurs divisent le processus d'agrégation spatiale en plusieurs groupes, et chaque groupe a un décalage d'échantillonnage indépendant. Depuis lors, différents groupes d’une même couche DCNv3 présentent différents modèles d’agrégation spatiale, ce qui entraîne une riche diversité de fonctionnalités.

(3) Normalisation scalaire de la modulation du point d'échantillonnage. Afin d'atténuer le problème d'instabilité lorsque la capacité du modèle est étendue, les chercheurs ont défini le mode de normalisation sur la normalisation Softmax sur une base échantillon par échantillon. Cela rend non seulement le processus de formation des modèles à grande échelle plus stable, mais également les constructions. un modèle de toutes les relations de connexion des points d’échantillonnage.

Après avoir construit l'opérateur DCNv3, vous devez d'abord normaliser les détails globaux des modules de base et des autres couches du modèle, puis construire une InternImage en explorant la stratégie d'empilement de ces modules de base. Enfin, des modèles avec différentes quantités de paramètres sont construits selon les règles d'expansion du modèle proposé.

Module de base. Différente de la structure de goulot d'étranglement largement utilisée dans les CNN traditionnels, cette étude adopte un module de base plus proche des ViT, équipé de composants plus avancés, notamment GELU, la normalisation de couche (LN) et le réseau à action directe (FFN), qui ont fait leurs preuves. plus efficace dans une variété de tâches de vision. Les détails du module de base sont présentés dans la figure ci-dessus, où l'opérateur principal est DCNv3, qui prédit le biais d'échantillonnage et l'échelle de modulation en faisant passer les caractéristiques d'entrée via une convolution séparable légère. Pour les autres composants, suivez la même conception qu'un transformateur normal.

Règles d'empilage. Afin de clarifier le processus d'empilement de blocs, cette étude propose deux règles d'empilement de modules. La première règle est le nombre de canaux dans les trois dernières étapes  , qui est déterminé par le nombre de canaux dans la première étape

, qui est déterminé par le nombre de canaux dans la première étape  , c'est-à-dire

, c'est-à-dire  ; La deuxième règle est que le numéro de groupe de chaque module correspond au nombre de canaux dans chaque étape, c'est-à-dire

; La deuxième règle est que le numéro de groupe de chaque module correspond au nombre de canaux dans chaque étape, c'est-à-dire  troisièmement, le mode d'empilement est fixé sur "AABA", c'est-à-dire ; le nombre de piles de modules dans les étapes 1, 2 et 4 est le même

troisièmement, le mode d'empilement est fixé sur "AABA", c'est-à-dire ; le nombre de piles de modules dans les étapes 1, 2 et 4 est le même , et pas plus grand que l'étape 3

, et pas plus grand que l'étape 3  . Par conséquent, un modèle avec un volume de paramètres de 30M est choisi comme base. Les paramètres spécifiques sont : le nombre de canaux de sortie Steam

. Par conséquent, un modèle avec un volume de paramètres de 30M est choisi comme base. Les paramètres spécifiques sont : le nombre de canaux de sortie Steam est de 64 ; le nombre de groupes est de 1/16 du nombre de canaux d'entrée dans chaque étage ; , étapes 1, 2 et 4 Le nombre de piles de modules

est de 64 ; le nombre de groupes est de 1/16 du nombre de canaux d'entrée dans chaque étage ; , étapes 1, 2 et 4 Le nombre de piles de modules  est de 4, le nombre de piles de modules

est de 4, le nombre de piles de modules  à l'étape 3 est de 18 et les paramètres du modèle sont de 30 M.

à l'étape 3 est de 18 et les paramètres du modèle sont de 30 M.

Règles de mise à l'échelle du modèle. Sur la base du modèle optimal sous les contraintes ci-dessus, cette étude a normalisé deux dimensions de mise à l'échelle du modèle de réseau : à savoir la profondeur D (nombre de piles de modules) et la largeur C (nombre de canaux), en utilisant les facteurs de restriction  et

et  le long du coefficient composite

le long du coefficient composite  met à l'échelle la profondeur et la largeur, c'est-à-dire

met à l'échelle la profondeur et la largeur, c'est-à-dire  , où

, où  , selon les expériences, son réglage optimal est

, selon les expériences, son réglage optimal est  .

.

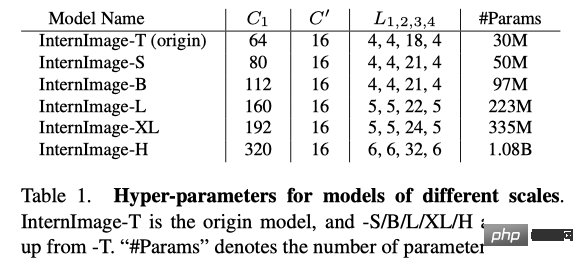

En suivant cette règle, cette étude a construit des modèles à différentes échelles, à savoir InternImage-T, S, B, L, XL. Les paramètres spécifiques sont :

Résultats expérimentaux

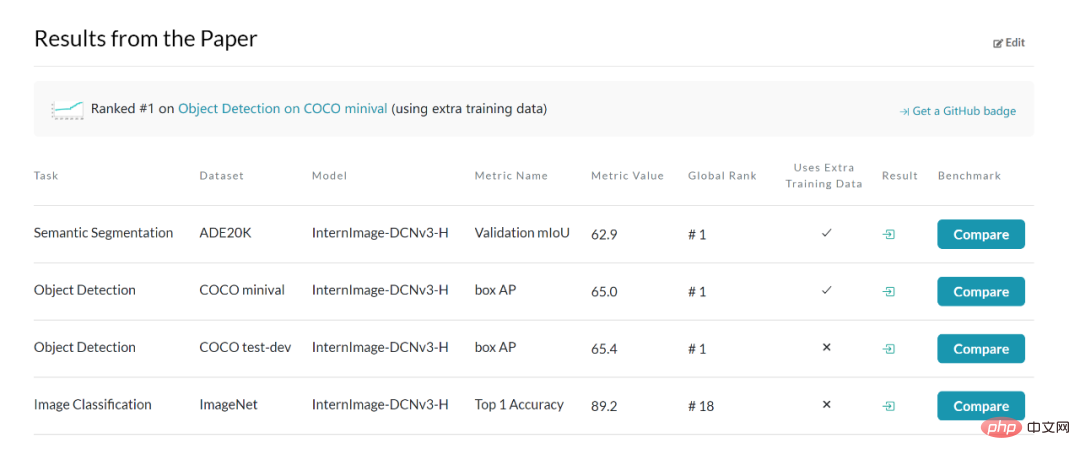

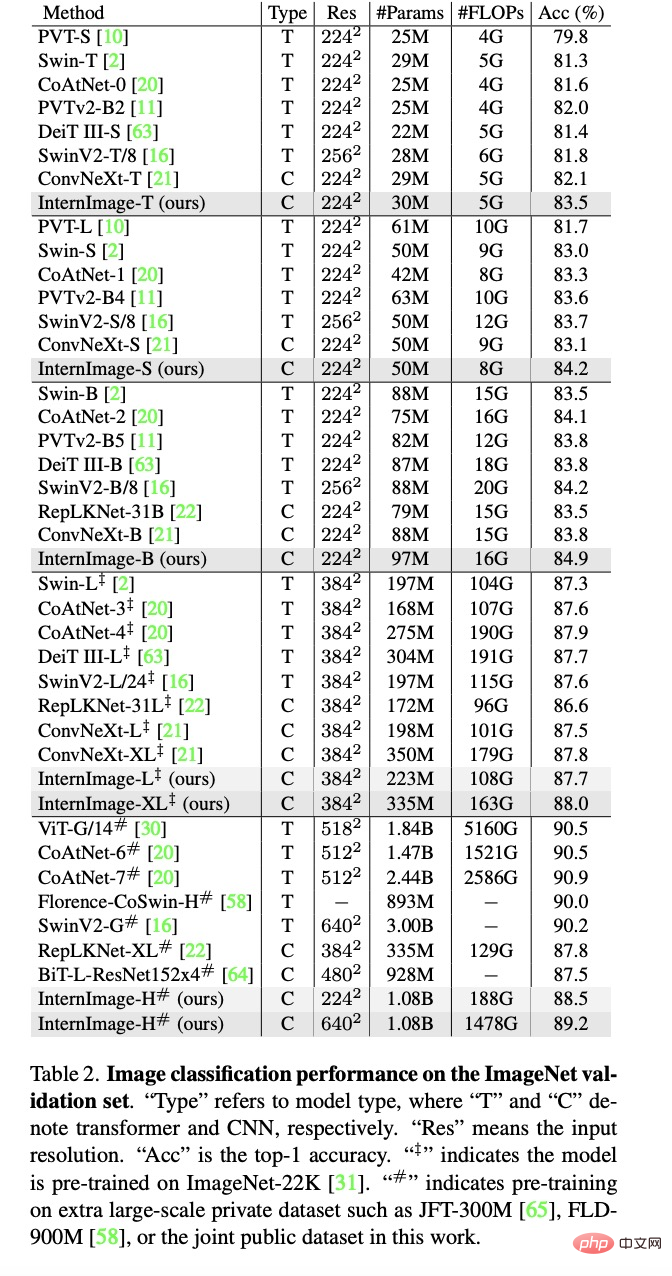

Expérience de classification d'images : En utilisant 427 millions d'ensembles de données publiques : Laion-400M, YFCC15M, CC12M, InternImage-H a obtenu une précision de 89,2 % sur ImageNet-1K.

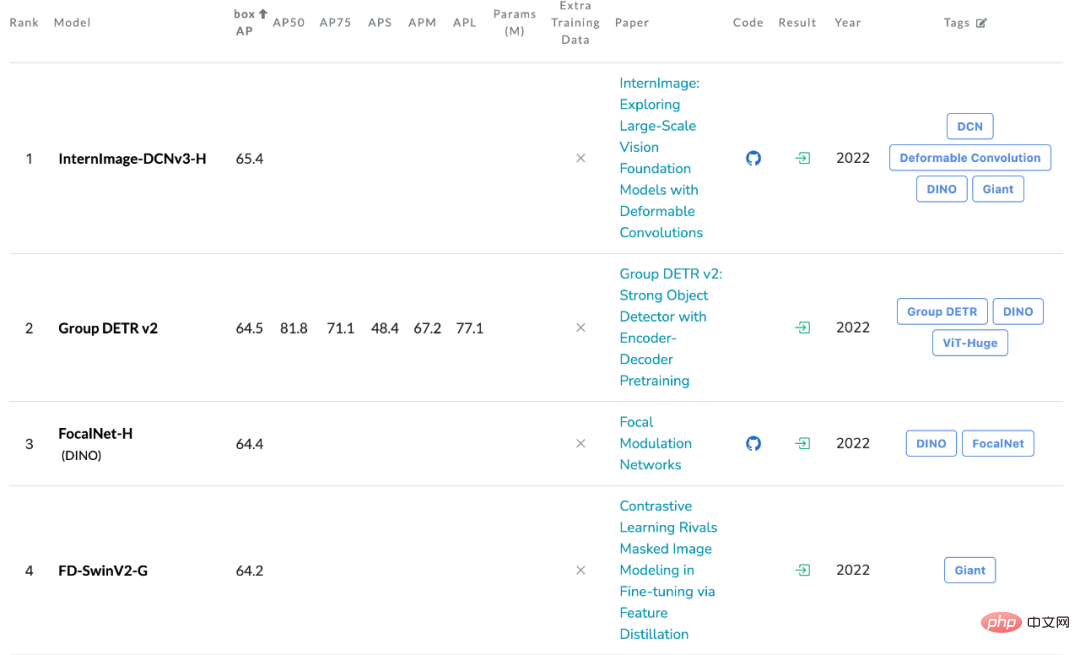

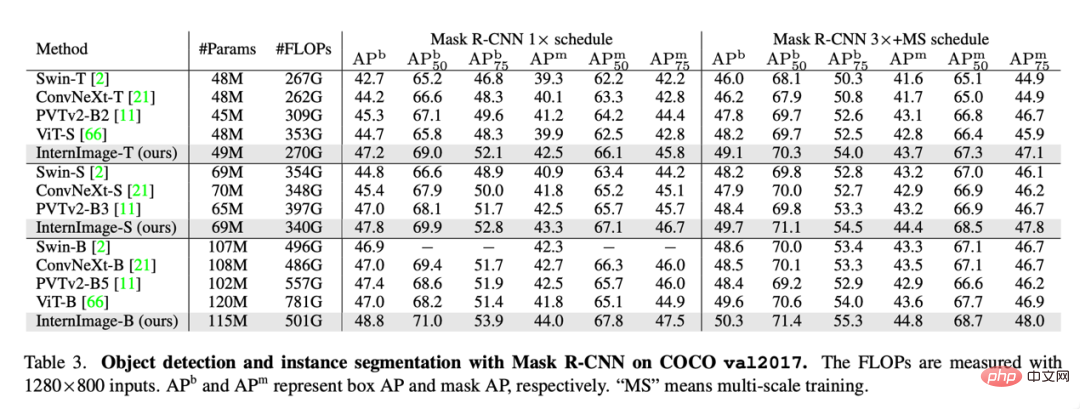

Détection d'objets : en utilisant le plus grand InternImage-H comme réseau principal et en utilisant DINO comme cadre de détection de base, pré-entraînez le détecteur DINO sur l'ensemble de données Objects365, puis exécutez sur COCO Effectuez des réglages fins. Le modèle a obtenu un résultat optimal de 65,4 % dans la tâche de détection de cible, dépassant ainsi les limites de performances de la détection de cible COCO.

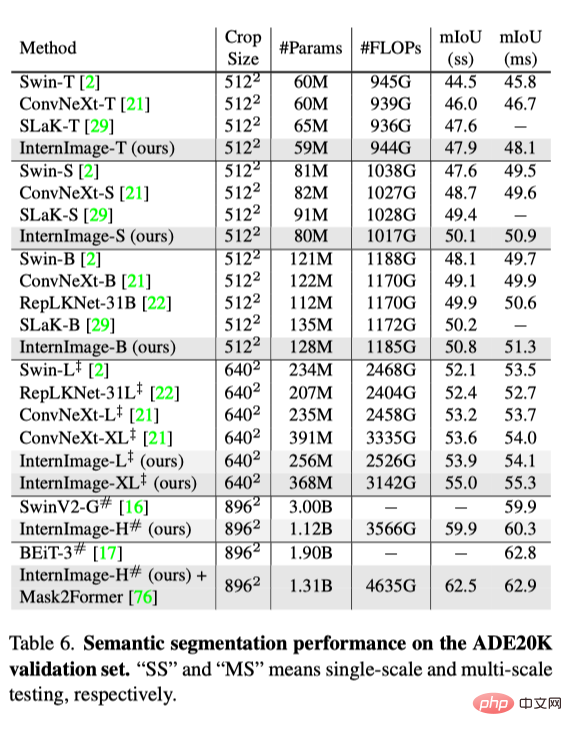

Segmentation sémantique : En termes de segmentation sémantique, InternImage-H a également obtenu de bonnes performances et, combiné à Mask2Former, a atteint le niveau actuel le plus élevé de 62,9 % sur ADE20K.

Conclusion

Cette étude propose InternImage, un nouveau modèle de base à grande échelle basé sur CNN qui peut fournir des représentations puissantes pour des tâches de vision polyvalentes telles que la classification d'images, la détection d'objets et la segmentation sémantique. Les chercheurs ont ajusté l'opérateur flexible DCNv2 pour répondre aux besoins du modèle de base et ont développé une série de règles de blocage, d'empilement et de mise à l'échelle basées sur l'opérateur principal. Des expériences approfondies sur la détection d'objets et les tests de segmentation sémantique ont vérifié qu'InternImage peut atteindre des performances équivalentes ou supérieures à celles des transformateurs visuels à grande échelle bien conçus, formés sur de grandes quantités de données, indiquant que CNN constitue également une étape considérable dans le modèle visuel de base à grande échelle. recherche. choisir. Pourtant, les CNN à grande échelle en sont encore à leurs premiers stades de développement, et les chercheurs espèrent qu’InternImage pourra constituer un bon point de départ.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI