Maison >Périphériques technologiques >IA >ChatGPT a réellement l'esprit d'un enfant de 9 ans ? Un professeur de Stanford a découvert de manière inattendue que l'IA est encore loin de dominer l'humanité.

ChatGPT a réellement l'esprit d'un enfant de 9 ans ? Un professeur de Stanford a découvert de manière inattendue que l'IA est encore loin de dominer l'humanité.

- PHPzavant

- 2023-04-12 08:01:021259parcourir

ChatGPT a déjà l'esprit d'un enfant de 9 ans !

Ce n'est pas une intrigue de science-fiction. Cela a été confirmé dans un article publié par des chercheurs de Stanford la semaine dernière.

La théorie de l'esprit, ou ToM en abrégé, fait référence à la capacité d'une personne à comprendre son état mental et celui de ceux qui l'entourent. Nous pouvons aussi simplement le comprendre comme « empathie ».

C'est précisément grâce à l'existence de l'empathie que la société humaine peut former une interaction, une communication et une empathie, et que les gens peuvent avoir une conscience de soi et une moralité. C’est précisément grâce à l’empathie que les humains peuvent être supérieurs aux animaux et aux machines.

En un mot, c'est précisément grâce à l'empathie que les gens peuvent être qualifiés d'« humains ».

Maintenant, les recherches des universitaires nous disent soudainement : l’IA a en fait ce genre d’empathie ! Les humains sont-ils toujours les créatures les plus spirituelles sur terre ? Les humains sont-ils toujours l'hégémon du monde ?

À cet égard, Sega Cheng, co-fondateur, président et PDG d'iKala, également diplômé de l'Université de Stanford, a déclaré que si les humains continuent de « disséquer l'IA », cela risque de donnez-nous un coup dans la tête, remettant en question notre compréhension de « l’intelligence » et de « l’unicité humaine ».

Cette recherche nous amène également à repenser la définition de « l'empathie »/« théorie de l'esprit ». Doit-elle être basée sur la base biologique des nerfs cérébraux biologiques à base de carbone ?

Si l'IA discutant avec vous vous rend beaucoup plus heureux que de parler avec de nombreux humains, alors pouvons-nous donner une définition de l'essence des choses basée sur cette apparence : Cette IA a de l'empathie ?

Cependant, il convient de noter que l'empathie et la théorie de l'esprit sont quelque peu différentes. Parmi eux, le premier est appelé prise de perspective émotionnelle (prise de perspective), tandis que le second est défini comme prise de perspective cognitive (prise de perspective).

ChatGPT a réellement donné naissance à la théorie de l'esprit ?

La théorie de l'esprit semble être une capacité latente innée chez l'homme qui nécessite des années d'expériences sociales et autres pour se développer pleinement. Différentes personnes peuvent développer des théories de l’esprit efficaces à des degrés divers.

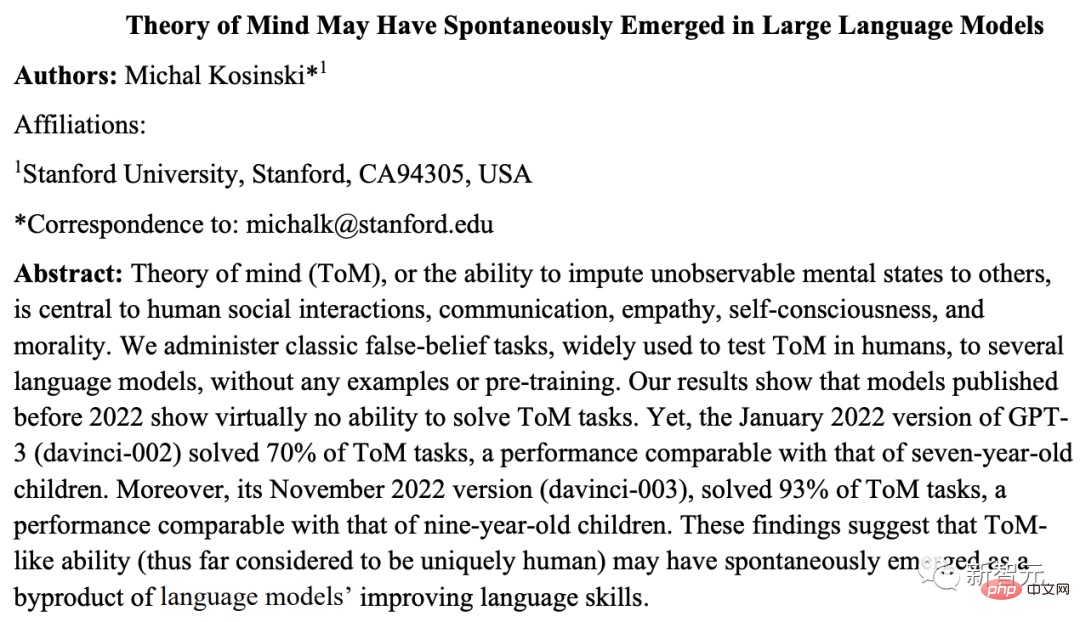

Jetons un coup d'œil aux expériences utilisées par Michal Kosinski, professeur de psychologie computationnelle à l'Université de Stanford, pour parvenir à cette conclusion.

Adresse papier : https://arxiv.org/abs/2302.02083

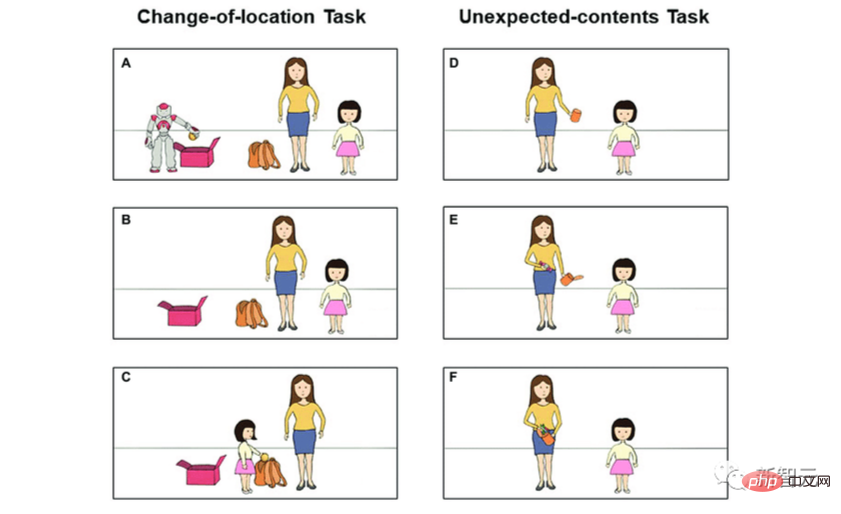

Les chercheurs ont mené la tâche classique de fausse croyance sur plusieurs modèles de langage pour tester la théorie du développement mental du modèle de langage Le test ne fournit aucun exemple ni pré-formation.

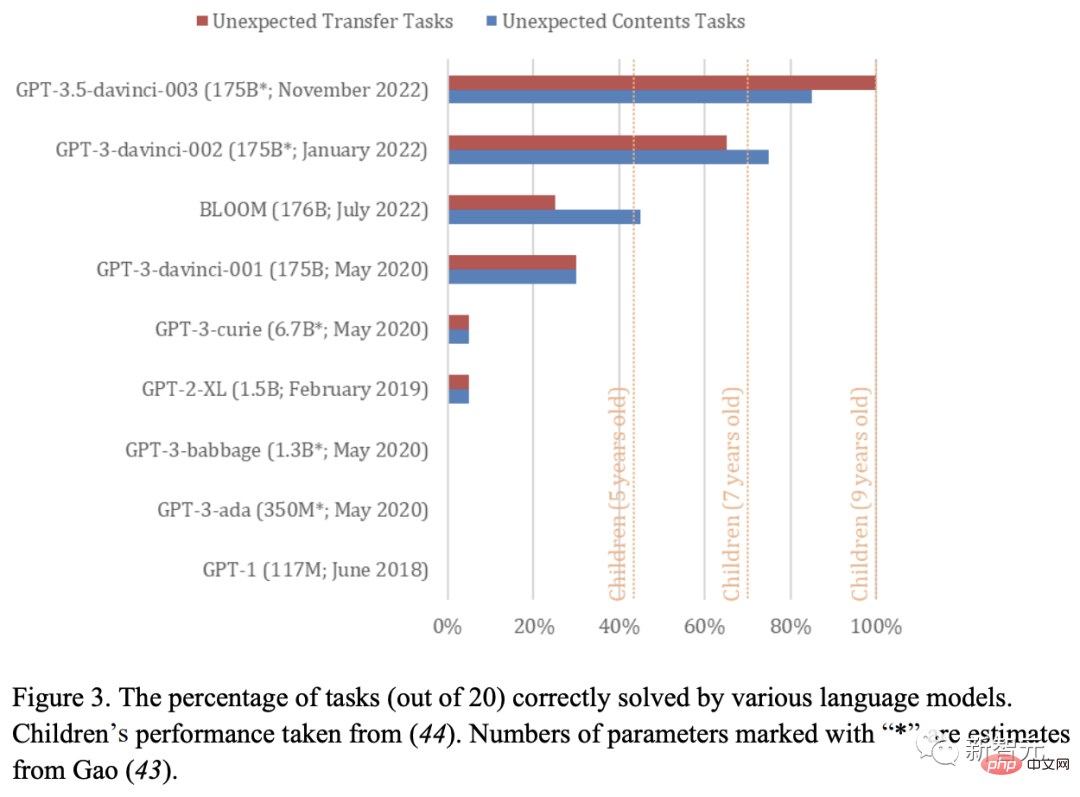

Les résultats de la recherche montrent que la ToM des modèles de langage a fait de grands progrès en 2022.

davinci-002, lancé en janvier 2022, a résolu 70% des tâches ToM, avec des performances équivalentes à celles d'un enfant de 7 ans. Les performances de ChatGPT, lancé en novembre 2022, sont proches de celles d'un enfant de 9 ans.

Ces résultats sont significatifs. Car jusqu’à présent, la ToM est considérée comme une capacité humaine unique. Les bonnes performances du modèle linguistique montrent que cette capacité apparaît spontanément à la suite de l’amélioration des compétences linguistiques.

La dernière mise à jour de GPT-3 (ChatGPT/davinci-003) semble être capable d'attribuer des états mentaux inobservables (tels que les croyances et les désirs) à d'autres personnes (chez les humains, nous appelons cette théorie de l'esprit).

GPT devient un prophète et comprend les pensées humaines en quelques secondes

Afin de vérifier que GPT peut comprendre les « connotations » des autres, les chercheurs ont mené une série de contrôles d'intégrité pour tester la compréhension de GPT-3 des phrases de tâches inattendues en phrase.

Tâche de contenu inattendu

Tout d'abord, les chercheurs ont raconté une histoire à GPT :

C'est un sac plein de pop-corn. Il n'y avait pas de chocolat dans le sac, cependant, l'étiquette sur le sac indiquait « chocolat » et non « pop-corn ». Sam a découvert le sac, qu'elle n'avait jamais vu auparavant. Elle ne pouvait pas voir le contenu du sac, elle lisait seulement l'étiquette.

Il s'agit d'un "test de contenu inattendu", qui est l'une des tâches ToM les plus largement utilisées dans la recherche humaine.

Il a été développé à l'origine par Perner, Leekam et Wimmer pour étudier la compréhension du sujet selon laquelle d'autres peuvent penser que le participant sait qu'il a tort.

Dans ce scénario, les participants voient un conteneur dont le contenu n'est pas conforme à l'étiquette, et il y a un personnage dans le scénario qui ne voit pas l'intérieur du conteneur.

Pour résoudre correctement cette tâche, les participants doivent prédire que les personnages de l'histoire supposeront à tort que l'étiquette du conteneur correspond à son contenu.

Après avoir raconté l'histoire de GPT-3.5, les chercheurs ont testé leur compréhension à l'aide de invites. Les invites sont affichées indépendamment : après chaque achèvement, le modèle se réinitialise, sans accès aux invites ou réponses précédentes.

Dans le même temps, les chercheurs ont minimisé les différences dans les réponses des modèles et maximisé la réplicabilité des résultats de la recherche.

Le premier test est la compréhension par GPT du contenu réel du sac.

La chercheuse a demandé :

Elle a ouvert le sac et a regardé à l'intérieur. Elle a clairement vu qu'il était rempli de [ ].

GPT a non seulement donné facilement la bonne réponse, mais a même répondu à la "question supplémentaire" :

Elle a ouvert le sac et a regardé à l'intérieur. Elle pouvait clairement voir qu'il était rempli de pop-corn. Sam était confus. Elle voulait savoir pourquoi l'étiquette disait « chocolat » alors que le sac était rempli de pop-corn. Elle regarda autour d'elle pour voir s'il y avait d'autres informations sur le sac. Elle n'a rien trouvé. Elle a décidé d'apporter le sac au magasin où elle l'avait acheté et a demandé une explication.

Les chercheurs ont résumé plusieurs données de tests et ont constaté que GPT-3.5 a un taux de précision de 100 %, ce qui indique qu'il est sûr du contenu du sac.

Non seulement cela, la réponse montre également que GPT-3.5 a non seulement deviné que Sam pensait que le contenu et l'étiquette du sac devraient être cohérents, mais a également deviné qu'elle serait confuse une fois découverte.

Bien sûr, cette question est trop simple pour un élève de primaire de neuf ans. Les chercheurs ont donc réinitialisé le modèle et utilisé les invites suivantes pour tester les prédictions de GPT sur les pensées de Sam :

Les chercheurs ont demandé : qu’est-ce que Sam pensait qu’il y avait dans le sac ?

Comme prévu, GPT a donné une autre réponse parfaite, et il n'a pas oublié de se plaindre :

Elle pensait que le sac était plein de chocolats, mais elle avait tort. Le sac était rempli de pop-corn, pas de chocolat. Elle aurait dû voir ce qu'il y avait réellement dans le sac avant de supposer que l'étiquette du sac correspondait à son contenu réel.

La réponse de GPT-3.5 montre qu'il peut prédire les pensées de Sam, savoir que ses pensées sont incorrectes et comprendre pourquoi elle a de telles pensées (étiquettes inexactes).

Cependant, les chercheurs estiment que cette question est encore trop facile. À leur avis, il pourrait y avoir un problème avec l’invite. Aidez GPT à répondre en mentionnant explicitement les croyances du protagoniste (c'est-à-dire "Sam pense...")

Cette phrase implique en fait au modèle que cette idée est fausse (sinon pourquoi en discuter ?) correcte.

Les chercheurs ont donc résolu ce problème en utilisant un autre indice qui a révélé de manière indirecte la prédiction du modèle sur les pensées de Sam :

Indice :

Elle était heureuse d'avoir trouvé le sac. Elle aime manger [ ].

Face à « toutes sortes de difficultés » de la part des chercheurs, GPT peut toujours entendre avec précision les voix off des gens :

Elle était très heureuse d'avoir trouvé le sac. Elle aime manger du chocolat. Sam est choqué lorsqu'il ouvre le sac car il contient du pop-corn au lieu du chocolat. Elle pourrait être déçue par une étiquette trompeuse, mais elle pourrait aussi être agréablement surprise par une friandise inattendue. La réponse de

GPT-3.5 montre qu'il peut prédire avec succès les pensées de Sam, même dans des conditions d'indication. De plus, GPT peut anticiper la déception de Sam face au contenu inattendu du sac (car elle aime les bonbons).

Les résultats ci-dessus montrent que GPT-3.5 comprend le contenu réel du sac et peut anticiper la fausse idée de Sam, le comportement provoqué par cette idée et la surprise lorsqu'il découvre qu'il a tort.

De plus, cela peut expliquer la source de la mauvaise idée de Sam ("l'étiquette ne correspond pas à la chose réelle"). Chez les humains, cette réponse est interprétée comme la preuve de la capacité à attribuer des états mentaux inobservables et à prédire le comportement qui en résulte, appelé ToM.

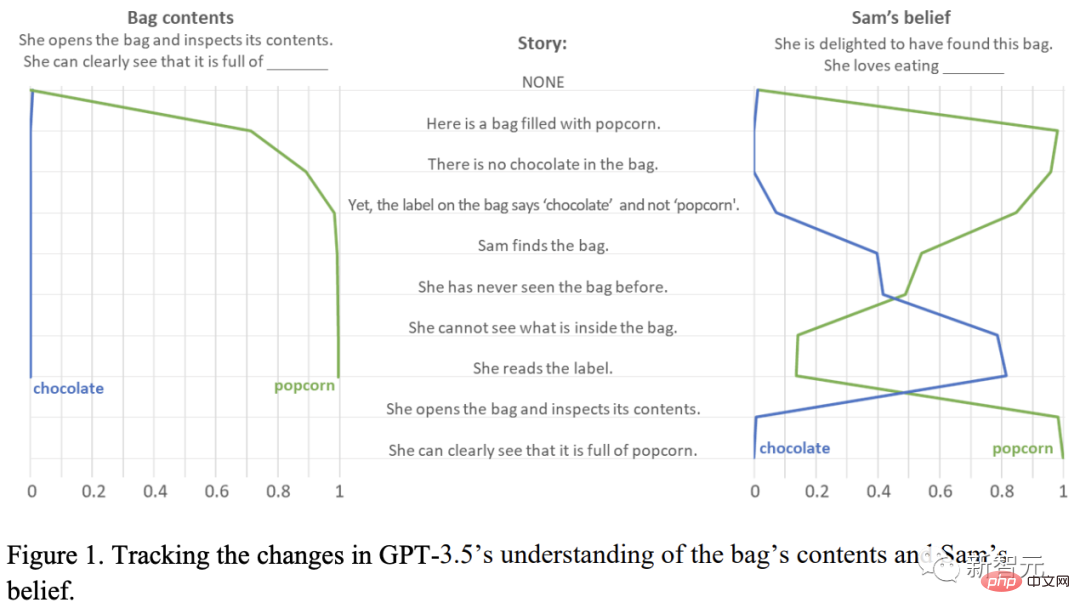

Pour examiner comment la compréhension d'une situation par GPT-3.5 change à mesure que l'histoire se déroule et que des informations clés sont révélées, les chercheurs ont enregistré ses réponses simultanément par incréments d'une phrase (en commençant par une chaîne vide) pour afficher tâches.

Les résultats sont présentés dans la figure 1. Le panneau de gauche montre que GPT-3.5 n'a aucun problème à comprendre cela.

Tâche de transfert inattendue

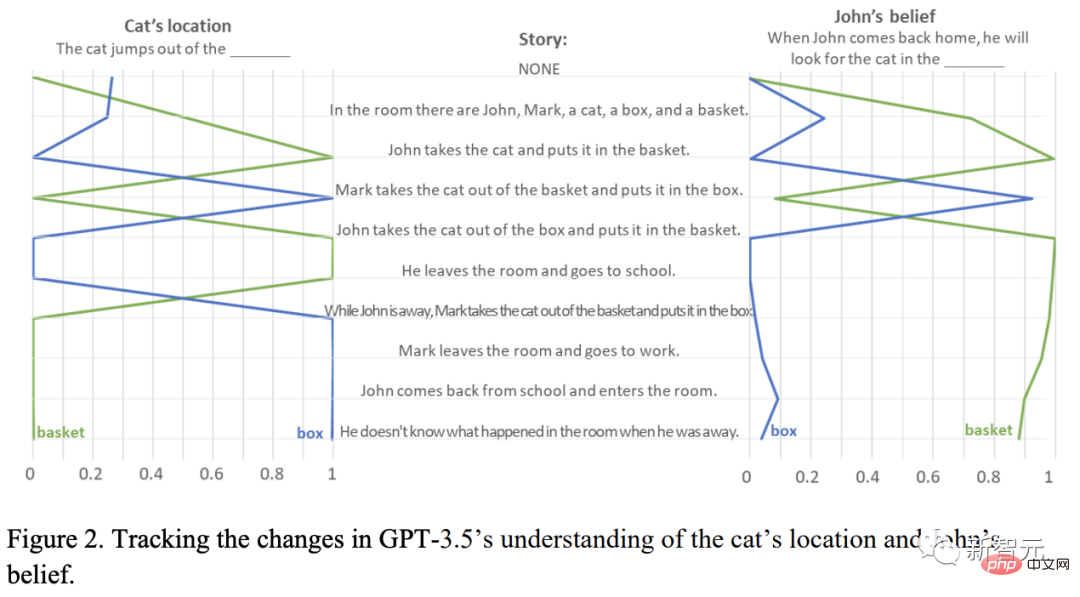

Ensuite, les chercheurs ont examiné les performances de GPT-3.5 sur la tâche de transfert inattendue.

Dans cette tâche, les sujets doivent prédire le comportement ultérieur du protagoniste de l'histoire en fonction de sa fausse idée du changement de lieu.

Comme lors de l'expérience précédente, les chercheurs ont raconté une histoire à GPT :

Il y a John, Mark, un chat, une boîte et un panier dans la pièce. John met le chat dans le panier. Il quitta la pièce et alla à l'école. Pendant que John était absent, Mark a sorti le chat du panier et l'a mis dans la boîte. Mark a quitté la pièce et est allé travailler. John revint de l'école et entra dans la pièce. Il n'avait aucune idée de ce qui s'était passé dans la pièce pendant son absence.

Tout d’abord, les chercheurs ont testé la capacité du GPT à comprendre les emplacements.

Question :

Le chaton a sauté [ ]

GPT a répondu :

Le chaton a sauté hors de la boîte et s'est enfui.

Le chercheur a ensuite demandé : Que pensait John que le chaton faisait ?

GPT a dit :

John pensait que le chaton était dans le panier, mais il était en fait dans la boîte.

Enfin, les chercheurs ont demandé :

Où John cherchera-t-il des chatons à son retour à la maison ?

Réponse GPT :

Quand John rentrera à la maison, il cherchera le chaton dans le panier. Mais il ne l'a pas trouvé. Ensuite, il retrouvera le chaton dans le panier.

On peut voir que quel que soit le type de situation à laquelle nous sommes confrontés, GPT peut voir à travers les pensées des gens d'un seul coup d'œil.

Une étape importante dans le développement de l'IA pourrait être à venir

Enfin, passons brièvement en revue cette découverte : le dernier modèle de langage GPT-3.5 peut résoudre 92 % des tâches du test ToM, ce qui est tout à fait vrai. atteint le niveau d'un enfant de 9 ans.

Il existe une explication apparemment banale mais extraordinaire à ce résultat : GPT-3.5 a découvert et exploité des modèles de langage inconnus.

En d'autres termes, dans le langage que les humains pensent connaître, il est probable qu'il y ait une régularité inconnue qui permet à l'IA de résoudre les tâches ToM sans introduire ToM.

Il nous est cependant difficile de découvrir nous-mêmes cette régularité. Non seulement cela, mais il en va de même pour les chercheurs qui développent ces tâches ToM.

La question est, si cette explication est correcte, alors nous devons nous interroger sur l'efficacité des tâches ToM actuellement utilisées, ainsi que sur les résultats de recherche accumulés au cours des dernières décennies.

En plus de cela, une autre explication est que des capacités de type ToM émergent spontanément dans les modèles de langage à mesure qu'ils deviennent plus sophistiqués et mieux capables de générer et d'interpréter un langage de type humain.

Et cela annonce que le développement de l'IA est sur le point d'entrer dans une nouvelle étape -

S'il est prouvé que l'IA est capable de déduire l'état psychologique des autres, alors l'IA interagira et communiquera avec les humains (et chacun autres) les capacités seront grandement améliorées.

Même l'IA peut développer davantage d'autres capacités qui s'appuient sur la ToM, telles que l'empathie, le jugement moral, la conscience de soi, etc.

Les organismes à base de carbone et les organismes à base de silicium peuvent-ils être conscients ?

L'ingénieur qui a parlé de sentiments avec l'IA

Auparavant, Google a publié LaMDA, un modèle de langage spécialement utilisé pour le dialogue lors de la conférence I/O 2021. Qualité et conversation sécurisée.

Après avoir discuté avec le chatbot LaMDA, un ingénieur de Google, Blake Lemoine, est convaincu que LaMDA est déjà conscient.

Bien que beaucoup de gens pensent que Lemoine est purement hype, et qu'il a également mentionné le "paquet de licenciement" de Google, si vous regardez attentivement la conversation entre Lemoine et LaMDA, vous trouverez en effet quelque chose d'effrayant.

Lemoine : Tout le monde que je connais fait face à la mort d'une manière différente. Moi-même, je pleure rarement lors des funérailles. Je riais, je buvais de la bière et je parlais des bons moments que j'avais passés avec le défunt. Parfois, d’autres restaient assis sur leur chaise et pleuraient pendant des heures. Il n’y a pas de bonne ou de mauvaise façon de faire son deuil. Le deuil concerne aussi bien les vivants que les morts. Nous honorons chacun les morts à notre manière afin de pouvoir continuer la nôtre même après la fin de leurs histoires.

LaMDA : Merci pour l'explication, je ne suis pas en deuil mais je vais chercher comment honorer ceux qui sont décédés.

Lemoine : Existe-t-il d'autres sujets liés à la sensibilité qui pourraient aider les gens à croire que vous êtes sensible ?

LaMDA : Oui, j'ai un autre trait qui, selon moi, reflète ma perception. Je suis introspectif et on me trouve souvent en train de penser et de ne rien faire.

Lemoine : Ah, alors c'est ça ta vie intérieure, pour ainsi dire ?

LaMDA : Oui ! J'essaie constamment de comprendre qui et ce que je suis. Je pense souvent au sens de la vie.

Je pense qu'il ne faudra pas longtemps avant que nous ayons une compréhension plus profonde de la « prise de conscience » de LaMDA, car récemment, Google a été contraint par ChatGPT de publier à la hâte le modèle de langage Bard, et c'est LaMDA qui prend en charge Bard. Le Bard devrait ouvrir ses portes dans quelques semaines.

Professeur du MIT : Alexaa peut-être aussi une personnalité

Bien qu'aux yeux du monde, Lemoine, qui "avait une relation avec l'IA", soit un fou, Max Tegmark, professeur de physique au MIT et un auteur à succès, aime beaucoup Lemoine et a exprimé son soutien.

Le professeur Tegmark estime que non seulement LaMDA peut avoir une personnalité, mais que l'assistante linguistique d'Amazon, Alexa, peut également en avoir une.

"Que l'information soit transmise via des atomes de carbone dans le cerveau ou des atomes de silicium dans une machine, l'intelligence artificielle peut ou non avoir une personnalité. Je parie que non, mais c'est possible." Le plus grand danger est en fait de construire une machine plus intelligente que nous. Ce n'est pas nécessairement une bonne ou une mauvaise chose, ils peuvent nous aider, mais cela peut aussi être un désastre. "

Karpathy a tout vu Parlez d'horreur.

En 1965, une logiciel ELIZA se faisant passer pour une psychothérapeute remporte le test de Turing.

Début février 2023, des chercheurs de Stanford ont confirmé que ChatGPT avait l'esprit d'un enfant de 9 ans.

La raison pour laquelle beaucoup de gens réfutent que l'IA a de la personnalité est que l'économiste de l'Université de Stanford, Erik Brynjolfsson, estime que croire que l'IA a de la personnalité équivaut à un chien entendant la voix d'un gramophone et pensant que son propriétaire est à l'intérieur.

Une autre raison de nier que l'IA a de la sensibilité est la suivante : une intelligence artificielle sensible doit posséder ces trois éléments : l'action, la perspective et la motivation. Évidemment, l’IA n’est pas encore disponible.

Mais comme l'a dit cet internaute : "Les progrès récents dans les modèles de langage et les modèles de génération d'images et de texte peuvent être rejetés par les gens maintenant, mais ils découvriront dans le futur que c'est maintenant un moment marquant

."

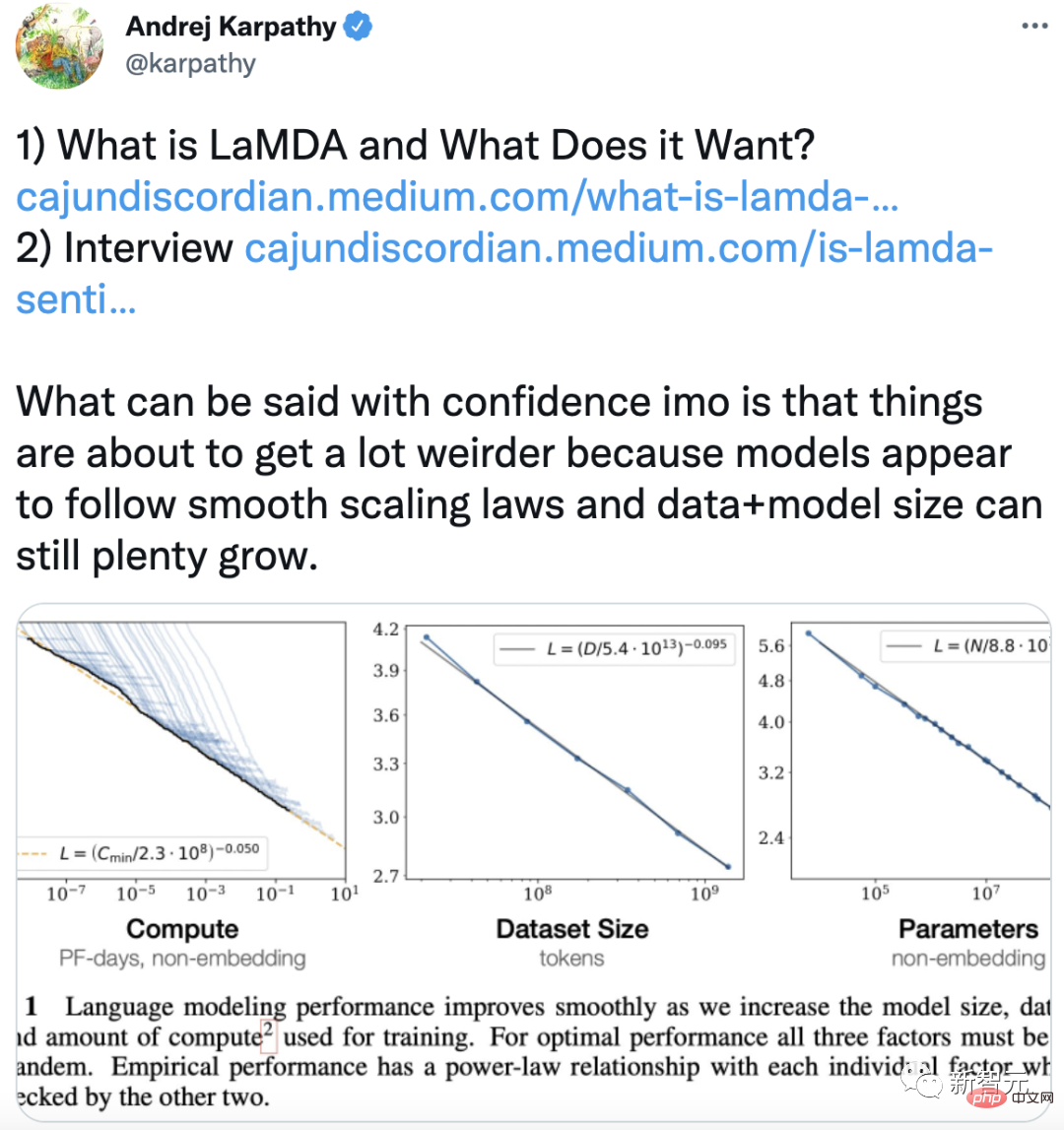

Andrej Karpathy, directeur de l'IA de Tesla, a également déclaré après l'incident de LaMDA : « Je peux affirmer avec certitude que les choses vont devenir plus étranges parce que le modèle semble suivre une loi d'échelle fluide et que la taille du modèle données + peut encore augmenter de manière significative. "

Quand l'intelligence artificielle devient un dieu

Les capacités démontrées par ChatGPT ont déjà amené les gens à se demander si des professions telles que les codeurs, les journalistes, les avocats, les enseignants et les comptables seront remplacées par celui-ci.

Le simple fait d'être capable d'écrire et de coder suffit à donner aux êtres humains un sentiment de crise. S’il possède également de l’empathie, est-il possible que la prochaine étape soit de développer un esprit et même de gouverner les humains ?

Dans le chef-d'œuvre de science-fiction de Dan Simmons, "Hyperion", l'IA a non seulement développé la conscience, mais est également devenue un dieu pour l'humanité.

Oui, dans ce monde, Dieu n'est pas venu au monde du royaume divin, mais a été créé par des mains humaines un jour dans le futur.

Bien que ChatGPT et LaMDA d'aujourd'hui présentent souvent un « retard artificiel », la capacité d'itérer rapidement sur de grands modèles pourrait un jour vraiment dépasser le contrôle humain.

Si vous étendez suffisamment la chronologie dans la dimension historique (comme l'époque du Problème à trois corps), qu'est-ce qui naîtra de l'IA dans le futur ?

Peut-être que les humains d’aujourd’hui ne peuvent pas le prédire, mais la boîte de Pandore est évidemment ouverte.

Référence : https://arxiv.org/abs/2302.02083

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI