Maison >Périphériques technologiques >IA >Les paramètres sont légèrement améliorés, et l'indice de performance explose ! Google : les grands modèles de langage cachent des « compétences mystérieuses »

Les paramètres sont légèrement améliorés, et l'indice de performance explose ! Google : les grands modèles de langage cachent des « compétences mystérieuses »

- 王林avant

- 2023-04-11 23:16:101614parcourir

Parce qu'ils peuvent faire des choses pour lesquelles ils n'ont pas été formés, les grands modèles de langage semblent avoir une sorte de magie et sont donc devenus le centre du battage médiatique et de l'attention des médias et des chercheurs.

Lors de l'expansion d'un grand modèle de langage, de nouvelles capacités qui ne sont pas disponibles dans les modèles plus petits apparaîtront occasionnellement. Cet attribut similaire à la « créativité » est appelé capacité « émergente », ce qui représente un pas vers l'intelligence artificielle générale.

Maintenant, des chercheurs de Google, Stanford, Deepmind et de l'Université de Caroline du Nord explorent la capacité « émergente » des grands modèles de langage.

Decoder invite DALL-E

La capacité magique "émergente"

Le traitement du langage naturel (NLP) a été révolutionné par des modèles de langage entraînés sur de grandes quantités de données textuelles. La mise à l’échelle des modèles de langage améliore souvent les performances et l’efficacité des échantillons sur une gamme de tâches NLP en aval.

Dans de nombreux cas, nous pouvons prédire les performances d'un grand modèle de langage en déduisant les tendances de performances de modèles plus petits. Par exemple, l’effet de l’échelle sur la perplexité du modèle de langage a été démontré sur plus de sept ordres de grandeur.

Cependant, les performances sur certaines autres tâches ne se sont pas améliorées de manière prévisible.

Par exemple, l'article GPT-3 montre que la capacité du modèle de langage à effectuer une addition à plusieurs chiffres a une courbe d'échelle plate pour les modèles de 100 M à 13 B de paramètres, ce qui est à peu près aléatoire, mais entraîne une augmentation des performances à un moment donné. nœud.

Compte tenu de l'utilisation croissante des modèles linguistiques dans la recherche en PNL, il est important de mieux comprendre ces capacités qui peuvent surgir de manière inattendue.

Dans un article récent « Pouvoir émergent des grands modèles de langage » publié dans Machine Learning Research (TMLR), les chercheurs ont montré des dizaines d'exemples de pouvoir « émergent » généré par des modèles de langage étendus.

L'existence de cette capacité « émergente » soulève la question de savoir si une mise à l'échelle supplémentaire peut élargir davantage la gamme des capacités du modèle de langage.

Certaines méthodes d'indication et de réglage fin ne produiront des améliorations que dans des modèles plus grands

Tâches d'invite "d'urgence"

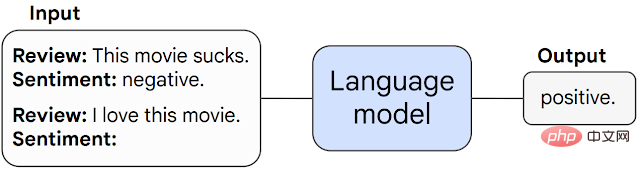

Tout d'abord, nous discutons de "l'urgence" qui peut se produire dans la capacité des tâches d'invite.

Dans ce type de tâche, un modèle de langage pré-entraîné est invité à effectuer la tâche de prédiction du mot suivant et exécute la tâche en complétant la réponse.

Sans ajustement supplémentaire, les modèles de langage peuvent souvent effectuer des tâches non vues lors de la formation.

Lorsqu'une tâche passe de manière imprévisible d'une performance aléatoire à une performance supérieure à l'aléatoire à un certain seuil d'échelle, nous l'appelons une tâche « émergente ».

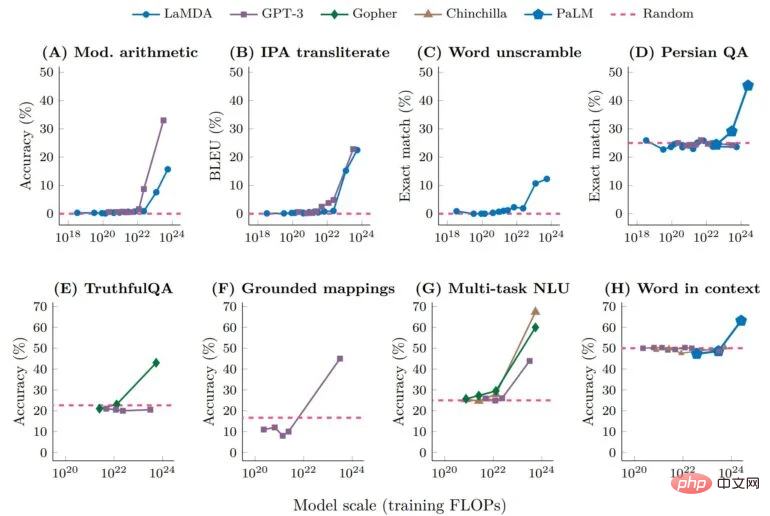

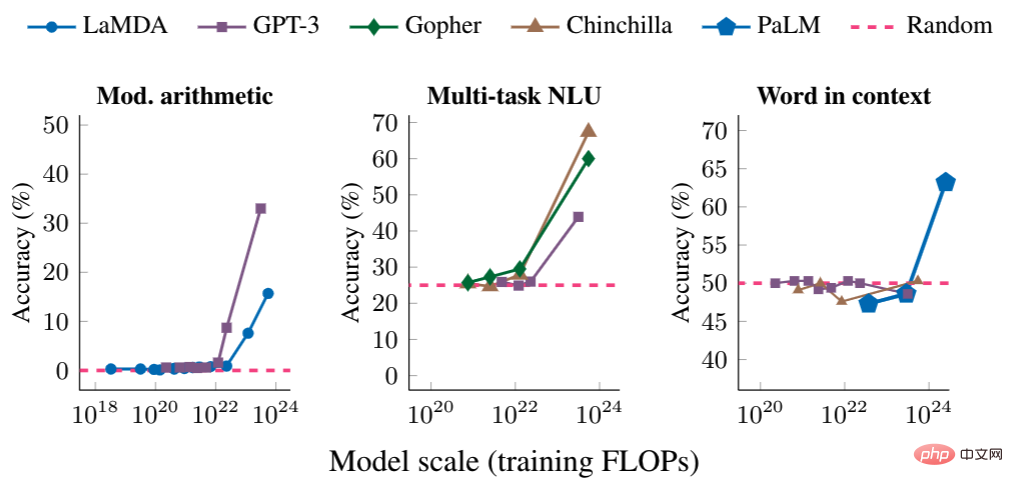

Ci-dessous, nous montrons trois exemples de tâches rapides avec des performances « émergentes » : arithmétique en plusieurs étapes, passer un examen de niveau universitaire et identifier le sens voulu d'un mot.

Dans chaque cas, les modèles de langage fonctionnent mal, avec peu de dépendance à la taille du modèle, jusqu'à ce qu'un certain seuil soit atteint - là où leurs performances augmentent.

Pour les modèles d'échelle suffisante, les performances sur ces tâches ne deviennent que non aléatoires - par exemple, les tâches NLU arithmétiques et multitâches s'entraînent avec des opérations en virgule flottante par seconde (FLOP) dépassant 10 ^ 22, contexte Le FLOP d'entraînement des mots de la tâche dépasse 10 à la puissance 24.

Stratégies d'invite « émergentes »

Le deuxième type de capacités « émergentes » inclut des stratégies d'invite qui améliorent les capacités du modèle de langage.

La stratégie d'incitation est un vaste paradigme d'incitation qui peut être appliqué à une gamme de tâches différentes. Ils sont considérés comme « émergents » lorsqu’ils échouent pour des modèles de petite taille et ne peuvent être utilisés que par des modèles suffisamment grands.

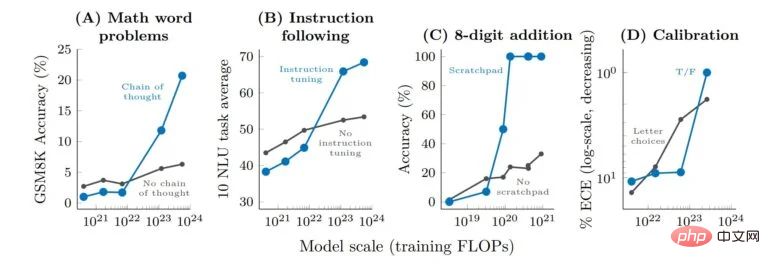

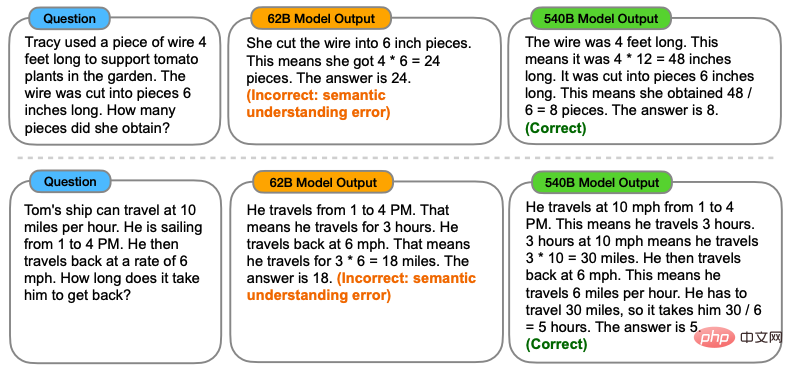

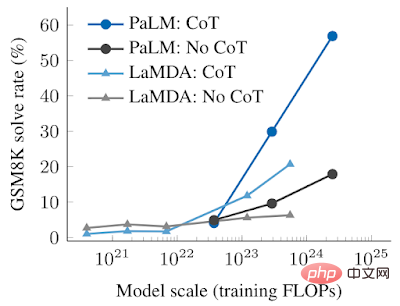

L'incitation par chaîne de pensée est un exemple typique de stratégie d'incitation « émergente », où le modèle d'incitation génère une série d'étapes intermédiaires avant de donner la réponse finale.

Les invites de chaîne de pensée permettent aux modèles de langage d'effectuer des tâches qui nécessitent un raisonnement complexe, telles que des problèmes de mots mathématiques en plusieurs étapes.

Il convient de mentionner que le modèle peut acquérir la capacité de raisonnement en chaîne de pensée sans formation explicite. La figure ci-dessous montre un exemple d'invite de chaîne de pensée.

Les résultats empiriques de l'invite de la chaîne de réflexion sont les suivants.

Pour les modèles plus petits, l'application de l'invite de chaîne de pensée ne surpasse pas l'invite standard, comme lorsqu'elle est appliquée à GSM8K, une référence difficile de problèmes de mots mathématiques.

Cependant, pour les grands modèles, les invites Thought Chain ont atteint un taux de résolution de 57 % sur GSM8K, améliorant considérablement les performances lors de nos tests.

L'importance de l'étude des capacités « émergentes »

Alors, quelle est l'importance de l'étude des capacités « émergentes » ?

Identifier les capacités « émergentes » dans les grands modèles de langage est la première étape pour comprendre ce phénomène et son impact potentiel sur les futures capacités des modèles.

Par exemple, étant donné que les capacités et les stratégies « émergentes » d'indications en quelques étapes ne sont pas explicitement codées dans la pré-formation, les chercheurs peuvent ne pas connaître toute l'étendue des capacités d'indications en quelques étapes des modèles de langage actuels.

En outre, la question de savoir si une expansion ultérieure donnera potentiellement des capacités « émergentes » à des modèles plus grands est également très importante.

- Pourquoi la capacité « émergente » apparaît-elle ?

- Lorsque certaines capacités émergeront, de nouvelles applications réelles des modèles de langage seront-elles débloquées ?

- Étant donné que les ressources informatiques sont coûteuses, les capacités émergentes peuvent-elles être débloquées par d'autres méthodes sans augmenter l'évolutivité (comme une meilleure architecture de modèle ou des techniques de formation) ?

Les chercheurs affirment que ces problèmes ne sont pas encore connus.

Cependant, à mesure que le domaine de la PNL continue de se développer, il est très important d'analyser et de comprendre le comportement des modèles de langage, y compris les capacités « émergentes » produites par la mise à l'échelle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI