Maison >Périphériques technologiques >IA >Quelle est la fiabilité des grands modèles ? Dernier tutoriel d'IBM et d'autres chercheurs sur la « Robustesse de base des modèles de base »

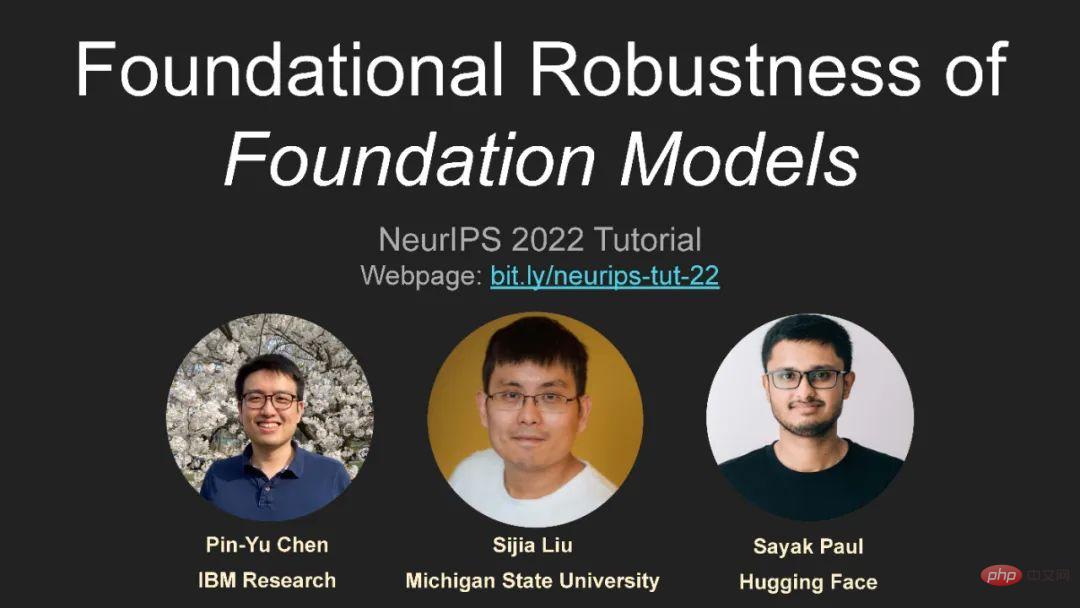

Quelle est la fiabilité des grands modèles ? Dernier tutoriel d'IBM et d'autres chercheurs sur la « Robustesse de base des modèles de base »

- 王林avant

- 2023-04-11 22:43:061267parcourir

En tant que l'une des conférences académiques sur l'IA les plus prestigieuses au monde, NeurIPS est chaque année un événement important dans la communauté universitaire. Son nom complet est Neural Information Processing Systems, qui est généralement organisé par la Fondation NeurIPS chaque année en décembre.

Le contenu discuté lors de la conférence comprend l'apprentissage profond, la vision par ordinateur, l'apprentissage automatique à grande échelle, la théorie de l'apprentissage, l'optimisation, la théorie de la parcimonie et de nombreuses autres subdivisions.

Cette année, NeurIPS est la 36ème édition et se tiendra pendant deux semaines du 28 novembre au 9 décembre.

La première semaine sera une réunion en personne au Ernest N. Morial Convention Center à la Nouvelle-Orléans, aux États-Unis, et la deuxième semaine sera une réunion en ligne.

Des chercheurs du Centre de recherche IBM et d'autres chercheurs parlent de la robustesse des grands modèles, ce qui mérite beaucoup d'attention !

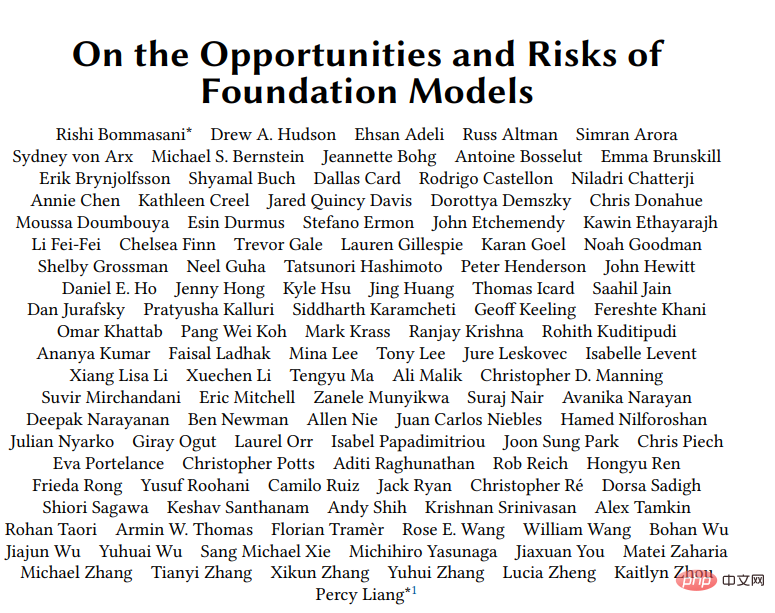

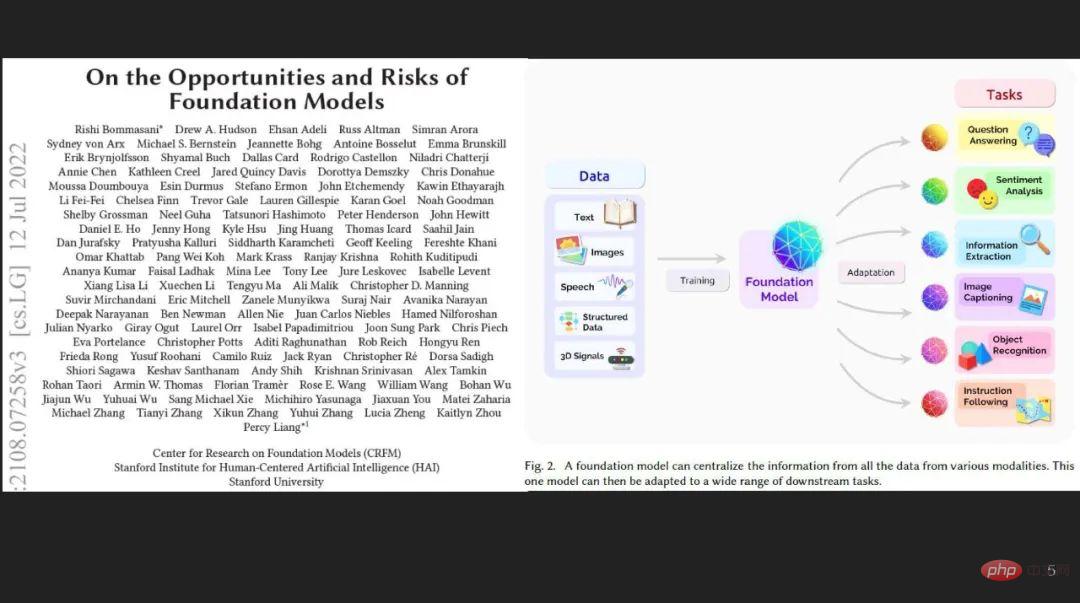

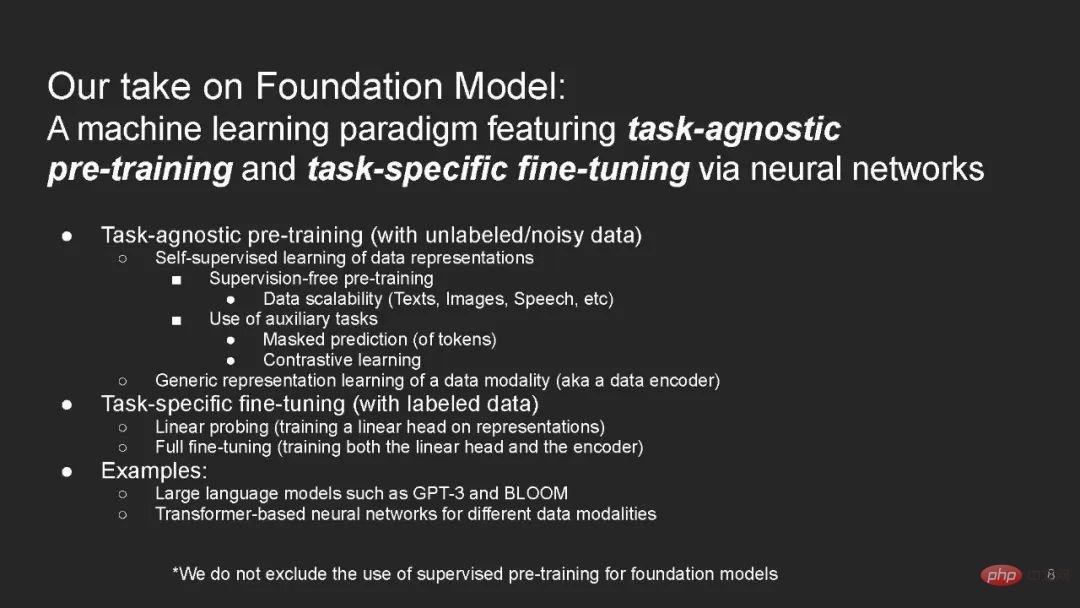

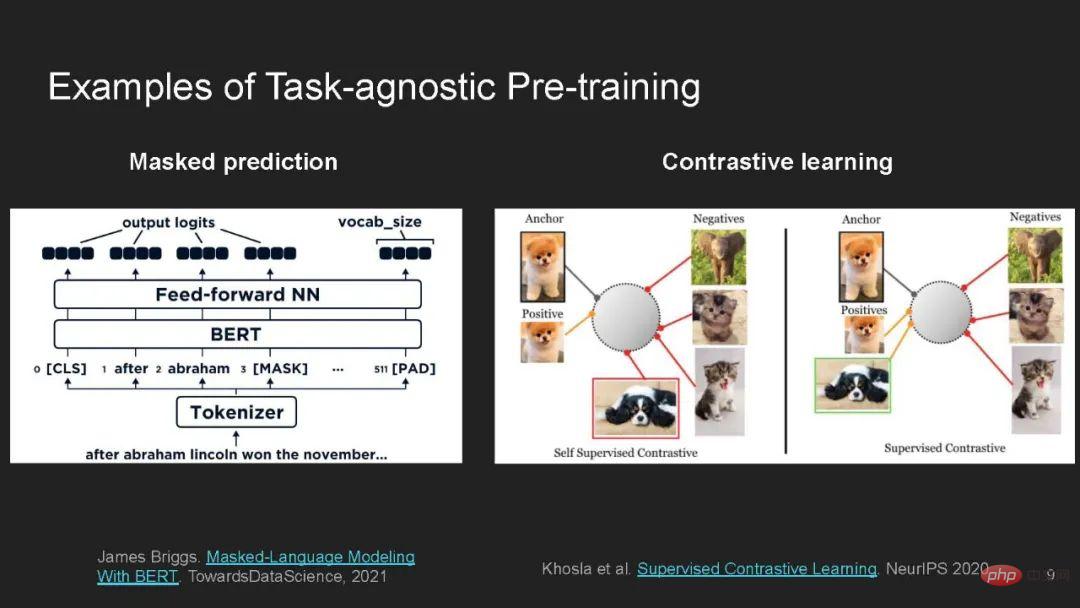

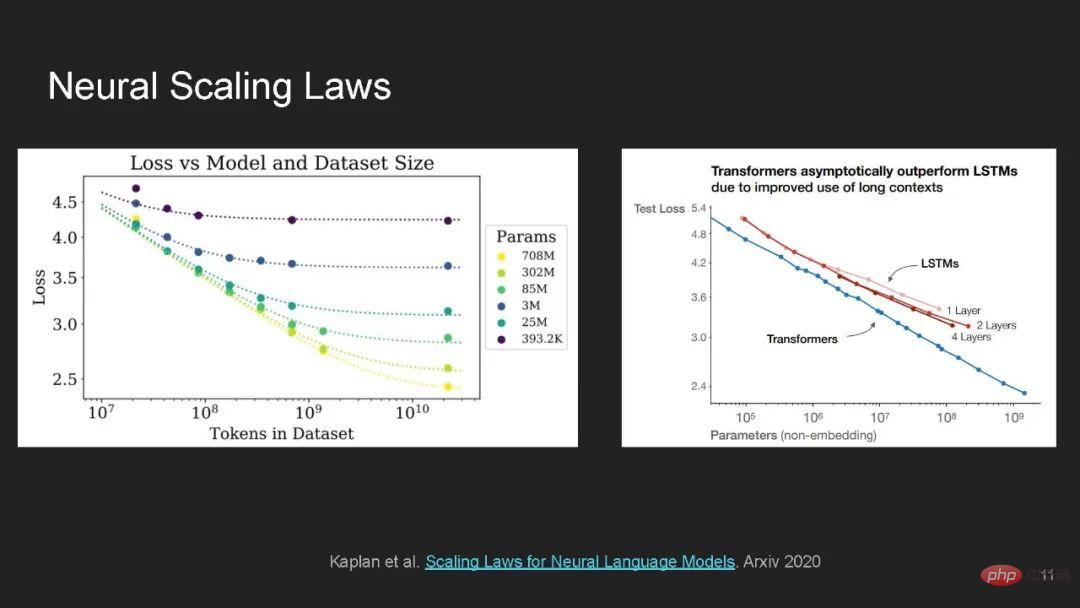

Le modèle de base adopte une méthode d'apprentissage en profondeur, une pré-formation sur des données non étiquetées à grande échelle et un réglage fin grâce à la supervision de tâches spécifiques, qui devient la technologie dominante de l'apprentissage automatique.

Bien que les modèles de base soient très prometteurs dans l'apprentissage des représentations générales et la généralisation peu/zéro à travers les domaines et les modèles de données, ils souffrent en même temps de limitations dues à l'utilisation de volumes de données excessifs et d'architectures de réseaux neuronaux complexes. Cela pose des défis sans précédent et des risques considérables en termes de sécurité et de confidentialité.

Ce didacticiel vise à fournir un didacticiel en ligne de type Coursera avec des conférences complètes, une démonstration pratique et interactive de codage en direct Jupyter/Colab et une discussion de groupe sur différents aspects de la fiabilité dans le modèle sous-jacent.

https://sites.google.com/view/neurips2022-frfm-turotial

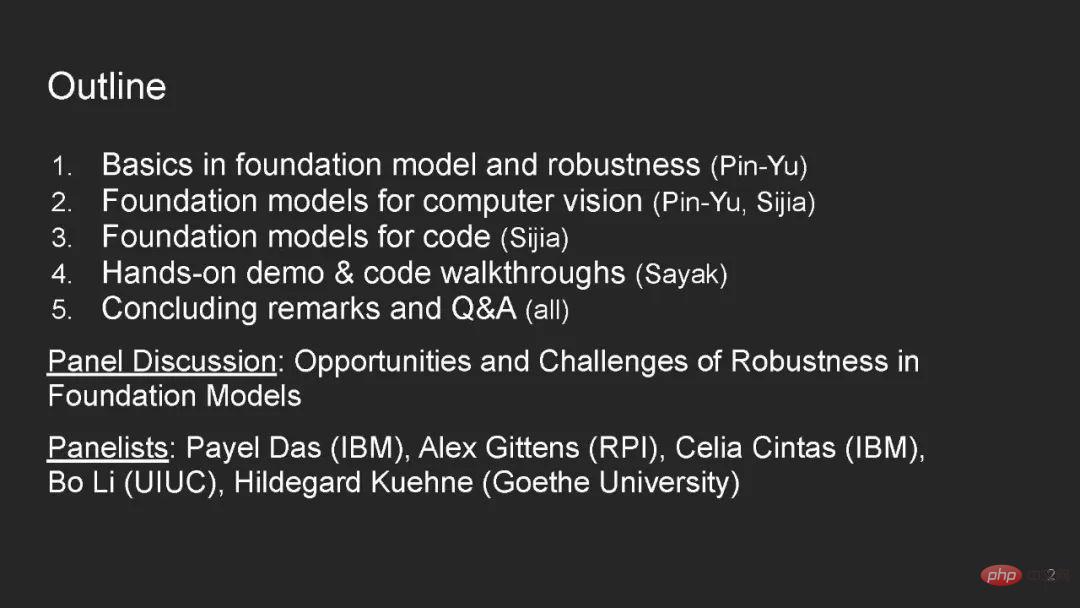

Contenu du répertoire :

- Bases des modèles de fondation et de la robustesse

- Plongée en profondeur sur les modèles de fondation pour ordinateur vision

- Plongée approfondie sur les modèles de base pour le code

- Présentation pratique du code

- Remarques finales

- Q&A

- Discussion en panel

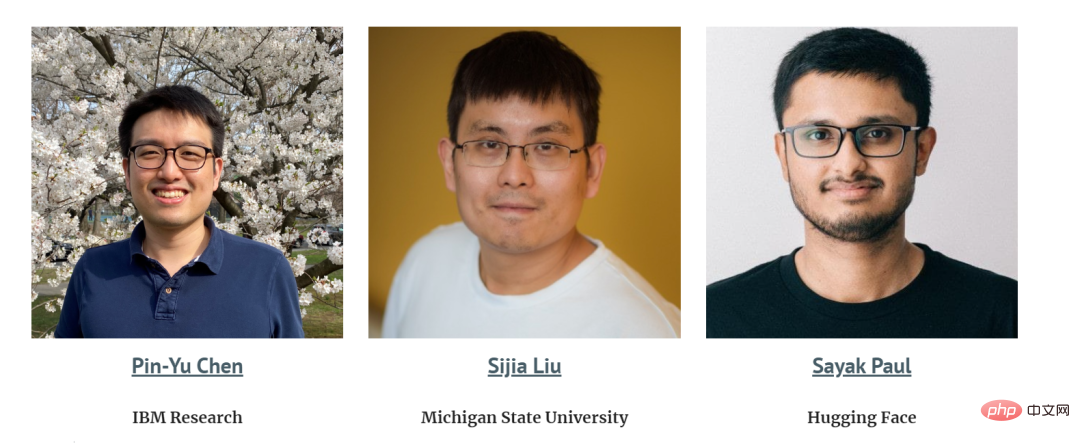

Intervenant :

Les systèmes d'apprentissage automatique du monde réel doivent être robustes aux changements de distribution - ils doivent bien fonctionner sur des distributions de test différentes de la distribution de formation.

Telles que les cartes de pauvreté dans les pays sous-financés [Xie et al. 2016 ; Jean et al. 2016], les voitures autonomes [Yu et al. 2020a], les diagnostics médicaux [AlBadawy et al. al. 2018 ; Dai et Gool 2018] De telles applications à haut risque nécessitent que le modèle se généralise bien à des environnements non visibles dans les données de formation. Par exemple, les échantillons de test proviennent de différents pays, sont dans des conditions de conduite différentes ou proviennent de différents. les hôpitaux.

Des travaux antérieurs ont montré que ces changements de distribution peuvent entraîner une dégradation importante des performances, même pour les modèles de pointe actuels [Blitzer et al. 2006 ; Sugiyama et al. 2007 ; Peng et al. 2019 ; Kumar et al. 2020a ; Yu et al. 2020b ; Geirhos et al. 2020 ;

Un modèle de base est formé sur un ensemble de données non étiquetés vaste et diversifié échantillonné à partir d'une distribution  , et peut ensuite être adapté à de nombreuses tâches en aval.

, et peut ensuite être adapté à de nombreuses tâches en aval.

Pour chaque tâche en aval  , le modèle de base est entraîné sur des données d'entraînement en distribution (ID) étiquetées échantillonnées à partir de la distribution d'entraînement

, le modèle de base est entraîné sur des données d'entraînement en distribution (ID) étiquetées échantillonnées à partir de la distribution d'entraînement  , puis entraîné sur la distribution hors distribution (ID), OOD) est évalué sur la distribution test

, puis entraîné sur la distribution hors distribution (ID), OOD) est évalué sur la distribution test  .

.

Par exemple, un modèle de prévision de carte de pauvreté [Xie et al. 2016 ; Jean et al. 2016] peut apprendre des caractéristiques utiles pour tous les pays à partir de données satellite non étiquetées du monde entier, puis utiliser des échantillons étiquetés du Nigeria Fine-. le réglage est effectué sur des exemples et finalement évalué au Malawi où il y a un manque d'exemples étiquetés.

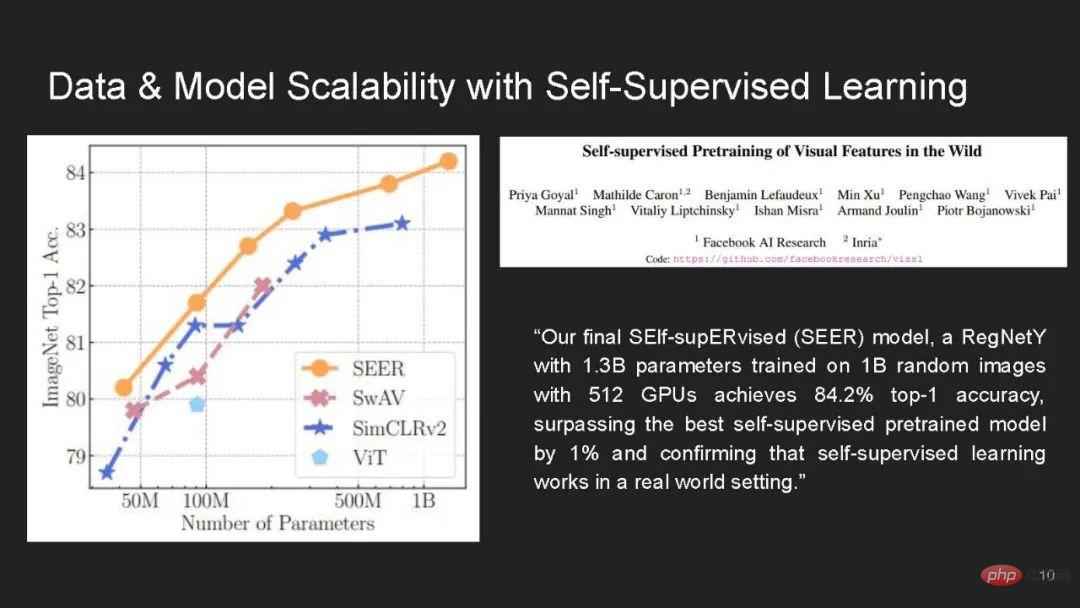

Nous pensons que : 1) Le modèle de base est une approche particulièrement prometteuse en termes de robustesse. Les travaux existants montrent que le pré-entraînement sur des données non étiquetées est une méthode efficace et générale pour améliorer la précision de la distribution des tests OOD, contrairement à de nombreuses interventions de robustesse qui se limitent à des changements de distribution limités.

Cependant, nous avons également discuté de 2) pourquoi le modèle sous-jacent peut ne pas toujours faire face aux changements de distribution, comme certains en raison de corrélations parasites ou de changements de distribution au fil du temps.

Enfin, 3) nous décrivons plusieurs directions de recherche pour exploiter et améliorer la robustesse du modèle sous-jacent.

Nous avons remarqué qu'une façon pour le modèle de base d'améliorer les performances des tâches en aval est de fournir des biais inductifs (via l'initialisation du modèle) pour le modèle adapté. Ces biais sont appris sur une variété d'ensembles de données en plus de l'aval. données de formation.

Cependant, le même biais inductif peut également coder des associations néfastes à partir de données de pré-formation et conduire à des préjudices de représentation et d'affectation en présence de changements de distribution.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI