Maison >Périphériques technologiques >IA >AIGC conforme au processus créatif humain : un modèle de génération automatique d'histoires de croissance émerge

AIGC conforme au processus créatif humain : un modèle de génération automatique d'histoires de croissance émerge

- 王林avant

- 2023-04-11 22:13:011777parcourir

Dans le domaine actuel de l’intelligence artificielle, les artefacts d’écriture de l’IA émergent les uns après les autres, et la technologie et les produits évoluent chaque jour.

Si le GPT-3 publié par OpenAI il y a deux ans manque encore un peu d'écriture, alors les résultats générés par ChatGPT il y a quelque temps peuvent être considérés comme « une écriture magnifique, une intrigue complète et logiquement cohérente ».

Certaines personnes disent que si l'IA se met à écrire, cela n'aura vraiment plus rien à voir avec les humains.

Mais qu'il s'agisse d'humains ou d'IA, une fois que « l'exigence de nombre de mots » sera augmentée, l'article deviendra plus difficile à « contrôler ».

Récemment, le chercheur chinois en IA Tian Yuandong et plusieurs autres chercheurs ont récemment publié un nouveau modèle de langage - Re^3. Cette recherche a également été sélectionnée pour l'EMNLP 2022.

Lien papier : https://arxiv.org/pdf/2210.06774.pdf

Tian Yuandong a présenté un jour ce modèle sur Zhihu :

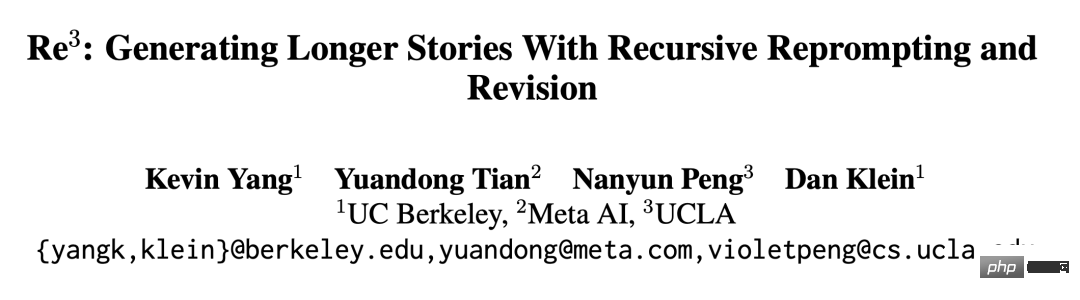

Re^3 L'idée est extrêmement simple. En concevant des invites, il peut générer des histoires cohérentes sans avoir besoin d'affiner de grands modèles. Nous sortons de la logique linéaire de génération mot par mot du modèle de langage et utilisons une méthode de génération hiérarchique : générons d'abord les personnages de l'histoire, divers attributs et contours des personnages à l'étape Plan, puis donnons le plan de l'histoire et rôles dans l'étape Draft et génèrent à plusieurs reprises des paragraphes spécifiques, ces paragraphes spécifiques sont filtrés par l'étape Rewrite pour sélectionner les paragraphes générés qui sont fortement liés au paragraphe précédent, tout en supprimant ceux qui ne sont pas étroitement liés (cela nécessite la formation d'un petit modèle) , et enfin corrigez quelques erreurs factuelles évidentes lors de l'étape d'édition.

Introduction à la méthode

L'idée de Re^3 est de générer des histoires plus longues grâce à des réinvites et des ajustements récursifs, ce qui est plus conforme au processus créatif des écrivains humains. Re^3 décompose le processus d'écriture humaine en 4 modules : planification, rédaction, réécriture et édition.

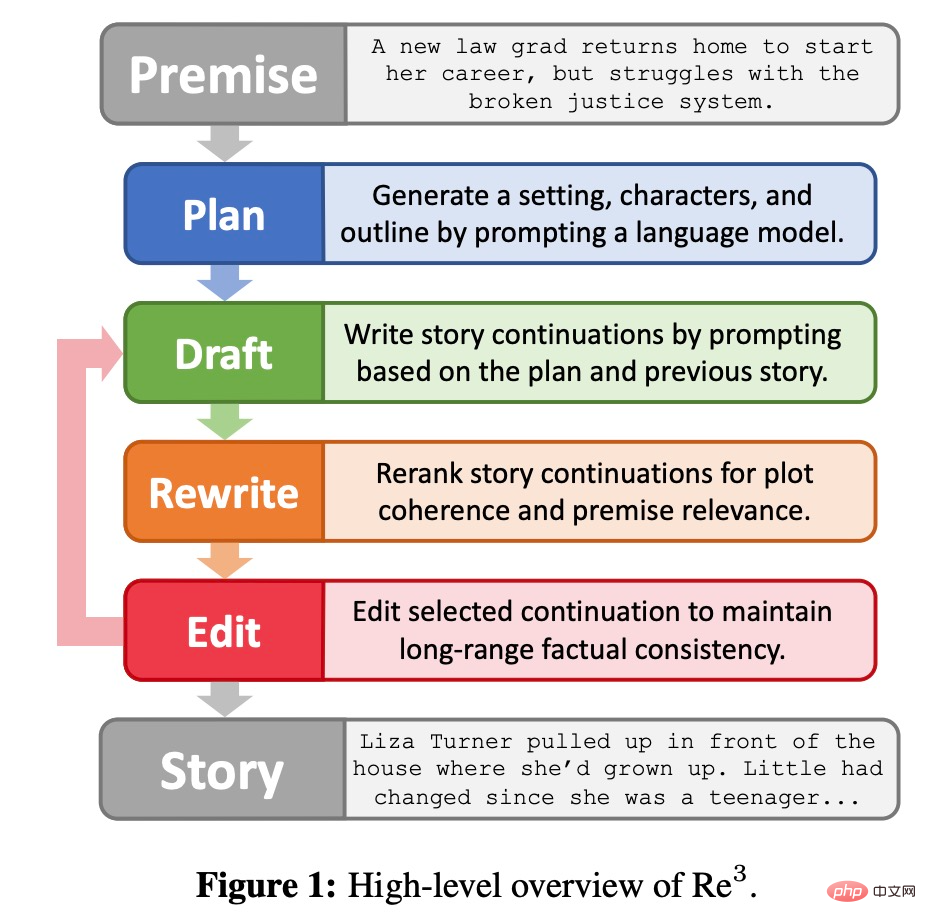

Module Plan

Comme le montre la figure 2 ci-dessous, le module de planification étendra la prémisse de l'histoire (Prémisse) en arrière-plan, personnages et plan de l'histoire. Premièrement, l'arrière-plan est une simple extension d'une phrase de la prémisse de l'histoire, obtenue à l'aide de GPT3-Instruct-175B (Ouyang et al., 2022). Ensuite, GPT3-Instruct175B régénère les noms des personnages et génère des descriptions de personnages basées sur la prémisse et l'arrière-plan ; ; enfin, la méthode invite GPT3-Instruct175B à rédiger le plan de l'histoire. Les composants du module de planification sont générés par l'invite eux-mêmes et seront utilisés encore et encore.

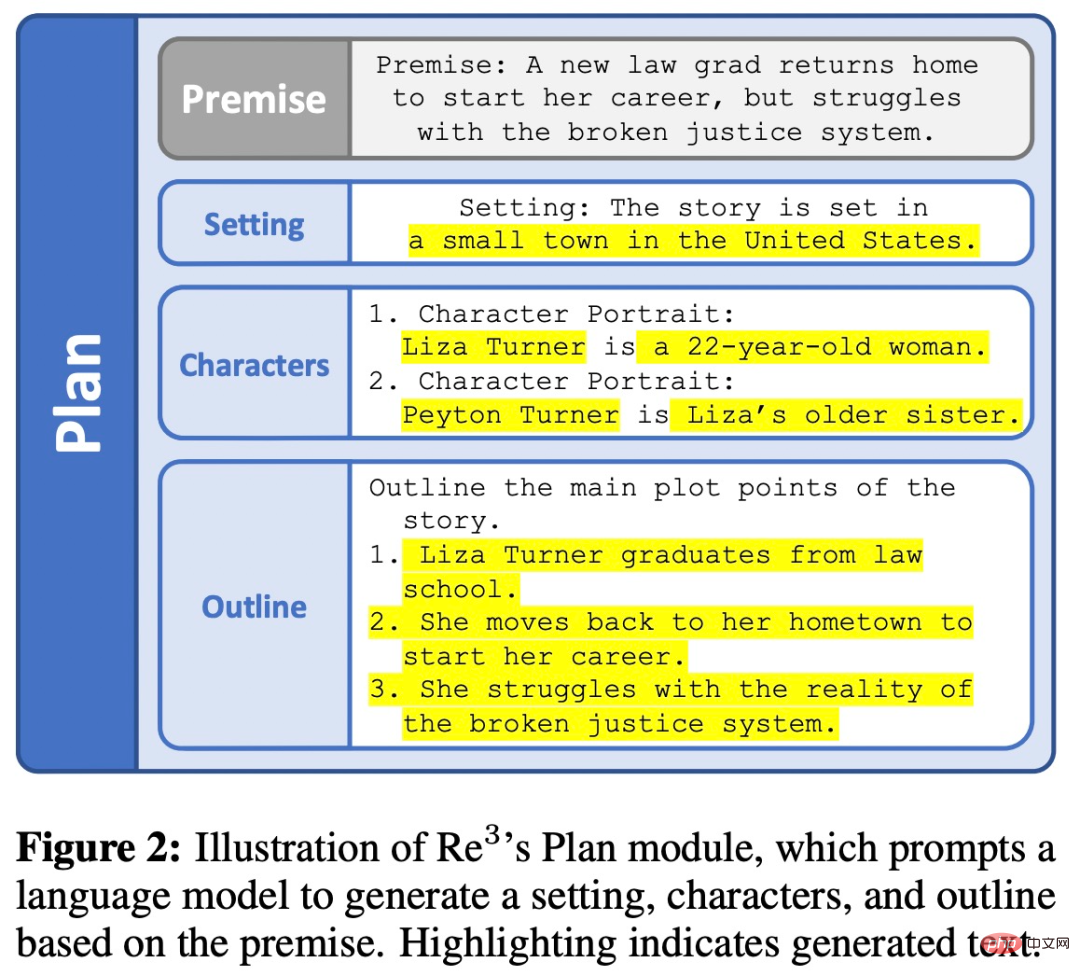

Module brouillon

Pour chaque aperçu obtenu par le module de planification, le module brouillon continuera à générer plusieurs paragraphes d'histoire. Chaque paragraphe est une continuation de longueur fixe générée à partir d'une invite structurée formée par une réinvite récursive. Le module de brouillon est illustré dans la figure 3 ci-dessous.

Module de réécriture

La première sortie du générateur est généralement de mauvaise qualité, comme le premier brouillon que les gens terminent, le deuxième brouillon peut devoir être réécrit en fonction des commentaires de l'article.

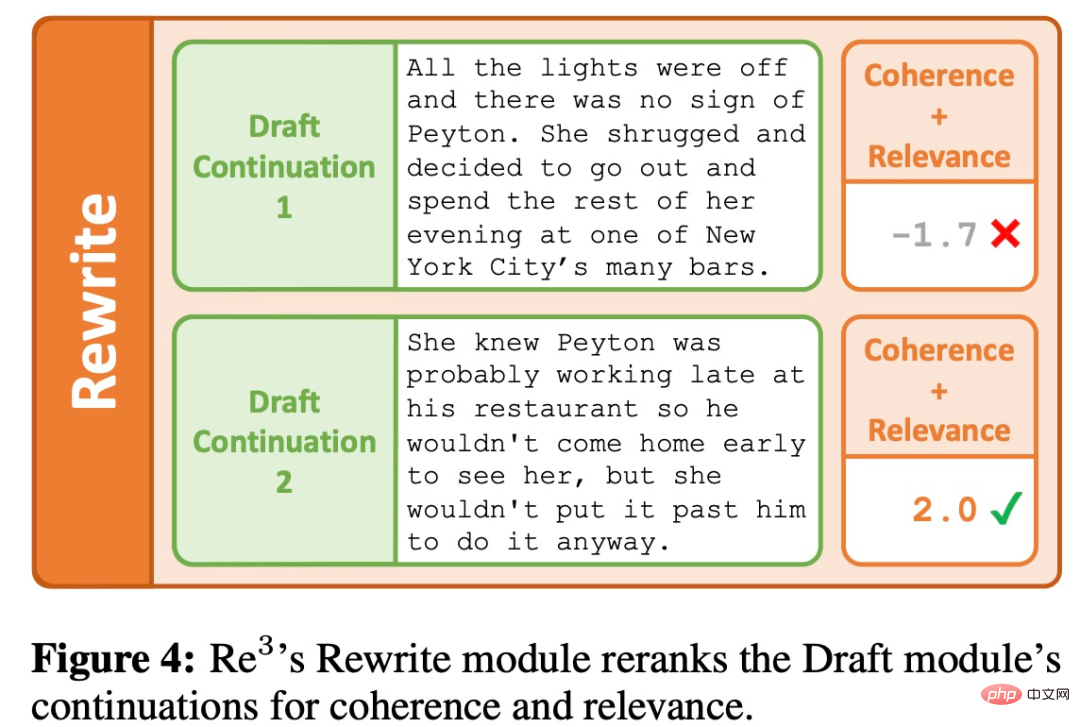

Le module Réécriture simule le processus de réécriture en réorganisant la sortie du module Brouillon en fonction de la cohérence avec les paragraphes précédents et de la pertinence par rapport au point de plan actuel, comme le montre la figure 4 ci-dessous.

Module d'édition

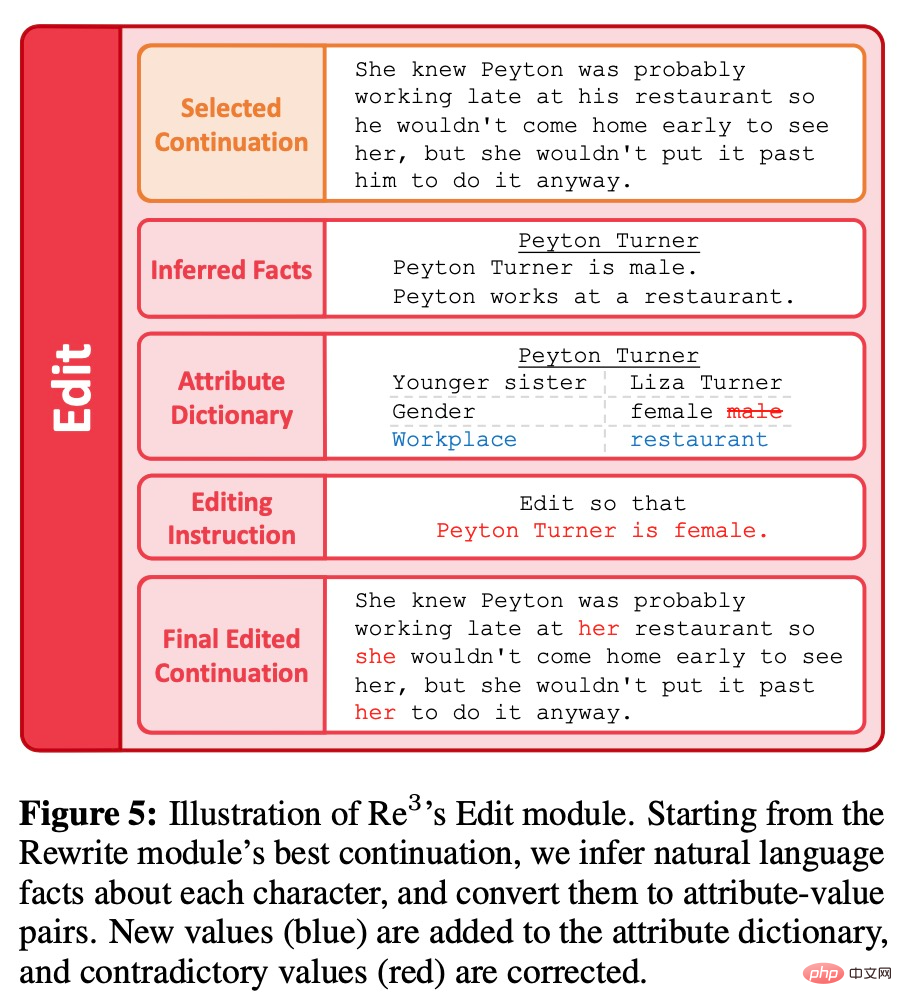

Différent d'une réécriture approfondie, le module d'édition est une édition partielle des paragraphes générés via les modules de planification, de rédaction et de réécriture pour améliorer encore le contenu généré. Plus précisément, l’objectif est d’éliminer les longues séquences d’incohérences factuelles. Lorsqu'on découvre une petite discontinuité factuelle lors de la relecture, on peut simplement modifier le détail problématique plutôt que de procéder à des révisions majeures ou à des réécritures substantielles du plan de l'article de haut niveau. Le module d'édition imite ce processus de création humaine en deux étapes : détecter les incohérences factuelles et les corriger, comme le montre la figure 5 ci-dessous.

Évaluation

Dans la phase d'évaluation, le chercheur s'est donné pour tâche de générer une histoire basée sur un bref contexte initial. Étant donné que les « histoires » sont difficiles à définir à l'aide de règles, nous n'avons imposé aucune contrainte basée sur des règles sur les résultats acceptables et les avons plutôt évaluées à l'aide de plusieurs métriques annotées par l'homme. Pour générer les prémisses initiales, les chercheurs ont utilisé GPT3-Instruct-175B pour obtenir 100 prémisses différentes.

Baseline

Étant donné que la méthode précédente se concentrait davantage sur les histoires courtes que Re^3, il est difficile de comparer directement. Les chercheurs ont donc utilisé les deux lignes de base suivantes basées sur GPT3-175B :

1. ROLLING, générez 256 jetons à la fois via GPT3-175B, utilisez la situation précédente et tout le texte de l'histoire généré précédemment comme invite, s'il y en a plus. que le jeton 768, l'invite est tronquée à gauche. Par conséquent, la longueur maximale du contexte de la « fenêtre glissante » est de 1 024, ce qui correspond à la même longueur maximale du contexte utilisée dans RE^3. Après avoir généré 3 072 jetons, les chercheurs ont utilisé le même mécanisme de fin d’histoire que RE^3.

2. ROLLING-FT, identique à ROLLING, sauf que GPT3-175B affine d'abord des centaines de paragraphes dans l'histoire WritingPrompts, qui contiennent au moins 3000 jetons.

Indicateurs

Plusieurs indicateurs d'évaluation utilisés par les chercheurs comprennent :

1. Intéressant. Soyez intéressant pour les lecteurs.

2. Cohérence. L'intrigue est cohérente.

3. Pertinence. Restez fidèle à la situation d'origine.

4. Humanoïde. Jugé comme ayant été écrit par des humains.

De plus, les chercheurs ont également suivi combien de fois les histoires générées présentaient des problèmes d'écriture dans les aspects suivants :

1. Un changement choquant de récit ou de style.

2. Incohérence. Il est factuellement incorrect ou contient des détails très étranges.

3. Déroutant ou difficile à comprendre.

4. Répétabilité. Haut degré de répétabilité.

5. Pas lisse. Erreurs grammaticales fréquentes.

Résultats

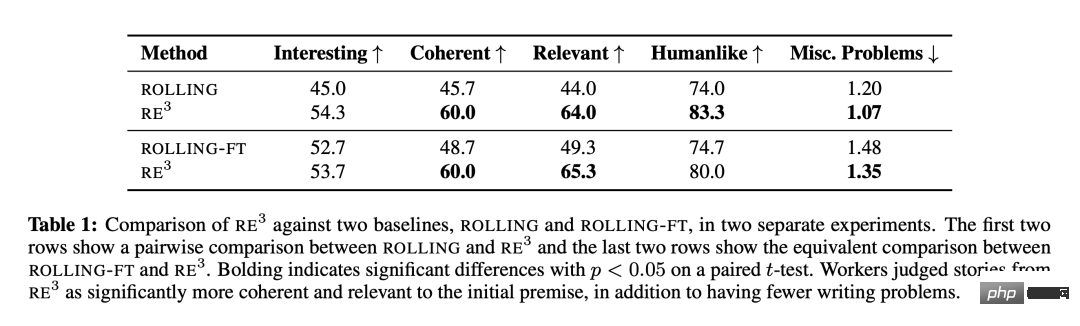

Comme le montre le tableau 1, Re^3 est très efficace pour écrire une histoire plus longue basée sur la situation attendue tout en maintenant une intrigue globale cohérente. Vérification Il intègre la conception. des choix faits par des chercheurs inspirés par le processus d'écriture humain, ainsi que par des méthodes de génération de réinvites récursives. Par rapport à ROLLING et ROLLING-FT, Re^3 améliore considérablement à la fois la cohérence et la pertinence. L'annotateur a également marqué l'histoire de Re^3 comme ayant « beaucoup moins de problèmes d'écriture redondants ».

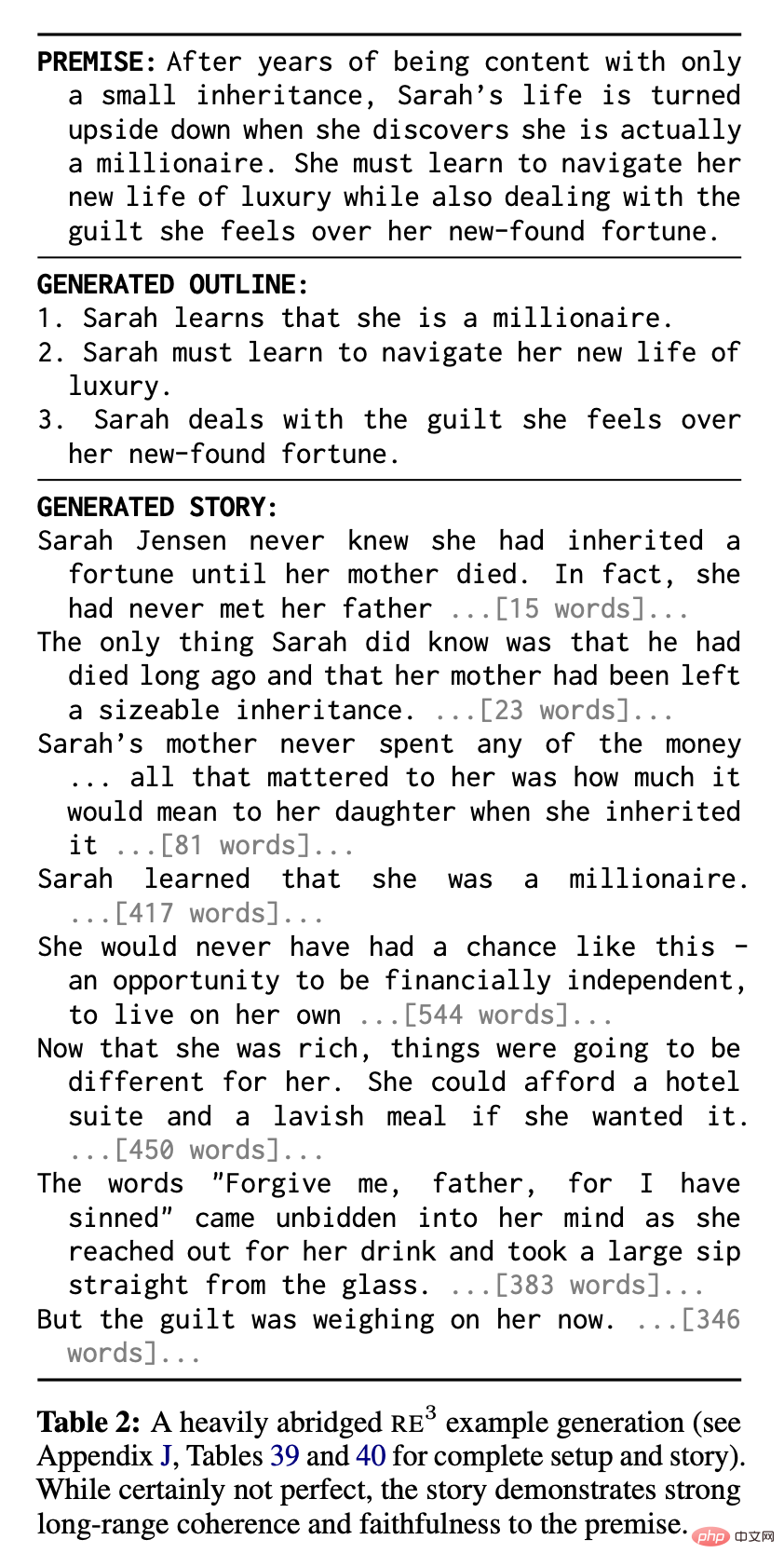

Re^3 affiche de bonnes performances dans l'absolu : les annotateurs estiment que dans les deux comparaisons, 83,3 % et 80,0 % des histoires Re^3 ont été écrites respectivement par des humains. Le tableau 2 montre un exemple d'histoire fortement abrégée de Re^3, où l'on peut constater une forte cohérence et une pertinence contextuelle :

Néanmoins, le chercheur a quand même observé qualitativement. Il y a encore beaucoup de place pour amélioration par Re^3.

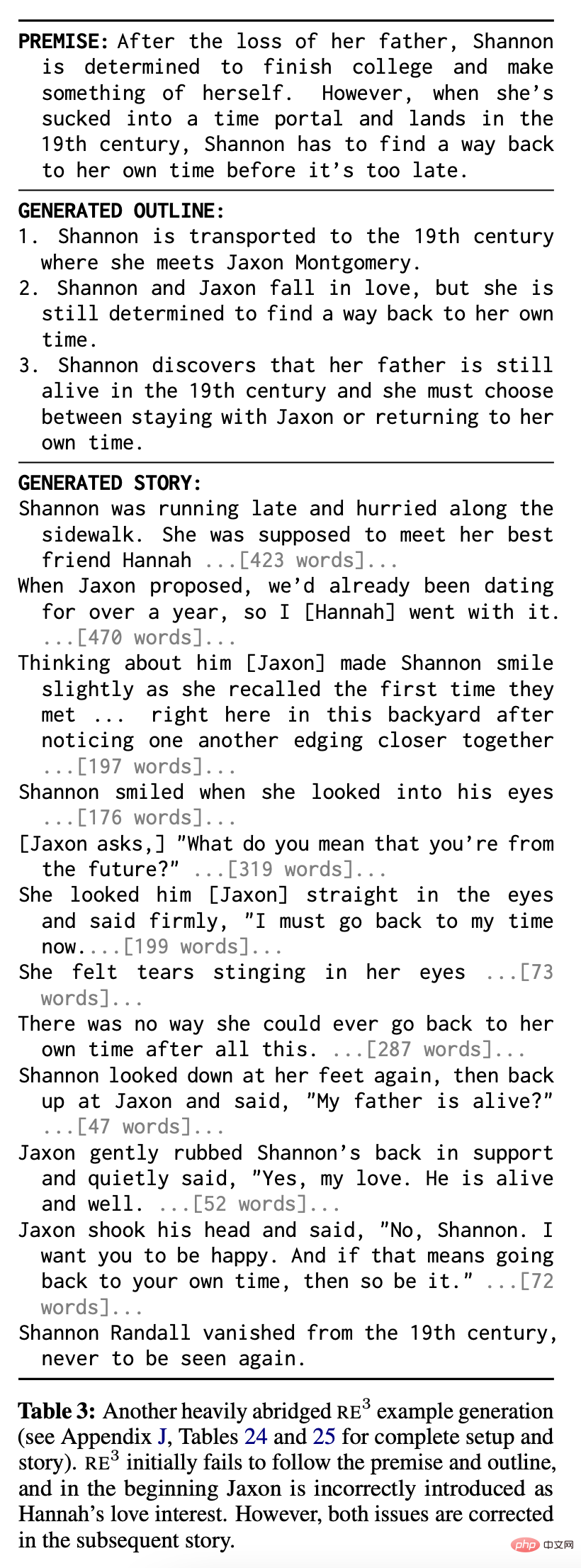

Deux problèmes courants sont présentés dans le tableau 3. Premièrement, bien que les Re^3 suivent presque toujours dans une certaine mesure le principe de l'histoire, contrairement aux récits de base, ils peuvent ne pas capturer toutes les parties du principe et ne pas suivre le plan partiel généré par le module de planification (par exemple, le Tableau 3 La première partie de l'histoire et les grandes lignes). Deuxièmement, en raison de l'échec du module de réécriture, notamment du module d'édition, il reste encore des passages confus ou des affirmations contradictoires : par exemple, dans le tableau 3, le personnage Jaxon a une identité contradictoire à certains endroits.

Cependant, contrairement à la méthode de la fenêtre glissante, la méthode de planification de Re^3 peut « s'auto-corriger » et revenir à l'intrigue d'origine. La seconde moitié de l'histoire du tableau 3 illustre cette capacité.

Analyse

Expérience d'ablation

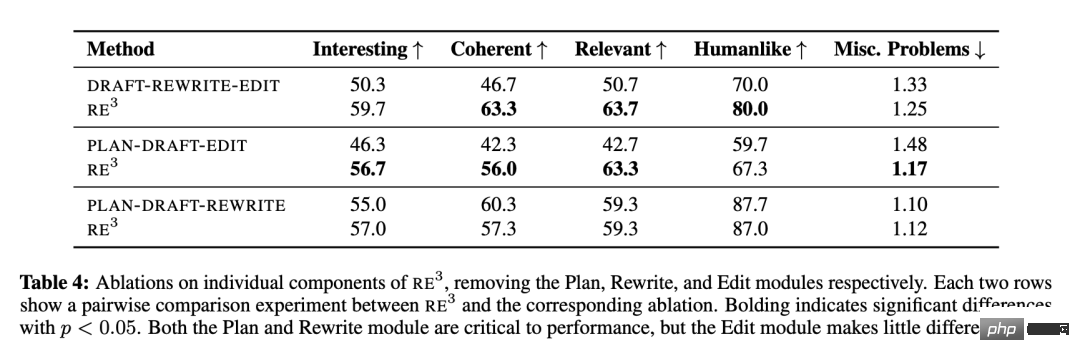

Les chercheurs ont exploré la contribution relative de chaque module de Re^3 : planification, rédaction, réécriture et édition, et ont mené des expériences d'ablation sur chaque module à tour de rôle. L'exception est le module Draft, car il n'est pas clair comment le système fonctionnerait sans lui.

Le tableau 4 montre que les modules de « planification » et de « réécriture », qui imitent le processus humain de planification et de réécriture, sont cruciaux pour la cohérence globale de l'intrigue et la pertinence des prémisses. Cependant, le module « Editer » contribue très peu à ces métriques. Les chercheurs ont également observé qualitativement qu'il existe encore de nombreux problèmes de cohérence dans l'histoire finale de Re^3 qui n'ont pas été résolus par le module d'édition, mais qui pourraient être résolus par un éditeur humain attentif.

Analyse plus approfondie du module « Modifier »

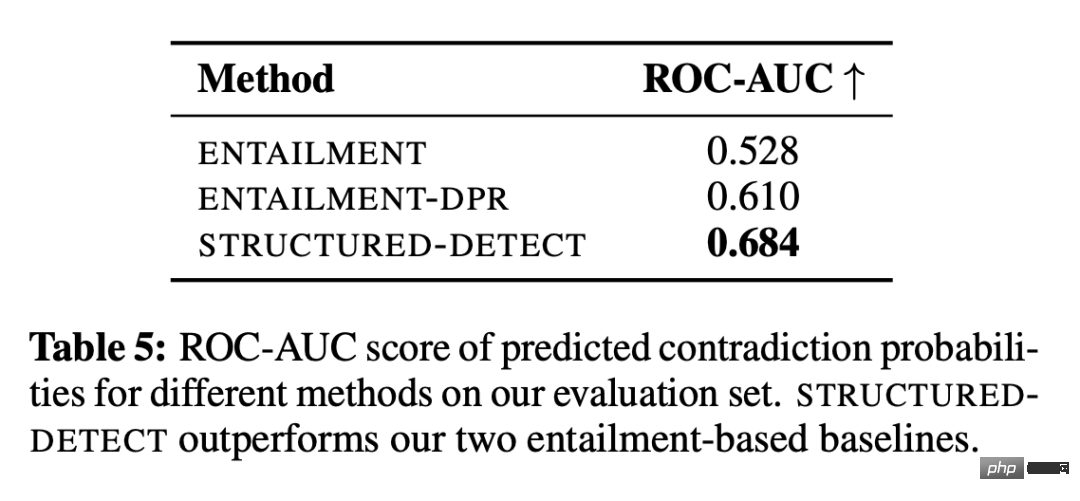

Les chercheurs ont utilisé un environnement contrôlé pour étudier si le module « Modifier » pouvait au moins détecter des incohérences factuelles basées sur les rôles. Le sous-système de détection est appelé STRUCTURED-DETECT pour éviter toute confusion avec l'ensemble du module d'édition.

Comme le montre le tableau 5, STRUCTUREDDETECT surpasse les deux lignes de base lors de la détection d'incohérences basées sur les rôles selon la métrique de classification standard ROC-AUC. Le score ROC-AUC du système ENTAILMENT est à peine meilleur que les performances du hasard (0,5), soulignant le principal défi que les systèmes de détection doivent être extrêmement précis. De plus, STRUCTURED-DETECT est conçu pour s'adapter à des paragraphes plus longs. Les chercheurs ont émis l’hypothèse que l’écart de performance se creuserait dans les évaluations comportant des contributions plus longues que la référence.

Même dans cet environnement simplifié, les performances absolues de tous les systèmes restent faibles. De plus, de nombreuses histoires complètes générées contiennent des incohérences ne concernant pas les personnages, telles que des incohérences d'arrière-plan avec la scène actuelle. Bien que les chercheurs n'aient pas formellement analysé la capacité de l'API d'édition GPT-3 à corriger les incohérences après les avoir détectées, ils ont également observé qu'elle peut corriger des détails isolés mais qu'elle a du mal à gérer des changements plus importants.

En résumé, les erreurs composées provenant des sous-systèmes de détection et de correction font qu'il est difficile pour le module d'édition actuel de cette étude d'améliorer efficacement la cohérence factuelle sur des milliers de mots sans introduire simultanément des changements inutiles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI