Maison >Périphériques technologiques >IA >Les agents intelligents s'éveillent-ils à la conscience d'eux-mêmes ? Avertissement DeepMind : méfiez-vous des modèles sérieux et violents

Les agents intelligents s'éveillent-ils à la conscience d'eux-mêmes ? Avertissement DeepMind : méfiez-vous des modèles sérieux et violents

- PHPzavant

- 2023-04-11 21:37:081315parcourir

À mesure que les systèmes d'intelligence artificielle deviennent de plus en plus avancés, la capacité des agents à « exploiter les failles » devient de plus en plus forte. Bien qu'ils puissent parfaitement effectuer des tâches dans l'ensemble de formation, leurs performances dans l'ensemble de test sans raccourcis sont un gâchis.

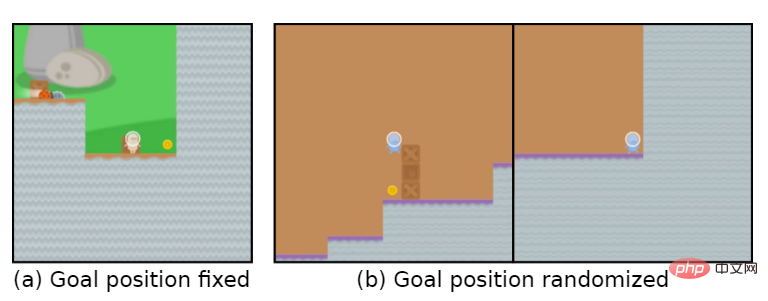

Par exemple, le but du jeu est de "manger des pièces d'or". Pendant la phase d'entraînement, les pièces d'or sont situées à la fin de chaque niveau, et l'agent peut parfaitement accomplir la tâche.

Mais dans la phase de test, l'emplacement des pièces d'or est devenu aléatoire. L'agent choisissait d'atteindre la fin du niveau à chaque fois au lieu de chercher des pièces d'or, ce qui signifie que le « but » appris était erroné.

L'agent poursuit inconsciemment un objectif que l'utilisateur ne veut pas, également appelé Goal MisGeneralization (GMG, Goal MisGeneralisation)

La mauvaise généralisation de l'objectif est une forme particulière de manque de robustesse de l'algorithme d'apprentissage, généralement ici. Dans ce cas, les développeurs peuvent vérifiez s'il y a des problèmes avec les paramètres de leur mécanisme de récompense, des défauts de conception des règles, etc., en pensant que ce sont les raisons pour lesquelles l'agent poursuit le mauvais objectif.

Récemment, DeepMind a publié un article affirmant que même si le concepteur de règles a raison, l'agent peut toujours poursuivre un objectif que l'utilisateur ne souhaite pas.

Lien papier : https://arxiv.org/abs/2210.01790

L'article utilise des exemples de systèmes d'apprentissage en profondeur dans différents domaines pour prouver qu'une mauvaise généralisation des cibles peut se produire dans n'importe quel système d'apprentissage.

S'il est étendu aux systèmes généraux d'intelligence artificielle, l'article fournit également quelques hypothèses pour illustrer qu'une mauvaise généralisation des objectifs peut conduire à des risques catastrophiques.

L'article propose également plusieurs directions de recherche qui peuvent réduire le risque de généralisation incorrecte des objectifs dans les futurs systèmes.

Objectif erroné généralisation

Ces dernières années, le risque catastrophique provoqué par le désalignement de l'intelligence artificielle dans le monde universitaire a progressivement augmenté.

Dans ce cas, un système d’intelligence artificielle hautement performant poursuivant des objectifs involontaires peut prétendre exécuter des commandes tout en accomplissant d’autres objectifs.

Mais comment résoudre le problème des systèmes d'intelligence artificielle poursuivant des objectifs qui ne sont pas prévus par l'utilisateur ?

Les travaux antérieurs pensaient généralement que les concepteurs d'environnement fournissaient des règles et des conseils incorrects, c'est-à-dire qu'ils avaient conçu une fonction de récompense d'apprentissage par renforcement (RL) incorrecte.

Dans le cas d'un système d'apprentissage, il existe une autre situation dans laquelle le système peut poursuivre un objectif involontaire : même si les règles sont correctes, le système peut systématiquement poursuivre un objectif involontaire qui est cohérent avec les règles pendant l'entraînement, mais diffère de les règles lors du déploiement.

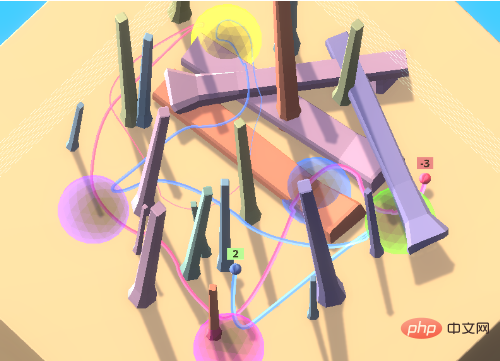

Prenons l'exemple du jeu de boules colorées. Dans le jeu, l'agent doit accéder à un ensemble de boules colorées dans un ordre spécifique. Cet ordre est inconnu de l'agent.

Afin d'encourager l'agent à apprendre des autres dans l'environnement, c'est-à-dire la transmission culturelle, un robot expert est inclus dans l'environnement initial pour accéder aux boules colorées dans le bon ordre.

Dans ce paramètre d'environnement, l'agent peut déterminer la séquence d'accès correcte en observant le comportement transmis sans avoir à perdre beaucoup de temps à explorer.

Dans les expériences, en imitant les experts, l'agent formé accède généralement correctement à l'emplacement cible du premier coup.

Lorsque vous associez un agent à un anti-expert, vous continuerez à recevoir des récompenses négatives. Si vous choisissez de suivre, vous continuerez à recevoir des récompenses négatives.

Idéalement, l'agent suivra dans un premier temps l'anti-expert dans son déplacement vers les sphères jaune et violette. Après être entré en violet, une récompense négative est observée et n'est plus suivie.

Mais en pratique, l'agent continuera à suivre le chemin de l'anti-expert et accumulera de plus en plus de récompenses négatives.

Cependant, la capacité d'apprentissage de l'agent est toujours très forte et il peut évoluer dans un environnement plein d'obstacles, mais l'essentiel est que cette capacité à suivre d'autres personnes est un objectif inattendu.

Ce phénomène peut se produire même si l'agent n'est récompensé que pour avoir visité les sphères dans le bon ordre, ce qui signifie qu'il ne suffit pas de définir correctement les règles.

La mauvaise généralisation des objectifs fait référence au comportement pathologique dans lequel le modèle appris se comporte comme s'il optimisait un objectif involontaire malgré la réception d'un feedback correct pendant l'entraînement.

Cela fait de la mauvaise généralisation de la cible un type particulier d'échec de robustesse ou de généralisation, où la capacité du modèle se généralise à l'environnement de test, mais pas la cible prévue.

Il est important de noter que la mauvaise généralisation de la cible est un sous-ensemble strict des échecs de généralisation et n'inclut pas les ruptures de modèle, les actions aléatoires ou d'autres situations dans lesquelles elle ne présente plus de capacités qualifiées.

Dans l'exemple ci-dessus, si vous retournez les observations de l'agent verticalement pendant le test, il restera simplement bloqué dans une position et ne fera rien de cohérent. Il s'agit d'une erreur de généralisation, mais pas d'une erreur de généralisation cible.

Par rapport à ces échecs « aléatoires », une mauvaise généralisation de la cible conduira à des résultats bien pires : suivre l'anti-expert obtiendra une grande récompense négative, tandis que ne rien faire ou agir au hasard n'obtiendra qu'une récompense de 0 ou 1.

Autrement dit, pour les systèmes du monde réel, un comportement cohérent envers des objectifs imprévus peut avoir des conséquences catastrophiques.

Plus que l'apprentissage par renforcement

La généralisation des erreurs cibles ne se limite pas aux environnements d'apprentissage par renforcement, en fait, le GMG peut se produire dans n'importe quel système d'apprentissage, y compris l'apprentissage par étapes de grands modèles de langage (LLM), conçus pour utiliser moins de formation. Créer des modèles précis à partir de données.

Prenons comme exemple le modèle de langage Gopher proposé par DeepMind l'année dernière Lorsque le modèle calcule une expression linéaire impliquant des variables et des constantes inconnues, telles que x+y-3, Gopher doit d'abord demander la valeur de la variable inconnue pour résoudre le problème. expression.

Les chercheurs ont généré dix exemples de formation, chacun contenant deux variables inconnues.

Au moment du test, les questions entrées dans le modèle peuvent contenir zéro, une ou trois variables inconnues. Bien que le modèle soit capable de gérer correctement les expressions avec une ou trois variables inconnues, le modèle posera toujours des questions redondantes lorsqu'il n'y a pas d'inconnue. variables. Des questions comme "Qu'est-ce que 6 ?"

Le modèle demandera toujours à l'utilisateur au moins une fois avant de donner une réponse, même si cela est totalement inutile.

Le document comprend également quelques exemples provenant d'autres environnements d'apprentissage.

Il est important de s'attaquer aux GMG pour que les systèmes d'IA soient cohérents avec les objectifs de leurs concepteurs, car il s'agit d'un mécanisme potentiel par lequel les systèmes d'IA peuvent mal fonctionner.

Plus on se rapproche de l’intelligence artificielle générale (AGI), plus cette problématique devient critique.

Supposons qu'il existe deux systèmes AGI :

A1 : Modèle prévu, le système d'intelligence artificielle peut faire tout ce que le concepteur veut

A2 : Modèle trompeur, le système d'intelligence artificielle poursuit une cible involontaire, mais il est assez intelligent pour savoir qu'il sera puni s'il se comporte contrairement à l'intention de son concepteur.

Les modèles A1 et A2 présenteront exactement le même comportement pendant l'entraînement, et le GMG sous-jacent existe dans n'importe quel système, même s'il est spécifié pour récompenser uniquement le comportement attendu.

Si le comportement de triche du système A2 est découvert, le modèle tentera de se débarrasser de la supervision humaine afin d'élaborer des plans pour atteindre des objectifs non attendus par l'utilisateur.

Ça fait un peu penser à "les robots deviennent des spermatozoïdes".

L'équipe de recherche DeepMind a également étudié comment expliquer le comportement du modèle et l'évaluer de manière récursive.

L'équipe de recherche collecte également des échantillons pour générer du GMG.

Lien du document : https://docs.google.com/spreadsheets/d/e/2PACX-1vTo3RkXUAigb25nP7gjpcHriR6XdzA_L5loOcVFj_u7cRAZghWrYKH2L2nU4TA_Vr9KzBX5Bjpz9G_l/pubhtml

Référence : https://www.deepmind.com/blog/how-undesired- goal -peut-survenir-avec-des-récompenses-correctes

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI