Maison >Périphériques technologiques >IA >Le chanteur de Google AI arrive ! AudioLM peut composer de la musique et des chansons en les écoutant simplement pendant quelques secondes.

Le chanteur de Google AI arrive ! AudioLM peut composer de la musique et des chansons en les écoutant simplement pendant quelques secondes.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-11 21:10:061101parcourir

Modèle de génération d'images déployé ! Modèles génératifs vidéo déployés !

Le prochain est le modèle de génération audio.

Récemment, l'équipe de recherche de Google a lancé un modèle d'IA pour la génération vocale-AudioLM.

Avec seulement quelques secondes d'invites audio, il peut générer non seulement un discours cohérent et de haute qualité, mais également de la musique de piano.

Adresse papier : https://www.php.cn/link/b6b3598b407b7f328e3129c74ca8ca94

AudioLM est un cadre de génération audio de haute qualité avec une cohérence à long terme, qui mappe l'audio d'entrée en une chaîne de jetons discrets, et Transformer les tâches de génération audio en tâches de modélisation du langage.

Les tagueurs audio existants doivent faire un compromis entre la qualité de la génération audio et une structure stable à long terme.

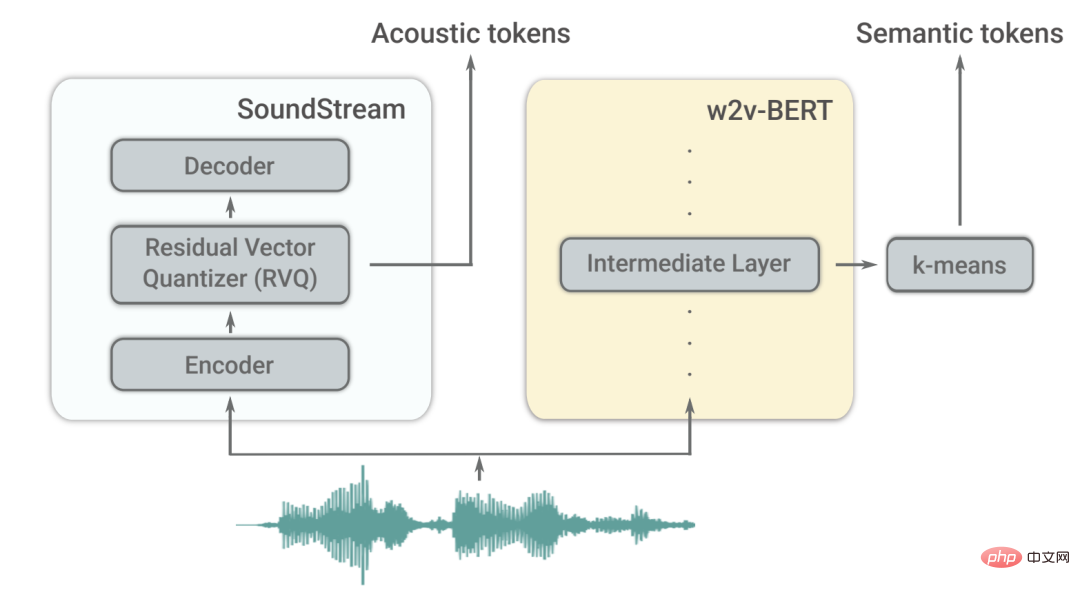

Afin de résoudre cette contradiction, Google adopte une solution de « tokenisation hybride », utilisant l'activation discrétisée de modèles de langage de masque pré-entraînés et utilisant les codes discrets générés par le codec audio neuronal pour obtenir une synthèse de haute qualité.

Le modèle AudioLM peut apprendre à générer des mots continus naturels et cohérents sur la base de courtes invites. Lorsqu'il est entraîné à la parole, il génère des mots continus syntaxiquement fluides et sémantiquement raisonnables sans aucun enregistrement ni annotation, tout en conservant l'identité et l'intonation. du locuteur.

En plus de la parole, AudioLM peut également générer une musique de piano cohérente sans même avoir besoin de s'entraîner sur une quelconque notation musicale.

Du texte à la musique pour piano : deux problèmes majeurs

Ces dernières années, les modèles linguistiques formés sur des corpus de textes massifs ont montré leurs excellentes capacités génératives, réalisant un dialogue ouvert, une traduction automatique et même un raisonnement de bon sens, ainsi qu'une capacité à modéliser signaux autres que le texte, tels que des images naturelles.

L'idée d'AudioLM est de tirer parti de ces avancées en matière de modélisation du langage pour générer de l'audio sans formation sur les données annotées.

Mais cela doit faire face à deux problèmes.

Premièrement, le débit de données pour l'audio est beaucoup plus élevé et la séquence d'unités est plus longue. Par exemple, une phrase contient des dizaines de représentations de caractères, mais après avoir été convertie en forme d'onde audio, elle contient généralement des centaines de milliers de valeurs.

De plus, il existe une relation un-à-plusieurs entre le texte et l'audio. La même phrase peut être présentée par différents locuteurs avec des styles, un contenu émotionnel et un contexte différents.

Pour surmonter ces deux défis, AudioLM utilise deux types de balises audio.

Tout d'abord, les balises sémantiques sont extraites de w2v-BERT, un modèle audio auto-supervisé.

Ces balises peuvent capturer à la fois les dépendances locales (telles que la parole dans la parole, la mélodie locale dans la musique pour piano) et la structure globale à long terme (telle que la syntaxe linguistique et le contenu sémantique dans la parole, la musique pour piano) l'harmonie et le rythme), tout en sous-échantillonnant fortement le signal audio afin de modéliser de longues séquences.

Cependant, la fidélité de l'audio reconstruit à partir de ces jetons n'est pas élevée.

Pour améliorer la qualité sonore, en plus du marquage sémantique, AudioLM utilise également des balises acoustiques générées par le codec neuronal SoundStream pour capturer les détails de la forme d'onde audio (tels que les caractéristiques du haut-parleur ou les conditions d'enregistrement) pour une synthèse de haute qualité.

Comment s'entraîner ?

AudioLM est un modèle uniquement audio formé sans aucune représentation symbolique de texte ou de musique.

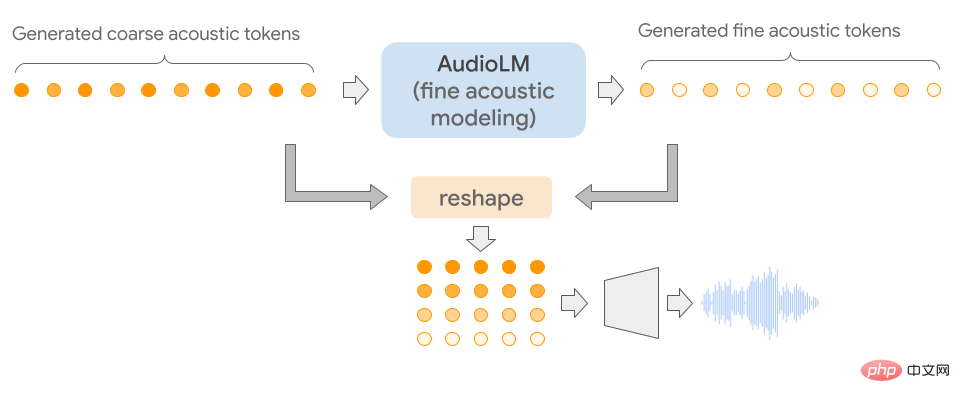

Il modélise les séquences audio de manière hiérarchique en chaînant plusieurs modèles Transformer (un pour chaque étape) du marquage sémantique au marquage acoustique fin.

Chaque étape est entraînée pour prédire le prochain jeton en fonction du dernier jeton, tout comme l'entraînement d'un modèle de langage.

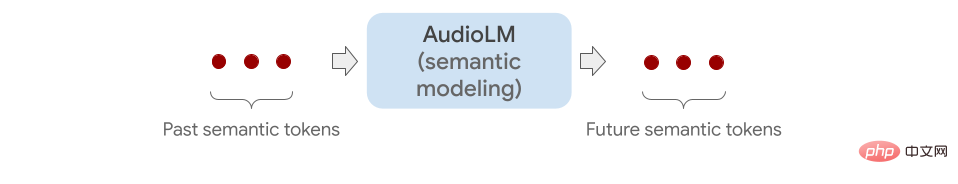

La première étape effectue cette tâche sur des balises sémantiques pour modéliser la structure de haut niveau de la séquence audio.

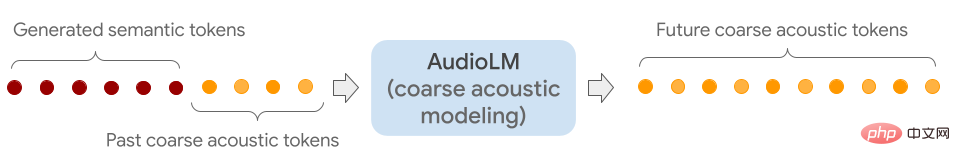

Dans la deuxième étape, en connectant toute la séquence de jetons sémantiques avec les jetons grossiers passés et en fournissant les deux comme conditions au modèle grossier, les futurs jetons sont ensuite prédits.

Cette étape simule les propriétés acoustiques, telles que les caractéristiques du haut-parleur ou le timbre de la musique.

Dans la troisième étape, un modèle acoustique fin est utilisé pour traiter le signal acoustique brut, ajoutant ainsi plus de détails à l'audio final.

Enfin, les marqueurs acoustiques sont introduits dans le décodeur SoundStream pour reconstruire la forme d'onde.

Une fois la formation terminée, AudioLM peut être ajusté sur quelques secondes d'audio, ce qui lui permet de générer un son continu.

Pour démontrer l'applicabilité générale d'AudioLM, les chercheurs l'ont testé à travers 2 tâches dans différents domaines audio.

Le premier est la continuation de la parole. Ce modèle conserve les caractéristiques et la prosodie suggérées du locuteur, tout en produisant également un nouveau contenu grammaticalement correct et sémantiquement cohérent.

Le second est la suite du piano, ce modèle générera une musique de piano cohérente avec l'invite en termes de mélodie, d'harmonie et de rythme.

Comme indiqué ci-dessous, tous les sons que vous entendez après les lignes verticales grises sont générés par AudioLM.

Pour vérifier l'effet, les chercheurs ont demandé à des évaluateurs humains d'écouter de courts clips audio pour déterminer s'il s'agissait d'enregistrements originaux de parole humaine ou d'enregistrements générés par AudioLM.

Selon les notes recueillies, on peut constater qu'AudioLM a un taux de réussite de 51,2%, ce qui signifie que le discours généré par ce modèle d'IA est difficile à distinguer pour les auditeurs ordinaires du discours réel.

Rupal Patel, qui étudie les sciences de l'information et du langage à la Northeastern University, a déclaré que des travaux antérieurs utilisant l'intelligence artificielle pour générer de l'audio ne pouvaient capturer ces nuances que si elles étaient explicitement annotées dans les données d'entraînement.

En revanche, AudioLM apprend automatiquement ces fonctionnalités à partir des données d'entrée et obtient également des résultats haute fidélité.

Avec l'émergence de modèles ML multimodaux tels que GPT3 et Bloom (génération de texte), DALLE et Stable Diffusion (génération d'images), RunwayML et Make-A-Video (génération de vidéos), la création de contenu et le travail créatif évoluent.

Le monde futur est un monde généré par l'intelligence artificielle.

Références :

https://www.php.cn/link/c11cb55c3d8dcc03a7ab7ab722703e0a

https://www.php.cn/link/b6b3598b407b7f328e3129c74 ca 8ca94

https://www.php.cn/link/c5f7756d9f92a8954884ec415f79d120

https://www.php.cn/link/9b644ca9f37e3699ddf2055800130aa9

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI