Maison >Périphériques technologiques >IA >Attendez, ChatGPT ne tombera pas !

Attendez, ChatGPT ne tombera pas !

- PHPzavant

- 2023-04-11 21:01:081897parcourir

Écrit par Yan Zheng

Ça n'avait plus été aussi animé depuis longtemps ! Un produit qui peut susciter de grandes discussions parmi les gens du monde entier est si précieux. J'y ai pensé alors que mon cerveau tournait à grande vitesse, et il semble que la seule façon de le décrire soit d'utiliser le « moment iPhone » du PDG de Nvidia, Jensen Huang. pour le décrire.

Cinq jours après son lancement, le nombre d'utilisateurs a dépassé le million. Deux mois, durée de vie mensuelle de 100 millions.

Alors, quel est le retour sur investissement de la participation à ChatGPT ? L'éditeur a trié le modèle de coûts et de revenus de ChatGPT et a brièvement examiné la présentation et les politiques associées des géants nationaux, ainsi que la manière dont les développeurs devraient y investir. J'espère que cela pourra aider tout le monde.

1. Combien ça coûte de construire un ChatGPT

L'arrivée de ChatGPT, bien que ce soit le "moment iPhone", le coût est scandaleux. Voici une compilation des données de calcul des institutions concernées, divisées en trois aspects : coût d'investissement initial, coût de formation et coût de fonctionnement.

1. Coût d'investissement initial

Guosheng Securities, une société de valeurs mobilières nationale bien connue, a calculé le coût de la puissance de calcul requise par OpenAI à ce stade. En prenant en moyenne environ 13 millions de visiteurs uniques utilisant ChatGPT chaque jour en janvier de cette année, la demande de puces correspondante est de plus de 30 000 GPU NVIDIA A100, le coût d'investissement initial est d'environ 800 millions de dollars américains et la facture d'électricité quotidienne sera également d'environ 50 000 dollars américains.

2. Coût de formation

Uniquement la puce et la base de puissance de calcul, le coût de formation du modèle est également un seuil important. Guosheng Securities estime, sur la base du nombre de paramètres et de jetons, que le coût de la formation GPT-3 est d'environ 1,4 million de dollars ; en utilisant la même formule de calcul pour certains modèles LLM plus importants, le coût de la formation se situe entre 2 et 12 millions de dollars. .

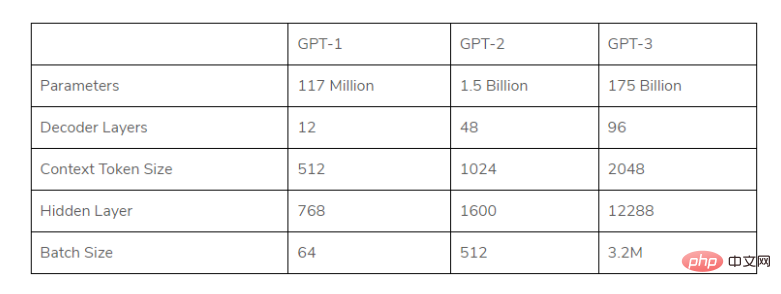

Photo : Aperçu des paramètres GPT de chaque génération

(Dans le cadre du grand modèle, le modèle GPT utilisé par ChatGPT a rapidement augmenté le nombre de paramètres dans chaque génération, ainsi que les exigences en matière de volume de données et les coûts de pré-formation ont également augmenté rapidement. )

3. Coûts de fonctionnement

Le premier est le coût de la réponse : Musk a demandé un jour à ChatGPT sur la plateforme Twitter "Quel est le coût moyen de chaque chat ?" Altmann, PDG d'OpenAI, s'attend à être légèrement amer : le coût moyen du chat GPT est de « centimes à un chiffre », et a déclaré que des efforts doivent être faits pour optimiser les coûts.

Alors, c'est quoi ce « un chiffre » ? L'auteur a obtenu la réponse sur la base des données suivantes.

· En janvier 2023, un rapport d'analyse de la banque d'investissement Morgan Stanley indiquait que le coût d'une réponse à ChatGPT est environ 6 fois à 28 fois le coût moyen d'une requête de recherche Google.

· Selon une dernière analyse de Morgan Stanley, le coût moyen des 3,3 billions de recherches effectuées par Google l'année dernière était d'environ 0,2 centime chacune.

Par conséquent, on peut voir que le coût de réponse au chat ChatGPT est de 1,2 à 5,6 cents.

Alors, combien de consultations y a-t-il chaque jour ? , Selon les données de Similarweb, fin janvier 2023, le site chat.openai.com (le site officiel de ChatGPT) avait attiré jusqu'à 25 millions de visiteurs quotidiens au cours de la semaine du 27 janvier au 3 février.

En supposant que chaque utilisateur pose environ 10 questions chaque jour, il y a environ 250 millions de consultations chaque jour. On peut alors conclure que rien que pour supporter le coût du chat, les dépenses quotidiennes peuvent atteindre 3 à 140 millions de dollars américains. (Bien sûr, le coût diminuera lentement.)

Des dizaines de millions de dollars ne sont que le prix d'entrée, et des opérations de dizaines de millions voire plus de 100 millions de dollars par jour sont insupportables !

Li Di, PDG de Xiaobing Company, a fait un calcul : « Si l'on considère le coût de ChatGPT, je brûlerai 300 millions de yuans chaque jour et plus de 100 milliards de yuans par an.

Récemment, Google parent John Hennessy, président de la société Alphabet, s'est également dit préoccupé par les coûts : le coût d'une recherche basée sur de grands modèles linguistiques pourrait être 10 fois supérieur à celui des recherches par mots clés standard. La technologie entraînera des milliards de dollars de coûts supplémentaires et devrait avoir un impact considérable. impact sur Alphabet Group. La rentabilité aura un impact.

Le seuil est donc trop élevé pour construire un véritable "ChatGPT" (le "fossé" des grandes entreprises sera très profond), même pour des géants internationaux comme Google. Réfléchissez bien.

Deuxièmement, combien OpenAI peut-il gagner ? Les énormes investissements et dépenses peuvent-ils générer les revenus attendus

La perte nette a évidemment atteint 545 millions. ChatGPT sur l'âme, les gens ne doutent pas de sa capacité de monétisation. Il n'y a pas si longtemps, OpenAI a annoncé qu'il prévoyait un chiffre d'affaires de 200 millions de dollars cette année et de 1 milliard de dollars l'année prochaine

Actuellement, le modèle de profit d'OpenAI autour de ChatGPT est grossièrement divisé. en deux types :

1) Fournir une interface de données API, effectuer des tâches de traitement du langage naturel et facturer en fonction du nombre de caractères

2) ChatGPTPlus offre la priorité pour les périodes d'occupation du serveur, les réponses et autres privilèges, et facture un abonnement ; frais de service de 20 $ US/mois

De plus, si nous intégrons le nouveau Bing avec ChatGPT, cette recherche intelligente basée sur la conversation générera également beaucoup de revenus publicitaires

.

Cela dit, Altman, le leader d'OpenAI, ne semble pas avoir beaucoup d'idées sur la commercialisation. Il a déjà déclaré à propos de cette question : « Mais avec l'intégration profonde des entreprises ultérieures, la capacité de le faire. attirer de l'argent dépasse de loin le nôtre.

De retour en Chine, les entreprises peuvent être plus préoccupées par les scénarios commerciaux, par le choix de faire d'abord la face B ou la face C.

3. Se battant pour être le premier à se déployer, l'éléphant danse

À une époque où le trafic Internet est à son apogée, les géants s'affairent à percer. Dans le domaine de l'AIGC, il semble que les grandes entreprises technologiques aient vu une lueur d'espoir et aient commencé à se déployer activement, dans l'espoir de convertir efficacement cette tendance technologique émergente en avantages concurrentiels sur le marché.

Les départements R&D en IA tels que Baidu Feipiao, Tencent Youtu, Alibaba Damo Academy, Byte et NetEase ont lancé une nouvelle série de concurrence pour les produits de type ChatGPT.

En fait, la piste des grands modèles n'est pas nouvelle. De nombreuses entreprises nationales ont leurs propres avantages en matière d'accumulation et de terrain.

Mais actuellement, Baidu est le plus important dans un avenir proche.

Jeudi, le fondateur de Baidu, Robin Li, a souligné son enthousiasme et ses attentes pour le prochain « Wen Xin Yi Yan » lors de la conférence téléphonique sur les rapports financiers du quatrième trimestre et de l'année complète, et a même déclaré : « Nous pensons que cela va changer le cloud. Les règles du jeu informatique. "

À en juger par les plans annoncés lors de la réunion, "Wen Xinyiyan" est devenu la "position C" pour le prochain développement commercial - plusieurs activités grand public, telles que la recherche, le cloud intelligent, Apollo. la conduite autonome, les appareils intelligents Xiaodu, etc. y seront intégrés, parmi eux, Wen Xinyiyan fournira des services externes via Baidu Smart Cloud. Mars approche, et "Wen Xin Yi Yan", qui est en "période de sprint", est sur le point de sortir de son cocon.

Plus de 10 ans d'investissements R&D élevés, en attente d'un point de rupture. La recherche est orientée vers l'extrémité C, et le cloud intelligent est orienté vers l'extrémité B. Baidu, un éléphant qui a autrefois raté l'ère de l'Internet mobile, inaugure une nouvelle opportunité de « danse » complète.

4. Pourquoi de nouveaux termes persistent ?

Des concepts techniques émergent sans cesse, et de plus en plus de « mots à la mode » ne peuvent résister.

La dernière fois que les gens ont mentionné le métavers, ils se sont limités à l'imagination de "qu'est-ce que le métavers". Puis, alors que les gens considéraient à plusieurs reprises "l'ère VUCA", les voix ont progressivement disparu.

Si une éventuelle tendance technologique veut prendre pied dans la société, en dernière analyse, elle doit apporter une réelle valeur. La technologie AIGC représentée par ChatGPT doit également surmonter les problèmes liés à la « difficulté de mise en œuvre de l'IA » dans le passé, permettant à l'IA de réfléchir attentivement et d'innover en améliorant l'expérience utilisateur, en créant de nouvelles expériences utilisateur et en créant de la valeur sociale. Et ce point est aussi le plus essentiel.

La bonne nouvelle est que nous voyons sa valeur. Les tâches basées sur du texte telles que la rédaction d'e-mails, le brainstorming, la réécriture de code et la rédaction de résumés peuvent en effet faire gagner beaucoup de temps et d'argent aux praticiens. Je pense qu'à l'avenir, l'AIGC sera vu dans divers scénarios de contenu tels que la voix, les images et. vidéos. Pas une mauvaise performance.

Bien sûr, en plus des valeurs fondamentales, elle est aussi indissociable du terroir qui encourage l'innovation. Le ministère de la Science et de la Technologie a également répondu hier aux questions sur ChatGPT : « Notre pays a pris des mesures correspondantes en termes d'éthique pour toute nouvelle technologie, y compris la technologie de l'IA, afin de rechercher des avantages et d'éviter les inconvénients dans le développement de la science et de la technologie, afin que pour améliorer les « avantages ». Montrez-le."

Ensuite, la perspective revient aux développeurs, que devons-nous faire, nous, les techniciens ? Abandonner la mentalité impétueuse de suivre la tendance et avoir une solide compréhension des problèmes à résoudre est plus pragmatique que de simplement regarder l'excitation des « hausses et baisses des actions ». Par exemple, les développeurs OpenAI travaillent sur des moyens pratiques de réduire les coûts de formation des modèles.

Le 25, Wang Jian, académicien de l'Académie chinoise d'ingénierie et fondateur d'Alibaba Cloud, a déclaré lors de la Conférence mondiale des pionniers de l'intelligence artificielle 2023 : La puissance de calcul n'est plus un goulot d'étranglement ou une excuse pour les développeurs. Les développeurs doivent avoir une compréhension globale de l’ensemble du secteur et comprendre les capacités et les limites de l’algorithme.

Wang Jian a déclaré que les développeurs qui développent véritablement une intelligence artificielle de haut niveau suivent l'idée detrouver des problèmes et utiliser les technologies existantes pour les résoudre. La résolution des problèmes elle-même est en fait une percée.

« Il est important que vous fassiez la bonne chose au bon moment. »

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI