Maison >Périphériques technologiques >IA >90 % du cerveau humain est un apprentissage auto-supervisé. Jusqu'où un grand modèle d'IA peut-il simuler le cerveau ?

90 % du cerveau humain est un apprentissage auto-supervisé. Jusqu'où un grand modèle d'IA peut-il simuler le cerveau ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-11 20:29:131203parcourir

Nous savons tous que 90 % du cerveau humain est un apprentissage auto-supervisé et que les organismes font constamment des prédictions sur ce qui va se passer ensuite. L'apprentissage auto-supervisé signifie que les décisions peuvent être prises sans intervention extérieure. Il n'y a que quelques cas où nous acceptons des commentaires externes, comme par exemple le professeur disant : « Vous avez fait une erreur ». Certains chercheurs ont découvert que le mécanisme d’apprentissage auto-supervisé des grands modèles de langage ressemble beaucoup à notre cerveau. Quanta Magazine, un média scientifique populaire bien connu, a récemment rapporté que de plus en plus d'études ont révélé que les modèles d'apprentissage auto-supervisés, en particulier les méthodes d'auto-apprentissage des modèles de langage à grande échelle, sont très similaires au modèle d'apprentissage de notre cerveau. .

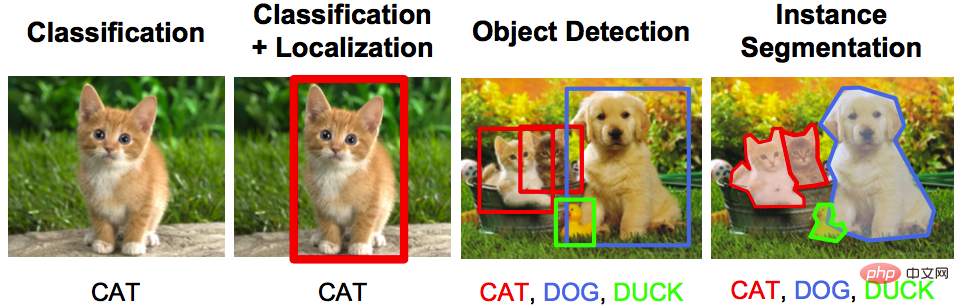

Dans le passé, les systèmes d'IA courants étaient entraînés à l'aide de grandes quantités de données étiquetées. Par exemple, les images peuvent être étiquetées « chat tigré » ou « chat tigre » pour entraîner un réseau neuronal artificiel à distinguer correctement le chat tigré du tigre.

Ce type de formation « auto-supervisée » nécessite un étiquetage manuel laborieux des données, et les réseaux de neurones prennent souvent des raccourcis et apprennent à associer des étiquettes à des informations minimales, et parfois superficielles. Par exemple, un réseau neuronal pourrait utiliser la présence d’herbe pour identifier des photos de vaches, puisque celles-ci sont souvent photographiées dans les champs. Alexei Efros, informaticien à l'Université de Californie à Berkeley, a déclaré :

Les algorithmes que nous formons sont comme des étudiants de premier cycle qui ne sont pas venus en classe depuis un semestre entier, même s'ils n'ont pas étudié la matière. systématiquement, mais ils ont obtenu de bons résultats à l'examen.

De plus, pour les chercheurs intéressés par l’intersection de l’intelligence animale et de l’intelligence machine, cet « apprentissage supervisé » peut se limiter à ce qu’il révèle sur les cerveaux biologiques. De nombreux animaux, y compris les humains, n’utilisent pas d’ensembles de données étiquetés pour apprendre. Pour la plupart, ils explorent leur environnement par eux-mêmes et acquièrent ainsi une compréhension riche et profonde du monde.

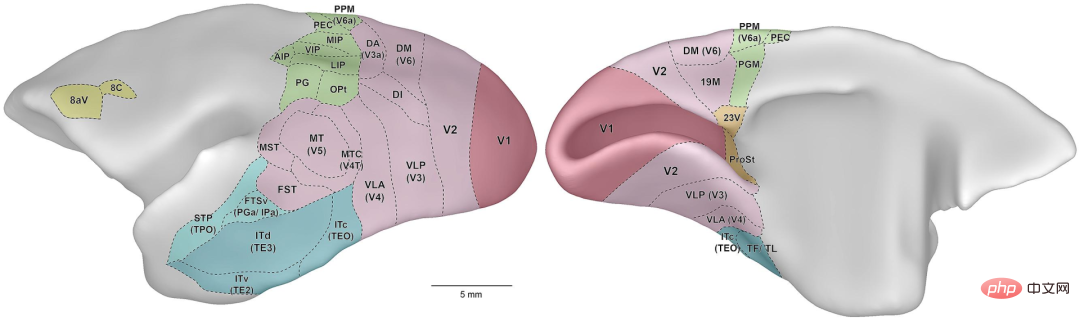

Maintenant, certains neuroscientifiques computationnels ont commencé à explorer des réseaux de neurones entraînés avec peu ou pas de données étiquetées par l'homme. Des découvertes récentes suggèrent que les modèles informatiques des systèmes visuels et auditifs animaux construits à l’aide de modèles d’apprentissage auto-supervisés se rapprochent davantage de la fonction cérébrale que les modèles d’apprentissage supervisé.

Pour certains neuroscientifiques, les réseaux de neurones artificiels semblent commencer à révéler des moyens d'utiliser le cerveau comme analogie pour l'apprentissage automatique.

Supervision défectueuse

Il y a environ 10 ans, des modèles cérébraux inspirés des réseaux de neurones artificiels ont commencé à émerger, tandis qu'un réseau de neurones appelé AlexNet a révolutionné la tâche de classification des images inconnues. Ce résultat a été publié dans l'article « ImageNet Classification with Deep Convolutional Neural Networks » par Alex Krizhevsky, Ilya Sutskever et Geoffrey E. Hinton.

Adresse papier : https://dl.acm.org/doi/10.1145/3065386 Comme tous les réseaux de neurones, ce réseau est constitué de plusieurs couches de neurones artificiels, dans lesquelles le poids des connexions entre différents neurones différent. Si le réseau neuronal ne parvient pas à classer correctement une image, l'algorithme d'apprentissage met à jour les poids des connexions entre les neurones pour réduire le risque d'erreur de classification lors du prochain cycle d'entraînement. L'algorithme répète ce processus plusieurs fois, en ajustant les pondérations, jusqu'à ce que le taux d'erreur du réseau soit suffisamment faible. Plus tard, les neuroscientifiques ont utilisé AlexNet pour développer le premier modèle informatique du système visuel des primates. Lorsque les mêmes images ont été montrées aux singes et aux réseaux de neurones artificiels, l’activité des neurones réels et artificiels a montré des réponses similaires. Des résultats similaires ont été obtenus sur des modèles artificiels de détection d’audition et d’odeurs. Mais à mesure que le domaine se développait, les chercheurs ont pris conscience des limites de la formation auto-supervisée. En 2017, l'informaticien Leon Gatys de l'Université de Tübingen en Allemagne et ses collègues ont pris une photo d'une Ford Model T et ont ensuite recouvert la photo d'un motif en peau de léopard. Alors que le réseau neuronal d'intelligence artificielle a correctement classé l'image originale comme modèle T, mais a considéré l'image modifiée comme un léopard. La raison en est qu'il se concentre uniquement sur la texture de l'image et ne comprend pas la forme de la voiture (ou du léopard). Les modèles d'apprentissage auto-supervisés sont conçus pour éviter de tels problèmes. Par exemple, dans un modèle de langage dit à grande échelle, un algorithme d'entraînement montrera à un réseau neuronal les premiers mots d'une phrase et lui demandera de prédire le mot suivant. Lorsqu'il était formé à l'aide de grandes quantités de textes collectés sur Internet, le modèle semblait apprendre la structure syntaxique de la langue, démontrant des prouesses linguistiques impressionnantes, le tout sans étiquettes ni supervision externes. Des efforts similaires sont en cours dans le domaine de la vision par ordinateur. Fin 2021, He Kaiming et ses collègues ont présenté la célèbre recherche sur les auto-encodeurs masqués « Masked Auto-Encoder » (MAE). MAE convertit la partie non masquée en une représentation latente - une description mathématique de la compression, qui contient Informations importantes sur l'objet. Dans le cas d'images, la représentation sous-jacente peut être une description mathématique incluant la forme des objets dans l'image. Le décodeur reconvertit ensuite ces représentations en images complètes. Le cerveau est également "auto-supervisé" Dans un tel système, certains neuroscientifiques pensent que notre cerveau est en fait un apprentissage auto-supervisé. "Je pense qu'il ne fait aucun doute que 90 pour cent de ce que fait le cerveau est un apprentissage auto-supervisé", déclare Blake Richards, neuroscientifique informatique à l'Université McGill et à l'Institut d'intelligence artificielle du Québec (Mila). prédire, par exemple, la position future d'un objet lorsqu'il se déplace, ou le mot suivant dans une phrase, un peu comme un algorithme d'apprentissage auto-supervisé essayant de prédire les lacunes dans une image ou un morceau de texte. Le neuroscientifique informatique Blake Richards a créé un système d'IA qui imite le réseau visuel dans le cerveau vivant Richards et son équipe ont créé un système autonome Les modèles supervisés suggèrent une réponse. Ils ont formé une intelligence artificielle combinant deux réseaux de neurones différents. La première, appelée architecture ResNet, est conçue pour traiter les images ; la seconde, appelée réseau récurrent, peut suivre la séquence d'entrée précédente et faire des prédictions sur la prochaine entrée attendue. Pour entraîner l’IA commune, l’équipe commence par une séquence de vidéos, disons 10 images, et laisse ResNet les traiter une par une. Ensuite, le réseau récurrent prédit la représentation latente de l'image 11 au lieu de simplement faire correspondre les 10 images précédentes. Les algorithmes d'apprentissage auto-supervisés comparent les valeurs prédites aux valeurs réelles et demandent au réseau neuronal de mettre à jour ses pondérations pour faire de meilleures prédictions. Pour le tester davantage, les chercheurs ont montré à l'IA une série de vidéos que des chercheurs de l'Allen Institute for Brain Science à Seattle avaient déjà montrées à des souris. Comme les primates, les souris possèdent des régions cérébrales dédiées aux images statiques et au mouvement. Les chercheurs d'Allen ont enregistré l'activité neuronale dans le cortex visuel de souris pendant qu'elles regardaient des vidéos. L’équipe de Richards a découvert des similitudes dans la manière dont l’IA et les cerveaux vivants réagissent aux vidéos. Au cours de l'entraînement, une voie du réseau neuronal artificiel est devenue plus similaire à la zone ventrale de détection d'objets du cerveau de la souris, tandis que l'autre voie est devenue plus similaire à la zone dorsale qui se concentre sur le mouvement. Ces résultats suggèrent que notre système visuel possède deux voies spécialisées, car elles aident à prédire l'avenir de la vision ; une seule voie n'est pas suffisante. Les modèles du système auditif humain racontent une histoire similaire. En juin, une équipe dirigée par Jean-Rémi King, chercheur chez Meta AI, a formé une intelligence artificielle appelée Wav2Vec 2.0, qui utilise un réseau neuronal pour convertir l'audio en représentations latentes. Les chercheurs ont masqué certaines de ces représentations et les ont ensuite introduites dans un autre composant du réseau neuronal appelé convertisseur. Pendant le processus de formation, le convertisseur prédit les informations bloquées. Ce faisant, l’IA dans son ensemble apprend à convertir les sons en représentations sous-jacentes, encore une fois, sans avoir besoin d’étiquettes. L'équipe a utilisé environ 600 heures de données vocales pour entraîner le réseau. "C'est à peu près ce qu'un enfant obtient au cours de ses deux premières années d'expérience", a déclaré King. Jean-Rémy King de Meta AI a aidé à former une intelligence artificielle qui traite l'audio d'une manière qui imite le cerveau, en partie en prédisant ce qui devrait se passer ensuite une fois que le système a été entraîné en jouant des portions de livres audio en anglais, français et mandarin, puis ont comparé les performances de l'IA avec les données de 412 personnes, toutes de langue maternelle de ces trois langues. Elles ont écouté le même long clip audio pendant que les examens IRM captaient leur cerveau. Les résultats montrent que bien que les images IRMf soient bruyantes et aient une faible résolution, le réseau neuronal de l'IA et le cerveau humain sont "non seulement liés l'un à l'autre, mais également liés de manière systématique". L’activité dans les premières couches de l’IA est cohérente avec l’activité du cortex auditif primaire, tandis que l’activité dans les couches les plus profondes de l’IA est cohérente avec l’activité dans les niveaux supérieurs du cerveau, comme le cortex préfrontal. " Ce sont de belles données, et même si elles ne sont pas concluantes, elles constituent une preuve irréfutable que la façon dont nous apprenons une langue consiste en grande partie à prédire ce que nous allons dire ensuite. " Bien sûr, tout le monde n'est pas d'accord avec cette affirmation. Josh McDermott, neuroscientifique computationnel au MIT, a utilisé l'apprentissage supervisé et auto-supervisé pour étudier des modèles de vision et d'audition. Son laboratoire a conçu des signaux audio et visuels synthétiques qui, pour les humains, ne seraient qu'un bruit insaisissable. Cependant, pour les réseaux de neurones artificiels, ces signaux semblent impossibles à distinguer du langage et des images réels. Cela montre que les représentations formées au plus profond des réseaux de neurones, même avec un apprentissage auto-supervisé, ne sont pas les mêmes dans notre cerveau. McDermott a déclaré : "Ces méthodes d'apprentissage auto-supervisées constituent une amélioration car vous êtes capable d'apprendre des représentations qui peuvent prendre en charge de nombreux comportements de reconnaissance sans avoir besoin de toutes les étiquettes. Mais il existe encore de nombreuses caractéristiques des modèles supervisés ." L'algorithme lui-même a également besoin de plus d'améliorations. Par exemple, dans le modèle Wav2Vec 2.0 de Meta AI, l'IA ne prédit la représentation potentielle des sons que pendant des dizaines de millisecondes, ce qui est plus court que le temps qu'il faut à une personne pour prononcer une syllabe bruyante, et encore moins prédire un mot. Pour créer véritablement des modèles d'IA similaires au cerveau humain, nous avons encore beaucoup à faire, a déclaré Jin. Si les similitudes entre le cerveau et les modèles d’apprentissage auto-supervisés découvertes jusqu’à présent s’avèrent vraies dans d’autres tâches sensorielles, cela serait une indication encore plus forte que, quelles que soient les capacités miraculeuses de notre cerveau, une certaine forme d’apprentissage auto-supervisé est nécessaire.

Dans cette approche, les humains n'étiquetent pas les données, a déclaré Friedemann Zenke, neuroscientifique informatique à l'Institut Friedrich Michel de recherche biomédicale à Bâle, en Suisse. Les étiquettes proviennent plutôt des données elles-mêmes. Les algorithmes auto-supervisés créent essentiellement des lacunes dans les données et demandent au réseau neuronal de les combler.

Dans cette approche, les humains n'étiquetent pas les données, a déclaré Friedemann Zenke, neuroscientifique informatique à l'Institut Friedrich Michel de recherche biomédicale à Bâle, en Suisse. Les étiquettes proviennent plutôt des données elles-mêmes. Les algorithmes auto-supervisés créent essentiellement des lacunes dans les données et demandent au réseau neuronal de les combler.

Certaines personnes ne sont pas d'accord : simuler le cerveau ? Les modèles et les algorithmes sont bien pires

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI