Maison >Périphériques technologiques >IA >Je ne peux pas l'arrêter ! Le modèle de diffusion peut être utilisé pour photoshoper des photos en utilisant uniquement du texte

Je ne peux pas l'arrêter ! Le modèle de diffusion peut être utilisé pour photoshoper des photos en utilisant uniquement du texte

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-11 20:01:281172parcourir

C'est le souhait commun de la partie A et de la partie B de pouvoir améliorer la situation en quelques mots, mais généralement seule la partie B connaît la douleur et le chagrin que cela implique. Aujourd’hui, l’IA s’attaque à ce problème difficile.

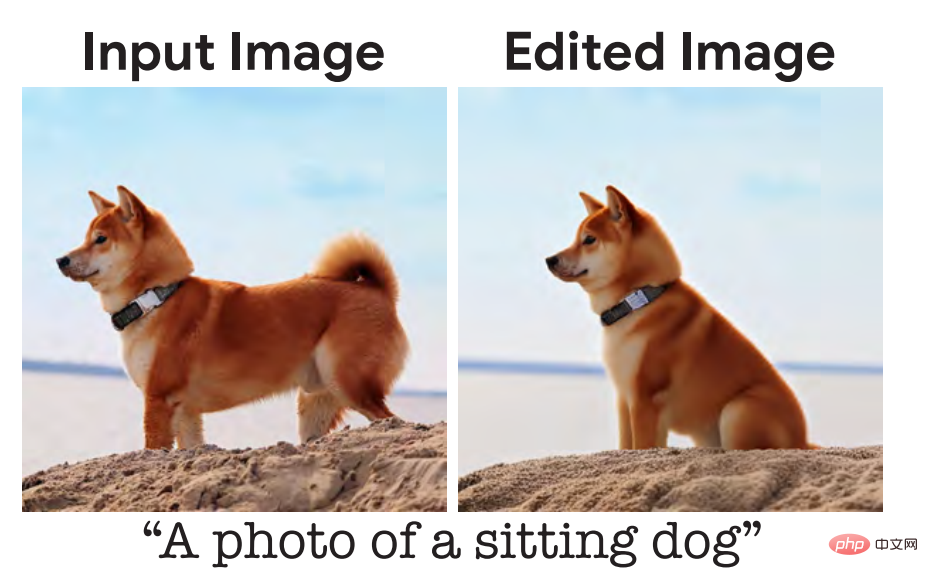

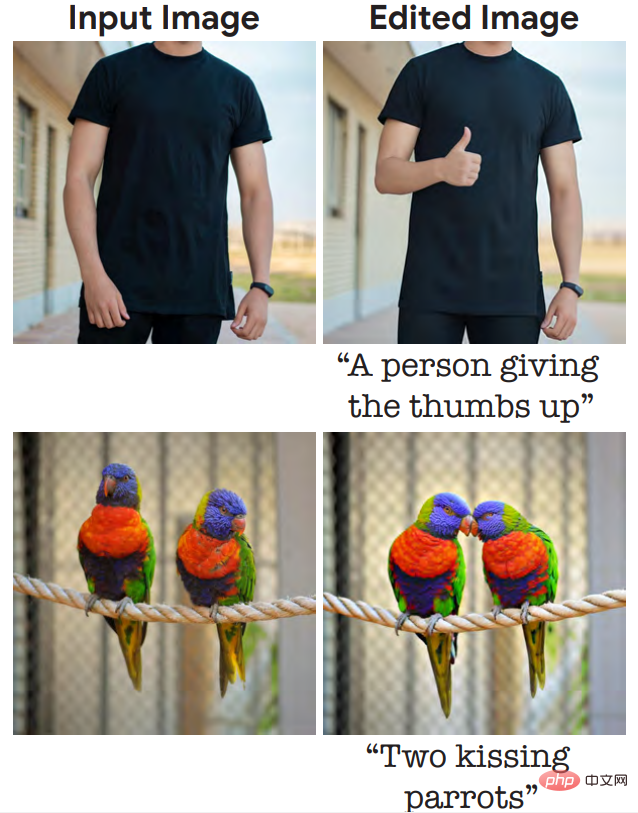

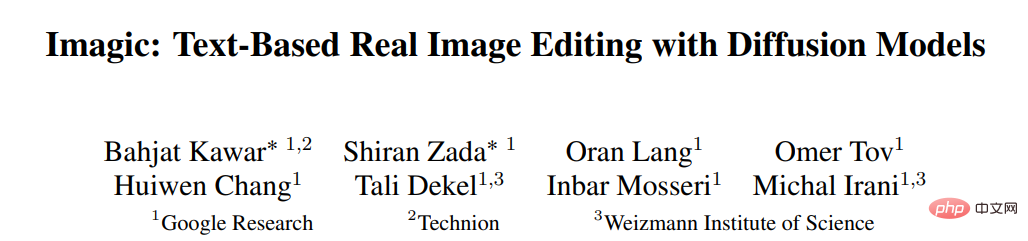

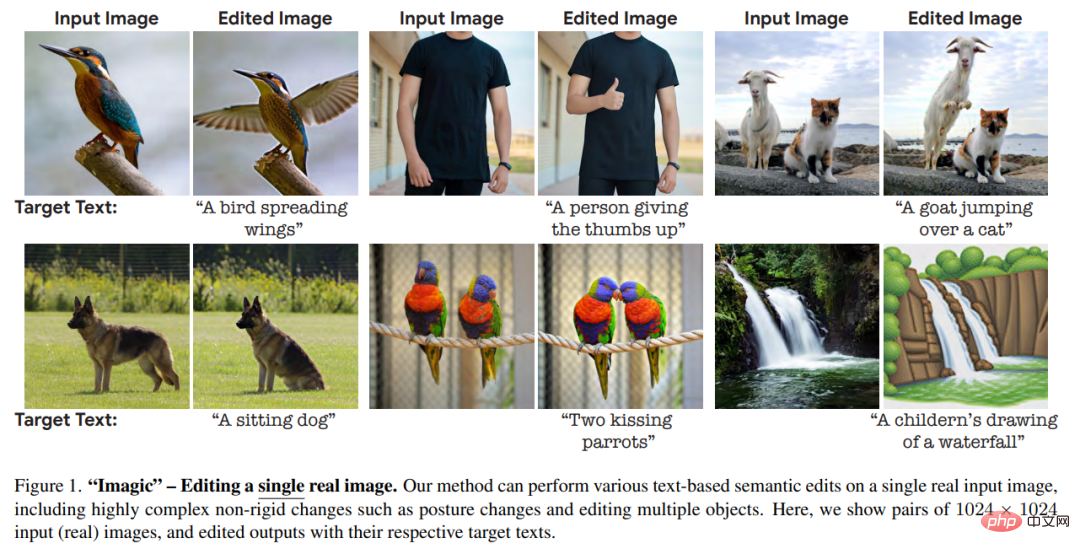

Dans un article mis en ligne sur arXiv le 17 octobre, des chercheurs de Google Research, de l'Institut israélien de technologie et de l'Institut Weizmann des sciences en Israël ont présenté une véritable méthode d'édition d'images basée sur le modèle de diffusion— —Imagic, vous pouvez utilisez uniquement du texte pour réaliser le PS de vraies photos, comme demander à une personne de lever le pouce ou à deux perroquets d'embrasser :

"S'il vous plaît, aidez-moi avec un geste similaire. "Modèle de diffusion : Pas de problème, je vais le couvrir."

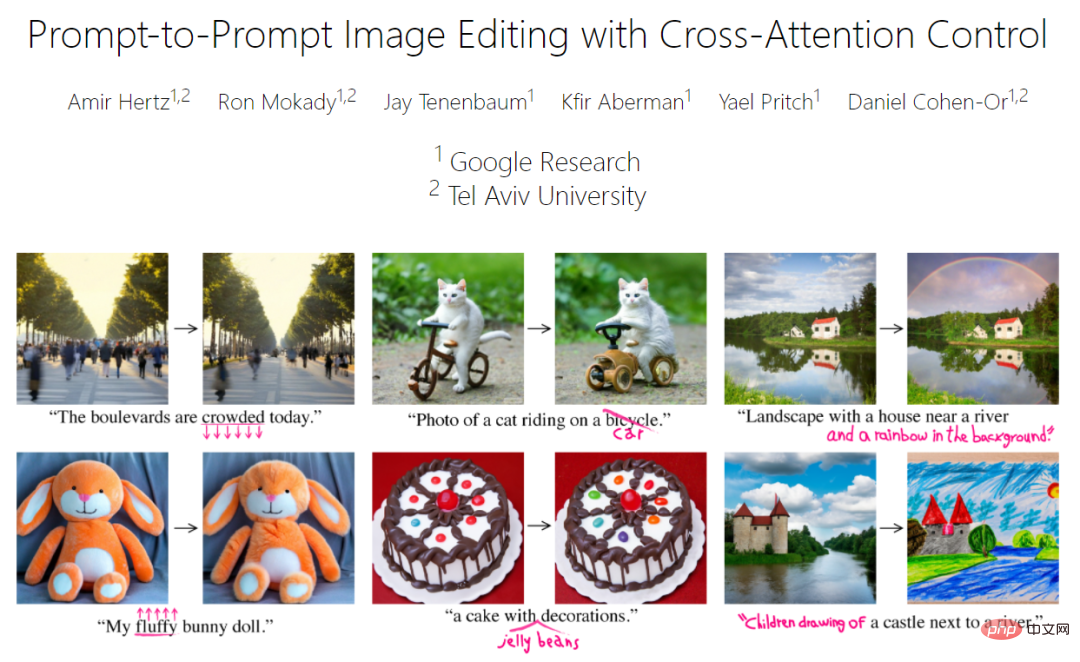

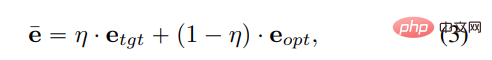

Comme le montrent les images du journal, les images modifiées sont toujours très naturelles et il n'y a aucun dommage évident aux informations autres que le contenu qui doit être modifié. Des recherches similaires incluent le Prompt-to-Prompt précédemment réalisé par Google Research et l'Université de Tel Aviv en Israël (référence [16] dans l'article Imagic) :

Lien du projet (y compris l'article, le code) :https ://prompt-to-prompt.github.io/

Par conséquent, certaines personnes ont déploré que "les changements dans ce domaine soient si rapides que c'est un peu exagéré. Désormais, le Parti A peut vraiment changer quoi que ce soit". il veut avec juste un mot Changé.

Aperçu du papier Imagic

Lien du papier : https://arxiv.org/pdf/2210.09276.pdf

Appliquer une édition sémantique drastique à de vraies photos a toujours été un défi Une tâche intéressante en traitement d'image. Cette tâche a suscité un intérêt considérable de la part de la communauté des chercheurs, car les systèmes basés sur l'apprentissage profond ont fait des progrès considérables ces dernières années.

L'utilisation de simples invites textuelles en langage naturel pour décrire ce que nous voulons modifier (comme demander à un chien de s'asseoir) est tout à fait cohérente avec la façon dont les humains communiquent. Par conséquent, les chercheurs ont développé de nombreuses méthodes d’édition d’images basées sur du texte, et ces méthodes sont également efficaces.

Cependant, les méthodes traditionnelles actuelles posent plus ou moins de problèmes, tels que :

1 Limitées à un ensemble spécifique d'éditions, comme peindre sur l'image, ajouter des objets ou migrer des styles [6, 28]. ;

2. Ne peuvent fonctionner que sur des images dans des champs spécifiques ou des images synthétisées [16, 36]

3. En plus des images d'entrée, elles nécessitent également une saisie auxiliaire, telle que l'indication des modifications requises. d'un lieu, de plusieurs images du même sujet ou d'un texte décrivant l'image originale [6, 13, 40, 44].

Cet article propose une méthode d'édition d'images sémantiques "Imagic" pour pallier aux problèmes ci-dessus. Étant donné une image d'entrée à modifier et une seule invite de texte décrivant la modification cible, cette méthode permet une édition complexe et non rigide d'images réelles haute résolution. L'image résultante s'aligne bien avec le texte cible, tout en préservant le contexte global, la structure et la composition de l'image d'origine.

Comme le montre la figure 1, Imagic peut faire s'embrasser deux perroquets ou faire lever le pouce à une personne. L'édition sémantique basée sur le texte qu'elle propose est la première fois que des opérations aussi complexes, y compris l'édition de plusieurs objets, peuvent être appliquées à une seule image réelle haute résolution. En plus de ces modifications complexes, Imagic permet une grande variété de modifications, notamment des changements de style, des changements de couleur et des ajouts d'objets.

Pour réaliser cet exploit, les chercheurs ont exploité le modèle de diffusion texte-image récemment couronné de succès. Les modèles de diffusion sont de puissants modèles génératifs capables de synthétiser des images de haute qualité. Lorsqu'il est conditionné par une invite de texte en langage naturel, il est capable de générer des images cohérentes avec le texte demandé. Dans ce travail, les chercheurs les ont utilisés pour éditer des images réelles plutôt que pour en synthétiser de nouvelles.

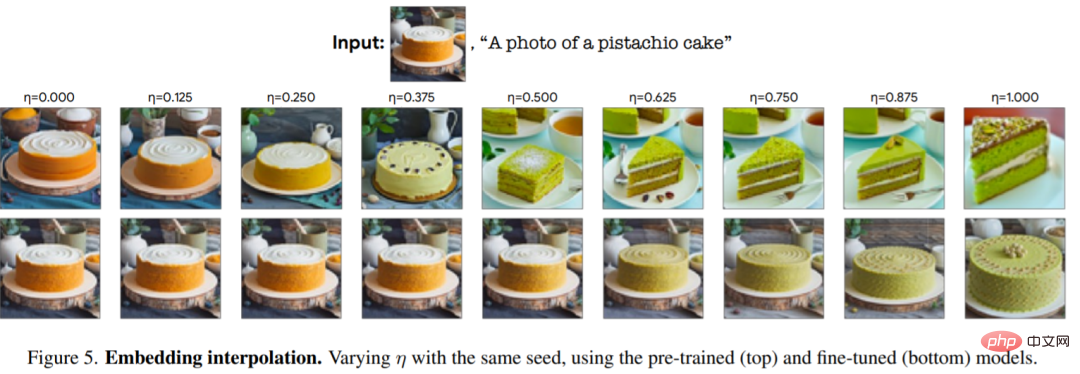

Comme le montre la figure 3, Imagic n'a besoin que de trois étapes pour accomplir la tâche ci-dessus : d'abord optimiser une intégration de texte pour produire une image similaire à l'image d'entrée. Le modèle de diffusion générative pré-entraîné est ensuite affiné pour mieux reconstruire l'image d'entrée, conditionnée par des intégrations optimisées. Enfin, une interpolation linéaire est effectuée entre l'intégration du texte cible et l'intégration optimisée, ce qui donne une représentation qui combine l'image d'entrée et le texte cible. Cette représentation est ensuite transmise à un processus de diffusion générative avec un modèle affiné, produisant l'image finale éditée.

Pour prouver la puissance d'Imagic, les chercheurs ont mené plusieurs expériences, appliquant la méthode à de nombreuses images dans différents domaines, et ont produit des résultats impressionnants dans toutes les expériences. Les images de haute qualité produites par Imagic sont très similaires aux images d'entrée et cohérentes avec le texte cible requis. Ces résultats démontrent la polyvalence, la polyvalence et la qualité d’Imagic. Les chercheurs ont également mené une étude sur l'ablation qui a mis en évidence l'efficacité de chaque composant de la méthode proposée. Par rapport à une gamme de méthodes récentes, Imagic présente une qualité d'édition et une fidélité à l'image originale nettement meilleures, en particulier lors de tâches d'édition non rigides très complexes.

Détails de la méthode

Étant donné une image d'entrée x et un texte cible, cet article vise à éditer l'image d'une manière qui satisfait le texte donné tout en conservant une grande quantité de détails dans l'image x. Pour atteindre cet objectif, cet article utilise la couche d'incorporation de texte du modèle de diffusion pour effectuer des opérations sémantiques d'une manière quelque peu similaire aux méthodes basées sur le GAN. Les chercheurs commencent par rechercher des représentations significatives, puis passent par un processus génératif qui produit des images similaires à l’image d’entrée. Le modèle génératif est ensuite optimisé pour mieux reconstruire l'image d'entrée, et l'étape finale consiste à traiter la représentation latente pour obtenir le résultat de l'édition.

Comme le montre la figure 3 ci-dessus, notre méthode se compose de trois étapes : (1) Optimiser l'intégration de texte pour trouver l'intégration de texte qui correspond le mieux à l'image donnée à proximité de l'intégration de texte cible ; (2) Affiner la diffusion ; modèle pour mieux correspondre à l'image donnée ; (3) interpoler linéairement entre l'intégration optimisée et l'intégration du texte cible pour trouver un point qui atteint à la fois la fidélité de l'image et l'alignement du texte cible.

Des détails plus spécifiques sont les suivants :

Optimisation de l'intégration de texte

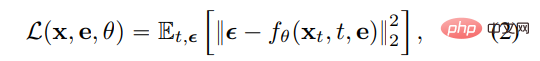

Tout d'abord, le texte cible est saisi dans l'encodeur de texte, qui génère l'intégration de texte correspondante , où T est la cible donnée. Le nombre de jetons dans le texte, d est la dimension d'intégration du jeton. Ensuite, les chercheurs gèlent les paramètres du modèle de diffusion f_θ généré et utilisent l'objectif de diffusion de débruitage pour optimiser le texte cible intégrant e_tgt

, où T est la cible donnée. Le nombre de jetons dans le texte, d est la dimension d'intégration du jeton. Ensuite, les chercheurs gèlent les paramètres du modèle de diffusion f_θ généré et utilisent l'objectif de diffusion de débruitage pour optimiser le texte cible intégrant e_tgt

Où x est l'image d'entrée,  est une version de bruit de x et θ est le poids du modèle de diffusion pré-entraîné. Cela permet au texte intégré de correspondre le plus fidèlement possible à l'image d'entrée. Ce processus s'exécute en relativement peu d'étapes, en restant proche de l'intégration du texte cible d'origine, ce qui donne lieu à une intégration optimisée d'e_opt.

est une version de bruit de x et θ est le poids du modèle de diffusion pré-entraîné. Cela permet au texte intégré de correspondre le plus fidèlement possible à l'image d'entrée. Ce processus s'exécute en relativement peu d'étapes, en restant proche de l'intégration du texte cible d'origine, ce qui donne lieu à une intégration optimisée d'e_opt.

Réglage fin du modèle

Il convient de noter ici que l'e_opt d'intégration optimisé obtenu ici ne sera pas nécessairement complètement similaire à l'image d'entrée x lors du passage par le processus de diffusion de génération, car ils ne s'exécutent que un petit nombre d'étapes d'optimisation (voir le panneau supérieur gauche de la figure 5). Par conséquent, dans la deuxième étape, les auteurs comblent cet écart en optimisant les paramètres du modèle θ en utilisant la même fonction de perte fournie dans l'équation (2) tout en gelant l'intégration d'optimisation.

Interpolation d'incorporation de texte

La troisième étape d'Imagic est une simple interpolation linéaire entre e_tgt et e_opt. Pour un hyperparamètre  donné, nous obtenons

donné, nous obtenons  . Ensuite, les auteurs utilisent un modèle affiné pour appliquer le processus de diffusion générative sous-jacent, conditionnel à

. Ensuite, les auteurs utilisent un modèle affiné pour appliquer le processus de diffusion générative sous-jacent, conditionnel à  . Cela produit une image éditée en basse résolution, qui est ensuite super-résolue à l'aide d'un modèle auxiliaire affiné pour super-réoudre le texte cible. Ce processus de génération produit l'image finale éditée en haute résolution

. Cela produit une image éditée en basse résolution, qui est ensuite super-résolue à l'aide d'un modèle auxiliaire affiné pour super-réoudre le texte cible. Ce processus de génération produit l'image finale éditée en haute résolution  .

.

Résultats expérimentaux

Pour tester l'effet, les chercheurs ont appliqué cette méthode à un grand nombre d'images réelles provenant de différents domaines, en utilisant de simples invites textuelles pour décrire différentes catégories d'édition, telles que : le style, l'apparence, la couleur, la pose et composition . Ils ont collecté des images haute résolution et gratuites d'Unsplash et Pixabay, les ont optimisées pour générer chaque modification avec 5 graines aléatoires et ont sélectionné les meilleurs résultats. Imagic démontre des résultats impressionnants avec sa capacité à appliquer une variété de catégories d'édition sur n'importe quelle image et texte d'entrée généraux, comme le montrent les figures 1 et 7.

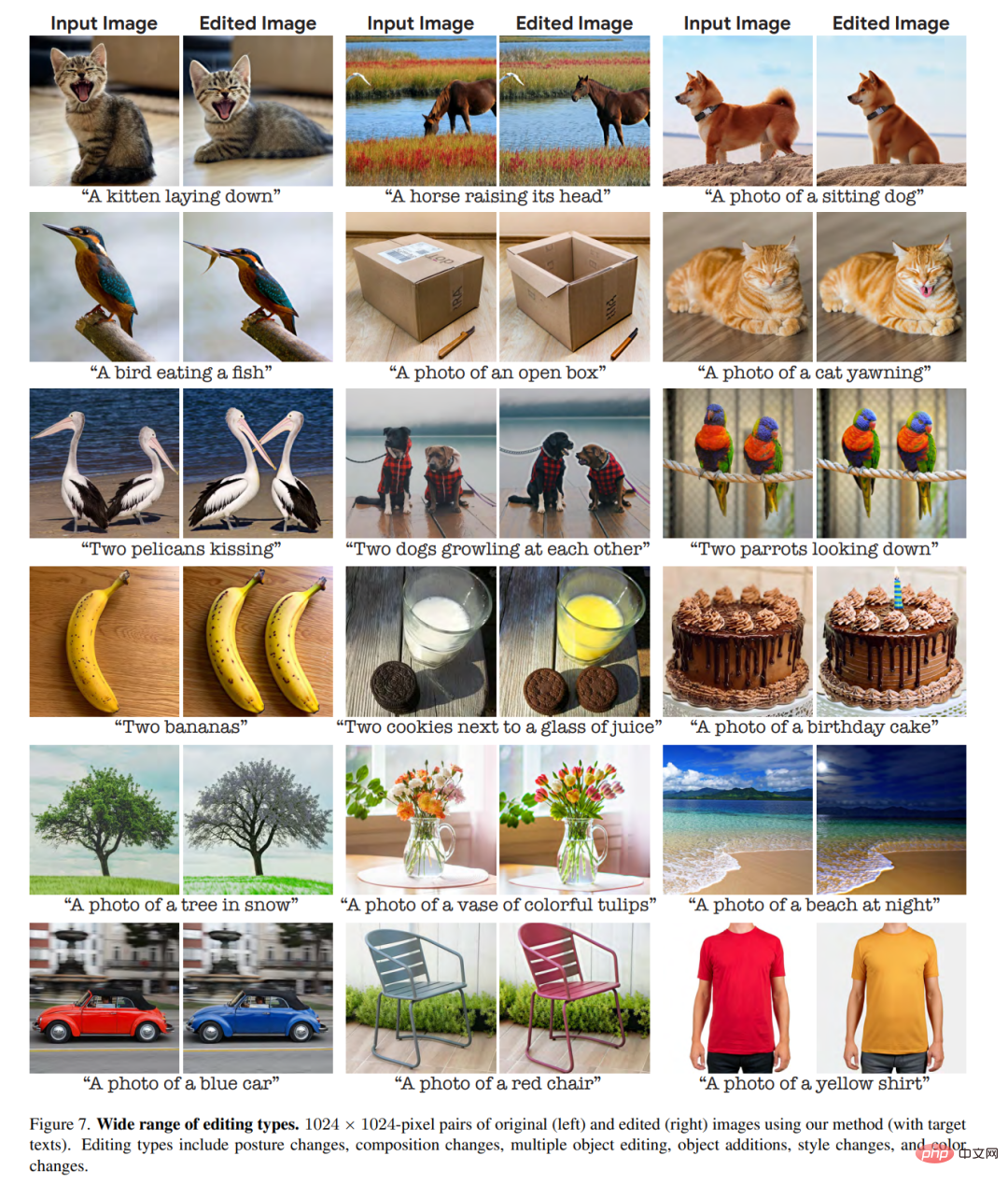

La figure 2 est une expérience avec différentes invites de texte sur la même image, montrant la polyvalence d'Imagic.

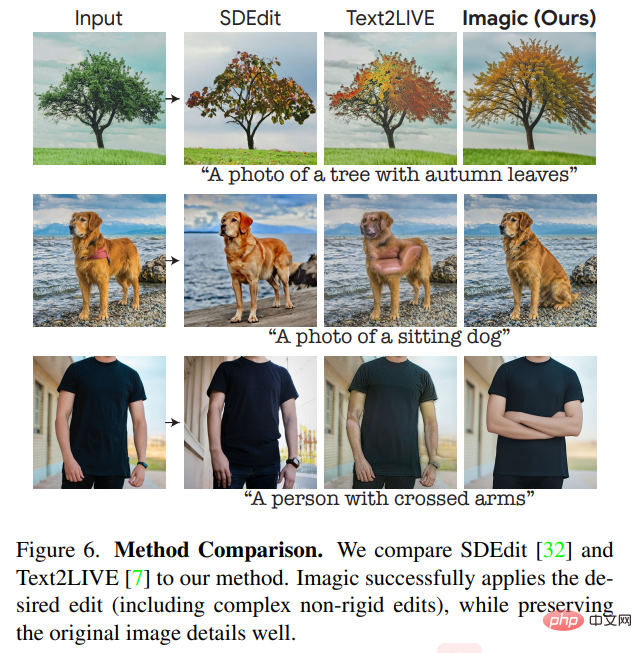

Étant donné que le modèle de diffusion générative sous-jacent exploité par les chercheurs est basé sur la probabilité, cette méthode peut générer des résultats différents pour une seule paire image-texte. La figure 4 montre plusieurs options d'édition utilisant différentes graines aléatoires (avec de légers ajustements de l'êta pour chaque graine). Ce caractère aléatoire permet aux utilisateurs de choisir entre ces différentes options, car les invites textuelles en langage naturel sont généralement ambiguës et imprécises. L'étude a comparé Imagic aux principales méthodes à usage général qui fonctionnent sur une seule entrée d'images du monde réel et les modifient en fonction d'une invite de texte. La figure 6 montre les résultats d'édition de différentes méthodes telles que Text2LIVE[7] et SDEdit[32].

On peut voir que notre méthode maintient une haute fidélité à l'image d'entrée tout en effectuant de manière appropriée les modifications requises. Lorsqu'on nous confie des tâches d'édition complexes et non rigides, telles que "faire asseoir le chien", notre méthode surpasse considérablement les techniques précédentes. Imagic est la première démo à appliquer cette édition sophistiquée basée sur du texte sur une seule image du monde réel.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI