Maison >Périphériques technologiques >IA >Les mathématiques derrière le modèle de diffusion sont-elles trop difficiles à digérer ? Google le dit clairement avec une perspective unifiée

Les mathématiques derrière le modèle de diffusion sont-elles trop difficiles à digérer ? Google le dit clairement avec une perspective unifiée

- 王林avant

- 2023-04-11 19:46:081328parcourir

Ces derniers temps, la peinture IA est devenue très populaire.

Bien que vous soyez émerveillé par les capacités de peinture de l’IA, ce que vous ne savez peut-être pas, c’est que le modèle de diffusion y joue un rôle important. Prenons l'exemple du modèle populaire DALL·E 2 d'OpenAI. Entrez simplement un simple texte (invite) et il peut générer plusieurs images haute définition 1024*1024.

Peu de temps après l'annonce de DALL·E 2, Google a ensuite publié Imagen, un modèle d'IA texte-image qui peut générer des images réalistes de la scène à partir d'une description textuelle donnée.

Il y a quelques jours à peine, Stability.Ai a rendu public la dernière version du modèle d'image de génération de texte Stable Diffusion, et les images qu'il a générées ont atteint la qualité commerciale.

Depuis que Google a lancé DDPM en 2020, le modèle de diffusion est progressivement devenu un nouveau point chaud dans le domaine de la génération. Plus tard, OpenAI a lancé les modèles GLIDE, ADM-G, etc., ce qui a rendu le modèle de diffusion populaire.

De nombreux chercheurs pensent que le modèle de génération d'images texte basé sur le modèle de diffusion possède non seulement un petit nombre de paramètres, mais génère également des images de meilleure qualité et a le potentiel de remplacer le GAN.

Cependant, la formule mathématique derrière le modèle de diffusion a intimidé de nombreux chercheurs, et de nombreux chercheurs pensent qu'elle est beaucoup plus difficile à comprendre que la VAE et le GAN.

Récemment, un chercheur de Google Research a écrit un article "Comprendre les modèles de diffusion : une perspective unifiée". Cet article montre les principes mathématiques derrière le modèle de diffusion de manière extrêmement détaillée, dans le but de permettre à d'autres chercheurs de suivre et de comprendre. le modèle de diffusion. Ce qu’ils sont et comment ils fonctionnent.

Adresse de l'article : https://arxiv.org/pdf/2208.11970.pdf Quant à savoir à quel point cet article est « mathématique », l'auteur le décrit ainsi : Nous et ses détails atroces) montre les mathématiques derrière ces modèles.

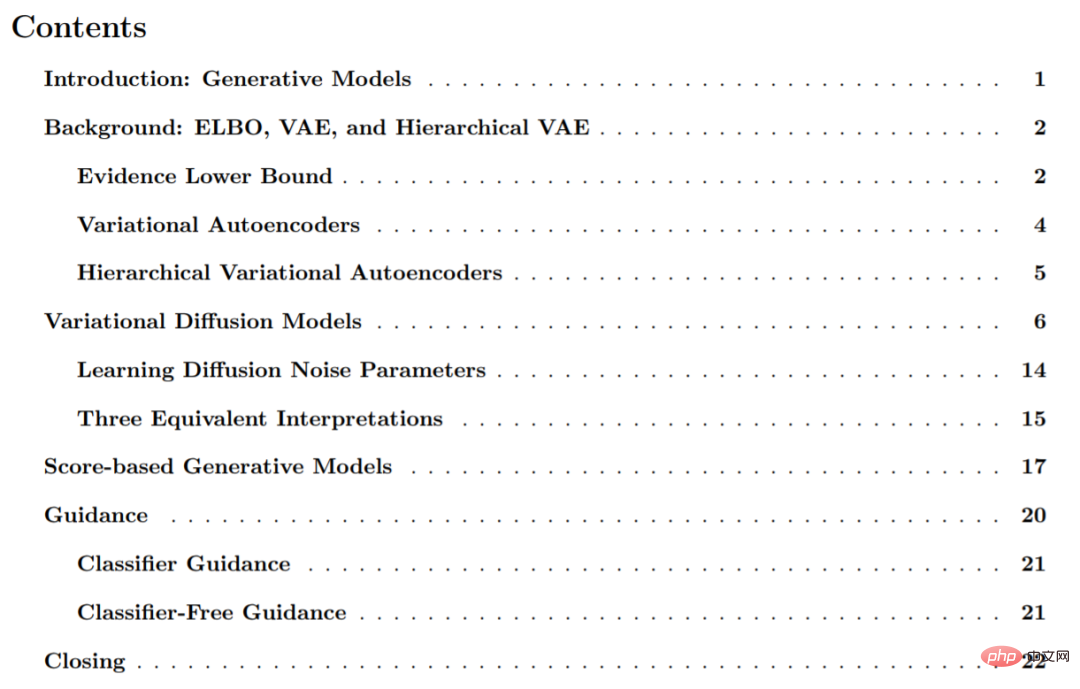

L'article est divisé en 6 parties, comprenant principalement des modèles génératifs ; ELBO, VAE et VAE hiérarchique ;

Ce qui suit est un extrait de l'article d'introduction :

Modèle générateur

Étant donné un échantillon d'observation x dans la distribution, le but du modèle génératif est d'apprendre ses véritables données distribution p( x) Modélisation. Une fois le modèle appris, nous pouvons générer de nouveaux échantillons. De plus, sous certaines formes, nous pouvons également utiliser des modèles d’apprentissage pour évaluer des observations ou des échantillons de données.

Il existe plusieurs directions importantes dans la littérature de recherche actuelle. Cet article ne les présente que brièvement à un niveau élevé. Elles incluent principalement : le GAN, qui modélise le processus d'échantillonnage de distributions complexes et apprend de manière contradictoire. Les modèles génératifs, que nous pouvons également appeler méthodes « basées sur la vraisemblance », peuvent attribuer une probabilité élevée aux échantillons de données observés et incluent généralement l'autorégression, le flux normalisé et la VAE. Modélisation basée sur l'énergie, dans cette approche, la distribution est apprise comme une fonction énergétique flexible arbitraire puis normalisée. Dans les modèles génératifs basés sur les scores, au lieu d’apprendre à modéliser la fonction énergétique elle-même, le score basé sur le modèle énergétique est appris sous forme d’un réseau neuronal.

Dans cette étude, cet article explore et passe en revue les modèles de diffusion, comme le montre l'article, ils ont des interprétations basées sur la vraisemblance et les scores.

Modèle de diffusion variationnel

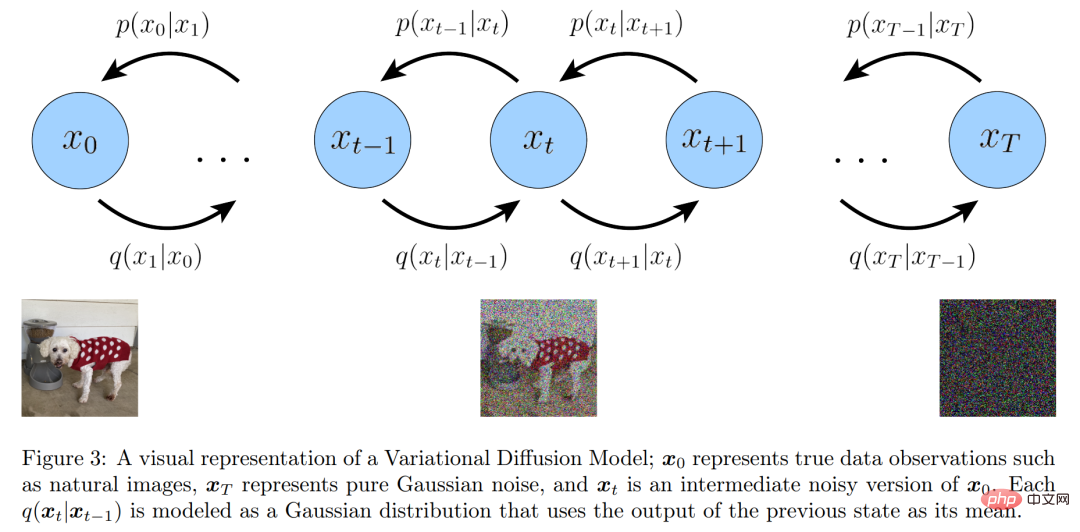

De manière simple, un modèle de diffusion variationnel (VDM) peut être considéré comme une variation hiérarchique de Markov avec trois restrictions (ou hypothèses) principales. Divisées en auto-encodeurs (MHVAE), elles sont :

- La dimension latente est exactement la même que la dimension des données ;

- La structure de l'encodeur latent à chaque pas de temps n'est pas apprise, elle est prédéfinie comme un modèle gaussien linéaire. En d'autres termes, il s'agit d'une distribution gaussienne centrée sur la sortie du pas de temps précédent ; les paramètres gaussiens du codeur latent changent avec le temps, et la distribution latente au pas de temps final T du processus est une distribution quasi-gaussienne.

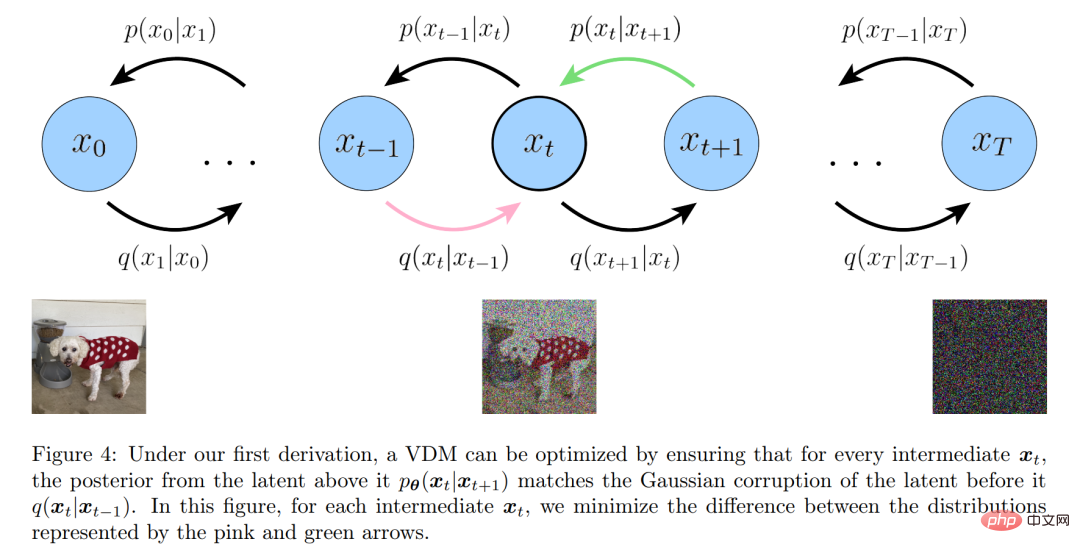

Représentation visuelle du modèle de diffusion variationnelle

Représentation visuelle du modèle de diffusion variationnelle

De plus, les chercheurs maintiennent explicitement la relation entre les transformations hiérarchiques à partir des auto-encodeurs variationnels hiérarchiques standard de Markov. Ils ont élargi une à une les implications des trois hypothèses principales ci-dessus.

À partir de la première hypothèse, en raison d'une mauvaise utilisation des symboles, les échantillons de données réelles et les variables latentes peuvent désormais être représentés par x_t, où t=0 représente les données réelles de l'échantillon et t ∈ [1, T] représente le variables latentes correspondantes, sa structure hiérarchique est indexée par t. Le postérieur VDM est le même que le postérieur MHVAE, mais peut maintenant être réécrit comme suit :

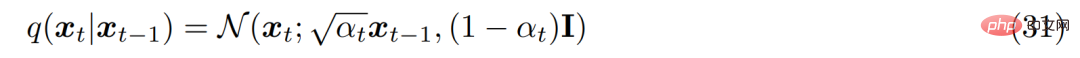

De la deuxième hypothèse, on sait que la distribution de chaque variable latente dans l'encodeur est divisée par le précédent La variable latente de couche est une distribution gaussienne centrée. Contrairement à MHVAE, la structure du codeur à chaque pas de temps n'est pas apprise, elle est fixée comme un modèle gaussien linéaire, où la moyenne et l'écart type peuvent être prédéfinis comme hyperparamètres ou appris comme paramètres. Mathématiquement, la transformation du codeur s'exprime comme suit :

De la deuxième hypothèse, on sait que la distribution de chaque variable latente dans l'encodeur est divisée par le précédent La variable latente de couche est une distribution gaussienne centrée. Contrairement à MHVAE, la structure du codeur à chaque pas de temps n'est pas apprise, elle est fixée comme un modèle gaussien linéaire, où la moyenne et l'écart type peuvent être prédéfinis comme hyperparamètres ou appris comme paramètres. Mathématiquement, la transformation du codeur s'exprime comme suit :

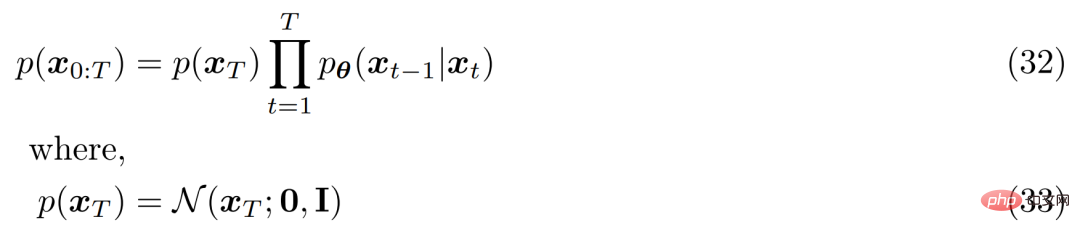

Pour la troisième hypothèse, α_t évolue dans le temps selon un planning fixe ou apprenable, tel que la distribution de la variable latente finale p(x_T) est la distribution gaussienne standard. La distribution conjointe de MHVAE peut alors être mise à jour et la distribution conjointe de VDM peut s'écrire comme suit :

Pour la troisième hypothèse, α_t évolue dans le temps selon un planning fixe ou apprenable, tel que la distribution de la variable latente finale p(x_T) est la distribution gaussienne standard. La distribution conjointe de MHVAE peut alors être mise à jour et la distribution conjointe de VDM peut s'écrire comme suit :

En résumé, cette série d'hypothèses décrit le bruit stable d'une image évoluant dans le temps. Les chercheurs ont progressivement corrompu l’image en ajoutant du bruit gaussien jusqu’à ce qu’elle devienne finalement identique au bruit gaussien.

En résumé, cette série d'hypothèses décrit le bruit stable d'une image évoluant dans le temps. Les chercheurs ont progressivement corrompu l’image en ajoutant du bruit gaussien jusqu’à ce qu’elle devienne finalement identique au bruit gaussien.

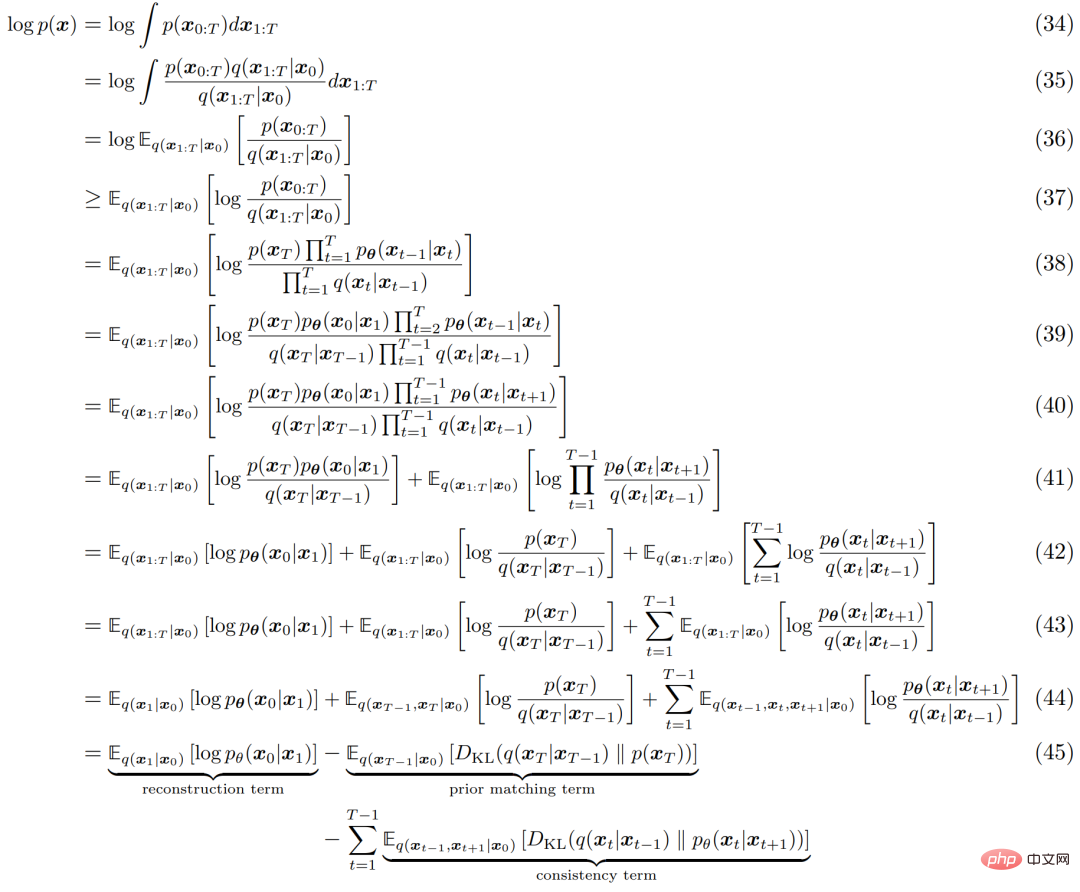

Semblable à n'importe quel HVACE, le VDM peut être optimisé en maximisant la limite inférieure des preuves (ELBO), qui peut être dérivée comme suit :

Le processus d'interprétation de l'ELBO est illustré dans la figure 4 ci-dessous. . :

Le processus d'interprétation de l'ELBO est illustré dans la figure 4 ci-dessous. . :

Trois interprétations équivalentes

Tout d'abord, vous pouvez utiliser la technique de paramétrage lourd. Lors de la dérivation de la forme de q(x_t|x_0), l'équation 69 peut être réorganisée comme suit :

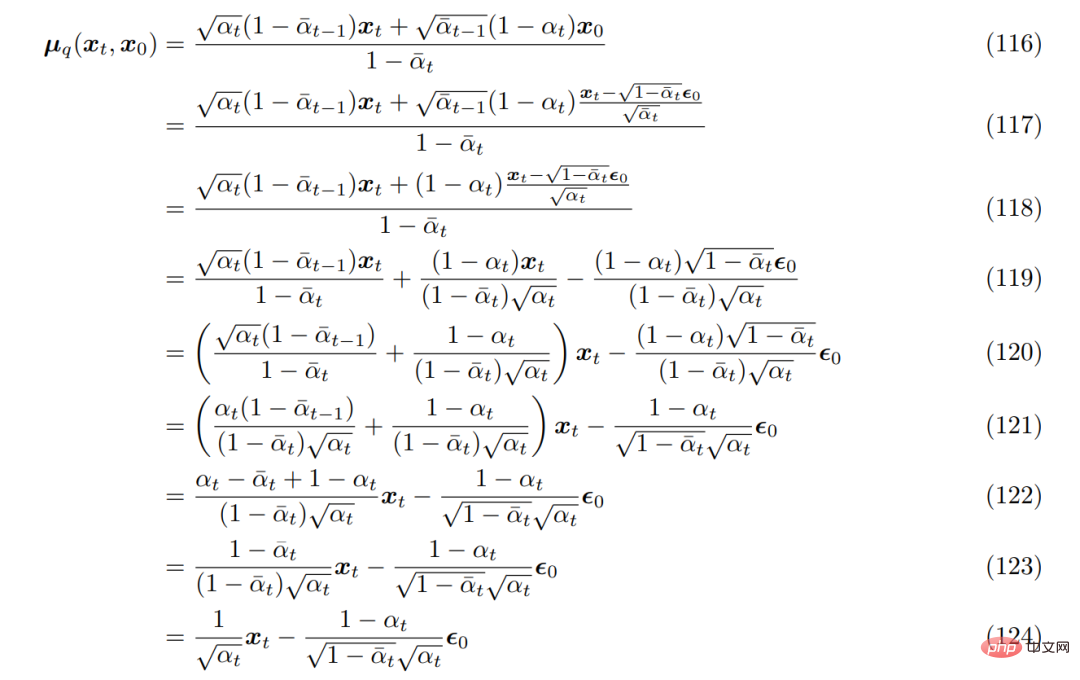

En l'introduisant dans la véritable moyenne de transformation de débruitage µ_q(x_t, x_0) précédemment dérivée, elle peut être re-dérivée comme suit :

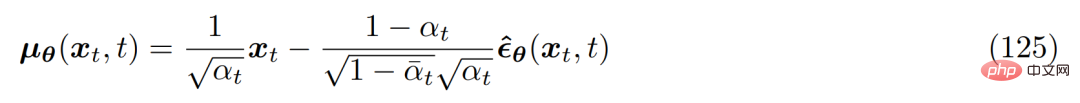

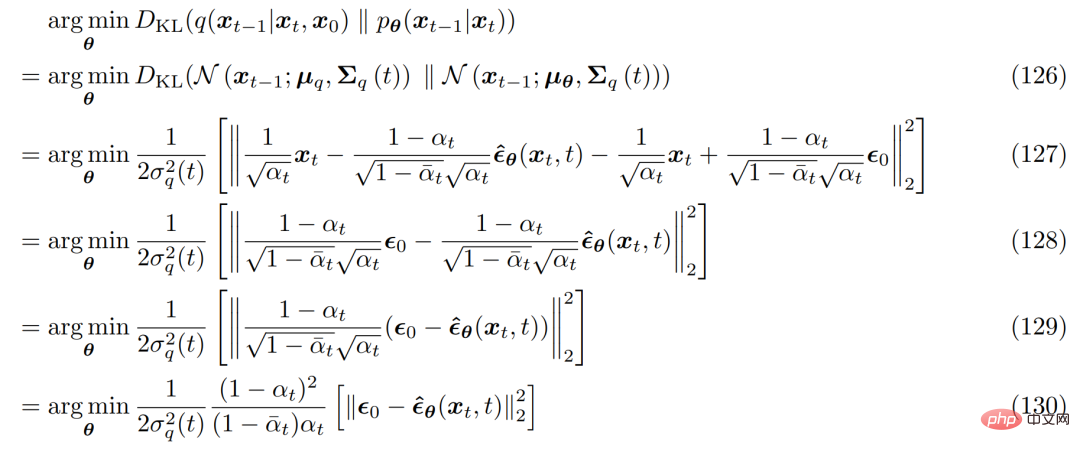

Par conséquent, la moyenne approximative de transformation de débruitage µ_θ(x_t, t) peut être définie comme suit :

et le problème d'optimisation correspondant devient le suivant :

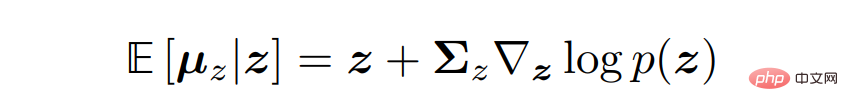

Afin de dériver les trois interprétations courantes des modèles de diffusion variationnelle, il faut se tourner vers la formule de Tweedie, ce qui fait référence au fait que lorsqu'un échantillon est donné, la vraie moyenne d'une distribution familiale exponentielle peut être estimée par l'estimation du maximum de vraisemblance de l'échantillon (également appelée moyenne empirique) plus un terme de correction impliquant le score estimé.

Mathématiquement parlant, pour une variable gaussienne z ∼ N (z; µ_z, Σ_z), la formule de Tweedie s'exprime comme suit :

Modèle génératif basé sur les scores

Des chercheurs ont montré que , Les modèles de diffusion variationnelle peuvent être appris simplement en optimisant un réseau neuronal s_θ(x_t, t) pour prédire une fonction de score ∇ log p(x_t). Cependant, le terme de notation dans la dérivation provient de l'application de la formule de Tweedie. Cela ne fournit pas nécessairement une bonne intuition ou un bon aperçu de ce qu’est exactement la fonction de score ou pourquoi elle mérite d’être modélisée.

Heureusement, nous pouvons obtenir cette intuition à l'aide d'un autre type de modèle génératif, à savoir le modèle génératif basé sur les scores. Les chercheurs ont en effet démontré que la formulation VDM précédemment dérivée possède une formulation de modélisation générative basée sur des fractions équivalente, permettant une commutation flexible entre les deux interprétations.

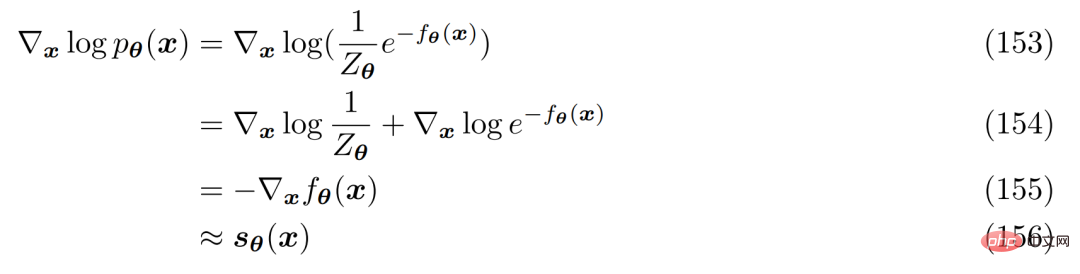

Pour comprendre pourquoi l’optimisation d’une fonction de score est logique, les chercheurs ont revisité les modèles basés sur l’énergie. Une distribution de probabilité flexible arbitraire peut être écrite comme suit :

Une façon d'éviter de calculer ou de modéliser la constante de normalisation est d'utiliser un réseau neuronal s_θ(x) pour apprendre le score de la distribution p( x) Fonction ∇ log p(x). On observe que les deux côtés de l'équation 152 peuvent être différenciés logarithmiquement :

qui peut être librement exprimé comme un réseau neuronal sans impliquer de constantes de normalisation. La fonction de score peut être optimisée en minimisant la divergence de Fisher à l'aide de la fonction de score réel.

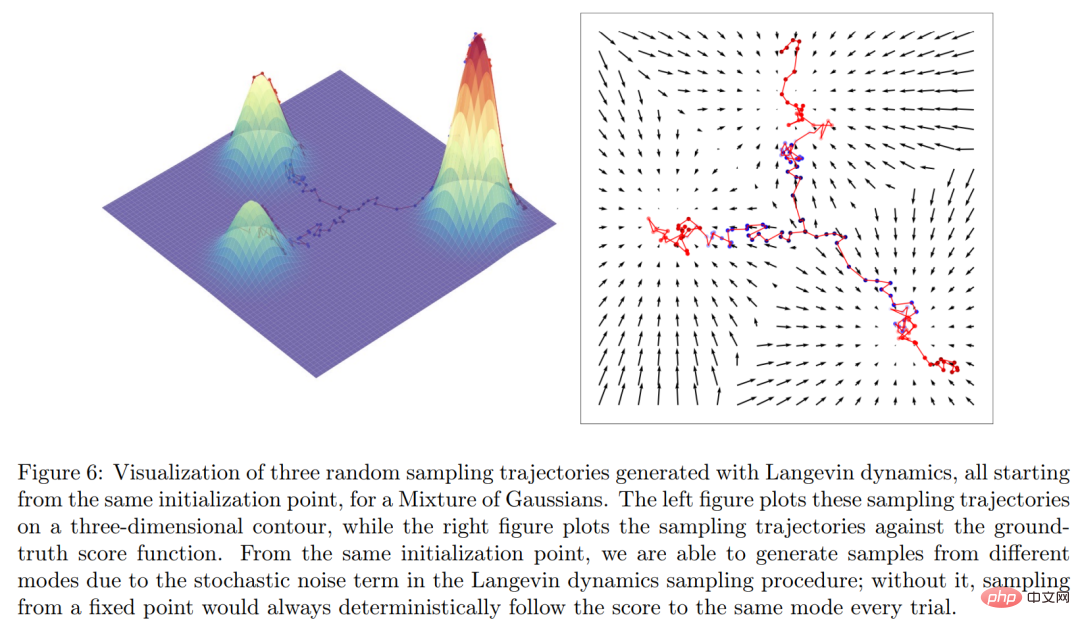

Intuitivement parlant, la fonction score définit un champ vectoriel sur tout l'espace où se trouvent les données x et pointe vers le modèle, comme le montre la figure 6 ci-dessous.

Enfin, les chercheurs ont établi un lien explicite entre le modèle de diffusion variationnelle et le modèle génératif basé sur les scores à partir des objectifs de formation et du processus d'échantillonnage.

Veuillez vous référer au document original pour plus de détails.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI