Maison >Périphériques technologiques >IA >DeepFake n'a jamais été aussi réel ! Quelle est la force de la dernière « distorsion implicite » de Nvidia ?

DeepFake n'a jamais été aussi réel ! Quelle est la force de la dernière « distorsion implicite » de Nvidia ?

- PHPzavant

- 2023-04-11 19:31:171542parcourir

Ces dernières années, la technologie de génération dans le domaine de la vision par ordinateur est devenue de plus en plus puissante, et la technologie de « contrefaçon » correspondante est devenue de plus en plus mature Du changement de visage DeepFake à la simulation d'action, il est difficile de faire la distinction. le vrai du faux.

Récemment, NVIDIA a fait un autre grand pas en avant lors de la conférence NeurIPS 2022, en publiant un nouveau Implicit Warping framework, qui utilise un ensemble d'images sources et un mouvement vidéo piloté pour créer une animation cible. .

Lien papier : https://arxiv.org/pdf/2210.01794.pdf

Du point de vue effet, l'image générée est plus réaliste, les personnages bougent dans la vidéo, Contexte Il n'y aura aucun changement.

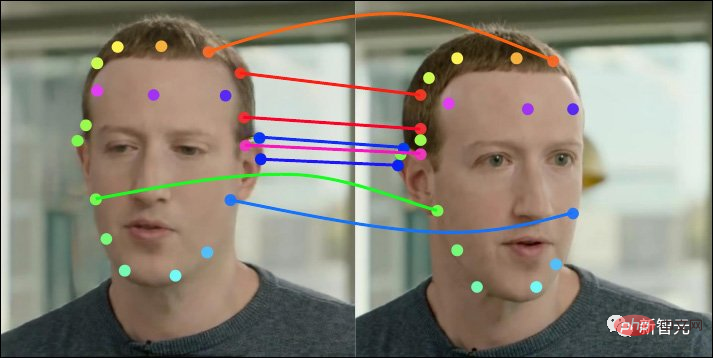

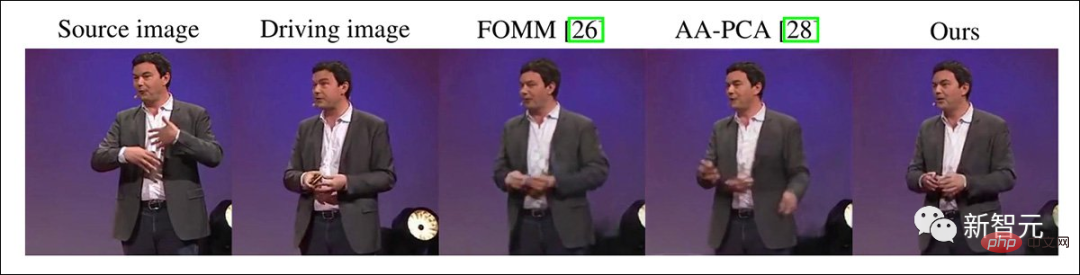

Les images sources multiples d'entrée fournissent généralement des informations d'apparence différentes, réduisant l'espace « fantastique » du générateur, comme les deux suivantes comme entrées de modèle.

On peut constater que par rapport à d'autres modèles, la distorsion implicite ne produit pas de « distorsion spatiale » similaire à l'effet de beauté.

En raison de l'occlusion des personnes, les images sources multiples peuvent également fournir un arrière-plan plus complet.

Comme vous pouvez le voir sur la vidéo ci-dessous, s'il n'y a qu'une seule image à gauche, il est difficile de deviner si c'est "BD" ou "ED" derrière l'arrière-plan, ce qui provoquera distorsion de l'arrière-plan et deux images produiront une image plus stable.

Lorsque vous comparez d'autres modèles, l'effet d'une seule image source est meilleur.

Magic Implicit Distortion

L'imitation vidéo dans le monde universitaire remonte à 2005. De nombreux projets incluent la transmission d'expression en temps réel de la reproduction faciale, Face2Face, Obama synthétique, Recycle-GAN, ReenactGAN, champ de rayonnement neuronal dynamique Etc. a diversifié l’utilisation de plusieurs technologies limitées à l’époque, telles que les réseaux contradictoires génératifs (GAN), les champs de rayonnement neuronal (NeRF) et les auto-encodeurs.

Toutes les méthodes n'essaient pas de générer des vidéos à partir d'une seule image. Certaines études effectuent également des calculs complexes sur chaque image de la vidéo. C'est en fait la voie d'imitation empruntée par Deepfake.

Mais comme le modèle DeepFake acquiert moins d'informations, cette méthode doit être entraînée sur chaque clip vidéo, et les performances sont réduites par rapport aux méthodes open source de DeepFaceLab ou FaceSwap, qui sont capables d'imposer une identité à n'importe lequel. nombre de clips vidéo.

Le modèle FOMM sorti en 2019 permet aux personnages de se déplacer avec la vidéo, donnant ainsi une autre chance à la tâche d'imitation vidéo.

Par la suite, d'autres chercheurs ont essayé d'obtenir plusieurs poses et expressions à partir d'une seule image de visage ou d'une représentation du corps entier ; cependant, cette méthode ne fonctionne généralement que pour des sujets relativement sans expression et immobiles, tels que des sujets relativement « parlants ». car il n’y a pas de « changements soudains de comportement » dans les expressions faciales ou les gestes que le réseau doit interpréter.

Bien que certaines de ces technologies et méthodes aient attiré l'attention du public avant que la technologie des deepfakes et les méthodes potentielles de synthèse d'images par diffusion ne deviennent populaires, leur champ d'application est limité et leur polyvalence est remise en question.

La distorsion implicite sur laquelle NVIDIA se concentre cette fois est d'obtenir des informations entre plusieurs images ou même seulement entre deux images, au lieu d'obtenir toutes les informations de posture nécessaires à partir d'une seule image. Ce paramètre est utilisé dans d'autres ni l'un ni l'autre n'est présent dans les modèles concurrents. , ou est extrêmement mal géré.

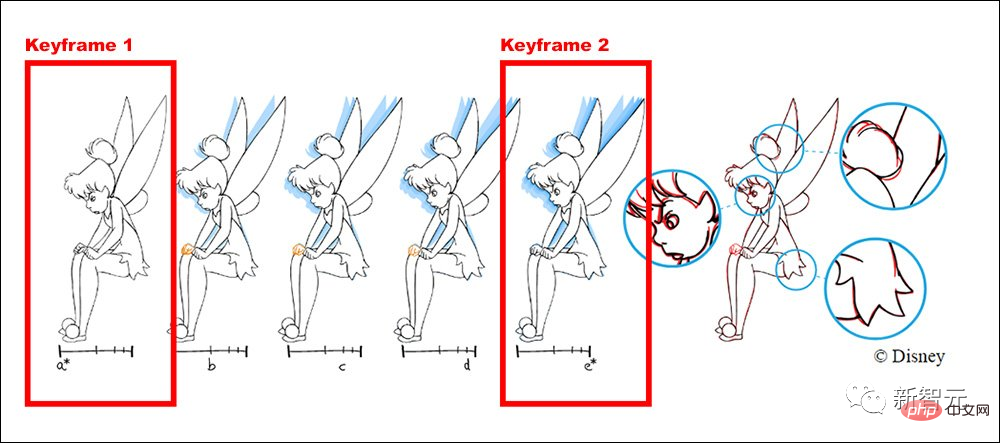

Par exemple, le flux de travail de Disney est que les animateurs seniors dessinent les images principales et les images clés, et que d'autres animateurs juniors sont responsables du dessin des images intermédiaires.

Grâce à des tests sur les versions précédentes, les chercheurs de NVIDIA ont constaté que la qualité des résultats de la méthode précédente se détériorerait avec des "images clés" supplémentaires, tandis que la nouvelle méthode est cohérente avec la logique de production d'animation à mesure que le nombre d'images clés augmente. , À mesure que le nombre augmente, les performances s'améliorent également de manière linéaire.

S'il y a des changements soudains au milieu du clip, comme un événement ou une expression qui n'est pas affiché dans l'image de début ou de fin, une distorsion implicite peut ajouter une image à ce point médian, et des informations supplémentaires seront réinjecté dans le mécanisme d’attention de l’ensemble du clip.

Structure du modèle

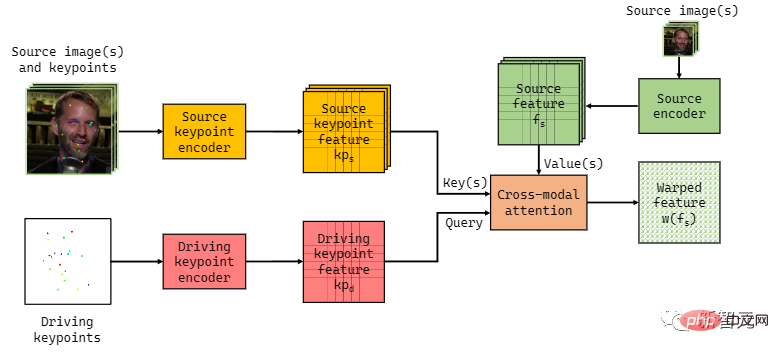

Les méthodes précédentes telles que FOMM, Monkey-Net et face-vid2vid utilisent une déformation explicite pour dessiner une série temporelle, et les informations extraites du visage source et du mouvement de contrôle doivent être adaptées et cohérentes. séries chronologiques.

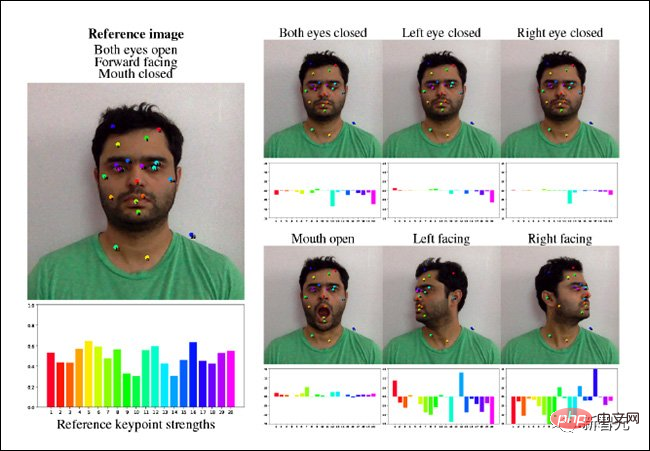

Sous la conception de ce modèle, la cartographie finale des points clés est assez stricte.

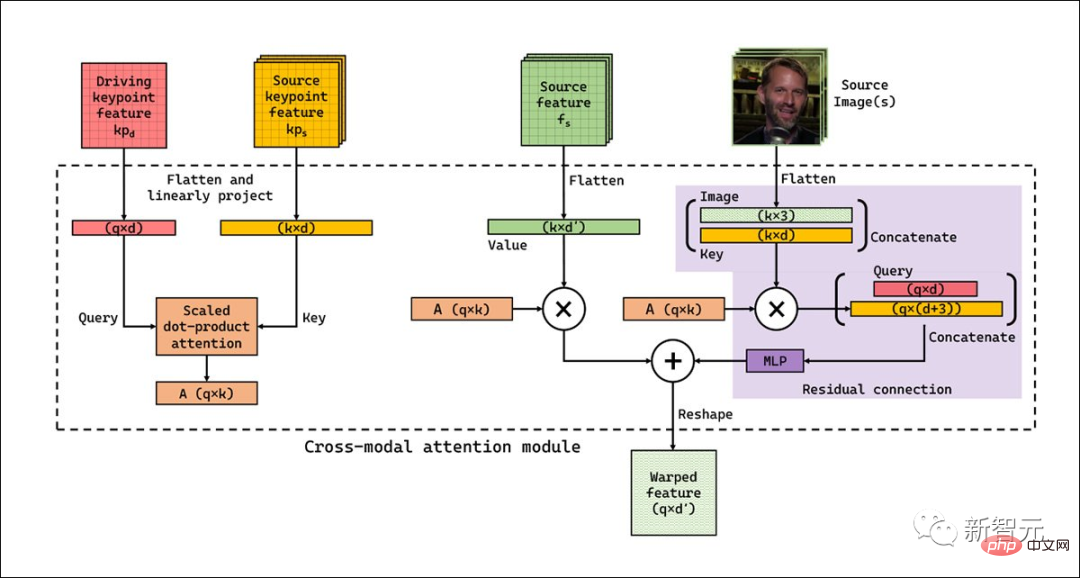

En revanche, la déformation implicite utilise une couche d'attention intermodale avec moins d'amorçage prédéfini inclus dans son flux de travail et peut s'adapter aux entrées de plusieurs frameworks.

Le flux de travail ne nécessite pas non plus de distorsion point par point clé, le système peut sélectionner les fonctionnalités les plus appropriées à partir d'une série d'images.

La déformation implicite réutilise également certains composants de prédiction de points clés dans le cadre FOMM et utilise enfin un simple U-net pour coder la représentation de points clés dérivée spatialement. Un U-net distinct est utilisé pour coder l'image source avec la représentation spatiale dérivée. Les deux réseaux peuvent fonctionner à des résolutions allant de 64 px (sortie carrée de 256 px) à 384 x 384 px.

Étant donné que ce mécanisme ne peut pas automatiquement prendre en compte tous les changements possibles dans les poses et les mouvements dans une vidéo donnée, des images clés supplémentaires sont nécessaires et peuvent être ajoutées de manière ponctuelle. Sans cette capacité d'intervention, les touches qui ne sont pas suffisamment similaires au point de mouvement cible seront automatiquement mises à jour, entraînant une diminution de la qualité de sortie.

L'explication des chercheurs est que, bien qu'il s'agisse de la clé la plus similaire à la requête dans un ensemble d'images clés donné, elle peut ne pas être suffisante pour produire un bon résultat.

Par exemple, supposons que l'image source ait un visage avec des lèvres fermées et que l'image pilote ait un visage avec des lèvres ouvertes et des dents exposées. Dans ce cas, il n’existe pas de clé (ni de valeur) appropriée dans l’image source pour piloter la région buccale de l’image.

Cette méthode surmonte ce problème en apprenant des paires clé-valeur supplémentaires indépendantes de l'image, qui peuvent faire face au manque d'informations dans l'image source.

Bien que la mise en œuvre actuelle soit assez rapide, environ 10 FPS sur une image de 512x512px, les chercheurs pensent que dans les versions futures, le pipeline pourrait être amélioré avec une couche d'attention I-D factorisée ou une couche d'attention spatiale réduite (SRA) (c'est-à-dire une couche visuelle pyramidale Transformateur) à optimiser.

Étant donné que la déformation implicite utilise l'attention globale au lieu de l'attention locale, elle peut prédire des facteurs que les modèles précédents ne peuvent pas prédire.

Résultats expérimentaux

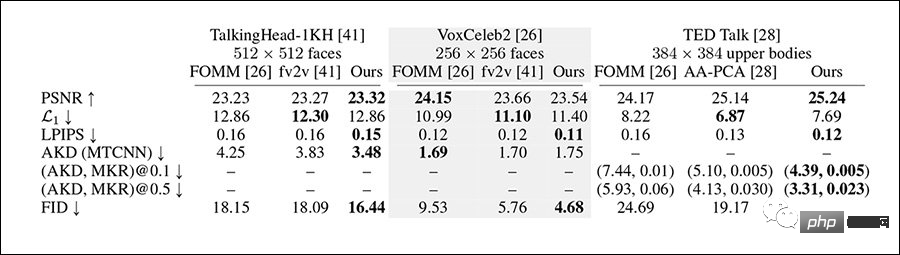

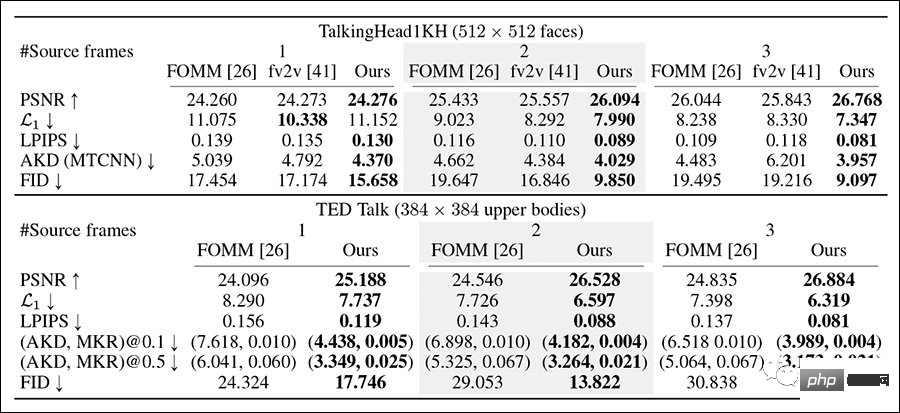

Les chercheurs ont testé le système sur l'ensemble de données VoxCeleb2, l'ensemble de données TED Talk le plus complexe, et l'ensemble de données TalkingHead-1KH, en comparant les lignes de base entre les résolutions de 256 x 256 px et celles de 512 x 512 px. Les métriques utilisées incluent le FID et le LPIPS basé sur AlexNet. et le rapport signal/bruit de crête (pSNR).

Les cadres de comparaison utilisés pour les tests incluent FOMM et face-vid2vid, ainsi que AA-PCA, étant donné que les méthodes précédentes ont peu ou pas de capacité à utiliser plusieurs images clés, c'est également la principale innovation en matière de distorsion implicite. méthodes d'essais.

La déformation implicite surpasse la plupart des méthodes contrastées sur la plupart des métriques.

Dans le test de reconstruction multi-images clés, dans lequel les chercheurs ont utilisé des séquences allant jusqu'à 180 images et des images d'espacement sélectionnées, la distorsion implicite a globalement gagné cette fois.

À mesure que le nombre d'images sources augmente, la méthode peut obtenir de meilleurs résultats de reconstruction et les scores de tous les indicateurs s'améliorent.

Et à mesure que le nombre d'images sources augmente, l'effet de reconstruction des travaux précédents s'aggrave, contrairement aux attentes.

Après avoir mené des recherches qualitatives auprès du personnel de l'AMT, on pense également que les résultats de génération de déformation implicite sont plus forts que les autres méthodes.

En ayant accès à ce framework, les utilisateurs seraient en mesure de produire des simulations vidéo plus cohérentes et plus longues et des vidéos deepfake de tout le corps, qui seraient toutes capables de démontrer de meilleures performances que n'importe quel framework sur lequel le système a été expérimenté. avec. Une amplitude de mouvement beaucoup plus grande.

Cependant, la recherche sur une synthèse d'images plus réaliste suscite également des inquiétudes, car ces techniques peuvent être facilement utilisées à des fins de contrefaçon, et il existe une clause de non-responsabilité standard dans le document.

Si notre méthode est utilisée pour créer des produits DeepFake, cela peut avoir des conséquences négatives. La synthèse vocale malveillante crée de fausses images de personnes en transférant et en transmettant de fausses informations à travers les identités, conduisant au vol d'identité ou à la diffusion de fausses nouvelles. Mais dans des environnements contrôlés, la même technologie peut également être utilisée à des fins de divertissement.

Le document souligne également le potentiel de ce système pour la reconstruction de vidéos neuronales, comme le projet Starline de Google, où l'effort de reconstruction est principalement concentré du côté client, en exploitant les informations de mouvement clairsemées de la personne à l'autre bout du fil.

Cette solution suscite de plus en plus l'intérêt de la communauté des chercheurs, et certaines entreprises envisagent également de mettre en œuvre des conférences téléphoniques à faible bande passante en envoyant des données de mouvement pures ou des images clés peu espacées, qui seront interprétées une fois arrivées chez le client cible. et inséré dans une vidéo Full HD.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI