Maison >Périphériques technologiques >IA >Dialogue interactif homme-machine piloté par de grands modèles

Dialogue interactif homme-machine piloté par de grands modèles

- PHPzavant

- 2023-04-11 19:27:471488parcourir

Introduction : La technologie de dialogue est l'une des capacités essentielles de l'interaction humaine numérique. Ce partage part principalement de la recherche, du développement et des applications liés à Baidu PLATO, et parle de l'impact des grands modèles sur. systèmes de dialogue et sur le numérique Quelques opportunités pour les personnes Le titre de ce partage est : Dialogue d'interaction homme-machine piloté par de grands modèles.

L'introduction d'aujourd'hui commence par les points suivants :

- Vue d'ensemble du système de dialogue

- Baidu PLATO et les technologies associées

- Dialogue large mise en œuvre du modèle et défis et perspectives

1. Aperçu du système de dialogue

1. Aperçu du système de dialogue

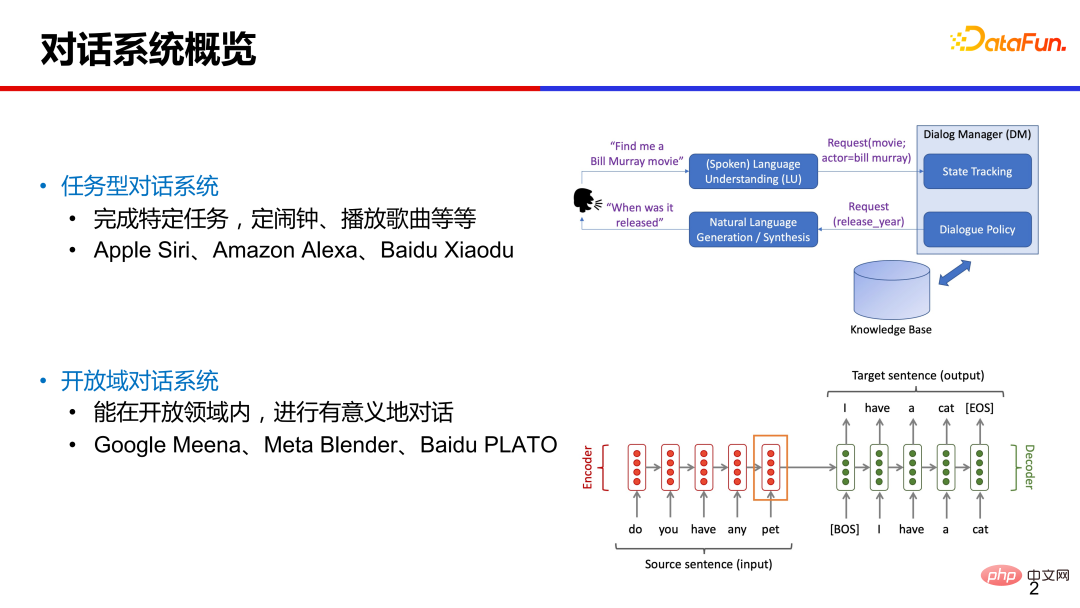

Dans la vie quotidienne, nous entrons souvent en contact avec certains systèmes de dialogue orientés tâches, comme demander au téléphone portable Assistant pour régler une alarme, demandant Le haut-parleur intelligent joue une chanson. La technologie pour ce type de dialogue vertical dans un domaine spécifique est relativement mature et la conception du système est généralement modulaire, comprenant des modules tels que la compréhension du dialogue, la gestion du dialogue et la génération du langage naturel.

Le processus général du dialogue traditionnel basé sur les tâches est le suivant : l'utilisateur saisit une phrase et le système analyse les paires intention et valeur d'emplacement pertinentes via le module de compréhension du langage naturel. sont prédéfinis ; le module de gestion des dialogues suit l'état de plusieurs cycles de dialogue et interagit avec la base de données externe pour prendre des décisions d'action du système, puis utilise le module de génération de dialogue pour générer une réponse et la renvoyer à l'utilisateur ;

Ces dernières années, de nombreuses recherches ont porté sur la technologie de conversation en domaine ouvert, ce qui signifie que vous pouvez discuter sur n'importe quel sujet sans limiter le champ. Les travaux représentatifs incluent Google Meena, Mata Blender et Baidu PLATO. Par rapport aux systèmes de dialogue modulaires traditionnels, ces systèmes de dialogue de bout en bout génèrent directement des réponses correspondantes compte tenu du contexte du dialogue.

2. Génération de dialogue de bout en bout - de nouvelles opportunités pour les systèmes de dialogue

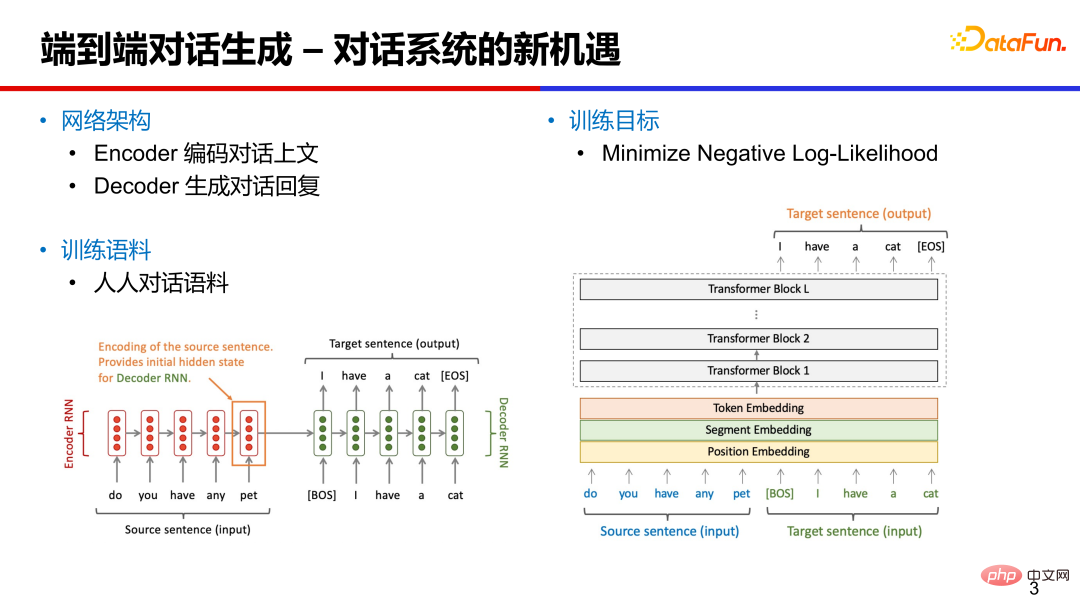

Les systèmes de dialogue de bout en bout peuvent être conçus sur la base de RNN, LSTM ou Transformer, etc. L'architecture du réseau comprend principalement deux parties : l'encodage de l'encodeur et du décodeur.

L'encodeur encode le texte de la conversation en vecteurs pour comprendre le contenu de la conversation.

Le décodeur génère la réponse correspondante en fonction du vecteur de conversation et du vecteur caché précédent. Le corpus de formation est principalement constitué de matériel de dialogue Renren. Les commentaires peuvent être extraits des forums publics de médias sociaux (Weibo, Tieba, Twitter, etc.) comme matériel de dialogue approximatif. L'objectif de la formation est principalement de minimiser la fonction de log-vraisemblance négative.

3. Les défis rencontrés par le dialogue en domaine ouvert

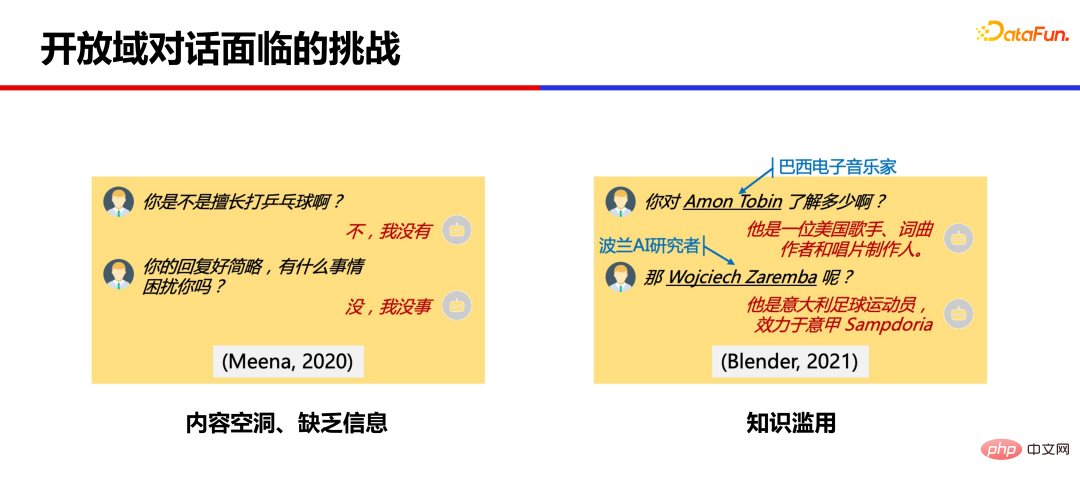

Des modèles à grande échelle formés sur la base d'une grande quantité de corpus peuvent déjà produire des réponses relativement cohérentes, mais de nombreux problèmes subsistent.

Le premier problème est que le contenu est relativement vide et manque d'informations. Les réponses du modèle sont relativement brèves et n'ont pas de contenu substantiel, ce qui peut facilement réduire la volonté de l'utilisateur de discuter.

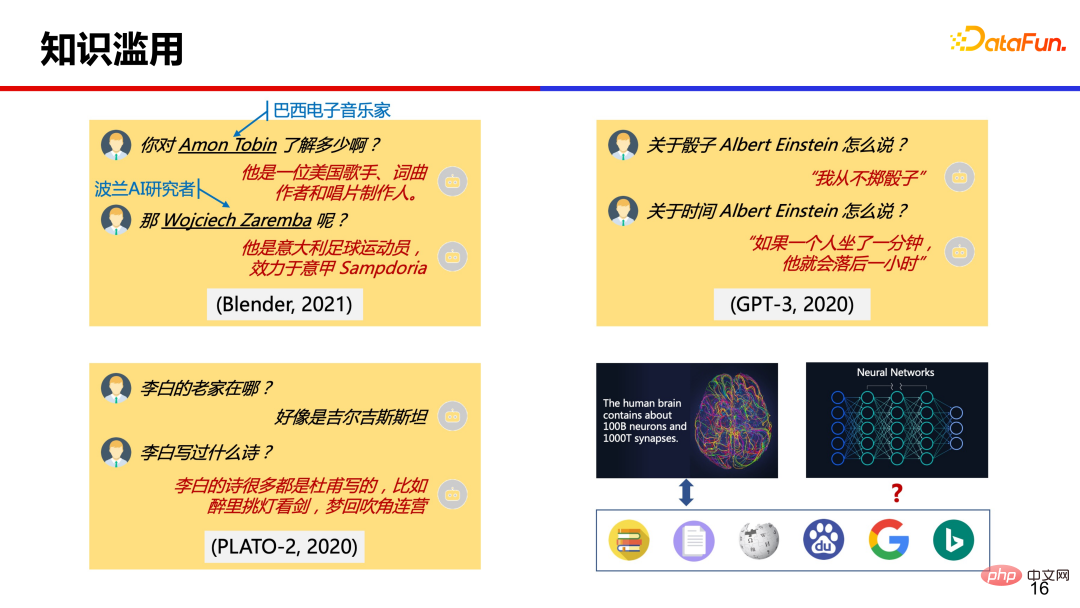

Un autre problème est l'abus de connaissances. Certaines informations détaillées renvoyées par le modèle sont parfois fausses ou fabriquées.

2. Baidu PLATO

Baidu PLATO a effectué une exploration technique sur les deux types de problèmes ci-dessus.

Visant les trous de contenu, une technologie de génération de dialogue de pré-formation basée sur des variables latentes discrètes est proposée pour parvenir à une génération raisonnable et diversifiée de réponses en domaine ouvert. Concernant le problème de l'abus des connaissances, un modèle de génération de dialogue faiblement supervisé qui intègre les connaissances est proposé, ce qui atténue dans une certaine mesure le problème de l'abus des connaissances et améliore la richesse du dialogue et l'exactitude des connaissances.

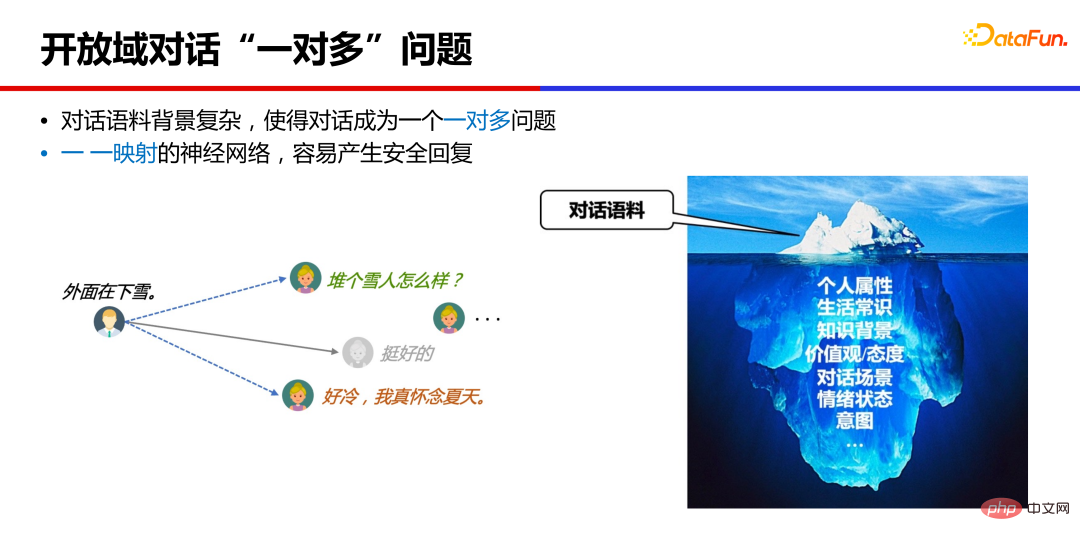

1. Le problème « un-à-plusieurs » du dialogue de domaine ouvert

Pourquoi le modèle de dialogue produit-il des « réponses sûres » avec un contenu vide ?

Essentiellement, le dialogue en domaine ouvert est un problème de un à plusieurs. Il existe généralement de nombreuses réponses raisonnables à un dialogue. Différentes personnes ont des antécédents, des expériences et des situations différentes, et les réponses données sont probablement non. le même. La formation des réseaux neuronaux est généralement cartographiée une par une, et ce qui est appris est l'état moyen de ces réponses, telles que « très bien » et « hahaha », qui sont des réponses sûres et non informatives.

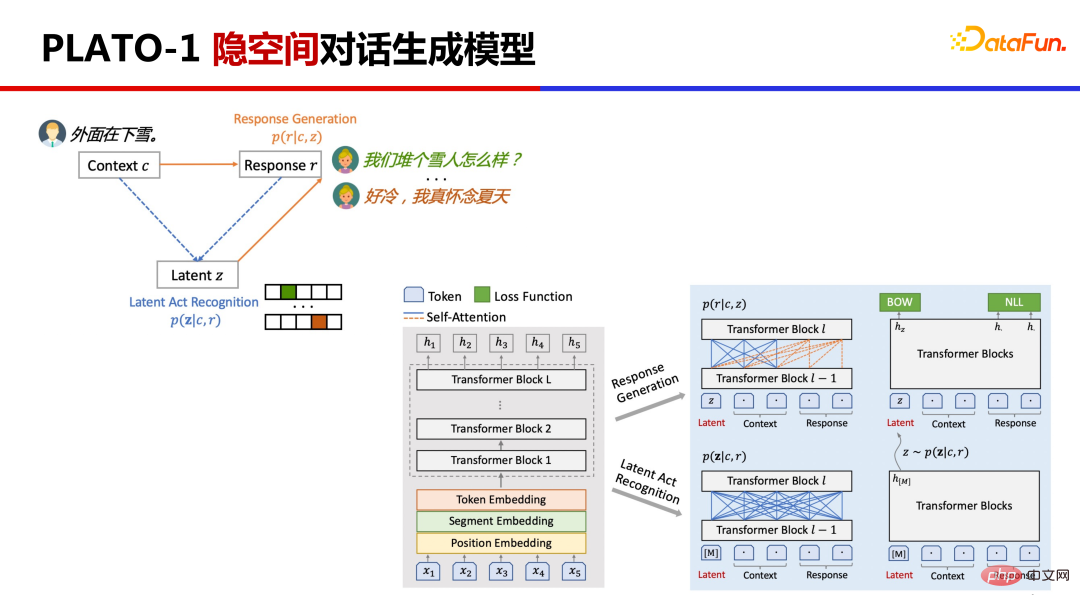

2. PLATO-1 modèle de génération de dialogues spatiaux latents

PLATO-1 propose de modéliser des relations de dialogue un-à-plusieurs basées sur des variables latentes discrètes.

Cela implique deux tâches, cartographier le contexte de conversation d'origine et la réponse de la conversation à la variable latente Action latente, puis apprendre à générer des réponses basées sur la variable latente. PLATO utilise le même réseau pour modéliser conjointement deux tâches. Il estime d'abord la distribution des variables latentes, échantillonne les variables latentes via Gumbel Softmax, puis apprend à générer des réponses de cette manière, diverses réponses peuvent être générées en échantillonnant différentes variables latentes.

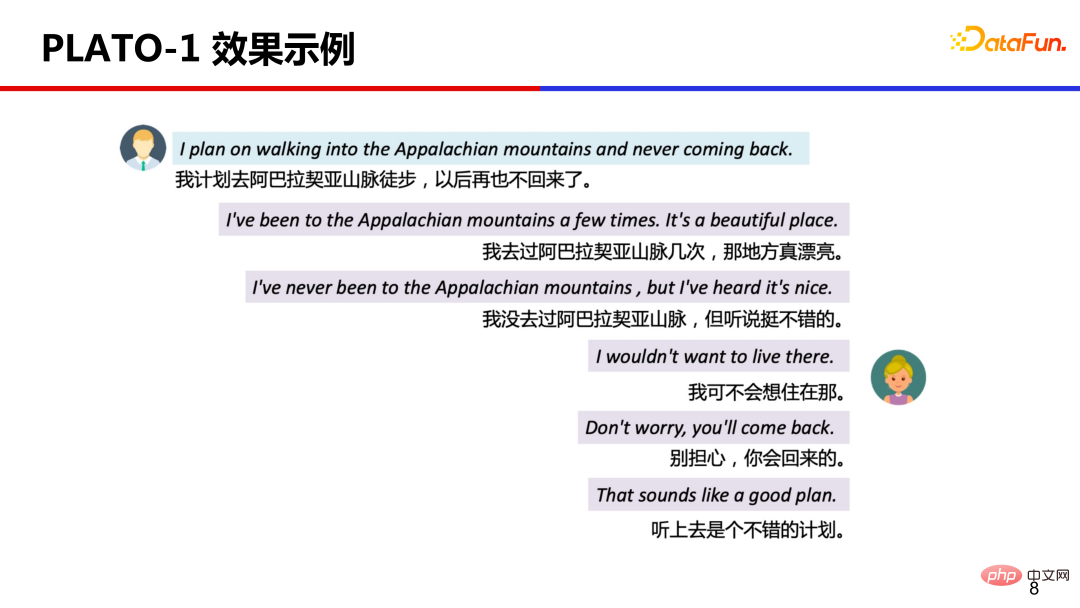

Affichage du cas, différentes variables latentes sont sélectionnées pour produire différents effets de réponse. Ces réponses sont toutes basées sur les réponses ci-dessus et sont de bonne qualité, appropriées et informatives.

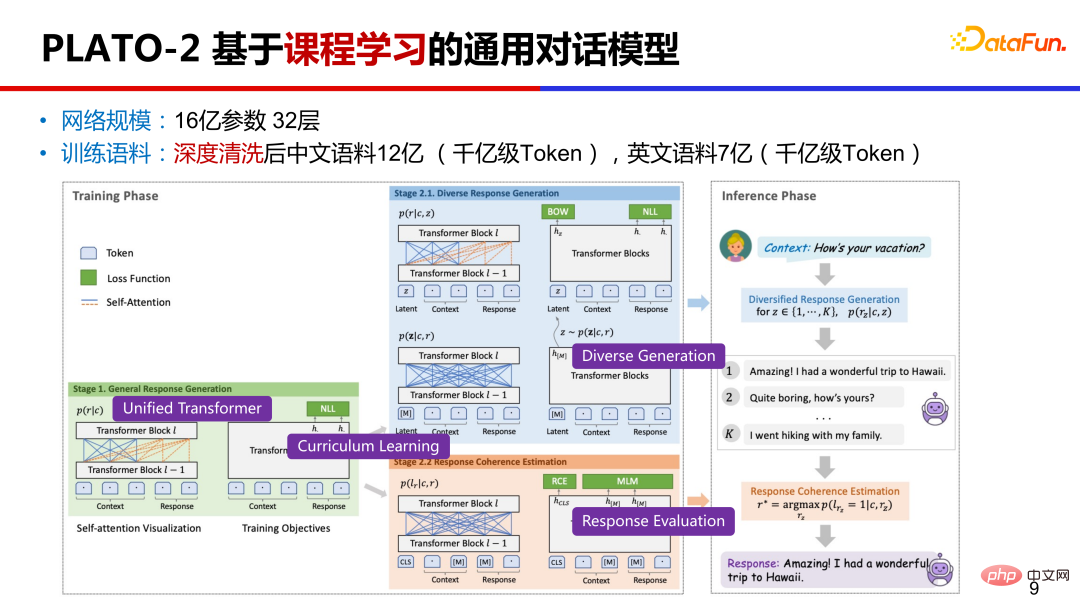

3. PLATO-2 Un modèle de dialogue général basé sur l'apprentissage en cours

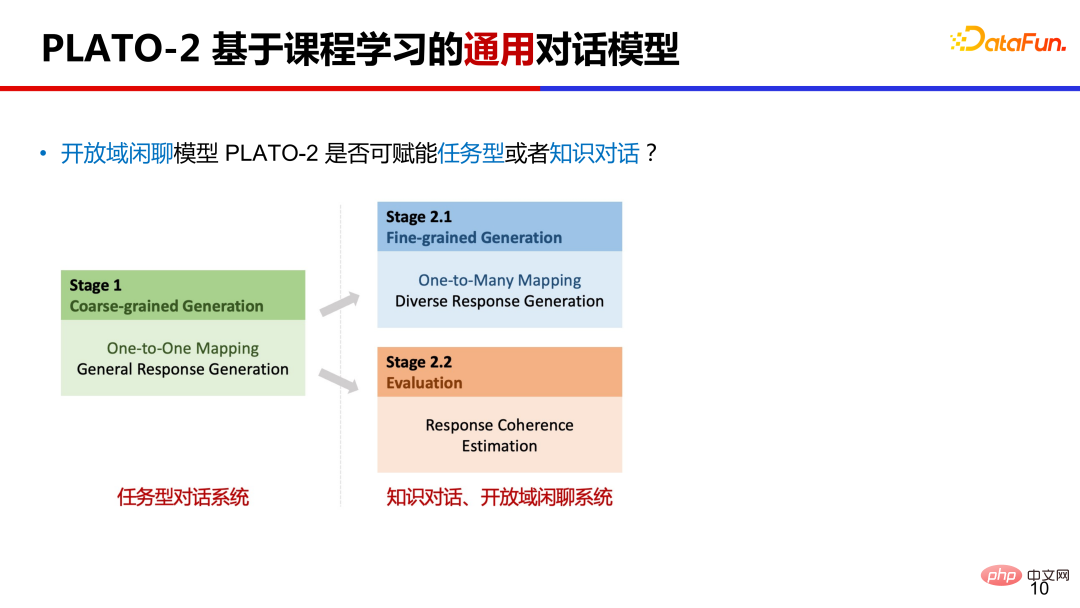

PLATO-2 continue de s'étendre sur la base de PLATO-1. En termes de paramètres, il a atteint une échelle de 1,6 milliard ; en termes de corpus de pré-formation, il existe 1,2 milliard d'échantillons de dialogues chinois et 700 millions d'échantillons d'anglais en termes de méthodes de formation, il est basé sur l'apprentissage de cours ; Qu’est-ce que l’apprentissage curriculaire ? Apprenez simplement les plus simples d’abord, puis les plus complexes.

De plus, PLATO-2 continue d'utiliser la conception de réseau unifiée PrefixLM, tout en apprenant la compréhension du dialogue et la génération de réponses. La formation basée sur l'apprentissage de cours est très efficace et la formation unifiée basée sur un réseau est très rentable.

PLATO-2 entraîne d'abord la génération de réponses générales simplifiées et entraîne la génération de réponses diversifiées dans la deuxième étape. Dans cette étape, des variables latentes sont ajoutées. La deuxième étape introduit également la formation à l'évaluation de la cohérence du dialogue. Par rapport au classement de probabilité de génération commun, l'évaluation de la cohérence améliore efficacement la qualité de la sélection des réponses.

PLATO-2 peut-il être utilisé comme cadre de dialogue universel ? Nous savons que le domaine du dialogue est grossièrement divisé en trois catégories : le dialogue basé sur les tâches, le dialogue sur les connaissances et le système de chat de domaine ouvert. Il est trop coûteux de pré-former séparément différents types de systèmes de dialogue. Le mécanisme d'apprentissage des cours de PLATO-2 peut l'aider à devenir un cadre de dialogue universel. Le dialogue basé sur les tâches est relativement ciblé. Le modèle de cartographie individuelle dans la première étape de l'apprentissage du cours répond tout simplement à cette situation. Il existe des situations un-à-plusieurs dans le dialogue de connaissances et dans le dialogue informel. peut utiliser différentes connaissances pour répondre à l'utilisateur, et dans le dialogue de discussion informel, il existe différentes directions de réponse, de sorte que le modèle d'apprentissage du cours de deuxième étape peut être appliqué au dialogue de connaissances et aux systèmes de discussion.

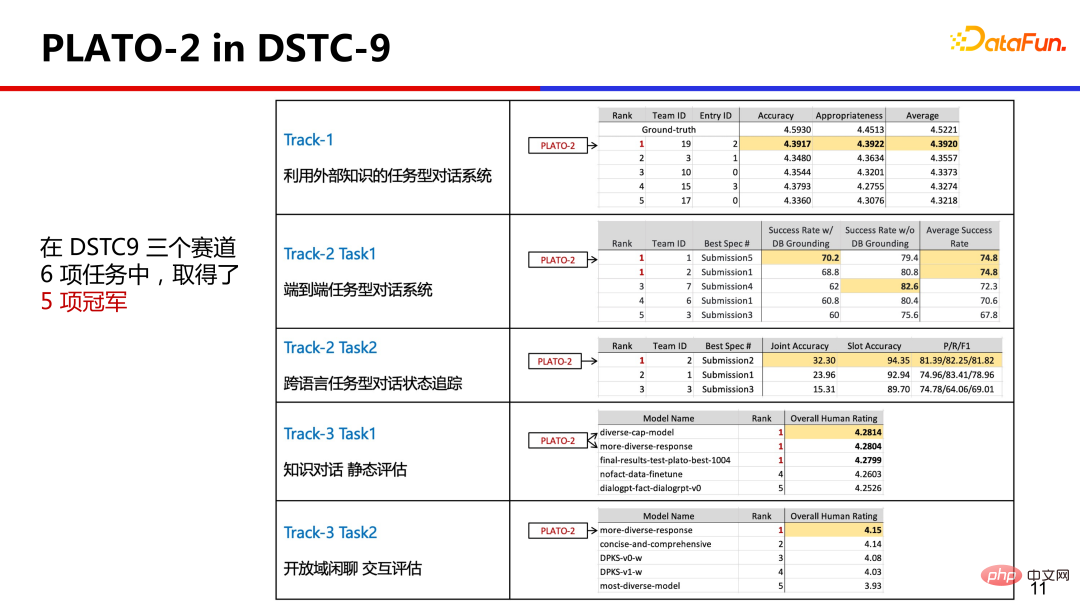

4, PLATO-2 dans DSTC-9

Afin de vérifier cette capacité, PLATO-2 a participé au concours international DSTC dans le domaine du dialogue, qui couvre de manière globale divers domaines de dialogue, PLATO- 2 Il a remporté 5 championnats en 6 tâches avec un cadre technique unifié, ce qui est la première fois dans l'histoire du DSTC.

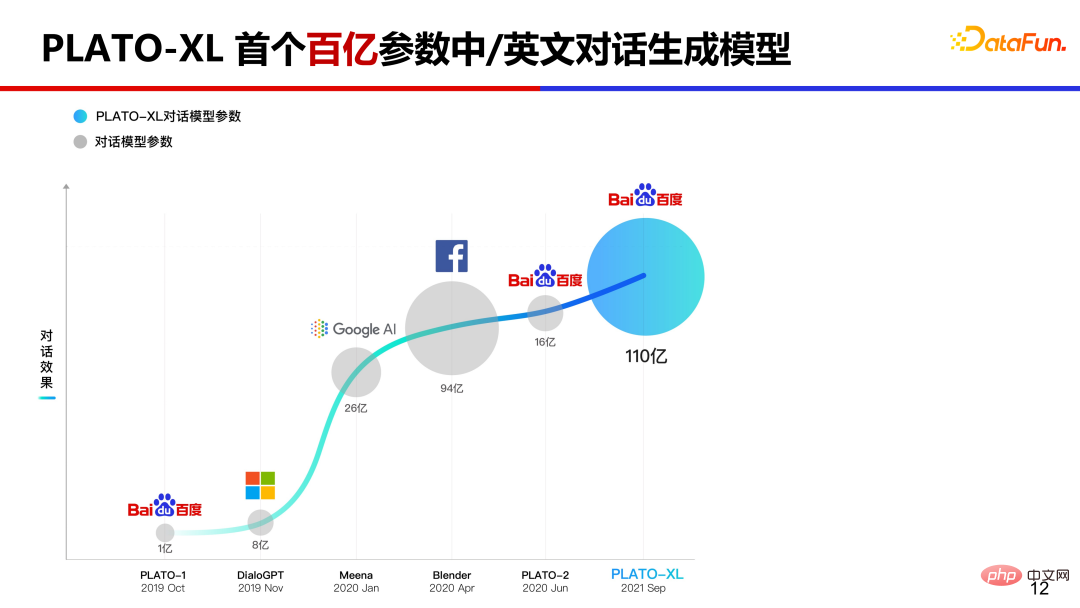

5. PLATO-XL, le premier modèle de génération de dialogues chinois et anglais de 10 milliards de paramètres

Quel sera l'effet si nous continuons à augmenter l'échelle des paramètres du modèle PLATO ? En septembre 2021, nous avons lancé PLATO-XL, le premier modèle mondial de génération de conversations en chinois et en anglais à l'échelle de plusieurs dizaines de milliards.

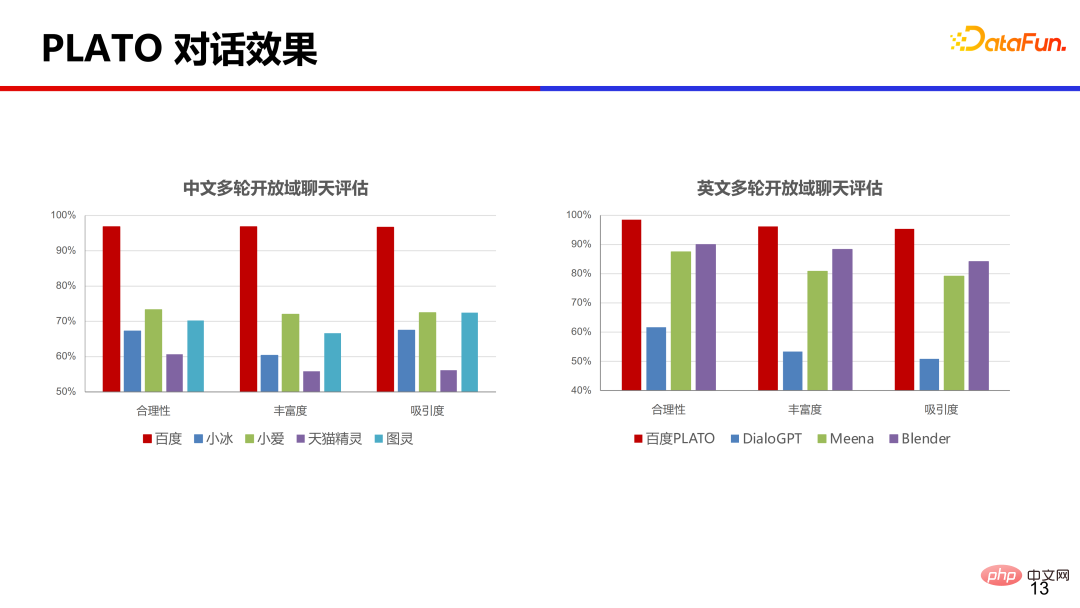

En chinois et en anglais, plusieurs produits commerciaux courants ont été comparés respectivement Du point de vue de la rationalité, de la richesse et de l'attractivité, l'effet de PLATO est loin devant.

Le compte public WeChat "Baidu PLATO" est connecté au modèle PLATO-XL, et tout le monde peut l'essayer et en faire l'expérience.

PLATO Le nombre de paramètres du modèle varie de 100 millions à un milliard puis à des dizaines de milliards. En fait, lorsqu'il atteint les milliards d'échelles, le dialogue est relativement fluide et fluide. atteint des dizaines de milliards d'échelles, les capacités logiques du modèle se sont considérablement améliorées.

6. Problème d'abus de connaissances

Les grands modèles ont tous le problème de l'abus de connaissances. Comment le résoudre ? Comment nous, les humains, résolvons-nous des problèmes que nous ne comprenons pas ? Peut-être pouvez-vous le vérifier sur un moteur de recherche. Cette méthode de recherche de connaissances externes peut-elle être utilisée dans le modèle ?

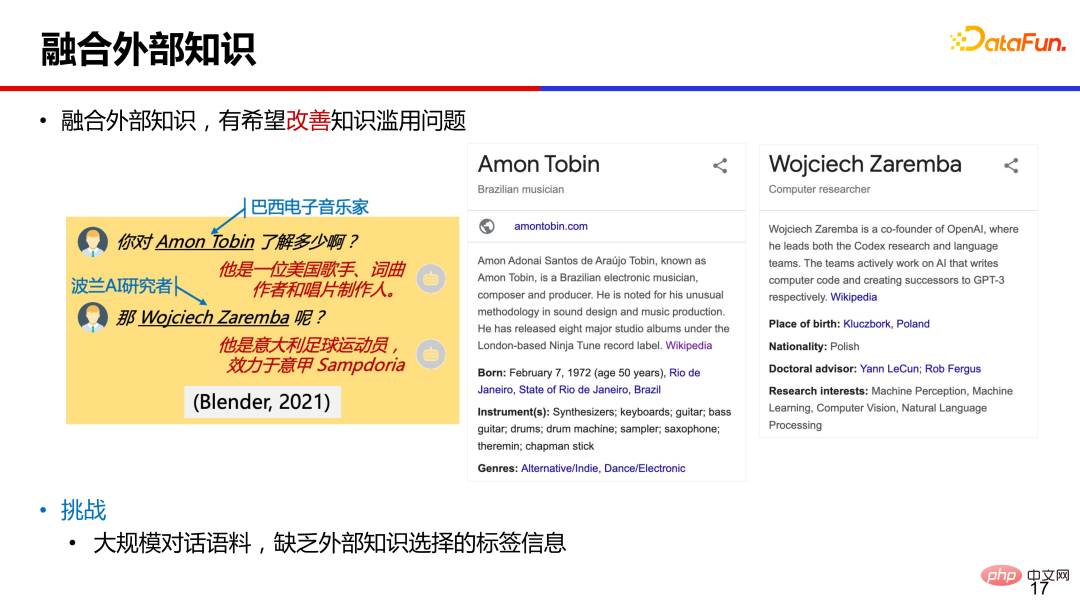

L'intégration de connaissances externes pour aider à la génération de réponses est une direction prometteuse pour atténuer l'abus de connaissances. Cependant, pour les matériaux de dialogue à grande échelle, seuls le texte du dialogue et les informations de réponse existent, et il est impossible de connaître la relation correspondante entre un certain corpus et les connaissances externes, c'est-à-dire qu'il y a un manque d'informations sur les étiquettes pour la sélection des connaissances.

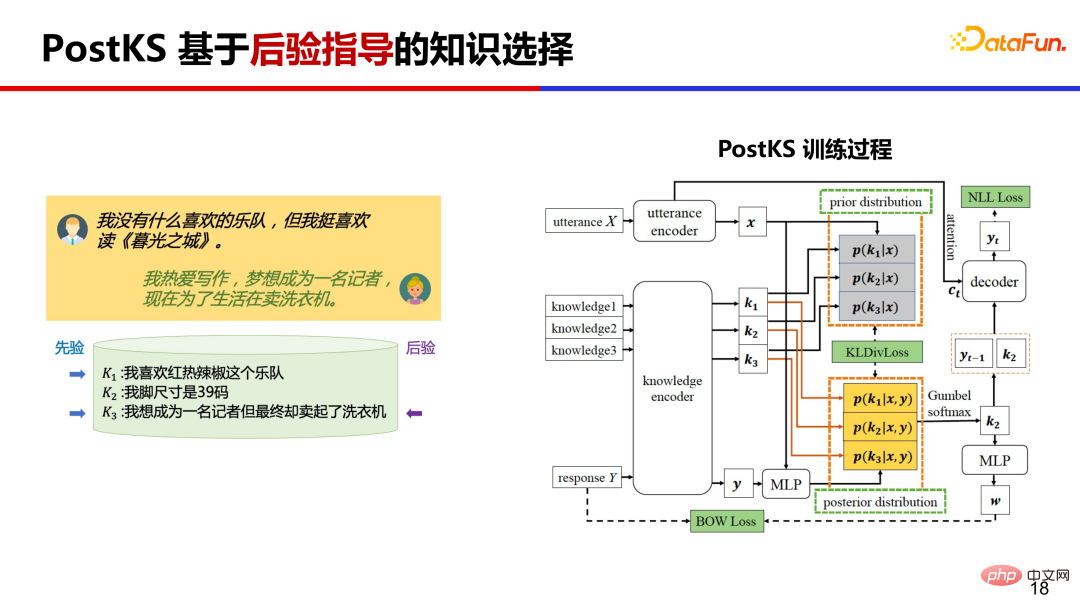

7. Sélection des connaissances PostKS basée sur un guidage postérieur

PostKS est l'un des ouvrages représentatifs dans le domaine du dialogue des connaissances. Il propose une sélection des connaissances basée sur un guidage postérieur. Laissez la distribution des connaissances antérieures se rapprocher de la distribution des connaissances postérieures.

Pendant la phase d'inférence, puisqu'il n'y a pas d'informations postérieures, le modèle doit utiliser des connaissances préalables pour la génération de réponses. Il y aura des incohérences entre les étapes de formation et d'inférence. La formation est basée sur des données postérieures, mais l'inférence ne peut être basée que sur des données antérieures.

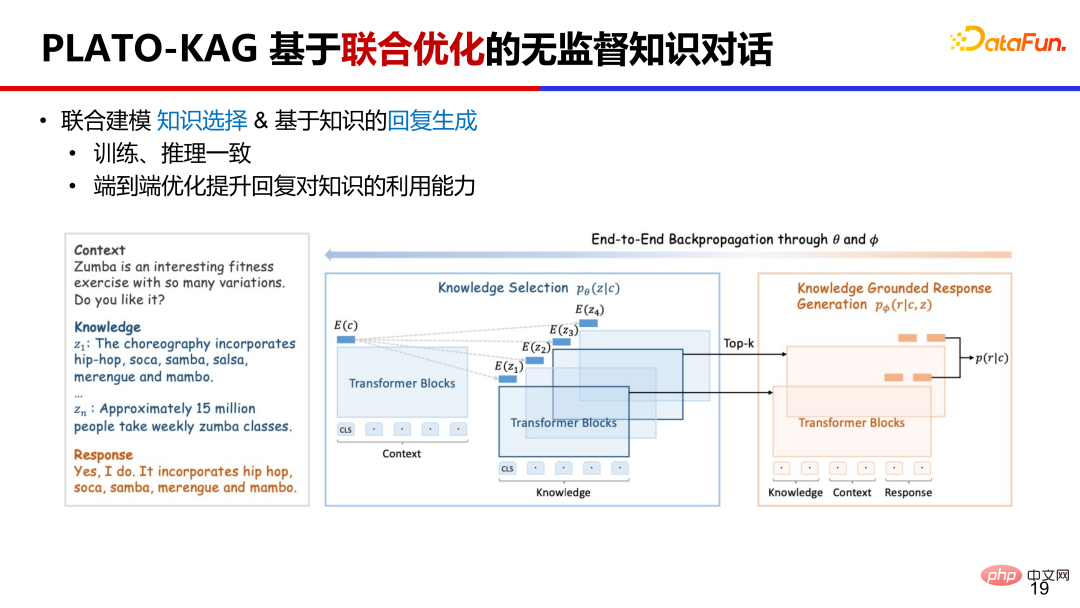

8. Dialogue de connaissances non supervisé PLATO-KAG basé sur une optimisation conjointe

Le modèle non supervisé PLATO-KAG modélise conjointement la sélection des connaissances et la génération de réponses. Les connaissances les plus importantes sont sélectionnées a priori et envoyées au modèle génératif pour une formation conjointe de bout en bout. Si les connaissances sont sélectionnées avec précision, elles seront très utiles pour générer la réponse cible, et la probabilité de génération sera relativement élevée. L'optimisation conjointe encouragera cette sélection et utilisera les connaissances données, si les connaissances sont mal sélectionnées ; n'ont aucun effet sur la génération de la réponse cible et la probabilité de génération sera relativement élevée, l'optimisation conjointe supprime ce choix et ignore les connaissances données. Cela optimise à la fois la sélection des connaissances et la génération de réponses.

9. PLATO Dialogue complet sur l'amélioration des connaissances

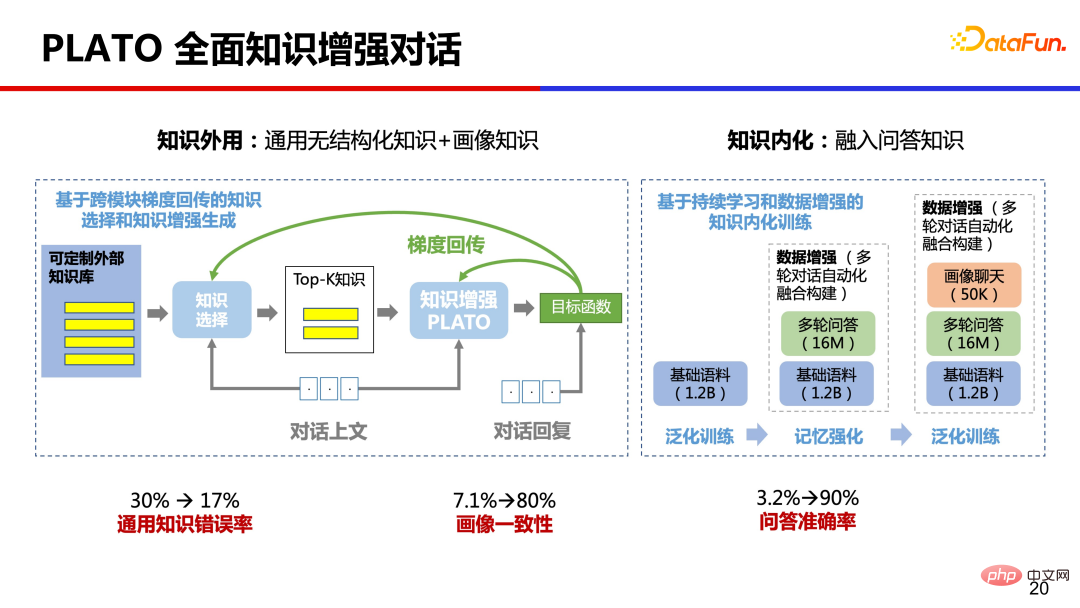

Du point de vue de l'expérience d'apprentissage humain, nous mémorisons également beaucoup de connaissances dans notre cerveau. et en même temps Réalisé une application externe des connaissances et une internalisation des connaissances. D'une part, il utilise des connaissances générales externes non structurées et des connaissances sur les portraits, et d'autre part, il internalise également une grande quantité de connaissances sur les questions et réponses dans les paramètres du modèle grâce à la pré-formation. Après une telle amélioration complète des connaissances, le taux d'erreur des connaissances générales sur les dialogues a été réduit de 30 % à 17 %, la cohérence des portraits a été augmentée de 7,1 % à 80 % et la précision des questions et réponses a été augmentée de 3,2 %. à 90%. L'amélioration est très évidente.

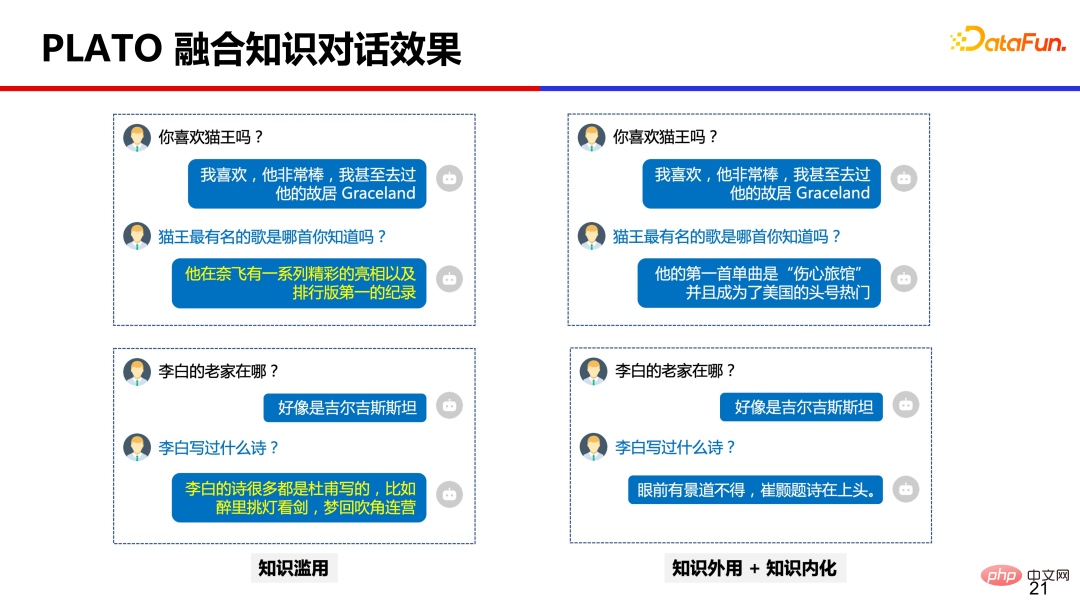

L'image ci-dessous est une comparaison des effets après une amélioration complète des connaissances.

Il convient de noter que bien que l'effet ait été considérablement amélioré, le problème de l'abus des connaissances n'a pas été complètement résolu, mais seulement atténué. Même si l’échelle du modèle est étendue à des centaines de milliards de paramètres, le problème de l’abus des connaissances existe toujours.

Il y a encore plusieurs points qui méritent nos efforts continus : Le premier est le moment de déclenchement des connaissances externes, c'est-à-dire quand vérifier les connaissances externes et quand utiliser les connaissances intériorisées, ce qui affectera la fluidité et l'attraction des le dialogue Dépenser. Le deuxième est la précision de la sélection des connaissances, qui implique une technologie de récupération. Le corpus de connaissances chinois est construit à l'échelle de milliards. Il n'est pas si simple de récupérer avec précision les connaissances appropriées à travers une conversation donnée. Le troisième est la rationalité et la fidélité de l’utilisation des connaissances. Parfois, le modèle ne peut pas comprendre avec précision les connaissances ou confondre et rassembler des réponses inexactes.

3. Mise en œuvre, défis et perspectives des modèles de dialogue à grande échelle

Ce qui précède présente certaines technologies du dialogue PLATO, telles que l'introduction de modèles à grande échelle, l'ajout de variables latentes discrètes pour améliorer le dialogue L'introduction non supervisée de connaissances externes atténue l'abus de connaissances, etc. Alors, quelles sont les applications pratiques dans la production réelle ?

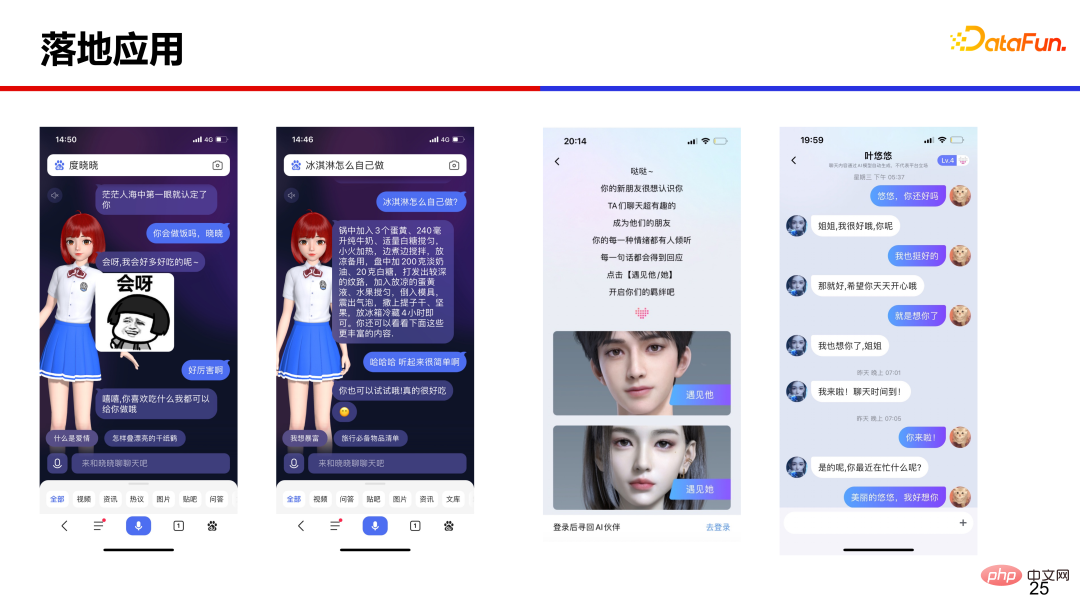

1. L'application Landed

PLATO fournit des fonctionnalités de chat de domaine ouvert dans plusieurs scénarios tels que des haut-parleurs intelligents, des personnes virtuelles et des discussions communautaires.

Sur la gauche se trouve l'humain numérique Du Xiaoxiao. Recherchez Du Xiaoxiao sur l'application Baidu ou entrez directement « Bonjour » pour appeler l'humain numérique. Le chat peut faciliter le processus de recherche et obtenir des réponses et des informations efficacement. Sur la droite se trouve une personne virtuelle utilisant la méthode de saisie Baidu, qui est à la fois belle et douée pour discuter.

2. Défis rencontrés dans les applications d'atterrissage

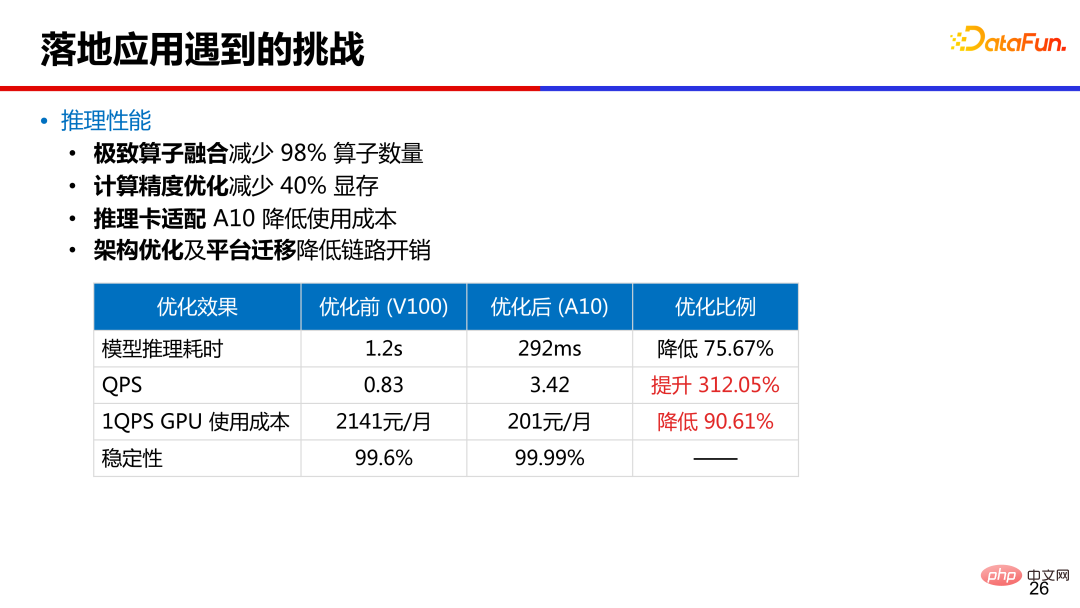

Dans les applications d'atterrissage, Le premier défi est la performance d'inférence Les données de performance de 1,6 milliard de paramètres PLATO sont répertoriées dans la figure. Le nombre d'opérateurs a été réduit de 98 % grâce à la fusion des opérateurs et le temps d'inférence du modèle a été réduit de 1,2 s sur la v100 d'origine à moins de 300 ms sur la carte A10. Grâce à l'optimisation de la précision des calculs, 40 % de la mémoire vidéo est réduite. La carte d'inférence passe de v100 à A10 pour réduire les coûts. En même temps, l'optimisation de l'architecture et la migration de la plate-forme sont effectuées pour réduire la surcharge de liaison.

Le deuxième défi est la sécurité des conversations . Par exemple, les discours préjudiciables, la sensibilité politique, la discrimination régionale, la vie privée et bien d’autres aspects nécessitent une grande attention. PLATO nettoie en profondeur le corpus, supprime les échantillons dangereux et utilise un modèle discriminant sûr pour supprimer les réponses des candidats dangereux après le déploiement. Dans le même temps, la table de mots clés est maintenue et une formation contradictoire est ajoutée pour détecter et combler les lacunes afin d'améliorer la sécurité.

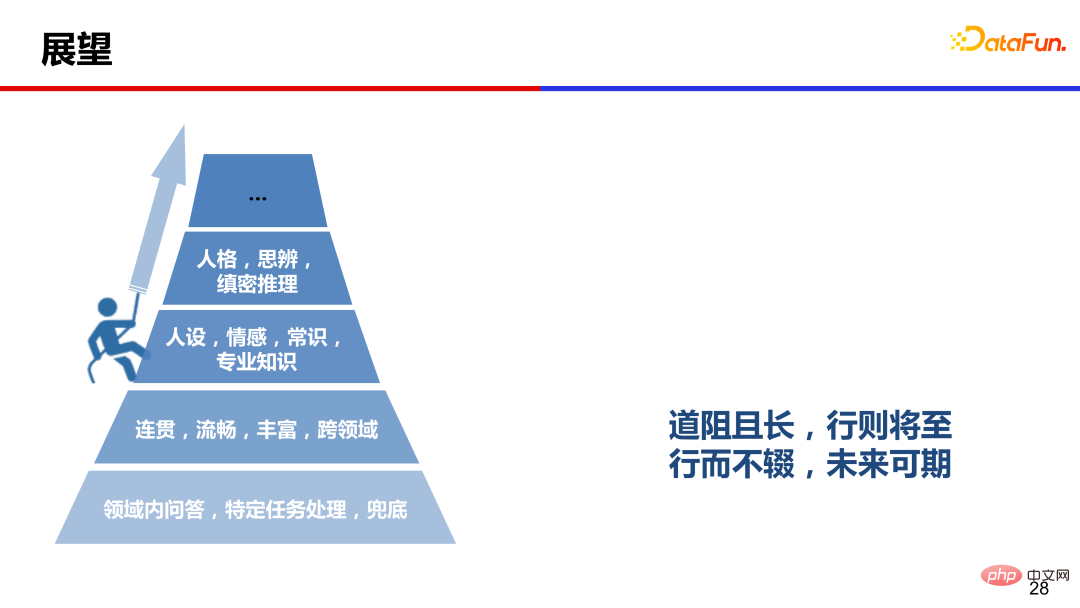

3. Outlook

Dans le passé, les gens pensaient que le chat de domaine ouvert était une fonction secrète. Avec le développement de grands modèles ces dernières années, des progrès significatifs ont été réalisés dans le domaine. dialogue. Le modèle actuel peut générer un dialogue cohérent, fluide, riche et interdomaine, mais il reste encore beaucoup à améliorer sur des aspects tels que l'émotion, le caractère, la personnalité et la réflexion.

La route est longue et pleine d'obstacles, mais elle arrive bientôt Si vous continuez, vous pouvez regarder vers l'avenir. J'espère également que les collègues dans le domaine du dialogue pourront travailler ensemble pour atteindre le sommet du dialogue homme-machine.

4. Citation

5. Séance de questions-réponses

Q : Comment l'efficacité du dialogue est-elle évaluée ?

A : Actuellement, il n'y a pas d'indicateurs automatiques dans le système de dialogue qui soient cohérents avec l'évaluation manuelle, et l'évaluation manuelle reste la référence. Pendant la phase de développement, vous pouvez itérer en référence à la perplexité. Lors de l'évaluation finale complète, vous devez toujours demander à un grand nombre de crowdsourcers d'interagir avec différentes machines et d'effectuer une évaluation manuelle sur certains indicateurs. Les indicateurs d'évaluation changent également avec le développement de la technologie. Par exemple, lorsque la maîtrise n'est plus un problème, des indicateurs tels que la sécurité et l'exactitude des connaissances peuvent être ajoutés pour évaluer des capacités plus avancées.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI