Maison >Périphériques technologiques >IA >Quel est l'état de développement de l'apprentissage en contexte, qui a été lancé par GPT ? Cet examen montre clairement

Quel est l'état de développement de l'apprentissage en contexte, qui a été lancé par GPT ? Cet examen montre clairement

- PHPzavant

- 2023-04-11 17:10:031030parcourir

À mesure que la taille des modèles linguistiques et des corpus augmente progressivement, les grands modèles linguistiques (LLM) montrent plus de potentiel. Certaines études récentes ont montré que le LLM peut utiliser l'apprentissage en contexte (ICL) pour effectuer une série de tâches complexes, telles que la résolution de problèmes de raisonnement mathématique.

Dix chercheurs de l'Université de Pékin, du Shanghai AI Lab et de l'Université de Californie à Santa Barbara ont récemment publié un article de synthèse sur l'apprentissage en contexte, détaillant les progrès actuels de la recherche ICL.

Adresse papier : https://arxiv.org/pdf/2301.00234v1.pdf

L'idée centrale de l'apprentissage en contexte est l'apprentissage par analogie. le modèle de langage utilise ICL. Prendre des décisions.

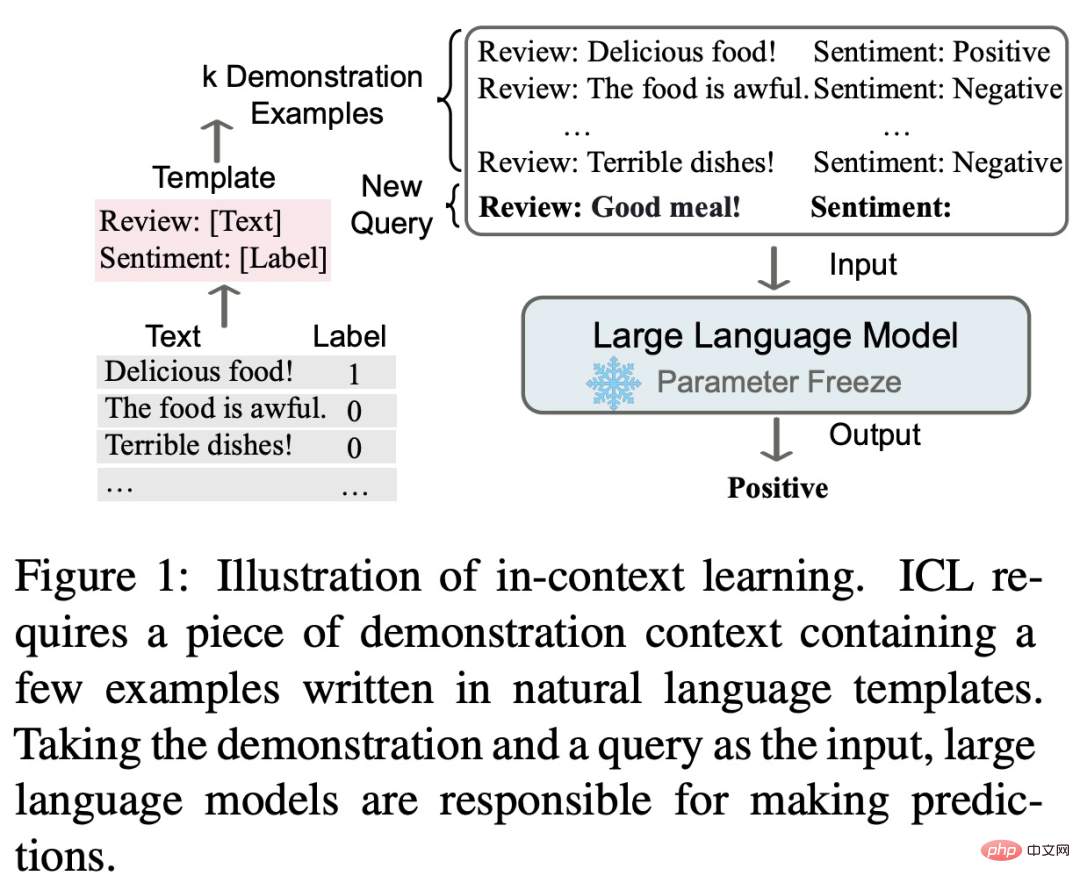

Tout d'abord, ICL nécessite certains échantillons pour former le contexte de démonstration, et ces exemples sont généralement écrits dans des modèles en langage naturel. ICL associe ensuite la question de requête au contexte de présentation pour former une invite et l'intègre dans un modèle de langage à des fins de prédiction. Contrairement à la phase de formation de l'apprentissage supervisé, qui nécessite la mise à jour des paramètres du modèle à l'aide de gradients inverses, ICL ne nécessite pas de mise à jour des paramètres pour permettre au modèle de langage pré-entraîné d'effectuer directement des tâches de prédiction, et le modèle est censé apprendre les modèles cachés dans la démonstration. exemples et prendre des décisions en conséquence.

En tant que nouveau paradigme, l'ICL présente de nombreux avantages intéressants. Premièrement, les exemples de démonstration sont écrits dans un format de langage naturel, qui fournit une interface interprétable pour se connecter à de grands modèles de langage. Ce paradigme facilite l'intégration des connaissances humaines dans les modèles de langage en modifiant les exemples et les modèles de démonstration (Liu et al., 2022 ; Lu et al., 2022 ; Wu et al., 2022 ; Wei et al., 2022c). Deuxièmement, l’apprentissage en contexte est similaire au processus de prise de décision de l’apprentissage humain par analogie. Troisièmement, comparé à la formation supervisée, l’ICL est un cadre d’apprentissage sans formation. Cela peut non seulement réduire considérablement le coût de calcul lié à l'adaptation du modèle à de nouvelles tâches, mais également rendre le modèle de langage en tant que service (LMaaS, Sun et al., 2022) possible et facilement appliqué à des tâches du monde réel à grande échelle.

Bien qu'ICL soit très prometteuse, de nombreuses questions méritent encore d'être explorées, notamment ses performances. Par exemple, le modèle GPT-3 original possède certaines capacités ICL, mais certaines études ont montré que cette capacité peut être considérablement améliorée grâce à une adaptation lors de la pré-formation. De plus, les performances d'ICL sont sensibles à des paramètres spécifiques, notamment les modèles d'invite, la sélection contextuelle des échantillons et le classement des échantillons. De plus, bien que le mécanisme de fonctionnement de l’ICL semble raisonnable, il n’est toujours pas assez clair et peu d’études peuvent expliquer de manière préliminaire son mécanisme de fonctionnement.

Cet article de synthèse conclut que la solide performance d'ICL repose sur deux étapes :

- L'étape de formation pour cultiver les capacités ICL des grands modèles de langage

- Le grand modèle de langage prédit en fonction d'une tâche spécifique ; étape de raisonnement des démonstrations.

Dans la phase de formation, le modèle de langage est formé directement en fonction des objectifs de modélisation du langage, tels que la génération de gauche à droite. Bien que ces modèles ne soient pas spécifiquement optimisés pour l'apprentissage en contexte, les capacités d'ICL restent surprenantes. Les recherches ICL existantes sont essentiellement basées sur des modèles linguistiques bien entraînés.

Dans la phase d'inférence, puisque les étiquettes d'entrée et de sortie sont représentées par des modèles interprétables en langage naturel, les performances ICL peuvent être optimisées sous plusieurs perspectives. Ce document de synthèse fournit une description détaillée et une comparaison, sélectionne des exemples appropriés pour la démonstration et conçoit des méthodes de notation spécifiques pour différentes tâches.

Le contenu général et la structure de cet article de synthèse sont présentés dans la figure ci-dessous, comprenant : la définition formelle de l'ICL (§3), la méthode d'échauffement (§4), la stratégie de conception rapide (§5) et la fonction de notation ( §6) .

De plus, le §7 donne un aperçu de la quête actuelle visant à découvrir le fonctionnement des ICL. Le §8 fournit en outre des évaluations et des ressources utiles pour l'ICL, et le §9 présente des scénarios d'application potentiels qui démontrent l'efficacité de l'ICL. Enfin, le §10 résume les défis existants et les orientations potentielles dans le domaine ICL afin de fournir une référence pour le développement ultérieur du domaine.

Les lecteurs intéressés peuvent lire le texte original de l'article pour en savoir plus sur les détails de la recherche.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI