Maison >Périphériques technologiques >IA >alerte! La crise de consommation d'énergie provoquée par l'explosion de ChatGPT pose d'énormes défis aux opérateurs de centres de données

alerte! La crise de consommation d'énergie provoquée par l'explosion de ChatGPT pose d'énormes défis aux opérateurs de centres de données

- 王林avant

- 2023-04-11 15:58:031735parcourir

Récemment, ChatGPT, un outil de chat intelligent appartenant à la société américaine OpenAI, a pris d'assaut les médias sociaux, attirant plus de 10 milliards de dollars d'investissement et suscitant un énorme engouement pour les applications d'intelligence artificielle sur le marché des capitaux. sous les projecteurs pendant un moment.

Microsoft a été le premier à annoncer un investissement de 10 milliards de dollars dans OpenAI, puis Amazon et la version américaine de "Today's Toutiao" BuzzFeed ont annoncé qu'ils activeraient ChatGPT dans leur travail quotidien. Baidu a également annoncé qu'il lancerait la « version chinoise » de ChatGPT en mars. Après que de nombreuses entreprises technologiques aient jeté de l’huile sur le feu, ChatGPT a immédiatement attiré l’attention du monde entier.

Les données montrent que le nombre de robots déployés par Amazon augmente rapidement, l'augmentation quotidienne atteignant environ 1 000. En outre, la société mère de Facebook, Meta, prévoit également d'investir entre 4 et 5 milliards de dollars supplémentaires dans les centres de données en 2023, la totalité de cette somme devant être utilisée pour l'intelligence artificielle. Le PDG d'IBM, Krishna, a déclaré que l'intelligence artificielle devrait contribuer à hauteur de 16 000 milliards de dollars à l'économie mondiale d'ici 2030.

Avec la popularité de ChatGPT, les géants pourraient lancer une nouvelle série de batailles acharnées dans le domaine de l'intelligence artificielle en 2023.

Cependant, lorsque ChatGPT-3 prédit le mot suivant, il doit effectuer plusieurs calculs d'inférence, occupant ainsi beaucoup de ressources et consommant plus d'énergie. À mesure que l'infrastructure des centres de données se développe pour prendre en charge la croissance explosive du cloud computing, du streaming vidéo et des réseaux 5G, son architecture GPU et CPU ne peut pas fonctionner efficacement pour répondre aux besoins informatiques imminents, ce qui crée des problèmes énormes pour les opérateurs de centres de données à grande échelle.

La formation GPT3.5 utilise le système informatique d'IA spécialement conçu par Microsoft, un cluster réseau hautes performances composé de 10 000 GPU V100, avec une consommation totale de puissance de calcul d'environ 3 640 jours-PF (c'est-à-dire si un quadrillion est calculé par deuxième fois, 3640 jours doivent être calculés). Une tâche de formation de cluster GPU d'une telle envergure et à long terme impose des exigences extrêmes en termes de performances, de fiabilité, de coût et d'autres aspects de la base d'interconnexion réseau.

Par exemple, Meta a annoncé qu'elle suspendrait l'expansion des centres de données dans le monde et reconfigurerait ces fermes de serveurs pour répondre aux besoins de traitement des données de l'intelligence artificielle.

Les besoins en traitement des données des plates-formes d'intelligence artificielle sont énormes. Les créateurs OpenAI de ChatGPT ont lancé la plate-forme en novembre de l'année dernière. Elle ne pourra pas continuer à fonctionner sans la prochaine mise à niveau de la plate-forme cloud Azure de Microsoft.

L'infrastructure du centre de données qui soutient cette transformation numérique sera organisée comme le cerveau humain en deux hémisphères ou lobes, un lobe devant être beaucoup plus puissant que l'autre. Un hémisphère servira à ce qu'on appelle la « formation », la puissance de calcul nécessaire pour traiter jusqu'à 300 milliards de points de données afin de créer la salade de mots générée par ChatGPT.

La formation des lobes nécessite une puissance de calcul puissante et des semi-conducteurs GPU de pointe, mais dans les clusters de centres de données prenant en charge les services de cloud computing et les réseaux 5G, peu de connectivité est actuellement requise.

Dans le même temps, l'infrastructure axée sur la « formation » de chaque plate-forme d'IA créera d'énormes demandes d'énergie, exigeant que les centres de données soient situés à proximité de gigawatts d'énergie renouvelable, que de nouveaux systèmes de refroidissement liquide soient installés et repensés. systèmes d'alimentation de secours et de générateur, ainsi que d'autres nouvelles fonctionnalités de conception.

Plateformes d'intelligence artificielle L'autre hémisphère du cerveau, une infrastructure numérique plus performante connue sous le nom de mode « inférence », prend en charge des plates-formes « génératives » interactives qui, quelques secondes après la saisie d'une question ou d'une instruction, les requêtes sont traitées dans la base de données modélisée. et a répondu avec une syntaxe humaine convaincante.

Alors que les réseaux de centres de données hyper-connectés d'aujourd'hui, comme le plus grand cluster de centres de données en Amérique du Nord, les « centres de données » de Virginie du Nord disposent également des réseaux de fibre optique les plus étendus pour répondre aux besoins de connectivité de niveau supérieur de « l'inférence » du cerveau de l'IA. " part, mais ces installations devront également être modernisées pour répondre à l'énorme capacité de traitement requise, et elles devront être plus proches des sous-stations.

De plus, les données des instituts de recherche montrent que les centres de données sont devenus les plus grands consommateurs d'énergie au monde et que leur proportion dans la consommation totale d'électricité passera de 3 % en 2017 à 4,5 % en 2025. En prenant la Chine comme exemple, la consommation électrique des centres de données opérant dans tout le pays devrait dépasser 400 milliards de kWh en 2030, soit 4 % de la consommation électrique totale du pays.

Par conséquent, même les produits numériques nécessitent de l'énergie pour se développer et consommer, et ChatGPT ne fait pas exception. On estime que le traitement d'inférence dans le travail d'apprentissage automatique représente 80 à 90 % de la consommation d'énergie de calcul, depuis le lancement de ChatGPT en novembre 2022. Depuis la mise en ligne le 30, les émissions de carbone ont dépassé 814,61 tonnes.

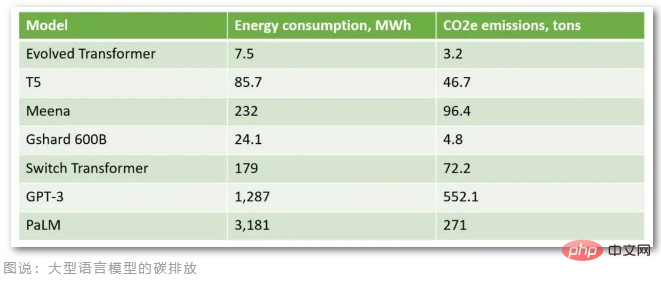

Selon les calculs des organisations professionnelles, en supposant que ChatGPT hébergé sur le cloud Azure de Microsoft reçoit 1 million de demandes d'utilisateurs par jour (environ 29 167 heures par jour sous un temps de réponse et un vocabulaire spécifiques), la puissance maximale du GPU A100 est de 407 W. (Watt), les émissions quotidiennes de carbone atteignent 3,82 tonnes et les émissions mensuelles de carbone dépassent 100 tonnes. Aujourd'hui, ChatGPT compte plus de 10 millions d'utilisateurs quotidiens et les émissions de carbone réelles dépassent largement les 100 tonnes par mois. De plus, la formation d'un modèle de langage aussi volumineux contenant 175 milliards de paramètres nécessite des dizaines de milliers de CPU/GPU pour saisir des données 24 heures sur 24, consomme environ 1 287 MWh d'électricité et émet plus de 552 tonnes de dioxyde de carbone.

À en juger par les émissions de carbone de ces grands modèles linguistiques, GPT-3, le prédécesseur de ChatGPT, a les émissions de carbone les plus importantes. On rapporte que les Américains produisent en moyenne 16,4 tonnes d’émissions de carbone chaque année et que les Danois produisent en moyenne 11 tonnes d’émissions de carbone chaque année. En conséquence, le modèle de ChatGPT est formé pour émettre plus d’émissions de carbone que 50 Danois n’en émettent par an.

Les fournisseurs de cloud computing reconnaissent également que les centres de données consomment de grandes quantités d'électricité et ont pris des mesures pour améliorer leur efficacité, comme la construction et l'exploitation de centres de données dans l'Arctique pour tirer parti des énergies renouvelables et des conditions de refroidissement naturelles. Toutefois, cela ne suffit pas pour répondre à la croissance explosive des applications d’IA.

Le laboratoire national Lawrence Berkeley aux États-Unis a découvert dans une recherche que les améliorations de l'efficacité des centres de données ont contrôlé la croissance de la consommation d'énergie au cours des 20 dernières années, mais les recherches montrent que les mesures d'efficacité énergétique actuelles pourraient ne pas suffire pour répondre aux besoins des futurs centres de données. besoins.

Le secteur de l’intelligence artificielle se trouve aujourd’hui à un tournant critique. Les progrès technologiques en matière d'IA générative, de reconnaissance d'images et d'analyse de données révèlent des connexions et des utilisations uniques pour l'apprentissage automatique, mais une solution technologique capable de répondre à ce besoin doit d'abord être construite car, selon Gartner, à moins d'un choix plus durable, sinon d'ici 2025 , l’IA consommera plus d’énergie que les activités humaines.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI