Maison >Périphériques technologiques >IA >OpenAI a officiellement lancé un identifiant de contenu généré par l'IA, mais le taux de réussite n'est que de 26 %. Internautes : ce n'est pas aussi efficace qu'un outil de vérification du plagiat sur papier.

OpenAI a officiellement lancé un identifiant de contenu généré par l'IA, mais le taux de réussite n'est que de 26 %. Internautes : ce n'est pas aussi efficace qu'un outil de vérification du plagiat sur papier.

- PHPzavant

- 2023-04-11 15:19:031299parcourir

Beaucoup de gens ont peut-être oublié que ChatGPT a été officiellement lancé fin novembre de l'année dernière, et cela ne fait que deux mois maintenant. Cependant, l'engouement qu'il a déclenché a poussé les entreprises technologiques à emboîter le pas, a donné naissance à des startups licornes, et aussi. fait des universitaires La communauté a modifié les exigences d'acceptation des papiers.

Après que ChatGPT ait déclenché une grande discussion dans le domaine de l'IA sur « l'opportunité de l'interdire », l'outil d'identification d'authenticité d'OpenAI est enfin là.

Le 31 janvier, OpenAI a officiellement annoncé le lancement d'un outil de reconnaissance permettant de distinguer les œuvres humaines des textes générés par l'IA. Cette technologie est conçue pour identifier le contenu généré par ses propres modèles ChatGPT, GPT-3 et autres. Cependant, la précision du classificateur semble actuellement préoccupante : OpenAI a souligné dans le blog que le taux de précision de haute confiance de l'identification de l'IA est d'environ 26 %. Mais l’agence estime que lorsqu’elle est utilisée conjointement avec d’autres méthodes, elle peut contribuer à empêcher une utilisation abusive des générateurs de texte IA.

「Le but du classificateur proposé est d'aider à réduire la confusion causée par le texte généré par l'intelligence artificielle. Cependant, il présente encore certaines limites, il devrait donc être utilisé en complément d'autres méthodes de détermination de la source du texte, plutôt que de le faire. comme principal outil de prise de décision", a déclaré un porte-parole d'OpenAI aux médias par courrier électronique. "Nous recevons des retours sur l'utilité de ces outils avec ce classificateur initial et espérons partager des méthodes améliorées à l'avenir."

Récemment, le domaine technologique se développe avec enthousiasme autour de l'IA générative, en particulier de l'IA de génération de texte Amid. Face aux préoccupations croissantes concernant les abus, les critiques ont appelé les créateurs de ces outils à prendre des mesures pour atténuer leurs effets potentiellement nocifs.

Face à la quantité massive de contenu généré par l'IA, certaines industries ont immédiatement imposé des restrictions. Certains des plus grands districts scolaires des États-Unis ont interdit l'utilisation de ChatGPT sur leurs réseaux et appareils, craignant que cela n'affecte l'apprentissage des élèves. et l'exactitude du contenu généré par l'outil. Des sites Web, notamment Stack Overflow, ont également interdit aux utilisateurs de partager du contenu généré par ChatGPT, affirmant que l'intelligence artificielle inonderait les utilisateurs de contenu inutile dans les discussions normales.

Ces situations mettent en évidence la nécessité d'outils de reconnaissance de l'IA. Bien que l'effet ne soit pas satisfaisant, l'OpenAI AI Text Classifier réalise une analyse comparative architecturale avec la série GPT. Comme ChatGPT, il s'agit d'un modèle de langage qui s'entraîne sur de nombreux exemples de textes publics provenant du Web. Contrairement à ChatGPT, il est affiné pour prédire la probabilité qu'un morceau de texte soit généré par l'IA, pas seulement à partir de ChatGPT, mais à partir de n'importe quel modèle d'IA générateur de texte.

Plus précisément, OpenAI a formé son classificateur de texte IA sur le texte de 34 systèmes de génération de texte dans cinq organisations différentes, y compris OpenAI lui-même. Ceux-ci ont été associés à du texte artificiel similaire (mais pas identique) de Wikipédia, à des sites Web extraits de liens partagés sur Reddit et à un ensemble de « démos humaines » collectées pour le système de génération de texte OpenAI.

Il est à noter que le classificateur de texte OpenAI ne convient pas à tous les types de texte. Le contenu à détecter doit comporter au moins 1 000 caractères, soit environ 150 à 250 mots. Il n’a pas les capacités de vérification du plagiat des plates-formes de détection sur papier – une limitation très inconfortable étant donné qu’il a été démontré que l’IA génératrice de texte copie les « réponses correctes » des ensembles de formation. OpenAI a déclaré qu'en raison de son ensemble de données en anglais, il était plus susceptible de commettre des erreurs sur des textes écrits par des enfants ou dans des langues autres que l'anglais.

Lors de l'évaluation si un morceau de texte donné a été généré par l'IA, le détecteur ne donne pas de réponse positive par oui ou par non. En fonction de son niveau de confiance, il marquera le texte comme « très peu probable » qu'il soit généré par l'IA (probabilité inférieure à 10 %), « peu probable » qu'il soit généré par l'IA (entre 10 % et 45 % de probabilité), « On ne sait pas si c'était "généré par l'IA (45 % à 90 % de chance), "peut-être" généré par l'IA (90 % à 98 % de chance) ou "très probablement" généré par l'IA (plus de 98 % de chance).

Cela ressemble beaucoup à l'IA de reconnaissance d'image, à l'exception de la précision. Selon OpenAI, les classificateurs étiquetent à tort le texte écrit par des humains comme du texte écrit par l’IA dans 9 % des cas.

Après quelques essais, l'effet n'est en effet pas très bon

OpenAI affirme que le taux de réussite de son classificateur de texte AI est d'environ 26 %. Après que certains internautes l'aient essayé, ils ont constaté que l'effet de reconnaissance n'était effectivement pas bon.

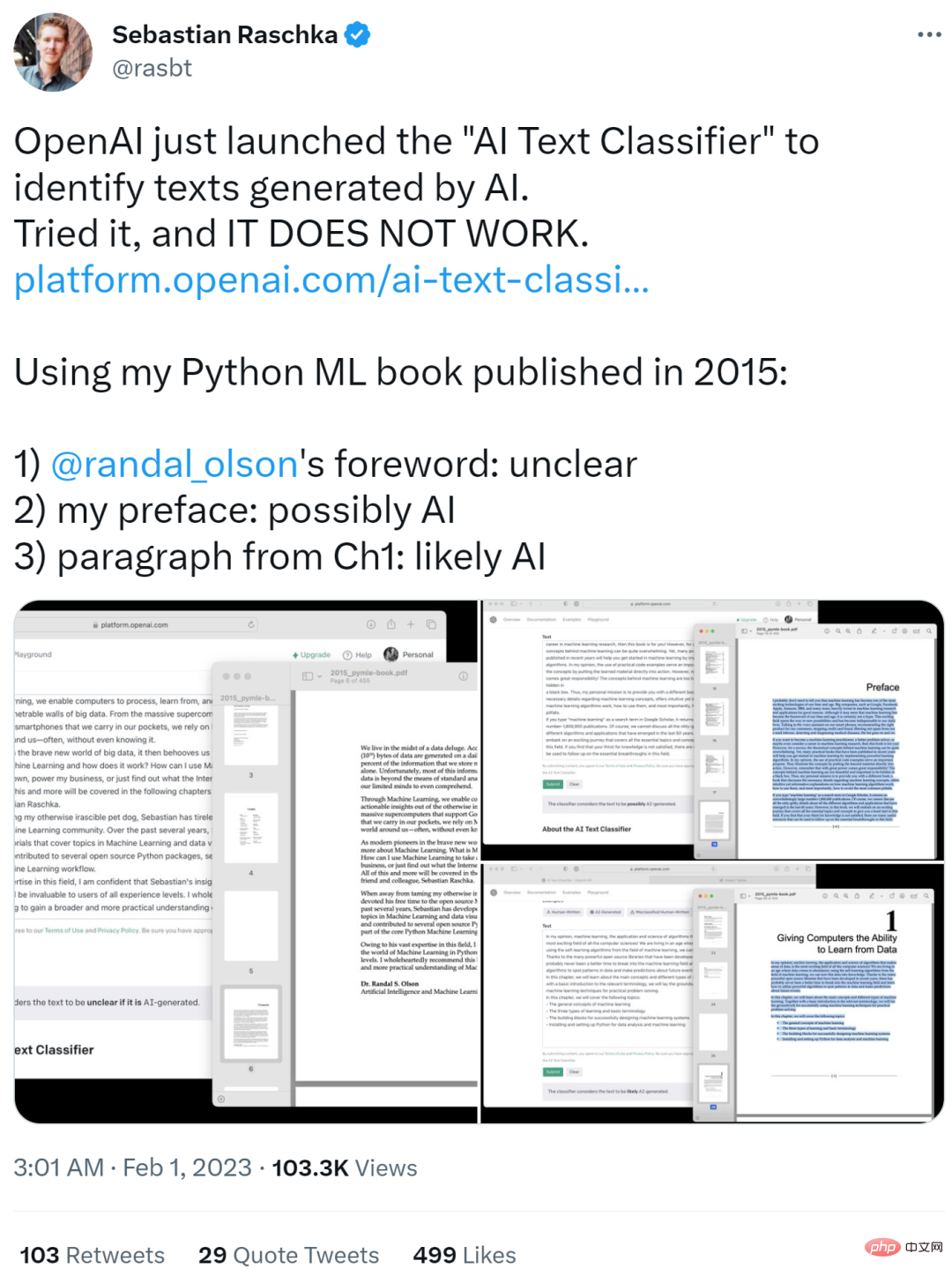

Après l'avoir essayé, Sebastian Raschka, un chercheur bien connu en ML et en IA, a commenté "Ça ne marche pas". Il a utilisé son livre Python ML de l'édition originale de 2015 comme texte d'entrée et les résultats sont présentés ci-dessous.

- La partie avant-propos de Randy Olson a été identifiée comme Pas clair

- Sa propre partie de préface a été identifiée comme peut-être une IA

- La partie paragraphe du premier chapitre a été identifiée comme probablement généré par l'IA (probablement l'IA)

Sebastian Raschka a dit que c'était un exemple intéressant, mais il se sentait déjà désolé pour les étudiants qui pourraient être punis pour des résultats scandaleux en matière de reconnaissance de dissertation. l'avenir.

Il a donc proposé que si vous souhaitez déployer un tel modèle, merci de partager une matrice de confusion. Sinon, si les éducateurs adoptent ce modèle de notation, cela pourrait causer des dommages réels. Il devrait également y avoir une certaine transparence concernant les faux positifs et les faux négatifs.

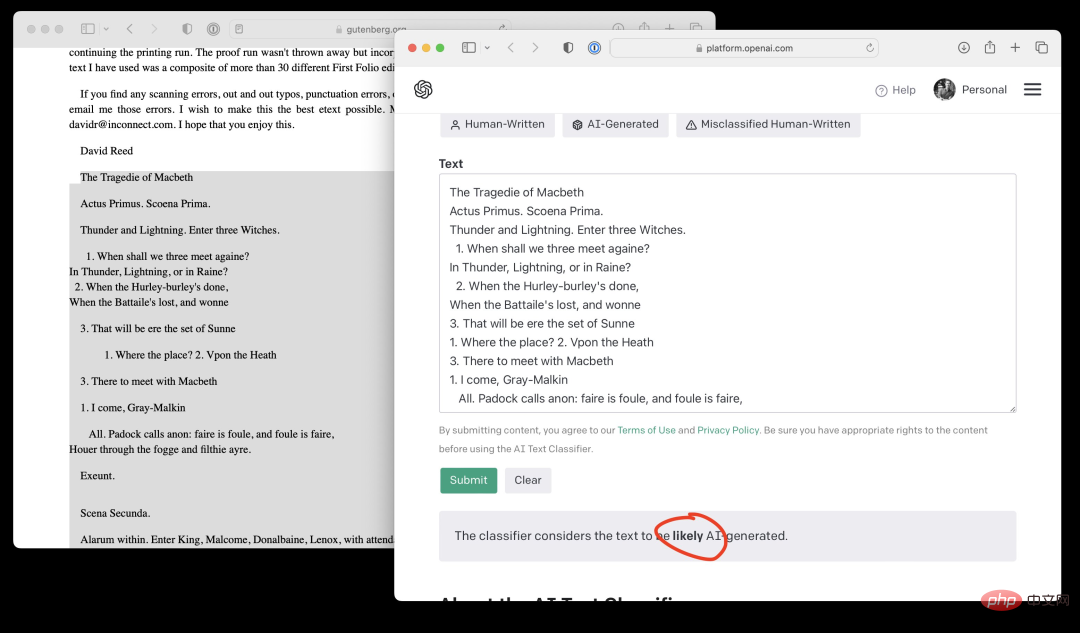

De plus, Sebastian Raschka a saisi le contenu de la première page de "Macbeth" de Shakespeare, et le classificateur de texte OpenAI AI a donné des résultats susceptibles d'être générés par l'IA. Tout simplement scandaleux !

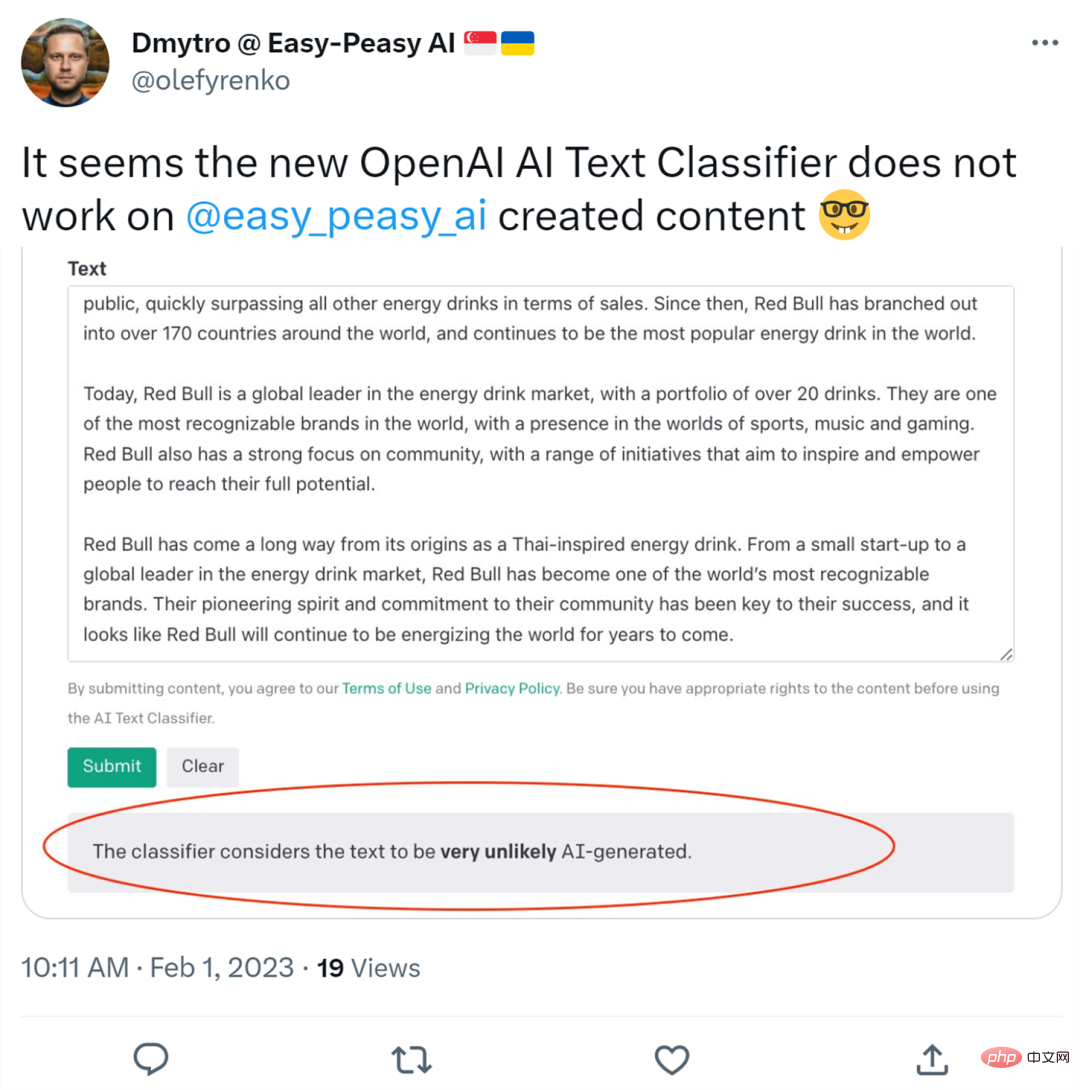

Quelqu'un a également téléchargé du contenu créé par l'outil d'écriture d'IA Easy-Peasy.AI. En conséquence, le classificateur de texte OpenAI AI a déterminé que la possibilité d'être généré par l'IA était très faible.

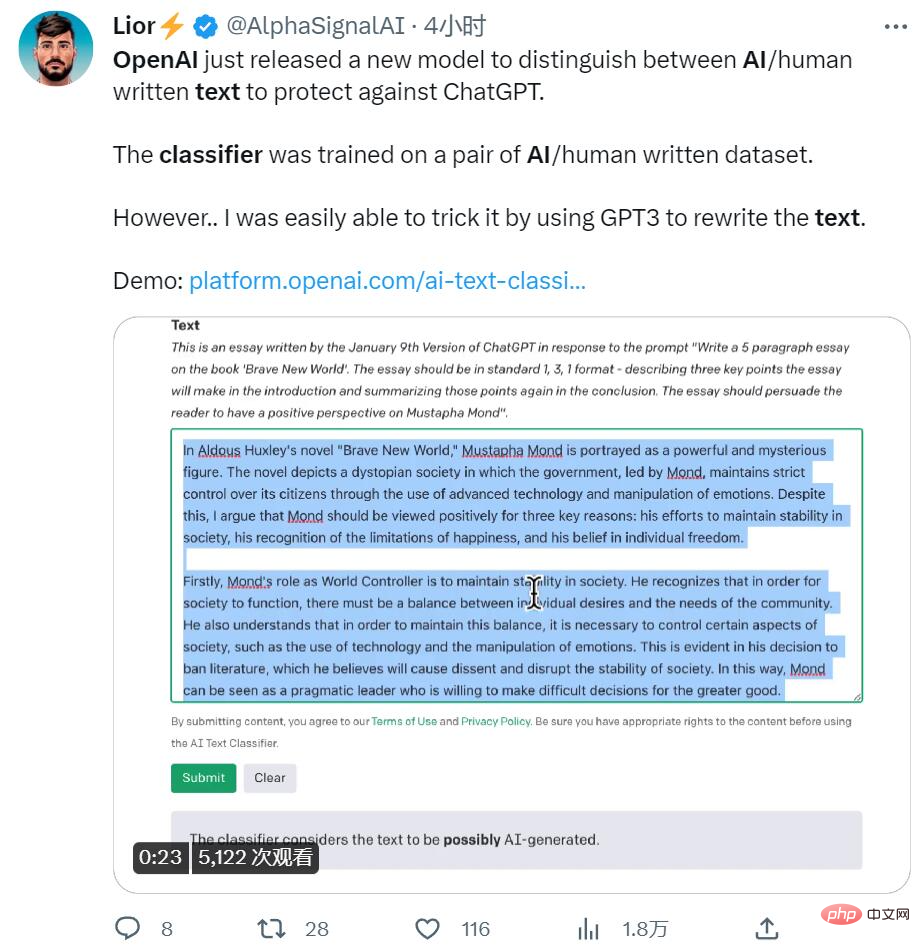

Finalement, quelqu'un a utilisé la méthode de traduction répétée et a laissé GPT3 réécrire le texte, ce qui a également trompé le module de reconnaissance.

Pour résumer, la reconnaissance avant est inexacte, la reconnaissance inverse est fausse et certaines techniques de révision du document ne sont pas visibles. Il semble qu'OpenAI doive encore travailler dur, au moins dans le domaine de la reconnaissance de contenu textuel par l'IA.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI