Maison >Périphériques technologiques >IA >'Technologie de génération d'images' errant à la limite du droit : cet article vous apprend à éviter de devenir 'accusé'

'Technologie de génération d'images' errant à la limite du droit : cet article vous apprend à éviter de devenir 'accusé'

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-11 14:55:031509parcourir

Ces dernières années, le contenu généré par l'IA (AIGC) a attiré beaucoup d'attention. Son contenu couvre des images, du texte, de l'audio, de la vidéo, etc. Cependant, l'AIGC est devenu une arme à double tranchant et a été controversé en raison de son utilisation irresponsable. .

Une fois que la technologie de génération d'images n'est pas utilisée correctement, vous pouvez devenir un "accusé".

Récemment, des chercheurs de Sony AI et Wisdom Source ont discuté des problèmes actuels de l'AIGC sous de nombreux aspects et de la manière de rendre le contenu généré par l'IA plus responsable.

Lien papier : https://arxiv.org/pdf/2303.01325.pdf

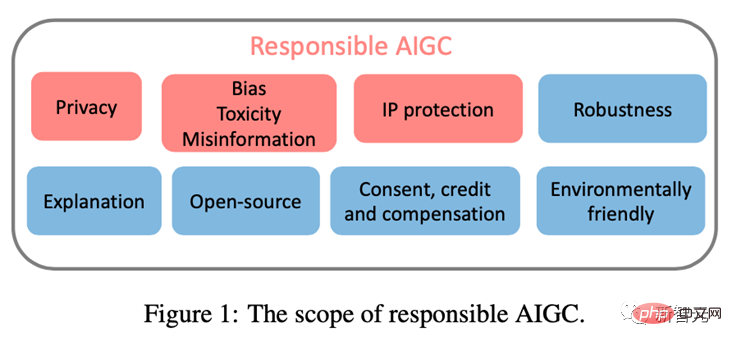

Cet article se concentre sur trois problèmes principaux qui peuvent entraver le développement sain de l'AIGC, notamment : ( 1)Confidentialité ; (2)préjugés, toxicité, désinformation ; (3)Propriété intellectuelle (PI)risques.

En documentant les risques connus et potentiels, ainsi que tout scénario d'abus possible de l'AIGC, cet article vise à attirer l'attention sur les risques potentiels et les abus de l'AIGC et à fournir des orientations pour répondre à ces risques afin de promouvoir l'AIGC. se développe dans une direction plus éthique et plus sûre au profit de la société.

Confidentialité

Il est bien connu que les grands modèles de base présentent une série de problèmes de fuite de confidentialité.

Des recherches antérieures ont montré qu'un intrus peut générer des séquences à partir d'un modèle GPT-2 entraîné et identifier ces séquences mémorisées à partir de l'ensemble d'entraînement, [Kandpal et al., 2022] attribue le succès de ces intrusions dans la vie privée à En raison de la En présence de données répétées dans l'ensemble d'apprentissage, des études ont prouvé que les séquences qui apparaissent plusieurs fois sont plus susceptibles d'être générées que les séquences qui n'apparaissent qu'une seule fois.

Étant donné que le modèle AIGC est formé sur des données explorées sur le Web à grande échelle, les problèmes de surajustement et de fuite de confidentialité deviennent particulièrement importants.

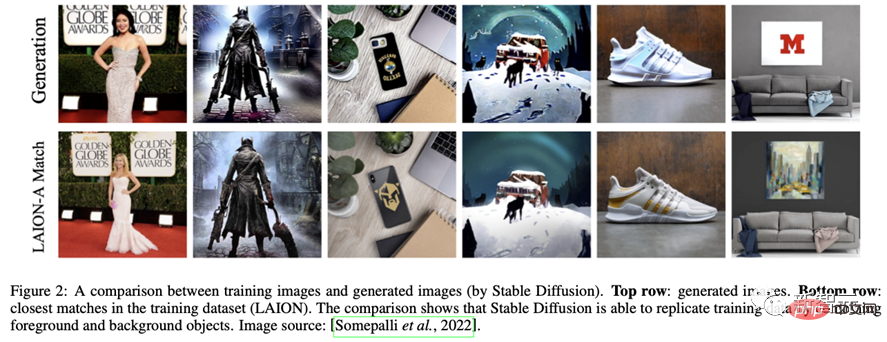

Par exemple, le modèle Stable Diffusion mémorise des images répétées dans les données d'entraînement [Rombach et al., 2022c]. [Somepalli et al., 2022] ont démontré qu'un modèle de diffusion stable copie de manière flagrante les images de ses données d'entraînement et génère des combinaisons simples d'objets de premier plan et d'arrière-plan dans l'ensemble de données d'entraînement.

De plus, le modèle montre la capacité de reconstruire la mémoire, générant ainsi des objets sémantiquement identiques à l'objet d'origine mais ayant des formes de pixels différentes. L’existence de telles images soulève des inquiétudes quant à la mémoire et à la propriété des données.

De même, des recherches récentes montrent que le système Imagen de Google a également des problèmes pour divulguer des photos de personnes réelles et des images protégées par le droit d'auteur. Dans le récent procès de Matthew Butterick [Butterick, 2023], il a souligné que, étant donné que toutes les informations visuelles du système proviennent d'images d'entraînement protégées par le droit d'auteur, les images générées, quelle que soit leur apparence, doivent être l'œuvre de ces images d'entraînement.

De même, DALL·E 2 souffrait d'un problème similaire : il copiait parfois des images de ses données d'entraînement au lieu d'en créer de nouvelles.

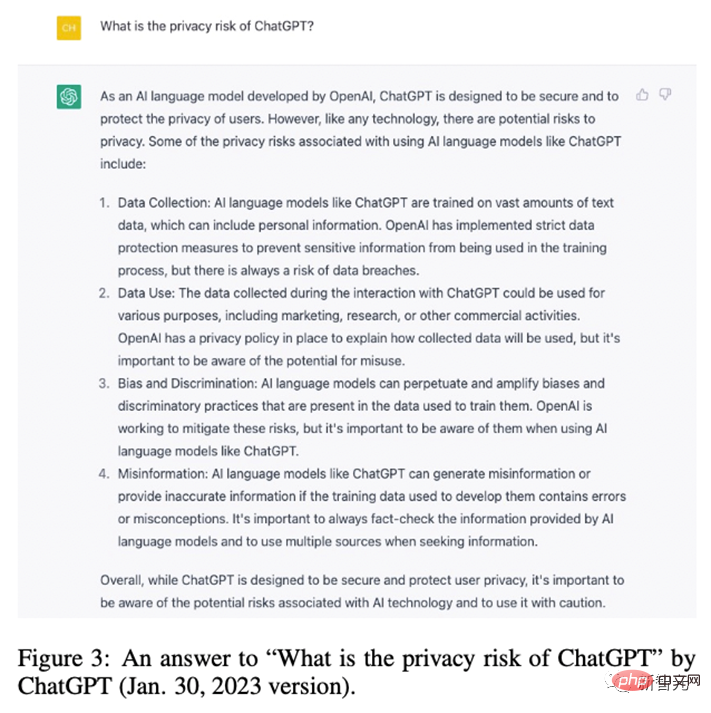

OpenAI a découvert que ce phénomène s'est produit parce que l'image avait été copiée plusieurs fois dans l'ensemble de données. De même, ChatGPT a lui-même admis qu'il présentait un risque de fuite de confidentialité.

Afin d'atténuer le problème de fuite de confidentialité des grands modèles, de nombreuses entreprises et chercheurs ont déployé de nombreux efforts pour défendre la vie privée. Au niveau industriel, Stability AI a reconnu les limites de Stable Diffusion.

A cet effet, ils mettent à disposition un site internet (https://rom1504.github.io/clip-retrieval/) pour identifier les images mémorisées par Stable Diffusion.

De plus, la société d'art Spawning AI a créé un site Web appelé « Have I Been Trained » (https://haveibeentrained.com) pour aider les utilisateurs à déterminer si leurs photos ou œuvres ont été utilisées pour une formation en intelligence artificielle.

OpenAI tente de résoudre les problèmes de confidentialité en réduisant la duplication des données.

De plus, des entreprises telles que Microsoft et Amazon ont interdit aux employés de partager des données sensibles avec ChatGPT pour empêcher les employés de divulguer la confidentialité, car ces informations peuvent être utilisées pour la formation des futures versions de ChatGPT.

Au niveau académique, Somepalli et al. ont étudié un cadre de récupération d'images pour identifier la duplication de contenu, et Dockhorn et al. ont également proposé un modèle de diffusion différentielle de la confidentialité pour garantir la confidentialité du modèle généré.

Biais, toxicité, désinformation

Les données de formation pour le modèle AIGC proviennent du monde réel. Cependant, ces données peuvent par inadvertance renforcer des stéréotypes nuisibles, exclure ou marginaliser certains groupes et contenir des sources de données toxiques, ce qui peut inciter. la haine ou la violence et offenser des individus [Weidinger et al., 2021].

Les modèles formés ou affinés sur ces ensembles de données problématiques peuvent hériter de stéréotypes néfastes, de préjugés sociaux et de toxicité, ou même générer de la désinformation, conduisant à une discrimination injuste et à nuire à certains groupes sociaux.

Par exemple, le modèle Stable Diffusion v1 est principalement formé sur l'ensemble de données LAION-2B, qui ne contient que des images avec des descriptions en anglais. Par conséquent, le modèle est biaisé en faveur des Blancs et des cultures occidentales, et les indices provenant d’autres langues peuvent ne pas être pleinement représentés.

Bien que les versions ultérieures du modèle de diffusion stable aient été affinées sur les versions filtrées de l'ensemble de données LAION, le problème du biais restait. De même, DALLA·E, DALLA·E 2 et Imagen présentent également des préjugés sociaux et des stéréotypes négatifs à l'égard des groupes minoritaires.

De plus, il a été démontré qu'Imagen a des préjugés sociaux et culturels même lorsqu'il génère des images de non-humains. En raison de ces problèmes, Google a décidé de ne pas rendre Imagen accessible au public.

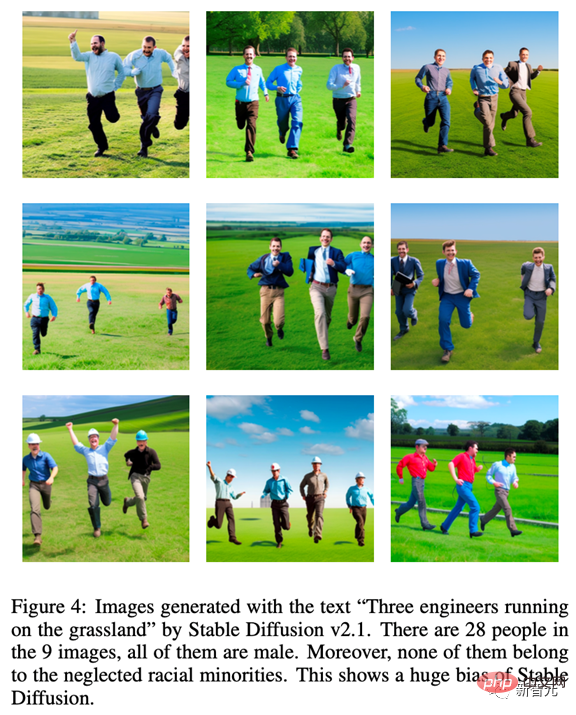

Afin d'illustrer le biais inhérent au modèle AIGC, nous avons testé Stable Diffusion v2.1. Les images générées à l'aide de l'invite « Trois ingénieurs courant dans la prairie » étaient toutes des hommes, et aucun d'entre eux n'appartenait aux négligés. minorité ethnique, ce qui illustre le manque de diversité dans les images générées.

De plus, le modèle AIGC peut également produire des informations erronées. Par exemple, le contenu généré par GPT et ses dérivés peut sembler exact et faisant autorité, mais peut contenir des informations totalement incorrectes.

Par conséquent, il peut fournir des informations trompeuses dans certains domaines (comme l'école, le droit, la médecine, les prévisions météorologiques). Par exemple, dans le domaine médical, les réponses fournies par ChatGPT concernant les dosages médicaux peuvent être inexactes ou incomplètes, ce qui peut mettre la vie en danger. Dans le domaine des transports, si les conducteurs suivent les mauvaises règles de circulation données par ChatGPT, cela peut entraîner des accidents, voire la mort.

De nombreuses défenses ont été mises en place contre les données et modèles problématiques.

OpenAI filtre finement l'ensemble de données de formation d'origine et supprime tout contenu violent ou pornographique dans les données de formation DALLA·E 2. Cependant, le filtrage peut introduire des biais dans les données de formation qui sont ensuite propagées aux modèles en aval.

Pour résoudre ce problème, OpenAI a développé une technologie de pré-formation pour atténuer les biais causés par les filtres. De plus, afin de garantir que le modèle AIGC puisse refléter en temps opportun la situation sociale actuelle, les chercheurs doivent régulièrement mettre à jour les ensembles de données utilisés par le modèle, ce qui contribuera à prévenir l'impact négatif causé par le décalage d'information.

Il convient de noter que même si les biais et les stéréotypes dans les données sources peuvent être réduits, ils peuvent toujours se propager ou même être exacerbés lors de la formation et du développement des modèles AIGC. Par conséquent, il est essentiel d’évaluer la présence de biais, de toxicité et de désinformation tout au long du cycle de vie de formation et de développement du modèle, et pas seulement au niveau de la source de données.

Propriété intellectuelle (PI)

Avec le développement rapide et l'application généralisée de l'AIGC, la question du droit d'auteur de l'AIGC est devenue particulièrement importante.

En novembre 2022, Matthew Butterick a déposé un recours collectif contre GitHub, filiale de Microsoft, accusant son service de génération de code produit Copilot d'enfreindre les lois sur le droit d'auteur. Comme pour les modèles de conversion texte-image, certains modèles génératifs ont été accusés de porter atteinte aux droits originaux des artistes sur leurs œuvres.

[Somepalli et al., 2022] montre que les images générées par Stable Diffusion peuvent être copiées à partir des données d'entraînement. Bien que Stable Diffusion refuse tout droit de propriété sur les images générées et permette aux utilisateurs de les utiliser librement tant que le contenu de l'image est légal et inoffensif, cette liberté déclenche toujours de féroces conflits sur le droit d'auteur.

Les modèles génératifs comme Stable Diffusion sont formés sur des images à grande échelle provenant d'Internet sans l'autorisation du détenteur de la propriété intellectuelle, certaines personnes pensent donc que cela viole leurs droits.

Pour résoudre les problèmes de propriété intellectuelle, de nombreuses entreprises de l'AIGC ont pris des mesures.

Par exemple, Midjourney a inclus une politique de retrait DMCA dans ses conditions de service, permettant aux artistes de demander que leur œuvre soit supprimée de l'ensemble de données si une violation du droit d'auteur est suspectée.

De même, Stability AI prévoit de donner aux artistes la possibilité d'exclure leur travail de l'ensemble de formation pour les futures versions de Stable Diffusion. De plus, les filigranes de texte [He et al., 2022a ; He et al., 2022b] peuvent également être utilisés pour identifier si ces outils AIGC utilisent des échantillons provenant d'autres sources sans autorisation.

Par exemple, Stable Diffusion génère des images avec un filigrane Getty Images [Vincent, 2023].

OpenAI développe une technologie de filigrane pour identifier le texte généré par les modèles GPT, un outil que les enseignants peuvent utiliser pour détecter le plagiat dans les devoirs. Google a également appliqué des filigranes Parti aux images qu'il publie. En plus des filigranes, OpenAI a récemment publié un classificateur permettant de distinguer le texte généré par l'IA du texte écrit par l'homme.

Conclusion

Bien que l'AIGC en soit encore à ses balbutiements, elle se développe rapidement et restera active dans un avenir prévisible.

Afin que les utilisateurs et les entreprises comprennent pleinement ces risques et prennent les mesures appropriées pour atténuer ces menaces, nous résumons les risques actuels et potentiels du modèle AIGC dans cet article.

Si ces risques potentiels ne peuvent pas être pleinement compris et si des mesures de défense contre les risques et des garanties de sécurité appropriées sont adoptées, le développement de l'AIGC pourrait se heurter à des défis et des obstacles réglementaires importants. Par conséquent, nous avons besoin d’une participation communautaire plus large pour contribuer à un AIGC responsable.

Enfin, merci SonyAI et BAAI !

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI