Maison >Périphériques technologiques >IA >Comment améliorer l'efficacité des algorithmes d'apprentissage profond, Google a ces astuces

Comment améliorer l'efficacité des algorithmes d'apprentissage profond, Google a ces astuces

- PHPzavant

- 2023-04-11 11:43:021704parcourir

Il y a dix ans, l'essor du deep learning était en partie dû à l'incorporation de nouveaux algorithmes et architectures, à une augmentation significative des données et à l'amélioration de la puissance de calcul. Au cours des 10 dernières années, les modèles d'IA et de ML sont devenus plus profonds et plus complexes, avec davantage de paramètres et de données d'entraînement, devenant ainsi plus volumineux et plus encombrants, ce qui a donné lieu à certains des résultats les plus transformateurs de l'histoire de l'apprentissage automatique.

Ces modèles sont de plus en plus utilisés dans les applications de production et commerciales, et en même temps, leur efficacité et leur coût ont évolué de considérations secondaires vers des limitations majeures. Pour relever des défis majeurs à quatre niveaux : architecture efficace, efficacité de la formation, efficacité des données et efficacité de l'inférence, Google continue d'investir massivement dans l'efficacité du ML. En plus de l'efficacité, ces modèles sont confrontés à de nombreux défis en matière d'authenticité, de sécurité, de confidentialité et de fraîcheur. Ensuite, cet article se concentrera sur les efforts de Google Research pour développer de nouveaux algorithmes pour relever les défis ci-dessus.

La question fondamentale de la recherche est « Existe-t-il une meilleure façon de paramétrer le modèle pour améliorer l'efficacité ? » En 2022, les chercheurs se concentrent sur la récupération du contexte, les systèmes experts hybrides et l'amélioration de l'efficacité du Transformer (le cœur des grands modèles ML). développer de nouvelles technologies qui injectent des connaissances externes grâce à des modèles améliorés.

Modèles améliorés par le contexte

Dans la recherche d'une qualité et d'une efficacité supérieures, les modèles neuronaux peuvent être améliorés avec un contexte externe provenant de grandes bases de données ou d'une mémoire pouvant être entraînée. En tirant parti du contexte récupéré, les réseaux de neurones peuvent obtenir une meilleure efficacité, interprétabilité et réalisme des paramètres sans avoir besoin de stocker de manière approfondie les connaissances dans leurs paramètres internes.

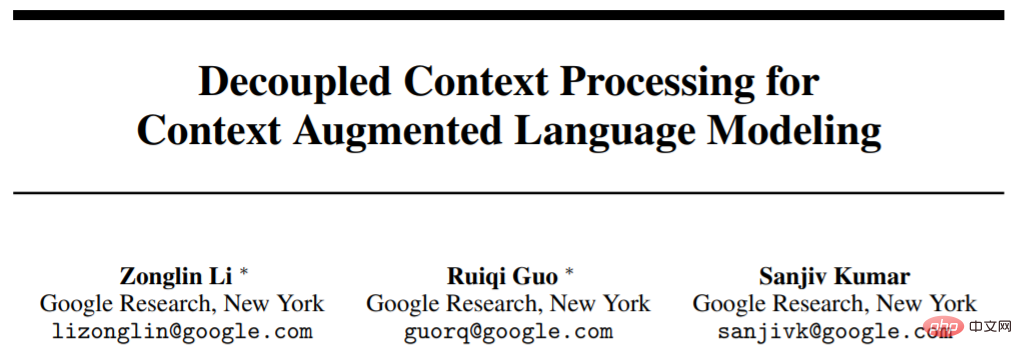

Un article intitulé "Traitement de contexte découplé pour la modélisation de langage augmentée par contexte" explore une architecture codeur-décodeur découplée simple basée sur Schema pour incorporer un contexte externe dans des modèles de langage. Cela permet des économies de calcul significatives dans la modélisation du langage autorégressive et les tâches de réponse aux questions en domaine ouvert. Cependant, les grands modèles de langage (LLM) pré-entraînés consomment une grande quantité d'informations grâce à l'auto-supervision sur de grands ensembles de formation. Cependant, on ne sait pas clairement comment la connaissance du monde de ces modèles interagit avec le contexte présenté. Grâce au réglage fin axé sur les connaissances (KAFT), les chercheurs intègrent un contexte contrefactuel et non pertinent dans des ensembles de données supervisés standard, ce qui améliore la contrôlabilité et la robustesse du LLM.

Adresse papier : https://arxiv.org/abs/2210.05758

Mécanisme d'attention croisée encodeur-décodeur pour la fusion de contexte, permettant l'encodage contextuel De couplé à la langue l'inférence de modèle, améliorant ainsi l'efficacité des modèles augmentés par le contexte.

Dans le processus de recherche de réseaux profonds modulaires, l'un des problèmes est de savoir comment concevoir une base de données conceptuelle avec les modules informatiques correspondants. Les chercheurs ont proposé une architecture théorique qui stocke les « événements mémorisés » sous forme de croquis dans une table LSH externe, comprenant un module de pointeurs pour gérer les croquis.

Exploiter les accélérateurs pour récupérer rapidement des informations à partir de grandes bases de données est un autre défi majeur pour les modèles augmentés par le contexte. Les chercheurs ont développé un algorithme de recherche de similarité basé sur le TPU qui est cohérent avec le modèle de performance du TPU et fournit des garanties analytiques sur le rappel attendu, permettant ainsi d'atteindre des performances optimales. Les algorithmes de recherche impliquent souvent un grand nombre d’hyperparamètres et de choix de conception, ce qui rend difficile leur réglage lors de l’exécution de nouvelles tâches. Les chercheurs proposent un nouvel algorithme d’optimisation contraint pour le réglage automatisé des hyperparamètres. Avec le coût ou le rappel souhaité fixé en entrée, l'algorithme proposé produit des réglages qui sont empiriquement très proches de la frontière de Pareto de rappel de vitesse et offrent des performances de pointe sur les benchmarks standards.

Modèle Expert Mixte

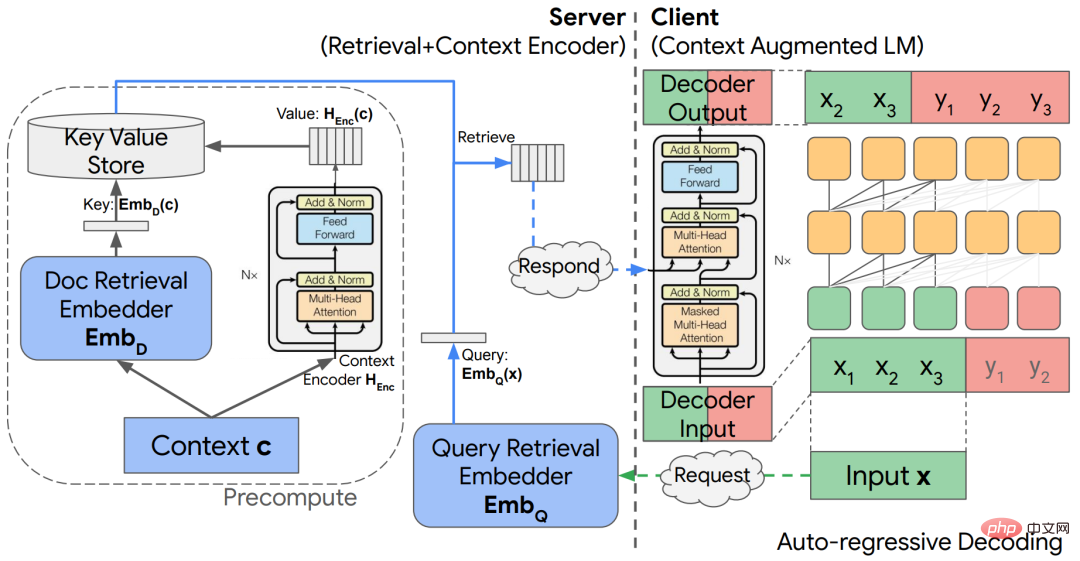

Les modèles Expert Mixte (MoE) se sont avérés être un moyen efficace d'augmenter la capacité des modèles de réseaux neuronaux sans augmenter excessivement les coûts de calcul. L'idée de base du MoE est de construire un réseau unifié à partir de nombreux sous-réseaux d'experts, où chaque entrée est traitée par un sous-ensemble d'experts approprié. En conséquence, MoE n’invoque qu’une fraction du modèle entier par rapport aux réseaux neuronaux standard, ce qui entraîne une efficacité élevée, comme le montrent les applications de modèle de langage telles que GLaM.

Chaque jeton d'entrée dans l'architecture GLaM est acheminé dynamiquement vers deux des 64 réseaux experts à des fins de prédiction.

Pour une entrée donnée, la fonction de routage est chargée de décider quels experts doivent être activés. La conception de cette fonction est un défi car les chercheurs veulent éviter la sous-utilisation et la surutilisation de chaque expert. Un travail récent propose le routage de sélection d'experts, un nouveau mécanisme de routage qui, au lieu d'attribuer chaque jeton d'entrée aux experts du top-k, attribue chaque expert aux jetons du top-k. Cela garantira automatiquement un équilibrage de charge expert tout en permettant naturellement à plusieurs experts de gérer un jeton d'entrée.

Les experts choisissent l'itinéraire. Les experts dotés d'une capacité tampon prédéterminée se voient attribuer des jetons top-k, garantissant ainsi l'équilibrage de la charge. Chaque token peut être traité par un nombre variable d'experts.

Effective Transformer

Transformer est un modèle séquence à séquence populaire qui a obtenu un succès remarquable dans une série de problèmes difficiles allant de la vision à la compréhension du langage naturel. Le composant principal de ce modèle est la couche d'attention, qui identifie les similitudes entre les requêtes et les clés et utilise ces similitudes pour construire une combinaison de valeurs correctement pondérée. Bien que les performances soient élevées, l'efficacité de calcul du mécanisme d'attention n'est pas élevée et la complexité est généralement la seconde puissance de la longueur de la séquence d'entrée.

Alors que l'échelle de Transformer continue de croître, l'une des questions très précieuses pour la recherche est de savoir s'il existe des structures naturelles ou des modèles de modèles d'apprentissage qui peuvent résoudre le principe de l'attention efficace. À cette fin, les chercheurs ont étudié les intégrations apprises dans les couches MLP intermédiaires et ont constaté qu'elles sont très clairsemées. Par exemple, le modèle T5-Large comporte 1 % d'entrées non nulles. La parcimonie démontre en outre qu'il est possible de réduire les FLOP sans affecter les performances du modèle.

Adresse papier : https://arxiv.org/pdf/2210.06313.pdf

Récemment, la recherche a introduit Treeformer - une alternative aux calculs d'attention standard qui s'appuie sur des arbres de décision. En termes simples, cela identifie rapidement un petit sous-ensemble de clés pertinentes pour une requête et effectue des opérations d'attention uniquement sur cet ensemble. En règle générale, Treeformer peut réduire les FLOP de la couche d'attention de 30x. En plus de cela, il existe Sequential Attention - une méthode de sélection de caractéristiques différenciables qui combine l'attention et les algorithmes gloutons. La technique présente de solides garanties prouvables pour les modèles linéaires et s’adapte de manière transparente aux grands modèles d’intégration.

Une autre façon d'améliorer l'efficacité du transformateur consiste à accélérer le calcul du softmax dans la couche d'attention. Sur la base de la recherche sur "l'approximation de bas rang du noyau softmax", les chercheurs ont proposé un nouveau type de caractéristiques aléatoires, fournissant la première approximation de caractéristiques aléatoires "positives et limitées" du noyau softmax, et le calcul de la longueur de la séquence est Linéaire.

Efficacité de la formation

Les méthodes d'optimisation efficaces sont la pierre angulaire des applications ML modernes, et cela est particulièrement important dans les environnements à grande échelle. Dans ce contexte, même les méthodes adaptatives de premier ordre comme Adam sont généralement coûteuses et se heurtent à des problèmes de stabilité de la formation. De plus, ces méthodes sont généralement indépendantes de l’architecture du réseau neuronal, ignorant ainsi la richesse de l’architecture, ce qui entraîne une formation inefficace. Cela incite également à proposer continuellement de nouvelles technologies pour optimiser plus efficacement les modèles de réseaux neuronaux modernes. Les chercheurs développent de nouvelles techniques de formation tenant compte de l'architecture. Par exemple, certaines études sur la formation des réseaux Transformer incluent de nouveaux réseaux Transformer invariants à l'échelle et de nouvelles méthodes d'élagage combinées à la descente de gradient stochastique (SGD) pour accélérer le processus de formation. Grâce à cette méthode, les chercheurs ont pu pour la première fois former efficacement BERT à l’aide d’un simple SGD, sans nécessiter d’adaptation.

Adresse papier : https://arxiv.org/pdf/2210.05758.pdf

De plus, les chercheurs ont proposé une nouvelle méthode avec l'aide de LocoProp—— Réaliser des résultats similaires performances à un optimiseur de second ordre tout en utilisant les mêmes ressources de calcul et de mémoire qu'un optimiseur de premier ordre. LocoProp adopte une vision modulaire des réseaux de neurones, les décomposant en compositions de couches. Chaque couche peut alors avoir sa propre fonction de perte ainsi que des objectifs de sortie et des régulateurs de poids. Avec cette configuration, après des passes avant et arrière appropriées, LocoProp continue de mettre à jour la perte locale de chaque couche en parallèle. En fait, ces mises à jour peuvent s’avérer similaires à celles des optimiseurs d’ordre supérieur, à la fois théoriquement et empiriquement. Sur le benchmark approfondi des auto-encodeurs, LocoProp atteint des performances comparables à celles des optimiseurs d'ordre élevé tout en ayant un avantage en termes de vitesse.

Lien papier : https://proceedings.mlr.press/v151/amid22a.html

Semblable à la rétropropagation, LocoProp applique une passe avant pour calculer les activations. Lors d'une passe arrière, LocoProp définit une cible par neurone pour chaque couche. Enfin, LocoProp divise la formation du modèle en problèmes indépendants sur plusieurs couches, où plusieurs mises à jour locales peuvent être appliquées en parallèle aux poids de chaque couche. L'idée centrale des optimiseurs comme

SGD est que chaque point de données est échantillonné indépendamment et de manière identique à partir de la distribution. Malheureusement, cela est difficile à satisfaire dans des contextes du monde réel, comme l'apprentissage par renforcement, où le modèle (ou l'agent) doit apprendre à partir des données générées sur la base de ses propres prédictions. Les chercheurs ont proposé un nouvel algorithme SGD basé sur la relecture d'expérience inversée, capable de trouver des solutions optimales dans les systèmes dynamiques linéaires, les systèmes dynamiques non linéaires et le Q-learning. De plus, des études ont prouvé qu'une version améliorée de cette méthode, IER, est actuellement la technique de relecture d'expérience la plus avancée et la plus stable dans divers benchmarks RL populaires.

Adresse papier : https://arxiv.org/pdf/2103.05896.pdf

Efficacité des données

Dans de nombreuses tâches, les réseaux de neurones profonds s'appuient fortement sur de grands ensembles de données. Outre les coûts de stockage et les problèmes potentiels de sécurité/confidentialité liés aux grands ensembles de données, la formation de réseaux neuronaux profonds modernes sur de tels ensembles de données entraîne également des coûts de calcul élevés. Une façon possible de résoudre ce problème consiste à sélectionner un sous-ensemble de données.

Les chercheurs ont analysé un cadre de sélection de sous-ensembles conçu pour fonctionner avec des familles de modèles arbitraires dans des contextes pratiques de traitement par lots. Dans ce cas, l'apprenant peut échantillonner un exemple à la fois, accédant à la fois au contexte et à la véritable étiquette, mais pour limiter la surcharge, son état (c'est-à-dire une formation ultérieure des poids du modèle) ne peut être mis à jour qu'après un lot suffisant d'exemples. a été sélectionné. Les chercheurs ont développé un algorithme, appelé IWeS, qui sélectionne les exemples par échantillonnage par importance, où la probabilité d'échantillonnage attribuée à chaque exemple est basée sur l'entropie d'un modèle formé sur des lots préalablement sélectionnés. L'analyse théorique fournie par l'étude démontre des limites en matière de généralisation et de taux d'échantillonnage.

Adresse papier : https://arxiv.org/pdf/2301.12052.pdf

Un autre problème avec la formation de grands réseaux est qu'ils peuvent être très sensibles aux changements de distribution entre les données de formation et les données vues lors du déploiement Sensible , en particulier lorsque vous travaillez avec une quantité limitée de données de formation qui peuvent ne pas couvrir tous les scénarios de déploiement. Une étude récente qui émet l'hypothèse que le « biais d'extrême simplicité » est le problème clé derrière cette fragilité des réseaux de neurones a rendu cette hypothèse réalisable, conduisant à la combinaison de deux nouvelles méthodes complémentaires : DAFT et FRR peuvent fournir des réseaux de neurones beaucoup plus robustes. En particulier, ces deux méthodes utilisent un réglage fin contradictoire ainsi que la prédiction inversée des caractéristiques pour renforcer le réseau d'apprentissage.

Adresse papier : https://arxiv.org/pdf/2006.07710.pdf

Efficacité de l'inférence

Il s'avère qu'augmenter la taille d'un réseau neuronal peut améliorer son précision des prédictions. Cependant, réaliser ces gains dans le monde réel est un défi car le coût d'inférence des grands modèles est très élevé pour le déploiement. Cela conduit à des stratégies visant à améliorer l’efficacité du service sans sacrifier la précision. En 2022, les experts ont étudié différentes stratégies pour atteindre cet objectif, notamment celles basées sur la distillation des connaissances et l’informatique adaptative.

Distillation

La distillation est une méthode de compression de modèle simple et efficace qui élargit considérablement l'applicabilité potentielle des grands modèles neuronaux. Des études ont prouvé que la distillation peut jouer son rôle dans une série d’applications pratiques telles que les recommandations publicitaires. La plupart des cas d'utilisation de la distillation impliquent l'application directe d'une recette de base à une zone donnée, avec une compréhension limitée du moment et de la raison pour laquelle cela devrait fonctionner. Les recherches menées par Google cette année ont porté sur la personnalisation de la distillation pour des environnements spécifiques et ont examiné formellement les facteurs qui contrôlent le succès de la distillation.

Du côté algorithmique, nous développons une approche importante pour repondérer les exemples de formation en modélisant soigneusement le bruit dans les étiquettes des enseignants, et une mesure efficace pour échantillonner un sous-ensemble de données afin d'obtenir les étiquettes des enseignants. Google a déclaré dans "Teacher Guided Training: An Efficient Framework for Knowledge Transfer" qu'au lieu d'utiliser passivement les enseignants pour annoter des ensembles de données fixes, les enseignants sont activement utilisés pour guider la sélection d'échantillons informatifs à annoter. Cela permet au processus de distillation de se démarquer dans des contextes de données limitées ou à longue traîne.

Adresse papier : https://arxiv.org/pdf/2208.06825.pdf

De plus, Google a également étudié du codeur croisé (double-encodeur, tel que BERT) au double codage factoriel A nouvelle méthode pour le double encodeur, qui constitue également un paramètre important pour évaluer la pertinence des paires (requête, document). Les chercheurs ont exploré les raisons de l'écart de performances entre les codeurs croisés et les codeurs doubles, notant que cela pourrait être le résultat d'une généralisation plutôt que de limitations de capacité des codeurs doubles. Une construction soignée de la fonction de perte de distillation peut atténuer cette situation et réduire l'écart entre les performances du codeur croisé et du codeur double. Par la suite, dans embedtitil, nous étudions l’amélioration de la distillation à double codeur en faisant correspondre les plongements dans le modèle enseignant. Cette stratégie peut également être utilisée pour extraire des informations de modèles à double encodeur, de grande à petite taille, où l’héritage et le gel des intégrations de documents de l’enseignant peuvent s’avérer très efficaces.

Adresse papier : https://arxiv.org/pdf/2301.12005.pdf

Théoriquement, la recherche offre une nouvelle perspective sur la distillation du point de vue de la complexité de la supervision. , qui mesure la capacité des élèves à prédire les étiquettes des enseignants. La théorie NTK (neural tangent kernel) fournit des informations conceptuelles. La recherche démontre en outre que la distillation peut amener les élèves à ne pas s'adapter à des points que le modèle de l'enseignant juge difficiles à modéliser. Intuitivement, cela peut aider les étudiants à concentrer leurs capacités limitées sur les échantillons qui peuvent être raisonnablement modélisés.

Adresse papier : https://arxiv.org/pdf/2301.12245.pdf

Calcul adaptatif

Bien que la distillation soit un moyen efficace de réduire le coût de l'inférence, elle est cohérente sur tous les échantillons. Cependant, intuitivement, certains échantillons faciles peuvent nécessiter moins de calculs que les échantillons difficiles. L’objectif du calcul adaptatif est de concevoir des mécanismes permettant un tel calcul dépendant de l’échantillon.

CALM (Confident Adaptive Language Modeling) introduit une fonctionnalité de sortie anticipée contrôlée pour les générateurs de texte basés sur Transformer tels que T5.

Adresse papier : https://arxiv.org/pdf/2207.07061.pdf

Dans cette forme de calcul adaptatif, le modèle modifie dynamiquement chaque étape de décodage en utilisant le nombre de transformateur couches. La porte de sortie anticipée utilise une mesure de confiance avec un seuil de décision calibré pour répondre aux garanties de performance statistique. De cette façon, le modèle n’a besoin que de calculer la pile complète des couches de décodeur pour les prédictions les plus difficiles. Des prédictions plus simples ne nécessitent que le calcul de quelques couches de décodeur. En pratique, le modèle utilise environ un tiers de couches en moyenne pour effectuer des prédictions, ce qui entraîne des accélérations 2 à 3 fois supérieures tout en conservant le même niveau de qualité de génération.

Générez du texte en utilisant le modèle de langage régulier (en haut) et CALM (en bas). CALM tente de faire des prédictions précoces. Une fois qu'il est suffisamment confiant dans le contenu généré (teinte bleu foncé), il saute pour gagner du temps.

Un mécanisme informatique adaptatif populaire est la cascade de deux modèles de base ou plus. Une question clé lors de l'utilisation de cascades : faut-il simplement utiliser les prédictions du modèle actuel ou reporter les prédictions aux modèles en aval. Pour savoir quand retarder, il faut concevoir une fonction de perte appropriée, capable d’exploiter les signaux appropriés pour superviser les décisions retardatrices. Pour atteindre cet objectif, les chercheurs ont étudié formellement les fonctions de perte existantes, démontrant qu'elles pourraient ne pas convenir à l'entraînement d'échantillons en raison des applications implicites de lissage des étiquettes. Des recherches ont montré que ce problème peut être atténué par une formation post-hoc de règles retardées, qui ne nécessite aucune modification des composants internes du modèle.

Adresse papier : https://openreview.net/pdf?id=_jg6Sf6tuF7

Pour les applications de récupération, les techniques de recherche sémantique standard utilisent une valeur fixe pour chaque intégration générée par un grand les modèles expriment. Autrement dit, la taille et les capacités de la représentation sont essentiellement fixes quelles que soient les tâches en aval et leurs environnements informatiques ou contraintes associés. MRL (Matriochka représentation learning) introduit la flexibilité d'adapter la représentation en fonction de l'environnement de déploiement. Lorsqu'il est utilisé conjointement avec des techniques standard de recherche du voisin le plus proche telles que ScaNN, MRL est capable de fournir des calculs jusqu'à 16 fois inférieurs tout en ayant les mêmes mesures de rappel et de précision.

Adresse papier : https://openreview.net/pdf?id=9njZa1fm35

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI