Maison >Périphériques technologiques >IA >Le modèle Google RT-1 demande à un robot d'effectuer plusieurs tâches, avec un taux de réussite de 97 % pour 700 instructions

Le modèle Google RT-1 demande à un robot d'effectuer plusieurs tâches, avec un taux de réussite de 97 % pour 700 instructions

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-11 11:34:031327parcourir

De nombreuses avancées récentes dans plusieurs sous-domaines de la recherche sur l'apprentissage automatique (ML), tels que la vision par ordinateur et le traitement du langage naturel, reposent sur l'exploitation d'ensembles de données vastes et diversifiés et de modèles de représentation capables d'absorber efficacement toutes les données.

Cependant, cette méthode de modélisation performante a relativement peu d'applications dans le domaine de la robotique.

La raison est simple. Premièrement, le manque de données robotiques diversifiées et à grande échelle limite la capacité du modèle à absorber un large éventail d’expériences robotiques.

Deuxièmement, il y a un manque de modèles d'inférence en temps réel expressifs, évolutifs et suffisamment rapides, capables d'apprendre de tels ensembles de données et de généraliser efficacement.

Et cette fois, le Robotics Transformer 1 (RT-1 en abrégé) de Google est un modèle multitâche qui peut étiqueter les actions d'entrée et de sortie du robot (telles que les images de la caméra, les instructions de tâches et les commandes de moteur) pour exécuter des tâches efficaces. raisonnement à tout moment et rendre possible un contrôle en temps réel.

RT-1 absorbe une grande quantité de données pour rendre le robot compétent pour une variété de tâches dans différents environnements, améliorant ainsi les performances de la machine et les capacités de généralisation

Pour faire simple, cela signifie laisser un robot le faire en même temps Plusieurs tâches.

Le modèle a été formé sur un vaste ensemble de données robotiques du monde réel de 130 000 épisodes couvrant plus de 700 tâches, collectées sur 17 mois à l'aide de 13 robots d'Everyday Robots (EDR).

Les résultats montrent que RT-1 peut améliorer considérablement la généralisation du tir zéro à de nouvelles tâches, environnements et objets par rapport aux techniques existantes.

L'éditeur a également judicieusement placé le lien Github ci-dessous. Si vous êtes intéressé, allez y jeter un œil.

https://github.com/google-research/robotics_transformer

Principe spécifique au modèle RT-1

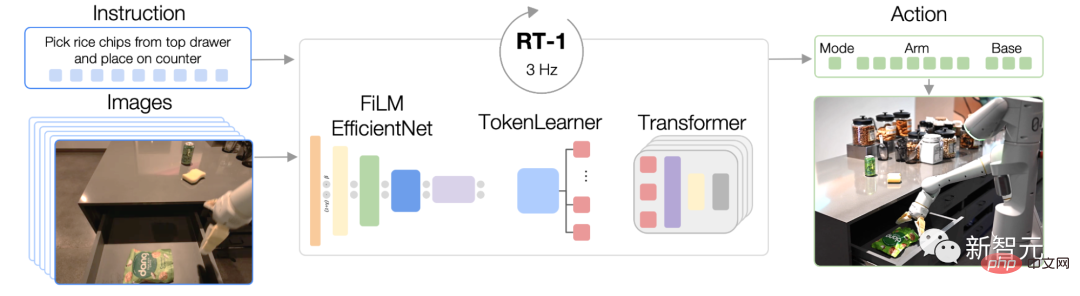

RT-1 est construit sur l'architecture Transformer, qui peut transformer le du robot L'historique des images est obtenu à partir de la caméra et la description de la tâche exprimée en langage naturel est utilisée comme entrée, tandis que les actions marquées sont directement sorties. L'architecture de

RT-1 est similaire à celle d'un modèle de séquence uniquement décodeur formé sur un objectif d'entropie croisée catégoriel standard avec masquage causal.

Le modèle prend des instructions textuelles et un ensemble d'images en entrée, les code en jetons via le modèle FiLM EfficientNet pré-entraîné, les compresse via TokenLearner, puis génère des jetons d'action via Transformer.

Ses principales fonctions incluent : la tokenisation d'image, la tokenisation d'action et la compression de jetons.

- Tokenisation d'image : nous transmettons l'image via le modèle EfficientNet-B3 pré-entraîné sur ImageNet, puis aplatissons la carte de caractéristiques spatiales 9×9×512 résultante en 81 jetons. Le tokenizer d'image est conditionné par des instructions de tâche en langage naturel et extrait très tôt les caractéristiques d'image pertinentes pour la tâche à l'aide d'une couche FiLM initialisée pour l'identité.

- Tokénisation de l'action : les dimensions d'action du robot sont 7 variables de mouvement du bras (x, y, z, roulis, tangage, lacet, ouverture de la pince), 3 variables de mouvement de base (x, y, navigation en lacet ), et une variable discrète supplémentaire pour basculer entre les trois modes.

- Compression des jetons : le modèle sélectionne de manière adaptative des combinaisons douces de jetons d'image qui peuvent être compressés en fonction de leur impact sur l'apprentissage à l'aide du module d'attention aux éléments TokenLearner, ce qui entraîne une inférence plus de 2,4 fois plus rapide.

Nous utilisons des démos fournies par des humains via une opération à distance et annotons chaque épisode avec des descriptions textuelles du robot exécutant les instructions.

Et ce robot s'appuie sur "un bras à 7 degrés de liberté, une pince à deux doigts et une base mobile" pour effectuer des tâches.

L'ensemble de compétences de haut niveau représenté dans l'ensemble de données comprend des opérations telles que choisir et placer des objets, ouvrir et fermer des tiroirs, mettre des objets dans et hors des tiroirs, placer des objets minces à la verticale, renverser des objets, etc.

Intégration de sources de données hétérogènes

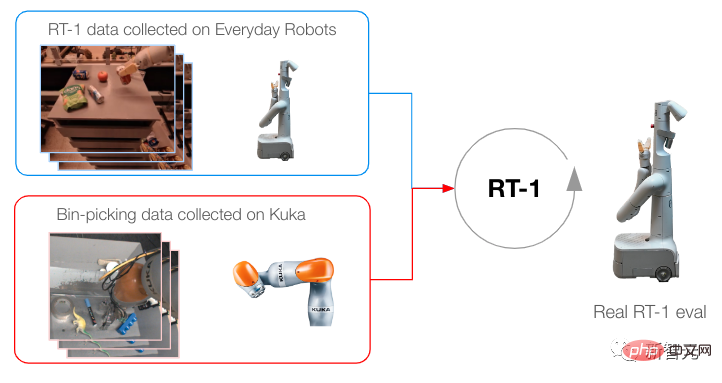

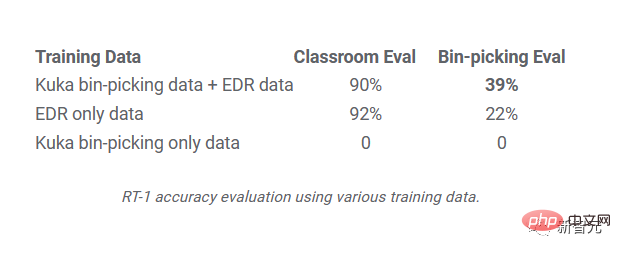

Pour pousser davantage RT-1, nous l'avons formé à l'aide de données collectées à partir d'un autre robot pour tester (1) si le modèle maintient ses performances sur la tâche d'origine lorsque de nouvelles sources de données sont présentées, et (2) si le modèle s'améliore en généralisation avec des données nouvelles et différentes.

Nous transformons les données collectées pour qu'elles correspondent aux spécifications d'action et aux limites des ensembles de données d'origine que nous avons collectés à l'aide d'EDR, et étiquetons chaque ensemble de données avec des instructions de tâche.

Mélangez ensuite les données Kuka avec les données EDR dans un rapport 1:2 dans chaque lot d'entraînement pour contrôler la régression des compétences EDR d'origine.

L'image montre la méthode de formation lors de la collecte de données de plusieurs robots

Les résultats montrent que RT-1 est capable d'acquérir de nouvelles compétences en observant l'expérience d'autres robots.

Lorsque RT-1 a été formé sur les données de sélection de bacs de Kuka et les données EDR existantes de la classe de robotique, la précision a bondi de près de 2 pour atteindre 39 %, contre 22 % lors d'une formation en utilisant uniquement les données EDR.

Lors de la formation du RT-1 en utilisant les données de sélection de Kuka uniquement et de son évaluation à l'aide des données de sélection du robot EDR, la précision était de 0 %.

Résultats expérimentaux

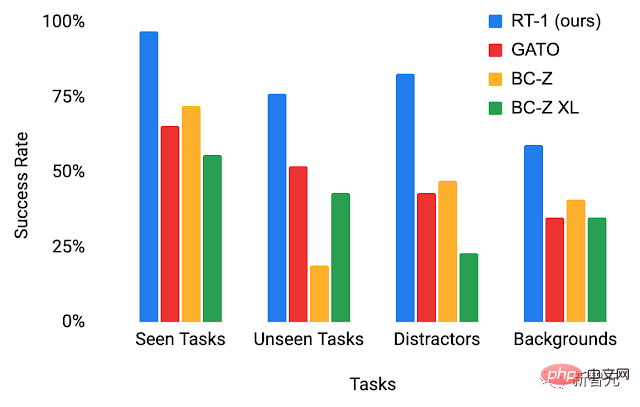

Pour mieux comprendre la capacité de généralisation du RT-1, nous avons étudié ses performances par rapport à trois lignes de base : Gato, BC-Z et BC-Z XL (c'est-à-dire avec le même BC-Z pour les paramètres quantitatifs).

et l'a divisé en quatre catégories :

La photo montre les performances du RT-1 et du groupe témoin dans l'environnement de test

- Performance des tâches invisibles : performance des tâches observées pendant la formation ;

-

Performance des tâches invisibles : performance sur des tâches invisibles où les compétences et les objets sont séparés dans l'ensemble de formation ; facteurs d'interférence et performances des changements d'arrière-plan (nouvelle cuisine, éclairage, scènes d'arrière-plan)

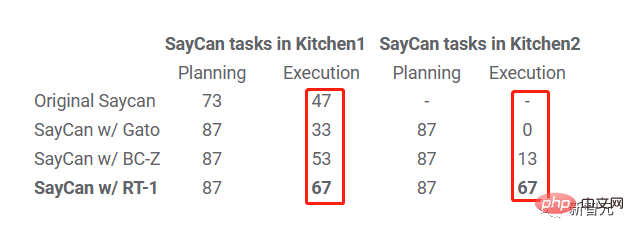

scénarios à long horizon) : Exécution d'instructions en langage naturel de type SayCan dans de vraies cuisines - Hautes performances et capacités de généralisation du RT-1 peut réaliser des tâches d'exploitation mobiles et longue distance via SayCan.

- SayCan fonctionne en plaçant un modèle de langage dans les capacités du robot et en exploitant une poignée d'indices pour décomposer la tâche à long terme consistant à exprimer le langage naturel en une série de compétences de bas niveau.

Nous évaluons SayCan dans deux vraies cuisines en utilisant RT-1 et deux autres références (SayCan avec Gato et SayCan avec BC-Z).

Ci-dessous, "Kitchen2" pose un scénario de généralisation plus difficile que "Kitchen1". La cuisine simulée utilisée pour collecter la plupart des données de formation a été calquée sur Kitchen1.

On peut voir que le taux de réussite d'exécution de SayCan avec RT-1 dans Kitchen1 est de 67 %, ce qui est meilleur que les autres références.

En raison des difficultés de généralisation causées par la nouvelle cuisine invisible, les performances de SayCan avec Gato et SayCan avec BCZ ont diminué, mais le taux de réussite de RT-1 n'a pas diminué.

En raison des difficultés de généralisation causées par la nouvelle cuisine invisible, les performances de SayCan avec Gato et SayCan avec BCZ ont diminué, mais le taux de réussite de RT-1 n'a pas diminué.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI