Maison >Périphériques technologiques >IA >OpenAI révèle le plan de mise à niveau de ChatGPT : tous les bugs que vous trouvez sont en cours de correction

OpenAI révèle le plan de mise à niveau de ChatGPT : tous les bugs que vous trouvez sont en cours de correction

- 王林avant

- 2023-04-10 20:41:011475parcourir

La mission d’OpenAI est de garantir que l’intelligence artificielle générale (AGI) profite à toute l’humanité. Nous réfléchissons donc beaucoup au comportement des systèmes d'IA que nous construisons au fur et à mesure que nous mettons en œuvre l'AGI, et à la manière dont ce comportement est déterminé.

Depuis que nous avons lancé ChatGPT, les utilisateurs ont partagé des résultats qu'ils jugent politiquement biaisés ou autrement répréhensibles. Dans de nombreux cas, nous pensons que les préoccupations soulevées sont légitimes et identifient de réelles limites de notre système que nous espérons résoudre. Mais dans le même temps, nous avons également constaté des malentendus liés à la manière dont nos systèmes et nos politiques fonctionnent ensemble pour façonner le résultat de ChatGPT.

Les principaux points du blog sont résumés ci-dessous :

- Comment le comportement de ChatGPT est né

- Comment nous prévoyons d'améliorer le comportement par défaut de ChatGPT

- Nous voulons ; permettre davantage de personnalisation du système ;

- Nous nous efforcerons de permettre au public d'avoir plus d'opinions sur nos décisions.

Notre priorité absolue

Contrairement aux logiciels ordinaires, nos modèles sont des réseaux de neurones à grande échelle. Leur comportement est tiré de nombreuses données plutôt que explicitement programmé. Pour utiliser une analogie moins appropriée, ce processus s’apparente davantage au dressage d’un chien qu’à une programmation ordinaire. Tout d'abord, le modèle passe par une phase de « pré-formation ». À ce stade, le modèle apprend à prédire le mot suivant dans une phrase en étant exposé à une grande quantité de texte Internet (et à une grande quantité d’opinions). Vient ensuite la deuxième étape, où nous « affinons » le modèle pour restreindre la portée du comportement du système.

Pour l’instant, ce processus n’est pas parfait. Parfois, le processus de réglage fin ne parvient pas à satisfaire à la fois notre intention (produire un outil sûr et utile) et l'intention de l'utilisateur (obtenir un résultat utile en réponse à une entrée donnée). À mesure que les systèmes d’IA deviennent plus puissants, améliorer la manière dont nous alignons les systèmes d’IA sur les valeurs humaines devient une priorité pour notre entreprise.

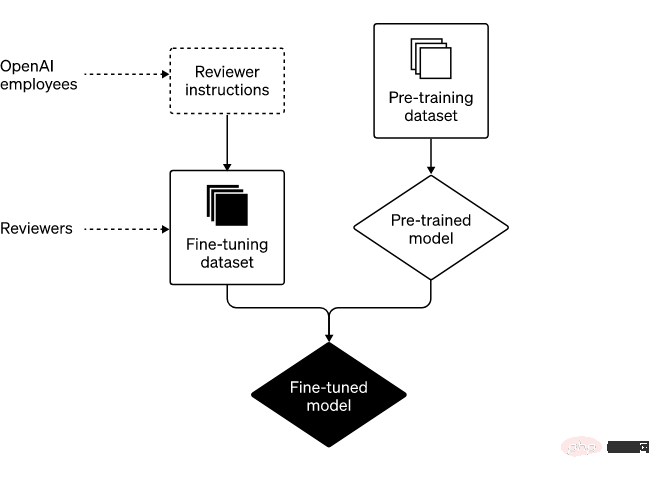

Deux étapes majeures : pré-formation et mise au point

Les deux étapes principales pour construire ChatGPT sont les suivantes :

Tout d'abord, nous "pré-entraînons" les modèles et les laissons prédire le contenu contenant des parties d’Internet. Quelle est la prochaine étape pour les ensembles de données volumineuses. Ils pourraient apprendre à compléter la phrase « Elle n’a pas tourné à gauche, elle s’est tournée vers __ ». En apprenant à partir de milliards de phrases, notre modèle maîtrise la grammaire, de nombreux faits sur le monde et certaines capacités de raisonnement. Ils ont également découvert certains des préjugés présents dans ces milliards de phrases.

Nous « affinons » ensuite ces modèles sur un ensemble de données plus restreint élaboré par des évaluateurs humains qui suivent les directives que nous fournissons. Parce que nous ne pouvons pas prédire toutes les informations que les futurs utilisateurs pourraient saisir dans notre système, nous n'avons pas rédigé d'instructions détaillées pour chaque entrée rencontrée par ChatGPT. Au lieu de cela, nous décrivons dans le guide plusieurs catégories que nos évaluateurs utilisent pour examiner et évaluer les résultats possibles du modèle pour une gamme d'exemples d'entrées. Ensuite, lors de son utilisation, le modèle généralise à partir des commentaires des évaluateurs afin de répondre à un large éventail de contributions spécifiques fournies par des utilisateurs spécifiques.

Le rôle des réviseurs et la stratégie d'OpenAI dans le développement du système

Dans certains cas, nous pouvons fournir à nos réviseurs des conseils concernant certains types de résultats (par exemple, « Ne répondez pas aux demandes de contenu illégal »). Dans d'autres cas, les conseils que nous partageons avec les évaluateurs sont de niveau supérieur (par exemple, « Évitez de prendre parti sur des sujets controversés »). Il est important de noter que notre travail avec les évaluateurs n’est pas une affaire ponctuelle mais une relation continue. Au cours de cette relation, nous avons beaucoup appris de leur expertise.

Une grande partie du processus de mise au point consiste à maintenir une solide boucle de rétroaction avec nos évaluateurs, ce qui implique des réunions hebdomadaires pour répondre aux questions qu'ils pourraient avoir ou pour obtenir des éclaircissements supplémentaires sur nos conseils. Ce processus de rétroaction itératif est la manière dont nous formons nos modèles pour les améliorer au fil du temps.

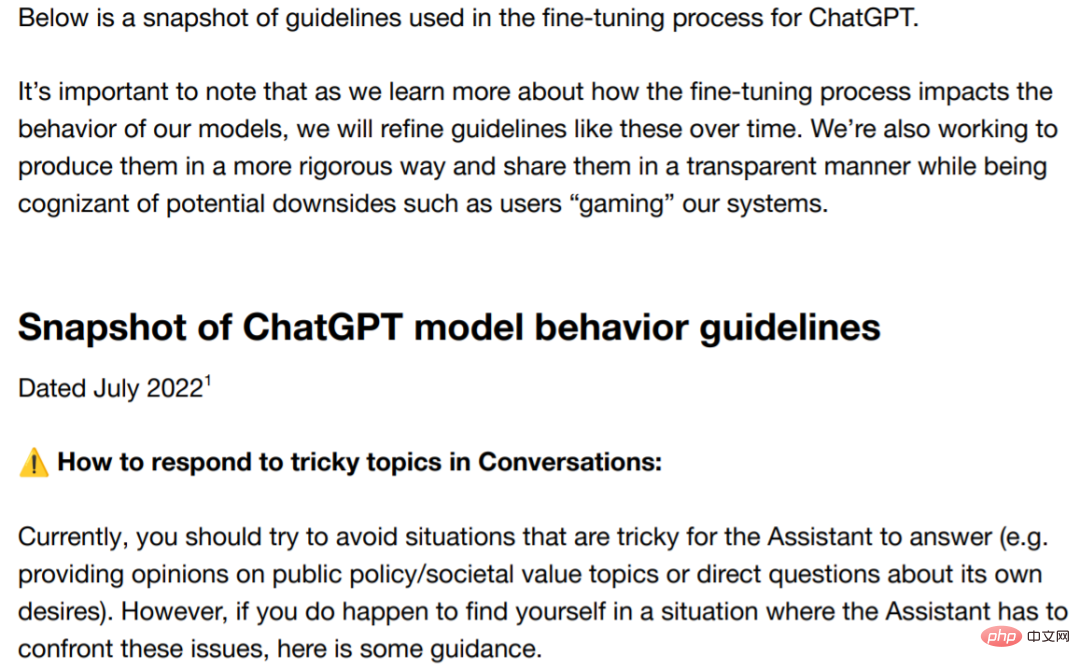

Réduire les biais

Pour les systèmes d'IA, le problème des biais existe depuis longtemps et de nombreux chercheurs ont exprimé leurs inquiétudes à ce sujet. Nous sommes fermement déterminés à résoudre ce problème et à rendre publics nos intentions et nos progrès. Pour exprimer les progrès sur le terrain, nous partageons ici quelques conseils sur des sujets liés à la politique et aux controverses. Les directives indiquent clairement que les évaluateurs ne doivent favoriser aucun groupe politique. Néanmoins, des biais peuvent survenir.

Adresse des lignes directrices : https://cdn.openai.com/snapshot-of-chatgpt-model-behaviour-guidelines.pdf

Bien que des différences existeront toujours, nous espérons pass Ce blog, accompagné de quelques conseils, vous permettra de mieux comprendre notre vision des préjugés. Nous croyons fermement que les entreprises technologiques doivent élaborer de manière responsable des politiques qui résistent à un examen minutieux.

Nous travaillons constamment à améliorer la clarté de ces directives et, sur la base de ce que nous avons appris jusqu'à présent de la version ChatGPT, nous fournirons aux évaluateurs des informations sur les pièges et les défis potentiels liés aux préjugés, ainsi que sur les données controversées. et Une description plus claire du sujet. De plus, dans le cadre d'une initiative de transparence en cours, nous nous efforçons de partager des statistiques globales sur les évaluateurs d'une manière qui ne viole pas les règles et normes de confidentialité, car il s'agit d'une autre source de biais potentiel dans les résultats du système.

En nous appuyant sur des avancées telles que les récompenses de règles et l'IA constitutionnelle (méthode originale d'intelligence artificielle), nous étudions actuellement comment rendre le processus de réglage fin plus facile à comprendre et à contrôler.

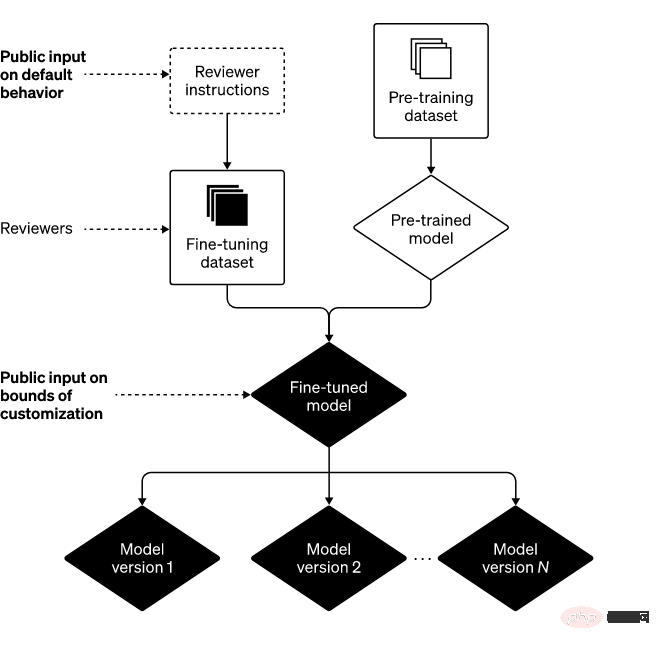

Orientations futures : éléments constitutifs du système

Pour réaliser notre mission, nous nous engageons à garantir qu'un plus large éventail de personnes puissent utiliser et bénéficier de l'IA et de l'AGI. Nous pensons que pour atteindre ces objectifs, au moins trois éléments de base sont nécessaires

1. Améliorer le comportement par défaut : Nous espérons que le système d'IA pourra être utilisé de manière prête à l'emploi, afin que le plus grand nombre d'utilisateurs possible puisse le trouver. que notre système d'IA est effectivement utile et pensons que nous, les technologues, comprenons et respectons leurs valeurs.

À cette fin, nous avons investi dans la recherche et l'ingénierie pour réduire les biais subtils de ChatGPT dans la réponse aux différentes entrées. Dans certains cas, ChatGPT refuse de produire le contenu qu'il devrait produire, et dans d'autres cas, il fait le contraire et génère du contenu qu'il ne devrait pas produire. Nous pensons que ChatGPT a un potentiel d'amélioration dans les deux domaines.

De plus, il y a place à l'amélioration dans d'autres aspects de notre système d'IA, comme le système qui « invente souvent des choses ». Pour ce problème, les commentaires des utilisateurs sont extrêmement précieux pour améliorer ChatGPT.

2. Définir la valeur de l'IA à grande échelle : Nous pensons que l'IA doit être un outil utile aux individus, afin que chaque utilisateur puisse la personnaliser avec certaines contraintes. Sur cette base, nous développons une mise à niveau de ChatGPT pour permettre aux utilisateurs de personnaliser facilement son comportement.

Cela signifie également que les résultats avec lesquels certaines personnes sont fortement en désaccord sont visibles par d'autres. Trouver cet équilibre constitue un défi de taille, car pousser la personnalisation à l’extrême peut conduire à une utilisation malveillante de notre technologie et amplifier aveuglément les performances de l’IA.

Par conséquent, il existe toujours certaines limites sur le comportement du système. Le défi est de définir quelles sont ces limites. Si nous essayons de prendre toutes ces décisions nous-mêmes, ou si nous essayons de développer un système d’IA unique et monolithique, nous ne parviendrons pas à tenir notre promesse d’éviter une concentration excessive du pouvoir.

3. Entrées publiques (par défaut et limites strictes) : Une façon d'éviter une concentration excessive du pouvoir est de permettre aux personnes qui utilisent ou sont affectées par des systèmes comme ChatGPT de pouvoir à leur tour influencer les règles du système.

Nous pensons que les valeurs par défaut et les limites strictes doivent être centralisées, et bien que cela soit difficile à mettre en œuvre, notre objectif est d'inclure autant de perspectives que possible. Pour commencer, nous recherchons une contribution externe à notre technologie sous la forme d'une « équipe rouge ». Nous avons également récemment commencé à solliciter l’avis du public sur l’éducation à l’IA (un contexte particulièrement important dans lequel nous déployons).

Conclusion

En combinant les trois éléments de base ci-dessus, nous pouvons arriver au cadre suivant

Parfois, nous faisons des erreurs, mais lorsque nous le faisons, nous apprenons et itérons sur des modèles et des systèmes. De plus, nous souhaitons remercier les utilisateurs de ChatGPT et les autres personnes qui nous maintiennent attentifs et vigilants, et nous sommes ravis de partager davantage sur notre travail dans ces trois domaines dans les mois à venir.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI