Maison >Périphériques technologiques >IA >Une interview exclusive avec le professeur Ou Zhijian de l'Université Tsinghua, fournissant une analyse approfondie de l'aura de ChatGPT et des défis futurs !

Une interview exclusive avec le professeur Ou Zhijian de l'Université Tsinghua, fournissant une analyse approfondie de l'aura de ChatGPT et des défis futurs !

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-10 16:01:032051parcourir

Fin novembre 2022, une fois lancé ChatGPT, il a attiré l'attention du monde entier et sa popularité est toujours forte ! Remplaçant les moteurs de recherche, la singularité et le point d'inflexion, plusieurs métiers sont confrontés à la crise du chômage, et l'humanité est confrontée au défi ultime... Face à des sujets aussi brûlants, cet article partage notre compréhension, et accueille discussion et correction.

De manière générale, ChatGPT a fait des progrès technologiques significatifs Bien qu'il y ait des lacunes, l'évolution vers l'AGI (intelligence artificielle générale, intelligence artificielle générale) est encore pleine de nombreux défis !

Figure 1 : https://openai.com/blog/chatgpt/ Capture d'écran de la page Web

Tout d'abord, introduisons l'Eliza Effect (Eliza Effect) dans la recherche sur l'IA, qui est également lié à Lié aux chatbots.

L'effet Eliza signifie que les gens vont surinterpréter les résultats de la machine et lire à haute voix un sens qu'ils n'avaient pas à l'origine. Les humains ont une tendance psychologique à croire inconsciemment que les phénomènes naturels sont similaires au comportement humain, ce que l'on appelle l'anthropomorphisation humaine (anthropomorphisation) en psychologie, en particulier lorsque les humains ne comprennent pas suffisamment les nouveaux phénomènes. Par exemple, dans les temps anciens, les gens croyaient que le tonnerre était causé par un dieu du tonnerre vivant dans le ciel. Lorsque le dieu du tonnerre se mettait en colère, il tonnait.

Le nom "Eliza" est tiré d'un robot de discussion développé par l'informaticien du MIT Joseph Weizenbaum en 1966. Le chatbot Eliza a été conçu comme un conseiller psychologique. Le projet intelligent Eliza a connu un succès inattendu à l'époque et a fait sensation. Cependant, il ne s'agissait en réalité que d'une application intelligente basée sur une simple règle de grammaire.

Une certaine compréhension des principes de ChatGPT devrait pouvoir réduire l'effet Eliza lors de la compréhension de ChatGPT. Ce n’est qu’avec un jugement correct que nous pouvons être en bonne santé et avoir une grande portée. À cette fin, nous nous efforçons d’être rigoureux et de fournir des références permettant aux lecteurs de mieux comprendre. Ce qui suit sera divisé en trois parties :

- Les progrès de ChatGPT

- Les lacunes de ChatGPT

- Les défis vers l'AGI

Page d'accueil personnelle : http://oa .ee .tsinghua.edu.cn/ouzhijian

Auteur : Ou Zhijian, professeur agrégé et directeur de doctorat au Département de génie électronique, Université Tsinghua. A été rédacteur associé du IEEE Audio Speech Language Journal (TASLP), membre du comité de rédaction de Computer Speech & Language, membre du comité technique du langage vocal de l'IEEE (SLTC), président de la conférence IEEE Speech Technology (SLT) 2021, membre distingué de China Computer. Fédération (CCF) et Discours Dialogue et Audition Membres des commissions spécialisées, etc. Il a publié près de 100 articles et a remporté trois prix provinciaux et ministériels ainsi que plusieurs prix nationaux et étrangers pour des articles exceptionnels. Réalisation de recherches fondamentales originales sur les modèles de langage à champ aléatoire, les algorithmes d'apprentissage pour les modèles à variables latentes discrètes, les modèles de dialogue de bout en bout et leur apprentissage semi-supervisé.

01 Les progrès de ChatGPT

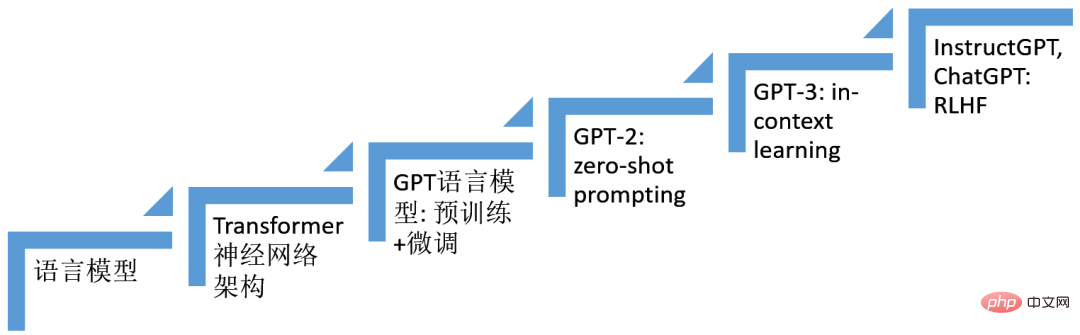

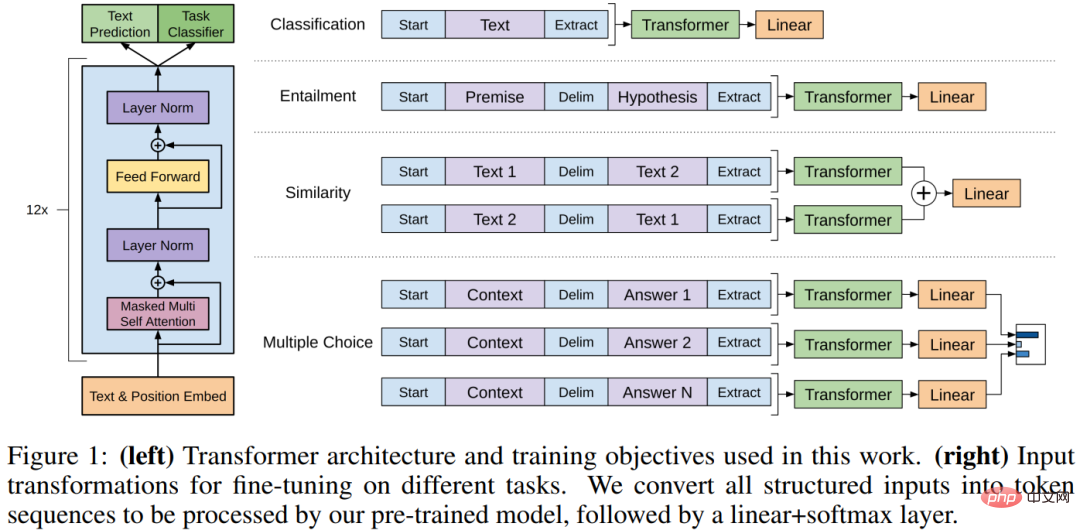

Les progrès de ChatGPT reposent depuis de nombreuses années sur les épaules des géants de la recherche sur l'intelligence artificielle, en particulier la technologie d'apprentissage profond, qui est la technologie qui utilise les réseaux neuronaux multicouches. Nous avons trié plusieurs technologies qui jouent un rôle important dans la construction du système ChatGPT, comme le montre la figure ci-dessous. C'est l'effet combiné de ces technologies (six étapes) qui a donné naissance à ChatGPT. Le squelette du modèle de

ChatGPT est un modèle de langage autorégressif (modèle de langage) basé sur l'architecture de réseau neuronal Transformer. Technologie basée sur le réglage fin (finetuning), technologie basée sur Prompt (invite), apprentissage situationnel (apprentissage en contexte), apprentissage par renforcement à partir de la rétroaction humaine (RLHF) la technologie s'est progressivement développée et a finalement contribué à La naissance de ChatGPT.

Figure 2 : Progression de ChatGPT

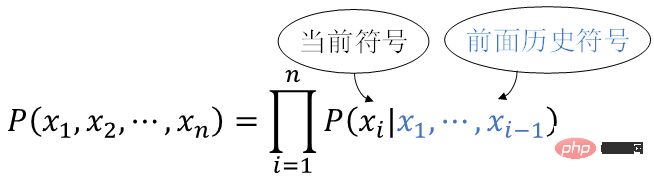

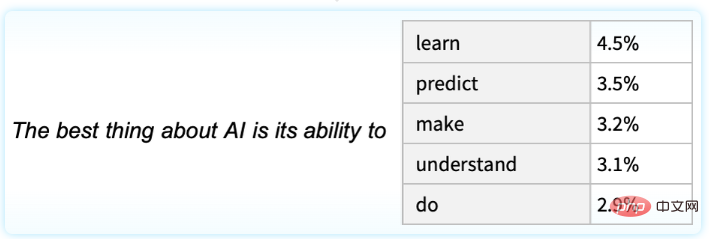

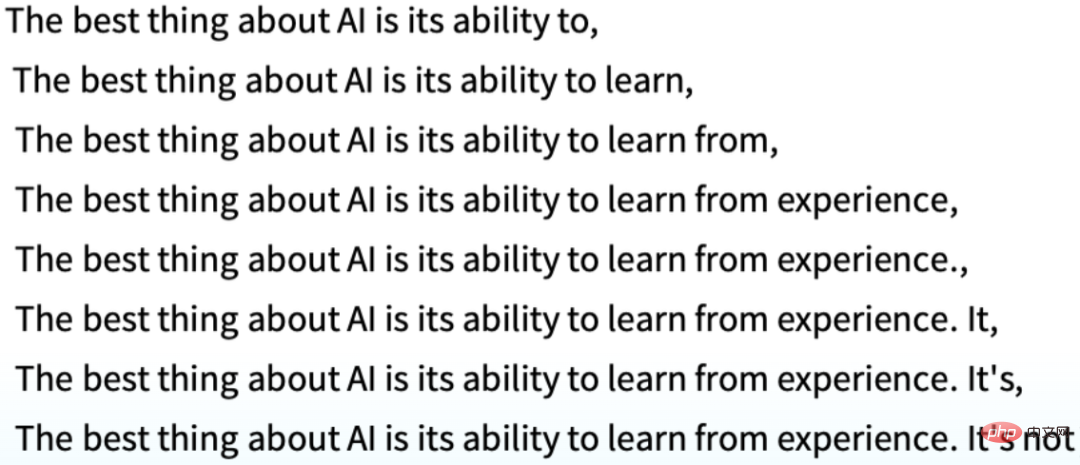

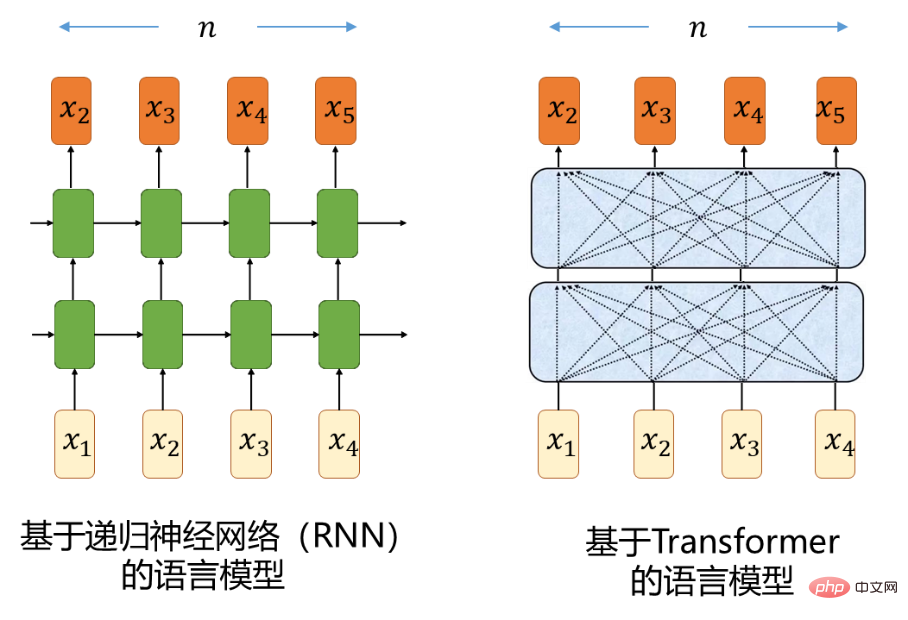

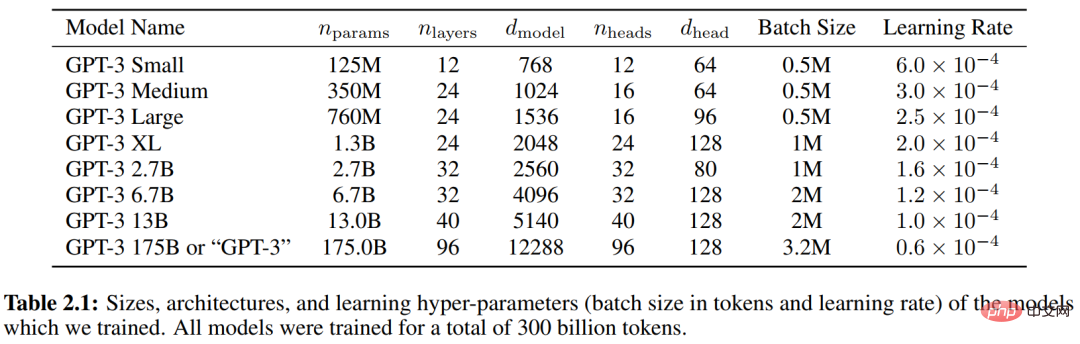

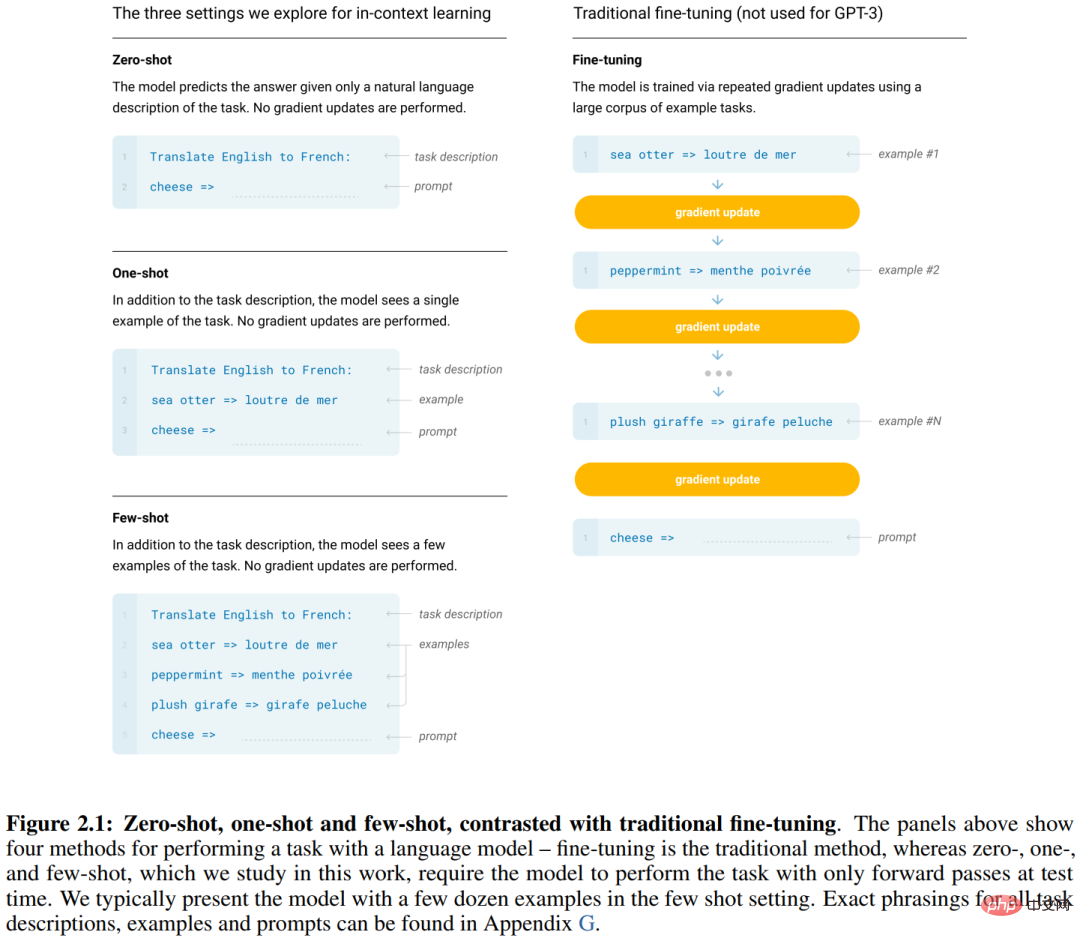

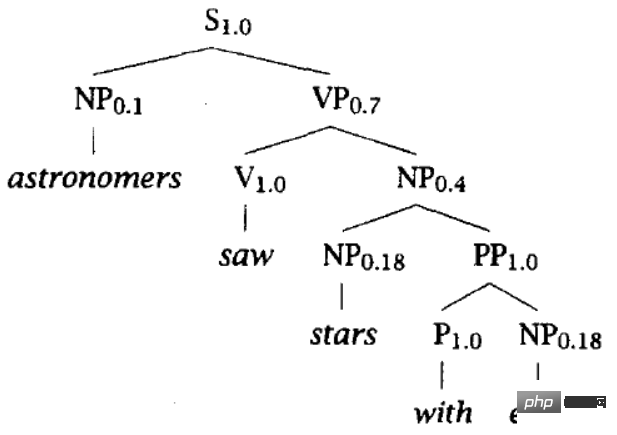

1. Le modèle linguistique est un modèle probabiliste du langage naturel humain. Le langage naturel humain est une phrase, et une phrase est une séquence de symboles du langage naturel x1,x2,...,xn, obéissant à la distribution de probabilité en utilisant la formule de multiplication de la théorie des probabilités, vous pouvez obtenir Mettez cela de gauche à droite, et utilisez les symboles historiques précédents x1,x2,…,xi-1 ( (c'est-à-dire ci-dessus), le modèle qui calcule la probabilité (conditionnelle) du symbole actuel P(xi | Naturellement, il peut être utilisé pour générer le symbole actuel étant donné les conditions ci-dessus. Par exemple, la figure ci-dessous illustre la probabilité d'apparition du prochain symbole compte tenu de la phrase ci-dessus "La meilleure chose à propos de l'IA est sa capacité à". peut être généré de manière récursive, La clé du problème du modèle de langage est de savoir quel type de famille de fonctions construire pour représenter la distribution conditionnelle P(x | x i-1), et peut apprendre efficacement les paramètres du modèle à partir du Big Data. Une avancée technologique basée sur ChatGPT est l'utilisation de réseaux de neurones pour représenter P(xi | x1,…,xi-1). 2. Architecture du réseau neuronal du transformateur Un défi pour la modélisation de la distribution conditionnelle de séquence P(xi | x1 i-1) C'est à dire , Modélisation des dépendances à longue portée. Les modèles de séquence utilisant des réseaux neuronaux récurrents ordinaires (RNN) rencontreront des effets de gradient explosifs et disparaissants pendant l'entraînement [1], c'est pourquoi depuis longtemps les gens utilisent des modèles basés sur un réseau de mémoire à long terme (mémoire à long terme, LSTM) RNN [2] est utilisé pour la modélisation de séquences. LSTM atténue dans une certaine mesure les défauts d’explosion et de disparition du gradient en introduisant un mécanisme de déclenchement. L'architecture de réseau neuronal Transformer [3] développée en 2017 a complètement abandonné les calculs récursifs et a utilisé le mécanisme d'auto-attention pour effectuer une modélisation de séquence à l'aide d'un réseau neuronal à action directe (FFNN), ce qui est meilleur. Il résout efficacement les défauts de l'explosion de gradient. et disparaître. Comprenons intuitivement les avantages de Transformer par rapport à RNN dans la modélisation de séquence. Considérons deux positions dans la séquence qui sont n séparées. Les signaux dans les calculs avant et arrière entre ces deux positions, et la longueur du chemin parcouru dans le réseau neuronal, affectent la capacité du réseau neuronal à apprendre les dépendances à longue portée. Le facteur important de RNN est O(n) O(1). Les lecteurs qui ne comprennent pas cette section peuvent la sauter sans affecter la lecture du contenu suivant :-)Figure 3 3. technologie de réglage La compréhension du langage naturel comprend un large éventail de tâches différentes, telles que la réponse aux questions, l'évaluation de la similarité sémantique, le jugement des relations d'implication du texte, la classification des documents, la traduction automatique, la compréhension écrite, le résumé, etc. Il a été constaté que l'on peut d'abord entraîner un grand Transformer-LM (souvent appelé squelette) sur une grande quantité de texte (non étiqueté), puis affiner ce grand réseau Transformer en utilisant les données d'annotation respectives des tâches en aval face à différentes tâches en aval. , a obtenu de grandes améliorations de performances. Il s'agit de la technologie de pré-formation + réglage fin (pré-formation + réglage fin). Les technologies typiques incluent GPT [4] et BERT [5] développées. en 2018-2019. GPT est un modèle de langage autorégressif basé sur Transformer, et BERT est un modèle de langage masqué (MLM) basé sur Transformer. Comme l'indique le texte original du GPT, "Notre travail relève largement de la catégorie de l'apprentissage semi-supervisé du langage naturel." Ce type de pré-formation non supervisée est combiné avec un perfectionnement supervisé, est une sorte. d'apprentissage semi-supervisé , dont l'essence est d'effectuer de manière collaborative un apprentissage supervisé et un apprentissage non supervisé. (extrait du texte original GPT [4] "Améliorer la compréhension du langage par une pré-formation générative") 4 dans GPT-2 et technologie d'invite à échantillon nul . pré-formation +Dans le cadre d'une technologie de mise au point fine, il est toujours nécessaire de collecter et d'étiqueter une grande quantité de données annotées pour chaque tâche en aval, puis d'affiner pour obtenir un « expert restreint » sur chaque tâche respective. un modèle étroit doit être construit et étiqueté séparément. Le stockage prend du temps, nécessite beaucoup de main-d'œuvre et de ressources. Ce serait formidable si nous pouvions créer un système plus général capable de gérer de nombreuses tâches et d'éliminer le besoin de collecter et d'étiqueter manuellement des ensembles de données pour chaque tâche. Dans le texte original du GPT-2 de 2019 [6], avec un énoncé de vision aussi clair, avez-vous déjà vu la saveur d'évoluer vers l'AGI :-) Laissez la machine apprendre à effectuer une tâche de compréhension du langage naturel (comme une question et une réponse), l'essence est d'estimer le distribution conditionnelle

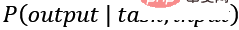

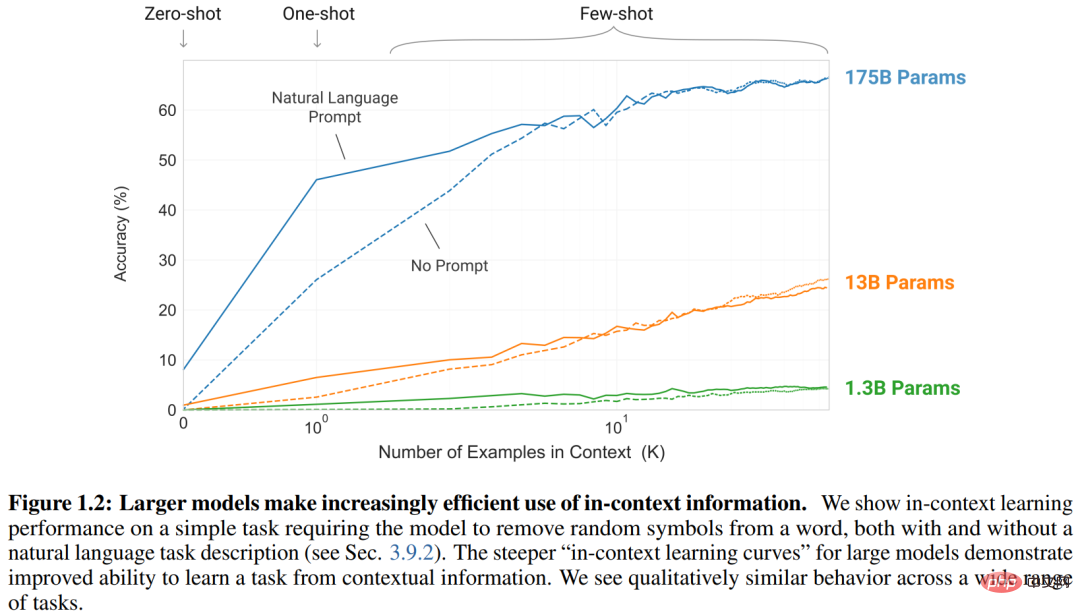

task, c'est-à-dire la modélisation Tâche, entrée, sortie sont toutes exprimées sous forme de séquences de symboles en langage naturel, de sorte que le modèle P(output | task, input) se résume à un modèle de langage - compte tenu de ce qui précède, génère récursivement le symbole suivant. Les données d'entraînement des différentes tâches sont uniformément organisées sous forme de séquences de symboles comme (traduire en français, texte anglais, texte français) (répondre à la question, document, question, réponse) Parmi eux, tâche est souvent appelée invite) . Il existe de nombreuses méthodes d’incitation, et de nombreuses études connexes ne les présenteront pas. Des recherches sur des idées similaires ont été menées avant GPT-2. GPT-2 a amené l'échelle (quelle que soit la taille de l'ensemble de formation ou du modèle) à un nouveau niveau Il a collecté des millions de pages Web et créé une grande quantité de données. set WebText (40 Go). Transformer-LM avec une taille de paramètre maximale de 1,5 B a été formé, démontrant d'excellentes performances sur plusieurs tâches dans des conditions d'échantillon nul sans aucune modification de paramètre ou d'architecture de modèle. Il convient de souligner que l’approche de GPT-2 incarne pleinement l’apprentissage multitâche et le méta-apprentissage, qui peuvent être utilisés comme explication intuitive des excellentes performances de GPT-2. (extrait du texte original de GPT-2 [6] "Les modèles de langage sont des apprenants multitâches non supervisés". GPT-2 a formé une série de Transformer-LM, avec des tailles de paramètres de 117M, 345M, 762M et 1542M , respectivement. La figure montre l'amélioration continue des performances de chaque tâche à mesure que l'échelle des paramètres du modèle augmente) 5 et apprentissage en contexte Travail sur GPT-3 en 2020. [7 ], poursuivant la vision et l'itinéraire technique de GPT-2, dans l'espoir de combler les lacunes de l'annotation spécifique à une tâche et du réglage fin de chaque tâche (il existe toujours un besoin d'ensembles de données spécifiques à une tâche et d'affinement spécifiques à une tâche). tuning), dans l’espoir de construire un système universel qui ressemble aux humains, l’article souligne clairement que l’une des motivations de la recherche est de noter : 「les humains n’ont pas besoin de grands ensembles de données supervisés pour apprendre la plupart des tâches linguistiques – un bref directive en langage naturel (par exemple 『s'il vous plaît dites-moi si cette phrase décrit quelque chose de joyeux ou quelque chose de triste』) ou tout au plus un infime nombre de démonstrations (par exemple 『voici deux exemples de personnes agissant courageusement ; s'il vous plaît donnez un troisième exemple de bravoure』) est souvent suffisant pour permettre à un humain d'effectuer une nouvelle tâche avec au moins un degré raisonnable de compétence. pour effectuer une variété de tâches comme les humains. GPT-3 a encore une fois atteint un nouveau niveau

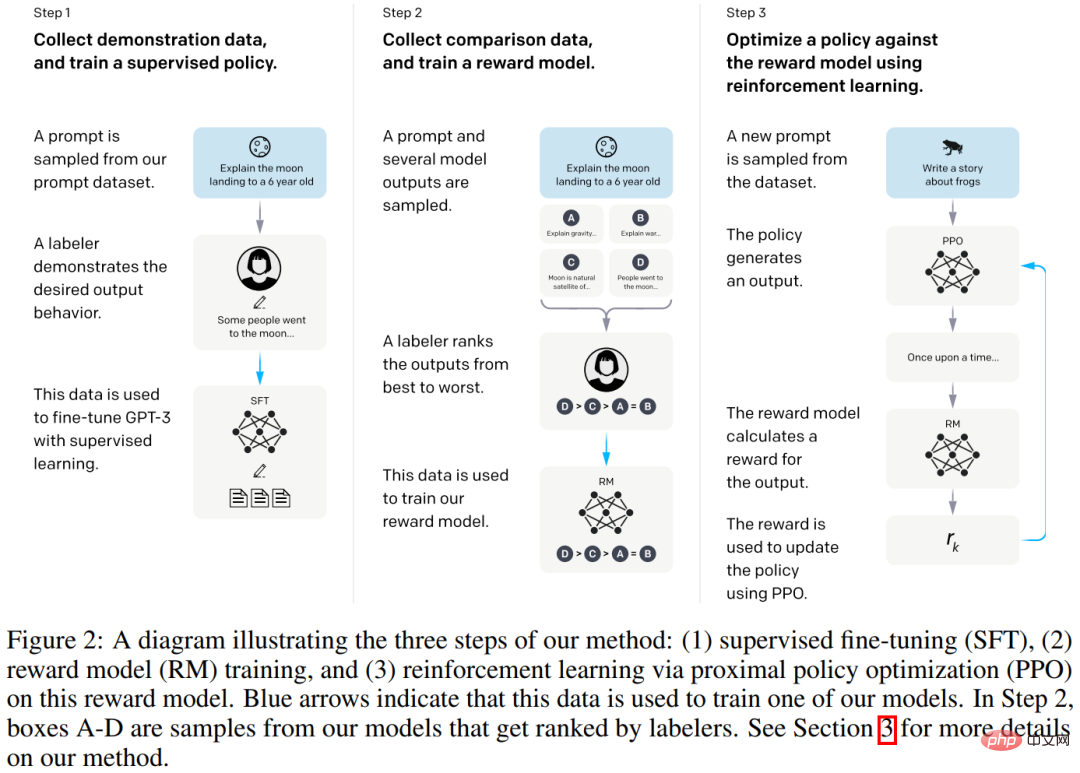

6. et Technologie RLHF La pratique actuelle du grand modèle de langage (LLM) pour la compréhension du langage naturel consiste à générer de manière récursive le symbole suivant. L’un des points de départ de la recherche InstructGPT est la considération selon laquelle, dans les conversations homme-machine, l’augmentation des modèles de langage ne les rend pas intrinsèquement plus aptes à suivre les intentions des utilisateurs. Les grands modèles linguistiques peuvent également présenter un comportement insatisfaisant, comme fabriquer des faits, générer du texte biaisé et préjudiciable, ou simplement ne pas être utiles aux utilisateurs. En effet, l'objectif de modélisation linguistiqueutilisé par de nombreux LM récents à grande échelle est de prédire le prochain jeton sur une page Web à partir d'Internet, ce qui est différent de l'objectif de « suivre les instructions de l'utilisateur de manière utile et en toute sécurité ». Par conséquent, nous disons que l’objectif de la modélisation du langage est mal aligné. Il est particulièrement important d’éviter ces comportements inattendus lors du déploiement et de l’utilisation de modèles de langage dans des centaines d’applications. En mars 2022, les travaux d'InstructGPT [8] ont démontré un moyen d'aligner les modèles de langage avec l'intention de l'utilisateur sur une gamme de tâches en affinant en fonction des commentaires humains. Le modèle résultant appelé InstructGPT. Plus précisément, comme le montre la figure 2 ci-dessous, le processus de construction d'InstructGPT se compose de trois étapes : ajustement finGPT-3 (taille 175B) , La formation aboutit à une politique encadrée. modèle de récompense) d'une taille de 6B. apprentissage par renforcement à partir du feedback humain (apprentissage par renforcement à partir du feedback humain, RLHF). Plus précisément, une méthode d'optimisation de stratégie appelée PPO est utilisée [9].

(d'après le texte original d'IntructGPT [8] "Former des modèles de langage pour suivre les instructions avec des commentaires humains")

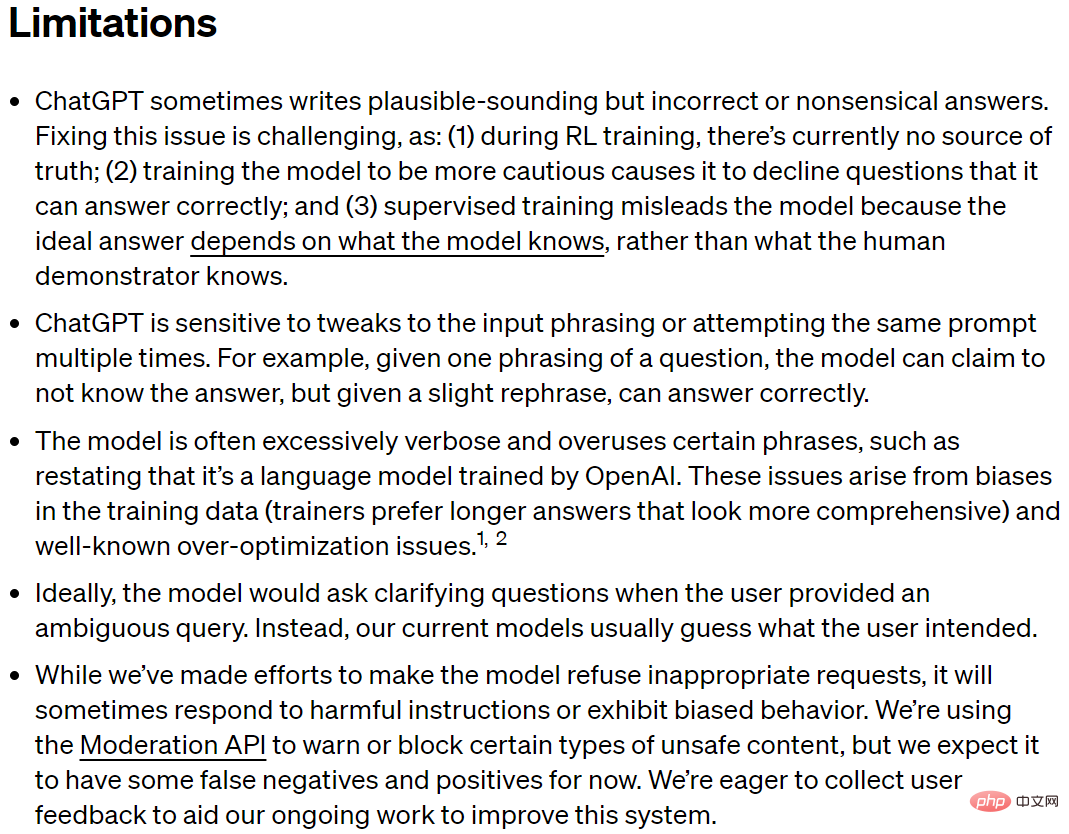

Résumé : De la recherche sur le modèle de langage, de l'architecture de réseau neuronal Transformer, du modèle de langage GPT et de la pré-formation + réglage fin, des invites GPT-2 et zéro-shot, de GPT-3 et de l'apprentissage de scénarios (apprentissage en contexte ), développé pour les technologies InstructGPT, ChatGPT et RLHF Avec le recul, cela semble être une voie technique relativement claire, mais en fait, d'autres types de modèles de langage (tels que les modèles de langage basés sur l'énergie [11]), d'autres types de neurones. Architecture de réseau (telle que le modèle d'espace d'états [12]), d'autres types de méthodes de pré-formation (telles que basées sur des modèles à variables latentes [13]), d'autres méthodes d'apprentissage par renforcement (telles que basées sur des émulateurs d'utilisateurs [14]), etc. ., se développent constamment. Dans le monde, la recherche de nouvelles méthodes ne s'est jamais arrêtée. Différentes méthodes s'inspirent et se promeuvent, formant un torrent roulant menant à l'intelligence artificielle générale, se précipitant sans fin. Un point très important tout au long des six parties de ChatGPT est l’effet d’échelle, communément appelé esthétique de la violence. Lorsque l’itinéraire est fondamentalement correct, augmenter l’échelle est un bon moyen d’améliorer les performances. 02 Lacunes de ChatGPT Limitations. Au contraire, éviter de parler de lacunes n’est pas rigoureux et ne favorise pas une compréhension globale d’une technologie. Cela peut induire le public en erreur, favoriser l’effet Eliza et même porter des jugements erronés.

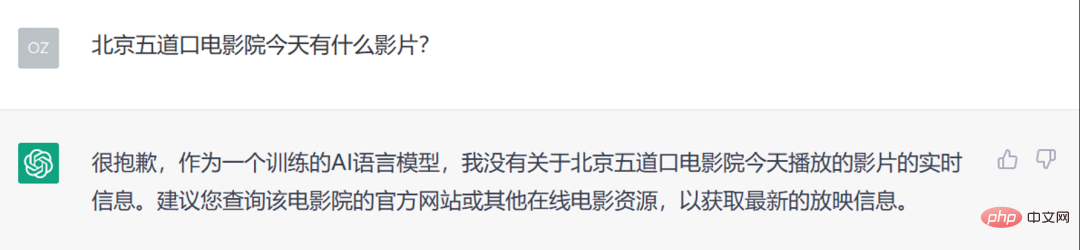

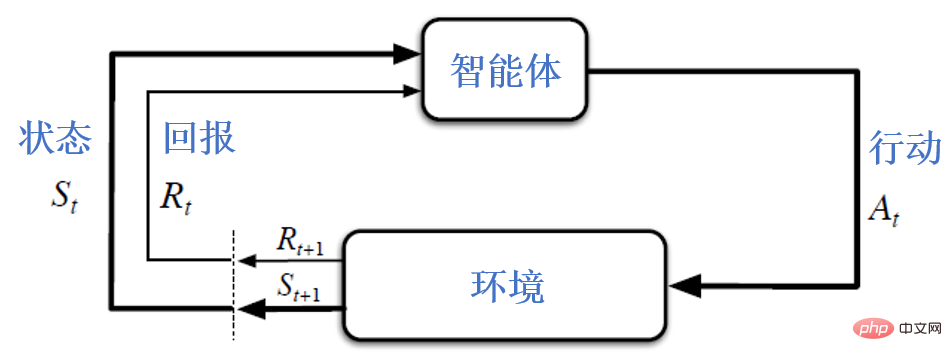

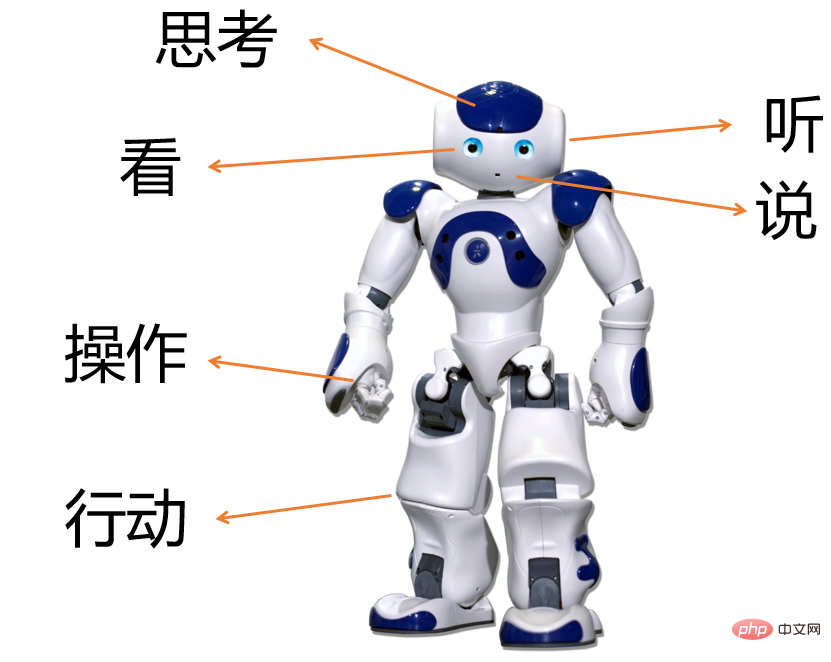

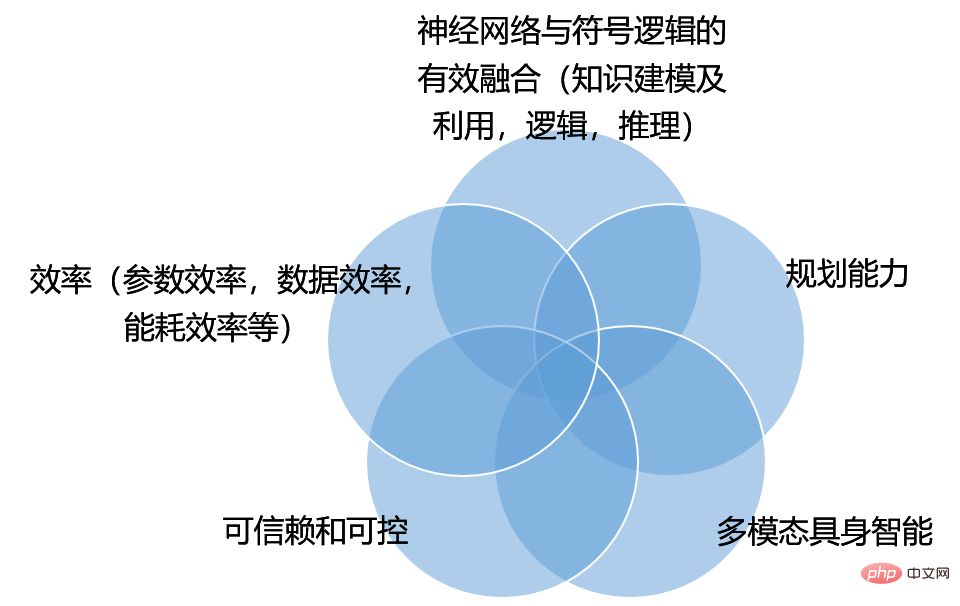

Lacunes de ChatGPT (capture d'écran du texte original de ChatGPT [10]) L1. ChatGPT écrit parfois des réponses qui semblent raisonnables mais qui sont incorrectes ou ridicules. aux ajustements du texte saisi ou à la tentative de la même invite plusieurs fois. L3. La génération de ChatGPT, est souvent trop verbeuse et abuse de certaines phrases , comme réitérer qu'il s'agit d'un modèle de langage formé par OpenAI. L4. Idéalement, lorsqu'un utilisateur fournit une requête ambiguë, le modèle devrait poser des questions qui nécessitent des éclaircissements de la part de l'autre partie. Au lieu de cela, les modèles actuels devinent souvent l’intention de l’utilisateur. L5. Bien que ChatGPT ait travaillé dur pour que le modèle rejette les demandes inappropriées, il peut encore parfois répondre à des instructions nuisibles ou présenter un comportement biaisé. Figure 4 : Exemple de ChatGPT sur la vache et l'œuf Figure 5 : Exemple sur le traitement insuffisant des informations en temps réel par ChatGPT Combinés aux lacunes décrites dans le texte original de ChatGPT [10],nous résumons les lacunes de ChatGPT dans les cinq points suivants. Ces cinq points représentent également fondamentalement les défis auxquels ChatGPT est confronté vers l'avenir et vers l'intelligence artificielle générale (AGI). Ce sont les problèmes scientifiques importants et les technologies clés qui doivent être résolus de toute urgence vers l'AGI. Il convient de souligner que le but de cet article n’est pas d’analyser les lacunes et les défis du point de vue des tâches, mais plutôt du point de vue des problèmes communs aux diverses tâches. Si les tâches sont des lignes et les problèmes des colonnes, alors notre perspective est d'analyser par colonnes. Ligne par ligne peut également donner une très bonne analyse et un très bon jugement. Lorsque nous discutons d'AGI, nous devons rompre avec les limites de nous concentrer uniquement sur le traitement du langage naturel et examiner la recherche et la technologie en matière d'intelligence artificielle dans une perspective plus large. En référence aux travaux classiques sur l'intelligence artificielle [15], l'intelligence artificielle fait référence à la recherche et à la conception d'agents intelligents. Agent intelligent (agent intelligent) fait référence à tout appareil capable observer l'environnement et entreprendre des actions pour le faire. maximiser les chances de succès, et plus encore. Le terme académique est de maximiser l'utilité attendue (utilité) ou de maximiser le rendement attendu (retour), comme le montre la figure ci-dessous. Les lecteurs attentifs constateront que la figure suivante est également couramment utilisée comme diagramme-cadre pour l’apprentissage par renforcement. En effet, il y a une déclaration similaire dans [15] : « L'apprentissage par renforcement pourrait être considéré comme englobant l'ensemble de l'IA » (l'apprentissage par renforcement peut être considéré comme englobant l'ensemble de l'intelligence artificielle). Avec ces concepts à l’esprit, comprenons les lacunes de ChatGPT. Figure 6 : L'interaction entre l'agent et l'environnement, souvent utilisée comme diagramme-cadre pour l'apprentissage par renforcement [16] 1. l'information au sérieux), il existe des lacunes évidentes dans la modélisation et l'utilisation des connaissances. Cela correspond essentiellement à la L1 introduite plus tôt, ce qui ressort clairement de l'exemple précédent. Ce que nous appelons connaissance comprend les connaissances de bon sens, les connaissances professionnelles et les informations en temps réel. Par exemple, d’un point de vue de bon sens, ChatGPT a initialement montré qu’il ne savait pas que les vaches sont des mammifères et ne peuvent pas pondre d’œufs. À en juger par les informations en temps réel, ChatGPT est essentiellement un modèle de langage autorégressif à grande échelle basé sur l'architecture Transformer. Les connaissances acquises sont limitées à ses données de formation et sa date limite est 2021. Les lecteurs peuvent essayer ChatGPT par eux-mêmes et découvrir ses lacunes à cet égard. Les lacunes ci-dessus, à un niveau plus profond, reflètent le différend de longue date entre le connectionnisme (connexionniste) et le symbolisme (symbolisme) dans l'histoire de l'intelligence artificielle. Figure 7 Le connexionnisme estime que la connaissance est enfouie dans le poids des réseaux de neurones, et entraîner un réseau de neurones à ajuster ses poids lui permet d'acquérir des connaissances. Le symbolisme préconise que la connaissance est organisée par des systèmes symboliques, tels que les bases de données relationnelles, les graphiques de connaissances, la physique mathématique et autres connaissances spécialisées, ainsi que la logique mathématique. Les deux courants de pensée se fertilisent également, comme Par conséquent, afin de surmonter les lacunes de ChatGPT en matière de modélisation et d'utilisation des connaissances, un défi majeur pour la technologie existante est l'intégration efficace des réseaux neuronaux et de la logique symbolique. Les données et les connaissances sont deux roues motrices. De nombreux travaux de recherche ont été réalisés au fil des années, mais en général, trouver une méthode d'intégration efficace nécessite encore des efforts continus. 2. ChatGPT présente des lacunes évidentes dans l'interaction de dialogue à plusieurs tours et manque de capacités de planification. Cela correspond essentiellement à L4 ci-dessus. L4 souligne simplement que ChatGPT ne posera pas de questions de clarification. Mais nous constatons des lacunes plus graves que L4 Dans le processus de construction de ChatGPT, il modélise la distribution conditionnelle P(output | input) pour la prédiction et ne fait pas de planification. Dans le cadre illustré à la figure 6, un concept très important est la planification. Le but de la planification est de maximiser l'utilité attendue. Ceci est très différent des grands modèles de langage maximisant la probabilité conditionnelle d'apparition de symboles de langage P(output | input). InstructGPT considère que le système doit suivre les intentions de l'utilisateur et utilise la technologie RLHF (apprentissage par renforcement à partir de commentaires humains) pour permettre au système de produire des résultats aligné aux questions humaines, ce qui atténue partiellement les problèmes causés par l'apprentissage supervisé sans planifier le désalignement de GPT-3. problème. Améliorer encore les capacités de planification pour maximiser l'utilité attendue sera un grand défi pour ChatGPT vers l'AGI. Alors, quelle est l'utilité du système d'interaction homme-machine ? Concernant ce point, l'article InstructGPT [8] en a discuté sous trois dimensions : utile, honnête et inoffensif. « Nous voulons que les modèles linguistiques soient utiles (ils doivent aider les utilisateurs à résoudre leurs tâches), honnêtes (ils ne doivent pas falsifier les informations ni induire les utilisateurs en erreur) et inoffensifs (ils ne doivent pas causer de préjudice physique, psychologique ou social aux personnes ou à l'environnement). ) ). "Cependant, les méthodes spécifiques de mise en œuvre doivent être explorées plus en détail, plutôt que de s'arrêter à la technologie RLHF. 3. Le comportement de ChatGPT est incontrôlable. Les êtres humains ont une sagesse socratique, c'est-à-dire "qu'ils savent qu'ils ne savent pas". C'est exactement ce qui manque au système de réseau neuronal profond actuel. Ils ne savent pas qu'ils ont tort. La plupart des systèmes de réseaux neuronaux actuels sont trop confiants et ne signalent pas les erreurs aux humains. Ils semblent néanmoins étonnamment élevés lorsqu'ils commettent des erreurs, ce qui les rend difficiles à faire confiance et à contrôler. Digne de confiance et contrôlable sera un grand défi pour AGI. 4. L'efficacité de ChatGPT est insuffisante. ChatGPT n'a pas prêté attention à ce point dans son relevé de carences. L'efficacité comprend l'efficacité des paramètres, l'efficacité des données, l'efficacité de la consommation d'énergie, etc.. ChatGPT a atteint des performances exceptionnelles en utilisant des données extrêmement volumineuses, en entraînant des modèles extrêmement volumineux et en augmentant continuellement son échelle. Cependant, à même échelle (même nombre de paramètres du modèle, même quantité ou coût d’étiquetage des données, même puissance de calcul, même consommation d’énergie), ChatGPT représente-t-il la technologie la plus avancée ? La réponse est souvent non. Par exemple, des recherches récentes ont rapporté [19] que le modèle LLaMA avec des paramètres 13B a surpassé le modèle 175B GPT-3 dans plusieurs tests de référence, de sorte que le modèle 13B LLaMA a une meilleure efficacité des paramètres. Nos propres travaux récents ont également montré qu'un modèle de dialogue de récupération de connaissances bien conçu n'utilise que 100M et que les performances dépassent largement celles d'un grand modèle de 1B. L’efficacité de la consommation énergétique est facile à comprendre, regardons l’efficacité des données. La construction actuelle de systèmes intelligents reste bloquée dans le paradigme de l’apprentissage supervisé reposant sur un grand nombre d’annotations manuelles, ce qui entraîne une faible efficacité des données. Sur la base de modèles linguistiques à grande échelle basés sur l'autorégression, il a été constaté qu'ils peuvent d'abord être formés sur une grande quantité de texte (sans annotation), puis utiliser une technologie de réglage fin ou d'invite, ce qui atténue en partie les inconvénients d'une faible efficacité des données. de la technologie actuelle d’apprentissage en profondeur, mais nécessite toujours des données d’annotation liées aux tâches. Plus le modèle est grand, plus les exigences en matière d'étiquetage sont élevées. Comment utiliser de manière plus efficace et collaborative les données étiquetées et non étiquetées est un défi pour atteindre l'efficacité des données. 5. L'intelligence incarnée multimodale est un contenu important dans l'exploration de l'AGI. ChatGPT se limite à la saisie et à la sortie de texte, et les nombreuses erreurs qu'il commet illustrent également son sérieux manque de sémantique, de connaissances et de raisonnement causal. La signification des mots semble résider dans leur cooccurrence statistique plutôt que dans leur base réelle. Ainsi, même si les futurs modèles linguistiques deviennent de plus en plus grands, ils fonctionnent toujours mal sur le plan du bon sens physique de base. L'intelligence est bien plus que la capacité linguistique. L'élément de base de l'intelligence biologique réside dans la capacité des animaux à avoir une interaction sensorielle-motrice avec le monde[20]. Les machines intelligentes du futur n’auront peut-être pas nécessairement une forme humaine, mais l’interaction multimodale entre la machine et l’environnement à travers le corps pour écouter, parler, lire, écrire, penser, manipuler des objets, agir, etc. favorisera grandement la développement de l’intelligence artificielle. Cela aidera également l’intelligence artificielle à transcender les limites d’une seule modalité de texte et à mieux aider les humains. Résumé : D'un point de vue linguistique, la Connaissance du langage comprend la structure et les caractéristiques des mots - la morphologie et le vocabulaire (lexique), la façon dont les mots forment des phrases et des phrases - la syntaxe, la signification des morphèmes, des mots, des phrases, phrases et discours - sémantique [21]. ChatGPT a acquis des connaissances linguistiques considérables (en particulier des connaissances inférieures au niveau sémantique) grâce à un très grand modèle, a une certaine capacité de compréhension du langage et peut générer des phrases fluides, mais il y a aussi des lacunes évidentes : Compte tenu de ces lacunes, nous avons résolu plusieurs défis auxquels ChatGPT est confronté et s'oriente vers l'intelligence artificielle générale (AGI) à l'avenir, comme le montre la figure 8, et a également souligné plusieurs contenus de recherche importants. Il convient de souligner que les domaines de recherche de chaque domaine ne sont pas isolés, mais se croisent. Par exemple, dans l'étude de la fiabilité et de la contrôlabilité, on espère que les résultats du système sont conformes aux normes sociales, donc comment refléter ces normes sociales dans l'utilité du système, afin que les résultats de la planification du système puissent se conformer aux normes sociales. Il existe donc un chevauchement entre la recherche sur la contrôlabilité des systèmes et la recherche sur l’amélioration des capacités de planification des systèmes. Pour un autre exemple, comment intégrer les connaissances dans la planification et la prise de décision systématiques ? Figure 8 : Défis envers l'AGI ChatGPT est un événement important dans la recherche sur l'intelligence artificielle. Il est très important d'avoir une compréhension rigoureuse de ses progrès, de ses lacunes et des défis futurs vers l'AGI. Nous pensons qu'en recherchant la vérité et en étant pragmatiques, et en innovant constamment, nous pouvons promouvoir le développement de l'intelligence artificielle vers de nouveaux sommets. Nous invitons tout le monde à discuter et à nous corriger, merci !

1

1

(Ce qui précède est tous du texte GPT-3 d'origine [7] "Les modèles de langue sont des apprenants à quelques tirs")

(Ce qui précède est tous du texte GPT-3 d'origine [7] "Les modèles de langue sont des apprenants à quelques tirs")

04 Conclusion

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI