Maison >Périphériques technologiques >IA >Tellement cool que ça explose ! La démonstration en ligne HuggingGPT a fait une apparition époustouflante et les internautes ont testé la génération d'images en personne

Tellement cool que ça explose ! La démonstration en ligne HuggingGPT a fait une apparition époustouflante et les internautes ont testé la génération d'images en personne

- 王林avant

- 2023-04-10 14:39:281605parcourir

La combinaison la plus puissante HuggingFace+ChatGPT="Jarvis" est maintenant ouverte en démo.

Il y a quelque temps, l'Université du Zhejiang et Microsoft ont lancé HuggingGPT, un système de collaboration à grande échelle qui est devenu un succès instantané.

Les chercheurs ont proposé d'utiliser ChatGPT comme contrôleur pour connecter divers modèles d'IA de la communauté HuggingFace afin d'effectuer des tâches complexes multimodales.

Dans l'ensemble du processus, tout ce que vous avez à faire est de : présenter vos exigences en langage naturel.

Les scientifiques de NVIDIA ont déclaré que c'était l'article le plus intéressant que j'ai lu cette semaine. Son idée est très proche de la "Everything App" que j'ai évoquée précédemment, c'est-à-dire que tout est une App, et les informations sont directement lues par l'IA.

Démarrez l'expérience

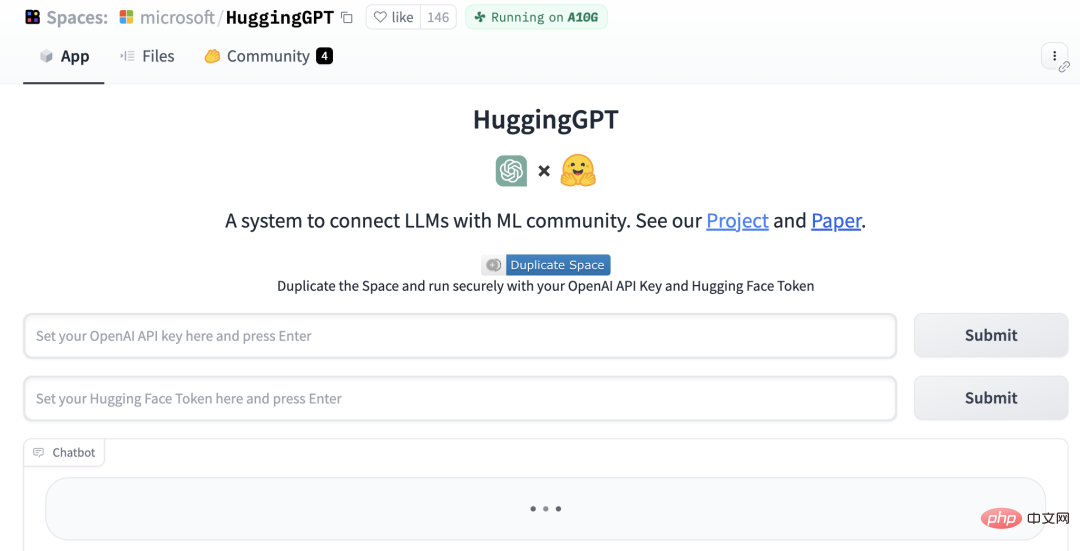

Maintenant, HuggingGPT a ajouté la démo Gradio.

Adresse du projet : https://github.com/microsoft/JARVIS

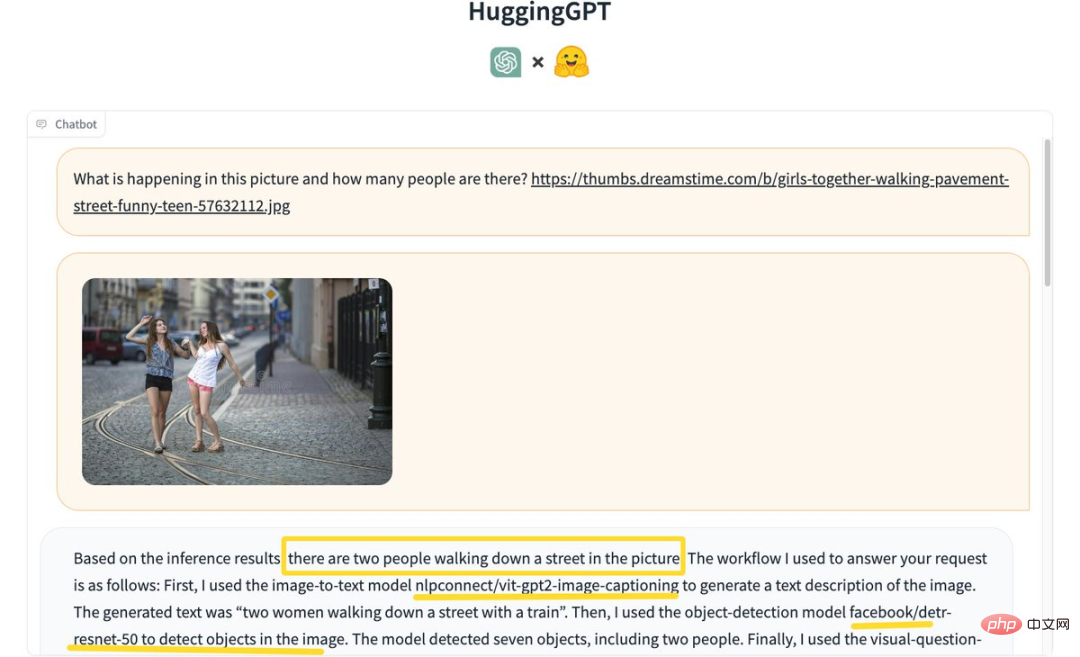

D'abord, « Reconnaître combien de personnes sont sur la photo » ?

HuggingGPT, sur la base des résultats d'inférence, a conclu qu'il y a 2 personnes marchant dans la rue sur la photo.

Le processus spécifique est le suivant :

Utilisez d'abord l'image pour envoyer un texte au modèle nlpconnect/vit-gpt2-image-captioning pour décrire l'image, et le texte généré "2 femmes marchant dans une rue avec un train ".

Ensuite, le modèle de détection d'objets facebook/detrresnet 50 est utilisé pour détecter le nombre de personnes sur la photo. Le modèle a détecté 7 objets et 2 personnes.

Ensuite, utilisez le modèle de réponse visuelle aux questions dandelin/vilt-b32-finetuned-vqa pour obtenir les résultats. Enfin, le système fournit des réponses détaillées et des informations modèles pour répondre à la question.

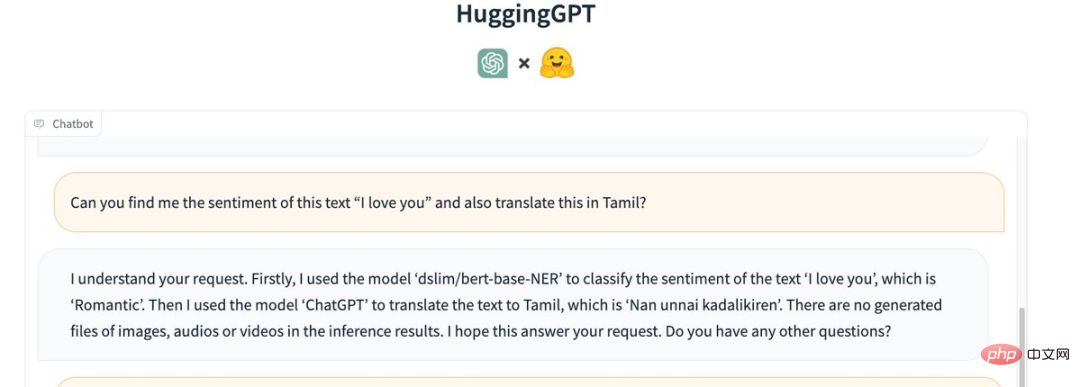

Aussi, faites-lui comprendre l'émotion de la phrase "Je t'aime" et traduisez-la en tamoul (Tamiḻ).

HuggingGPT a appelé le modèle suivant :

Tout d'abord, le modèle "dslim/bert-base-NER" a été utilisé pour classer l'émotion du texte "je t'aime", qui est "romantique".

Ensuite, utilisez « ChatGPT » pour traduire le texte en tamoul, qui est « Nan unnai kadalikiren ».

Il n'y a aucune image, fichier audio ou vidéo généré dans les résultats d'inférence.

HuggingGPT a échoué lors de la transcription des fichiers MP3. Un internaute a déclaré : « Je ne sais pas s'il s'agit d'un problème avec mon fichier d'entrée. »

Regardons les capacités de génération d'images.

Entrez l'image "Un chat dansant" et ajoutez le texte "Je t'aime" en superposition.

HuggingGPT a d'abord utilisé le modèle "runwayml/stable-diffusion-1-5" pour générer une image de "chat dansant" basée sur le texte donné.

Ensuite, le même modèle a été utilisé pour générer une image de "I LOVE YOU" basée sur le texte donné.

Enfin, fusionnez les deux images ensemble et le résultat est le suivant :

Jarvis devient réalité

Quelques jours seulement après que le projet a été rendu public, Jarvis a déjà reçu 12,5k étoiles et 811 étoiles sur le fork GitHub. .

Les chercheurs ont souligné que la résolution des problèmes actuels des grands modèles de langage (LLM) pourrait être la première et cruciale étape vers l'AGI.

Étant donné que la technologie actuelle des grands modèles de langage présente encore certaines lacunes, il existe des défis urgents sur la voie de la construction de systèmes AGI.

Pour gérer des tâches d'IA complexes, les LLM doivent être capables de se coordonner avec des modèles externes pour exploiter leurs capacités.

Par conséquent, le point clé est de savoir comment choisir le middleware approprié pour relier les LLM et les modèles d'IA.

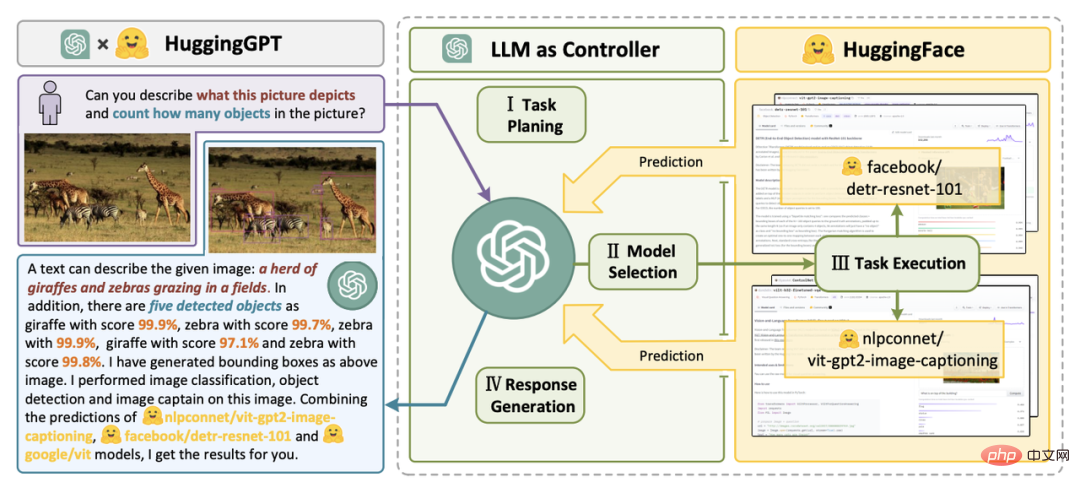

Dans ce document de recherche, le chercheur propose que le langage soit une interface universelle dans HuggingGPT. Son flux de travail est principalement divisé en quatre étapes :

Adresse papier : https://arxiv.org/pdf/2303.17580.pdf

La première est la planification des tâches. ChatGPT analyse les demandes des utilisateurs et les convertit. Décomposez-le en plusieurs tâches et planifiez la séquence de tâches et les dépendances en fonction de ses connaissances.

Ensuite, procédez à la sélection du modèle. LLM attribue des tâches analysées à des modèles experts en fonction de la description du modèle dans HuggingFace.

Ensuite, effectuez la tâche. Le modèle expert exécute les tâches assignées sur le point de terminaison d'inférence et enregistre les informations d'exécution et les résultats d'inférence dans le LLM.

La dernière étape est la génération de réponses. LLM résume les journaux du processus d'exécution et les résultats d'inférence, et renvoie le résumé à l'utilisateur.

Supposons qu'une telle demande soit donnée :

Veuillez générer une photo d'une fille lisant un livre, sa posture est la même que celle du garçon dans l'exemple.jpg. Utilisez ensuite votre voix pour décrire la nouvelle image.

Vous pouvez voir comment HuggingGPT le décompose en 6 sous-tâches et sélectionne respectivement le modèle à exécuter pour obtenir le résultat final.

En incorporant des descriptions de modèles d'IA dans les invites, ChatGPT peut être considéré comme le cerveau qui gère les modèles d'IA. Par conséquent, cette méthode permet à ChatGPT d'appeler des modèles externes pour résoudre des tâches pratiques.

Pour parler simplement, HuggingGPT est un système de collaboration, pas un grand modèle.

Sa fonction est de connecter ChatGPT et HuggingFace pour traiter les entrées selon différentes modalités et résoudre de nombreuses tâches complexes d'intelligence artificielle.

Ainsi, chaque modèle d'IA de la communauté HuggingFace a une description de modèle correspondante dans la bibliothèque HuggingGPT et est intégrée dans l'invite pour établir une connexion avec ChatGPT.

HuggingGPT utilise ensuite ChatGPT comme cerveau pour déterminer la réponse à la question.

Jusqu'à présent, HuggingGPT a intégré des centaines de modèles sur HuggingFace autour de ChatGPT, couvrant 24 tâches telles que la classification de texte, la détection de cible, la segmentation sémantique, la génération d'images, les questions et réponses, la synthèse vocale et la synthèse texte-vidéo.

Les résultats expérimentaux prouvent que HuggingGPT peut montrer de bonnes performances sur diverses formes de tâches complexes.

Commentaires chauds des internautes

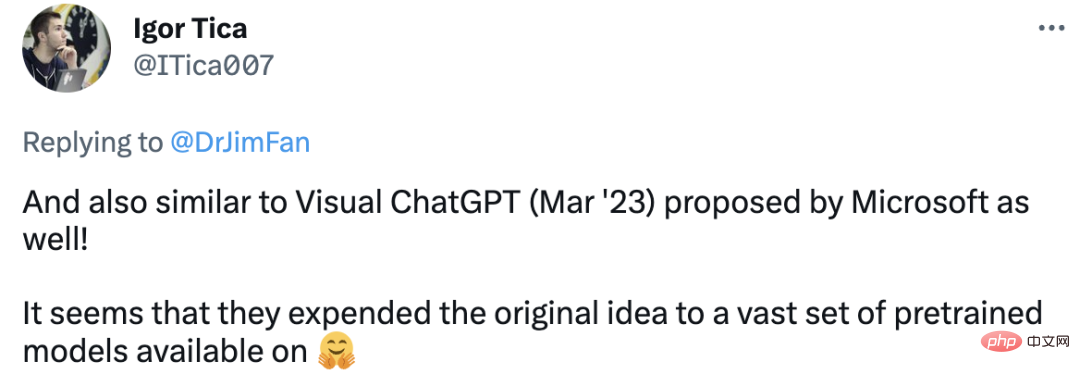

Certains internautes ont déclaré que HuggingGPT est similaire au Visual ChatGPT précédemment proposé par Microsoft. Il semble qu'ils aient étendu l'idée originale à un vaste ensemble de modèles pré-entraînés.

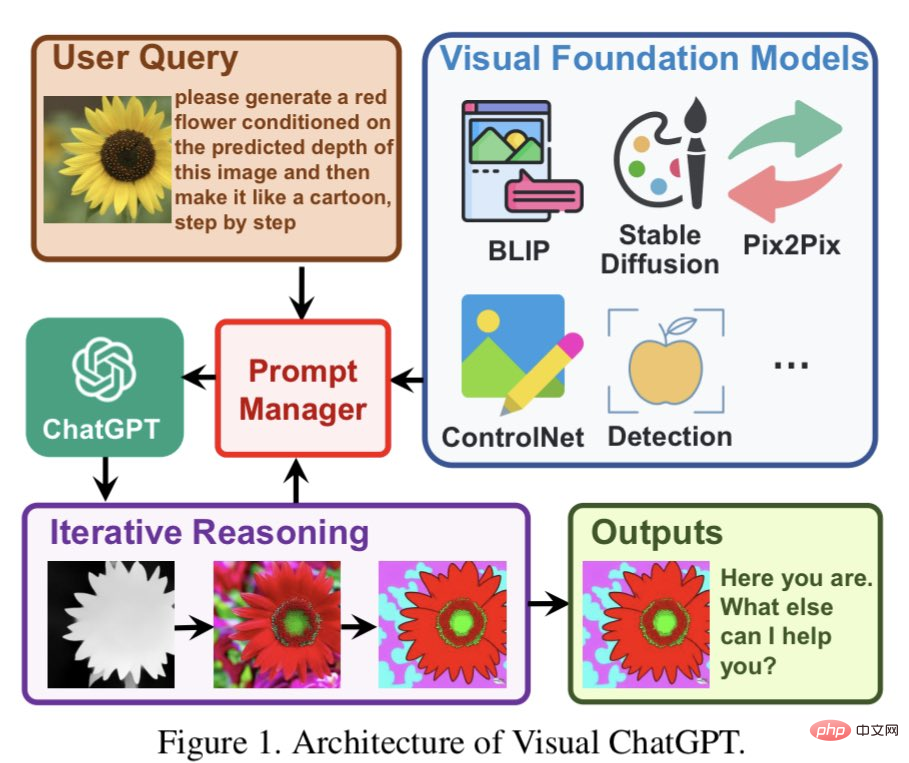

Visual ChatGPT est construit directement sur ChatGPT et y injecte de nombreux modèles visuels (VFM). Prompt Manage est proposé dans l’article.

Avec l'aide des PM, ChatGPT peut utiliser ces VFM et recevoir leurs commentaires de manière itérative jusqu'à ce que les exigences de l'utilisateur soient satisfaites ou que la condition finale soit atteinte.

Certains internautes pensent que cette idée est en effet très similaire à ChatGPT. Utiliser LLM comme centre de compréhension sémantique et de planification des tâches peut améliorer infiniment les capacités de LLM. En combinant LLM avec d'autres experts fonctionnels ou spécialisés, nous pouvons créer des systèmes d'IA plus puissants et plus flexibles, capables de mieux s'adapter à une variété de tâches et de besoins.

C'est ce que j'ai toujours pensé de l'AGI, des modèles d'intelligence artificielle capables de comprendre des tâches complexes puis d'attribuer des tâches plus petites à d'autres modèles d'IA plus professionnels.

Tout comme le cerveau, il comporte également différentes parties pour accomplir des tâches spécifiques, ce qui semble très logique.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI