Maison >Périphériques technologiques >IA >Des méta-chercheurs créent un cortex visuel artificiel qui permet aux robots d'opérer visuellement

Des méta-chercheurs créent un cortex visuel artificiel qui permet aux robots d'opérer visuellement

- PHPzavant

- 2023-04-10 14:31:061599parcourir

Des chercheurs du département de recherche en IA de Meta ont récemment publié une annonce annonçant des progrès clés dans la coordination des compétences adaptatives des robots et la réplication du cortex visuel. Ils affirment que ces avancées permettent aux robots basés sur l’IA de fonctionner dans le monde réel grâce à la vision et sans avoir besoin d’acquérir de données du monde réel.

Ils affirment qu'il s'agit d'une avancée majeure dans la création de robots « IA incorporés » à usage général qui peuvent interagir avec le monde réel sans intervention humaine. Les chercheurs ont également déclaré avoir créé un cortex visuel artificiel appelé « VC-1 » qui a été formé sur l'ensemble de données Ego4D, qui enregistre les activités quotidiennes de milliers de participants à la recherche à travers le monde.

Comme l'expliquent les chercheurs dans un article de blog précédemment publié, le cortex visuel est la zone du cerveau qui permet aux organismes de convertir la vision en mouvement. Par conséquent, disposer d’un cortex visuel artificiel est une exigence clé pour tout robot devant effectuer des tâches basées sur la scène qui se trouve devant lui.

Étant donné que le cortex visuel artificiel « VC-1 » est nécessaire pour effectuer une gamme de tâches sensorimotrices différentes dans une variété d'environnements, l'ensemble de données Ego4D joue un rôle particulièrement important car il contient les données que les participants à l'étude portent. Les caméras enregistrent des milliers d'heures de vidéo d'activités quotidiennes, notamment la cuisine, le ménage, l'exercice, l'artisanat, etc.

Les chercheurs ont déclaré : « Les organismes biologiques possèdent un cortex visuel universel, qui est l'agent de représentation que nous recherchons. Par conséquent, nous avons décidé de créer un ensemble de données performant dans plusieurs tâches, en utilisant Ego4D comme ensemble de données de base, et d'améliorer. VC-1 en ajoutant des ensembles de données supplémentaires. Étant donné qu'Ego4D se concentre principalement sur les activités quotidiennes telles que la cuisine, le jardinage et l'artisanat, nous avons également adopté un ensemble de données de vidéos égocentriques explorant les maisons et les appartements. "

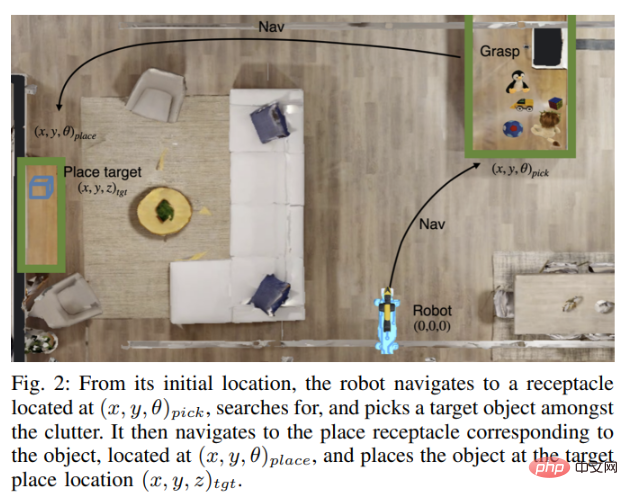

Cependant, la vision n'est qu'un élément de la vision. « IA incarnée ». Pour qu'un robot fonctionne de manière totalement autonome dans le monde réel, il doit également être capable de manipuler des objets du monde réel. Le robot a besoin de vision pour naviguer, trouver et transporter un objet, le déplacer vers un autre emplacement, puis le placer correctement : toutes les actions qu'il effectue de manière autonome en fonction de ce qu'il voit et entend.

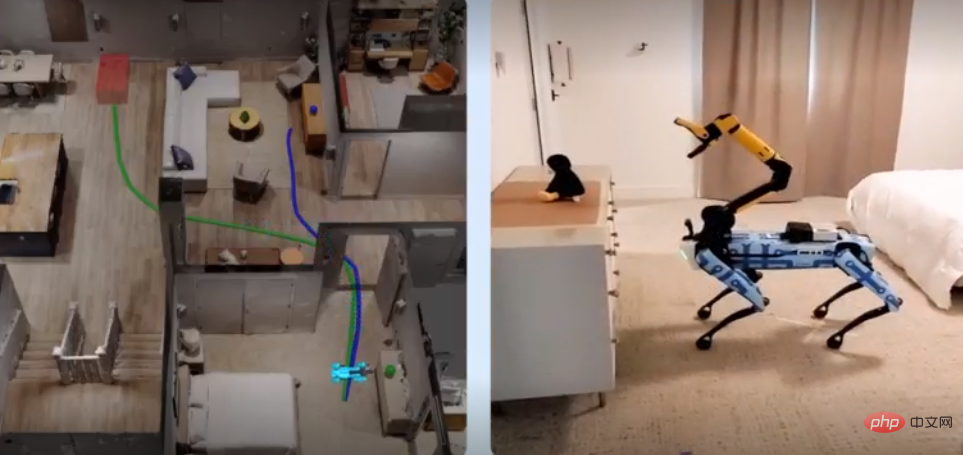

Pour résoudre ce problème, les experts en IA de Meta ont collaboré avec des chercheurs du Georgia Institute of Technology pour développer une nouvelle technologie appelée Adaptive Skill Coordination (ASC), que les robots utilisent pour simuler puis entraîner ces compétences sont reproduites dans des robots du monde réel.

Meta a également coopéré avec Boston Dynamics pour démontrer l'efficacité de sa technologie ASC. Les deux sociétés ont combiné la technologie ASC avec le robot Spot de Boston Dynamics pour donner à son robot de puissantes capacités de détection, de navigation et de manipulation, même si cela nécessite également une intervention humaine importante. Par exemple, pour choisir un objet, quelqu'un doit cliquer sur l'objet affiché sur la tablette du robot.

Les chercheurs ont écrit dans l'article : « Notre objectif est de construire un modèle d'IA capable de percevoir le monde à partir de capteurs embarqués et de commandes motrices via l'API Boston Dynamics. »

Le robot Spot a été testé à l'aide du simulateur Habitat, que The L'environnement de simulation a été créé à l'aide des ensembles de données HM3D et ReplicaCAD, qui contiennent des données de numérisation 3D intérieures de plus de 1 000 maisons. Le robot Spot a ensuite été entraîné à se déplacer dans une maison qu’il n’avait jamais vue auparavant, en transportant des objets et en les plaçant aux endroits appropriés. Les connaissances et les informations acquises par les robots Spot formés sont ensuite répliquées sur les robots Spot opérant dans le monde réel, qui effectuent automatiquement les mêmes tâches en fonction de leur connaissance de l'agencement de la maison.

Les chercheurs ont écrit : « Nous avons testé le robot Spot dans deux environnements réels très différents, un appartement entièrement meublé de 185 mètres carrés et un laboratoire universitaire de 65 mètres carrés, nécessitant que le robot Spot re- Placez une variété d'objets. Dans l'ensemble, le robot Spot doté de la technologie ASC a fonctionné presque parfaitement, réussissant 59 fois sur 60 tests, surmontant l'instabilité matérielle, les pannes de collecte et les interférences adverses telles que le déplacement d'obstacles ou le blocage de chemins ", ont déclaré les chercheurs de Meta. qu'ils ont également ouvert le code source du modèle VC-1 et partagé des détails sur la façon de mettre à l'échelle la taille du modèle, la taille de l'ensemble de données, etc. dans un autre article. En attendant, la prochaine priorité de l'équipe sera d'essayer d'intégrer VC-1 à ASC pour créer un système d'IA de représentation plus humain.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI