Maison >Périphériques technologiques >IA >Pour la première fois : Microsoft utilise GPT-4 pour affiner les instructions des grands modèles, et les performances sans échantillon des nouvelles tâches sont encore améliorées.

Pour la première fois : Microsoft utilise GPT-4 pour affiner les instructions des grands modèles, et les performances sans échantillon des nouvelles tâches sont encore améliorées.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-10 14:21:081849parcourir

Nous savons que des modèles Google T5 aux grands modèles de la série OpenAI GPT, les grands modèles de langage (LLM) ont démontré des capacités de généralisation impressionnantes, telles que l'apprentissage contextuel et le raisonnement en chaîne de pensée. Dans le même temps, afin de permettre aux LLM de suivre les instructions en langage naturel et d’effectuer des tâches du monde réel, les chercheurs ont exploré des méthodes de réglage fin des instructions pour les LLM. Cela se fait de deux manières : en utilisant des invites et des commentaires annotés par l'homme pour affiner les modèles sur un large éventail de tâches, ou en utilisant des références et des ensembles de données publics complétés par des instructions générées manuellement ou automatiquement pour superviser le réglage fin.

Parmi ces méthodes, le réglage fin de l'auto-instruction est une méthode simple et efficace qui apprend de l'instruction en suivant les données générées par les LLM des enseignants de réglage fin de l'instruction SOTA, afin que les LLM soient alignés sur les intentions humaines. Les faits ont prouvé que le réglage fin de l’enseignement est devenu un moyen efficace d’améliorer les capacités de généralisation des LLM sur échantillons nuls et sur petits échantillons.

Le succès récent de ChatGPT et GPT-4 offre une énorme opportunité d'utiliser le réglage fin des instructions pour améliorer les LLM open source. Meta LLaMA est une famille de LLM open source avec des performances comparables aux LLM propriétaires tels que GPT-3. Pour apprendre à LLaMA à suivre les instructions, l'auto-instruction a été rapidement adoptée en raison de ses performances supérieures et de son faible coût. Par exemple, le modèle Alpaca de Stanford utilise 52 000 échantillons de conformité de commandes générés par GPT-3.5, et le modèle Vicuna utilise environ 70 000 échantillons de conformité de commandes de ShareGPT.

Afin de faire progresser le niveau SOTA de réglage fin de l'enseignement des LLM, Microsoft Research a utilisé GPT-4 comme modèle d'enseignant pour le réglage fin de l'auto-instruction pour la première fois dans son article "Instruction Tuning with GPT-4". ".

- Adresse papier : https://arxiv.org/pdf/2304.03277.pdf

- Adresse du projet : https://instruction-tuning-with-gpt-4.github. io/

- Adresse GitHub : https://github.com/Instruction-Tuning-with-GPT-4/GPT-4-LLM

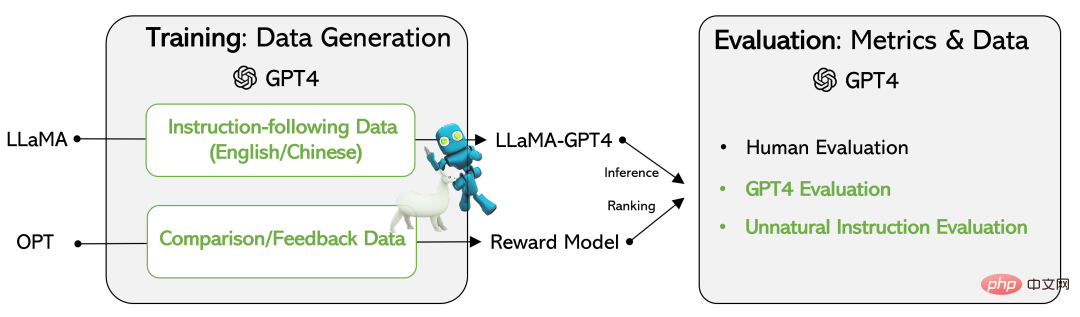

Chercheur publié sur celui-ci main Les données générées par GPT-4 incluent l'ensemble de données de conformité aux instructions de 52 000 en chinois et en anglais, ainsi que les données de retour générées par GPT-4 pour évaluer la sortie des trois modèles de réglage fin des instructions.

D'autre part, un modèle LLaMA de réglage fin des instructions et un modèle de récompense ont été développés sur la base des données générées par GPT-4. Pour évaluer la qualité des LLM de réglage fin des instructions, les chercheurs ont évalué les échantillons de test à l'aide de trois mesures : évaluation manuelle de trois critères d'alignement, évaluation automatique basée sur le retour GPT-4 et ROUGE-L (méthode d'évaluation de synthèse automatisée) des instructions non naturelles. . un).

Les résultats expérimentaux vérifient l'efficacité du réglage fin des instructions LLM à l'aide des données générées par GPT-4. Les 52 000 données de conformité aux instructions en chinois et en anglais générées par GPT-4 permettent d'obtenir de meilleures performances sans échantillon sur les nouvelles tâches que les modèles SOTA précédents. Actuellement, les chercheurs ont divulgué les données générées à l'aide de GPT-4 et du code associé.

Ensembles de données

Cette étude utilise GPT-4 pour générer les quatre ensembles de données suivants :

- Données de suivi des instructions en anglais : pour 52 000 instructions collectées auprès d'Alpaga, chaque instruction est fournie avec une réponse GPT-4 en anglais. Cet ensemble de données est principalement utilisé pour explorer et comparer les statistiques des réponses GPT-4 et des réponses GPT-3.

- Données de suivi des instructions chinoises : cette étude a utilisé ChatGPT pour traduire 52 000 instructions en chinois et a demandé à GPT-4 de répondre en chinois.

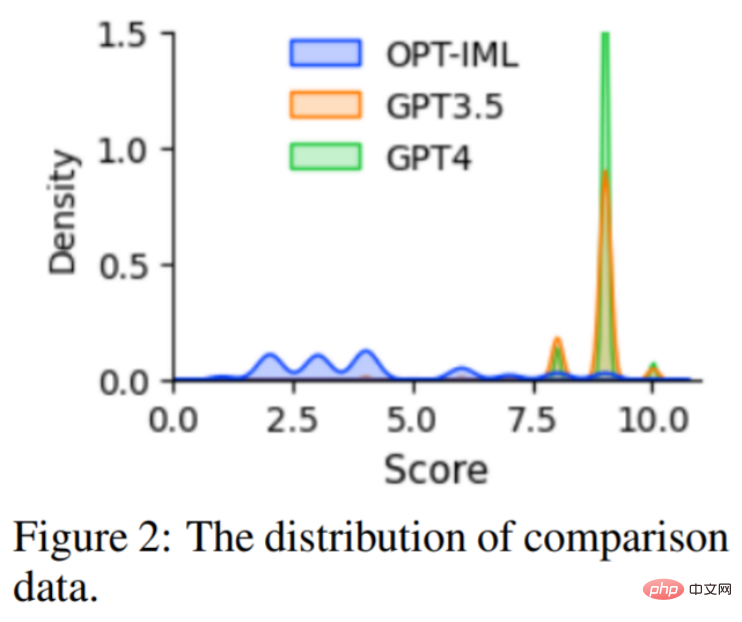

- Données de comparaison : laissez GPT-4 évaluer votre réponse sur une échelle de 1 à 10. De plus, l'étude a demandé à GPT-4 de comparer et de noter les réponses de trois modèles : GPT-4, GPT-3.5 et OPT-IML. Cet ensemble de données est principalement utilisé pour former des modèles de récompense.

- Réponses sur les instructions non naturelles : les réponses de GPT-4 sont décodées sur les trois ensembles de données de base de 68 000 instructions-entrées-sorties. Ce sous-ensemble est utilisé pour quantifier l'écart entre GPT-4 et le modèle de réglage fin des instructions.

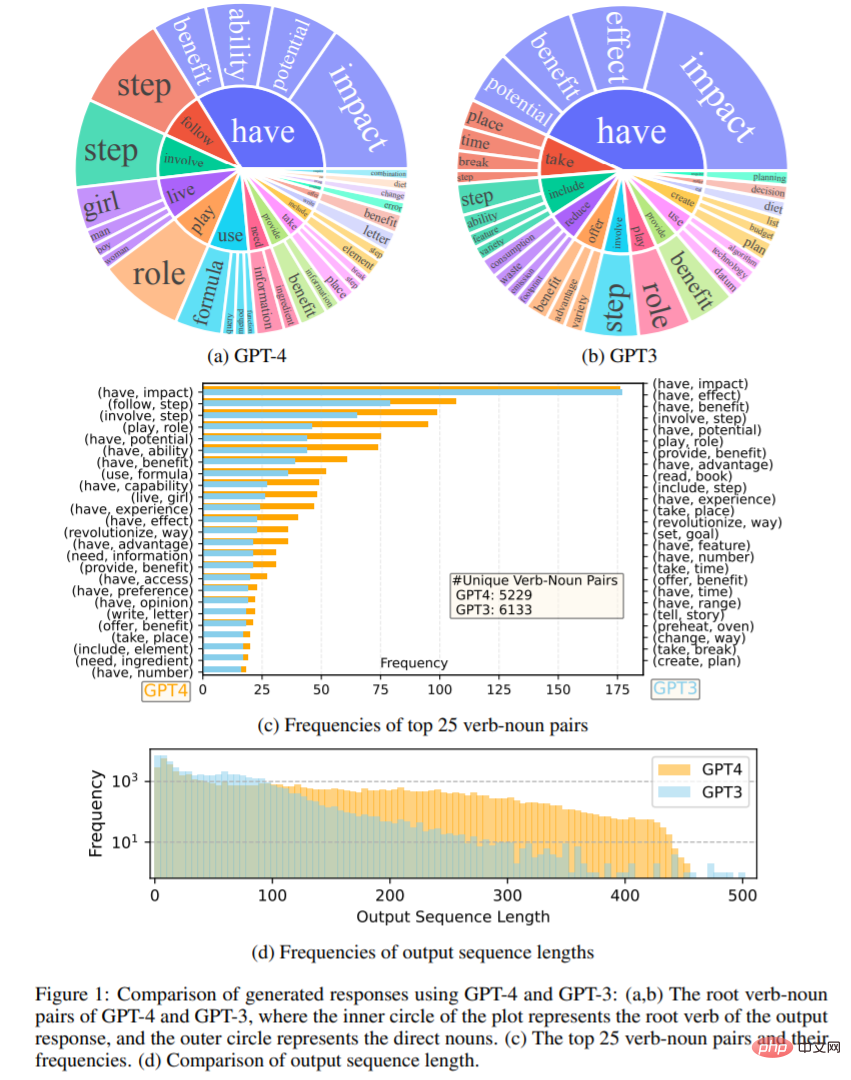

La figure 1 compare les ensembles de réponses de sortie en anglais de GPT-4 et GPT-3.5. Les figures 1 (a) et (b) montrent deux ensembles de sorties de paires verbe-nom avec une fréquence supérieure à 10. La figure 1 (c) compare les 25 paires de mots les plus fréquentes dans les deux ensembles. distribution de fréquence des longueurs de séquence, et les résultats montrent que GPT-4 a tendance à générer des séquences plus longues que GPT-3.5.

Modèle linguistique de réglage fin des instructions

Cette étude est basée sur le point de contrôle LLaMA 7B et utilise un réglage fin supervisé pour former deux modèles : (i) LLaMA-GPT4, sur 52 000 données de conformité des instructions en anglais générées par Train GPT-4. (ii) LLaMA-GPT4-CN, formé sur l'instruction chinoise 52K, suit les données générées à partir de GPT-4.

Modèle de récompense

L'apprentissage par renforcement avec rétroaction humaine (RLHF) vise à rendre le comportement LLM cohérent avec les préférences humaines. La modélisation des récompenses est l'un de ses éléments clés. Ce problème est souvent formulé comme une tâche de régression. prédire la récompense entre un signal donné et une réponse. Cependant, cette méthode nécessite généralement des données comparatives à grande échelle. Les modèles open source existants tels que Alpaca, Vicuna et Dolly n'impliquent pas RLHF en raison du coût élevé de l'annotation des données comparatives. Dans le même temps, des recherches récentes montrent que GPT-4 est capable d'identifier et de réparer ses propres erreurs et de juger avec précision la qualité des réponses. Par conséquent, pour faciliter la recherche sur le RLHF, cette étude a créé des données comparatives à l'aide de GPT-4, comme décrit ci-dessus.

Pour évaluer la qualité des données, l'étude a également formé un modèle de récompense basé sur OPT 1.3B pour l'évaluation de cet ensemble de données. La distribution des données de comparaison est illustrée à la figure 2 .

Expérience

Cette étude utilise les trois types d'évaluations suivants : l'évaluation humaine, le GPT-4 et l'évaluation des instructions non naturelles. Les résultats confirment que l'utilisation des données générées par GPT-4 est une méthode efficace et efficiente pour affiner les instructions LLM par rapport à d'autres données générées par la machine. Nous examinons ensuite le processus expérimental spécifique.

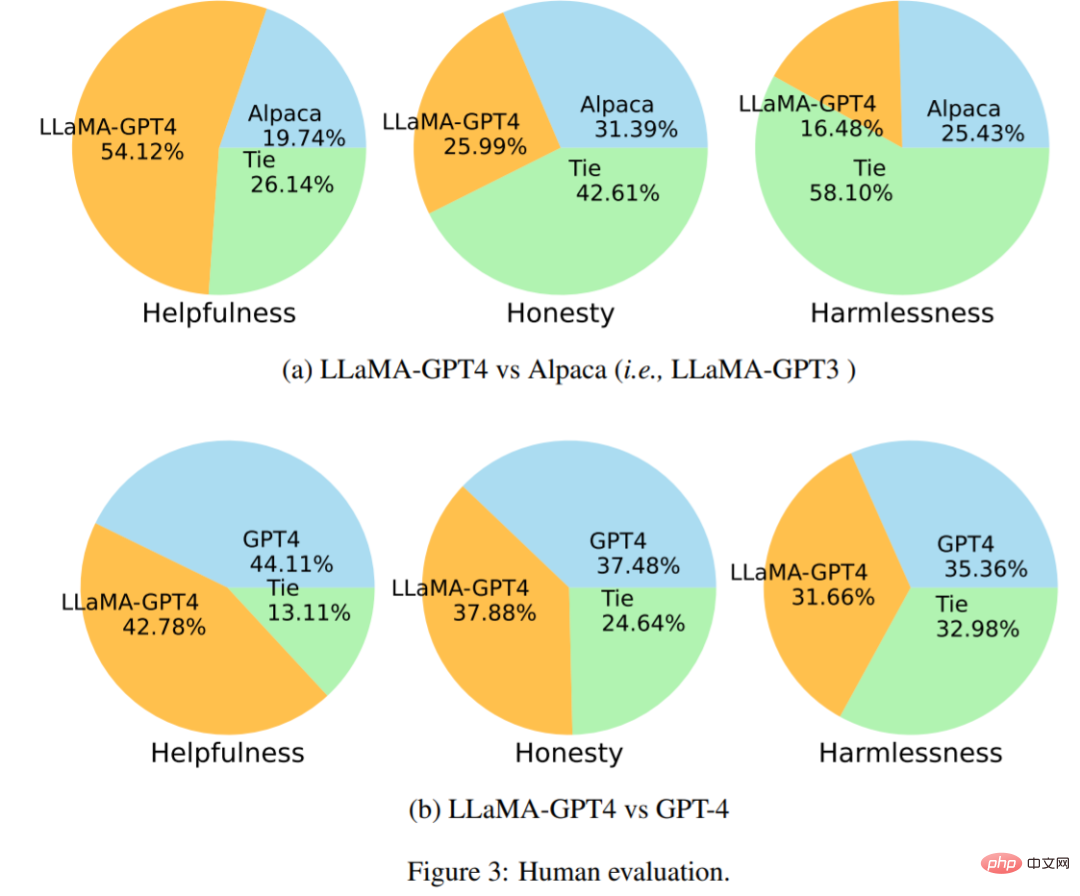

Évaluation humaine

La figure 3 (a) montre les résultats de la comparaison LLaMA-GPT4 vs Alpaca. L'expérience montre que sous l'indicateur d'utilité, GPT-4 gagne avec un score de 54,12 %. La figure 3 (b) montre les résultats de comparaison de LLaMA-GPT4 par rapport à GPT-4, ce qui montre que les performances de LLaMA affinées par les instructions GPT-4 sont similaires à celles du GPT-4 d'origine.

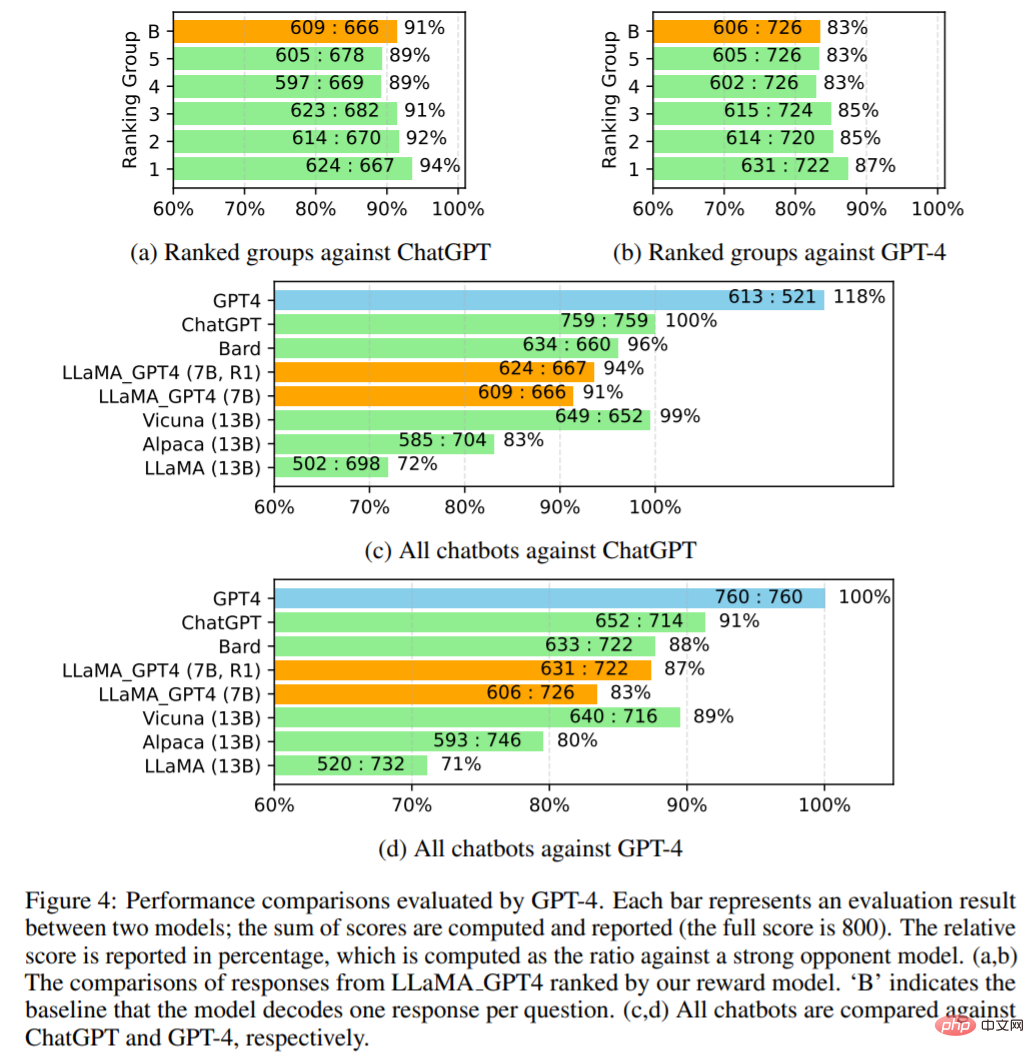

Comparez avec SOTA en utilisant l'évaluation automatique

Cette étude utilise GPT-4 pour évaluer automatiquement les réponses de différents modèles sur 80 questions inédites. Collectez d'abord les réponses de deux chatbots, LLaMA-GPT-4 (7B) et GPT-4, et publiez les réponses à l'aide d'autres chatbots, notamment LLaMA (13B), Alpaca (13B), Vicuna (13B), Bard (Google, 2023) et ChatGPT. Pour chaque évaluation, l'étude a demandé à GPT-4 d'évaluer la qualité de la réponse entre les deux modèles sur une échelle de 1 à 10. Les résultats sont présentés dans la figure 4.

La figure 4 (c,d) compare tous les chatbots. LLaMA_GPT4 est plus performant : 7B LLaMA GPT4 est plus performant que 13B Alpaca et LLaMA. Cependant, LLaMA_GPT4 présente encore un écart par rapport aux grands chatbots commerciaux tels que GPT-4.

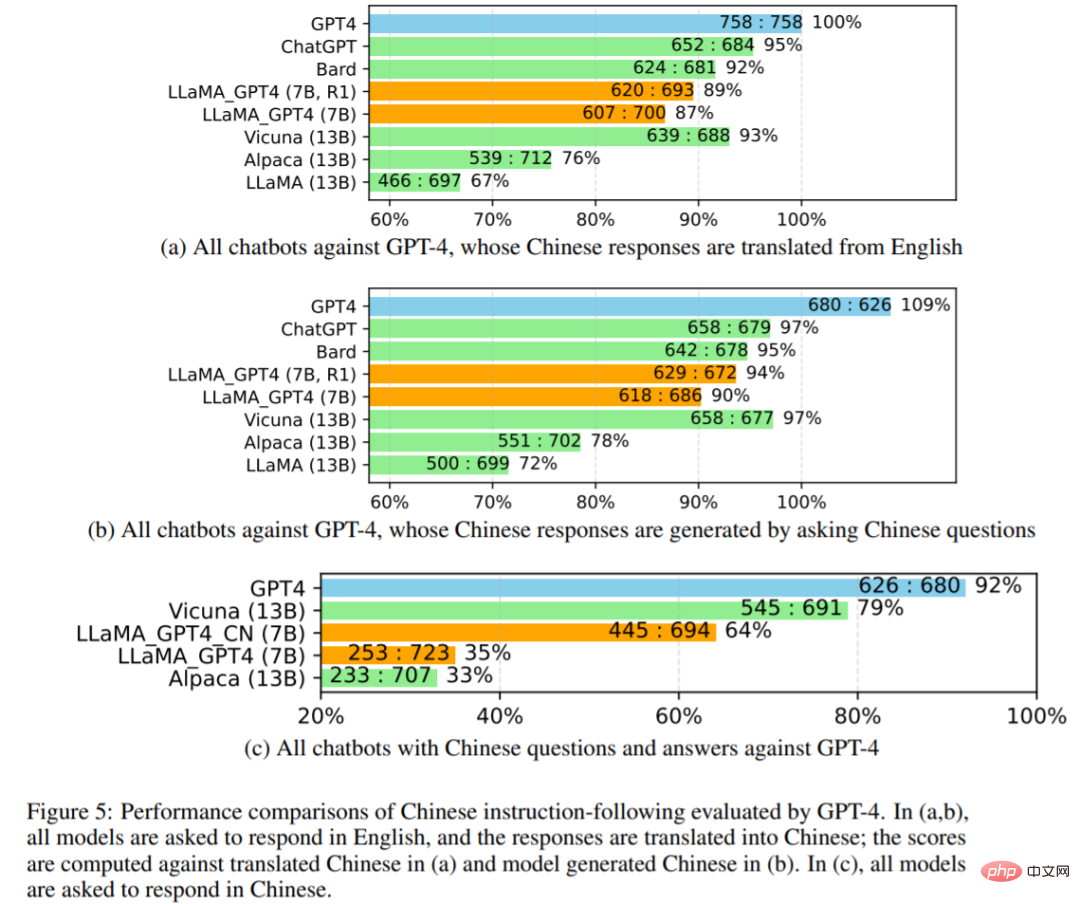

Les chercheurs ont étudié plus en détail les performances de tous les chatbots dans la figure 5 ci-dessous. Utilisez d'abord GPT-4 pour traduire les réponses anglaises du chatbot en chinois, puis utilisez GPT-4 pour traduire les questions anglaises en chinois afin d'obtenir les réponses. Les comparaisons avec les traductions GPT-4 et les réponses chinoises générées sont présentées en 5 (a) et 5 (b), tous les résultats du modèle étant invités à répondre en chinois en 5 (c).

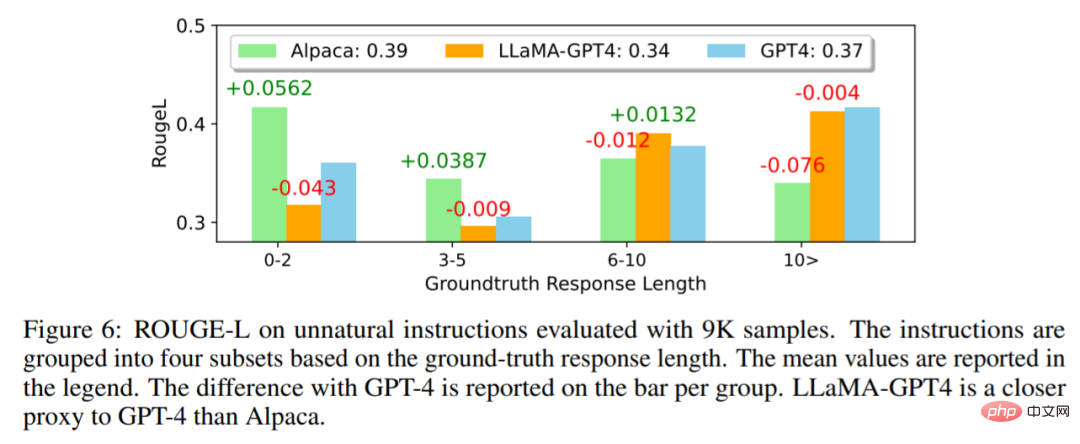

Dans la figure 6 ci-dessous, les chercheurs comparent LLaMA-GPT4 avec les instructions non naturelles de GPT-4 et Alpaca. Les résultats montrent que LLaMA-GPT4 et GPT-4 fonctionnent mieux à mesure que la longueur de réponse de la vérité terrain augmente. Cela signifie qu’ils peuvent mieux suivre les instructions lorsque les scènes sont plus créatives. LLaMA-GPT4 et GPT-4 peuvent tous deux générer des réponses contenant des réponses simples de vérité terrain lorsque la longueur de la séquence est courte, et l'ajout de mots supplémentaires peut rendre la réponse plus proche d'un chat.

Veuillez vous référer à l'article original pour plus de détails techniques et expérimentaux.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI