Maison >Périphériques technologiques >IA >Nouvelle recherche de Google et DeepMind : Comment le biais inductif affecte-t-il la mise à l'échelle du modèle ?

Nouvelle recherche de Google et DeepMind : Comment le biais inductif affecte-t-il la mise à l'échelle du modèle ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-09 20:21:011308parcourir

La mise à l'échelle du modèle Transformer a suscité l'intérêt de nombreux chercheurs ces dernières années. Cependant, on sait peu de choses sur les propriétés d’échelle des différents biais inductifs imposés par les architectures de modèles. On suppose souvent que les améliorations apportées à une échelle spécifique (calcul, taille, etc.) peuvent être transférées à différentes échelles et régions de calcul.

Cependant, il est crucial de comprendre l'interaction entre l'architecture et les lois d'échelle, et il est d'une grande importance pour la recherche de concevoir des modèles qui fonctionnent bien à différentes échelles. Plusieurs questions restent à clarifier : les architectures de modèles évoluent-elles différemment ? Si tel est le cas, comment le biais inductif affecte-t-il les performances de mise à l'échelle ? Comment cela affecte-t-il les tâches en amont (pré-formation) et en aval (transfert) ?

Dans un article récent, des chercheurs de Google ont cherché à comprendre l'impact du biais inductif (architecture) sur la mise à l'échelle du modèle de langage . Pour ce faire, les chercheurs ont pré-entraîné et affiné dix architectures de modèles différentes sur plusieurs régions et échelles de calcul (de 15 millions à 40 milliards de paramètres). Dans l'ensemble, ils ont pré-entraîné et affiné plus de 100 modèles d'architectures et de tailles différentes et ont présenté des informations et des défis liés à la mise à l'échelle de ces dix architectures différentes.

Lien papier : https://arxiv.org/pdf/2207.10551.pdf

Ils ont également remarqué que la mise à l'échelle de ces modèles n'est pas aussi simple qu'il y paraît, c'est-à-dire la mise à l'échelle du complexe les détails de sont étroitement liés aux choix architecturaux examinés en détail dans cet article. Par exemple, une fonctionnalité d'Universal Transformers (et d'ALBERT) est le partage de paramètres. Ce choix architectural déforme considérablement le comportement de mise à l'échelle par rapport au Transformer standard, non seulement en termes de performances, mais également en termes de mesures de calcul telles que les FLOP, la vitesse et le nombre de paramètres. En revanche, les modèles comme les Switch Transformers sont assez différents, avec une relation inhabituelle entre les FLOP et la taille des paramètres.

Plus précisément, les principales contributions de cet article sont les suivantes :

- La loi d'échelle pour différents biais inductifs et architectures de modèles est dérivée pour la première fois . Les chercheurs ont constaté que ce facteur d’échelle variait considérablement d’un modèle à l’autre et ont noté qu’il s’agissait d’une considération importante dans le développement du modèle. Il s'avère que parmi les dix architectures envisagées, le Transformer Vanilla présentait les meilleures performances de mise à l'échelle, même si ce n'était pas le meilleur en termes absolus par zone de calcul.

- Les chercheurs ont observé que un modèle qui fonctionne bien dans une région de mise à l'échelle informatique n'est pas nécessairement le meilleur modèle dans une autre région de mise à l'échelle informatique. De plus, ils ont constaté que certains modèles, bien que performants dans les régions à faible calcul, étaient difficiles à mettre à l’échelle. Cela signifie qu'il est difficile d'avoir une image complète de l'évolutivité du modèle en comparant point par point dans une certaine zone de calcul.

- Les chercheurs ont découvert que la perplexité dans la pré-formation en amont peut être moins pertinente pour le transfert en aval lorsqu'il s'agit de faire évoluer différentes architectures de modèles. Par conséquent, l’architecture sous-jacente et le biais inductif sont également essentiels à la migration vers l’aval.

- Les chercheurs ont souligné la difficulté de mise à l'échelle sous certaines architectures et ont montré que certains modèles n'étaient pas évolutifs (ou évoluaient avec une tendance négative). Ils ont également constaté que les modèles d’attention temporelle linéaire (tels que Performer) ont tendance à être difficiles à mettre à l’échelle.

Méthodes et expériences

Dans le troisième chapitre de l'article, le chercheur décrit la configuration expérimentale globale et présente le modèle évalué dans l'expérience.

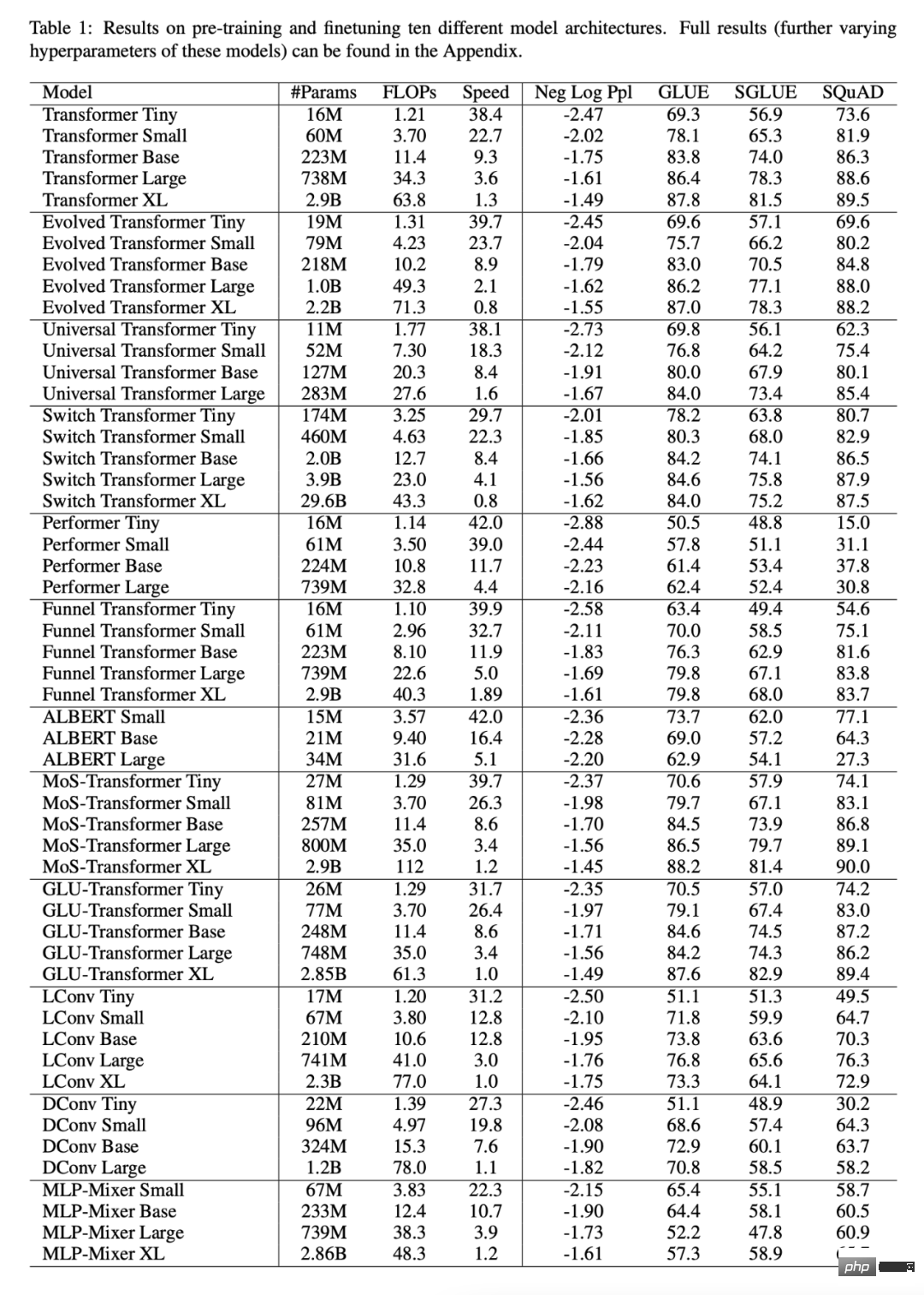

Le tableau 1 ci-dessous montre les principaux résultats de cet article, y compris le nombre de paramètres entraînables, les FLOP (passe avant unique) et la vitesse (pas par seconde), etc., en plus de la perplexité de vérification (pré-entraînement en amont ) et les résultats de 17 tâches en aval.

Tous les modèles évoluent-ils de la même manière ?

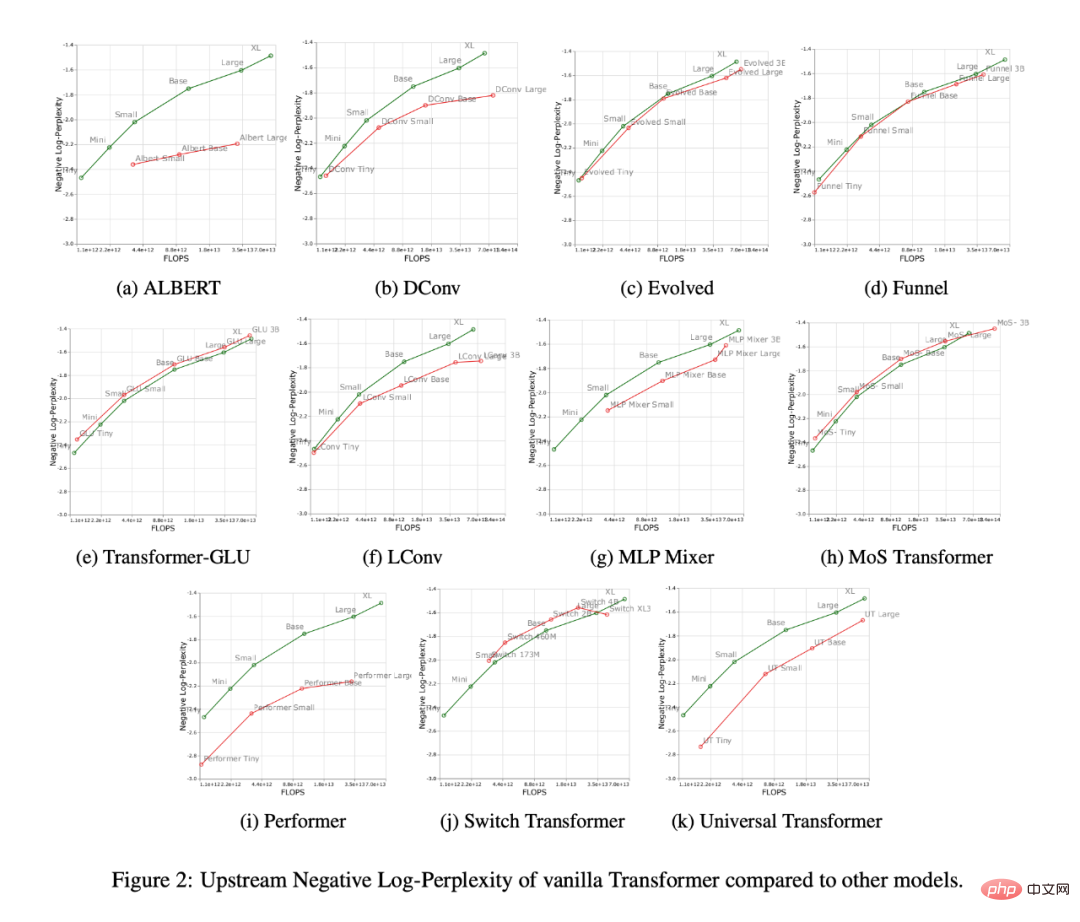

La figure 2 ci-dessous montre le comportement de mise à l'échelle de tous les modèles lors de l'augmentation du nombre de FLOP. On peut observer que le comportement de mise à l'échelle de tous les modèles est assez unique et différent, c'est-à-dire que la plupart d'entre eux sont différents du Transformer standard. La plus grande découverte ici est peut-être que la plupart des modèles (par exemple, LConv, Evolution) semblent fonctionner au même niveau ou mieux que le Transformer standard, mais ne parviennent pas à évoluer avec des budgets de calcul plus élevés.

Une autre tendance intéressante est que les Transformers « linéaires », tels que Performer, ne sont pas évolutifs. Comme le montre la figure 2i, comparée de la base à la grande échelle, la perplexité avant la formation n'a diminué que de 2,7 %. Pour le Transformer vanille, ce chiffre est de 8,4%.

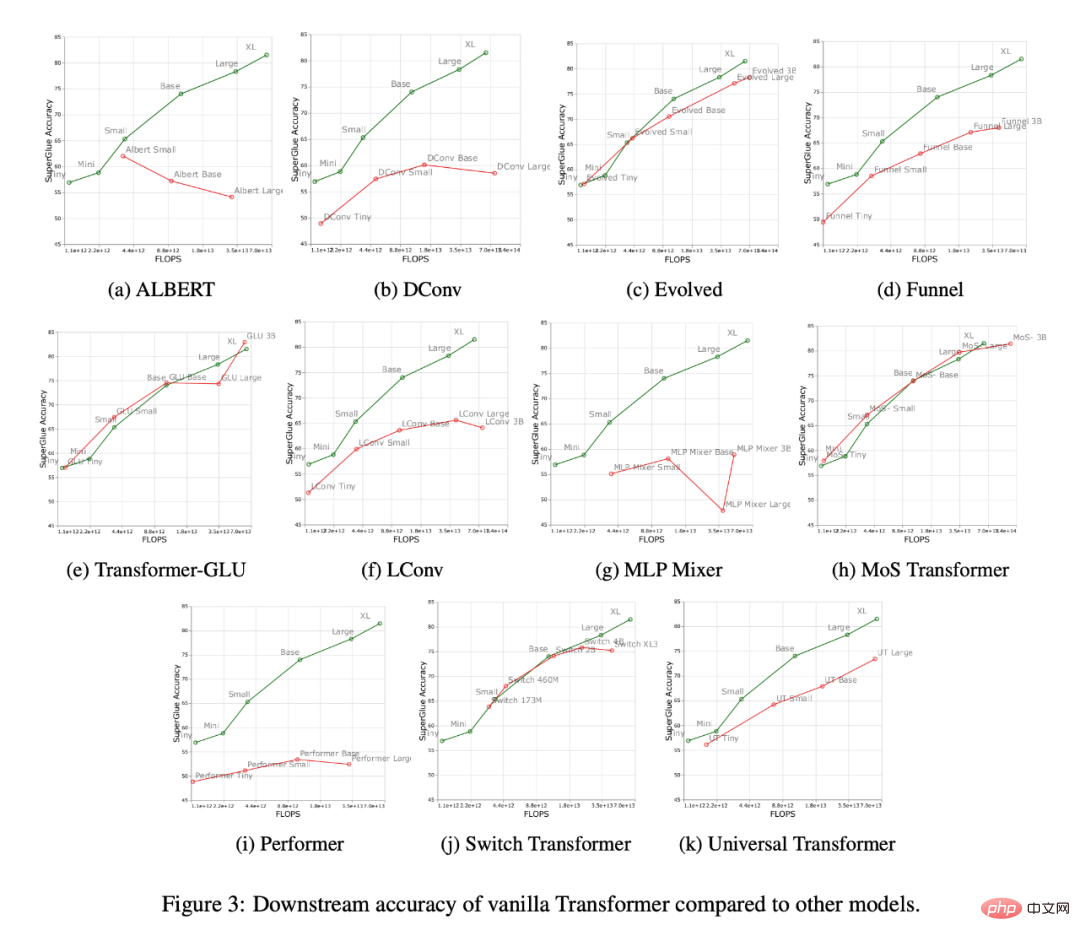

La figure 3 ci-dessous montre les courbes de mise à l'échelle de tous les modèles sur la tâche de migration en aval. On peut constater que par rapport à Transformer, la plupart des modèles ont des courbes de mise à l'échelle différentes, qui changent considérablement dans les tâches en aval. Il convient de noter que la plupart des modèles ont des courbes d’échelle différentes en amont et en aval.

Les chercheurs ont constaté que certains modèles, tels que Funnel Transformer et LConv, semblaient assez bien fonctionner en amont, mais étaient fortement affectés en aval. Quant à Performer, l’écart de performance entre l’amont et l’aval semble encore plus large. Il convient de noter que les tâches en aval de SuperGLUE nécessitent souvent une pseudo-attention croisée sur l'encodeur, ce que des modèles tels que la convolution ne peuvent pas gérer (Tay et al., 2021a).

Par conséquent, les chercheurs ont découvert que même si certains modèles ont de bonnes performances en amont, ils peuvent encore avoir des difficultés à apprendre les tâches en aval.

Le meilleur modèle est-il différent pour chaque échelle ?

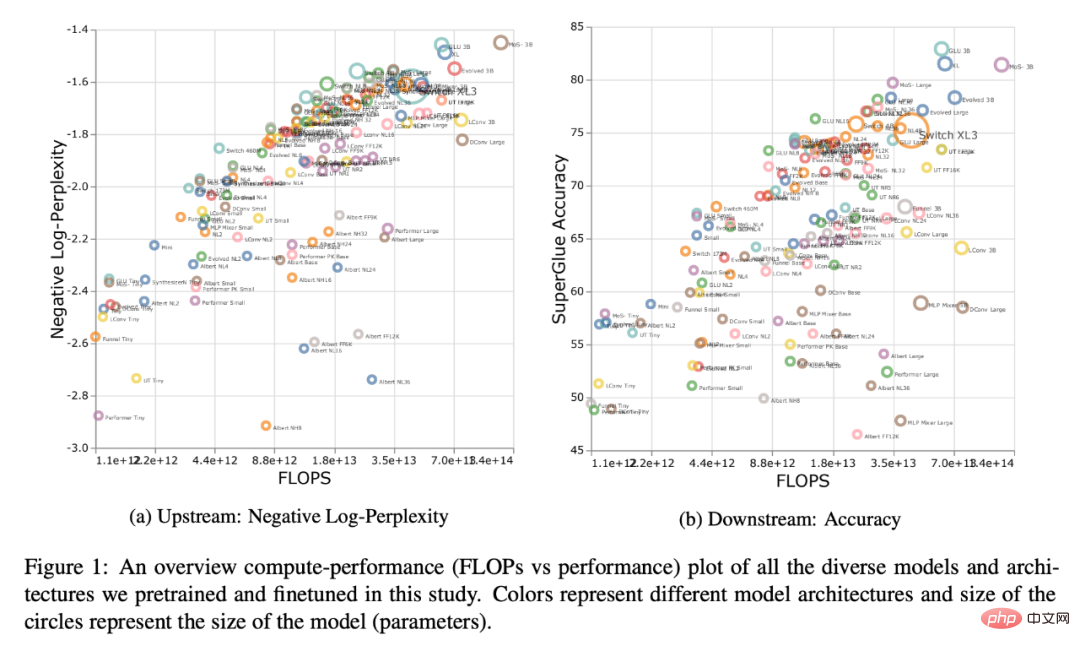

La figure 1 ci-dessous montre la frontière de Pareto lorsqu'elle est calculée en termes de performances en amont ou en aval. Les couleurs du tracé représentent différents modèles, et on peut observer que le meilleur modèle peut être différent pour chaque échelle et zone de calcul. De plus, cela peut également être vu dans la figure 3 ci-dessus. Par exemple, le transformateur évolué semble fonctionner aussi bien que le transformateur standard dans les régions minuscules à petites (en aval), mais cela change rapidement lors de la mise à l'échelle du modèle. Les chercheurs ont également observé cela dans MoS-Transformer, qui a obtenu des performances nettement supérieures à celles du Transformer ordinaire dans certains domaines, mais pas dans d'autres.

Loi d'échelle pour chaque modèle

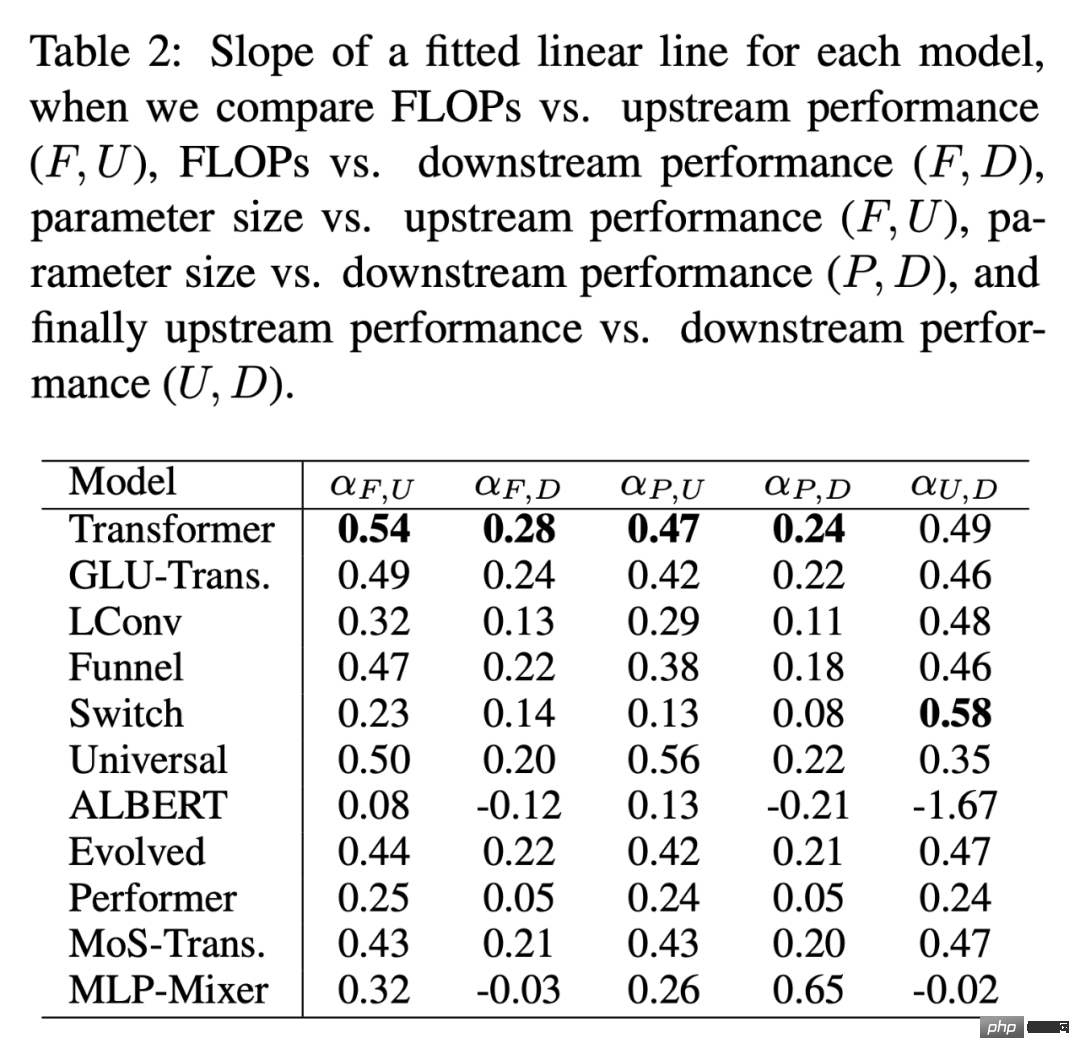

Le tableau 2 ci-dessous donne la pente de la droite linéaire ajustée α pour chaque modèle dans différents cas. Les chercheurs ont obtenu α en traçant F (FLOP), U (perplexité en amont), D (précision en aval) et P (nombre de paramètres). De manière générale, α décrit l'évolutivité du modèle, par exemple α_F,U trace les FLOP par rapport aux performances en amont. La seule exception est α_U,D, qui est une mesure des performances en amont et en aval, avec des valeurs α_U,D élevées, ce qui signifie une meilleure mise à l'échelle du modèle pour les tâches en aval. Dans l’ensemble, la valeur alpha est une mesure des performances d’un modèle par rapport à la mise à l’échelle.

Les protocoles de mise à l'échelle affectent-ils l'architecture du modèle de la même manière ?

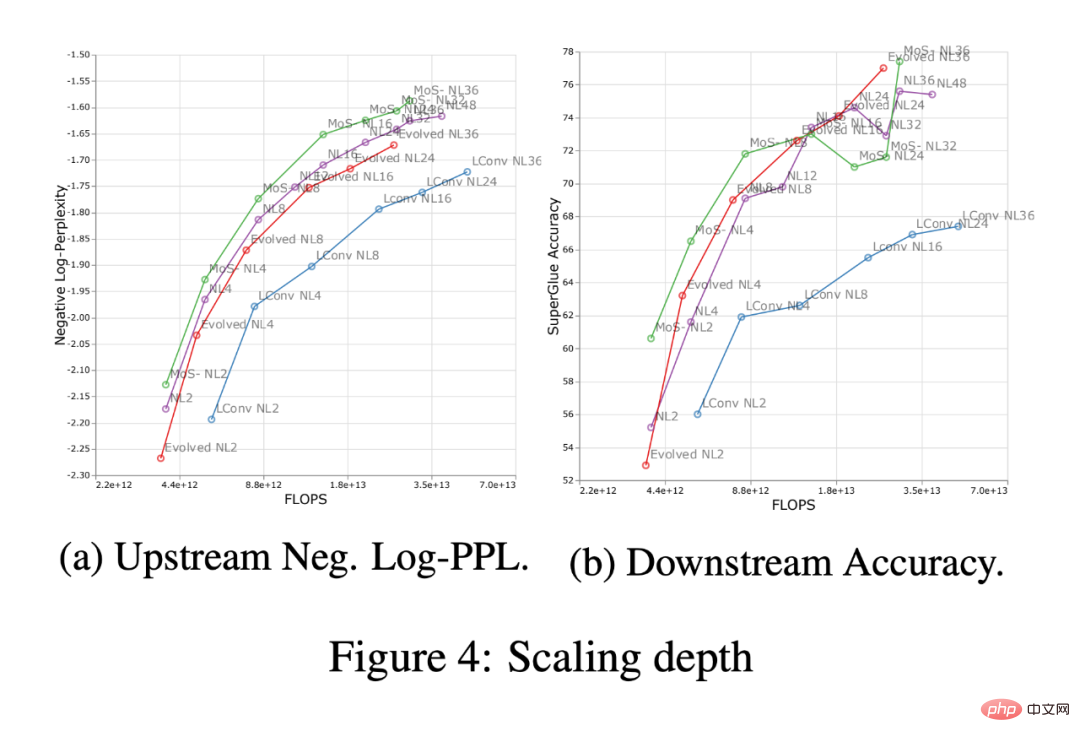

La figure 4 ci-dessous montre l'impact de la profondeur de mise à l'échelle dans quatre architectures de modèles (MoS-Transformer, Transformer, Evolved Transformer, LConv).

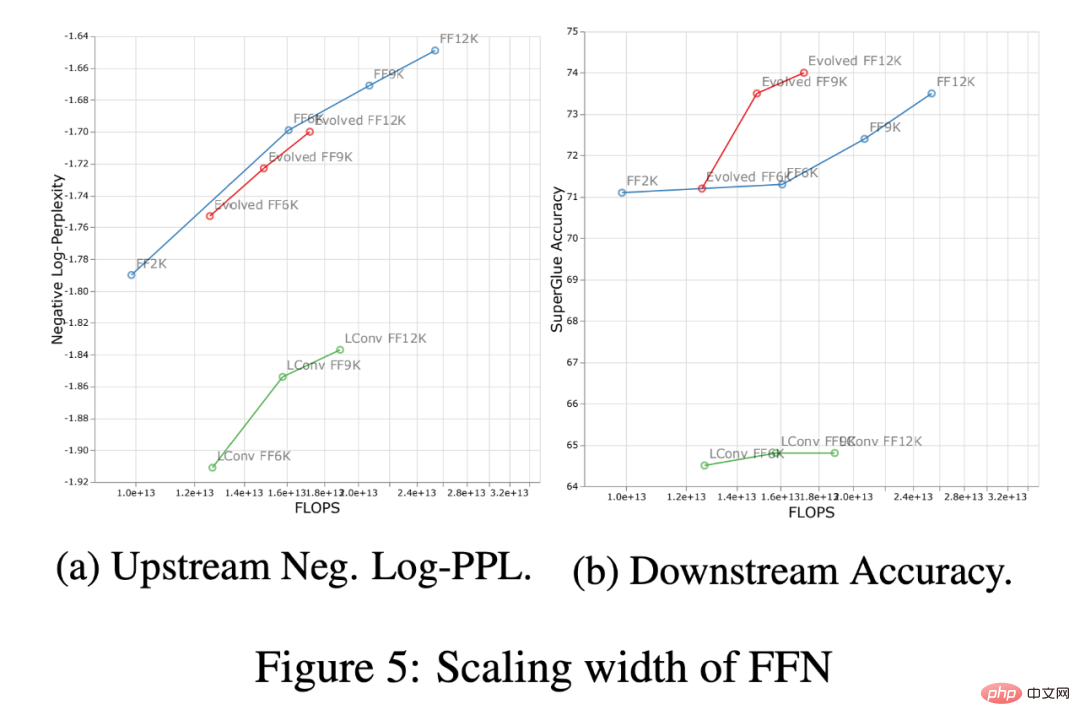

La figure 5 ci-dessous montre l'impact de la mise à l'échelle de la largeur sur les quatre mêmes architectures. Premièrement, sur la courbe en amont (log-perplexité négative), on peut remarquer que même s'il existe de nettes différences de performances absolues entre les différentes architectures, les tendances de mise à l'échelle restent très similaires. En aval, à l'exception de LConv, la mise à l'échelle approfondie (Figure 4 ci-dessus) semble fonctionner de la même manière sur la plupart des architectures. En outre, il semble que le transformateur évolué soit légèrement meilleur pour appliquer la mise à l'échelle de la largeur par rapport à la mise à l'échelle de la largeur. Il convient de noter que la mise à l'échelle en profondeur a un impact beaucoup plus important sur la mise à l'échelle en aval que la mise à l'échelle en largeur.

Pour plus de détails sur la recherche, veuillez vous référer à l'article original.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI