Maison >Périphériques technologiques >IA >Ce modèle a obsédé Andrej Karpathy, ancien directeur de l'IA de Tesla, pendant trois jours !

Ce modèle a obsédé Andrej Karpathy, ancien directeur de l'IA de Tesla, pendant trois jours !

- 王林avant

- 2023-04-09 16:51:03915parcourir

Récemment, un chercheur en IA et artiste numérique nommé Xander Steenbrugge a mis en ligne une vidéo très choquante "Journey Across Time".

La grande évolution de la vie sur terre, depuis l'océan primitif, jusqu'aux anciens lézards, dinosaures, mammifères, jusqu'aux singes, orangs-outans, singes, homo sapiens... et enfin le monde futur de la science-fiction est apparu.

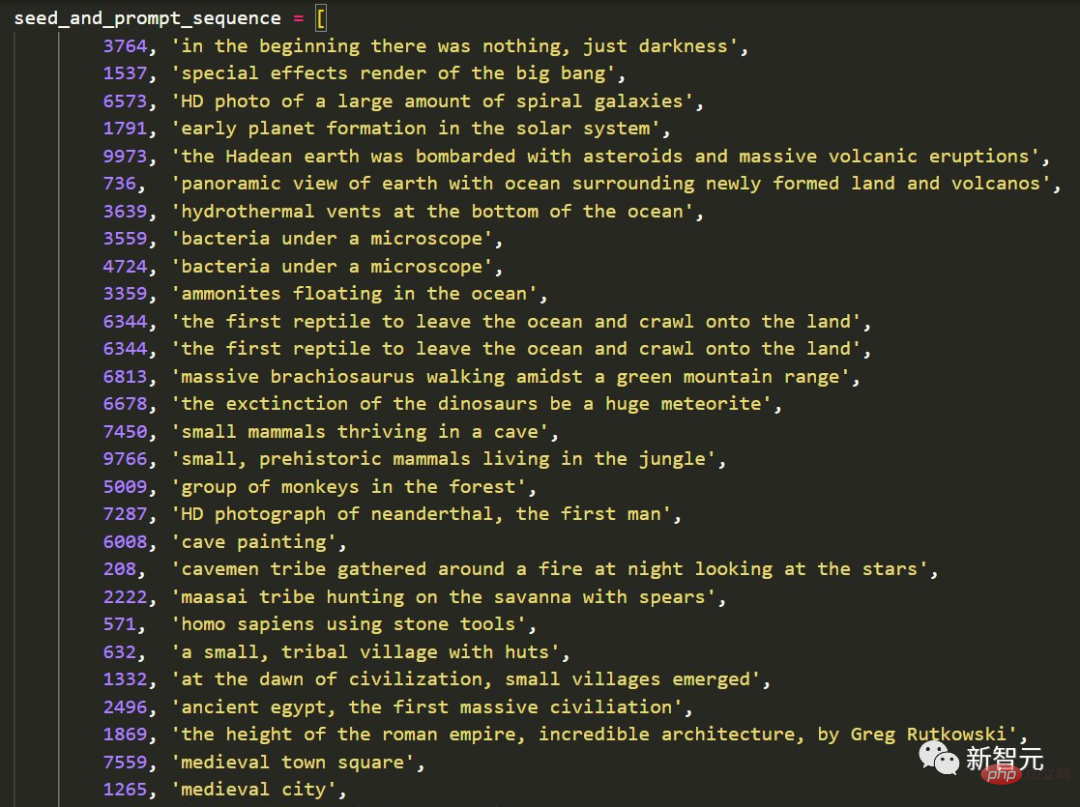

Et Steenbrugge a également commenté avec enthousiasme : Nous franchissons un seuil où l'IA générative n'est plus seulement une question d'esthétique nouvelle, mais a évolué pour devenir un outil incroyable pour construire des récits puissants et centrés sur l'humain. Steenbrugge a déclaré que la vidéo utilisait 36 phrases consécutives. Pour trouver le meilleur ordre possible, il a essayé plus d'un millier d'indices et de graines différents, et a appliqué de nombreuses techniques d'« ingénierie des indices » au code pour déterminer ce qui fonctionnait et ce qui ne fonctionnait pas.

L'ancien directeur principal de Tesla AI, Andrej Karpathy, a été tellement choqué après l'avoir lu qu'il n'a pas pu s'empêcher de l'essayer.

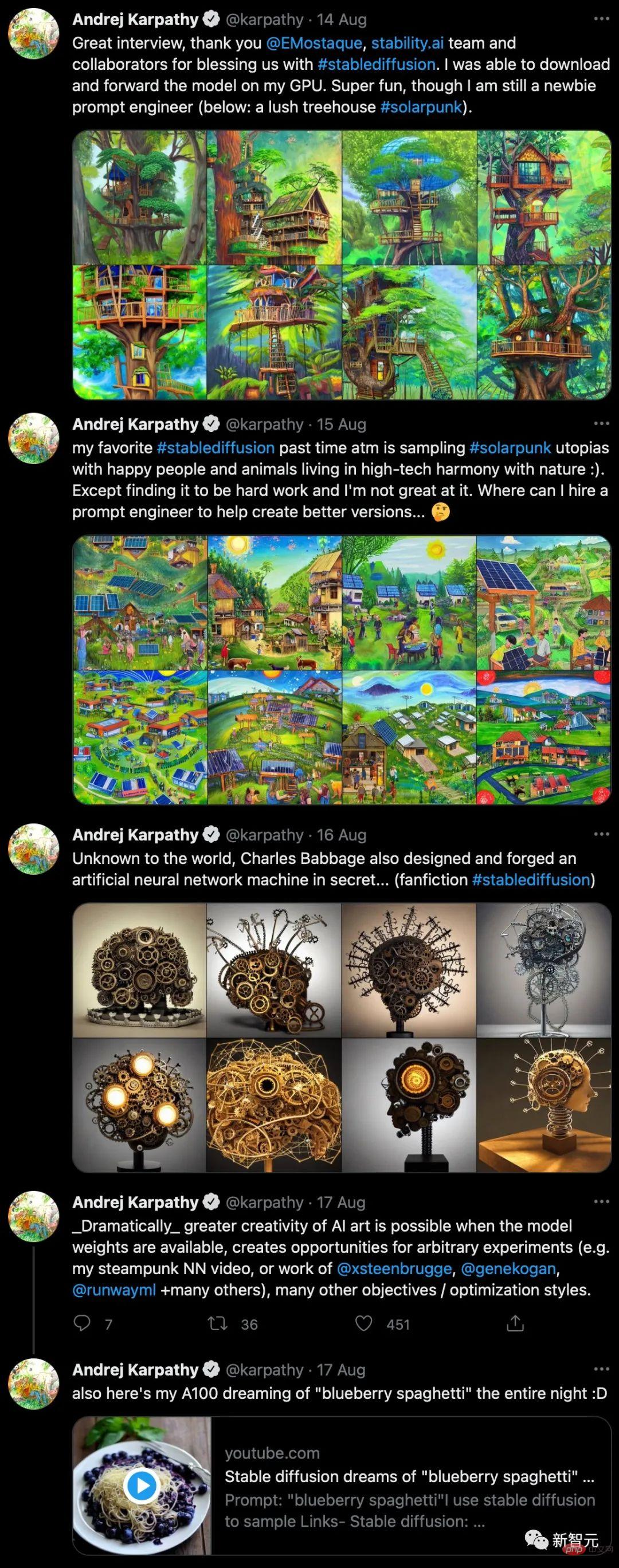

"Une machine à réseau neuronal steampunk surréaliste, en forme de cerveau, posée sur un socle et recouverte de neurones constitués d'engrenages." Après avoir saisi ce texte, son chef-d'œuvre a également été généré.

Vidéo de 2 minutes (~ 1 heure rendue sur A100), générée par interpolation fluide entre modèles avec entrée de bruit aléatoire.

Ce modèle appelé Stable Diffusion utilise une méthode "d'interpolation" entre les sens de deux phrases. L’insertion est un écart sémantique plutôt que visuel, elle change donc radicalement la façon dont l’histoire est racontée.

Et ce n'est que le début de la révolution de la création de contenu numérique portée par l'intelligence artificielle générative.

Diffusion stable : une étape importante pour les modèles Open Source

Depuis début 2021, l'intelligence artificielle capable de générer des images à partir de descriptions textuelles se développe rapidement. À cette époque, OpenAI démontrait des résultats impressionnants avec DALL-E 1 et CLIP.

En 2022, OpenAI a publié l'impressionnant DALL-E 2, Google a présenté Imagen et Parti, Midjourney a lancé une version bêta publique et les images d'IA créées par Craiyon ont été diffusées sur divers médias sociaux.

Et maintenant récemment, Stability AI a publié un nouveau modèle - Stable Diffusion.

Contrairement à DALL-E 2, cependant, Stable Diffusion peut engendrer une variété de personnages notables interdits par OpenAI.

Bien que des systèmes tels que Midjourney, Pixelz.ai, etc. puissent également le faire, la qualité qu'ils génèrent est loin d'être comparable à Stable Diffusion, et ils ne sont pas open source.

Maintenant, nous invitons notre vieil ami Musk à effectuer une transformation en "Black Widow" (Scarlett Johansson) en quelques secondes.

Apparemment, Stability AI, en tant que développeur principal, espère que plus d'une entreprise ou équipe sera en mesure de former des variantes de Stable Diffusion.

Par exemple, vous êtes un chercheur qui ne dispose pas d'une puissance de calcul GPU massive. Ne vous inquiétez pas, Stable Diffusion pourra bientôt fonctionner sur une carte graphique avec seulement 5,1 Go de VRAM.

Pour un autre exemple, si vous êtes un fan qui utilise habituellement un MacBook équipé d'une puce Apple M1, Stable Diffusion peut également fonctionner. Cependant, le temps de génération d’images passera de quelques secondes à quelques minutes.

Il semble que les modèles multimodaux empruntent le chemin que les grands modèles de langage ont emprunté auparavant : s'éloigner d'un fournisseur unique et rendre de nombreuses alternatives largement disponibles via l'open source.

De plus, Runway étudie déjà comment mettre en œuvre un montage texte-vidéo basé sur la diffusion stable.

En un mot, laissez le court de tennis se transformer en plage

Peu importe qu'il y ait des éclairs et du tonnerre, ou que le vent soit ensoleillé

Que ce soit sur la lune ou sur Mars

;

Rien ne peut m'empêcher de jouer au tennis...

Utiliser le calcul pour accélérer l'open source de base de l'IA

Après la phase de test, Stable Diffusion sera gratuit et le code et les modèles entraînés seront publiés en open source source. Il y aura également une version hébergée avec une interface Web permettant aux utilisateurs de tester le système.

Stable Diffusion est le résultat d'une collaboration entre des chercheurs de Stability AI, RunwayML, LMU Munich, EleutherAI et LAION. EleutherAI est célèbre pour ses modèles de langage open source GPT-J-6B et GPT-NeoX-20B, etc.

L'organisation à but non lucratif LAION (Open Network for Large-scale Artificial Intelligence) a fourni l'ensemble de données open source LAION 5B pour les données d'entraînement, que l'équipe a filtré en fonction des commentaires humains pendant la phase de test initiale pour créer le LAION final. -Ensemble de données de formation esthétique.

Patrick Esser de Runway et Robin Rombach de LMU Munich ont dirigé le projet, dont les recherches au sein du groupe CompVis de l'Université de Heidelberg ont jeté les bases de ce projet. À l’Université de Heidelberg, ils ont créé le VQGAN et la diffusion latente, largement utilisés. Ces deux modèles, couplés aux résultats d'OpenAI et de Google Brain, permettent une diffusion stable.

Stability AI a été fondée en 2020 et l'investisseur derrière elle est le mathématicien et informaticien Emad Mostaque. Il a travaillé comme analyste auprès de divers hedge funds.

Avec Stability AI et sa richesse privée, Mostaque espère cultiver une communauté de recherche en IA open source. Sa startup a déjà soutenu la création du jeu de données « LAION 5B ». Pour entraîner les modèles de Stable Diffusion, Stability AI a fourni des serveurs équipés de 4 000 GPU Nvidia A100.

"Personne d'autre n'a de pouvoir de décision à l'exception de nos 75 employés - ni milliardaires, ni grands fonds, ni gouvernements, nous sommes complètement indépendants", a déclaré Mostaque. "Nous prévoyons d'utiliser notre informatique pour accélérer l'open source de l'intelligence artificielle de base."

Les internautes deviennent fous

En plus des deux vidéos du début, certains internautes ont également utilisé Stable Diffusion pour générer une animation vieillissante.

Il a dit que changer un mot dans une longue invite pendant la production avait un effet plus subtil que dans une courte invite. De plus, utiliser des descriptions telles que vieux, d'âge moyen ou jeune fonctionne souvent mieux que d'indiquer des âges spécifiques tels que 10, 40 ou 80 ans.

De plus, il existe une variété d'images fixes de rêve.

"Lover"

"Lion"

"Dark Soul" de Leyendecker et Maxence

"Cyber Opéra de Pékin"

Pâques Egg

Découvrez les abus de l'ancien directeur de la vision de l'intelligence artificielle et de la conduite autonome de Tesla, Andrej Karpathy.

Après avoir regardé la vidéo réalisée par le maître, Karpathy était très excitée.

Les résultats obtenus grâce à une série d'opérations ne sembleront pas déplacés, même dans une petite classe de maternelle. Le désespéré Karpathy a déclaré qu'il souhaitait embaucher un "ingénieur rapide" pour le créer pour lui. Finalement Karpathy a finalement repris ses esprits et a créé de nouvelles œuvres dont il était très satisfait - une machine à réseau neuronal artificiel steampunk et des pâtes aux myrtilles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI