Maison >Périphériques technologiques >IA >La deuxième génération de méta-numériques est là ! Dites adieu aux casques VR, glissez simplement avec votre iPhone

La deuxième génération de méta-numériques est là ! Dites adieu aux casques VR, glissez simplement avec votre iPhone

- 王林avant

- 2023-04-09 14:21:061406parcourir

L'humain numérique réaliste 2.0 de Meta a encore évolué et peut désormais être généré avec l'iPhone, sortez simplement votre téléphone et scannez-le !

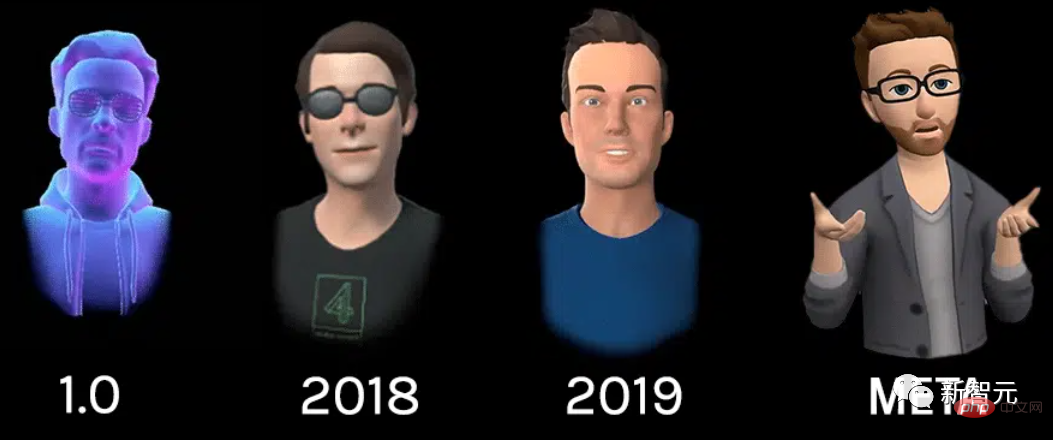

Dès mars 2019, Facebook a présenté l'image humaine numérique de première génération (Codec Avatar 1.0) lors de l'événement. La première génération d’humains numériques a été générée à l’aide d’une plate-forme de capture dédiée dotée de 132 caméras utilisant plusieurs réseaux neuronaux.

Une fois générées, 5 caméras sur le dispositif casque VR. Chaque œil offre deux vues internes et trois vues externes sous le visage. Comme ci-dessous. Depuis lors, Facebook n’a cessé d’améliorer le réalisme de ces avatars, en utilisant uniquement des microphones et une technologie de suivi oculaire pour obtenir des images plus réalistes. Il a finalement évolué vers Codec Avatar version 2.0 en août 2020. La plus grande amélioration de la version 2.0 par rapport à la version 1.0 est que la caméra n'a plus besoin de numériser et de suivre les visages, mais uniquement de suivre les mouvements oculaires.

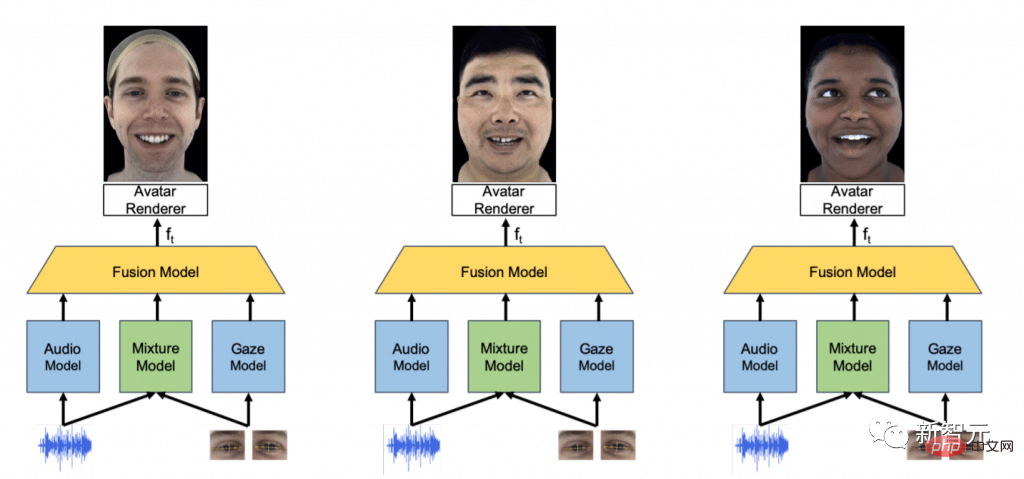

Le nouveau réseau neuronal fusionne les données de suivi oculaire du casque VR avec le flux audio du microphone pour déduire les expressions faciales probables du porteur. Les données du modèle sonore et du modèle de mouvement oculaire sont renvoyées au modèle hybride, puis, grâce au calcul et au traitement du modèle de fusion, le moteur de rendu génère l'image de l'Avatar.

En mai de cette année, l'équipe a en outre annoncé que la version 2.0 d'Avatar avait complètement atteint des effets "complètement réalistes". "Je dirais que l'un des grands défis de la prochaine décennie est de savoir si nous pouvons réaliser des interactions Avatar à distance qui ne se distinguent pas des interactions en face-à-face", a déclaré Sheikh, l'un des chefs de projet.

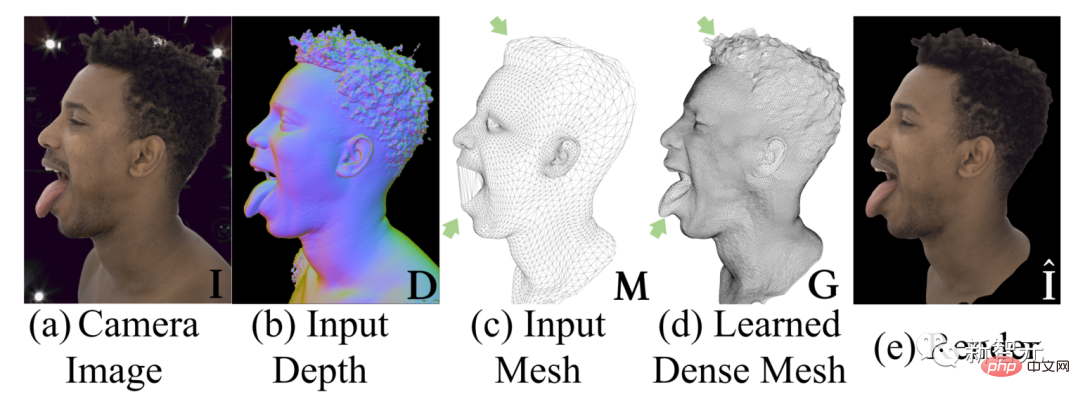

Regardez la comparaison ci-dessus, a est une photo d'une personne réelle, et e est une personne virtuelle générée par le rendu final. On dirait qu'il n'y a pas beaucoup de vantardise ? Ne vous inquiétez pas, ce qui précède est le résultat de la comparaison de l'expérience. Dans des scénarios d'application réels, l'image actuelle de l'humain virtuel Meta est comme ceci.

Même l'image "la plus réaliste" à l'extrême droite reste une image de dessin animé, ce qui est probablement un peu loin d'être "complètement réaliste", mais Meta parle d'une dizaine d'années, regardez l'image de démonstration, l'espoir d'atteindre cet objectif n'est toujours pas petit.

De plus, les progrès de la technologie humaine virtuelle ne se reflètent pas seulement dans le sens du réalisme. Il n'est pas nécessaire de continuer à suivre une voie, mais Meta essaie également d'autres directions. Par exemple, enlever le casque VR ?

De plus, les progrès de la technologie humaine virtuelle ne se reflètent pas seulement dans le sens du réalisme. Il n'est pas nécessaire de continuer à suivre une voie, mais Meta essaie également d'autres directions. Par exemple, enlever le casque VR ?

Dans le passé, générer un avatar Codec distinct nécessitait un dispositif de capture spécial appelé "MUGSY", doté de 171 caméras haute résolution, comme le montre l'image ci-dessus.

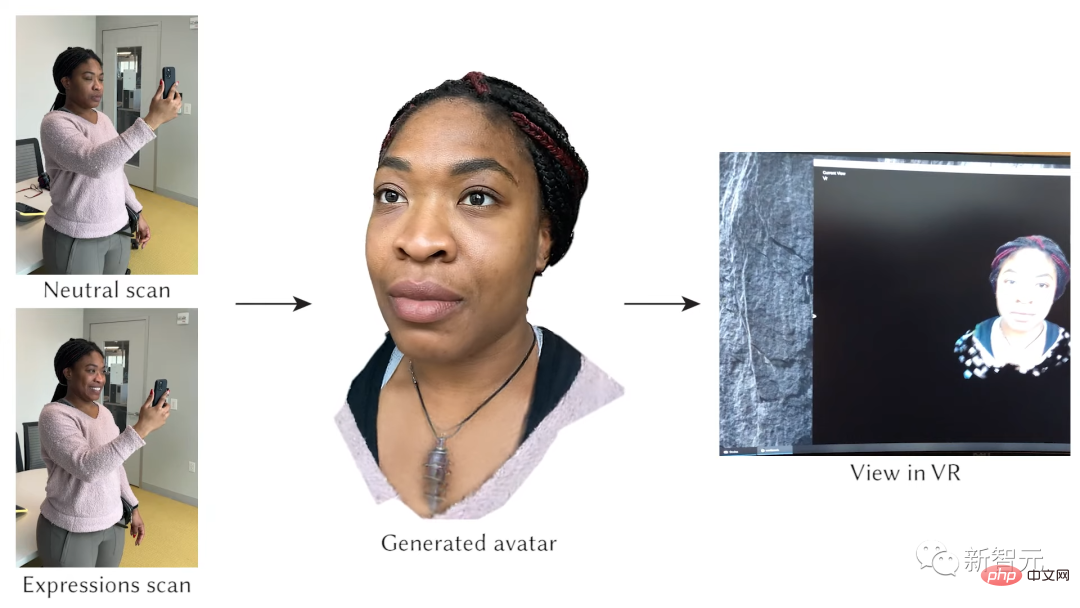

Meta dit maintenant que vous n'avez pas besoin d'apporter ce truc, ayez juste un iPhone ! Tant qu'un smartphone doté d'un capteur de profondeur frontal (comme un iPhone avec fonction FaceID) peut scanner directement (pour être exact, des dizaines de scans), un avatar humain virtuel réaliste peut être généré.

Meta dit maintenant que vous n'avez pas besoin d'apporter ce truc, ayez juste un iPhone ! Tant qu'un smartphone doté d'un capteur de profondeur frontal (comme un iPhone avec fonction FaceID) peut scanner directement (pour être exact, des dizaines de scans), un avatar humain virtuel réaliste peut être généré.

Gardez d'abord votre visage sans expression, numérisez-le une fois, puis créez diverses expressions, jusqu'à 65 expressions différentes sont prises en charge.

Meta a déclaré qu'il fallait environ 3 à 4 minutes en moyenne pour terminer l'analyse des expressions faciales avec un téléphone mobile. Bien entendu, cela nécessite la prise en charge de la puissance de calcul. L’avatar humain virtuel réaliste final généré prend environ 6 heures sur une machine dotée de quatre GPU haut de gamme. Bien entendu, si cette technologie est utilisée dans des produits, ces calculs seront transférés au GPU cloud, sans les propres ressources informatiques de l'utilisateur.

Alors, pourquoi quelque chose qui nécessitait auparavant 100 caméras peut-il être réalisé avec un seul téléphone mobile ? Le secret réside dans un modèle général appelé Hypernetwork. Il s'agit d'un réseau de neurones qui génère les poids d'un autre réseau de neurones. Dans l'exemple ci-dessus, il s'agit de générer un avatar Codec pour une personne spécifique. ne dispose que de 90 caméras.

Bien que d'autres chercheurs aient démontré des portraits générés par la numérisation avec des smartphones, Meta a déclaré que les résultats générés sont de niveau SOTA.  Cependant, le système actuel ne peut toujours pas gérer les lunettes et les cheveux longs. Et cela ne peut aller qu’à la tête, pas aux autres parties du corps.

Cependant, le système actuel ne peut toujours pas gérer les lunettes et les cheveux longs. Et cela ne peut aller qu’à la tête, pas aux autres parties du corps.

Bien sûr, Meta a encore un long chemin à parcourir avant d'atteindre ce niveau de fidélité. Les portraits de Meta ont désormais un style cartoon. Et ce sentiment de réalisme a progressivement diminué avec le temps. Désormais, cette image peut être plus adaptée aux personnes qui utilisent Quest 2 pour jouer à Horizon Worlds.

Cependant, Codec Avatar pourrait finir par être simplement une option autonome plutôt que la mise à niveau caricaturale qu'il est actuellement. Zuckerberg, PDG de Meta, a décrit l'avenir ainsi : Vous pouvez utiliser un portrait expressionniste pour jouer à des jeux ordinaires, et utiliser un portrait plus réaliste pour assister à des réunions de travail, etc.

En avril de cette année, Yaser Sheikh, responsable de l'équipe Codec Avatar, a déclaré : "Il est impossible de prédire combien de temps il faudra pour que Codec Avatar soit mis en service. Cependant, il l'a fait." il est clair qu'il estime que le projet a fait de grands progrès.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI