Maison >Périphériques technologiques >IA >En débloquant la bonne combinaison de CNN et Transformer, ByteDance propose un transformateur visuel efficace de nouvelle génération

En débloquant la bonne combinaison de CNN et Transformer, ByteDance propose un transformateur visuel efficace de nouvelle génération

- PHPzavant

- 2023-04-09 14:01:111777parcourir

En raison de mécanismes d'attention et de conceptions de modèles complexes, la plupart des transformateurs visuels (ViT) existants ne peuvent pas fonctionner aussi efficacement que les réseaux de neurones convolutifs (CNN) dans des scénarios de déploiement industriel réels. Cela soulève la question : un réseau de neurones visuels peut-il déduire aussi rapidement qu'un CNN et aussi puissant qu'un ViT ?

Certains travaux récents ont tenté de concevoir une architecture hybride CNN-Transformer pour résoudre ce problème, mais les performances globales de ces travaux sont loin d'être satisfaisantes. Sur cette base, les chercheurs de ByteDance ont proposé un transformateur visuel de nouvelle génération, Next-ViT, qui peut être déployé efficacement dans des scénarios industriels réels. Du point de vue du compromis latence/précision, les performances de Next-ViT sont comparables à celles des excellents CNN et ViT.

Adresse papier : https://arxiv.org/pdf/2207.05501.pdf

L'équipe de recherche de Next-ViT a développé un nouveau bloc de convolution (NCB) et un bloc transformateur (NTB) ), déployant des mécanismes conviviaux pour capturer des informations locales et mondiales. L’étude propose ensuite une nouvelle stratégie hybride NHS qui vise à empiler les BCN et les BNT dans un paradigme hybride efficace pour améliorer les performances de diverses tâches en aval.

Des expériences approfondies montrent que Next-ViT surpasse considérablement les architectures hybrides CNN, ViT et CNN-Transformer existantes en termes de compromis latence/précision pour diverses tâches visuelles. Sur TensorRT, Next-ViT surpasse ResNet de 5,4 mAP sur la tâche de détection COCO (40,4 VS 45,8) et de 8,2 % mIoU sur la segmentation ADE20K (38,8 % VS 47,0 %). Pendant ce temps, Next-ViT atteint des performances comparables à celles de CSWin et permet une inférence 3,6 fois plus rapide. Sur CoreML, Next-ViT surpasse EfficientFormer de 4,6 mAP sur la tâche de détection COCO (42,6 VS 47,2) et de 3,5 % mIoU sur la segmentation ADE20K (de 45,2 % à 48,7 %).

Méthode

L'architecture globale de Next-ViT est présentée dans la figure 2 ci-dessous. Next-ViT suit une architecture pyramidale hiérarchique, avec une couche d'intégration de correctifs et une série de blocs convolutifs ou transformateurs à chaque étape. La résolution spatiale sera progressivement réduite à 1/32 de l'original, tandis que les dimensions du canal seront étendues par étapes.

Les chercheurs ont d'abord conçu en profondeur le module de base de l'interaction de l'information et ont développé respectivement de puissants NCB et NTB pour simuler les dépendances à court et à long terme dans les données visuelles. La fusion des informations locales et globales est également réalisée dans NTB pour améliorer encore les capacités de modélisation. Enfin, afin de surmonter les lacunes inhérentes aux méthodes existantes, cette étude étudie systématiquement l'intégration des blocs de convolution et de transformateur et propose une stratégie NHS pour empiler NCB et NTB afin de construire une nouvelle architecture hybride CNN-Transformer.

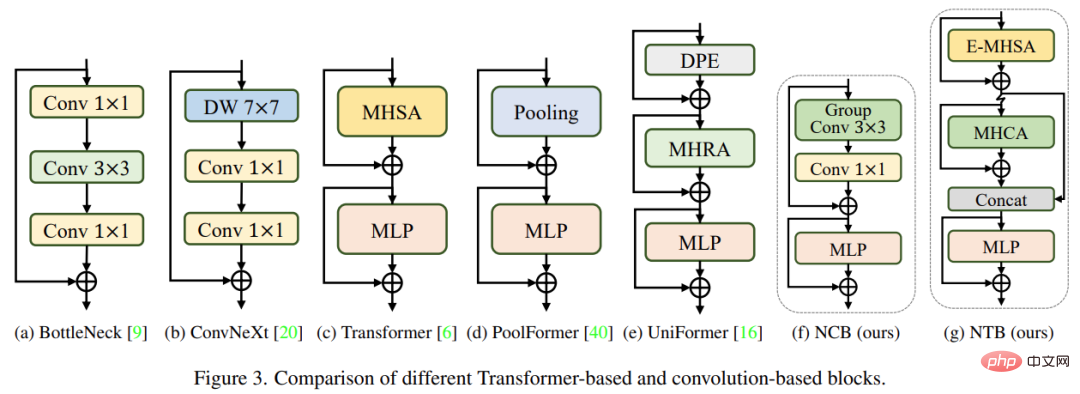

NCB

Les chercheurs ont analysé plusieurs conceptions structurelles classiques, comme le montre la figure 3 ci-dessous. Le bloc Bottleneck proposé par ResNet [9] a longtemps dominé les réseaux de neurones visuels en raison de son biais inductif inhérent et de sa facilité de déploiement sur la plupart des plates-formes matérielles. Malheureusement, les blocs Bottleneck sont moins efficaces que les blocs Transformer. Le bloc ConvNeXt [20] modernise le bloc Bottleneck en imitant la conception du bloc Transformer. Alors que les blocs ConvNeXt améliorent les performances du réseau, sa vitesse d'inférence sur TensorRT/CoreML est sévèrement limitée par des composants inefficaces. Le bloc Transformer a obtenu d'excellents résultats dans diverses tâches de vision. Cependant, la vitesse d'inférence du bloc Transformer est beaucoup plus lente que celle du bloc Bottleneck sur TensorRT et CoreML car son mécanisme d'attention est plus complexe, ce qui n'est pas le cas dans la plupart des cas du monde réel. scénarios industriels.

Pour surmonter les problèmes des types de blocs mentionnés ci-dessus, cette étude propose le Next Convolution Block (NCB), qui obtient les performances exceptionnelles du bloc Transformer tout en conservant les avantages de déploiement du bloc Bottleneck. Comme le montre la figure 3 (f), NCB suit l'architecture générale du MetaFormer (qui s'est avérée critique pour le bloc Transformer).

De plus, un mélangeur de jetons efficace basé sur l'attention est tout aussi important. Cette étude a conçu une attention convolutionnelle multi-têtes (MHCA) en tant que mélangeur de jetons efficace déployant des opérations convolutives, et a construit un NCB en utilisant les couches MHCA et MLP dans le paradigme de MetaFormer [40].

NTB

NCB a efficacement appris les représentations locales, et la prochaine étape doit capturer des informations mondiales. L'architecture Transformer a une forte capacité à capturer des signaux basse fréquence qui fournissent des informations globales (telles que la forme et la structure globales).

Cependant, des recherches connexes ont montré que le bloc Transformateur peut détériorer dans une certaine mesure les informations à haute fréquence, telles que les informations de texture locale. Les signaux provenant de différentes bandes de fréquences sont essentiels dans le système visuel humain et sont fusionnés de manière spécifique pour extraire des caractéristiques plus essentielles et uniques.

Influencé par ces résultats connus, cette recherche a développé le Next Transformer Block (NTB) pour capturer des signaux multifréquences dans un mécanisme léger. De plus, NTB peut être utilisé comme mélangeur de signaux multifréquences efficace, améliorant encore les capacités globales de modélisation.

NHS

Des efforts récents ont été déployés pour combiner CNN et Transformer pour un déploiement efficace. Comme le montre la figure 4(b)(c) ci-dessous, ils utilisent presque tous des blocs convolutifs dans l'étape peu profonde et n'empilent que des blocs Transformer dans la ou les deux dernières étapes. Cette combinaison est efficace dans les tâches de classification. Mais l’étude a révélé que ces stratégies hybrides peuvent facilement atteindre une saturation des performances sur les tâches en aval telles que la segmentation et la détection. La raison en est que les tâches de classification utilisent uniquement le résultat de la dernière étape pour la prédiction, tandis que les tâches en aval telles que la segmentation et la détection s'appuient souvent sur les caractéristiques de chaque étape pour obtenir de meilleurs résultats. En effet, les stratégies hybrides traditionnelles empilent simplement les blocs Transformer au cours des dernières étapes, et les couches superficielles ne peuvent pas capturer les informations globales.

Cette étude propose une nouvelle stratégie hybride (NHS) qui combine de manière créative des blocs convolutifs (NCB) et des blocs transformateurs (NTB) avec le paradigme hybride (N + 1) * L. NHS améliore considérablement les performances du modèle sur les tâches en aval et permet un déploiement efficace tout en contrôlant la proportion de blocs Transformer.

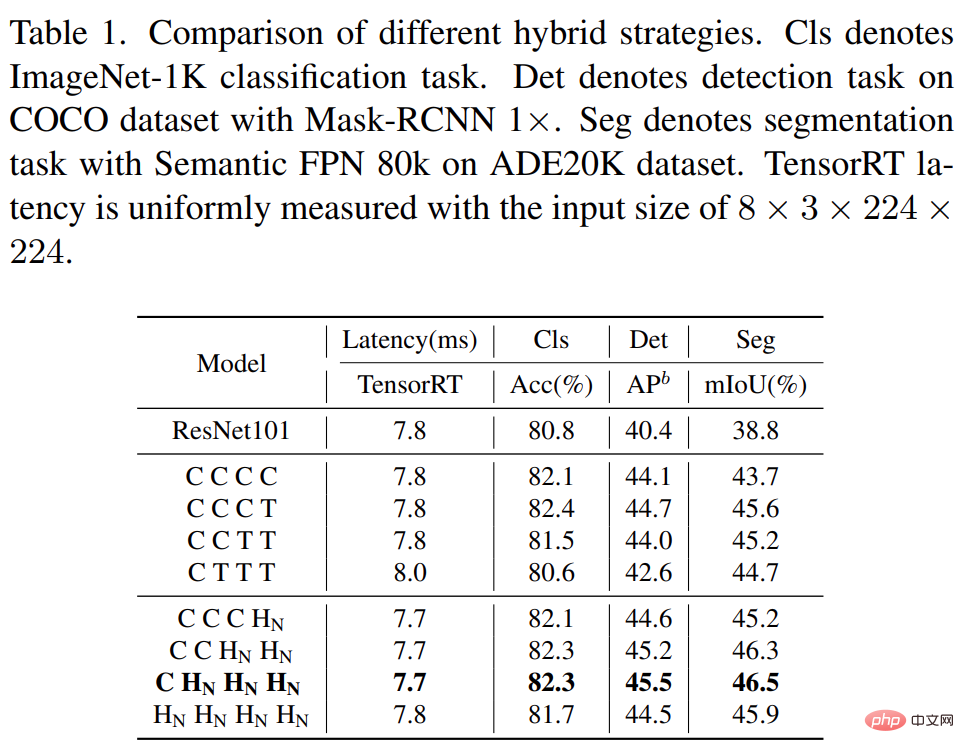

Premièrement, afin de donner à la couche peu profonde la capacité de capturer des informations globales, cette étude propose une stratégie de mélange de modes (NCB×N+NTB×1), empilant N NCB et un NTB à chaque étape, comme le montre la figure 4(d) est représentée. Plus précisément, des blocs transformateurs (NTB) sont placés à la fin de chaque étape, permettant au modèle d'apprendre des représentations globales en couches peu profondes. Cette étude a mené une série d'expériences pour vérifier la supériorité de la stratégie hybride proposée, et les performances des différentes stratégies hybrides sont présentées dans le tableau 1 ci-dessous.

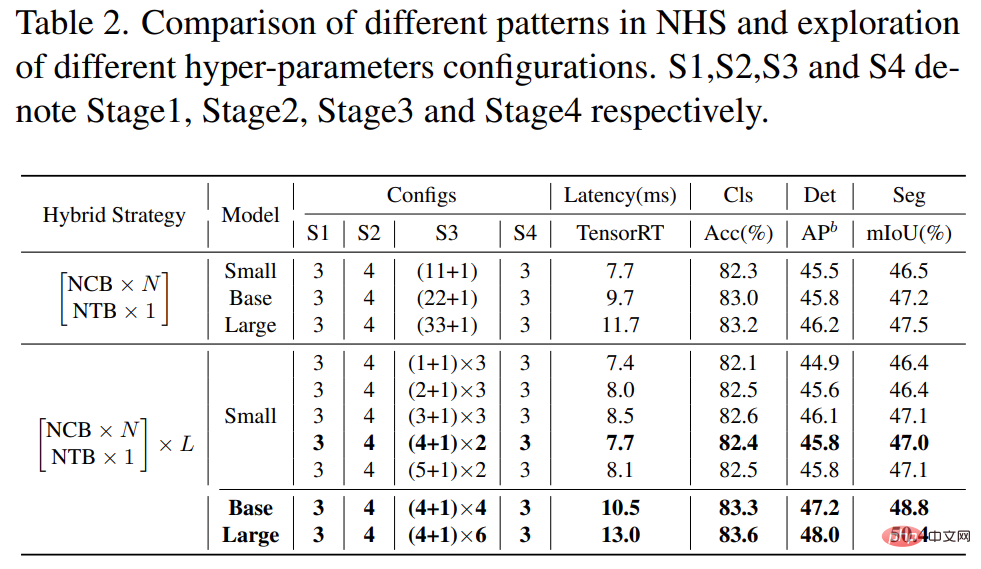

De plus, comme le montre le tableau 2 ci-dessous, les performances des grands modèles atteindront progressivement la saturation. Ce phénomène montre qu'agrandir la taille du modèle en agrandissant N du mode (NCB × N + NTB × 1), c'est-à-dire en ajoutant simplement plus de blocs convolutifs n'est pas le choix optimal, le mode (NCB × N + NTB × 1) La valeur de N dans peut sérieusement affecter les performances du modèle.

Par conséquent, les chercheurs ont commencé à explorer l'impact de la valeur de N sur les performances du modèle à travers des expériences approfondies. Comme le montre le tableau 2 (au milieu), l'étude a construit des modèles avec différentes valeurs de N au cours de la troisième étape. Pour construire des modèles avec des latences similaires pour une comparaison équitable, cette étude empile L ensembles de modèles (NCB × N + NTB × 1) à de petites valeurs de N.

Comme le montre le tableau 2, le modèle avec N = 4 dans la troisième étape réalise le meilleur compromis entre performances et latence. L'étude construit en outre un modèle plus large en développant L dans le mode (NCB × 4 + NTB × 1) × L dans la troisième étape. Comme le montre le tableau 2 (ci-dessous), les performances des modèles de base (L = 4) et grand (L = 6) sont significativement améliorées par rapport au petit modèle, validant ainsi le modèle proposé (NCB × N + NTB × 1) × L. modéliser l’efficacité générale.

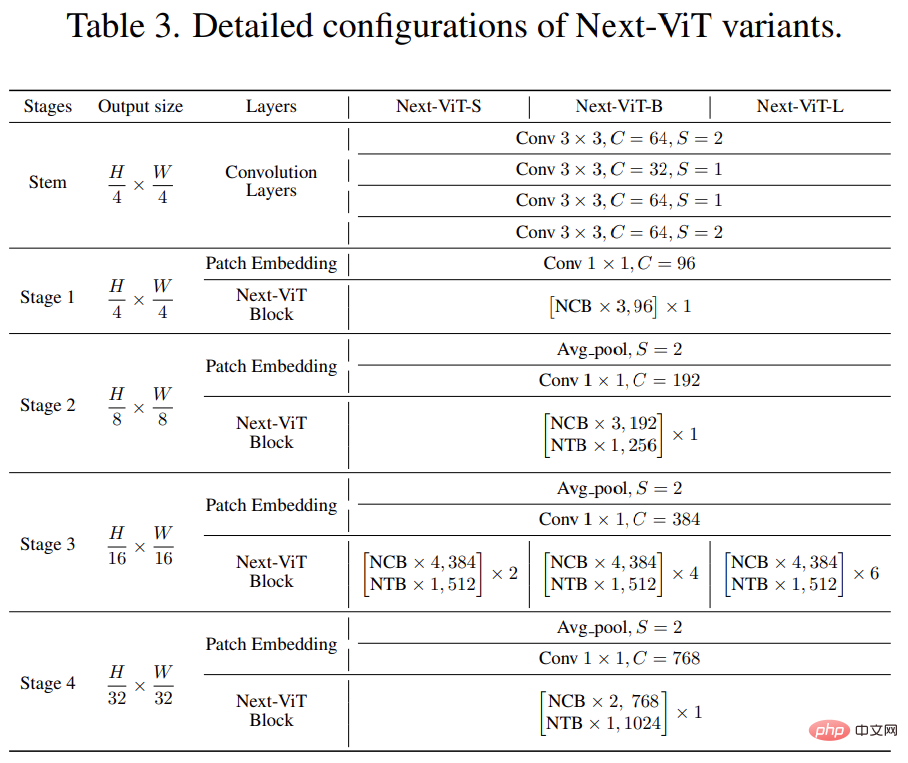

Enfin, afin de fournir une comparaison équitable avec les réseaux SOTA existants, les chercheurs ont proposé trois variantes typiques, à savoir Next-ViTS/B/L.

Résultats expérimentaux

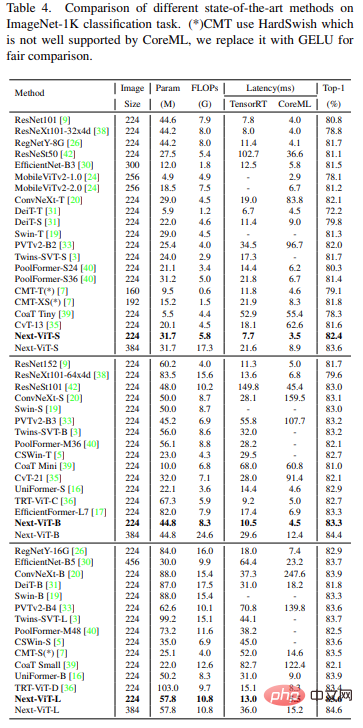

Tâche de classification sur ImageNet-1K

Par rapport aux dernières méthodes SOTA telles que CNN, ViT et les réseaux hybrides, Next-ViT réalise le meilleur compromis entre précision et latence, les résultats sont les suivants Comme indiqué dans le tableau 4.

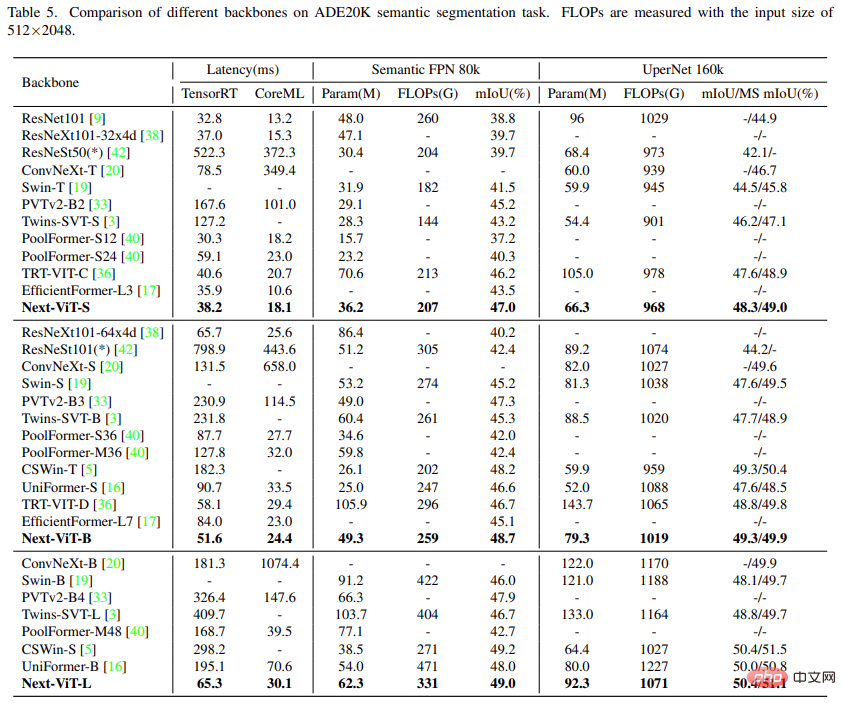

Tâche de segmentation sémantique sur ADE20K

Cette étude compare Next-ViT avec CNN, ViT et certaines architectures hybrides récentes pour les tâches de segmentation sémantique. Comme le montre le tableau 5 ci-dessous, des expériences approfondies montrent que Next-ViT présente un excellent potentiel pour les tâches de segmentation.

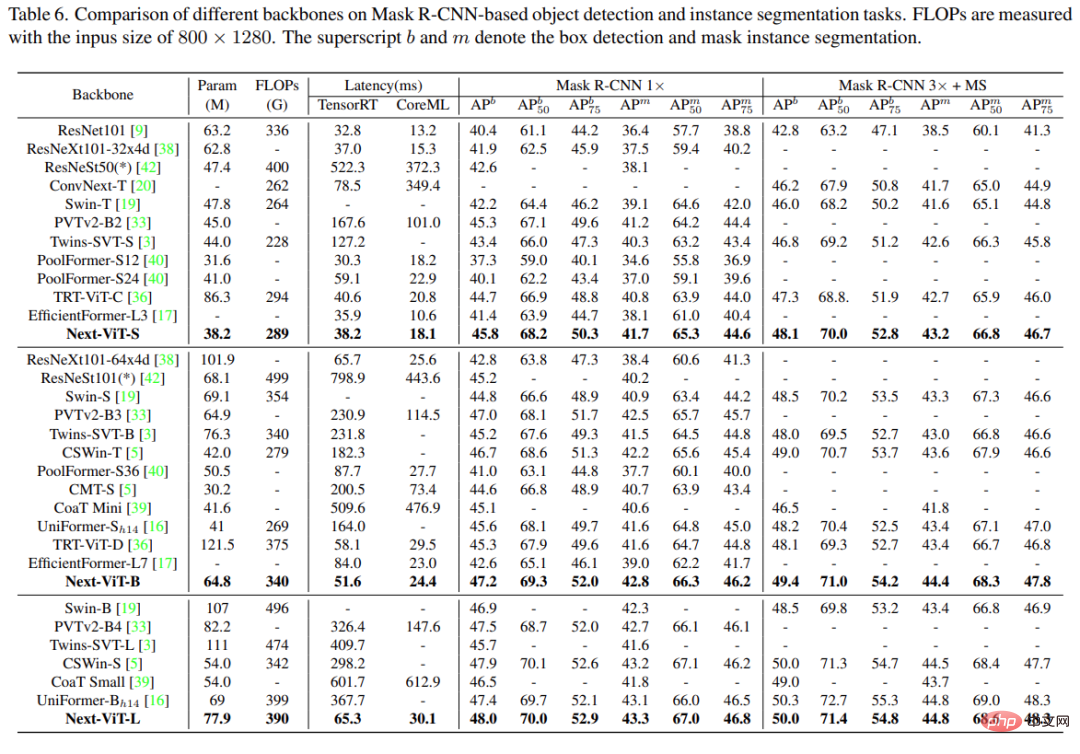

Détection d'objets et segmentation d'instances

Sur les tâches de détection d'objets et de segmentation d'instances, cette étude a comparé Next-ViT avec le modèle SOTA, et les résultats sont présentés dans le tableau 6 ci-dessous.

Expériences et visualisation d'ablation

Pour mieux comprendre Next-ViT, les chercheurs ont analysé le rôle de chaque conception clé en évaluant ses performances sur la classification ImageNet-1K et les tâches en aval, et en produisant une visualisation du spectre de Fourier et de la carte thermique des caractéristiques. pour montrer les avantages inhérents à Next-ViT.

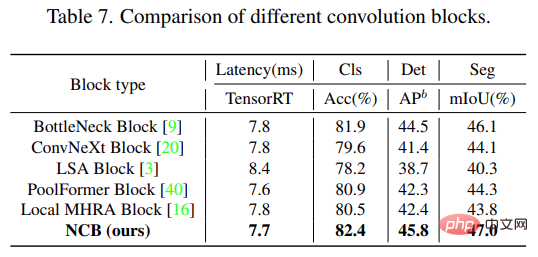

Comme le montre le tableau 7 ci-dessous, NCB obtient le meilleur compromis latence/précision sur les trois tâches.

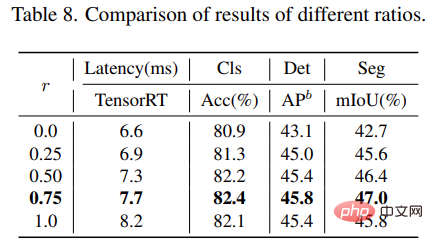

Pour le bloc NTB, cette étude explore l'impact du taux de retrait r du NTB sur les performances globales de Next-ViT. Les résultats sont présentés dans le tableau 8 ci-dessous. La réduction du taux de retrait r réduira le modèle. latence.

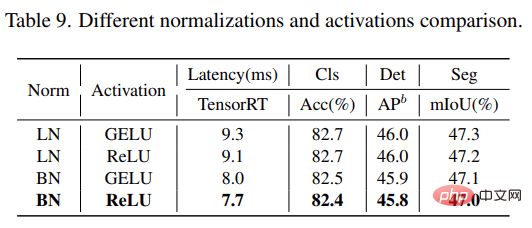

De plus, le modèle avec r = 0,75 et r = 0,5 a de meilleures performances que le modèle Transformateur pur (r = 1). Cela indique que la fusion appropriée des signaux multifréquences améliorera les capacités d'apprentissage des représentations du modèle. En particulier, le modèle avec r = 0,75 réalise le meilleur compromis latence/précision. Ces résultats illustrent l’efficacité des blocs NTB. Cette étude analyse plus en détail l'impact des différentes couches de normalisation et fonctions d'activation dans Next-ViT. Comme le montre le tableau 9 ci-dessous, bien que LN et GELU apportent certaines améliorations de performances, la latence d'inférence sur TensorRT est nettement plus élevée. D’un autre côté, BN et ReLU obtiennent le meilleur compromis latence/précision sur la tâche globale. Par conséquent, Next-ViT utilise BN et ReLU de manière uniforme pour un déploiement efficace dans des scénarios industriels réels.

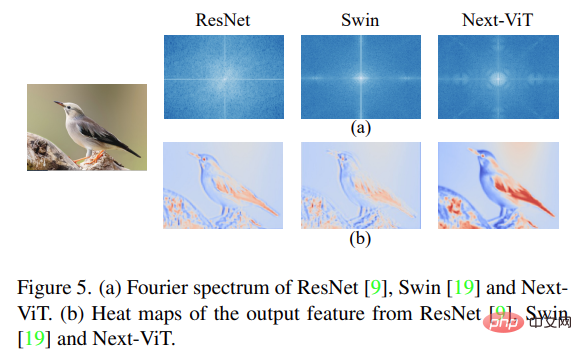

Enfin, l'étude a visualisé le spectre de Fourier et la carte thermique des caractéristiques de sortie de ResNet, Swin Transformer et Next-ViT, comme le montre la figure 5(a) ci-dessous. La distribution spectrale de ResNet montre que le bloc de convolution a tendance à capturer les signaux haute fréquence et a du mal à prêter attention aux signaux basse fréquence ; ViT est bon pour capturer les signaux basse fréquence et ignore les signaux haute fréquence ; signaux multifréquences de haute qualité en même temps, ce qui montre les avantages de l'efficacité du NTB.

De plus, comme le montre la figure 5(b), Next-ViT peut capturer des informations de texture plus riches et des informations globales plus précises que ResNet et Swin, ce qui montre que Next-ViT a des capacités de modélisation plus fortes.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI