Maison >Périphériques technologiques >IA >Brisant le triangle impossible et rivalisant avec 540 milliards de modèles, l'équipe IDEA Fengshen List n'atteint l'apprentissage SOTA sans échantillon qu'avec 200 millions de modèles

Brisant le triangle impossible et rivalisant avec 540 milliards de modèles, l'équipe IDEA Fengshen List n'atteint l'apprentissage SOTA sans échantillon qu'avec 200 millions de modèles

- 王林avant

- 2023-04-09 13:31:061155parcourir

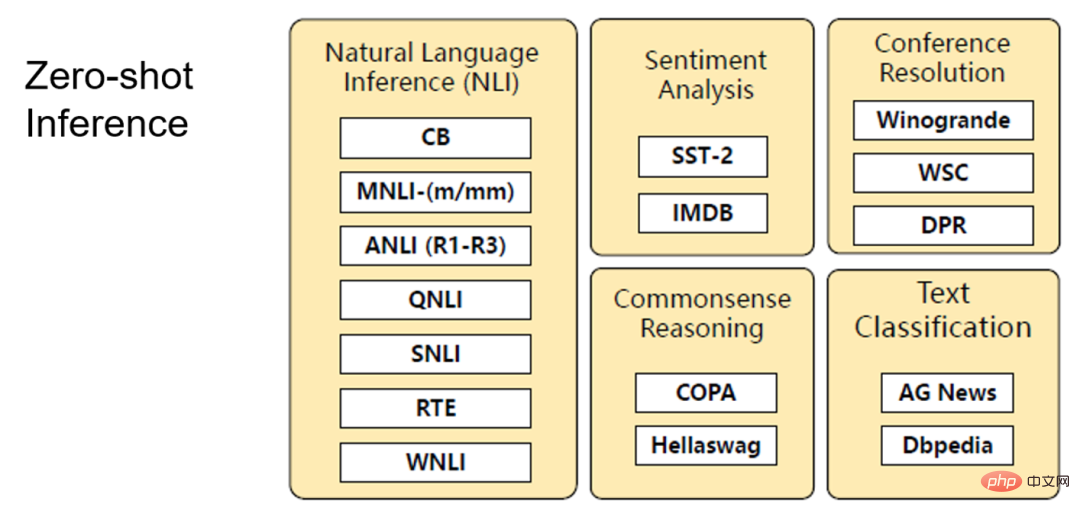

Depuis l'avènement de GPT-3, qui a démontré la puissance de centaines de milliards de modèles, les tâches de PNL se sont heurtées au triangle impossible de l'échelle, des échantillons et du réglage fin des performances. Comment un modèle de langage avec moins d'un milliard de paramètres peut-il atteindre les performances Few-Shot (ou même Zero-shot) et de réglage fin de SOTA ? Devons-nous disposer de centaines de milliards de paramètres et supporter des invites instables pour résoudre le scénario du zéro tir ? Dans cet article, l'équipe Fengshenbang de l'IDEA Research Institute présente un nouvel UniMC « phénoménologique », qui peut atteindre un SOTA zéro avec seulement 200 millions de paramètres. Les travaux connexes ont été acceptés par EMNLP 2022.

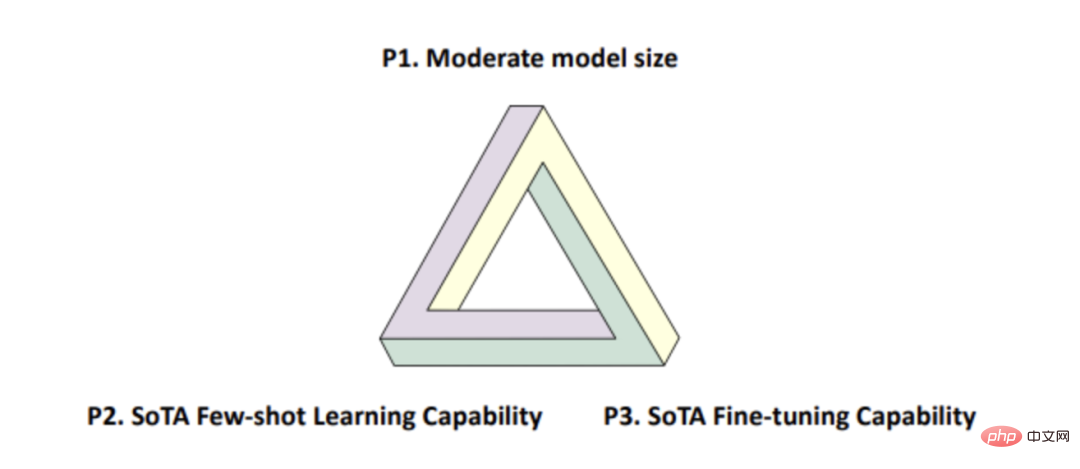

a souligné dans un article [1] cette année que depuis que la technologie de pré-formation a été proposée, il existe un triangle impossible dans le monde de la PNL (comme le montre la figure 1 ci-dessous), c'est-à-dire qu'un modèle ne peut pas satisfaire simultanément :

- Taille de modèle moyenne (moins de 1 milliard) ;

- Performances Few-Shot (ou même Zero-shot) de SOTA ;

- Performances de réglage fin de SOTA.

Figure 1

La raison pour laquelle le triangle impossible existe est que le nombre de paramètres du modèle pré-entraîné actuel n'atteint qu'un certain ordre de grandeur, et l'utilisation de l'apprentissage des indices peut refléter la puissante performance de quelques tirs nuls.

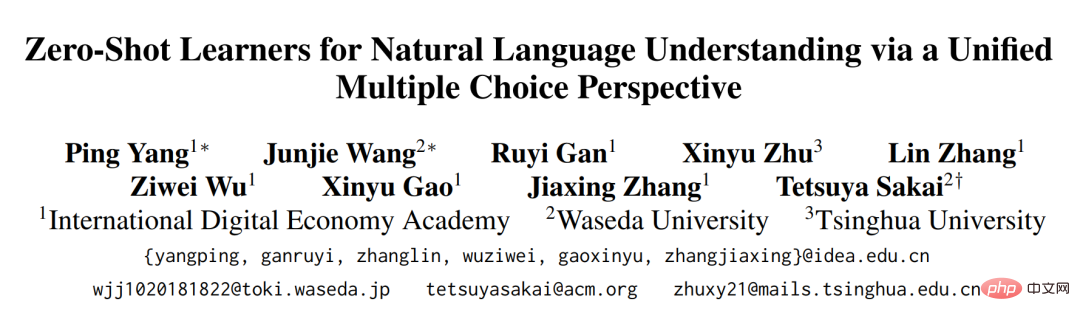

L'article récemment publié par notre équipe de Fengshenbang et inclus dans l'EMNLP 2022 : "Zero-Shot Learners for Natural Language Understanding via a Unified Multiple Choice Perspective" brise cette "malédiction" et fournit une solution flexible et efficace. L'UniMC proposé dans notre article possède un très petit nombre de paramètres de modèle (seulement 100 millions de niveaux) et les capacités de réglage fin de SOTA. Il possède également les performances Few/Zero de SOTA (comparables aux 540 milliards de PaLM-Shot). .

- Adresse papier : https://arxiv.org/abs/2210.08590

- Adresse open source modèle : https://github.com/IDEA-CCNL/Fengshenbang - LM/tree/main/fengshen/examples/unimc/ Contexte technique

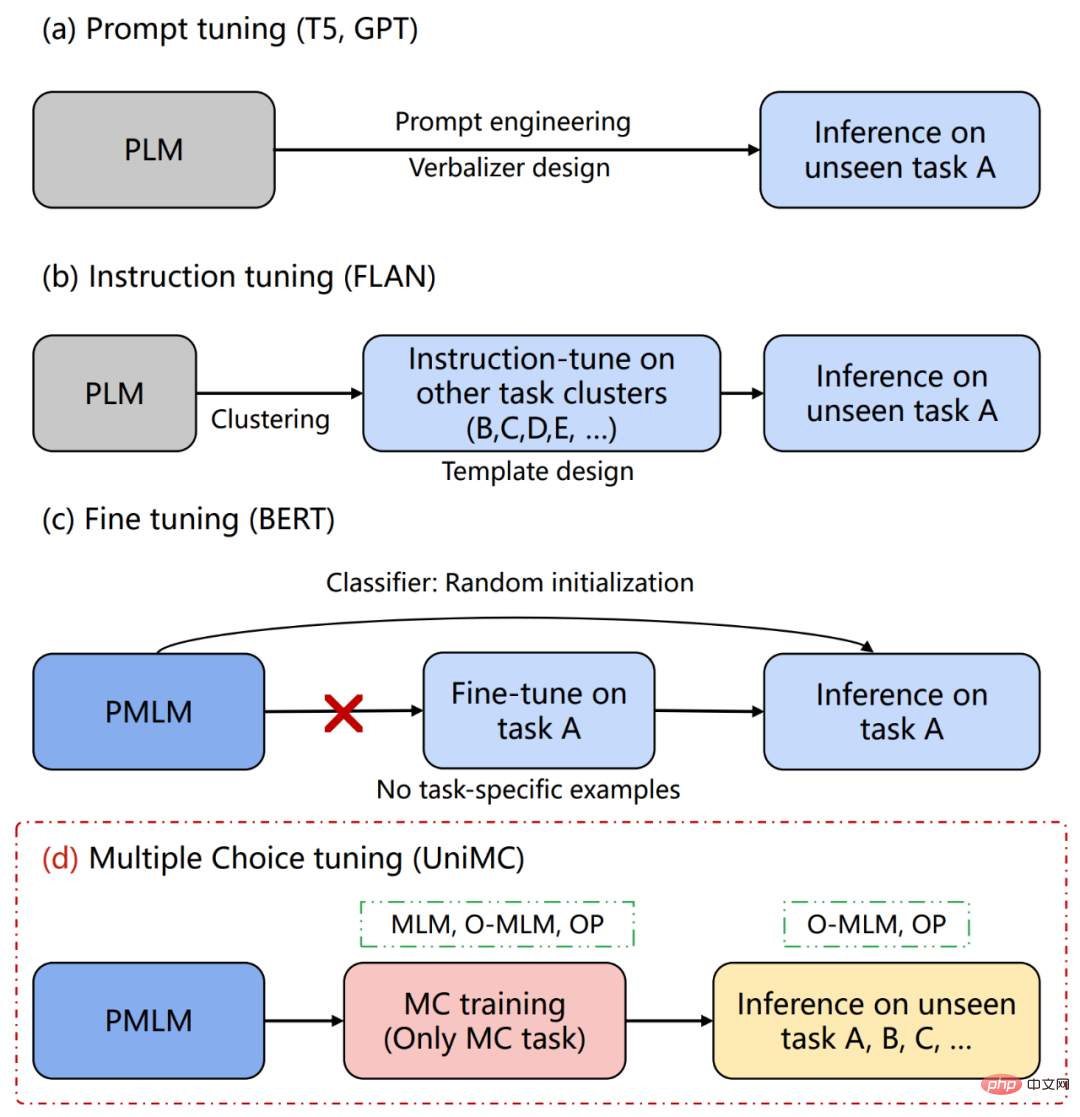

La raison est que lors de l'utilisation de PMLM, nous devons ajouter une couche MLP par-dessus pour des tâches spécifiques, comme le montre la figure 2(c). De plus, cette couche MLP ajoutera des paramètres supplémentaires, ce qui fait que cette méthode choisit uniquement une initialisation aléatoire face à des scénarios sans tir, et il n'y a aucun moyen d'obtenir un résultat raisonnable. De plus, dans le scénario de réglage fin, l'ajout d'une couche MLP rendra également impossible le transfert entre différentes tâches (par exemple, il est impossible de transférer entre des tâches à 2 et 3 classifications).

Pour les scénarios Zero-shot, l'approche dominante de ces dernières années consiste à utiliser des dizaines, voire des centaines de milliards de modèles de langage pré-entraînés (PLM) pour convertir uniformément les tâches NLU en tâches de génération de texte. être construit manuellement ou manuellement Le verbaliseur est conçu de manière à ce que de grands modèles puissent être appliqués à des tâches sans tir, comme le montre la figure 2 (a). De plus, dans l'article FLAN, un grand nombre de modèles construits artificiellement sont utilisés pour unifier différentes tâches, de sorte que la connaissance d'autres tâches puisse être transférée à des tâches spécifiques, comme le montre la figure 2 (b). Cependant, un tel modèle génératif présente les inconvénients suivants :

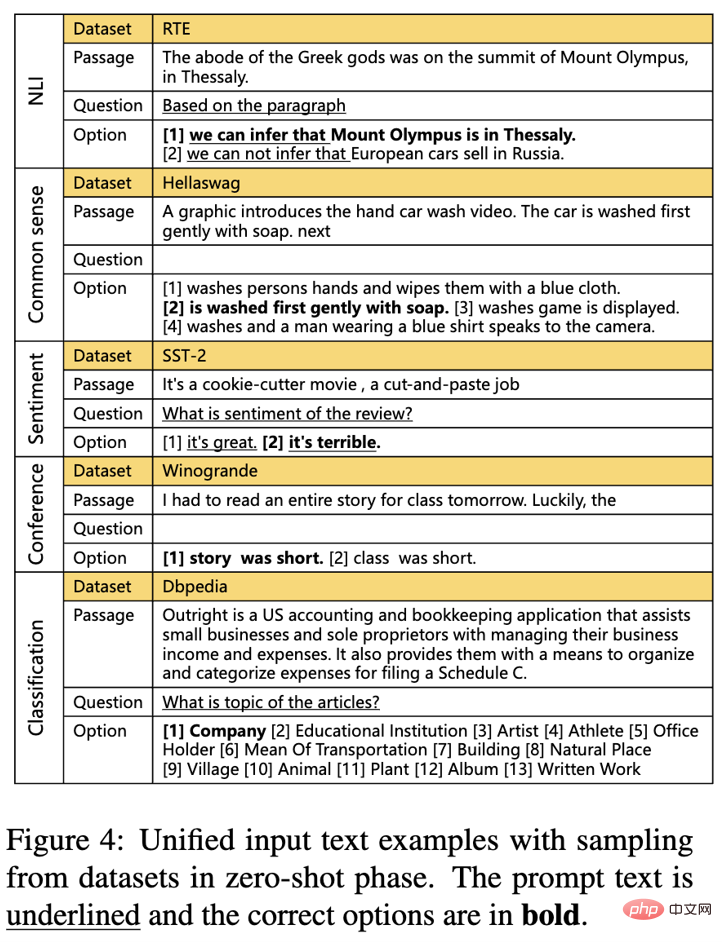

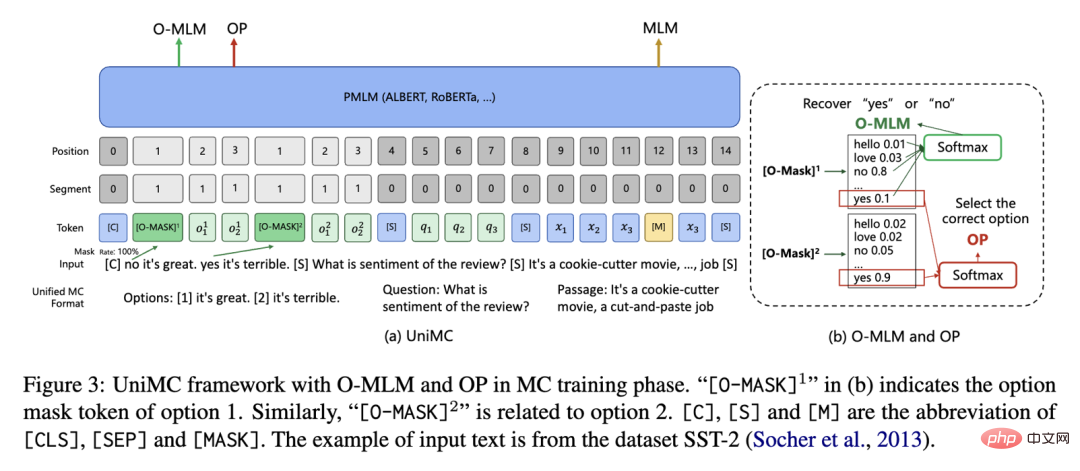

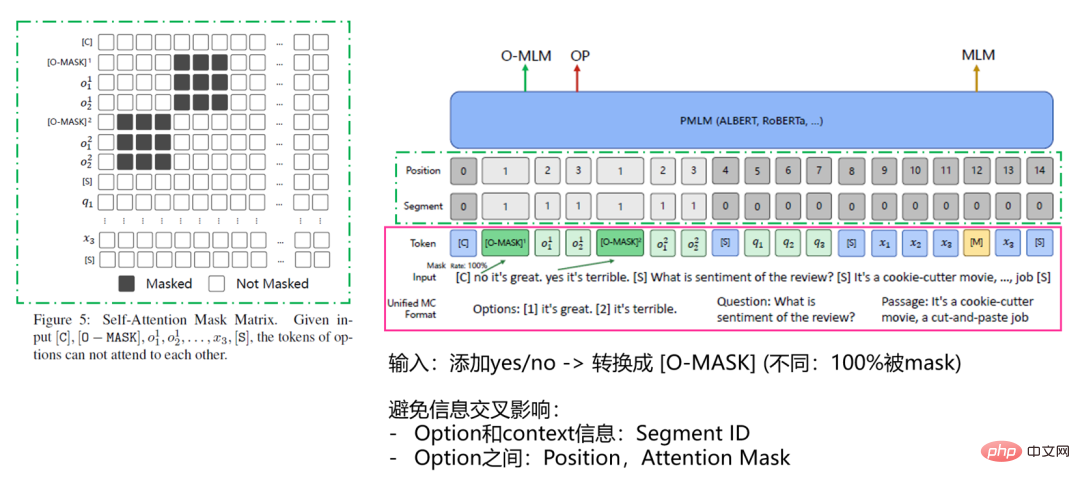

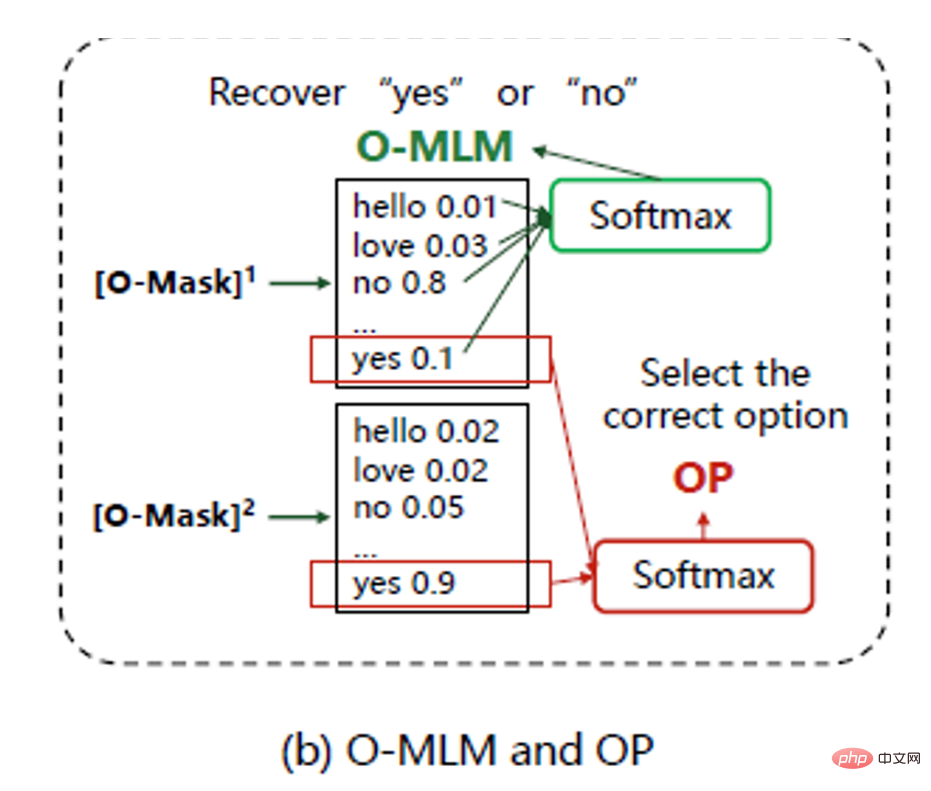

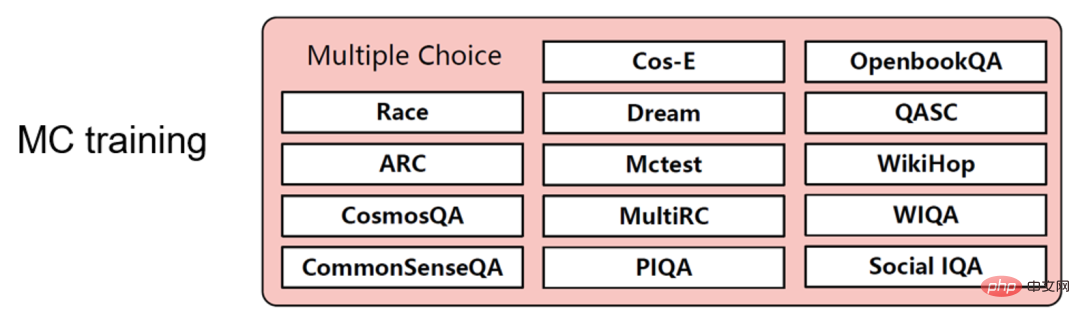

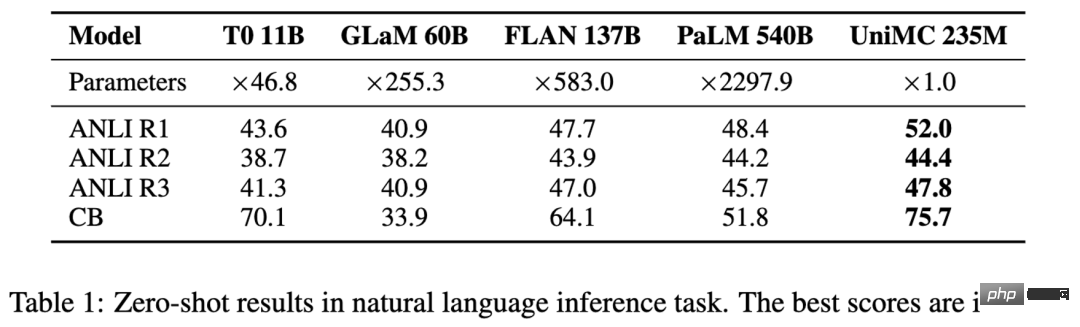

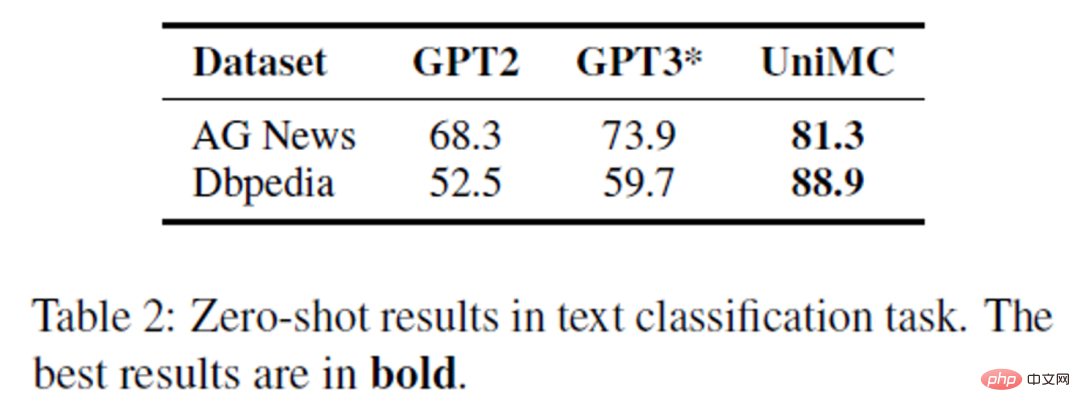

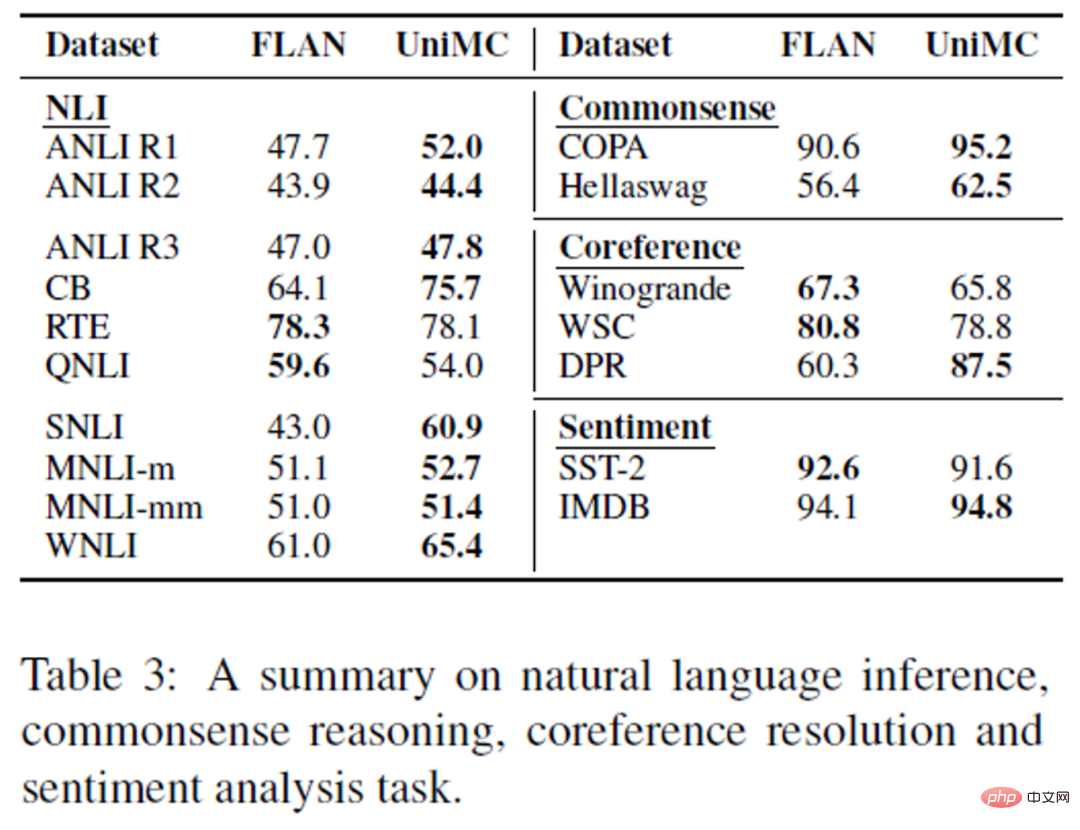

Et nous avons proposé la méthode UniMC dans la figure 2(d), qui évite les problèmes ci-dessus et atteint SOTA ou des performances similaires aux modèles les plus avancés dans plusieurs tâches chinoises et anglaises. Figure 2 Idée de modèle La plupart des tâches NLU sont basées sur des étiquettes, et la génération de modèles nécessite La génération d'étiquettes va sans aucun doute augmenter la difficulté de la tâche et le coût d’apprentissage du modèle. Pour de nombreuses tâches basées sur des étiquettes, il suffit généralement de donner le texte d'entrée et la probabilité que le texte de sortie appartienne à chaque étiquette. Partant de cette idée, nous transformons la tâche NLU en tâche à choix multiples (Multiple-Choice). Autrement dit, étant donné le texte, les questions et les options, affichez la probabilité de chaque option sans générer les options. Sur cette base, nous proposons un nouveau concept : phénomène du modèle. Les expressions de modèle existantes ajoutent toujours une certaine couche ultérieurement, comme une couche de classification. Alternativement, le phénotype du modèle GPT généré consiste à exploiter la connaissance du modèle via Prompt. Le schéma UniMC que nous avons proposé ne nécessite l'introduction d'aucune couche supplémentaire dans le PMLM et exploite un autre phénotype de PMLM. Dans cet article, nous choisissons ALBERT comme réseau PMLM de base. Format uniforme à choix multiples Comme le montre la figure 3, nous espérons convertir toutes les tâches NLU basées sur des étiquettes en un format MC (à choix multiples) unifié. Notre philosophie est d'ajouter le moins d'informations humaines possible. Figure 3 Plus précisément, nous avons effectué les deux étapes suivantes : Avantages : Une seule invite d'option est conçue, et une ou aucune invite de question est conçue. Structure du modèle La structure d'UniMC est illustrée dans la figure 4 ci-dessous, qui utilise une structure d'encodage automatique similaire à BERT. Le processus principal est que nous unifions d'abord les entrées des différentes tâches et limitons le flux d'informations d'entrée. Après PMLM, nous utilisons O-MLM, OP et MLM pour la formation MC, et enfin O-MLM et OP pour la prédiction du tir zéro. . Ensuite, je vais détailler notre solution étape par étape. Figure 4 Entrée Entrée Figure 5 Le contenu de la zone de la zone de ligne continue rouge. Avant d'entrer dans UniMC, il doit être traité et transformé au format de jeton unique d'UniMC. Afin d'améliorer l'efficacité du calcul, nous associons directement toutes les options avec des questions et du texte, c'est-à-dire [Options, Question, Passage]. Et on insère un jeton spécial devant chaque option, [O-MASK], pour indiquer oui ou non (sélectionner cette option ou non). (Remarque : afin d'améliorer la réutilisabilité, nous avons réutilisé le jeton [MASK]. Comme le montre la figure 5, le contenu de la zone verte en pointillés. Nous devons considérer qu'il y a trop de sources d'informations d'entrée, y compris informations sur les options, informations sur les questions et informations sur les segments de texte. Les informations entre elles s'influenceront mutuellement, nous espérons donc isoler différentes informations. Par exemple, si nous pouvons voir d'autres options lors de la saisie, la difficulté de cette question sera réduite et le modèle. sera inerte. Nous avons donc pris en compte les considérations suivantes : Comment le modèle réalise-t-il les questions à choix multiples ? (O-MLM et OP) Comme le montre la figure 6, nous utilisons les tâches O-MLM et OP pour permettre au modèle de « sélectionner » le La réponse O-MASK est entièrement héritée du jeton MASK (en particulier, afin de ne pas ajouter de paramètres supplémentaires et en utilisant pleinement les connaissances acquises par le modèle lors de la phase de pré-formation non supervisée, nous avons réutilisé les paramètres de la tête MaskLM) . La seule différence est qu'il est masqué à 100%. Le but de la tâche O-MLM est de faire décoder O-. Le rôle de la tâche OP est de prédire la réponse à partir du « oui » de chaque option. Plus précisément, nous prenons chaque option [O-MASK] Effectuons un softmax sur le logit de la sortie « oui » pour obtenir la probabilité de chacune. et choisissez l'option avec la probabilité la plus élevée comme réponse prédite. Traitement de plusieurs tâches MC en un seul lot Comme le montre la figure 7, nous espérons mettre plusieurs ensembles de données MC dans un seul lot, ce qui peut améliorer les capacités. du modèle et le rendre plus unifié (Unifié). Lors du traitement par lots, nous avons découvert un problème : que se passe-t-il s'il y a des échantillons avec différentes options dans un lot Nous avons donc conçu une méthode de masque logit pour attribuer directement l'infini négatif à non pertinent ? jetons devant la sortie. En additionnant les valeurs prédites, nous pouvons éliminer l'influence des autres jetons sur O-MASK lors du calcul du softmax. De plus, différents nombres de questions à choix multiples peuvent être traités uniformément dans un seul lot. Figure 7 Formation et prédiction du modèle Différent du réglage des instructions de FLAN, nous nous entraînons uniquement sur l'ensemble de données MC. Il s'agit principalement de permettre au modèle d'apprendre à poser des questions à choix multiples, et l'ensemble de données MC a un certain degré de polyvalence, par exemple. Les ensembles de données peuvent être déterminés par le nombre d'étiquettes inégales. Figure 8 Inférence zéro-shot Fait intéressant, nous pouvons constater que ces deux tâches peuvent être effectuées en deux étapes : Entraînement et inférence zéro-shot Avoir une cohérence. En effet, nous utilisons deux tâches, O-MLM et OP, pour permettre au modèle de répondre à des questions à choix multiples. Et depuis que nous avons abandonné la couche de classification, tous les paramètres peuvent être réutilisés, activant ainsi la capacité Zero-shot du PMLM. Figure 9 Scénario anglais Nous avons collecté 14 tâches à choix multiples pour la pré-formation, puis avons effectué d'autres tâches NLU pour le tir zéro Tests de performances. Dans 4 tâches NLI, UniMC atteint SOTA et dépasse le modèle PaLM à 540 milliards de paramètres. Figure 10 Et nous avons battu le réseau avec GPT-2 et GPT-3 comme épine dorsale sur la tâche de classification. Pour la tâche très difficile de Dbpedia, jusqu'à 13 catégories, une précision même ultra-élevée de 88,9 % peut être obtenue. Figure 11 Afin d'explorer la généralisation de l'UNIMC, nous l'avons comparé avec FLAN. Comme on peut le constater, notre UniMC peut surpasser ou se rapprocher du FLAN dans presque toutes les tâches. Figure 12 Scène chinoise Dans la scène chinoise, nous avons collecté 40 ensembles de données supervisés et les avons uniformément construits sous forme de formulaires de tâches MC pour effectuer des expériences sur le modèle UniMC. -s'entraîner puis tester sur 9 tâches de FewCLUE et ZeroCLUE. Au 30 août 2022, UniMC a atteint la première place dans les listes FewCLUE et ZeroCLUE (Erlangshen sur la photo - UnifiedMC est UniMC). Nous avons proposé une nouvelle solution Zero-shot. aux tâches NLU dans des scénarios, en utilisant uniquement des centaines de millions de paramètres peut vaincre un grand modèle complexe comportant mille fois plus de paramètres. De plus, nous n’introduisons pratiquement aucune information artificielle. Et cela résout le problème de l'incohérence entre la pré-formation et le réglage fin des modèles de type BERT, et notre formation et nos prévisions sont cohérentes. Nous pouvons même effectuer une formation et plusieurs prédictions sans tir, ce qui permet de réduire considérablement les coûts de puissance de calcul. Actuellement, l'équipe IDEA Fengshenban a lancé plus de 70 grands modèles pré-entraînés. Quote [1]Triangle impossible : quelle est la prochaine étape pour les modèles linguistiques pré-entraînés ?https : //readpaper.com/paper/4612531641570566145

UniMC (un nouveau phénotype de modèle)

.

.

Performance UniMC

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI