Maison >Périphériques technologiques >IA >Un examen systématique de la pré-formation en apprentissage par renforcement profond, ainsi que des recherches en ligne et hors ligne, suffit.

Un examen systématique de la pré-formation en apprentissage par renforcement profond, ainsi que des recherches en ligne et hors ligne, suffit.

- 王林avant

- 2023-04-09 11:31:031808parcourir

Ces dernières années, l'apprentissage par renforcement (RL) s'est développé rapidement, grâce à l'apprentissage profond. Diverses avancées dans des domaines allant des jeux à la robotique ont stimulé l'intérêt des gens pour la conception d'algorithmes et de systèmes RL complexes à grande échelle. Cependant, les recherches RL existantes permettent généralement aux agents d'apprendre à partir de zéro lorsqu'ils sont confrontés à de nouvelles tâches, ce qui rend difficile l'utilisation de connaissances préalables acquises pour aider à la prise de décision, ce qui entraîne une surcharge de calcul élevée.

Dans le domaine de l'apprentissage supervisé, le paradigme de pré-formation s'est avéré être un moyen efficace d'obtenir des connaissances préalables transférables. En pré-formation sur des ensembles de données à grande échelle, le modèle de réseau peut s'adapter rapidement aux différents éléments en aval. tâches. Des idées similaires ont également été essayées en RL, en particulier les recherches récentes sur les agents « généralistes » [1, 2], ce qui amène les gens à se demander si quelque chose comme GPT-3 [3] peut également naître dans le domaine universel pré-entraîné. modèle.

Cependant, l'application de la pré-formation dans le domaine de la RL est confrontée à de nombreux défis, tels que les différences significatives entre les tâches en amont et en aval, comment obtenir et utiliser efficacement les données de pré-formation et comment transférer efficacement les connaissances antérieures. , etc., qui entravent la pré-formation. Application réussie des paradigmes de formation en RL. Dans le même temps, il existe de grandes différences dans les contextes expérimentaux et les méthodes envisagées dans les études précédentes, ce qui rend difficile pour les chercheurs de concevoir des modèles de pré-formation appropriés dans des scénarios réels.

Afin de trier le développement de la pré-formation dans le domaine du RL et les éventuelles orientations de développement futures, Des chercheurs de l'Université Jiao Tong de Shanghai et de Tencent ont rédigé une revue pour discuter des méthodes de subdivision et des méthodes de pré-formation RL existantes. -entraînement sous différents contextes Problèmes à résoudre .

Adresse papier : https://arxiv.org/pdf/2211.03959.pdf

Introduction à la pré-formation RL

L'apprentissage par renforcement (RL) fournit une forme mathématique générale pour la décision séquentielle -fabrication . Grâce aux algorithmes RL et aux réseaux neuronaux profonds, les agents appris de manière basée sur les données et optimisant les fonctions de récompense spécifiées ont atteint des performances supérieures aux performances humaines dans diverses applications dans différents domaines. Cependant, bien que la RL se soit avérée efficace pour résoudre des tâches spécifiées, l’efficacité des échantillons et la capacité de généralisation restent deux obstacles majeurs entravant l’application de la RL dans le monde réel. Dans la recherche RL, un paradigme standard consiste pour un agent à apprendre de l'expérience collectée par lui-même ou par d'autres, en optimisant un réseau neuronal grâce à une initialisation aléatoire pour une seule tâche. En revanche, pour les humains, une connaissance préalable du monde facilite grandement le processus de prise de décision. Si la tâche est liée à des tâches vues précédemment, les humains ont tendance à réutiliser les connaissances déjà acquises pour s'adapter rapidement à de nouvelles tâches sans apprendre à partir de zéro. Par conséquent, par rapport aux humains, les agents RL souffrent d’une faible efficacité des données et sont sujets au surajustement.

Cependant, les progrès récents dans d'autres domaines de l'apprentissage automatique préconisent activement l'exploitation des connaissances préalables acquises à partir d'une pré-formation à grande échelle. Grâce à une formation à grande échelle sur un large éventail de données, les grands modèles de base peuvent être rapidement adaptés à une variété de tâches en aval. Ce paradigme de pré-formation et de mise au point s'est avéré efficace dans des domaines tels que la vision par ordinateur et le traitement du langage naturel. Cependant, la pré-formation n’a pas eu d’impact significatif sur le domaine RL. Bien que cette approche soit prometteuse, la conception des principes d’une pré-formation RL à grande échelle se heurte à de nombreux défis. 1) Diversité des domaines et des tâches ; 2) Sources de données limitées ; 3) Adaptation rapide à la difficulté de résoudre les tâches en aval ; Ces facteurs découlent des caractéristiques intrinsèques du RL et nécessitent une attention particulière de la part des chercheurs.

La pré-formation a un grand potentiel pour la RL, et cette étude peut servir de point de départ à ceux qui s'intéressent à cette direction. Dans cet article, les chercheurs tentent de procéder à une revue systématique des travaux de pré-formation existants sur l’apprentissage par renforcement profond.

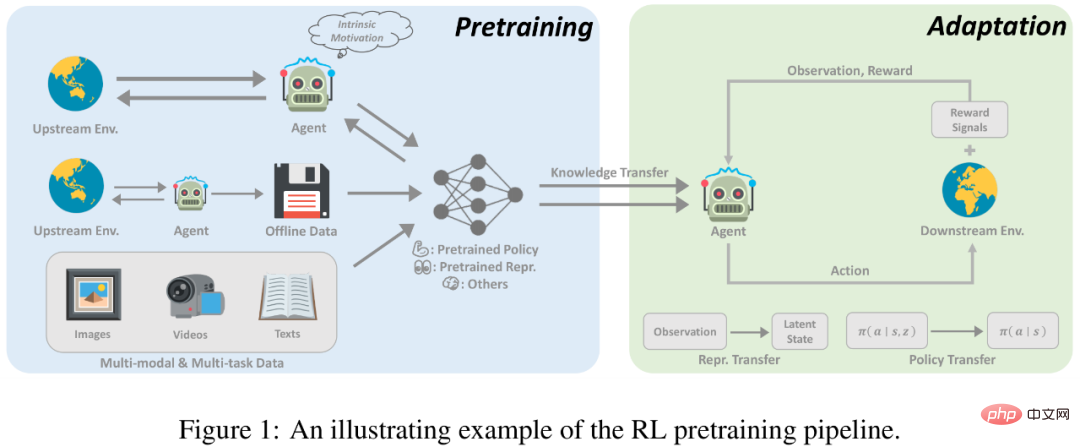

Ces dernières années, la pré-formation par apprentissage par renforcement profond a connu plusieurs avancées. Premièrement, une pré-formation basée sur des démonstrations d’experts, qui utilise l’apprentissage supervisé pour prédire les actions entreprises par des experts, a été utilisée sur AlphaGo. À la recherche d'une pré-formation à grande échelle et moins supervisée, le domaine de la RL non supervisée s'est développé rapidement, ce qui permet aux agents d'apprendre des interactions avec l'environnement sans signaux de récompense. En outre, le développement rapide de l’apprentissage par renforcement hors ligne (RL hors ligne) a incité les chercheurs à réfléchir davantage à la manière d’utiliser des données hors ligne non étiquetées et sous-optimales pour la pré-formation. Enfin, les méthodes de formation hors ligne basées sur des données multitâches et multimodales ouvrent la voie à un paradigme général de pré-formation.

Pré-formation en ligne

Les succès précédents du RL ont été obtenus grâce à des fonctions de récompense denses et bien conçues. Les paradigmes traditionnels de RL, qui ont fait de grands progrès dans de nombreux domaines, sont confrontés à deux défis majeurs lors de leur mise à l’échelle vers une pré-formation à grande échelle. Premièrement, les agents RL sont facilement suréquipés et il est difficile pour les agents pré-entraînés avec des récompenses pour des tâches complexes d'obtenir de bonnes performances sur des tâches qu'ils n'ont jamais vues auparavant. De plus, la conception de fonctions de récompense est généralement très coûteuse et nécessite de nombreuses connaissances spécialisées, ce qui constitue sans aucun doute un défi de taille en pratique.

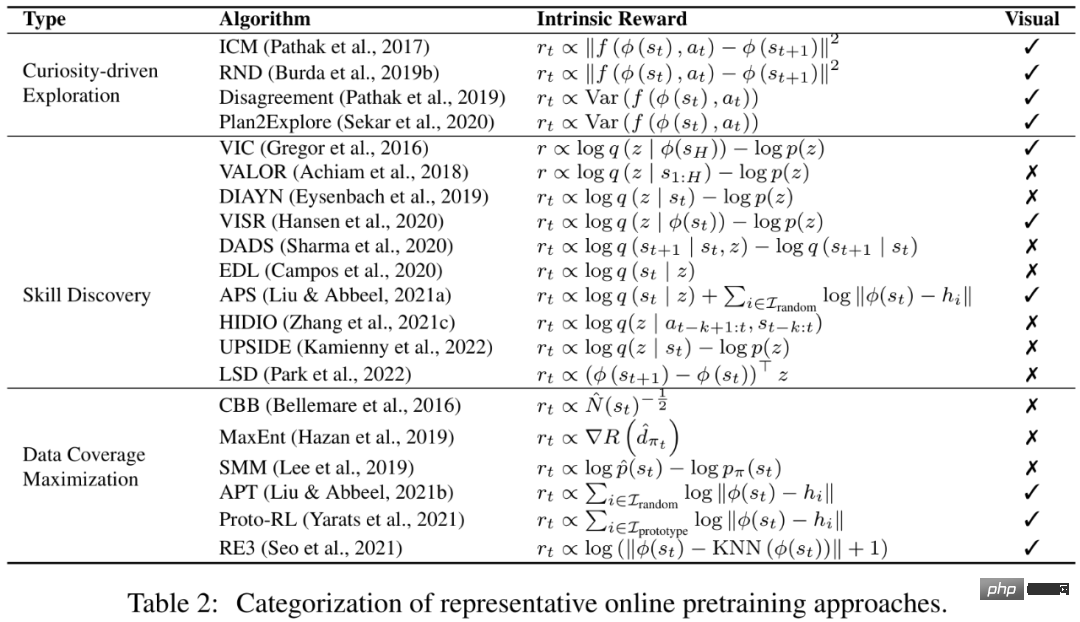

La pré-formation en ligne sans signaux de récompense peut devenir une solution disponible pour apprendre des connaissances préalables universelles et des signaux supervisés sans implication humaine. La pré-formation en ligne vise à acquérir des connaissances préalables par l'interaction avec l'environnement sans supervision humaine. Dans la phase de pré-formation, l’agent est autorisé à interagir avec l’environnement pendant une longue période mais ne peut pas recevoir de récompenses extrinsèques. Cette solution, également connue sous le nom de RL non supervisé, a été activement étudiée par les chercheurs ces dernières années.

Afin de motiver les agents à acquérir des connaissances préalables de l'environnement sans aucun signal de supervision, une méthode mature consiste à concevoir des récompenses intrinsèques pour les agents afin d'encourager les agents à acquérir diverses expériences ou à maîtriser des compétences transférables et à concevoir des récompenses en conséquence. Des recherches antérieures ont montré que les agents peuvent s'adapter rapidement aux tâches en aval grâce à une pré-formation en ligne avec des récompenses intrinsèques et des algorithmes RL standard.

Pré-formation hors ligne

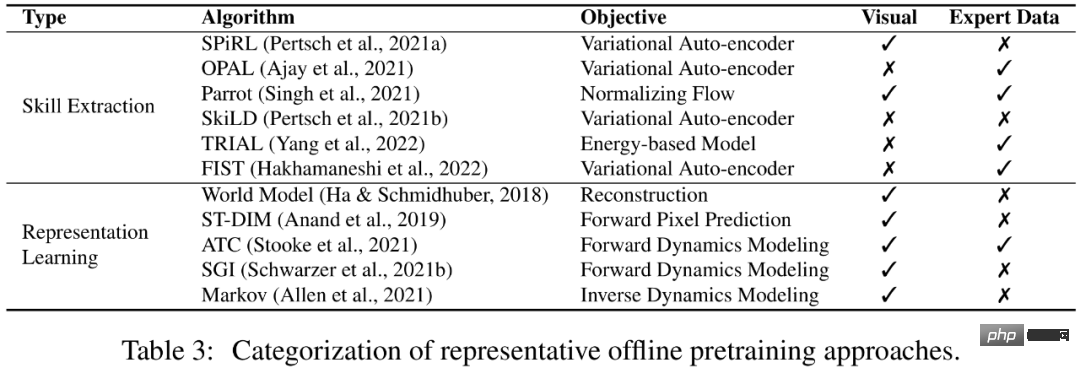

Bien que la pré-formation en ligne puisse obtenir de bons résultats de pré-formation sans supervision humaine, elle est encore limitée pour les applications à grande échelle. Après tout, l’interaction en ligne s’exclut dans une certaine mesure avec la nécessité de se former sur des ensembles de données vastes et diversifiés. Afin de résoudre ce problème, les gens espèrent souvent découpler les liens de collecte de données et de pré-formation et utiliser directement les données historiques collectées auprès d'autres agents ou humains pour la pré-formation.

Une solution réalisable est l'apprentissage par renforcement hors ligne. Le but de l’apprentissage par renforcement hors ligne est d’obtenir une politique RL maximisant les récompenses à partir de données hors ligne. Un défi fondamental est le problème du changement de distribution, c'est-à-dire la différence de distribution entre les données d'entraînement et les données observées lors des tests. Les méthodes d'apprentissage par renforcement hors ligne existantes se concentrent sur la manière de résoudre ce défi lors de l'utilisation de l'approximation de fonctions. Par exemple, les méthodes de contrainte politique exigent explicitement que la politique apprise évite de prendre des actions non vues dans l'ensemble de données, et les méthodes de régularisation de valeur atténuent le problème de surestimation de la fonction valeur en ajustant la fonction valeur à une certaine forme de limite inférieure. Cependant, la question de savoir si les stratégies formées hors ligne peuvent se généraliser à de nouveaux environnements non visibles dans les ensembles de données hors ligne reste sous-explorée.

Peut-être pouvons-nous éviter l'apprentissage des politiques RL et utiliser à la place des données hors ligne pour acquérir des connaissances préalables bénéfiques à la vitesse de convergence ou à la performance finale des tâches en aval. Plus intéressant encore, si notre modèle peut exploiter des données hors ligne sans supervision humaine, il a le potentiel de bénéficier d’énormes quantités de données. Dans cet article, les chercheurs appellent ce paramètre la pré-formation hors ligne, et l'agent peut extraire des informations importantes (telles qu'une bonne représentation et des priorités comportementales) à partir de données hors ligne.

Vers un agent général

Les méthodes de pré-formation dans un seul environnement et une seule modalité se concentrent principalement sur les paramètres de pré-formation en ligne et hors ligne mentionnés ci-dessus, et récemment, dans le domaine Il y a Il y a eu un regain d'intérêt parmi les chercheurs pour la construction d'un modèle général unique de prise de décision (par exemple, Gato [1] et Multi-game DT [2]), permettant au même modèle de gérer des tâches de différentes modalités dans différents environnements. Afin de permettre aux agents d'apprendre et de s'adapter à une variété de tâches ouvertes, la recherche espère exploiter de grandes quantités de connaissances préalables sous différentes formes, telles que la perception visuelle et la compréhension du langage. Plus important encore, si les chercheurs parviennent à établir un pont entre le RL et l’apprentissage automatique dans d’autres domaines et à combiner des expériences réussies antérieures, ils pourront peut-être construire un modèle d’agent général capable d’accomplir diverses tâches.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI