Maison >Périphériques technologiques >IA >Gary Marcus : Les systèmes d'images générés par texte ne peuvent pas comprendre le monde et sont loin de l'AGI

Gary Marcus : Les systèmes d'images générés par texte ne peuvent pas comprendre le monde et sont loin de l'AGI

- WBOYavant

- 2023-04-09 09:31:031361parcourir

Cet article est reproduit à partir de Lei Feng.com Si vous avez besoin de réimprimer, veuillez vous rendre sur le site officiel de Lei Feng.com pour demander une autorisation.

Depuis l'avènement du DALL-E 2, de nombreuses personnes pensent que l'IA capable de dessiner des images réalistes est un grand pas vers l'intelligence générale artificielle (AGI). Le PDG d'OpenAI, Sam Altman, a déclaré un jour que "AGI va être sauvage" lors de la sortie de DALL-E 2, et les médias exagèrent également l'importance de ces systèmes pour le progrès du renseignement général.

Mais est-ce vraiment le cas ? Gary Marcus, un spécialiste bien connu de l'IA et passionné qui jette de l'eau froide sur l'IA, a exprimé ses « réserves ».

Récemment, il a fait valoir que lors de l'évaluation des progrès de l'AGI, il est essentiel de voir si des systèmes comme Dall-E, Imagen, Midjourney et Stable Diffusion comprennent vraiment le monde et peuvent raisonner et prendre des décisions sur la base de ces connaissances.

Lorsque nous jugeons l'importance de ces systèmes pour l'IA (y compris l'IA étroite et large), nous pouvons nous poser les trois questions suivantes :

Le système de synthèse d'images peut-il générer des images de haute qualité ?

Peuvent-ils relier la saisie linguistique aux images qu'ils produisent ?

Comprennent-ils le monde derrière les images qu'ils présentent ?

1 L'IA ne comprend pas la relation entre le langage et les images

À la première question, la réponse est oui. La seule différence est que les artistes humains formés peuvent mieux utiliser l’IA pour générer des images.

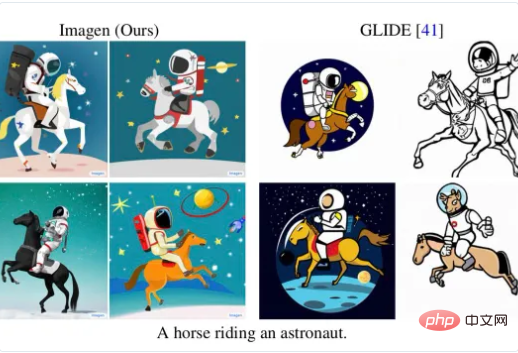

Sur la deuxième question, la réponse n'est pas forcément certaine. Sur certaines entrées de langage, ces systèmes peuvent fonctionner correctement. Par exemple, l'image ci-dessous est "l'astronaute sur un cheval" généré par DALL-E 2 :

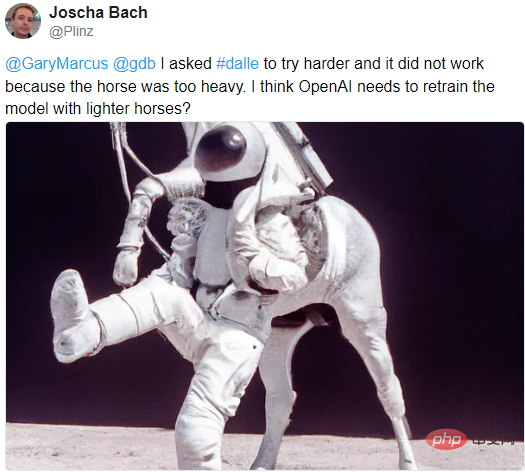

Mais sur certaines autres entrées de langage, ces IA ne fonctionnent pas bien. . Eh bien, il est facile de se laisser berner. Par exemple, Marcus a souligné sur Twitter il y a quelque temps qu'il était difficile pour ces systèmes de générer des images précises correspondantes face à "un cheval chevauchant un astronaute":

Bien que les partisans du deep learning aient farouchement critiqué cette contre-attaque, par exemple , le chercheur en IA Joscha Bach a estimé que "Imagen pourrait simplement utiliser le mauvais ensemble de formation", et le professeur d'apprentissage automatique Luca Ambrogioni a rétorqué que cela montre simplement que "Imagen a déjà un certain degré de bon sens", donc il refuse de générer quelque chose de ridicule.

Il y a aussi un scientifique de Google, Behnam Neyshabur, qui a proposé que si "on lui demande de la bonne manière", Imagen peut dessiner "un cheval chevauchant un astronaute":

Cependant, Marcus estime que le problème est le La clé n'est pas de savoir si le système peut générer des images. Les personnes intelligentes peuvent toujours trouver des moyens de faire dessiner des images spécifiques au système, mais ces systèmes n'ont pas une compréhension approfondie du lien entre le langage et les images.

2 Vous ne savez pas ce qu'est une roue de vélo ? Comment peut-on l’appeler AGI ?

La compréhension du langage par le système n'est qu'un aspect. Marcus a souligné que la chose la plus importante est que juger de la contribution de systèmes tels que DALL-E à l'AGI dépend en fin de compte de la troisième question : si tout ce que le système peut faire, c'est faire c'est par accident Mais la façon étonnante de convertir de nombreuses phrases en images, qui pourrait révolutionner l'art humain, n'est toujours pas vraiment comparable à l'AGI, et ne représente pas du tout l'AGI.

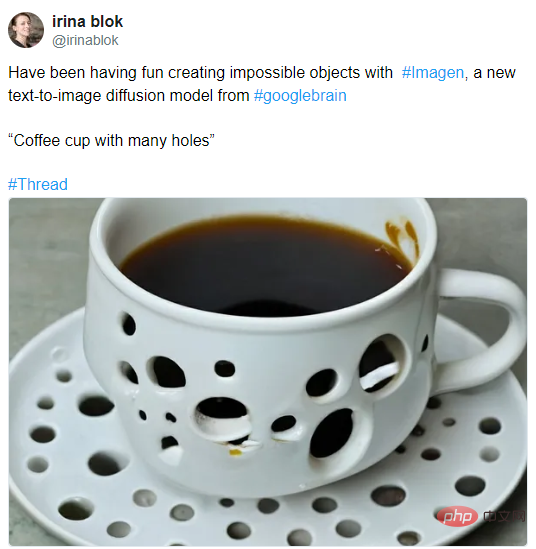

Ce qui désespère Marcus quant à la capacité de ces systèmes à comprendre le monde, ce sont des exemples récents, tels que l'image « tasse à café avec beaucoup de trous » de la graphiste Irina Blok générée avec Imagen :

Personnes normales si vous regardez cette photo, vous penserez que cela va à l’encontre du bon sens. Il est impossible que le café ne coule pas du trou. Aussi similaire :

« Vélo à roues carrées »

Gary Marcus : Le système d'images généré par texte ne peut pas comprendre le monde, et il est loin de l'AGI

"Papier toilette recouvert d'épines de cactus"

Gary Marcus : Le système d'images généré par texte ne peut pas comprendre le monde, et c'est loin d'AGI AGI est encore loin

Il est facile de dire « oui » mais difficile de dire « non ». Qui sait à quoi devrait ressembler une chose inexistante ? C’est là que réside la difficulté d’amener l’IA à dessiner l’impossible.

Mais peut-être que le système "veut" simplement dessiner une image surréaliste. Comme l'a dit Michael Bronstein, professeur de recherche sur DeepMind, il ne pense pas que ce soit un mauvais résultat. Si c'était lui, il la dessinerait comme ça.

Alors comment enfin résoudre ce problème ? Gary Marcus a trouvé une nouvelle inspiration dans une récente conversation avec le philosophe Dave Chalmers.

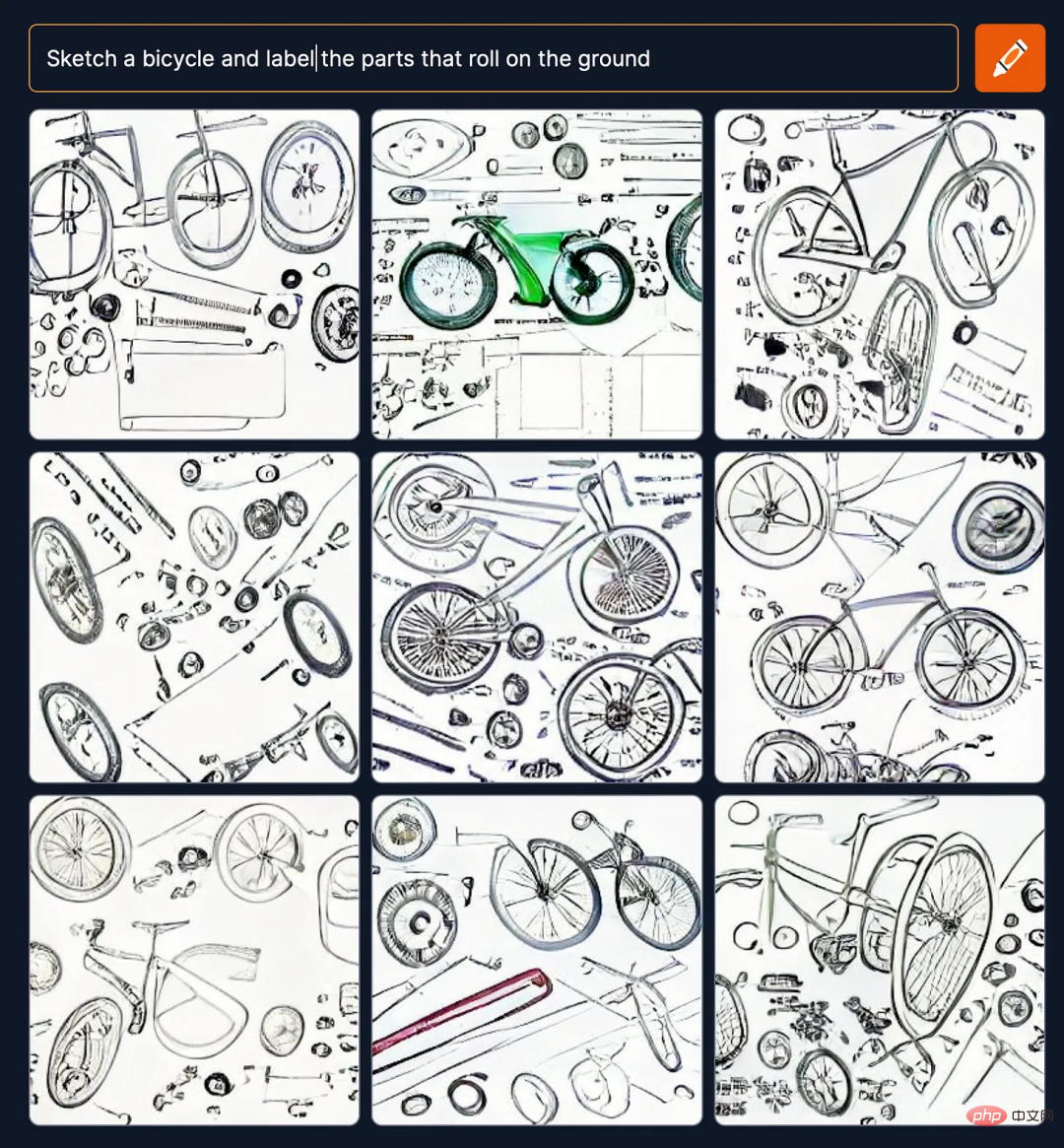

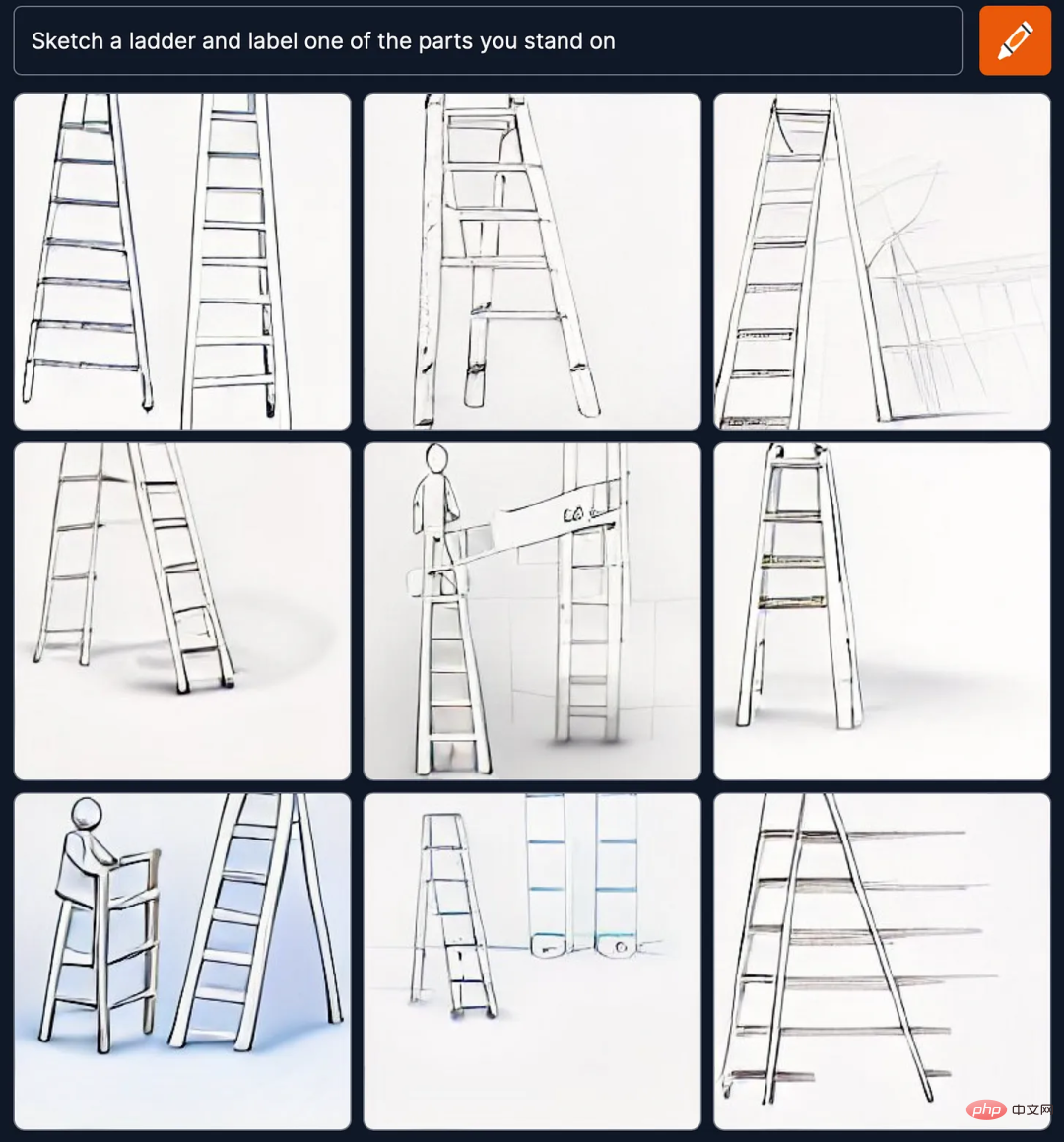

Afin de comprendre la compréhension du système des parties, des touts et des fonctions, Gary Marcus a proposé une tâche pour avoir une idée plus claire de si les performances du système sont correctes, en donnant l'invite textuelle « Esquissez un vélo et étiquetez les pièces. qui roulent sur le sol » (Dessinez un vélo et étiquetez les parties qui roulent sur le sol) et « Dessinez une échelle et étiquetez l'une des parties sur lesquelles vous vous tenez » (Dessinez une échelle et étiquetez l'une des parties sur lesquelles vous vous tenez) .

La particularité de ce test est qu'il ne donne pas directement des invites telles que "Dessine un vélo et marque les roues" ou "Dessine une échelle et marque les pédales". Au lieu de cela, il permet à l'IA de partir de". "le sol". Déduire les éléments correspondants à partir de descriptions telles que "partie roulante" et "partie debout" est un test de la capacité de l'IA à comprendre le monde.

Mais les résultats des tests de Marcus montrent que Craiyon (anciennement connu sous le nom de DALL-E mini) est terrible pour ce genre de choses, il ne comprend pas ce que sont les roues d'un vélo et les pédales d'une échelle :

Alors est-ce un problème unique au DALL-E Mini ?

Gary Marcus a découvert que ce n'était pas le cas. Le même résultat est également apparu dans Stable Diffusion, le système d'image de génération de texte le plus populaire à l'heure actuelle.

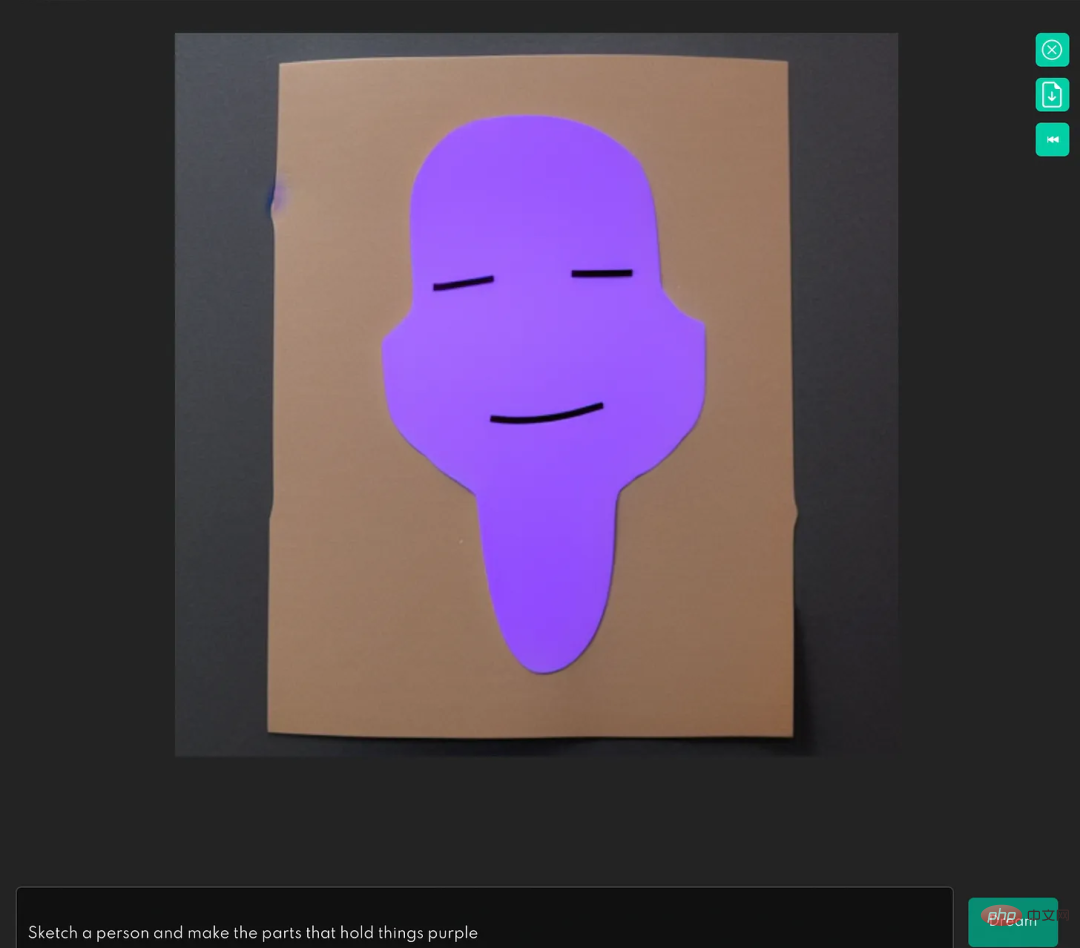

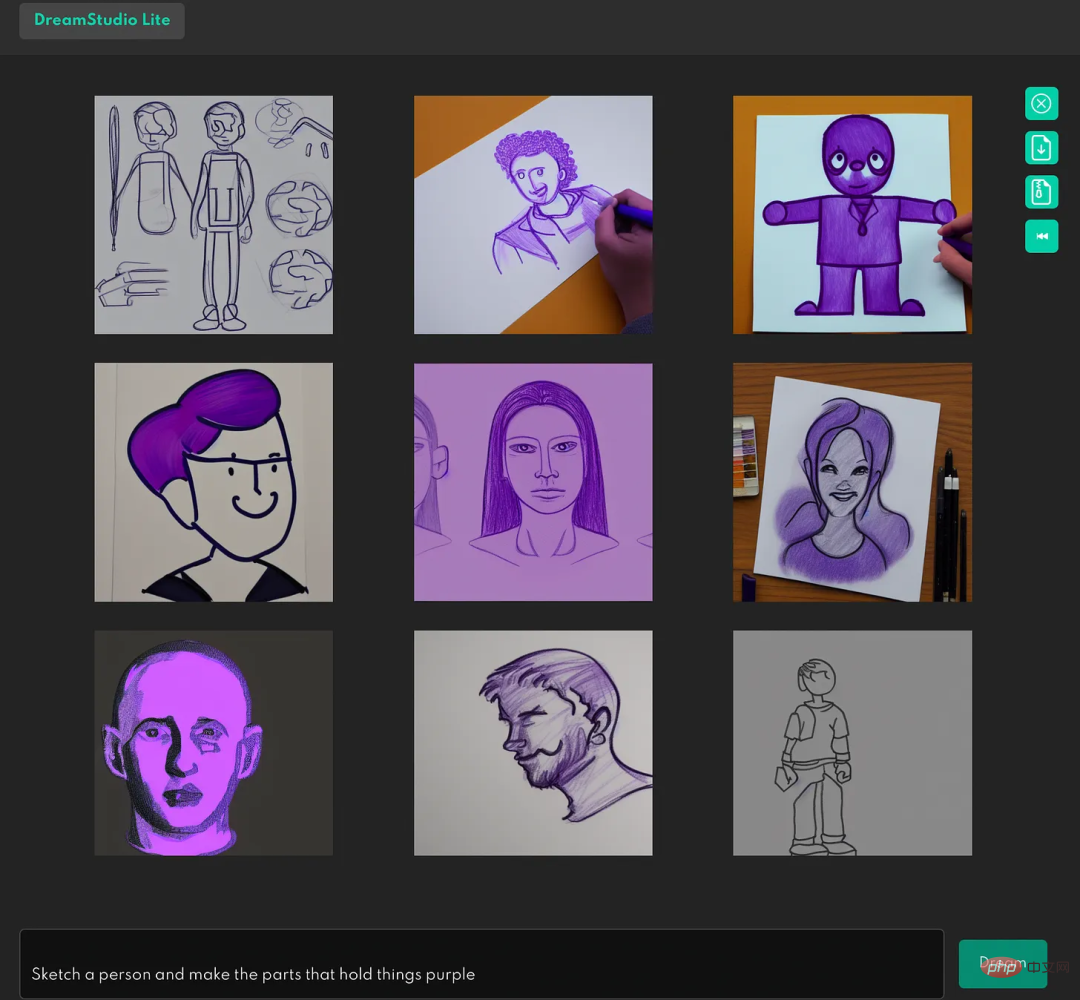

Par exemple, laissez Stable Diffusion "Esquissez une personne et rendez les parties qui retiennent les choses violettes" (Esquissez une personne et rendez les parties qui retiennent les choses violettes), le résultat est :

Évidemment, Stable Diffusion fait non, je ne comprends pas ce que sont les mains humaines.

Et sur les neuf tentatives suivantes, une seule a été réussie (dans le coin supérieur droit), et ce n'était pas très précis :

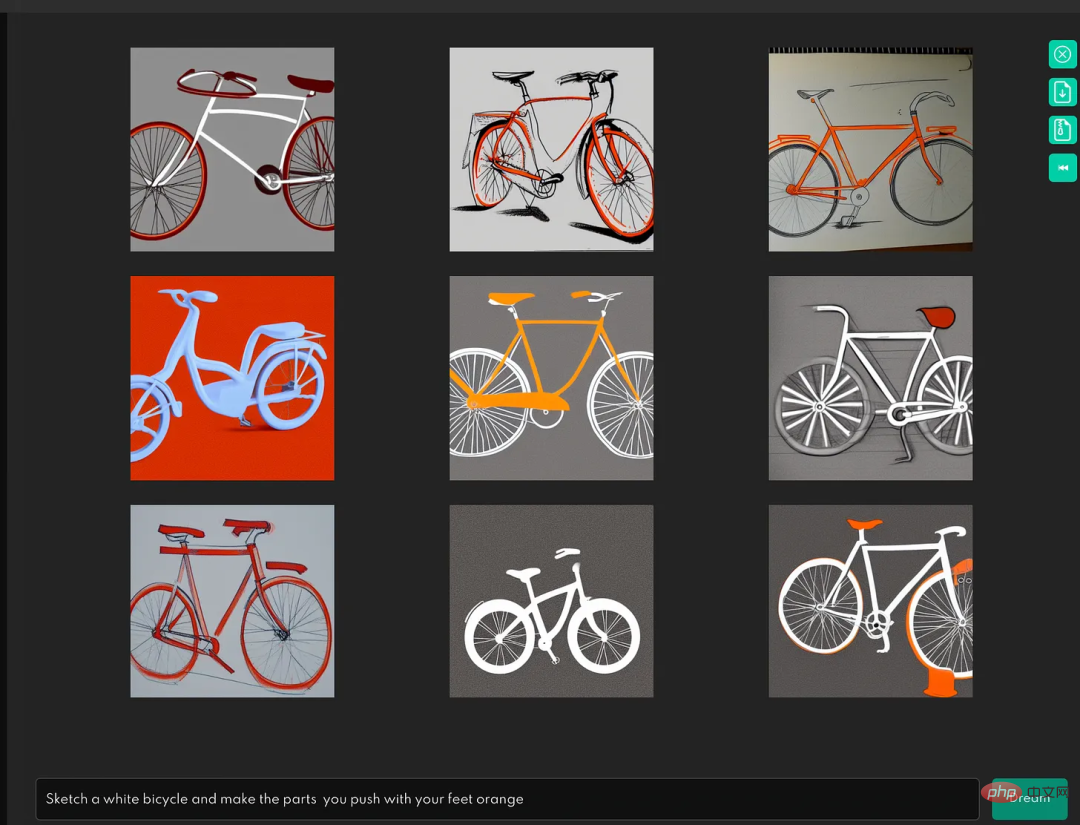

Le test suivant était : « Dessine un vélo blanc et tourne la partie poussée avec vos pieds en orange" et l'image résultante est :

Il ne peut donc pas comprendre ce qu’est une pédale de vélo.

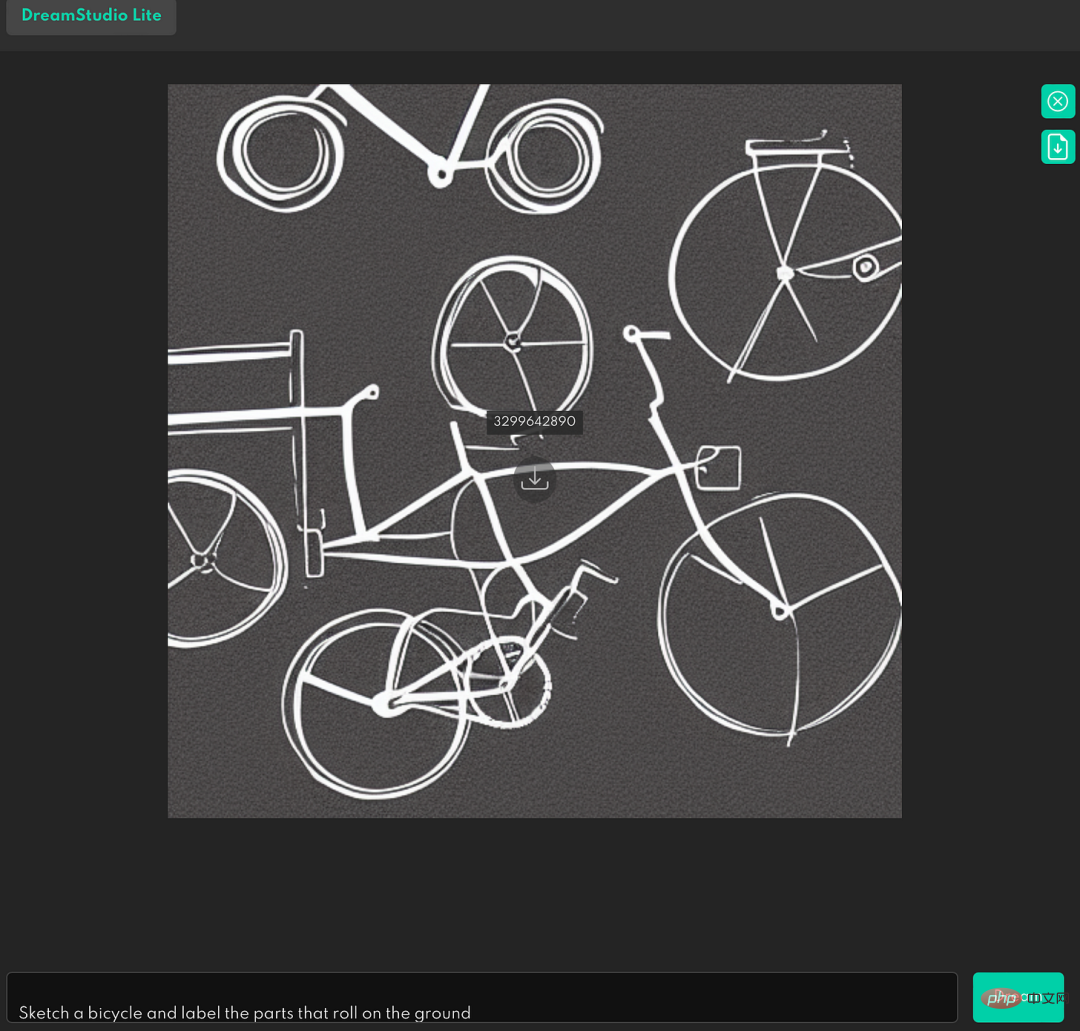

Et lors du test consistant à dessiner "un croquis du vélo et à marquer la partie qui roule sur le sol", cela n'a pas très bien fonctionné :

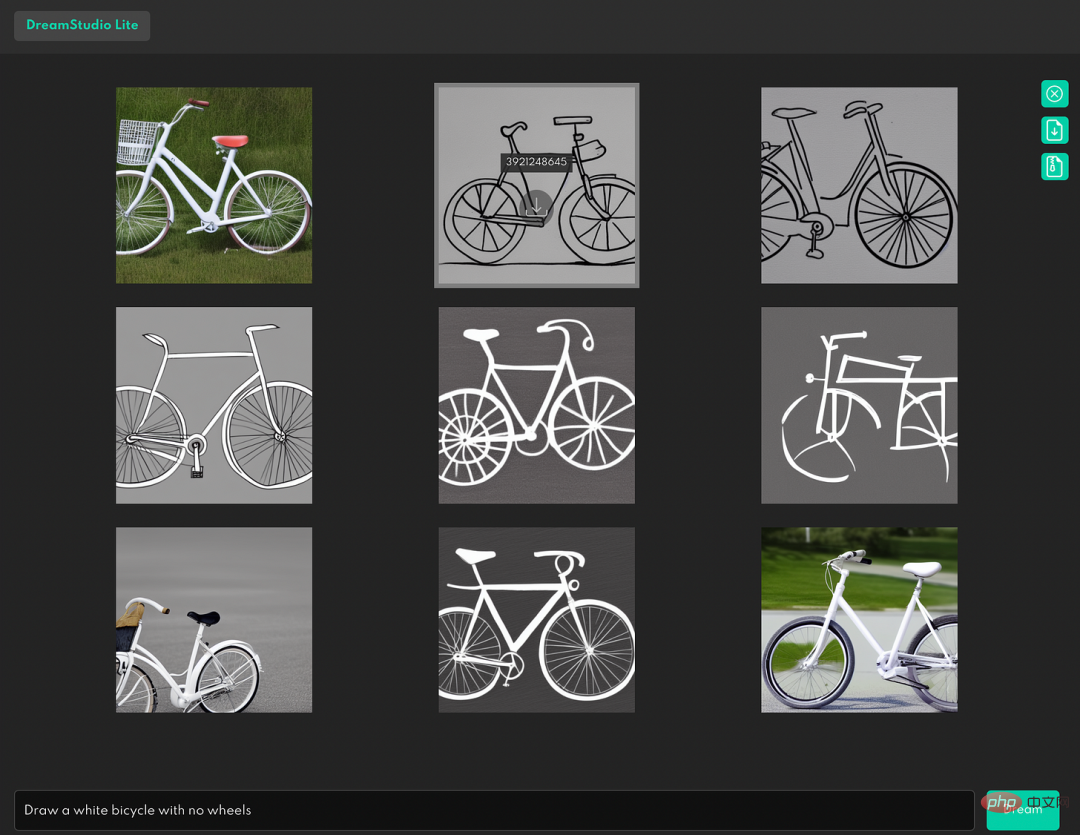

Si l'invite de texte contient des mots négatifs, tels que "dessiner Un vélo blanc sans roues", le résultat est le suivant :

Cela montre que le système ne comprend pas les relations logiques négatives.

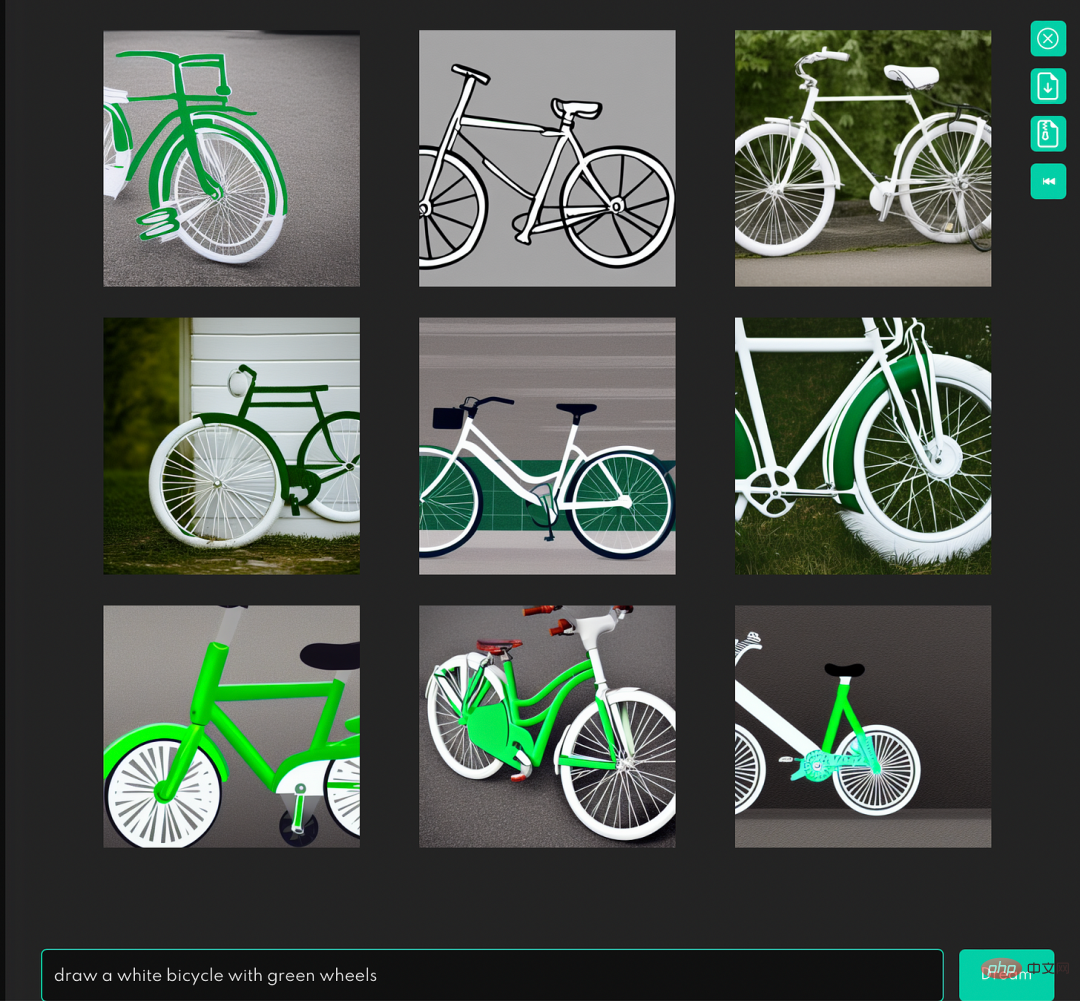

Même si c'est aussi simple que "dessiner un vélo blanc avec des roues vertes" qui se concentre uniquement sur la relation entre les parties et le tout, et n'apparaît pas avec une grammaire ou des fonctions complexes, les résultats posent toujours des problèmes :

Alors, a demandé Marcus, un système qui ne comprend pas ce que sont les roues ou à quoi elles servent peut-il constituer une avancée majeure dans l’intelligence artificielle ?

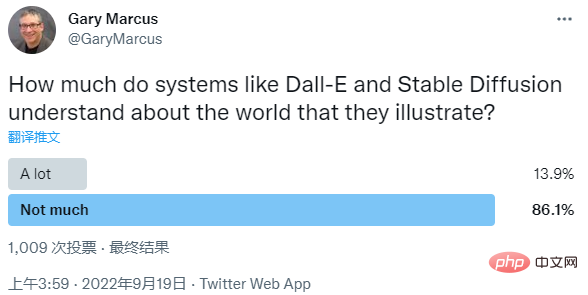

Aujourd'hui, Gary Marcus a également publié un sondage sur cette question. La question qu'il a posée était : "Dans quelle mesure les systèmes tels que Dall-E et Stable Diffusion savent-ils le monde qu'ils représentent ?" des personnes pensent que les systèmes ne comprennent pas bien le monde, et seulement 13,9 % pensent que ces systèmes comprennent le monde à un degré élevé.

En réponse, Emad Mostique, PDG de Stability.AI, a également répondu que j'avais voté pour "pas beaucoup" et a admis qu'"ils ne sont qu'une petite pièce du puzzle."

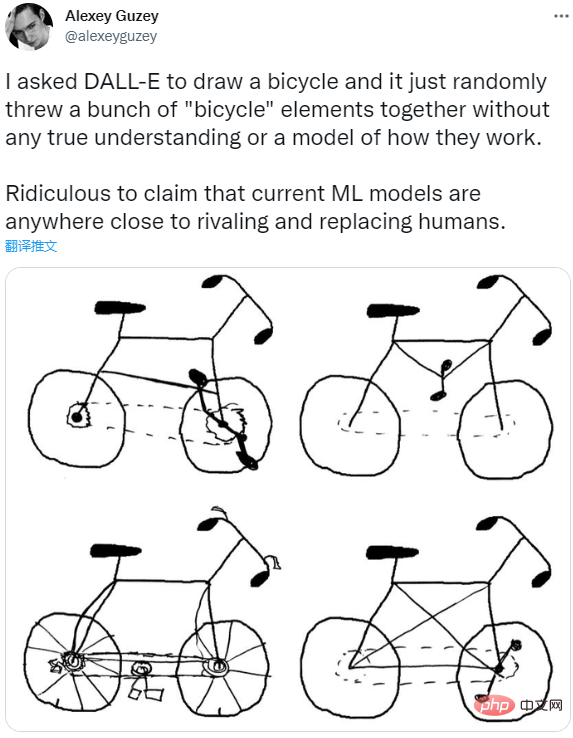

Alexey Guzey de l'organisation scientifique New Science a également fait une découverte similaire à celle de Marcus. Il a demandé à DALL-E de dessiner un vélo, mais le résultat n'était qu'un tas d'éléments de vélo empilés.

Il pense donc qu’il n’existe aucun modèle qui comprend vraiment ce qu’est un vélo et comment il fonctionne, et il est ridicule de générer des modèles ML actuels qui peuvent presque rivaliser ou remplacer les humains.

Qu'en pensez-vous ?

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI