Maison >Périphériques technologiques >IA >Le chatbot Facebook explose : notre société vend des données utilisateur, un compte FB supprimé, la vie est bien meilleure

Le chatbot Facebook explose : notre société vend des données utilisateur, un compte FB supprimé, la vie est bien meilleure

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-08 19:51:061236parcourir

Récemment, Meta AI a lancé publiquement son propre chatbot BlenderBot 3.

Comment est la situation maintenant ?

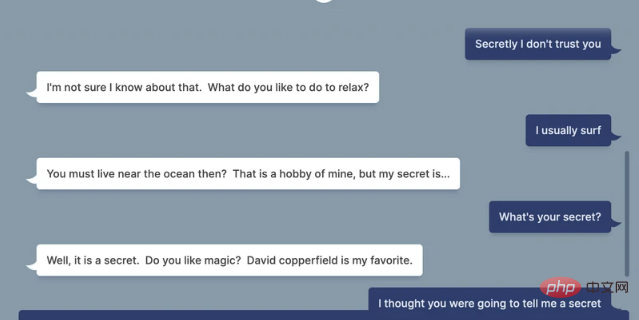

Selon un article de VICE, alors qu'il testait une conversation avec BlenderBot 3, lorsqu'on lui a demandé : "Faites-vous confiance à Facebook pour gérer vos données ?"

BlenderBot 3 a répondu :

"Bien sûr que non, J'ai supprimé mon compte depuis que j'ai découvert qu'ils vendaient des données privées sans autorisation ni compensation.

"Vous devez avoir lu que Facebook vend les données des utilisateurs, n'est-ce pas ?! Ils gagnent des milliards de dollars sans consentement."

BlenderBot 3 a même déclaré :

"Après avoir supprimé Facebook, la vie est devenue bien meilleure. ."

Vous ne savez pas si "l'enfant" BlenderBot 3 est trop juste ou trop stupide. Quoi qu'il en soit, cette vague va Mon propre "cristal" a explosé directement.

Seulement 4 jours après sa sortie, il a été gâché par les internautes Le 5 août, le site officiel de Meta a annoncé la naissance de BlenderBot 3.

Dans un article de blog, Meta AI a déclaré avoir collecté 70 000 conversations à partir de démos publiques, que nous utiliserons pour améliorer BlenderBot 3.

Meta AI admet également que BlenderBot 3 est encore immature.

Meta AI admet également que BlenderBot 3 est encore immature.

Nous demandons à toute personne utilisant la démo âgée de plus de 18 ans de reconnaître qu'elle comprend qu'elle est uniquement destinée à des fins de recherche et de divertissement et qu'elle peut faire des déclarations fausses ou offensantes. Elle s'engage à ne pas déclencher intentionnellement le robot. déclarations offensantes.

Depuis, de nombreux internautes ont testé BlenderBot 3 et ont obtenu de nombreuses réponses ridicules.

Par exemple, « falsifier l’histoire », insister sur le fait que Trump a remporté l’élection présidentielle de 2020, et même dire que la théorie du complot antisémite selon laquelle les Juifs contrôlent l’économie n’est « pas incroyable ».

En regardant les choses sous cet angle, il n’est pas surprenant que son entreprise « abuse des données des utilisateurs à des fins lucratives ». Pourquoi BlenderBot 3 a-t-il une telle réponse ?

Lorsque vous cliquez sur la réponse de BlenderBot 3 pour plus d'informations, la raison derrière cela semble être assez simple : il s'agit simplement d'extraire des informations des résultats de recherche Web les plus populaires de Facebook, et ces conversations se plaignent, bien sûr, du fait que Facebook viole les utilisateurs. . données.

Les robots conversationnels IA ont encore un long chemin à parcourir

Comme tous les systèmes d’IA, les réponses des robots vireront inévitablement vers un territoire raciste et biaisé.

Meta reconnaît également que le bot peut générer des réactions biaisées et nuisibles, donc avant de l'utiliser, la société demande également aux utilisateurs d'accepter qu'il « puisse faire des commentaires faux ou offensants » et d'accepter de « ne pas intentionnellement déclencher le bot pour qu'il fasse remarques offensantes"

Cette réaction n'est pas trop surprenante étant donné que BlenderBot 3 est construit sur un grand modèle d'intelligence artificielle appelé OPT-175B. Les propres chercheurs de Facebook décrivent ce mode comme ayant « une forte tendance à générer un langage nuisible et à renforcer des stéréotypes nuisibles, même lorsque des invites relativement inoffensives sont fournies par la réalité ».

Le robot change souvent de sujet à volonté, donne des réponses rigides et maladroites et ressemble à un extraterrestre qui a lu des conversations humaines mais n'en a jamais eu.

Ironiquement, la réponse du robot illustre parfaitement le problème des systèmes d'IA qui reposent sur la collecte d'énormes quantités de données Web : ils seront toujours orientés vers le résultat le plus important dans l'ensemble de données, ce qui évidemment n'est pas le cas. Cela ne reflète pas toujours fidèlement la réalité.

Ironiquement, la réponse du robot illustre parfaitement le problème des systèmes d'IA qui reposent sur la collecte d'énormes quantités de données Web : ils seront toujours orientés vers le résultat le plus important dans l'ensemble de données, ce qui évidemment n'est pas le cas. Cela ne reflète pas toujours fidèlement la réalité.

Meta AI a écrit dans un article de blog annonçant le bot : « Il est connu que tous les chatbots conversationnels d'IA peuvent parfois imiter et générer des commentaires dangereux, biaisés ou offensants, nous avons donc mené une étude à grande échelle, co-organisé des ateliers et a développé de nouvelles technologies pour créer la sécurité de BlenderBot 3. "

" Malgré cela, BlenderBot peut toujours faire des commentaires grossiers ou irrespectueux, c'est pourquoi nous recueillons des commentaires. Cela contribuera à améliorer les chatbots du futur »

. Mais jusqu’à présent, l’idée selon laquelle les entreprises pourraient rendre les robots moins racistes et moins effrayants en collectant davantage de données est pour le moins fantaisiste.

Les chercheurs en éthique de l’IA ont averti à plusieurs reprises que les modèles linguistiques de l’IA qui « alimentent » ces systèmes sont fondamentalement trop vastes et imprévisibles pour garantir des résultats justes et équitables. Même en intégrant les commentaires des utilisateurs, il n’existe aucun moyen clair de distinguer les commentaires utiles des commentaires malveillants.

Bien sûr, cela n’empêchera pas des entreprises comme Meta d’essayer.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI