Maison >Périphériques technologiques >IA >La recherche a été remise en question, Jeff Dean a répondu : Nous n'essayions pas d'obtenir de nouveaux SOTA, et le calcul des coûts était également erroné.

La recherche a été remise en question, Jeff Dean a répondu : Nous n'essayions pas d'obtenir de nouveaux SOTA, et le calcul des coûts était également erroné.

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-08 16:21:151371parcourir

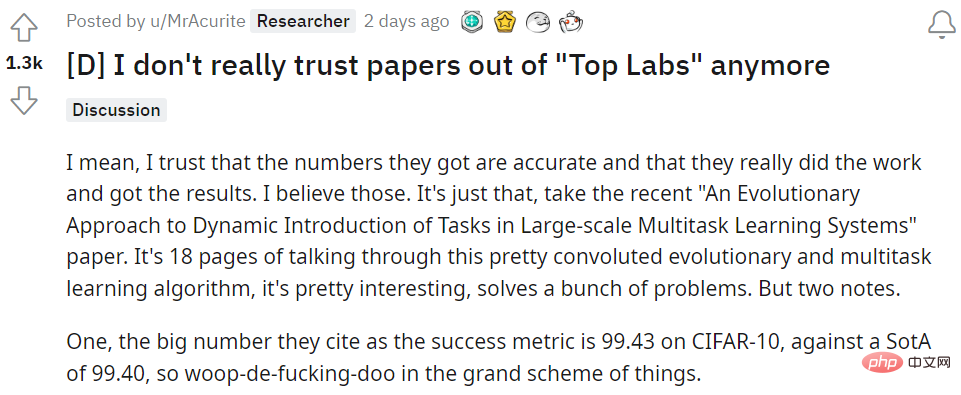

Hier, le sujet le plus populaire dans toute la communauté n'était rien d'autre qu'un chercheur en apprentissage automatique sur Reddit remettant en question la participation du leader de l'IA de Google, Jeff Dean, dans l'article. L'article, intitulé « Une approche évolutive de l'introduction dynamique de tâches dans les systèmes d'apprentissage multitâches à grande échelle », a été soumis jeudi à la plateforme de préimpression arXiv.

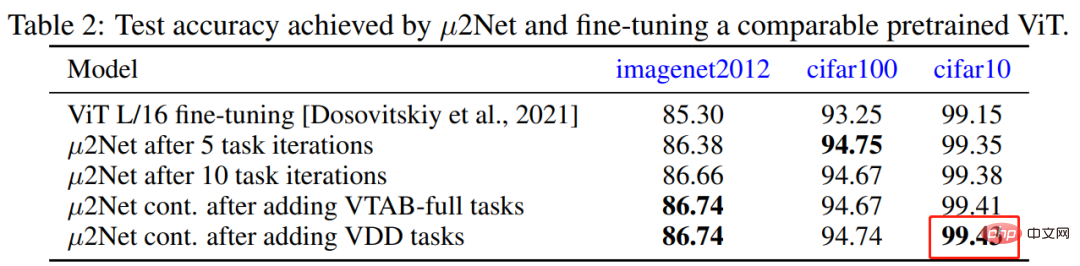

Dans l'article, Jeff Dean et al. ont proposé un algorithme évolutif capable de générer des modèles multitâches à grande échelle, tout en prenant également en charge l'ajout dynamique et continu de nouvelles tâches. Les modèles multitâches générés sont peu activés et intégrés. routage basé sur les tâches. La nouvelle méthode obtient des résultats compétitifs sur 69 tâches de classification d'images, comme l'obtention d'une nouvelle précision de reconnaissance de 99,43 %, la plus élevée de l'industrie, sur CIFAR-10 pour un modèle formé uniquement sur des données publiques.

C'est ce nouveau SOTA réalisé sur CIFAR-10 qui a été remis en cause, le SOTA précédent était de 99,40. Elle a déclaré : « Produire ce résultat a nécessité un total de 17 810 heures de base TPU. Si vous ne travaillez pas chez Google, cela signifie que vous devez utiliser un paiement à la demande de 3,22 $/heure et que le modèle formé coûte 57 348 $

Par conséquent. , a-t-elle demandé à son âme : "Jeff Dean a dépensé suffisamment d'argent pour subvenir aux besoins d'une famille de quatre personnes pendant cinq ans, a réalisé une amélioration de 0,03 % par rapport au CIFAR-10 et a créé un nouveau SOTA. Est-ce que tout cela en vaut la peine ?"

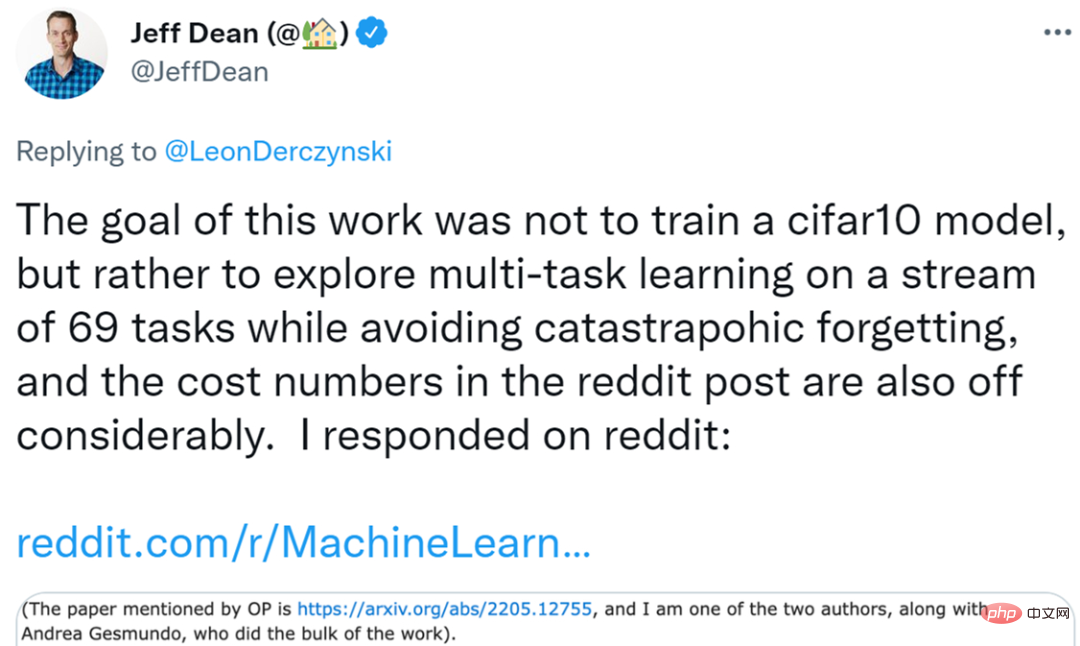

Cette question a été repris par de nombreuses personnes sur le terrain. Certains chercheurs ont même déclaré avec pessimisme : « J'ai presque perdu tout intérêt pour l'apprentissage profond. En tant que praticien dans un petit laboratoire, il est fondamentalement impossible de rivaliser avec les géants de la technologie en termes de budget informatique. Il peut également y avoir des préjugés dans l'environnement grand public qui font qu'il est difficile de voir le jour. Cela crée des règles du jeu injustes. " Alors que le sujet continuait de fermenter, Jeff Dean a personnellement répondu sur Reddit. Il a déclaré: "Le but de notre recherche n'est pas d'obtenir un modèle cifar10 de meilleure qualité, et il y a également des problèmes avec la méthode de calcul des coûts de l'auteur original

Texte intégral de la réponse de Jeff Dean

Texte intégral de la réponse de Jeff Dean

Cet article." est une collaboration entre moi et Andrea Gesmundo et Andrea Gesmundo l'a réalisé ensemble, et Andrea Gesmundo a réalisé la majeure partie du travail sur le papier.

Adresse papier : https://arxiv.org/pdf/2205.12755.pdf

Adresse papier : https://arxiv.org/pdf/2205.12755.pdf

Ce que je veux dire, c'est que le but de cette recherche n'est pas d'obtenir un modèle cifar10 de haute qualité. Cette étude explore plutôt un paramètre qui peut introduire dynamiquement de nouvelles tâches dans un système en cours d'exécution et obtenir avec succès un modèle de haute qualité pour la nouvelle tâche qui réutilisera les représentations des modèles existants et de manière éparse. De nouveaux paramètres sont introduits tout en évitant les problèmes de système multitâches tels que comme un oubli catastrophique ou une migration négative.

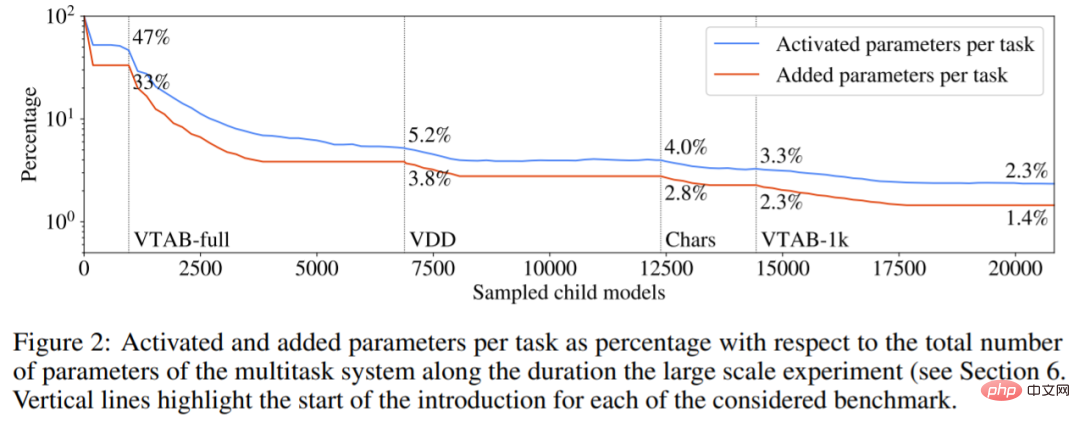

Les expériences de cette étude montrent que nous pouvons introduire dynamiquement 69 flux de tâches différents à partir de plusieurs benchmarks de tâches de visualisation indépendants, pour aboutir à un système multitâche capable de produire conjointement des solutions de haute qualité pour toutes ces tâches. Le modèle résultant est peu activé pour une tâche donnée, le système introduisant de moins en moins de nouveaux paramètres pour les nouvelles tâches (voir la figure 2 ci-dessous). Le système multitâche n'a introduit que 1,4 % de nouveaux paramètres pour les tâches incrémentielles à la fin de ce flux de tâches, chaque tâche activant en moyenne 2,3 % du total des paramètres du modèle. Il existe un partage considérable de représentation entre les tâches, et le processus d'évolution aide à déterminer quand cela a du sens et quand de nouveaux paramètres pouvant être entraînés doivent être introduits pour de nouvelles tâches.

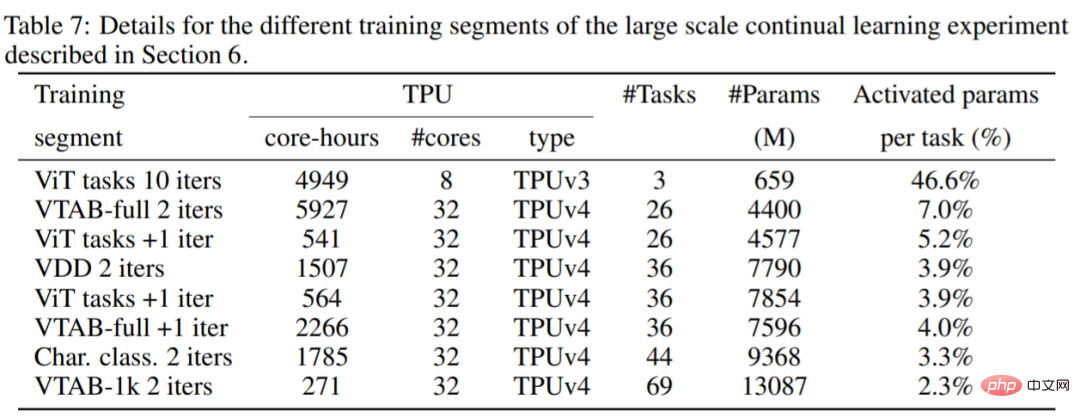

Je pense également que l'auteur du message original a mal calculé le coût. L'expérience consistait à former un modèle multitâche pour résoudre conjointement 69 tâches au lieu de former un modèle cifar10. Comme vous pouvez le voir dans le tableau 7 ci-dessous, les calculs utilisés sont un mélange de cœurs TPUv3 et de cœurs TPUv4, de sorte que les heures de cœur ne peuvent pas être simplement calculées car leur prix est différent.

Je pense également que l'auteur du message original a mal calculé le coût. L'expérience consistait à former un modèle multitâche pour résoudre conjointement 69 tâches au lieu de former un modèle cifar10. Comme vous pouvez le voir dans le tableau 7 ci-dessous, les calculs utilisés sont un mélange de cœurs TPUv3 et de cœurs TPUv4, de sorte que les heures de cœur ne peuvent pas être simplement calculées car leur prix est différent.

À moins que vous n'ayez une tâche particulièrement urgente et que vous ayez besoin de former rapidement des tâches cifar10+68, en fait, ce type de recherche peut facilement utiliser des ressources avec des prix préemptifs, à savoir 0,97 $/heure TPUv4, 0,60 $/heure TPUv3 (pas ce qu'ils disent The You Le tarif à la demande est de 3,22 $/heure). Selon ces hypothèses, le coût de calcul du cloud public décrit dans le tableau 7 est d'environ 13 960 $ (en utilisant des prix préemptifs de 12 861 heures de puce TPUv4 et 2 474,5 heures de puce TPUv3), soit environ 202 $/tâche.

Je pense qu'il est important d'avoir des modèles avec des activations clairsemées et d'être capable d'introduire dynamiquement de nouvelles tâches dans les systèmes existants qui peuvent partager des représentations (le cas échéant) et éviter un oubli catastrophique, ces études méritent au moins d'être explorées. Le système présente également l'avantage que de nouvelles tâches peuvent être automatiquement incorporées dans le système sans avoir à être spécifiquement formulées pour cela (c'est ce que fait le processus de recherche évolutive), ce qui semble être une propriété utile d'un système d'apprentissage continu.

Le code de cet article est open source et vous pouvez le vérifier par vous-même.

Adresse du code : https://github.com/google-research/google-research/tree/master/muNet

L'auteur du message original a répondu à Jeff Dean

Après avoir vu la réponse de Jeff Dean, le message original L'auteur a dit : Pour clarifier, je pense que cet article de Jeff Dean (modèles évolutifs utilisés pour générer une augmentation de modèle dans chaque tâche) est vraiment intéressant, il me rappelle un autre article, mais je ne me souviens plus du titre, l'article parle grossièrement de l'ajout de nouveaux modules à l'ensemble de l'architecture pour chaque nouvelle tâche, en utilisant les états cachés des autres modules dans le cadre de l'entrée de chaque couche, mais sans mettre à jour les poids des composants existants.

J'ai aussi l'idée de construire des modules dans le modèle pour chaque tâche. Savez-vous comment les bébés cerfs peuvent marcher quelques minutes après leur naissance ? En revanche, à cette époque, les faons nouveau-nés ne disposaient pratiquement d'aucune « données d'entraînement » pour apprendre à ressentir le mouvement ou à modéliser le monde, et devaient plutôt exploiter des structures spécialisées dans le cerveau qui devaient être héritées pour que le faon ait des compétences de base. . Ces structures seront très utiles, dans le sens où elles se généraliseront rapidement à une tâche de contrôle nouvelle mais connexe.

Cet article m'a donc fait réfléchir au développement de ces structures héréditaires déjà existantes qui peuvent être utilisées pour apprendre de nouvelles tâches plus efficacement.

Les chercheurs d'un autre laboratoire peuvent avoir la même idée mais obtenir des résultats bien pires car ils ne peuvent pas se permettre de passer de leur configuration existante à une grande plateforme cloud. Et comme la communauté est désormais trop concentrée sur les résultats de SOTA, leurs recherches ne peuvent pas être publiées. Même si le coût n'est « que » de 202 $/tâche, il faut de nombreuses itérations pour bien faire les choses.

Donc, pour ceux d’entre nous qui n’ont pas accès à un gros budget informatique, nous n’avons essentiellement que deux options. La première consiste à prier et à espérer que Google distribuera publiquement le modèle existant et que nous pourrons l'adapter à nos besoins. Mais il s’avère que le modèle a peut-être appris des biais ou des faiblesses contradictoires que nous ne pouvons pas éliminer. La seconde est de ne rien faire et de s'allonger.

Donc, mon problème ne concerne pas seulement cette étude. Si OpenAI veut dépenser des centaines de milliards de dollars (au sens figuré) pour GPT-4, alors donnez-lui plus de pouvoir. Il s’agit d’une culture scientifique et éditoriale qui récompense excessivement le faste, les grands chiffres et le luxe, plutôt que d’aider les gens à s’améliorer dans leur travail réel. Mon article préféré est « Representation Learning with Contrastive Predictive Coding » de van der Oord en 2019, qui utilise une tâche de pré-formation non supervisée, puis une formation supervisée sur un petit sous-ensemble d'étiquettes pour obtenir des résultats de précision étiquetés par réplique, et en discuter. cette amélioration du point de vue de l’efficacité des données. J'ai reproduit et utilisé ces résultats dans mon travail, économisant ainsi du temps et de l'argent. Sur la base de cet article, je suis prêt à devenir son doctorant.

Cependant, OpenAI a proposé un modèle de transformateur plus grand, GPT-3, dans l'article "Language Models are Few-Shot Learners", qui a reçu près de quatre mille citations et le NeurIPS 2020 Best Paper Award, et a également attiré l'attention de l'ensemble des médias.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI