Maison >Périphériques technologiques >IA >Dix questions sur l'intelligence artificielle : Alors que l'IA devient de plus en plus complexe, où est l'avenir ?

Dix questions sur l'intelligence artificielle : Alors que l'IA devient de plus en plus complexe, où est l'avenir ?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-08 16:21:031158parcourir

Ces dernières années, l'intelligence artificielle a connu des explosions, un développement et récemment un déclin progressif de sa popularité. Il semble que l'intelligence artificielle soit devenue un jeu réservé aux grandes entreprises.

La raison en est que le « seuil » de l'intelligence artificielle est de plus en plus élevé.

Il n'y a pas si longtemps, Jeff Dean, la figure représentative de Google AI, a publié un nouvel ouvrage, mais il a fait beaucoup de bruit dans l'industrie. La raison n’est pas que le travail en lui-même soit génial. Cette étude ne s'est améliorée que de 0,03 % par rapport aux derniers résultats, mais elle a coûté plus de 57 000 $ en puissance de calcul TPU, ce qui est une grosse affaire.

Beaucoup de gens disent que la recherche actuelle sur l'IA est devenue une représentation de la puissance et des ressources de calcul, et que les universitaires ordinaires ne peuvent plus étudier.

Il y a encore beaucoup de gens qui ont de tels doutes : quels changements l'intelligence artificielle nous a-t-elle apportés ? Que peut-il faire d'autre que jouer au Go, et que lui réserve l'avenir ?

Avec ces questions, nous avons eu une communication approfondie avec le Dr Feng Ji. Il est directeur exécutif de l'Institut de recherche sur l'IA de Nanjing de Sinovation Ventures et fondateur de Bei Yang Quantitative. Il possède de nombreuses années d'expérience en recherche dans le domaine de l'IA. Grâce à cette conversation, nous avons une nouvelle compréhension du développement et de la mise en œuvre futurs de l’IA.

1 L'innovation en intelligence artificielle, face à un plafond ?

Google a en effet reçu beaucoup d'attention sur cette question récemment. Je pense qu'il y a trois questions qui méritent réflexion :

Premièrement, les grandes entreprises ont progressivement commencé à s'orienter vers une « esthétique violente », c'est-à-dire : en utilisant des « données à très grande échelle » + « une puissance de calcul à très grande échelle », explorant violemment le plafond des réseaux de neurones profonds. Cependant, où sont les limites de cette approche ?

Deuxièmement, d’un point de vue académique et scientifique, cette méthode est-elle la seule issue pour l’IA ? En fait, il existe déjà de nombreuses recherches explorant d'autres voies techniques, comme comment passer de l'intelligence perceptuelle à l'intelligence cognitive, comment utiliser une quantité relativement faible de données pour résoudre les problèmes rencontrés par l'intelligence artificielle, etc.

Troisièmement, une puissance de calcul aussi importante est-elle vraiment nécessaire pour des applications pratiques dans l'industrie ? Il existe un grand nombre de tâches dans l'industrie qui ne sont pas liées à la parole, à l'image et au texte, ce qui oblige également la communauté universitaire à développer des algorithmes plus efficaces.

2 Algorithme d'intelligence artificielle, uniquement réseau de neurones profonds ?

Avant les années 1990, la technologie représentative de « l'intelligence artificielle » était encore basée sur le « symbolisme », c'est-à-dire basée sur un raisonnement logique, des technologies telles que la planification et la recherche.

Après 2010, un changement important dans l'intelligence artificielle a marqué le début, qui consistait à utiliser la technologie des réseaux neuronaux pour mieux représenter ces tâches de perception. Cependant, il existe encore un grand nombre de problèmes du « Saint Graal » de l'intelligence artificielle qui n'ont pas été résolus, comme comment faire un raisonnement logique, comment faire preuve de bon sens, comment mieux modéliser la mémoire, etc.

Pour résoudre ces problèmes, est-il suffisant d'utiliser des réseaux de neurones profonds ? Il s’agit peut-être de la prochaine direction importante qui préoccupe davantage les universités et l’industrie.

3 L'avenir de l'intelligence artificielle : perception vs cognition ?

La soi-disant « intelligence artificielle perceptuelle » est en fait un exemple représentatif de la mise en œuvre réussie de l'intelligence artificielle au cours des dernières années, comme la reconnaissance d'images, la synthèse vocale et certaines tâches de génération de texte.

Mais plus important encore, comment passer de ce type de tâches perceptuelles à des tâches dotées de capacités cognitives, notamment comment utiliser l'intelligence artificielle pour parvenir au raisonnement logique et au bon sens, afin de véritablement réaliser l'intelligence artificielle générale ?

En réponse à ce problème, à ma connaissance, il existe trois principales voies techniques dans le monde universitaire.

Tout d'abord, suivez toujours le chemin des réseaux de neurones et essayez de résoudre le problème en accumulant constamment des données et de la puissance de calcul.

Deuxièmement, essayez d'introduire la technologie du symbolisme, qui est une combinaison de connexionnisme + symbolisme.

Troisièmement, continuez à améliorer les techniques de raisonnement logique traditionnelles, et cette voie est aussi la plus difficile.

4 Data : Comment extraire le pétrole à l’ère du numérique ?

Les données sont devenues de plus en plus importantes pour l'ingénierie de l'intelligence artificielle. L'industrie a proposé un nouveau concept appelé modèle de développement « centré sur les données ». En revanche, on l'appelait auparavant « centré sur le modèle ».

Traditionnellement, les ingénieurs consacrent plus de temps à la création d'un modèle et à l'ajustement des paramètres pour améliorer les performances du système. Mais de nos jours, 80 % de l'attention de chacun se porte sur la manière d'améliorer l'ensemble de données, sur la manière d'améliorer l'ensemble de formation, sur la manière de rendre l'ensemble de formation plus équilibré, puis de laisser le modèle être formé sur un bon ensemble de données et d'obtenir. de meilleurs résultats.

À mesure que notre demande en matière de confidentialité des données augmente progressivement, certains effets négatifs et exigences non techniques apportés par les données augmentent également. Par exemple, lorsque plusieurs institutions effectuent une modélisation conjointe, les données ne peuvent pas être partagées entre les institutions pour des raisons de protection de la confidentialité des données. Les technologies telles que l'apprentissage fédéré sont donc conçues pour réaliser une modélisation conjointe tout en protégeant la confidentialité des données.

Maintenant, tout le monde a progressivement compris que la différence entre chaque organisation dans un développement industriel spécifique réside dans ses données. Maintenant qu'il existe des frameworks logiciels open source très pratiques et des implémentations matérielles très efficaces, les ingénieurs se sont tournés vers les données - Il s'agit d'un changement de paradigme, c'est-à-dire un changement au niveau du paradigme.

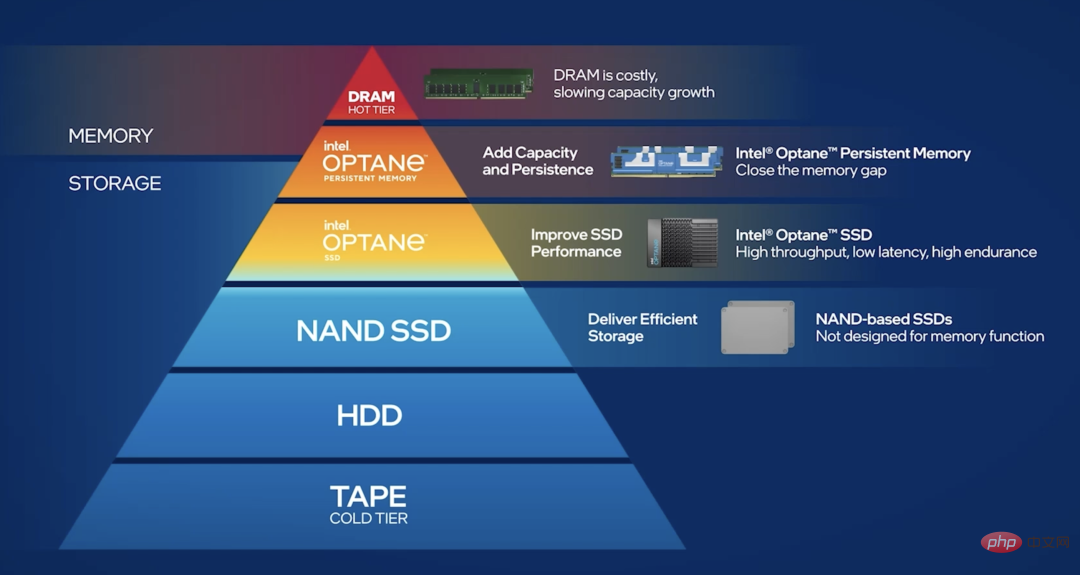

Bei Yang Quantitative, que j'ai moi-même incubé, est un hedge fund dont le cœur est la technologie de l'IA. Au sein de l'entreprise, la quantité de données qui doit être stockée chaque jour est d'environ 25 à 30 To. Nous rencontrons donc le problème du « mur de mémoire ».

Afin de faire face à la pression exercée par les données massives sur la mémoire, nous avons divisé les données en données froides, données chaudes et données chaudes. « Données froides » signifie que la fréquence d'accès aux données n'est pas très élevée et qu'elles peuvent être déposées dans la base de données. Les « données chaudes » signifient que nous devons effectuer de nombreuses tâches de lecture et d'écriture, que les données sont généralement dispersées et que la quantité de lecture et d'écriture à chaque fois est très importante. Alors comment stocker les données chaudes de manière distribuée ?

Par rapport aux solutions SSD pures, il existe désormais de meilleures solutions, comme la mémoire persistante Optane : elle se situe entre la mémoire et le SSD, et peut stocker des données chaudes de manière distribuée, ce qui peut garantir minimiser le « mur de mémoire » " problème.

5Une infrastructure informatique « IA-native » va-t-elle émerger ?

Il existe désormais un concept très populaire appelé « cloud native », qui favorise la reconstruction des infrastructures de cloud computing. Et « AI-native » pour l’intelligence artificielle est bel et bien arrivé. Surtout au cours des 10 dernières années, l’innovation en matière de matériel informatique s’est développée autour des applications d’intelligence artificielle.

Par exemple, nous avons actuellement de plus en plus de demandes en matière d'informatique fiable dans le cloud. Par exemple, le processus de calcul d'un modèle d'IA constitue la propriété intellectuelle essentielle d'une entreprise. S'il est placé sur le cloud ou sur une plateforme publique, il y aura naturellement des inquiétudes quant au risque de vol du processus de calcul.

Dans ce cas, existe-t-il une solution matérielle ? La réponse est oui. Par exemple, nous utilisons le bac à sable de confidentialité SGX sur les puces Intel, qui peut protéger nos calculs matériels. Il s'agit en fait d'une base très importante pour la coopération inter-organisationnelle.

C'est un exemple très typique, qui consiste à pousser les fabricants de puces ou de matériel à proposer des solutions correspondantes en fonction de la demande.

6 Le matériel d'intelligence artificielle est égal au GPU ?

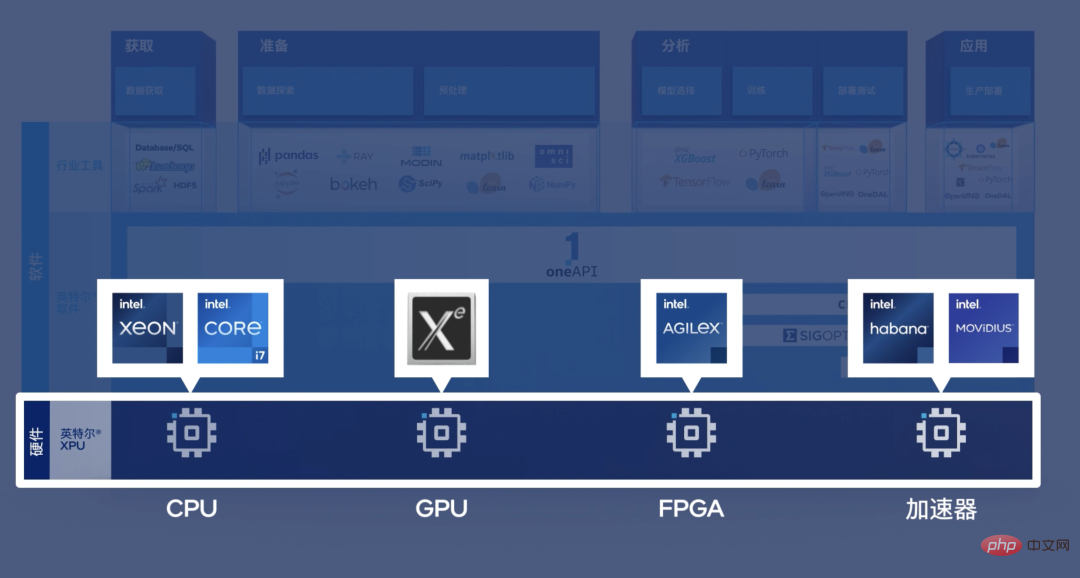

Cette vision est en effet plutôt unilatérale. Prenons l'exemple du travail quotidien de BeiYang Quantitative. Lorsque nous effectuons du trading quantitatif, si nous copions les données du CPU vers le GPU puis les recopions, il sera trop tard pour de nombreuses tâches de trading quantitatif. En d’autres termes, nous avons besoin d’une version CPU très performante de la mise en œuvre du modèle d’intelligence artificielle.

Pour un autre exemple, nous avons de nombreuses tâches qui nécessitent une analyse et un traitement des données directement sur la carte réseau, et la carte réseau a généralement une puce FPGA, et il est même trop tard pour transférer les données qu'elle traite vers le GPU. Pour ce type de scénario à faible latence qui nécessite l’aide de la technologie de l’intelligence artificielle, nous avons besoin d’une architecture hétérogène.

En d'autres termes, qu'il s'agisse de FPGA, ASIC, CPU ou GPU, ils ont des utilisations différentes dans différents scénarios.

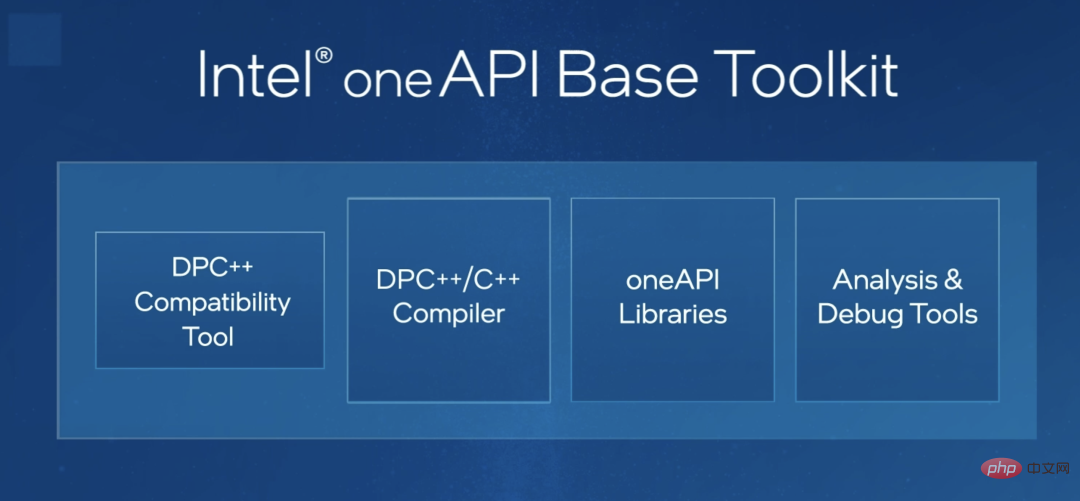

Concernant la programmation pour plateformes hétérogènes, je constate que l'industrie a déjà fait quelques tentatives. Par exemple, oneAPI d'Intel, je pense que c'est un outil très important. En d’autres termes, oneAPI permet au même ensemble de codes de s’adapter automatiquement au CPU, au FPGA ou à d’autres types de puces. Cela réduira considérablement les difficultés de programmation pour les ingénieurs et leur permettra de se concentrer sur l’innovation algorithmique.

Je pense que c'est très important pour promouvoir des applications hétérogènes.

7 Quelles sont les autres orientations pour le développement de l'intelligence artificielle dans le futur ?

Je pense qu'une meilleure solution de bout en bout pourrait être nécessaire. Nous sommes désormais passés de l'ère du « Logiciel 1.0 » à l'ère du « Logiciel 2.0 ». En d'autres termes, De la construction traditionnelle d'un génie logiciel complexe basée sur des règles à une méthode de construction du génie logiciel basée sur les données.

Avant, nous devions compter sur notre grande ingéniosité pour écrire une série de systèmes exquis permettant de faire fonctionner l'ensemble du programme. Ceci est similaire à une montre mécanique. Les meilleurs programmeurs se concentrent sur le fonctionnement des « engrenages » et sur la façon de faire fonctionner cette « montre ».

Maintenant, si je ne sais pas comment déterminer cet ensemble de règles de fonctionnement, alors donnez-le simplement à une grande quantité de données ou à un algorithme d'apprentissage automatique. Cet algorithme générera un nouvel algorithme, et ce nouvel algorithme est. Des choses que nous voulons obtenir. Cette approche s’apparente un peu à la construction d’un robot qui construit des robots.

À l'ère du logiciel 2.0, le paradigme de développement de l'ensemble de l'ingénierie logicielle subira un grand changement. Nous espérons vraiment obtenir une solution de bout en bout. L'essentiel est de savoir comment mettre en œuvre plus facilement « centrée sur les données. " Logiciel. Développement technique.

8 Comment l'intelligence artificielle sera-t-elle mise en œuvre à l'avenir ?

Je pense qu'il y a probablement deux aspects. Premièrement, d’un point de vue industriel, nous devons encore partir des premiers principes, c’est-à-dire en nous basant sur nos propres besoins et en tenant compte de nombreux facteurs non techniques. Par exemple, j'ai vu une entreprise qui souhaitait développer un système de reconnaissance faciale pour la sécurité communautaire, mais chaque entrée et sortie nécessitait quatre GPU très coûteux. C'est un exemple typique de ne pas partir des besoins et des coûts.

Deuxièmement, la recherche universitaire ne suit pas forcément la tendance. Comme nous l'avons dit au début, il n'est pas nécessaire d'être en concurrence quant à la taille des modèles : si vous en avez un avec des centaines de milliards, j'en construirai un avec des milliards, et si vous en avez un avec des milliards, je construirai un. Dix mille milliards.

En fait, il existe un grand nombre de tâches qui nécessitent des paramètres à petite échelle, ou seul un petit nombre d'échantillons peut être fourni en raison du coût et d'autres contraintes. Dans de telles conditions, comment innover et faire des percées ? C’est une responsabilité que la communauté universitaire devrait prendre l’initiative d’assumer.

9 L'entrepreneuriat en intelligence artificielle est-il toujours un sujet d'actualité ?

Réfléchissons-y. À la fin des années 1990, la création d'un site Web coûtait entre 20 000 et 30 000 yuans, car à cette époque, il y avait très peu de personnes possédant des compétences en programmation réseau. Mais aujourd’hui, n’importe quel lycéen peut probablement créer un site Web en un seul clic de souris.

En d’autres termes, la connaissance des réseaux fait déjà partie de la boîte à outils de tout programmeur ordinaire.

En fait, la technologie de l'intelligence artificielle est la même. Vers 2015, il n’y avait probablement pas plus de 1 000 personnes dans le monde capables de créer un framework d’apprentissage profond et de l’exécuter sur un GPU. Mais maintenant qu’il a connu une croissance exponentielle, de nombreuses personnes savent comment s’y prendre. Nous avons des raisons de croire que dans environ cinq ans, tout programmeur disposera de solutions d'intelligence artificielle plus riches dans sa boîte à outils, et le seuil de sa mise en œuvre sera certainement continuellement abaissé. Ce n’est qu’ainsi que la technologie de l’intelligence artificielle pourra être plus largement utilisée dans chaque entreprise.

Ainsi, les laboratoires d'IA dans les grandes usines vont inévitablement disparaître. Tout comme vers 2000, de nombreuses entreprises disposent d'un Internet Lab, qui est un laboratoire dédié à toutes les questions liées aux réseaux de l'entreprise, et ce laboratoire fournit des informations techniques aux autres services métiers. En effet, très peu de gens connaissent cette technologie et doivent donc le faire.

Il en va de même pour AI Lab. Lorsque le seuil de mise en œuvre de la technologie de l'IA sera progressivement abaissé et qu'un grand nombre de personnes dans les départements commerciaux posséderont également des technologies similaires, ce type de AI Lab disparaîtra inévitablement. Je pense qu'il s'agit d'un produit temporaire en cours de développement technologique, ce qui est une bonne chose. Quand les grands fabricants n’auront pas d’AI Labs, ce sera probablement l’ère où l’intelligence artificielle s’épanouira vraiment.

10 Comment l'intelligence artificielle peut-elle profiter au public ?

Tout d’abord, nous avons également besoin de la bénédiction de la loi de Moore. Il existe encore un grand nombre de tâches qui nécessitent beaucoup de puissance de calcul. Nous devons continuer à itérer le matériel et à mettre à jour l'algorithme. Ce n’est que lorsque les éléments qui doivent être exécutés sur un cluster peuvent l’être sur un téléphone mobile que l’IA peut être mise en œuvre en grand nombre.

Deuxièmement, l'innovation en matière d'intelligence artificielle doit se déplacer du commerce Internet vers certaines industries traditionnelles. Auparavant, l’énergie de chacun était consacrée à la manière d’utiliser l’intelligence artificielle pour créer de meilleures solutions visuelles, ou de meilleurs systèmes de recommandation, ou un meilleur logiciel P-picture. Mais dans l’économie réelle, il existe en réalité un grand nombre de départements et d’entreprises qui génèrent des données. Lorsque ces données économiques réelles pourront être mieux informées, la valeur qu’elles apporteront pourrait dépasser de loin celle de l’économie virtuelle actuelle.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI