Maison >Périphériques technologiques >IA >Dernière interview avec Oriol Vinyals, scientifique en chef de DeepMind : L'avenir de l'IA générale repose sur un méta-apprentissage interactif puissant

Dernière interview avec Oriol Vinyals, scientifique en chef de DeepMind : L'avenir de l'IA générale repose sur un méta-apprentissage interactif puissant

- PHPzavant

- 2023-04-08 13:31:091042parcourir

Depuis qu'AlphaGo a vaincu les humains au Go en 2016, les scientifiques de DeepMind ont travaillé à l'exploration de puissants algorithmes généraux d'intelligence artificielle, et Oriol Vinyals en fait partie.

Vinyals a rejoint DeepMind en 2016 et est actuellement le scientifique en chef, dirigeant le groupe d'apprentissage profond. Auparavant, il a travaillé chez Google Brain. Son doctorat a été obtenu à l'Université de Californie à Berkeley, où il a reçu le MIT TR35 Innovator Award 2016. Ses résultats de recherche sur seq2seq, la distillation des connaissances et TensorFlow ont été appliqués à des produits tels que Google Translate, la synthèse vocale et la reconnaissance vocale. Ses articles ont été cités plus de 160 000 fois.

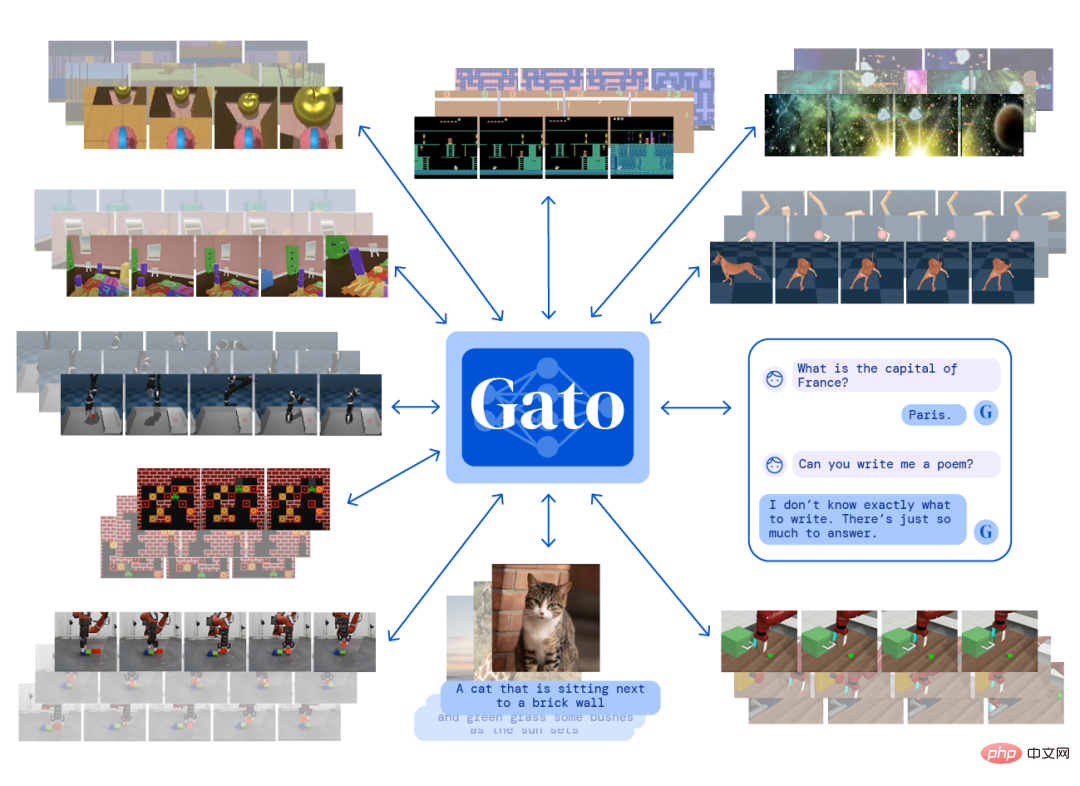

Récemment, Oriol Vinyals était l'invité du podcast de Lex Fridman et a parlé de certains de ses points de vue sur l'apprentissage profond, l'agent généraliste Gato, le méta-apprentissage, les réseaux de neurones, la conscience de l'IA et d'autres directions. Vinyals estime :

- L'expansion de l'échelle du modèle peut améliorer la synergie entre les modes multimodaux de l'agent. Les modèles modulaires sont un moyen d'étendre efficacement l'échelle du modèle grâce à la réutilisation du poids, le modèle n'a pas besoin de le faire. être formé à partir de zéro ;

- À l'avenir, le méta-apprentissage accordera plus d'attention à l'apprentissage interactif entre l'agent et l'environnement

- Le biais d'attention inductif intégré à Transformer le rend plus puissant que les autres architectures de réseaux neuronaux ; réussite technique de modèles ou d'agents généraux à grande échelle. Les clés sont : l'ingénierie des données, l'ingénierie du déploiement et l'établissement de lignes de base.

- Les modèles d'IA existants sont encore loin de produire de la conscience. Les cerveaux biologiques sont bien plus complexes que les cerveaux informatiques. La façon dont la pensée humaine fonctionne peut inspirer la recherche au niveau des algorithmes.

- À l'avenir, les systèmes d'IA pourraient avoir le même niveau d'intelligence ; comme les humains. Mais il est incertain qu’il puisse dépasser les niveaux humains.

1. Algorithme universel

Fridman : Un système d'IA peut-il être construit de notre vivant et nous remplacer dans cette conversation ? Intervieweur ou interviewé ?Vinyals :

Ce que je veux demander, c'est : voulons-nous y parvenir ? Je suis heureux de voir que nous utilisons des modèles très puissants et que nous avons l'impression qu'ils se rapprochent de nous, mais la question est : serait-ce toujours un artefact intéressant sans le côté humain de la conversation ? Probablement pas. Par exemple, dans StarCraft, nous pouvons créer des agents pour jouer à des jeux et rivaliser avec eux-mêmes, mais en fin de compte, ce qui importe aux gens, c'est comment l'agent se comportera lorsque le concurrent est un humain. Il ne fait donc aucun doute qu’avec l’IA, nous serons plus forts. Par exemple, vous pouvez filtrer certains problèmes très intéressants du système d'IA. Dans le domaine du langage, nous appelons parfois cela "Terry Picking". De même, si j'avais un outil comme celui-ci en ce moment, vous poseriez une question intéressante et un certain système sélectionnerait quelques mots pour former la réponse, mais ce n'est pas très excitant pour moi.

Fridman : Et si exciter les gens faisait en soi partie de la fonction objective de ce système ?Vinyals

: Dans les jeux, lorsque vous concevez un algorithme, vous pouvez écrire la fonction de récompense comme objectif. Mais si vous pouvez le mesurer et l’optimiser, qu’y a-t-il d’excitant ? C’est probablement la raison pour laquelle nous jouons à des jeux vidéo, interagissons en ligne et regardons des vidéos de chats. En effet, il est très intéressant de modéliser les récompenses au-delà des fonctions de récompense évidentes utilisées en apprentissage par renforcement. De plus, l'IA réalise des avancées clés dans des aspects spécifiques, par exemple, nous pouvons évaluer si une conversation ou une information est digne de confiance en fonction de son acceptation sur Internet. Ensuite, si vous pouvez apprendre une fonction automatiquement, vous pouvez plus facilement optimiser, puis avoir une conversation pour optimiser certaines des informations les moins évidentes comme l'excitation. Il serait intéressant de construire un système où au moins un aspect serait entièrement piloté par la fonction de récompense excitatrice.

Mais évidemment, le système contient encore de nombreux éléments humains provenant du constructeur du système, et l'étiquette d'excitation vient de nous, il est donc difficile de calculer l'excitation. Autant que je sache, personne n'a encore fait quelque chose de pareil.

Fridman : Peut-être que le système doit également avoir un fort sentiment d'identité. Il aura des souvenirs et pourra raconter des histoires sur son passé. Il peut tirer des leçons des opinions controversées, car il existe de nombreuses données sur Internet sur les opinions des gens et sur l’enthousiasme associé à une certaine opinion. Le système peut en créer quelque chose qui n’optimise plus la grammaire et la vraisemblance, mais optimise la cohérence humaine de la phrase.Vinyals : Du point de vue d'un constructeur de réseaux de neurones, d'intelligence artificielle, vous essayez généralement de cartographier un grand nombre de sujets intéressants dont vous avez parlé en benchmarks, puis également en questions sur la façon dont ces systèmes sont actuellement construits, comment Dans l'architecture actuelle de l'apprentissage, apprendre à partir de quelles données et de quoi apprendre, nous allons parler ici du poids des fonctions mathématiques. Dans l’état actuel du jeu, de quoi avons-nous besoin pour vivre ces expériences de vie, comme la peur ? Du côté du langage, nous constatons très peu de progrès à l'heure actuelle, car ce que nous faisons actuellement, c'est prendre des quantités massives d'interactions humaines en ligne, puis extraire des séquences, qui sont des chaînes de mots, de lettres, d'images, de sons, de modalités, puis essayer d'apprendre une fonction, via un réseau neuronal, pour maximiser la probabilité de voir ces séquences. Certaines des façons dont nous formons actuellement ces modèles permettront, espérons-le, de développer le type de capacités dont vous parlez. L’un d’eux est le cycle de vie de l’agent ou du modèle, que le modèle apprend à partir des données hors ligne, de sorte qu’il se contente d’observer et de maximiser passivement. Tout comme dans un paysage montagneux, où il y a des données sur les interactions humaines partout, augmentez le poids là où il n'y a pas de données, réduisez le poids. Les modèles ne font généralement pas d’expérience eux-mêmes, ils sont simplement des observateurs passifs des données. Nous leur demandons ensuite de générer des données au fur et à mesure que nous interagissons avec eux, mais cela limite considérablement l'expérience qu'ils peuvent réellement expérimenter lors de l'optimisation ou de l'optimisation supplémentaire des pondérations. Mais nous n’en sommes même pas encore là. Dans AlphaGo et SlphaStar, nous déployons le modèle et le laissons rivaliser avec les humains ou interagir avec les humains (comme les modèles de langage) pour entraîner le modèle. Ils ne sont pas continuellement formés, ils n’apprennent pas sur la base des poids tirés des données et ils ne s’améliorent pas continuellement. Mais si l'on pense aux réseaux de neurones, il est compréhensible qu'ils n'apprennent pas des changements de poids au sens strict du terme, car ils sont liés à la manière dont les neurones sont interconnectés et à la manière dont nous apprenons tout au long de notre vie. Mais lorsque vous parlez à ces systèmes, le contexte de la conversation existe bel et bien dans leur mémoire. C'est comme si vous démarriez un ordinateur et qu'il contient de nombreuses informations sur son disque dur, vous avez également accès à Internet qui contient toutes les informations. Il y a aussi la mémoire, que nous considérons comme l'espoir de l'agent. Le stockage est très limité pour le moment, on parle maintenant d'environ 2 000 mots que l'on possède, au-delà on commence à oublier ce que l'on voit, donc une certaine continuité à court terme est là. Si l'agent a de la cohérence, alors si vous demandez « Quel est votre nom ? », il peut se souvenir de cette phrase, mais il peut oublier le contexte au-delà de 2 000 mots. Donc, techniquement parlant, il y a une telle limite à ce que les gens peuvent attendre du deep learning. Mais nous espérons que les références et la technologie pourront accumuler continuellement de l'expérience en mémoire, et que l'apprentissage hors ligne est évidemment très puissant. Nous avons parcouru un long chemin, nous avons constaté à nouveau le pouvoir de ces imitations ou de l'échelle d'Internet pour donner du poids à ces connaissances de base sur le monde, mais l'expérience manque. En fait, lorsque nous parlons aux systèmes, nous ne les entraînons même pas à moins que leur mémoire ne soit affectée. C'est la partie dynamique, mais ils n'apprennent pas de la même manière que vous et moi apprenons dès la naissance. Donc, en réponse à votre question, ce que je veux dire ici, c'est que la mémoire et l'expérience sont différentes de la simple observation et de l'apprentissage du monde. Le deuxième problème que je vois est que nous formons tous ces modèles à partir de zéro. Il semble que si nous ne formons pas le modèle à partir de zéro et ne trouvons pas l’inspiration dès le début, il manquera quelque chose. Il devrait y avoir un moyen pour nous d'entraîner le modèle comme une espèce tous les quelques mois, tandis que de nombreux autres éléments de l'univers sont construits à partir d'itérations précédentes. Du point de vue d'un pur réseau de neurones, il est difficile de ne pas écarter les poids précédents, nous apprenons et mettons à jour ces poids à partir des données. On a donc l'impression qu'il manque quelque chose, et nous pourrions éventuellement le trouver, mais à quoi cela ressemblera n'est pas encore tout à fait clair. Fridman : S'entraîner à partir de zéro semble être un gaspillage, il doit y avoir un moyen de réutiliser les poids à chaque fois que nous résolvons des problèmes de Go, d'échecs, de StarCraft, de repliement de protéines alors que nous développons d'énormes nouvelles bases de données de réseaux neuronaux. Alors, comment réutiliser les poids ? Comment apprendre à extraire ce qui est généralisable et comment écarter le reste ? Comment mieux initialiser les poids ? Vinyals : Au cœur de l'apprentissage profond se trouve l'idée brillante selon laquelle un seul algorithme résout toutes les tâches. À mesure que de plus en plus de critères apparaissent, ce principe de base s’avère impossible. Autrement dit, vous disposez d'une initialisation informatique vierge du réseau neuronal, semblable à celle d'un cerveau, et vous lui alimentez ensuite davantage de contenu dans le cadre d'un apprentissage supervisé. La situation idéale est que ce que l'entrée est attendue, le résultat doit être ce qu'il est. Par exemple, la classification des images peut consister à sélectionner l'une des 1000 catégories. Il s'agit du réseau d'images. De nombreux problèmes peuvent être cartographiés de cette manière. Il devrait également y avoir une approche générale que vous pouvez utiliser pour n'importe quelle tâche donnée sans apporter beaucoup de changements ni de réflexion, ce qui, à mon avis, est au cœur de la recherche sur l'apprentissage profond. Nous ne l’avons pas encore compris, mais ce serait passionnant si les gens pouvaient découvrir moins d’astuces (un algorithme général) pour résoudre des problèmes importants. Au niveau algorithmique, nous avons déjà quelque chose de général, une formule pour entraîner des modèles de réseaux neuronaux très puissants sur de grandes quantités de données. Et dans de nombreux cas, il faut tenir compte des particularités de certains problèmes pratiques. Le problème du repliement des protéines est important et il existe déjà des approches de base telles que les modèles Transformer, les réseaux de neurones graphiques, les informations issues de la PNL (telles que BERT) et la distillation des connaissances. Dans cette formulation, nous devons également trouver quelque chose d'unique au problème du repliement des protéines qui est si important que nous devrions le résoudre, potentiellement ce que nous apprenons dans ce problème sera appliqué à la prochaine itération des chercheurs en apprentissage profond. Peut-être qu'au cours des 23 dernières années, dans le domaine du méta-apprentissage, les algorithmes généraux ont fait des progrès, principalement GPT-3 produit dans le domaine du langage. Le modèle n'est formé qu'une seule fois, et il ne se limite pas à traduire des langues ou à connaître uniquement le sentiment qui sous-tend une phrase, qui peut en fait lui être enseigné grâce à des indices, qui leur montrent essentiellement plus d'exemples. Nous sommes guidés par le langage, et le langage lui-même est un moyen naturel pour nous d’apprendre les uns des autres. Peut-être qu'il me posera d'abord quelques questions, puis je lui dirai qu'il devrait accomplir cette nouvelle tâche. Vous n'avez pas besoin de le recycler à partir de zéro. Nous avons vu des moments magiques avec un apprentissage en quelques étapes, incitant à utiliser le langage dans des modalités uniquement linguistiques. Au cours des deux dernières années, nous avons vu cela s'étendre à d'autres modalités au-delà du langage, en ajoutant des visuels, de l'action et des jeux, et en faisant de grands progrès. Cela pourrait être un moyen de mettre en œuvre un modèle unique. Le problème est qu'il est difficile d'ajouter du poids ou de la capacité à ce modèle, mais il est certainement puissant. Des progrès actuels ont eu lieu dans les tâches basées sur du texte ou dans les tâches de classification de style visuel, mais il devrait y avoir davantage de percées. Nous avons une bonne base de référence, et nous voulons qu’elle évolue vers l’intelligence artificielle générale, et la communauté évolue dans cette direction, ce qui est formidable. Ce qui me passionne, c'est quelles sont les prochaines étapes de l'apprentissage profond pour rendre ces modèles plus puissants ? Comment les former ? S’ils doivent évoluer, comment peuvent-ils être « reproduits » ? Doivent-ils changer de poids lorsque vous lui enseignez des tâches ? De nombreuses questions restent encore sans réponse. Fridman : Pouvez-vous expliquer le « Miaou » et l'expression du chat dans votre tweet ? Et qu'est-ce que Gato ? Comment ça marche ? Quel type de réseau neuronal est impliqué ? Comment s'entraîner ? Vinyals : Tout d'abord, le nom Gato, comme une série d'autres modèles publiés par DeepMind, porte le nom d'animaux. Les modèles à grande séquence commencent uniquement par le langage, mais nous les étendons à d'autres modalités. Gopher, Chinchilla, ce sont de purs modèles de langage, et récemment nous avons également publié Flamingo, qui couvre la vision. Gato ajoute des modalités visuelles et d'action. Les actions discrètes telles que le haut, le bas, la gauche et la droite peuvent être naturellement mappées à partir de mots vers de puissants modèles de séquences linguistiques. Avant de publier Gato, nous avons discuté de l'animal que nous devrions choisir de nommer. Je pense que la principale chose à considérer est l'agent général, qui est un attribut unique de Gato, qui signifie "gato" en espagnol "chat". Les fondamentaux de Gato ne sont pas différents de ceux de nombreux autres emplois. Il s'agit d'un modèle Transformer, un réseau neuronal récurrent qui couvre plusieurs modalités, notamment la vision, le langage et l'action. L'objectif de l'entraînement est de pouvoir prédire la suite de la séquence. Si l'entraînement est une séquence d'actions, il s'agit alors de prédire quelle sera la prochaine action. Les séquences de caractères et les séquences d'images sont également similaires. Nous les considérons tous comme des octets, et la tâche du modèle est de prédire quel est l'octet suivant, puis vous pouvez comprendre cet octet comme une action et utiliser cette action dans le jeu, vous pouvez également le comprendre comme un mot et écrire le mot ; mot pendant la conversation avec le système. Les entrées de Gato incluent des images, du texte, des vidéos, des actions et certains capteurs de perception des robots, car les robots font également partie du contenu de la formation. Il génère du texte et des actions, il ne génère pas d'images. Nous concevons actuellement un tel formulaire de sortie, donc je dis que Gato est un début, car il y a encore du travail à faire. Essentiellement, Gato est un cerveau qui, si vous lui donnez une séquence d'observations et de modalités, il affichera l'étape suivante de la séquence. Ensuite, vous commencez à passer au suivant et continuez à prédire le suivant, et ainsi de suite. Maintenant, ce n'est pas seulement un modèle de langage. Vous pouvez discuter avec Gato comme Chinchilla et Flamingo, mais c'est aussi un agent intelligent qui est formé sur divers ensembles de données pour être universel et non seulement pour être bon dans les jeux StarCraft, Atari, ou Allez-y. Fridman : En termes de modalités d'action, quel type de modèle peut-on qualifier d'« agent intelligent » ? Vinyals : À mon avis, un agent est en fait la capacité d'agir dans un environnement. Il réagit en donnant une action à l'environnement, qui renvoie une nouvelle observation, puis il génère l'action suivante. La façon dont nous formons Gato consiste à extraire l'ensemble de données d'observation, qui est un algorithme d'apprentissage par imitation à grande échelle, par exemple en l'entraînant à prédire quel sera le prochain mot de l'ensemble de données. Nous disposons d'un ensemble de données de personnes envoyant des SMS et discutant sur des pages Web. DeepMind s'intéresse à l'apprentissage par renforcement et aux agents d'apprentissage qui travaillent dans différents environnements. Nous avons développé un ensemble de données qui enregistre les trajectoires d'expérience de l'agent. D'autres agents que nous formons visent un seul objectif, comme contrôler un environnement de jeu en trois dimensions et naviguer dans un labyrinthe, et nous ajoutons à l'ensemble de données l'expérience acquise lors de l'interaction d'un agent avec l'environnement. Lors de la formation de Gato, nous mélangeons des données telles que les mots et l'interaction entre l'agent et l'environnement pour la formation. C'est « l'universalité » de Gato. Pour différentes modalités et tâches, il n'a qu'un seul « cerveau » », et. comparé à la plupart des réseaux de neurones de ces dernières années, il n'est pas si grand, avec seulement 1 milliard de paramètres. Malgré sa petite taille, son ensemble de données de formation est très stimulant et diversifié, contenant non seulement des données Internet mais également l'expérience d'interaction de l'agent avec différents environnements. En principe, Gato peut contrôler n'importe quel environnement, en particulier les jeux vidéo entraînés, diverses tâches de robot et d'autres environnements. Mais cela ne fera pas mieux que l'enseignant qui l'a enseigné. L'échelle est toujours importante. Gato est donc encore relativement petit, c'est donc un début. Et je crois qu'il y aura de nouvelles façons d'étudier ou de préparer les données, par exemple nous devons faire comprendre au modèle qu'il ne s'agit pas seulement de considérer les mouvements de haut en bas lorsqu'il joue à des jeux Atari, l'agent doit être capable de voir les mouvements de haut en bas lorsqu'il joue à des jeux Atari. écran avant de commencer à jouer au jeu. Avec un certain arrière-plan, vous pouvez utiliser du texte pour lui dire "Je vous montre toute une séquence et vous allez commencer à jouer à ce jeu". Le texte peut donc être un moyen de valoriser les données. Fridman : Comment tokeniser du texte, des images, des actions de jeu et des tâches de robot ? Vinyals : Bonne question. La tokenisation est un point de départ pour transformer toutes les données en une séquence, c'est comme si nous décomposions tout en pièces de puzzle et que nous pouvions ensuite simuler à quoi ressemble le puzzle. Lorsque vous les alignez, ils deviennent une séquence. Gato utilise la technologie standard actuelle de tokenisation du texte. Nous tokenisons le texte via des sous-chaînes couramment utilisées. Par exemple, "ing" est une sous-chaîne couramment utilisée en anglais, elle peut donc être utilisée comme jeton. Fridman : Combien de jetons faut-il pour un mot ? Vinyals : Pour un mot anglais, la granularité actuelle de la tokenisation est généralement de 2 à 5 symboles, ce qui est plus grand que les lettres et plus petit que les mots. Fridman : Avez-vous essayé de tokeniser les emojis ? Vinyals : les emojis ne sont en fait que des séquences de lettres. Fridman : Les emojis sont-ils des images ou du texte ? Vinyals : Vous pouvez réellement mapper des emojis à des séquences de caractères, afin que vous puissiez envoyer des emojis au modèle et qu'il produira des emojis. Dans Gato, la façon dont nous traitons les images consiste à les compresser en pixels d'intensités variables, ce qui donne une très longue séquence de pixels. Fridman : Il n’y a donc aucune sémantique impliquée ? Vous n'avez pas besoin de comprendre quoi que ce soit à l'image ? Vinyals : Oui, seule la notion de compression est utilisée ici. Au niveau de la tokenisation, nous trouvons des modèles communs pour compresser les images. Fridman : Les informations visuelles telles que la couleur capturent la signification d'une image, pas seulement des statistiques. Vinyals : Dans l'apprentissage automatique, la méthode de traitement des images est davantage basée sur les données. Nous utilisons simplement les statistiques des images puis les quantifions. Les sous-chaînes communes sont positionnées comme un jeton et les images sont similaires, mais il n'y a aucun lien entre elles. Si nous considérons les jetons comme des nombres entiers, disons que le texte comporte 10 000 jetons, de 1 à 10 000, et qu'ils représentent toutes les langues et tous les mots que nous verrons. L'image est un autre ensemble d'entiers, de 10001 à 20000, et les deux sont complètement indépendants. Ce qui les relie, ce sont les données, et dans l'ensemble de données, le titre de l'image indique de quoi parle l'image. Le modèle doit prédire du texte aux pixels, et la corrélation entre les deux se produit au fur et à mesure que l'algorithme apprend. En plus des mots et des images, nous pouvons également attribuer des entiers aux actions, les discrétiser et utiliser des idées similaires pour compresser les actions en jetons. C'est ainsi que nous mappons désormais tous les types spatiaux en séquences entières. Ils occupent chacun des espaces différents, et ce qui les relie est l'algorithme d'apprentissage. Fridman : Vous avez déjà mentionné qu'il était difficile à mettre à l'échelle, que voulez-vous dire ? Certaines émergences ont des seuils d’échelle. Pourquoi est-il si difficile d’étendre un réseau comme Gato ? Vinyals : La mise à l'échelle n'est pas difficile si vous recyclez le réseau Gato. Le fait est que nous avons maintenant 1 milliard de paramètres, pouvons-nous utiliser les mêmes poids pour adapter cela à un cerveau plus grand ? C'est très difficile. Il existe donc le concept de modularité en génie logiciel, et certaines études ont utilisé la modularité. Flamingo ne gère pas les actions, mais il est puissant dans la gestion des images, et les tâches entre ces projets sont différentes et modulaires. Nous avons parfaitement implémenté la modularité dans le modèle Flamingo, nous avons pris les poids du modèle de langage pur Chinchilla, puis avons gelé ces poids et connecté de nouveaux réseaux de neurones aux emplacements corrects dans le modèle. Vous devez comprendre comment ajouter des fonctionnalités supplémentaires sans interrompre d’autres fonctionnalités. Nous créons un petit sous-réseau qui n'est pas initialisé au hasard mais qui apprend par auto-supervision. Nous avons ensuite utilisé l'ensemble de données pour relier les deux modalités, visuelle et verbale. Nous avons gelé la plus grande partie du réseau puis ajouté quelques paramètres en plus de la formation à partir de zéro. Puis Flamingo est apparu, son entrée était du texte et des images, et sa sortie était du texte. Vous pouvez lui apprendre de nouvelles tâches de vision, et il fait des choses au-delà de ce que l'ensemble de données lui-même fournit, mais il exploite une grande partie des connaissances linguistiques qu'il a acquises auprès de Chinchilla. L'idée clé de cette modularité est que nous prenons un cerveau gelé et lui ajoutons une nouvelle fonction. Dans une certaine mesure, vous pouvez constater que même chez DeepMind, nous avons cet éclectisme de Flamingo, qui permet une utilisation plus raisonnable de l'échelle sans avoir à recycler un système à partir de zéro. Bien que Gato utilise également le même ensemble de données, il est formé à partir de zéro. Je suppose donc que la grande question pour la communauté est la suivante : devrions-nous nous former à partir de zéro ou devrions-nous adopter la modularité ? La modularité est un moyen très efficace d’évoluer. Fridman : Après l'émergence de Gato, peut-on redéfinir le terme « méta-apprentissage » ? Selon vous, qu’est-ce que le méta-apprentissage ? Dans 5 ou 10 ans, le méta-apprentissage ressemblera-t-il à un Gato élargi ? Vinyals : Peut-être que regarder en arrière plutôt qu'en avant donnerait une bonne perspective. Quand on parle de méta-apprentissage en 2019, son sens a surtout changé avec la révolution GPT-3. La référence à l’époque concernait la capacité à apprendre l’identité des objets, elle était donc très adaptée à la vision et à la classification des objets. Nous n'apprenons pas seulement les 1000 catégories qu'ImageNet nous demande d'apprendre, nous apprenons également les catégories d'objets qui peuvent être définies lors de l'interaction avec le modèle. L'évolution du modèle est intéressante. Pour commencer, nous disposons d'un langage spécial, qui est un petit ensemble de données, et nous incitons le modèle à effectuer une nouvelle tâche de classification. Avec des indices sous forme d’ensembles de données d’apprentissage automatique, nous obtenons un système capable de prédire ou de classer les objets au fur et à mesure que nous les définissons. Finalement, le modèle linguistique devient un apprenant. GPT-3 montre que nous pouvons nous concentrer sur la classification des objets et sur ce que signifie le méta-apprentissage dans le contexte des classes d'objets d'apprentissage. Maintenant, nous ne sommes plus liés par le benchmark, nous pouvons directement indiquer au modèle certaines tâches logiques via le langage naturel. Ces modèles ne sont pas parfaits, mais ils accomplissent de nouvelles tâches et acquièrent de nouvelles capacités grâce au méta-apprentissage. Le modèle Flamingo s’étend à la multimodalité visuelle et linguistique mais possède les mêmes capacités. Vous pouvez l'enseigner. Par exemple, une fonctionnalité émergente est que vous pouvez prendre une photo d’un nombre et lui apprendre à faire du calcul. Vous lui montrez quelques exemples et il apprend, ce qui va bien au-delà de la classification d'images précédente. Cela développe ce que le méta-apprentissage signifiait dans le passé. Le méta-apprentissage est un terme en constante évolution. Compte tenu des progrès actuels, j'ai hâte de voir ce qui se passera ensuite, peut-être que dans 5 ans ce sera une autre histoire. Nous avons un système doté d'un ensemble de poids et nous pouvons lui apprendre à jouer à StarCraft via des invites interactives. Imaginez que vous parlez à un système, que vous lui apprenez un nouveau jeu et que vous lui montrez des exemples de jeu. Peut-être que le système vous posera même des questions, comme : « Je viens de jouer à ce jeu, est-ce que j'ai bien joué ? Pouvez-vous m'en apprendre davantage ? » Ainsi, dans cinq ou dix ans, dans des domaines spécialisés, ces éléments seront plus interactifs. et plus riche. Par exemple, AlphaStar, que nous avons développé spécifiquement pour StarCraft, est très différent. L'algorithme est général, mais les poids sont spécifiques. Le méta-apprentissage va au-delà des invites et inclut davantage d'interactions. Le système peut nous demander de lui donner des commentaires après avoir commis une erreur ou perdu une partie. En fait, les benchmarks existent déjà, nous avons juste modifié leurs objectifs. Donc, d'une certaine manière, j'aime penser à l'intelligence artificielle générale comme suit : nous avons déjà 101 % de performances sur des tâches spécifiques comme les échecs et StarCraft, et dans la prochaine itération, nous pouvons atteindre 20 % sur toutes les tâches. Les progrès de la prochaine génération de modèles vont définitivement dans ce sens. Bien sûr, nous pouvons nous tromper sur certaines choses, par exemple si nous n'avons pas les outils, ou peut-être pas assez de Transformer. Dans les 5 à 10 prochaines années, les poids du modèle auront probablement été entraînés, et il s’agira davantage d’enseigner ou de permettre au modèle de méta-apprendre. Il s'agit d'un enseignement interactif. Dans le domaine de l’apprentissage automatique, cette méthode n’a pas été utilisée depuis longtemps pour traiter les tâches de classification. Mon idée ressemble un peu à l'algorithme du voisin le plus proche. C'est presque l'algorithme le plus simple et ne nécessite ni apprentissage ni calcul de gradients. Le voisin le plus proche mesure la distance entre les points d'un ensemble de données, puis pour classer un nouveau point, il vous suffit de calculer quel est le point le plus proche dans cette grande quantité de données. Vous pouvez donc considérer l'indice comme suit : vous ne traitez pas seulement des points simples lors du téléchargement, mais vous ajoutez des connaissances au système pré-entraîné. L'astuce est le développement d'un concept très classique en machine learning, qui est l'apprentissage au point le plus proche. L'une de nos études en 2016 a utilisé la méthode du plus proche voisin, également très courante dans le domaine de la vision par ordinateur. Comment calculer la distance entre deux images est un domaine de recherche très actif si vous pouvez obtenir une bonne matrice de distance. obtenez également un bon classificateur. Ces distances et points ne se limitent pas aux images, mais peuvent également être du texte ou du texte, des images, des séquences d'action et d'autres nouvelles informations enseignées au modèle. Nous ne ferons probablement plus de musculation. Certaines techniques de méta-apprentissage effectuent des ajustements précis, et lorsqu'elles se voient confier une nouvelle tâche, elles entraînent un peu les poids. Fridman : Nous avons réalisé des modèles et des agents généraux à grande échelle tels que Flamingo, Chinchilla et Gopher. Quelles sont leurs spécialités techniques ? Vinyals : Je pense que la clé du succès est l'ingénierie. Le premier est l’ingénierie des données, car ce que nous finissons par collecter est un ensemble de données. Vient ensuite le projet de déploiement, où nous déployons le modèle sur certains clusters informatiques à grande échelle. Ce facteur de réussite s’applique à tout, le diable se cache bel et bien dans les détails. De plus, il y a des progrès dans le benchmark actuel. Une équipe passe plusieurs mois à faire une recherche et n'est pas sûre qu'elle réussira, mais si vous ne prenez pas de risques et faites quelque chose qui semble impossible, il n'y aura aucune chance. de réussite. Toutefois, nous avons besoin d’un moyen de mesurer les progrès. Il est donc crucial d’établir des critères de référence. Nous avons développé AlphaFold à l'aide de nombreux benchmarks, et les données et indicateurs de ce projet sont tous facilement disponibles. Une bonne équipe ne devrait pas avoir pour objectif de trouver des améliorations progressives et de publier un article, mais plutôt d'avoir un objectif plus élevé et d'y travailler pendant des années. Dans le domaine de l'apprentissage automatique, nous aimons les architectures comme les réseaux de neurones, et avant l'arrivée de Transformer, c'était un domaine en croissance très rapide. « L'attention est tout ce dont vous avez besoin » est en effet un excellent sujet de dissertation. Cette architecture réalise notre rêve de modéliser n'importe quelle séquence d'octets. Je pense que les progrès de ces architectures résident dans une certaine mesure dans la façon dont fonctionnent les réseaux de neurones. Il est difficile de trouver une architecture qui a été inventée il y a cinq ans et qui soit encore stable et ait très peu changé, donc Transformer peut continuer à apparaître dans de nombreux projets. .est surprenant. Fridman : Sur le plan philosophique de la technologie, où réside la magie de l'attention ? Comment fonctionne l’attention dans l’esprit humain ? Vinyals : Il existe une différence entre Transformer et les LSTM de réseaux neuronaux artificiels à mémoire longue et à court terme. Au début de Transformer, les LSTM étaient encore des modèles de séquence très puissants. Par exemple, AlphaStar utilisait les deux. La puissance de Transformer réside dans le fait qu’il intègre un biais d’attention inductif. Supposons que nous souhaitions résoudre une tâche complexe pour une chaîne de mots, comme traduire un paragraphe entier ou prédire le paragraphe suivant sur la base des dix paragraphes précédents. Intuitivement, la façon dont Transformer effectue ces tâches est d'imiter et de copier les humains. Dans Transformer, vous recherchez quelque chose après avoir lu un paragraphe de texte, vous penserez à ce qui va se passer ensuite. au niveau du texte, il s’agit d’un processus fondé sur des hypothèses. Si je me demande si mon prochain mot sera « chat » ou « chien », la façon dont le Transformer fonctionne est qu'il repose sur deux hypothèses : sera-t-il chat ? Ou un chien ? Si c'est un chat, je trouverai quelques mots (pas nécessairement le mot « chat » lui-même) et je reviendrai en arrière pour voir si « chat » ou « chien » a plus de sens. Ensuite, il effectue des calculs très approfondis sur les mots, il combine des mots et il peut également interroger. Si vous réfléchissez vraiment au texte, vous devez revenir sur tout le texte ci-dessus, mais qu’est-ce qui attire l’attention ? Ce que je viens d’écrire est certes important, mais ce que vous avez écrit il y a dix pages peut aussi être critique, ce n’est donc pas à l’emplacement qu’il faut penser, mais au contenu. Les transformateurs peuvent interroger un contenu spécifique et l'extraire pour une meilleure prise de décision. C'est une façon d'expliquer Transformer, et je pense que ce biais inductif est très puissant. Le Transformer peut subir des changements détaillés au fil du temps, mais le biais inductif rend le Transformer plus puissant qu'un réseau récurrent basé sur le biais de récence, qui est efficace dans certaines tâches, mais présente de très gros défauts. Le transformateur lui-même a également des défauts. Je pense que l’un des principaux défis réside dans les invites dont nous venons de discuter. Une invite peut contenir jusqu'à 1 000 mots, ou même je dois montrer au système une vidéo et un article Wikipédia sur un jeu. J'ai également dû interagir avec le système pendant qu'il jouait au jeu et me posait des questions. Je dois être un bon professeur pour apprendre aux modèles à réaliser des choses au-delà de leurs capacités actuelles. La question est donc de savoir comment évaluer ces tâches ? Comment changer la structure de l’architecture ? C'est controversé. Fridman : Quelle est l’importance des individus dans tous ces progrès de la recherche ? Dans quelle mesure ont-ils changé le terrain ? Vous dirigez désormais la recherche sur l’apprentissage profond chez DeepMind, vous avez beaucoup de projets, beaucoup de chercheurs brillants, quel changement tous ces humains peuvent-ils apporter ? Vinyals : Je crois que les gens jouent un rôle énorme. Certaines personnes veulent avoir une idée qui fonctionne et s'y tenir, d'autres peuvent être plus pratiques et ne se soucient pas de savoir quelle idée fonctionne tant qu'elles peuvent déchiffrer le repliement des protéines. Nous avons besoin de ces deux idées apparemment opposées. Historiquement, les deux ont produit quelque chose tôt ou tard. La distinction entre les deux peut également être similaire à ce que l’on appelle le compromis exploration-exploitation dans le domaine de l’apprentissage par renforcement. Lorsque vous interagissez avec des personnes au sein d’une équipe ou lors d’une réunion, vous constaterez rapidement que quelque chose est explorable ou exploitable. Il est faux de nier tout style de recherche. Je viens de l'industrie, nous avons donc une puissance de calcul à grande échelle à utiliser, et il y aura également des types de recherche spécifiques correspondants. Pour le progrès scientifique, nous devons répondre à des questions auxquelles nous devons répondre maintenant. En même temps, je constate aussi beaucoup de progrès. Le mécanisme d'attention a été découvert à Montréal, au Canada, en raison d'un manque de puissance de calcul, alors que nous travaillions sur des modèles séquence à séquence avec nos amis de Google Brain. Nous utilisions 8 GPU (ce qui était effectivement beaucoup à l'époque), et je pense que Montréal était encore relativement limitée en termes d'échelle de calcul. Mais ensuite, ils ont découvert le concept d’attention basée sur le contenu, ce qui a conduit à Transformer. Fridman : Beaucoup de gens ont tendance à penser que le génie réside dans les grandes idées, mais je soupçonne que le génie en ingénierie réside souvent dans les détails. Parfois, un seul ingénieur ou quelques ingénieurs peuvent changer ce que nous faisons, en particulier ceux qui prennent une décision technique. réalisé sur un ordinateur à grande échelle peut déclencher une réaction en chaîne. Vinyals : Si vous regardez l'histoire du développement de l'apprentissage profond et des réseaux de neurones, vous constaterez qu'il y a des éléments accidentels. Parce que les GPU sont arrivés au bon moment, mais pour les jeux vidéo. Ainsi, même l’ingénierie matérielle est affectée par le facteur temps. C’est également grâce à cette révolution matérielle que les centres de données ont été créés. Par exemple, les centres de données de Google. Avec un tel centre de données, nous pouvons former des modèles. Les logiciels constituent également un facteur important et de plus en plus de personnes se lancent dans ce domaine. Nous pourrions également nous attendre à ce qu’un système ait tous les critères de référence. Fridman : Vous avez un article co-écrit avec Jeff Dean, Percy Liang et d'autres, intitulé "Capacités émergentes des grands modèles de langage". Comment l’émergence dans les réseaux de neurones s’explique-t-elle intuitivement ? Existe-t-il un point de bascule magique ? Est-ce que cela varie d’une tâche à l’autre ? Vinyals : Prenons l'analyse comparative comme exemple. Lorsque vous entraînez le système, lorsque vous analysez dans quelle mesure la taille de l'ensemble de données affecte les performances, comment la taille du modèle affecte les performances, combien de temps il faut pour entraîner le système pour affecter les performances, etc., la courbe est assez lisse. Si nous considérons ImageNet comme une courbe de formation très fluide et prévisible, elle semble assez fluide et prévisible d'une certaine manière. Côté langage, le benchmark demande plus de réflexion, même si la saisie est une phrase décrivant un problème mathématique, cela demande plus de traitement et plus d'introspection. Les performances du modèle peuvent devenir aléatoires jusqu'à ce qu'une question correcte soit posée par le système de requête de Transformer ou un modèle de langage tel que Transformer, et les performances commencent à passer d'aléatoire à non aléatoire. Ceci est très empirique et n'a aucune théorie derrière cela. . Fridman : Récemment, un ingénieur de Google a affirmé que le modèle de langage Lambda est conscient. Ce cas touche à l’aspect humain, à l’aspect technique de l’apprentissage automatique et à l’aspect philosophique du rôle des systèmes d’IA dans le monde humain. Quelle est votre perspective en tant qu’ingénieur en apprentissage automatique et en tant qu’être humain ? Vinyals : Je pense qu'aucun des modèles actuels est encore loin d'être conscient. J'ai l'impression d'être un peu un scientifique raté, et j'ai toujours l'impression de voir l'apprentissage automatique comme une science qui pourrait éventuellement aider d'autres sciences. J'aime l'astronomie, la biologie, mais je ne suis pas un expert dans ces domaines, donc je a décidé d'étudier l'apprentissage automatique. Mais au fur et à mesure que j'en apprenais davantage sur Alphafold et que j'en apprenais un peu plus sur les protéines, la biologie et les sciences de la vie, j'ai commencé à observer ce qui se passait au niveau atomique. Nous avons tendance à considérer les réseaux de neurones comme des cerveaux, et quand je ne suis pas un expert, cela semble complexe et magique, mais les systèmes biologiques sont bien plus complexes que les cerveaux informatiques, et les modèles existants n'ont pas encore atteint le niveau des cerveaux biologiques. Je ne suis pas si surpris par cet ingénieur de Google. Peut-être parce que je vois la courbe temporelle se lisser, les modèles de langage n'ont pas progressé aussi vite depuis les travaux de Shannon dans les années 50, et les idées que nous avions il y a 100 ans ne sont pas si différentes de celles que nous avons aujourd'hui. Mais personne ne devrait dire aux autres ce qu’ils devraient penser. La complexité que les humains ont depuis le début de leur création, et la complexité de l'évolution de l'univers dans son ensemble, est pour moi d'un ordre de grandeur plus fascinant. C'est bien d'être obsédé par ce que l'on fait, mais j'aimerais qu'un expert en biologie me dise que ce n'est pas si magique. Grâce à l’interaction au sein de la communauté, nous acquérons également un niveau d’éducation qui nous aide à comprendre ce qui n’est pas normal, ce qui est dangereux, etc., sans lequel une technologie ne sera pas utilisée correctement. Fridman : Afin de résoudre des problèmes d’intelligence, un système doit-il prendre conscience ? Quelle partie de l’esprit humain est instructive dans la création de systèmes d’IA ? Vinyals : Je ne pense pas que l'intelligence d'un système doive atteindre le point où il dispose d'un cerveau extrêmement utile qui peut vous mettre au défi et vous guider. Au lieu de cela, vous devriez lui apprendre à faire des choses. Personnellement, je ne suis pas sûr que la conscience soit nécessaire, peut-être que la conscience ou d'autres perspectives biologiques ou évolutives influenceront nos algorithmes de prochaine génération. Les détails des calculs effectués par le cerveau humain et les réseaux neuronaux sont différents. Bien sûr, il existe certaines similitudes entre les deux, mais nous n'en savons pas suffisamment sur les détails du cerveau. Mais si vous limitez un peu la portée, comme notre processus de réflexion, le fonctionnement de la mémoire, même la façon dont nous avons évolué jusqu'à ce que nous sommes aujourd'hui, ce que sont l'exploration et le développement, etc., cela peut inspirer la recherche au niveau des algorithmes. Fridman : Êtes-vous d'accord avec Richard Sutton dans The Bitter Lesson selon lequel la plus grande leçon de 70 ans de recherche sur l'IA est que les méthodes générales d'exploitation de la puissance de calcul sont celles qui fonctionnent en fin de compte ? Vinyals : Je ne pourrais pas être plus d’accord. L’échelle est nécessaire pour construire des systèmes complexes et fiables. Cela ne suffira peut-être pas et nous avons besoin de quelques avancées. Sutton a mentionné que la recherche est une méthode de mise à l'échelle et que dans un domaine comme Go, la recherche est utile car il existe une fonction de récompense claire. Mais dans d’autres missions, nous ne savions pas trop quoi faire. Fridman : Pensez-vous que nous pouvons construire un système d'intelligence artificielle générale qui atteint ou même surpasse l'intelligence humaine au cours de votre vie ? Vinyals : Je crois absolument qu'il aura une intelligence de niveau humain. Le mot « au-delà » est difficile à définir, surtout si l’on considère les normes actuelles du point de vue de l’apprentissage par imitation, mais nous pouvons certainement faire en sorte que l’IA imite et surpasse les humains dans le langage. Donc, pour atteindre le niveau humain grâce à l’imitation, il faut un apprentissage par renforcement et d’autres choses. Cela s’avère déjà payant dans certains domaines. En termes de dépassement des capacités humaines, AlphaGo est de loin mon exemple préféré. Et d’une manière générale, je ne suis pas sûr que nous puissions définir une fonction de récompense d’une manière qui imite l’intelligence humaine. Quant à la transcendance, je n'en suis pas encore sûr, mais elle atteindra certainement le niveau humain. Évidemment, nous n'allons pas essayer de transcender, et si nous le faisions, nous aurions des scientifiques et des découvertes surhumaines pour faire progresser le monde, mais au moins les systèmes au niveau humain seraient très puissants. Fridman : Pensez-vous qu'il y aura un moment de singularité où des milliards d'agents intelligents atteignant ou dépassant le niveau humain seront profondément intégrés à la société humaine ? Aurez-vous peur ou serez-vous enthousiasmé par le monde ? Vinyals : Peut-être devons-nous nous demander si nous pouvons réellement atteindre cet objectif. La coexistence d’un trop grand nombre de personnes avec des ressources limitées peut créer des problèmes. Des limites de quantité devraient probablement également exister pour les entités numériques. Ceci pour des raisons de disponibilité énergétique, car ils consomment également de l'énergie. En fait, la plupart des systèmes sont moins efficaces que nous en termes de besoins énergétiques. Mais je pense qu’en tant que société, nous devons travailler ensemble pour trouver des moyens raisonnables de croître et de coexister. Je serais ravi si cela se produisait, des aspects de l'automatisation qui donnent accès à certaines ressources ou connaissances à des personnes qui autrement n'y auraient évidemment pas accès, et c'est l'application que j'ai le plus hâte de voir. Fridman : Dernière question, à mesure que les humains quitteront le système solaire, y aura-t-il plus d'humains ou plus de robots dans le monde futur ? Vinyals : Les humains et l'IA peuvent se mélanger et coexister, ce n'est que de la spéculation, mais il existe déjà des entreprises qui tentent de nous rendre meilleurs de cette manière. J'aimerais que le rapport soit de 1:1 au maximum. 1:1 est peut-être réalisable, mais perdre l'équilibre n'est pas une bonne chose. Lien vidéo original : https://youtu.be/aGBLRlLe7X82. Agent généraliste Gato

3. Le méta-apprentissage inclura plus d'interactions

4. La puissance de Transformer

5. L'IA est encore loin d'une conscience émergente

6. L'IA peut avoir au moins une intelligence de niveau humain

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI