Maison >Périphériques technologiques >IA >Entraînez-vous une seule fois pour générer de nouvelles scènes 3D ! L'histoire de l'évolution du « Light Field Neural Rendering » de Google

Entraînez-vous une seule fois pour générer de nouvelles scènes 3D ! L'histoire de l'évolution du « Light Field Neural Rendering » de Google

- PHPzavant

- 2023-04-08 13:01:031490parcourir

La synthèse de vues est un problème clé à l'intersection de la vision par ordinateur et de l'infographie. Elle fait référence à la création d'une nouvelle vue d'une scène à partir de plusieurs images de la scène.

Pour synthétiser avec précision une nouvelle vue d'une scène, un modèle doit capturer plusieurs types d'informations à partir d'un petit ensemble d'images de référence, telles que structure 3D détaillée, matériaux et éclairage, etc.

Depuis que les chercheurs ont proposé le modèle Neural Radiation Field (NeRF) en 2020, cette question a également reçu de plus en plus d'attention, ce qui a grandement favorisé les performances de la synthèse de nouvelles vues.

L'un des super grands acteurs est Google, qui a également publié de nombreux articles dans le domaine du NeRF. Cet article vous présentera deux articles publiés par Google sur le CVPR 2022 et l'ECCV 2022, à propos de . Light Field Neural L'évolution des modèles de rendu .

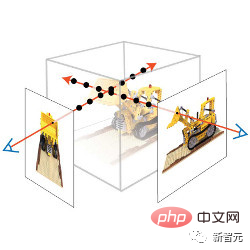

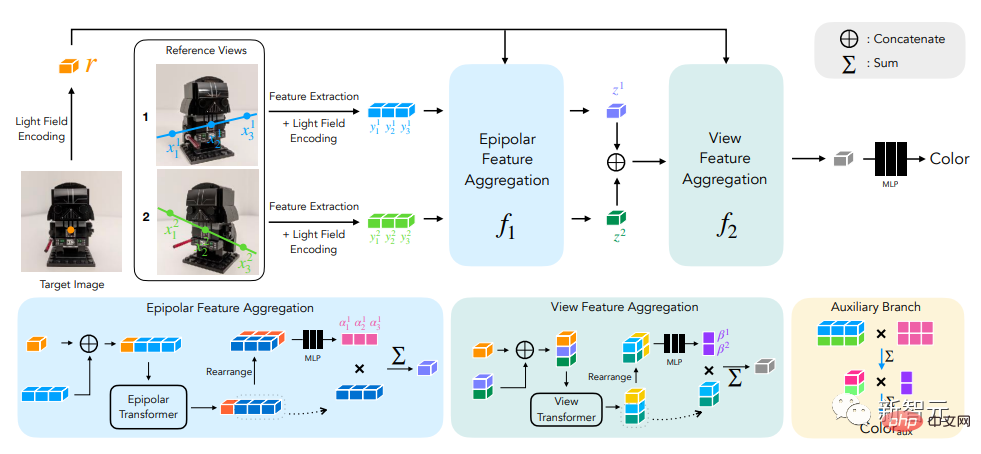

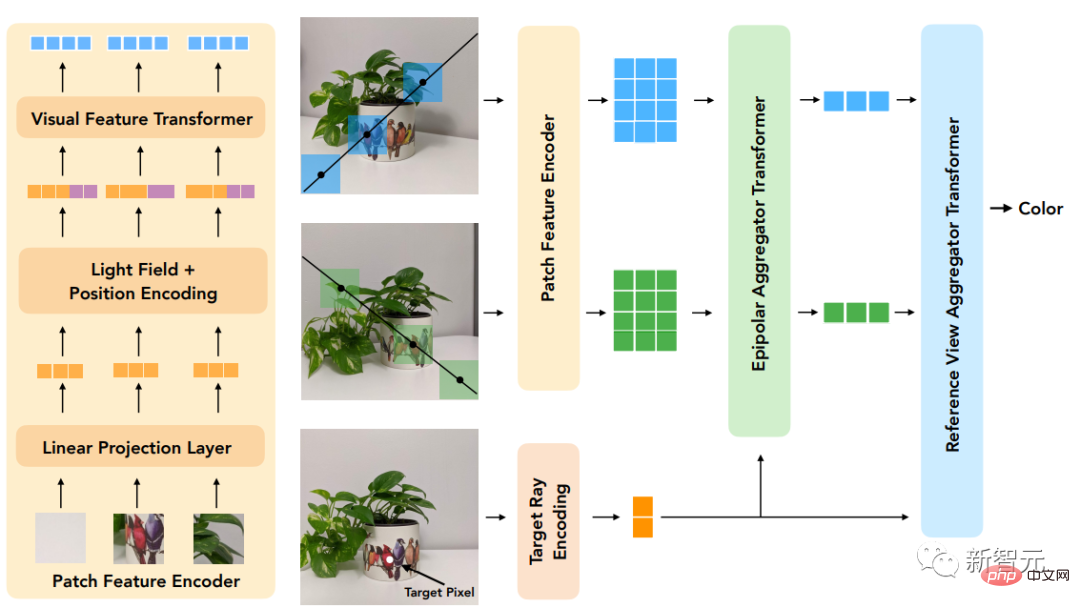

Le premier article propose un Modèle en deux étapes basé sur un transformateur pour apprendre à combiner les couleurs des pixels de référence, en obtenant d'abord des caractéristiques le long de lignes épipolaires (lignes épipolaires), puis en obtenant des caractéristiques le long de la vue de référence pour générer des rayons cibles. Couleur , améliore considérablement la précision de la reproduction de la vue .

Lien papier : https://arxiv.org/pdf/2112.09687.pdf

ClassicLight Field Renderingpeut reproduire avec précision les effets liés à la vue tels que la réflexion, la réfraction, et la translucidité, mais nécessite un échantillonnage de vue dense de la scène. Les méthodes basées sur la reconstruction géométrique ne nécessitent que des vues clairsemées mais ne peuvent pas modéliser avec précision les effets non lambertiens, c'est-à-dire la diffusion non idéale.

Le nouveau modèle proposé dans l'article combine les avantages de ces deux directions et atténue leurs limites En opérant sur une représentation tridimensionnelle du champ lumineux, le modèle peut apprendre à représenter avec précision la vue. effets liés. La géométrie de la scène est implicitement apprise à partir d'un ensemble clairsemé de vues en appliquant des contraintes géométriques lors de la formation et de l'inférence.

Le modèle surpasse les modèles de pointe sur plusieurs ensembles de données avant et à 360°, et dispose d'une plus grande marge sur les scènes présentant de graves changements dépendant de la ligne de vue.

Un autre article aborde le problème de généralisation de la synthèse de scènes inédites en utilisant des Séquences de transformateuravec un codage de position canonique. Une fois le modèle formé sur un ensemble de scènes, il peut être utilisé pour synthétiser des vues de nouvelles scènes. L'article propose un paradigme différent qui ne nécessite pas de fonctionnalités approfondies ni de rendu de volume de type NeRF, Cette méthode peut prédire directement la couleur du rayon cible dans la nouvelle scène en échantillonnant simplement l’ensemble de patchs de la scène.

Utilise d'abord la

Utilise d'abord la

pour extraire des patchs le long de la ligne épipolaire de chaque vue de référence, et projette linéairement chaque patch dans un vecteur de caractéristiques unidimensionnel, puis consiste en une série de processus Transformer pour cette collection.

Pour le encodage de position, les chercheurs ont paramétré les rayons de manière similaire à la méthode de représentation du champ lumineux. La différence est que les coordonnées sont normalisées par rapport au rayon cible, ce qui rend également la méthode indépendante du référentiel et l'améliore. généralité. Sexe .

L'innovation du modèle est qu'il effectue un rendu basé sur l'image, combinant la couleur et les caractéristiques de l'image de référence pour restituer une nouvelle vue, et il est purement basé sur Transformer et fonctionne sur l'ensemble de patchs d'image. . Et ils utilisent des représentations de champs lumineux 4D pour le codage de position, aidant ainsi à simuler les effets liés à la vue.

L'innovation du modèle est qu'il effectue un rendu basé sur l'image, combinant la couleur et les caractéristiques de l'image de référence pour restituer une nouvelle vue, et il est purement basé sur Transformer et fonctionne sur l'ensemble de patchs d'image. . Et ils utilisent des représentations de champs lumineux 4D pour le codage de position, aidant ainsi à simuler les effets liés à la vue.

Les résultats expérimentaux finaux montrent que cette méthode surpasse les autres méthodes dans la synthèse de nouvelles vues de scènes invisibles, même lorsqu'elle est entraînée

avec beaucoup moins de données que. Rendu neuronal du champ lumineux

L'entrée du modèle se compose d'un ensemble d'images de référence, des paramètres de caméra correspondants (distance focale, position et orientation spatiale) et des coordonnées du rayon cible dont l'utilisateur souhaite connaître la couleur. déterminer.

Afin de générer une nouvelle image, nous devons partir des paramètres de caméra de l'image d'entrée, obtenir d'abord les coordonnées du rayon cible (chacune correspondant à un pixel) et effectuer une requête de modèle pour chaque coordonnée.

La solution des chercheurs n’est pas de traiter entièrement chaque image de référence, mais uniquement d’examiner les zones susceptibles d’affecter les pixels cibles. Ces régions peuvent être déterminées par géométrie épipolaire, en mappant chaque pixel cible sur une ligne sur chaque image de référence.

Pour des raisons de sécurité, vous devez sélectionner une petite zone autour de certains points de la ligne épipolaire pour former un ensemble de patchs qui seront réellement traités par le modèle, puis appliquer le Transformer à cet ensemble de patchs pour obtenir la couleur du pixel cible.

Transformer est particulièrement utile dans ce cas car le mécanisme d'auto-attention peut naturellement prendre la collection de patchs en entrée, et le poids d'attention lui-même peut être utilisé pour prédire les pixels de sortie en combinaison avec les couleurs et les caractéristiques de la vue de référence. . couleur.

Transformer est particulièrement utile dans ce cas car le mécanisme d'auto-attention peut naturellement prendre la collection de patchs en entrée, et le poids d'attention lui-même peut être utilisé pour prédire les pixels de sortie en combinaison avec les couleurs et les caractéristiques de la vue de référence. . couleur.

Dans le rendu neuronal en champ lumineux (LFNR), les chercheurs utilisent deux séquences Transformer pour mapper une collection de patchs afin de cibler les couleurs des pixels.

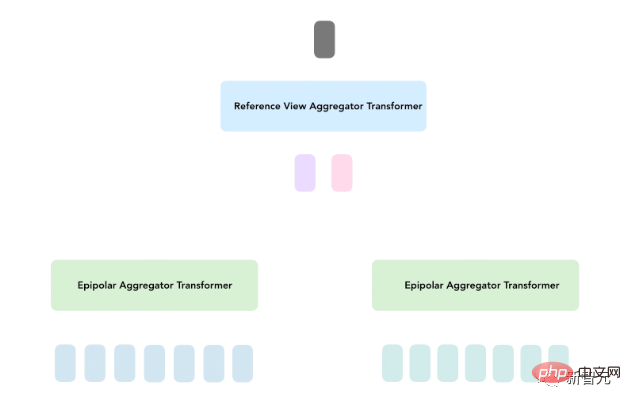

Le premier Transformateur regroupe les informations le long de chaque ligne épipolaire, et le second Transformateur regroupe les informations le long de chaque image de référence.

Cette approche peut interpréter le premier Transformer comme trouvant des correspondances potentielles de pixels cibles sur chaque cadre de référence, tandis que le second Transformer raisonne sur l'occlusion et les effets dépendants de la ligne de mire, qui sont également basés sur des dilemmes courants avec. rendu.

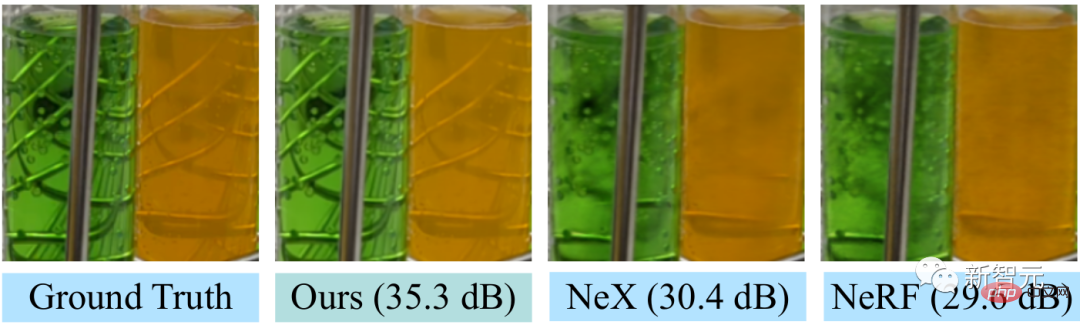

LFNR améliore le rapport signal/bruit de crête (PSNR) jusqu'à 5 dB par rapport au modèle sota sur les benchmarks de synthèse de vue les plus populaires (Blender de NeRF et scènes Real Forward-Facing et Shiny de NeX), ce qui est tout à fait cela réduit l'erreur au niveau des pixels de 1,8 fois.

LFNR améliore le rapport signal/bruit de crête (PSNR) jusqu'à 5 dB par rapport au modèle sota sur les benchmarks de synthèse de vue les plus populaires (Blender de NeRF et scènes Real Forward-Facing et Shiny de NeX), ce qui est tout à fait cela réduit l'erreur au niveau des pixels de 1,8 fois.

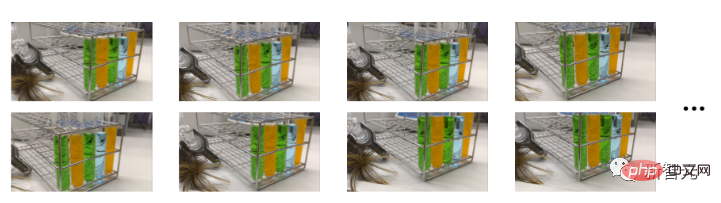

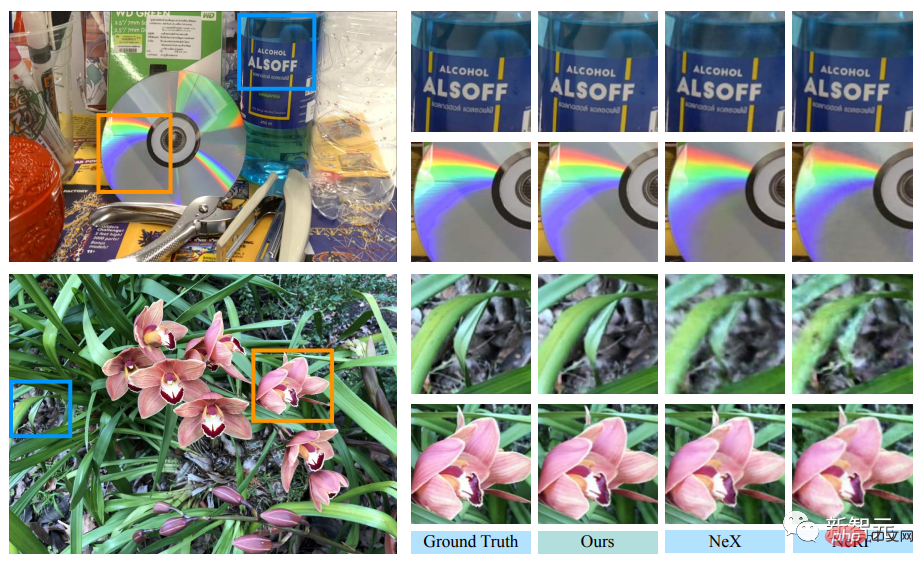

LFNR peut reproduire certains des effets dépendants de la ligne de mire les plus difficiles dans l'ensemble de données NeX/Shiny, tels que les arcs-en-ciel et les reflets sur les CD, les reflets, les réfractions et la translucidité sur les bouteilles.

Par rapport aux méthodes précédentes telles que NeX et NeRF, elles sont incapables de reproduire les effets liés à la ligne de mire, tels que la translucidité et l'indice de réfraction des tubes à essai dans la scène du laboratoire dans l'ensemble de données NeX/Shiny. .

Par rapport aux méthodes précédentes telles que NeX et NeRF, elles sont incapables de reproduire les effets liés à la ligne de mire, tels que la translucidité et l'indice de réfraction des tubes à essai dans la scène du laboratoire dans l'ensemble de données NeX/Shiny. .

S'entraîner une fois et généraliser à de nouvelles scènes

Mais LFNR a aussi des limites.

Le premier Transformer replie les informations le long de chaque ligne épipolaire indépendamment pour chaque image de référence. Cela signifie également que le modèle ne peut décider quelles informations conserver en fonction des coordonnées des rayons de sortie et des patchs de chaque image de référence. fonctionne bien dans les scènes d'entraînement (comme la plupart des méthodes de rendu neuronal), mais ne se généralise pas à différentes scènes.

Les modèles généralisables sont importants car ils peuvent être directement appliqués à de nouveaux scénarios sans recyclage.

Les chercheurs ont proposé un modèle général de rendu neuronal basé sur des patchs (GPNR) pour résoudre cette lacune du LFNR.

En ajoutant un Transformateur au modèle afin qu'il fonctionne avant les deux autres Transformateurs et échange des informations entre des points de même profondeur dans toutes les images de référence.

GPNR se compose d'une séquence de trois transformateurs qui mappent un ensemble de patchs extraits le long de lignes épipolaires en couleurs de pixels. Les zones d'image sont mappées sur les caractéristiques initiales via des couches de projection linéaire, puis ces caractéristiques sont continuellement affinées et agrégées par le modèle pour finalement former des caractéristiques et des couleurs.

Par exemple, une fois que le premier Transformer a extrait la séquence de patch de "Park Bench", le nouveau modèle peut utiliser des indices tels que des "fleurs" apparaissant aux profondeurs correspondantes dans les deux vues pour indiquer la présence d'une correspondance potentielle.

Une autre idée clé de ce travail est de normaliser l'encodage de position en fonction du rayon cible, car si l'on veut généraliser dans différents scénarios, il faut représenter les quantités dans un système de référence relatif plutôt qu'absolu

Pour évaluer les performances de généralisation du modèle, les chercheurs ont formé le GPNR sur un ensemble de scénarios et l'ont testé sur de nouveaux scénarios.

GPNR s'améliore de 0,5 à 1,0 dB en moyenne sur plusieurs benchmarks (suivant les protocoles IBRNet et MVSNeRF), notamment sur le benchmark IBRNet, GPNR surpasse le modèle de base en n'utilisant que 11% des scénarios d'entraînement.

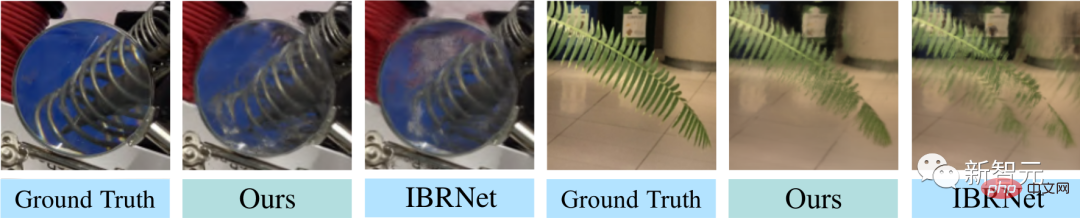

GPNR a généré des détails de vue sur les scènes maintenues dans NeX/Shiny et LLFF sans aucun réglage fin. GPNR reproduit avec plus de précision les détails sur les lames et la réfraction à travers la lentille qu'IBRNet.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI