Maison >Périphériques technologiques >IA >Débarrassez-vous du « clickbait », autre chef-d'œuvre open source de l'équipe Tsinghua !

Débarrassez-vous du « clickbait », autre chef-d'œuvre open source de l'équipe Tsinghua !

- WBOYavant

- 2023-04-08 12:51:181008parcourir

En tant que personne qui a du mal à nommer, la chose la plus gênante pour moi lorsque j'écris des dissertations au lycée est que je peux écrire de bons articles mais que je ne sais pas quel est le titre. Après avoir commencé à créer un compte public, j'ai perdu beaucoup. de cheveux à chaque fois que je pensais à un titre...

Récemment, j'ai enfin découvert la lumière du "naming waste" sur GitHub, une application intéressante à grand modèle lancée par l'Université Tsinghua et la communauté open source OpenBMB : "Title Capture ". Saisissez le contenu du texte pour générer un sujet d'actualité en un seul clic. titre !

Prêt à l'emploi dès la sortie de la boîte. Après l'avoir essayé, tout ce que je peux dire c'est : ça sent bon !

Expérience en ligne : https://live.openbmb.org/ant

GitHub : https://github.com/OpenBMB/CPM-Live

mentionné Pour Pour cet artefact qui fait la une des journaux, nous devons d'abord parler de son "corps" - le grand modèle CPM-Ant.

CPM-Ant est le premier modèle de dizaines de milliards à être formé en direct en Chine. La formation a duré 68 jours et s'est achevée le 5 août 2022 et a été officiellement publiée par OpenBMB !

- Cinq fonctionnalités exceptionnelles

- Quatre avancées innovantes majeures

- Le processus de formation est peu coûteux et respectueux de l'environnement !

- La chose la plus importante est - complètement open source !

En tant que première formation en direct de grands modèles chinois, CPM-Ant fournit une solution pratique réalisable dans la formation, le réglage fin, la compression, le raisonnement, l'application, etc. de grands modèles. Nous espérons fournir à différents adeptes différents aide et références.

Maintenant, jetons un coup d'œil au rapport sur le contenu des résultats de la version CPM-Ant !

Présentation du modèle

CPM-Ant est un modèle de langage chinois pré-entraîné open source avec 10B de paramètres. C'est également la première étape du processus de formation en direct CPM-Live.

L'ensemble du processus de formation est peu coûteux et respectueux de l'environnement. Il ne nécessite pas d'exigences matérielles ni de coûts de fonctionnement élevés. Il est basé sur la méthode de réglage delta et a obtenu d'excellents résultats au test de référence CUGE.

Le code, les fichiers journaux et les paramètres de modèle associés à CPM-Ant sont entièrement open source dans le cadre d'un accord de licence ouvert. En plus du modèle complet, OpenBMB propose également diverses versions compressées pour s'adapter à différentes configurations matérielles.

Les cinq fonctionnalités exceptionnelles de CPM-Ant :

(1) Efficacité informatique

Grâce à la boîte à outils BMTrain[1], il peut utiliser pleinement la capacité des ressources informatiques distribuées à former efficacement de grands modèles.

La formation de CPM-Ant a duré 68 jours et a coûté 430 000 yuans, soit 1/20 du coût d'environ 1,3 million de dollars de la formation du modèle T5-11B par Google. Les émissions de gaz à effet de serre de la formation CPM-Ant sont d'environ 4872 kg CO₂e, tandis que les émissions de la formation T5-11B sont de 46,7 t CO₂e[9]. La solution CPM-Ant représente environ 1/10 de ses émissions.

(2) Excellentes performances

Avec l'outil OpenDelta[3], il est très pratique d'adapter CPM-Ant aux tâches en aval grâce à un réglage fin incrémentiel.

Les expériences montrent que CPM-Ant obtient les meilleurs résultats sur 3/6 tâches CUGE en ajustant uniquement 6,3 millions de paramètres. Ce résultat surpasse les autres modèles entièrement paramétrés avec précision. Par exemple : le nombre de paramètres précis de CPM-Ant n'est que de 0,06 % de celui du CPM2 (paramètres 11B affinés).

(3) Économie de déploiement

Avec l'aide des boîtes à outils BMCook[7] et BMInf[4], CPM-Ant peut être piloté avec des ressources informatiques limitées.

Basé sur BMInf, il peut remplacer le cluster informatique et effectuer une inférence de grand modèle sur un seul GPU (même une carte graphique grand public telle que GTX 1060). Pour rendre le déploiement de CPM-Ant plus économique, OpenBMB utilise BMCook pour compresser davantage le modèle 10B d'origine en différentes versions. Le modèle compressé (7B, 3B, 1B, 300M) peut s'adapter aux besoins de différents scénarios à faibles ressources.

(4) Facile à utiliser

Qu'il s'agisse du modèle 10B original ou de la version compressée associée, il peut être facilement chargé et exécuté avec quelques lignes de code.

OpenBMB ajoutera également CPM-Ant à ModelCenter[8], facilitant ainsi le développement ultérieur du modèle.

(5) Démocratie ouverte

Le processus de formation de CPM-Ant est complètement ouvert.

OpenBMB publie tous les codes, fichiers journaux et archives de modèles en libre accès. CPM-Ant adopte également une licence ouverte qui permet la commercialisation.

Une pratique complète de formation de grands modèles

Pour les fabricants et les instituts de recherche capables de former de grands modèles, le processus de formation CPM-Ant fournit un enregistrement réel complet de formation de grands modèles chinois.

OpenBMB a publié la conception du modèle, le programme de formation, les exigences en matière de données et le code de mise en œuvre de la série de modèles CPM-Live. Sur la base de l'architecture de modèle de CPM-Live, il est possible de concevoir et de mettre en œuvre rapidement et facilement de grandes solutions de formation de modèles et d'organiser les données commerciales pertinentes pour terminer la recherche préalable du modèle et la préparation des données.

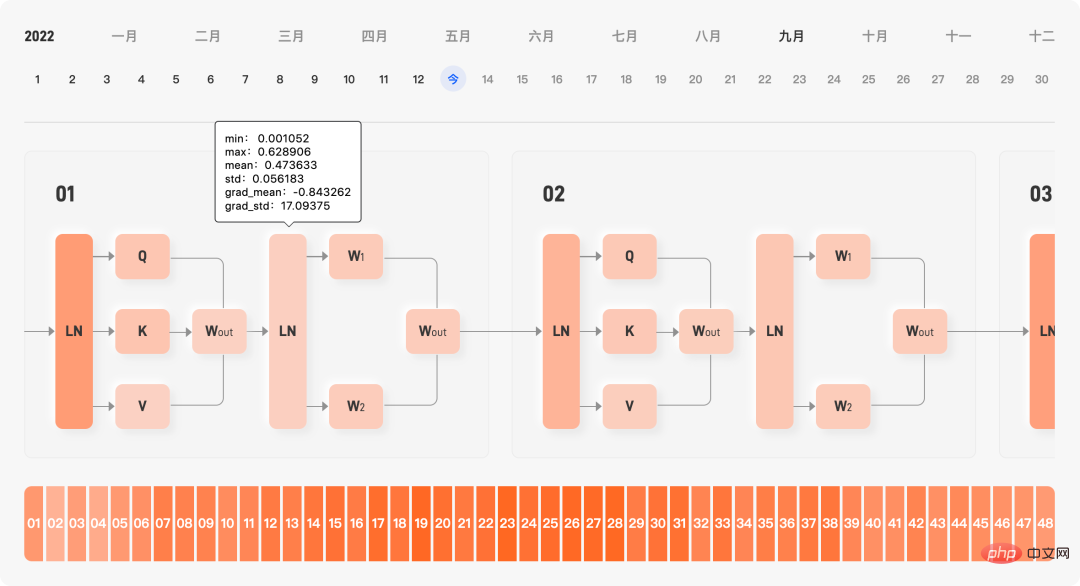

Le site officiel enregistre toutes les dynamiques d'entraînement au cours du processus d'entraînement, y compris la fonction de perte, le taux d'apprentissage, les données apprises, le débit, la taille du gradient, la courbe de coût et l'affichage en temps réel de la moyenne et de l'écart type des paramètres internes de le modèle, grâce à cette dynamique de formation, permet aux utilisateurs de diagnostiquer rapidement s'il y a des problèmes dans le processus de formation du modèle.

Affichage en temps réel des paramètres internes de la formation du modèle

De plus, les étudiants R&D d'OpenBMB mettent à jour chaque jour le résumé du dossier de formation en temps réel. Le résumé comprend la valeur de perte et la valeur de gradient. , la progression globale, et enregistre également les rencontres. Certains problèmes et bugs rencontrés au cours du processus de formation aident les utilisateurs à comprendre à l'avance les différents « creux » qui peuvent être rencontrés lors de la formation du modèle.

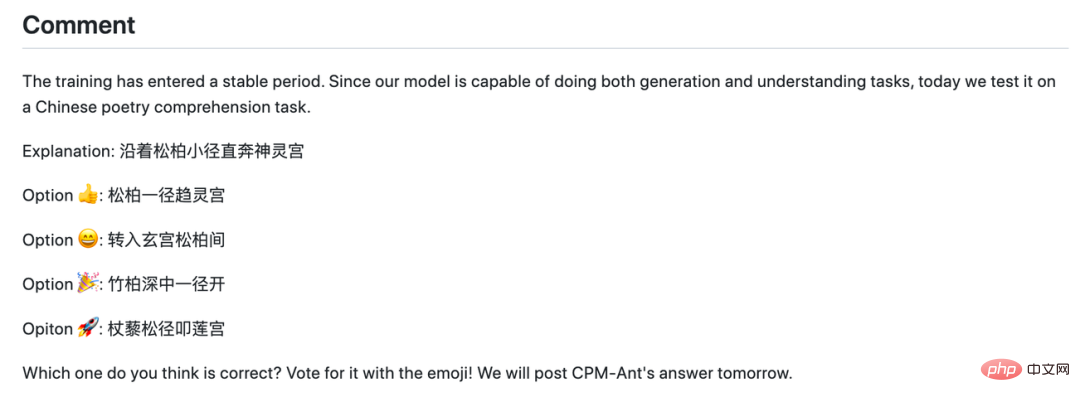

Les jours où la formation des modèles est "calme", le responsable R&D lancera également des citations célèbres, présentera les derniers articles et lancera même une activité de devinettes.

Une activité de devinette dans le journal

De plus, OpenBMB fournit également des solutions de formation rentables pour les entreprises qui ont réellement de grands besoins de formation de modèles, grâce à une technologie d'accélération de la formation pertinente, les coûts de formation ont augmenté. été réduite à des niveaux acceptables.

En utilisant la boîte à outils BMTrain[1], la puissance de calcul de dizaines de milliards de formations CPM-Ant de grands modèles ne coûte que 430 000 yuans (le coût actuel est calculé en fonction des prix du cloud public, le coût réel sera inférieur), soit 11B grand modèle T5 externe Environ 1/20 du coût estimé de 1,3 million de dollars !

Une solution de réglage fin très efficace qui a créé à plusieurs reprises SOTA

Comment CPM-Ant peut-il nous aider dans l'adaptation des tâches en aval ?

Pour les chercheurs sur de grands modèles, OpenBMB fournit une solution d'évaluation des performances de grands modèles basée sur un réglage fin efficace des paramètres, qui facilite une adaptation rapide des tâches en aval et une évaluation des performances du modèle.

Utilisez un réglage fin efficace des paramètres, connu sous le nom de réglage delta, pour évaluer les performances de CPM-Ant sur six tâches en aval. LoRA [2] a été utilisé dans l'expérience, qui insère deux matrices réglables de bas rang dans chaque couche d'attention et gèle tous les paramètres du modèle original. Grâce à cette approche, seuls 6,3 millions de paramètres ont été affinés par tâche, ce qui représente seulement 0,067 % du total des paramètres.

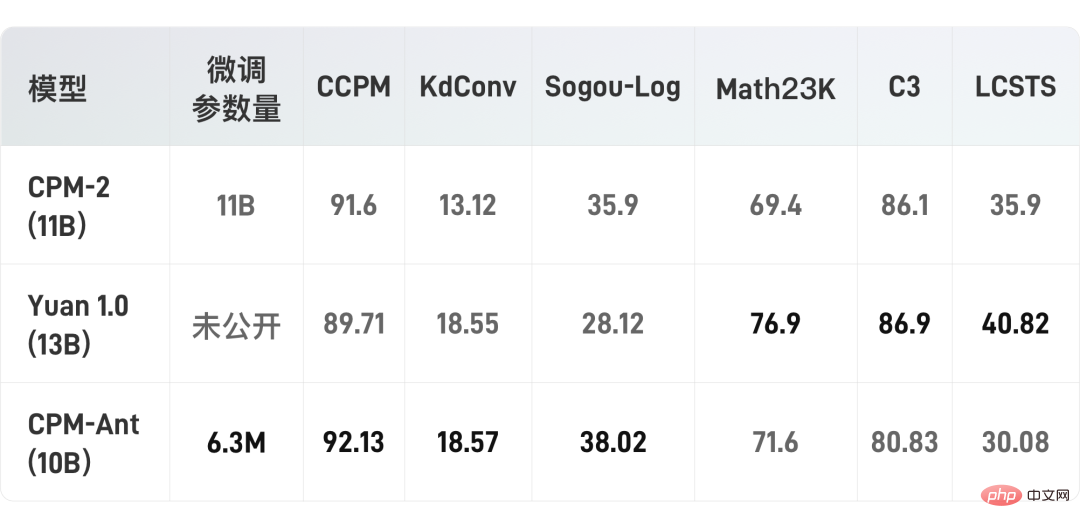

Avec l'aide d'OpenDelta[3], OpenBMB a mené toutes les expériences sans modifier le code du modèle original. Il convient de noter qu'aucune méthode d'augmentation des données n'a été utilisée lors de l'évaluation du modèle CPM-Ant sur les tâches en aval. Les résultats expérimentaux sont présentés dans le tableau suivant :

On peut constater qu'avec seulement un réglage fin de quelques paramètres, les performances du modèle d'OpenBMB ont dépassé le CPM-2 et la source 1.0 sur trois ensembles de données.

Certaines tâches (telles que LCSTS) peuvent être difficiles à apprendre lorsqu'il y a très peu de paramètres affinés. Le processus de formation de CPM-Live se poursuivra et les performances de chaque tâche seront encore peaufinées.

Les étudiants intéressés peuvent visiter le lien GitHub ci-dessous pour découvrir CPM-Ant et OpenDelta en premier, et explorer davantage les capacités de CPM-Ant sur d'autres tâches !

https://github.com/OpenBMB/CPM-Live

Une série de méthodes d'inférence respectueuses du matériel

Les performances des grands modèles sont étonnantes, mais des exigences matérielles et des coûts de fonctionnement élevés ont a toujours été un problème pour de nombreux utilisateurs. Pour les utilisateurs de grands modèles, OpenBMB propose une série de méthodes d'utilisation respectueuses du matériel, qui permettent d'exécuter plus facilement différentes versions de modèles dans différents environnements matériels.

Grâce à la boîte à outils BMInf[4], CPM-Ant peut fonctionner dans un environnement à faibles ressources tel qu'une seule carte 1060 !

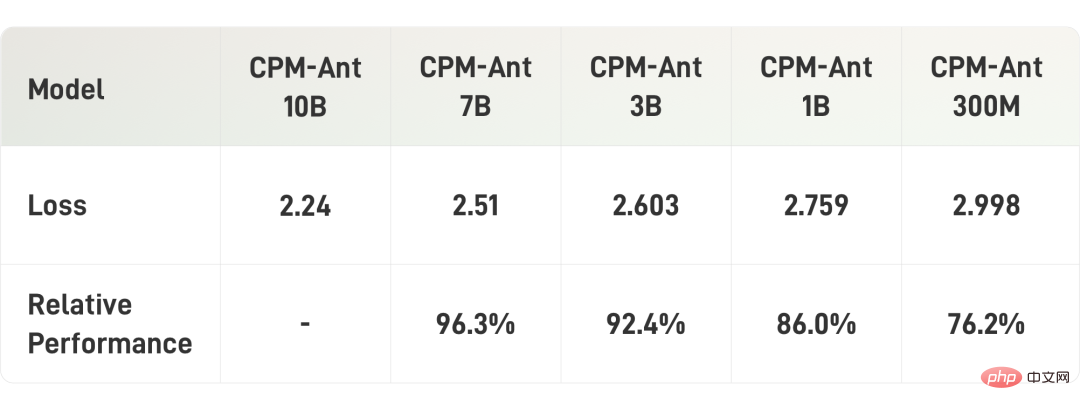

De plus, OpenBMB compresse également CPM-Ant. Ces modèles compressés incluent CPM-Ant-7B/3B/1B/0.3B. Toutes ces tailles de compression de modèles peuvent correspondre aux tailles classiques des modèles de langage open source pré-entraînés existants.

Étant donné que les utilisateurs peuvent effectuer un développement ultérieur sur les points de contrôle publiés, OpenBMB utilise principalement l'élagage structuré indépendant des tâches pour compresser CPM-Ant. Le processus de taille est également progressif, c'est-à-dire de 10B à 7B, de 7B à 3B, de 3B à 1B et enfin de 1B à 0,3B.

Dans le processus d'élagage spécifique, OpenBMB formera une matrice de masque dynamique apprenable, puis utilisera cette matrice de masque pour élaguer les paramètres correspondants. Enfin, les paramètres sont élagués en fonction du seuil de la matrice de masque, qui est déterminé en fonction de la parcimonie cible. Pour plus de détails sur la compression, veuillez vous référer au blog technique [5].

Le tableau suivant montre les résultats de la compression du modèle :

Maintenant que le contenu hardcore est terminé, comment le grand modèle peut-il nous aider à « obtenir le titre » ?

Une application amusante et inattendue de grands modèles

Basée sur CPM-Ant, tous les développeurs et passionnés de grands modèles peuvent développer des applications textuelles intéressantes.

Afin de vérifier davantage l'efficacité du modèle et de fournir des exemples, OpenBMB a affiné un générateur de titres basé sur CPM-Ant pour démontrer les capacités du modèle.

Collez simplement le contenu du texte dans la zone de texte ci-dessous, cliquez pour le générer, et vous pourrez obtenir le titre passionnant fourni par le grand modèle !

Le titre du premier article du rapport de résultats CPM-Ant est généré par le générateur

Cette démo sera continuellement peaufinée et d'autres effets spéciaux seront ajoutés à l'avenir pour améliorer l'expérience utilisateur

Les utilisateurs intéressés peuvent également utiliser CPM-Ant pour créer leurs propres applications d'affichage. Si vous avez des idées d'application, avez besoin d'assistance technique ou rencontrez des problèmes lors de l'utilisation de la démo, vous pouvez lancer une discussion sur le forum CPM-Live [6] à tout moment !

La sortie de CPM-Ant est la première étape de CPM-Live, mais ce n'est que la première phase de formation qu'OpenBMB continuera à mener une série de formations à l'avenir.

Petit spoiler, la prochaine session de formation ajoutera de nouvelles fonctionnalités telles que le support multilingue, les entrées et sorties structurées, etc. Bienvenue à tous pour continuer à faire attention !

Portail|Lien du projet

Adresse GitHub du projet :

https://github.com/OpenBMB/CPM-Live

Adresse de l'expérience de démonstration (accès PC uniquement) :

https : //live.openbmb.org/ant

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI