Maison >Périphériques technologiques >IA >Interprétation des sujets d'actualité : la capacité émergente des grands modèles et le changement de paradigme déclenché par ChatGPT

Interprétation des sujets d'actualité : la capacité émergente des grands modèles et le changement de paradigme déclenché par ChatGPT

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-08 12:31:051604parcourir

Récemment, les puissantes capacités démontrées par les modèles linguistiques à grande échelle (tels que les chaînes de pensée[2], les blocs-notes[3]) ont suscité un grand intérêt, et de nombreux travaux ont été réalisés. Nous les appelons collectivement les capacités émergentes des grands modèles [4]. Ces capacités peuvent [5] exister uniquement dans les grands modèles mais pas dans les petits modèles, elles sont donc appelées « émergentes ». Beaucoup de ces capacités sont très impressionnantes, comme le raisonnement complexe, le raisonnement par connaissances et la robustesse hors distribution, dont nous parlerons en détail plus tard.

Notamment, ces capacités sont proches de ce que la communauté PNL recherche depuis des décennies et représentent donc un changement de paradigme de recherche potentiel, passant du réglage fin de petits modèles à l'utilisation de grands modèles pour l'apprentissage contextuel. Pour les pionniers, le changement de paradigme peut être évident. Cependant, dans un souci de rigueur scientifique, nous avons besoin de raisons très claires pour lesquelles il faut passer à de grands modèles de langage, même si ces modèles sont chers [6], difficiles à utiliser [7], et peuvent être seulement modérément efficace [8]. Dans cet article, nous examinerons de plus près quelles sont ces capacités, ce que les grands modèles de langage peuvent offrir et quels sont leurs avantages potentiels dans un plus large éventail de tâches NLP/ML.

Lien original : yaofu.notion.site/A-Closer-Look-at-Large-Language-Models-Emergent-Abilities-493876b55df5479d80686f68a1abd72f

Table des matières

Prémisse : Nous supposons que les lecteurs ont les connaissances suivantes :

- Pré-formation, mise au point, conseils (capacités de traitement du langage naturel/apprentissage profond que les praticiens ordinaires devraient avoir)

- Conseils de chaîne de réflexion, blocs-notes (les praticiens ordinaires peuvent je n'en sais pas grand chose), mais n'affecte pas la lecture)

1. Capacités émergentes qui existent dans les grands modèles plutôt que dans les petits modèles

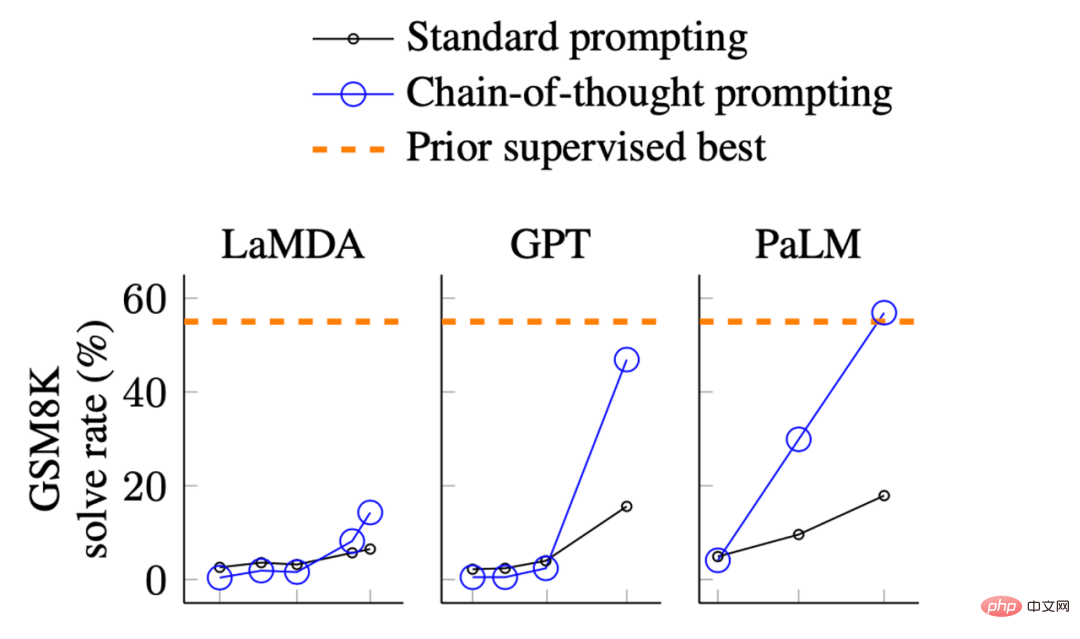

Photos de Wei et al. L'incitation à la pensée suscite un raisonnement dans de grands modèles de langage. L'axe X correspond à la taille du modèle. GSM8K est une collection de problèmes mathématiques de niveau primaire.

Dans les rendus ci-dessus, nous pouvons observer les performances du modèle :

- Lorsque la taille est relativement petite, l'amélioration n'est pas grande

- Il y a une amélioration significative lorsque le modèle devient plus grand

Cela montre fondamentalement que certaines capacités peuvent ne pas exister dans les petits modèles, mais sont obtenues dans les grands modèles.

Il existe de nombreux types de capacités émergentes, comme celles identifiées par Wei et al en 2022[9]. Certaines capacités sont intéressantes, mais nous n'en parlerons pas dans cet article, comme épeler les dernières lettres d'une chaîne de mots. Nous pensons qu'il s'agit d'une tâche pour Python plutôt que d'un modèle de langage ou d'une addition à 3 chiffres ; est un calcul. C'est ce que fait le processeur à la place du modèle de langage.

Dans cet article, nous nous intéressons principalement aux capacités suivantes :

1 Capacités auxquelles la communauté PNL a prêté attention ces dernières années, mais qui étaient difficiles à réaliser par les modèles PNL précédents

. 2. Dérivé des humains La capacité essentielle la plus profonde du langage (profondeur de la capacité)

3. La capacité qui peut atteindre le plus haut niveau d'intelligence humaine (la limite supérieure de la capacité)

2. capacitéBeaucoup de capacités intéressantes peuvent toutes être classées dans les catégories mentionnées ci-dessus, parmi lesquelles nous discutons principalement des trois capacités typiques suivantes :

- Raisonnement complexe

- Raisonnement par connaissances

- Hors de. -robustesse de la distribution

Discutons de chacun en détail.

Raisonnement complexe

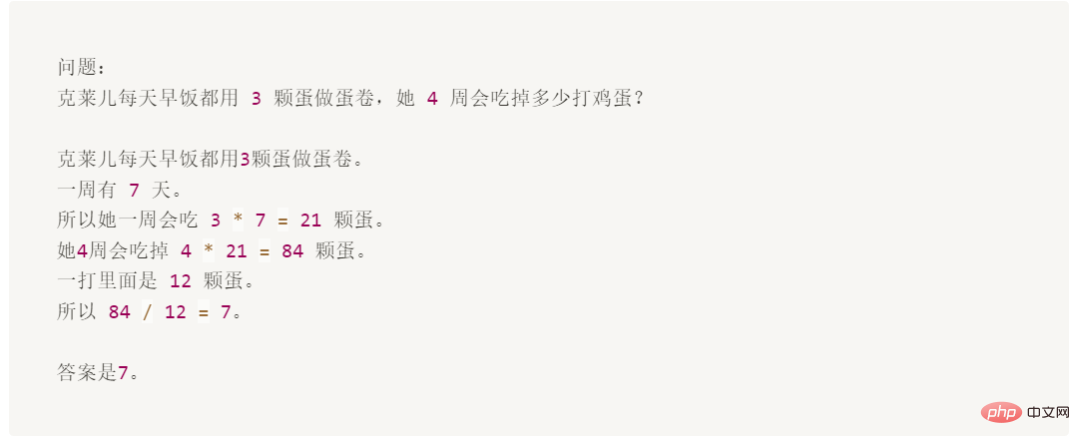

Ce qui suit est un exemple dans l'ensemble de données GSM8K où l'utilisation de mots d'invite dépasse largement le réglage fin :

Bien que cette question soit facile pour un enfant de 10 ans, C'est difficile pour les modèles de langage, principalement parce que les mathématiques et le langage sont mélangés.

GSM8K a été initialement proposé par OpenAI en octobre 2021 [10]. À cette époque, ils utilisaient la première version [11]GPT3 pour affiner l'ensemble de l'entraînement, avec une précision d'environ 35 %. Ce résultat rend les auteurs assez pessimistes, car leurs résultats montrent la loi d'échelle des modèles de langage : à mesure que la taille du modèle augmente de façon exponentielle, les performances augmentent de manière linéaire (j'en parlerai plus tard). Ils réfléchissent donc dans la section 4.1 :

« Le modèle 175B semble nécessiter au moins deux ordres de grandeur supplémentaires de données de formation pour atteindre un taux de solution de 80 %

Trois mois plus tard, en 2022. » Janvier, Wei et al. [12] Basé sur le modèle 540BPaLM, a amélioré la précision à 56,6 % en utilisant seulement 8 exemples d'invites de chaîne de pensée (sans augmenter l'entraînement défini de deux ordres de grandeur). Plus tard en mars 2022, Wang et al.[13] se sont basés sur le même modèle PaLM 540B et ont amélioré la précision à 74,4 % grâce au vote majoritaire. Le SOTA actuel provient de mon propre travail sur AI2 (Fu et. al. novembre 2022[14]), où nous avons atteint une précision de 82,9 % sur le Codex 175B en utilisant des chaînes de pensée complexes. Comme le montrent les progrès ci-dessus, le progrès technologique connaît en effet une croissance exponentielle.

L'invite de la chaîne de réflexion est un exemple typique qui montre la capacité émergente du modèle à l'échelle :

- Du point de vue de la capacité émergente : Ce n'est que lorsque le modèle est plus grand que 100B que l'effet de la la chaîne de pensée soit plus grande que le seul indice de réponse. Cette capacité n’existe donc que dans les grands modèles.

- À en juger par l'effet : Les performances de l'invite de chaîne de pensée sont nettement meilleures que sa précédente méthode de réglage fin [15].

- Du point de vue de l'efficacité des annotations : les invites de chaîne de pensée ne nécessitent que des annotations de 8 exemples, tandis que le réglage fin nécessite un ensemble de formation complet.

Certains élèves peuvent penser que les modèles peuvent faire des mathématiques à l'école primaire et ne veulent rien dire (dans un sens, ils ne sont vraiment pas si cool). Mais GSM8K n'est qu'un début, et des travaux récents ont poussé l'avant-garde dans les problèmes du lycée [16], de l'université [17] et même des problèmes de l'Olympiade mathématique internationale [18]. Est-ce qu'il fait plus frais maintenant ?

Connaissance Raisonnement

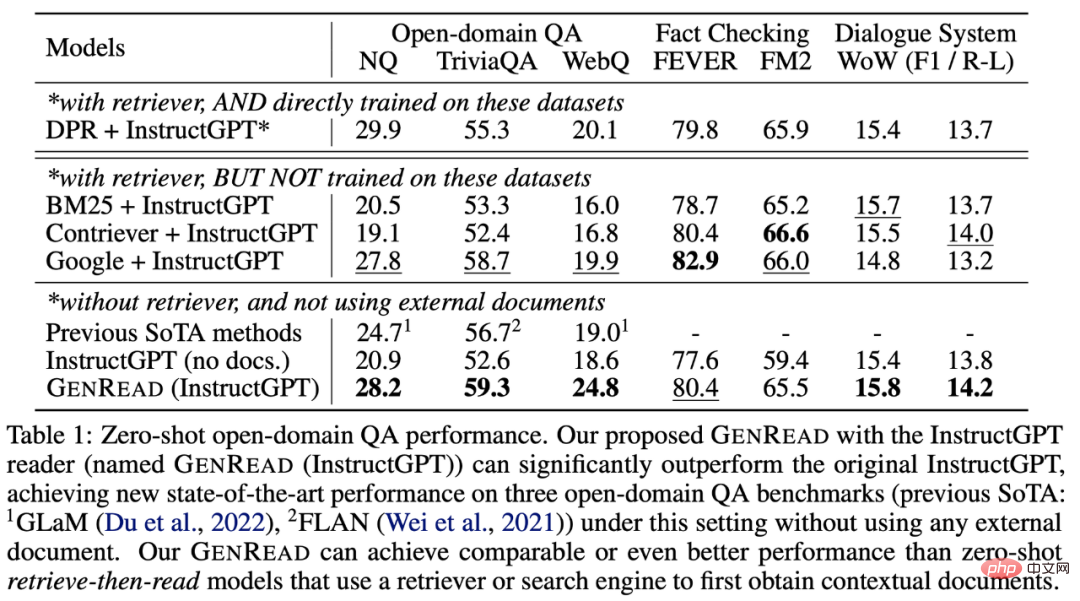

L'exemple suivant concerne les compétences de raisonnement qui nécessitent des connaissances (telles que les questions et réponses et le raisonnement de bon sens). Dans ce cas, il n’est pas nécessairement préférable de proposer un grand modèle que d’affiner un petit modèle (il reste à savoir quel modèle est le meilleur). Mais l'efficacité de l'annotation dans ce cas est amplifiée car :

- Dans de nombreux ensembles de données, afin d'obtenir les connaissances de base/de bon sens requises, le modèle (auparavant petit) nécessite un graphe de corpus/connaissances externe pour récupérer [19 ], ou vous devez vous entraîner sur des [20]données améliorées grâce à un apprentissage multitâche

- Pour les grands modèles de langage, vous pouvez directement supprimer le retriever[21] et vous fier uniquement aux connaissances internes du modèle [22], et aucun réglage fin n'est requis

L'image provient de Yu et al. 2022. Les modèles SOTA précédents doivent être récupérés à partir de sources de connaissances externes. GPT-3 fonctionne aussi bien/mieux que les modèles précédents sans récupération.

Comme le montre le tableau, contrairement à l'exemple de problème mathématique, GPT-3 ne surpasse pas de manière significative le modèle affiné précédent. Mais il n’est pas nécessaire de le récupérer à partir de documents externes, il contient lui-même des connaissances [23].

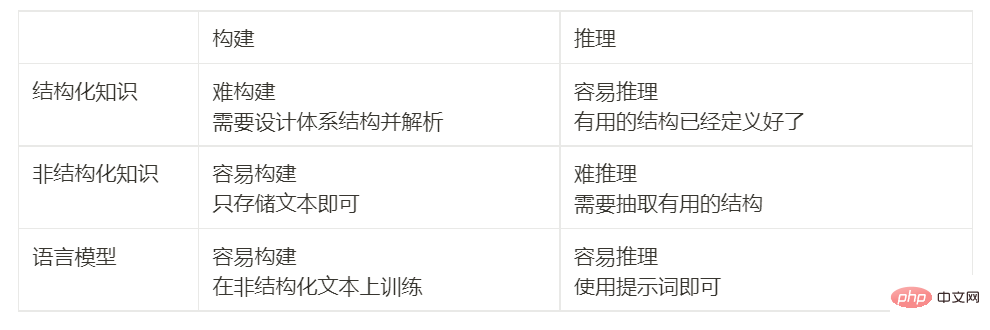

Pour comprendre l'importance de ces résultats, nous pouvons revenir sur l'histoire : la communauté PNL a été confrontée au défi de comment encoder efficacement les connaissances depuis le début. Les gens explorent constamment des moyens de stocker les connaissances à l’extérieur ou à l’intérieur du modèle. Depuis les années 1990, on tente d’enregistrer les règles du langage et du monde dans une bibliothèque géante, stockant ainsi les connaissances en dehors du modèle. Mais c’est très difficile, car on ne peut pas épuiser toutes les règles. Par conséquent, les chercheurs ont commencé à construire des bases de connaissances spécifiques à un domaine pour stocker les connaissances sous forme de texte non structuré, semi-structuré (comme Wikipédia) ou entièrement structuré (comme les graphiques de connaissances). Généralement, les connaissances structurées sont difficiles à construire(car le système structurel des connaissances doit être conçu), mais faciles à raisonner(à cause de l'architecture), les connaissances non structurées sont faciles à construire(il suffit de les enregistrer directement) , mais très Difficile à utiliser pour raisonner (pas d'architecture). Cependant, les modèles linguistiques offrent une nouvelle façon d’extraire facilement des connaissances d’un texte non structuré et de raisonner efficacement sur la base de ces connaissances, sans avoir besoin de modèles prédéfinis. Le tableau suivant compare les avantages et les inconvénients :

Robustesse hors distribution

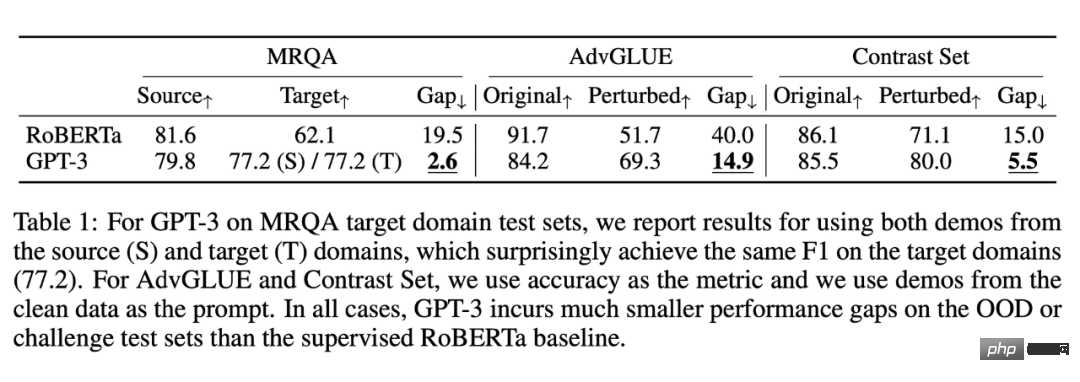

La troisième capacité dont nous discutons est la robustesse hors distribution. Entre 2018 et 2022, de nombreuses recherches ont été menées sur le changement de distribution/la robustesse contradictoire/la génération de combinaisons dans les domaines de la PNL, du CV et de l'apprentissage automatique général. Il a été constaté que lorsque la distribution de l'ensemble de tests est différente de la distribution de la formation, le comportement. les performances du modèle peuvent diminuer considérablement. Cependant, cela ne semble pas être le cas dans l’apprentissage contextuel de grands modèles de langage. La recherche de Si et al. [24] en 2022 montre :

Les données proviennent de Si et al. 2022. Bien que GPT-3 soit pire que RoBERTa dans le même contexte de distribution, il l'est. C'est mieux que RoBERTa dans des paramètres de distribution non identiques et la baisse de performances est nettement inférieure.

De même, dans cette expérience, l'effet de GPT-3 basé sur des mots rapides sous la même distribution n'est pas aussi bon que celui de RoBERTa affiné. Mais il surpasse RoBERTa dans trois autres distributions (commutation de domaine, bruit et perturbations contradictoires), ce qui signifie que GPT3 est plus robuste.De plus, même s'il y a un changement de répartition, la performance de généralisation apportée par de bons mots rapides sera toujours maintenue. Par exemple :

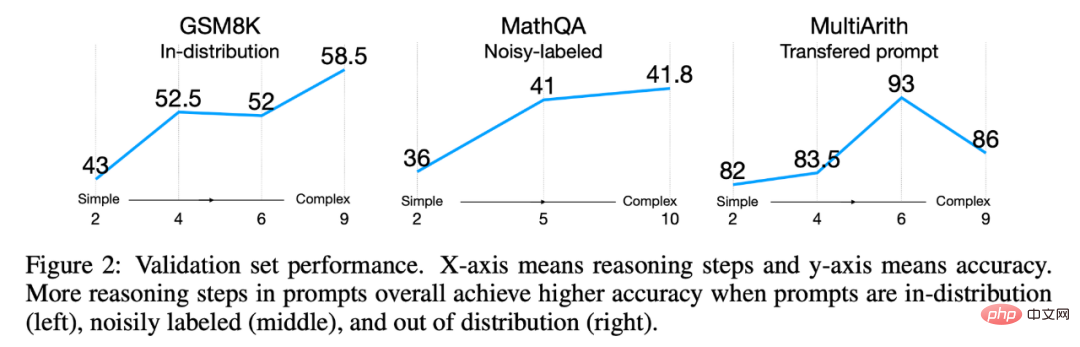

Photo de Fu et al. 2022. Même si la distribution des tests est différente de la distribution des entraînements, les signaux complexes fonctionnent toujours mieux que les signaux simples. L'étude

Fu et al. de 2022[25] a montré que plus les invites de saisie sont complexes, meilleures sont les performances du modèle. Cette tendance s'est poursuivie lors des changements de distribution : les signaux complexes ont systématiquement surpassé les signaux simples, que la distribution test soit différente de la distribution d'origine, qu'elle provienne d'une distribution de bruit ou qu'elle ait été transférée d'une autre distribution.

Résumé jusqu'à présent

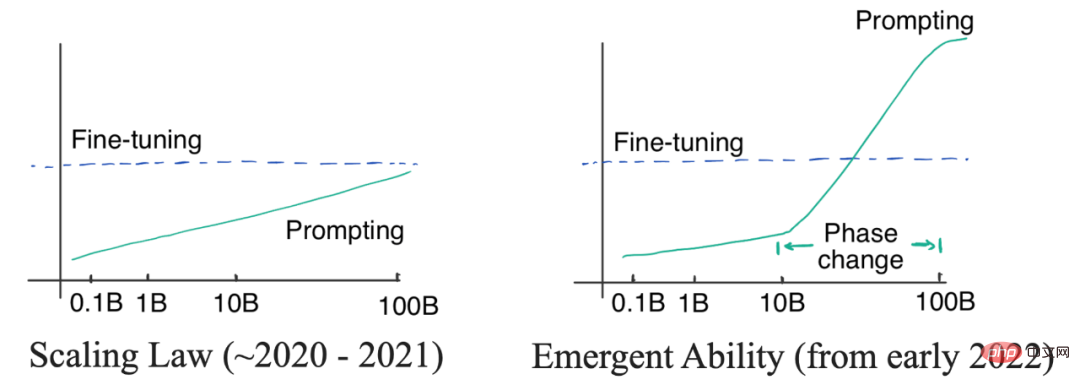

Dans l'article ci-dessus, j'ai évoqué trois capacités émergentes qui ne sont disponibles que dans les grands modèles. Ce sont :Au vu des avantages énumérés ci-dessus, vous pouvez commencer à penser que les grands modèles de langage sont en effet très bons. Avant d'en discuter davantage, passons en revue les travaux antérieurs et nous trouverons une question très étrange : GPT-3 est sorti en 2020, mais pourquoi n'avons-nous pas découvert et commencé à réfléchir au changement de paradigme jusqu'à maintenant ? La réponse à cette question réside dans deux types de courbes : la courbe linéaire logarithmique et la courbe de changement de phase. Comme indiqué ci-dessous : Photo de gauche : Loi de proportion. Lorsque la taille du modèle augmente de façon exponentielle, les performances du modèle correspondant augmentent de manière linéaire. À droite : lorsque la taille du modèle atteint une certaine échelle, des capacités émergentes apparaissent, permettant aux performances d'augmenter considérablement. Au départ, les chercheurs (OpenAI) pensaient que la relation entre les performances du modèle de langage et la taille du modèle pouvait être prédite par une courbe log-linéaire, c'est-à-dire que lorsque la taille du modèle augmente de façon exponentielle, les performances augmenteront de manière linéaire. Ce phénomène est connu sous le nom de loi d'échelle des modèles de langage, comme discuté par Kaplan et al dans leur article GPT3 original de 2020. Il est important de noter qu'à ce stade, même le plus grand GPT-3 ne pouvait pas surpasser les réglages précis des petits modèles avec des indices. Il n’était donc pas nécessaire d’utiliser de grands modèles coûteux à cette époque (même si l’étiquetage des mots d’invite était très efficace). Jusqu'en 2021, Cobbe et al. [28] ont constaté que la loi d'échelle s'appliquait également au réglage fin. Il s'agit d'un résultat quelque peu pessimiste, car cela signifie nous pouvons être verrouillés dans la taille du modèle -- bien que l'optimisation de l'architecture du modèle puisse améliorer les performances du modèle dans une certaine mesure, l'effet sera toujours verrouillé dans une plage (correspondant au modèle échelle), il est difficile d’avoir une avancée plus significative. Sous le contrôle de la loi d'échelle (2020 à 2021), puisque GPT-3 ne peut pas surpasser le réglage fin du T5-11B et que le réglage fin du T5-11B est déjà très gênant, la communauté PNL accorde plus d'attention à Étudiez des modèles plus petits ou une adaptation efficace des paramètres. Le réglage des préfixes[29] est un exemple de l'intersection des invites et de l'adaptation, unifié plus tard par He et al [30] en 2021. La logique à l'époque était simple : Si l'effet de réglage fin est meilleur, nous devrions travailler davantage sur une adaptation efficace des paramètres ; si la méthode des mots d'invite est meilleure, nous devrions investir plus d'énergie dans la formation de grands modèles de langage. Plus tard en janvier 2022, le travail de Thought Chain a été publié. Comme le montrent les auteurs, les signaux de la chaîne de pensée présentent une transition de phase claire dans la courbe d’échelle des performances. Lorsque la taille du modèle est suffisamment grande, les performances s’améliorent considérablement et dépassent clairement la courbe de mise à l’échelle. 4. Que signifie un changement de paradigme ?

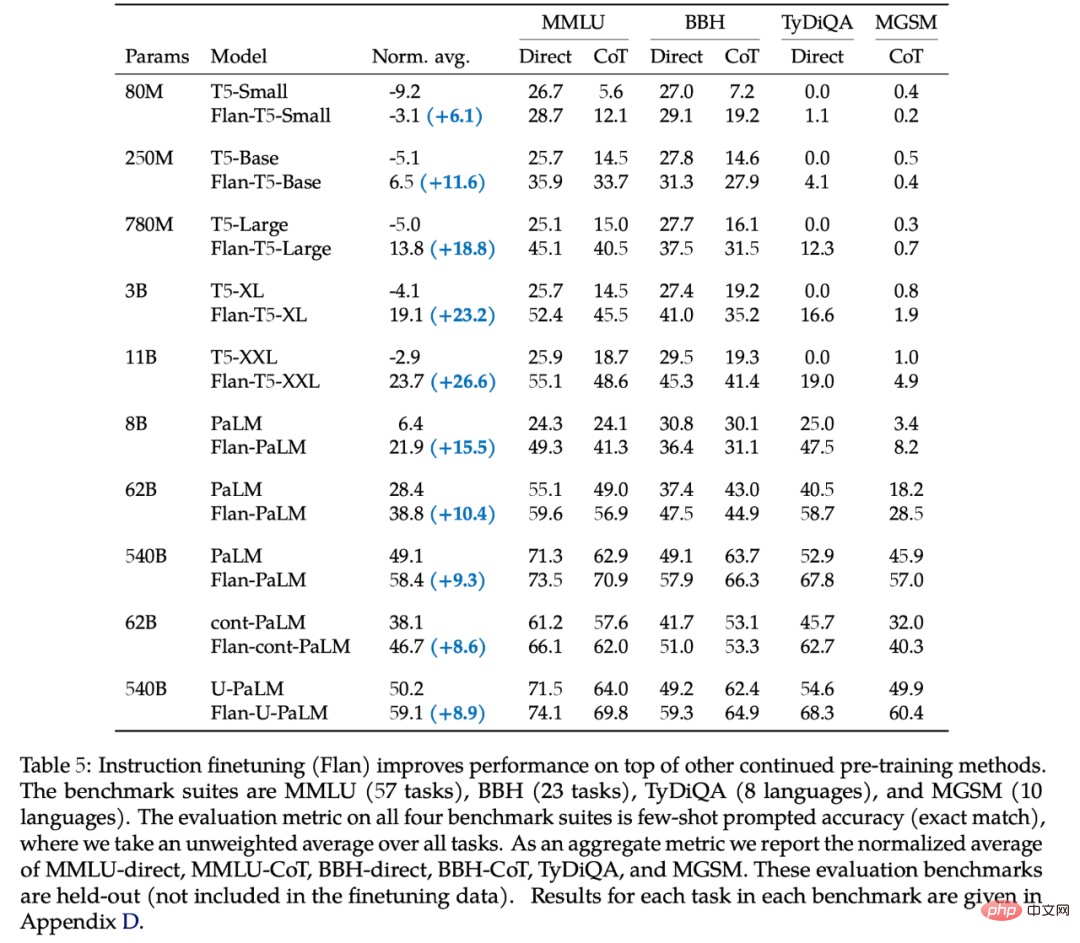

Les avantages des mots rapides sont évidents : nous n'avons plus besoin d'annotations de données fastidieuses et d'ajustements précis sur la quantité totale de données. Il nous suffit d'écrire des mots rapides et d'obtenir des résultats qui répondent aux exigences, ce qui est beaucoup plus rapide que d'affiner. réglage. Deux autres points à noter sont : L'apprentissage contextuel est-il un apprentissage supervisé ? L'apprentissage contextuel est-il vraiment meilleur que l'apprentissage supervisé ? Passons en revue la logique mentionnée ci-dessus : si le réglage fin est meilleur, nous devrions travailler dur pour étudier comment optimiser efficacement les paramètres ; si les mots d'invite sont meilleurs, nous devrions travailler dur pour former de meilleurs modèles de langage à grande échelle ; Ainsi, même si nous pensons que les grands modèles de langage ont un potentiel énorme, il n'existe toujours aucune preuve concluante qu'il est préférable d'affiner ou d'indiquer les mots, nous ne sommes donc pas sûrs si le paradigme devrait réellement changer, ou devrait changer. dans quelle mesure. Il est très significatif de comparer soigneusement ces deux paradigmes pour nous donner une compréhension claire de l’avenir. Nous laissons plus de discussion au prochain article. Deux numéros : 62B et 175B. 62B Ce numéro provient du cinquième tableau du travail 2022 de Chung et al. [31] : Pour tous les modèles inférieurs à 62B, il est préférable d'utiliser directement des mots d'invite que chaîne de pensée. Le premier meilleur modèle utilisant la chaîne de pensée est le résultat de Flan-cont-PaLM 62B sur BBH. Le modèle 540B utilisant la chaîne de réflexion obtiendra de bons résultats sur un plus grand nombre de tâches, mais toutes les tâches ne valent pas mieux qu'un réglage fin. De plus, la taille idéale peut être inférieure à 540 B. Dans les travaux de Suzgun et al [32] en 2022, l'auteur a montré que 175B InstructGPT et 175B Codex utilisent des chaînes de pensée pour être meilleurs que l'utilisation directe de mots d'invite. En combinant les résultats ci-dessus, nous obtenons deux nombres : 63B et 175B. Ainsi, si vous souhaitez participer à ce jeu, vous devez au préalable posséder un modèle de taille supérieure à la moyenne. Cependant, il existe d'autres grands modèles qui fonctionnent bien moins bien sous la chaîne de pensée et ne peuvent même pas apprendre la chaîne de pensée, comme la première version d'OPT, BLOOM et GPT-3. Ils sont tous deux de taille 175B. Cela nous amène à notre prochaine question. Non. L'échelle est un facteur nécessaire mais pas suffisant. Certains modèles sont suffisamment grands (comme OPT et BLOOM, tous deux 175B), mais ils ne peuvent pas créer de chaînes de pensées. Il existe deux modèles[33] qui peuvent être utilisés pour l'enchaînement de pensées : La raison pour laquelle il existe une capacité émergente n'est toujours pas claire, mais nous avons découvert les facteurs qui peuvent produire une capacité émergente : Cependant, tous ces facteurs ne sont que des spéculations à ce stade. Il est très significatif de révéler comment entraîner le modèle pour produire des capacités émergentes, et nous laisserons plus de détails au prochain article. Dans cet article, nous avons soigneusement étudié la capacité émergente des modèles linguistiques. Nous soulignons l’importance et les opportunités du raisonnement complexe, du raisonnement fondé sur la connaissance et de la robustesse hors distribution. Les capacités émergentes sont très intéressantes car elles peuvent transcender les lois d’échelle et présenter des transitions de phase dans les courbes d’échelle. Nous avons discuté en détail de la question de savoir si le paradigme de recherche passerait réellement du réglage fin à l'apprentissage contextuel, mais nous n'avons pas encore de réponse définitive car les effets du réglage fin et de l'apprentissage contextuel dans les scénarios de distribution et hors distribution restent il faut comparer. Enfin, nous discutons de trois facteurs potentiels qui produisent des capacités émergentes : le réglage fin des instructions, le réglage fin du code et le réglage fin de la chaîne de pensée. Les suggestions et les discussions sont les bienvenues. Nous avons également mentionné deux questions intéressantes qui n'ont pas encore été discutées : Pour ces deux problématiques, nous en parlerons dans les articles d'après .

3. La capacité émergente renverse la loi des proportions

5. Quelle doit être la taille du modèle ?

6. L’échelle est-elle le seul facteur ?

7. Conclusion Conclusion

Tableau comparatif chinois-anglais

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI