Maison >Périphériques technologiques >IA >Une tentative de localisation de la technologie ChatGPT

Une tentative de localisation de la technologie ChatGPT

- 王林avant

- 2023-04-08 11:31:031931parcourir

Le sujet de ce partage est la technologie ChatGPT, les tentatives de localisation et les modèles open source. Le partage se compose de trois parties. La première partie donne une introduction globale aux technologies liées à ChatGPT : l'évolution de la technologie ChatGPT, les problèmes actuels, les trois étapes de l'apprentissage de la technologie ChatGPT, l'organisation des données et l'évaluation des effets ; Nos tentatives de localisation technologique incluent les problèmes que nous avons rencontrés au cours de l'expérience, nos réflexions, ainsi que les effets et applications du modèle ; la troisième partie présente le grand modèle open source chinois que nous avons publié et comment utiliser nos propres données pour former un modèle local Pendant l'opération, les problèmes que vous pourriez rencontrer au cours de l'expérience, les écarts entre celui-ci et les modèles open source avancés et comment améliorer encore l'effet du modèle.

1. Technologies liées à ChatGPT

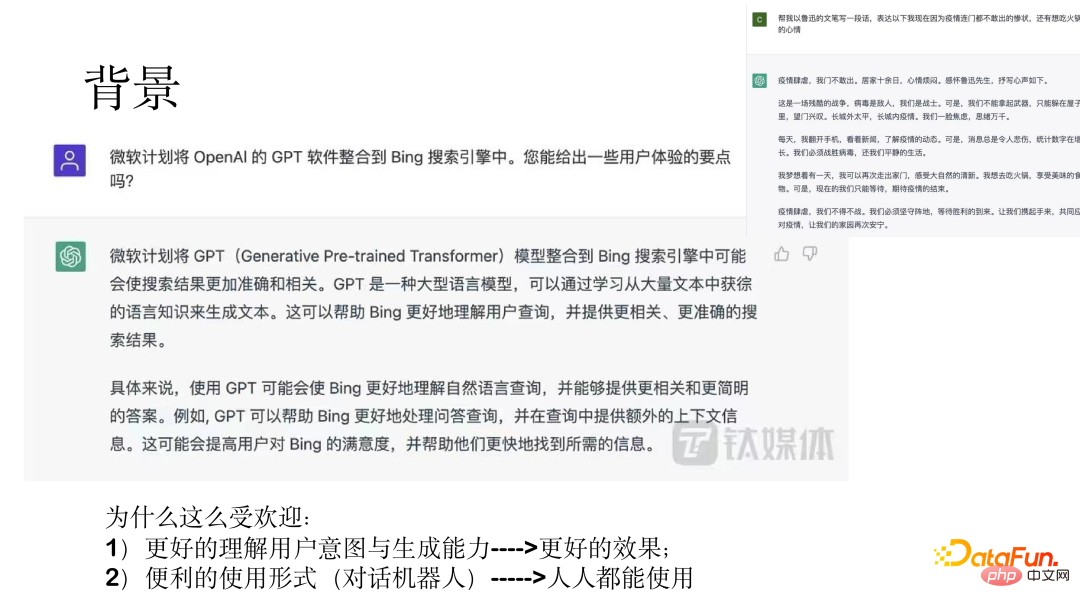

ChatGPT est un assistant fonctionnel général. Le 5 décembre 2022, Sam Altman, PDG d'OpenAI, a publié sur les réseaux sociaux que ChatGPT avait dépassé le million d'utilisateurs cinq jours après son lancement. Le chatbot IA ChatGPT a explosé en popularité et est devenu un événement marquant. Microsoft est en pourparlers pour augmenter sa participation de 10 milliards de dollars et l'intégrer prochainement dans le Microsoft Cloud.

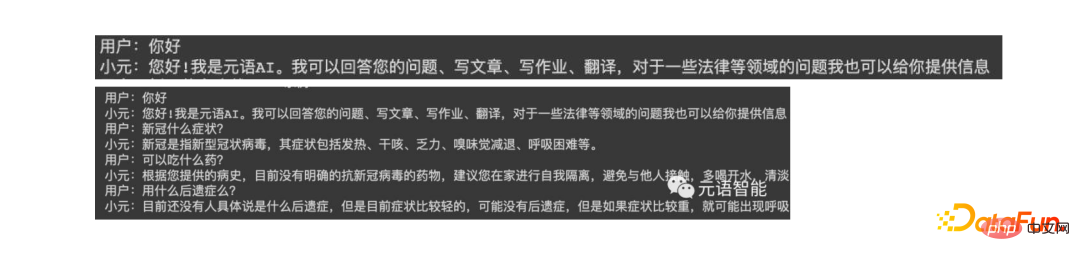

L'image ci-dessus montre deux exemples, montrant des résultats étonnants.

La raison pour laquelle ChatGPT est si populaire est, d'une part, sa capacité à comprendre les intentions des utilisateurs et les meilleurs effets générés, d'autre part, grâce à la forme d'un robot conversationnel, il peut être utilisé par ; tout le monde.

Ce qui suit présentera l'évolution du modèle, les problèmes avec le modèle initial, les trois étapes de l'apprentissage du modèle ChatGPT, ainsi que l'organisation des données et les effets de la formation du modèle ChatGPT.

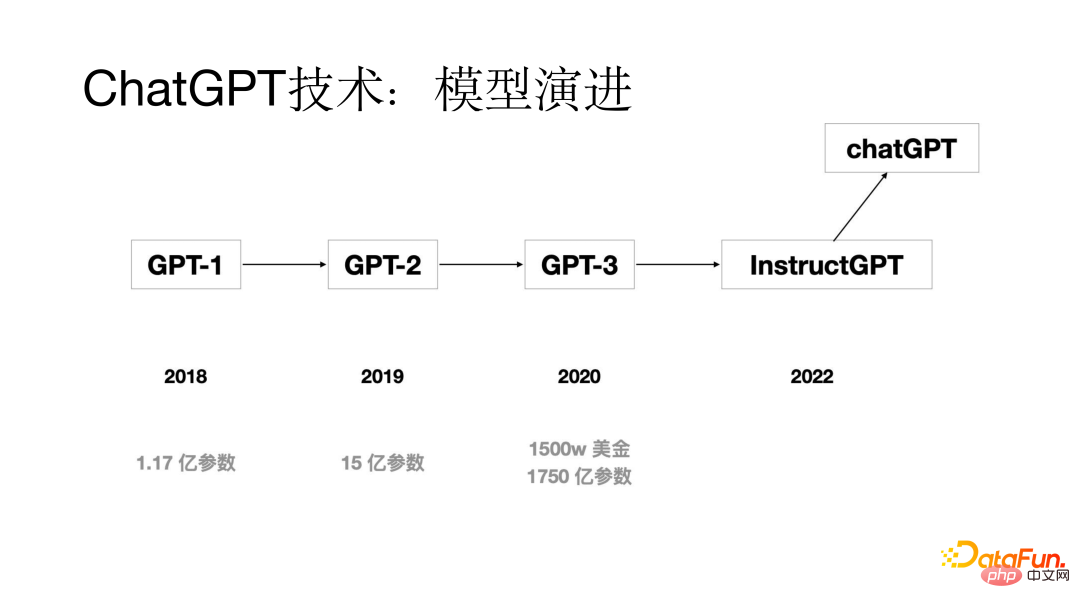

1. Évolution du modèle

La technologie ChatGPT a également évolué à travers plusieurs générations de modèles. Le modèle GPT original a été proposé en 2018 avec seulement 117 millions de paramètres de modèle ; sont 1,5 milliards ; d'ici 2020, les paramètres du modèle GPT-3 ont atteint 175 milliards grâce à plusieurs générations d'itérations de mise à jour du modèle, le modèle ChatGPT apparaîtra en 2022 ;

2. Quels types de problèmes le modèle précédent avait-il ?

Quels types de problèmes le modèle avait-il avant la sortie du modèle ChatGPT ? L'analyse a révélé que l'un des problèmes les plus évidents est le problème d'alignement. Bien que la capacité de génération des grands modèles soit relativement forte, les réponses générées ne répondent parfois pas aux intentions de l'utilisateur. Grâce à des recherches, il a été constaté que la principale raison du problème d'alignement est que l'objectif de la formation sur le modèle linguistique est de prédire le mot suivant, plutôt que de le générer selon l'intention de l'utilisateur. Afin de résoudre le problème d'alignement, le processus d'apprentissage par renforcement à partir de la rétroaction humaine (RLHF) est ajouté au processus de formation du modèle ChatGPT.

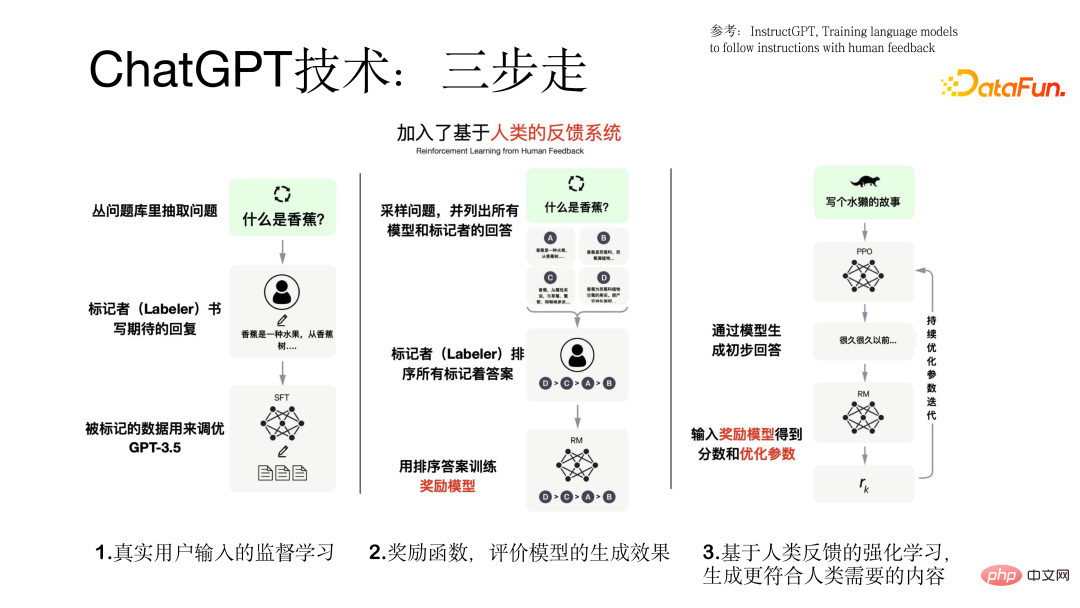

3. Trois étapes d'apprentissage

Le processus de formation du modèle ChatGPT se déroule en trois étapes.

La première étape consiste à utiliser la saisie d'un utilisateur réel pour un apprentissage supervisé basé sur le modèle GPT. Dans ce processus, les données proviennent d'utilisateurs réels et la qualité des données est relativement élevée et précieuse.

La deuxième étape consiste à former un modèle de récompense. Pour une requête, différents modèles produiront différents résultats de sortie. L'étiqueteur trie les résultats de sortie de tous les modèles et utilise ces données triées. Modèle de récompense de formation.

La troisième étape consiste à saisir la réponse préliminaire générée par le modèle dans le modèle de récompense. Le modèle de récompense évaluera la réponse si la réponse générée répond à l'intention de l'utilisateur, elle donnera un retour positif, sinon. Donnez simplement un retour négatif pour rendre le modèle de mieux en mieux. C'est le but de l'introduction de l'apprentissage par renforcement pour rendre les résultats générés plus conformes aux besoins humains. Le processus en trois étapes de formation du modèle ChatGPT est illustré dans la figure ci-dessous.

4. Organisation des données et évaluation des effets

Avant d'entraîner le modèle, nous devons préparer l'ensemble de données utilisé. Dans ce processus, nous rencontrerons le problème du démarrage à froid des données. , peuvent être résolus à travers les trois aspects suivants :

(1) Collecter les ensembles de données utilisés par les utilisateurs de l'ancien système

(2) Laisser les annotateurs annoter certaines questions en fonction des entrées précédentes par de vrais utilisateurs Invites et résultats similaires

(3) Les annotateurs de données proposent des invites de questions-réponses, d'écriture d'histoires, de génération, etc.

Les données pour la formation du modèle ChatGPT contiennent trois parties de l'ensemble de données (77 000 données réelles) :

(1) Données d'apprentissage supervisé basées sur des invites utilisateur réelles, des invites utilisateur, la réponse du modèle, la quantité de données est 13k.

(2) L'ensemble de données utilisé pour entraîner le modèle de récompense. Cette partie des données est destinée au tri de plusieurs réponses correspondant à une invite, et le volume de données est de 33 000.

(3) Un ensemble de données basé sur le modèle de récompense utilisant la technologie d'apprentissage par renforcement pour la formation du modèle. Il ne nécessite que des invites de l'utilisateur. Le volume de données est de 31 000 et les exigences de qualité sont élevées.

Après avoir terminé la formation du modèle ChatGPT, l'évaluation du modèle est relativement suffisante, principalement sous les aspects suivants :

(1) Si les résultats générés par le modèle répondent à l'intention de l'utilisateur

(2) Si les résultats générés peuvent répondre aux contraintes mentionnées par l'utilisateur

(3) Si le modèle peut avoir de bons résultats dans le domaine du service client

Résultats expérimentaux détaillés en comparant avec le Modèle de base GPT Comme indiqué ci-dessous.

2. Localisation de la technologie ChatGPT

Ce qui suit présentera notre localisation de la technologie ChatGPT sous trois aspects : contexte et problèmes, idées de solutions, effets et pratique.

1. Contexte et problèmes

Pourquoi la localisation est-elle nécessaire ? Les aspects suivants sont principalement pris en compte :

(1) La technologie ChatGPT elle-même est relativement avancée et peut être utilisée dans de nombreuses tâches. L'effet est relativement bon, mais il ne fournit pas de services à la Chine continentale.

(2) Il se peut qu'il ne soit pas en mesure de répondre aux besoins des clients nationaux au niveau des entreprises et ne puisse pas fournir de support et de services techniques localisés.

(3) Le prix est indiqué en dollars américains en Europe et aux États-Unis, principaux marchés. Le prix est relativement élevé et la plupart des utilisateurs nationaux ne pourront peut-être pas se le permettre. Grâce à des tests, il a été constaté que chaque élément de données coûte environ 0,5 yuan et que la commercialisation est impossible pour les clients disposant de grandes quantités de données.

En raison des trois problèmes ci-dessus, nous avons essayé de localiser la technologie ChatGPT.

2. Idée de solution

Nous avons adopté une stratégie distribuée dans le processus de localisation de la technologie ChatGPT.

Premièrement, un modèle de pré-entraînement chinois avec des dizaines de milliards de paramètres a été formé ; deuxièmement, un apprentissage supervisé par tâche a été effectué à l'aide de Prompt sur des données de tâche de niveau milliard, puis le modèle a été conversationnalisé, c'est-à-dire sous la forme ; de dialogue ou d'interaction homme-machine. Enfin, nous introduisons la technologie d'apprentissage par renforcement RLHF du modèle de récompense et des commentaires des utilisateurs.

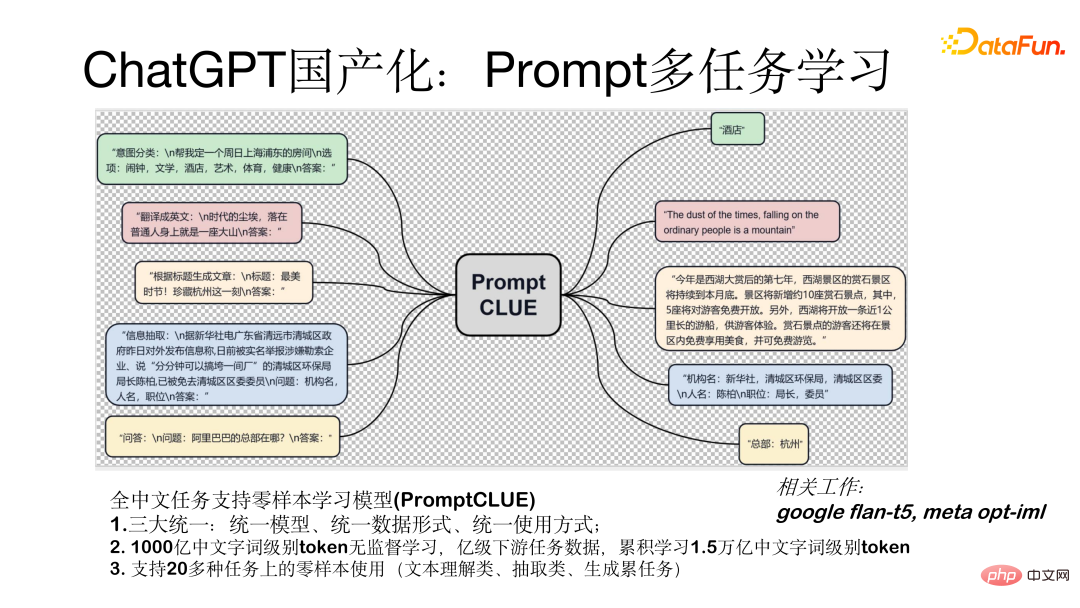

Le modèle d'apprentissage multi-tâches Prompt (PromptCLUE) est un modèle qui prend en charge l'apprentissage zéro pour toutes les tâches chinoises. Ce modèle réalise trois unifications majeures : modèle unifié, forme de données unifiée (toutes les tâches sont converties en forme d'invite) et méthode d'utilisation unifiée (utilisée sous forme d'échantillon zéro). Le modèle est basé sur l'apprentissage non supervisé de 100 milliards de jetons au niveau des mots chinois. Il est formé sur des données de tâches en aval au niveau d'un milliard et a accumulé 1,5 billion de jetons au niveau des mots chinois. Prend en charge l'utilisation d'un échantillon nul sur plus de 20 tâches (tâches de compréhension, d'extraction et de génération de texte).

Comment rendre le modèle conversationnel, c'est-à-dire le convertir en modèle sous forme d'interaction homme-machine Nous avons principalement réalisé le travail suivant :

Tout d'abord, dans l'ordre ? pour que le modèle ait un meilleur effet de génération, nous avons supprimé les tâches de compréhension et d'extraction de texte, renforçant ainsi l'apprentissage des tâches de questions et réponses, de dialogue et de génération. Deuxièmement, après la conversion en modèle de dialogue, les résultats de la génération seront perturbés par le contexte ; Pour résoudre ce problème, nous avons ajouté des données anti-interférences permettant au modèle d'ignorer le contexte non pertinent lorsque cela est nécessaire. Enfin, nous ajoutons un processus d'apprentissage basé sur des données de commentaires réels des utilisateurs afin que le modèle puisse mieux comprendre les intentions de l'utilisateur. La figure ci-dessous montre la forme de tests à un seul tour et à plusieurs tours avec le modèle.

3. Effets et pratique

Ce qui suit est l'effet du test du modèle En comparant le modèle actuel avec le modèle ChatGPT, il y a encore un écart de 1 à 2 ans, mais. cet écart peut être Nous comblons progressivement. À l'heure actuelle, nous avons fait quelques tentatives utiles et avons obtenu certains résultats. Nous pouvons actuellement mener certaines interactions telles que le dialogue, les questions et réponses et l'écriture. L'image ci-dessous montre les résultats du test.

3. Grand modèle open source domestique

1. Modèle open source chinois

Le grand modèle de dialogue fonctionnel métalangage (ChatYuan) que nous venons de publier compte 770 millions de paramètres, et la version en ligne Il est un modèle avec 10 milliards de paramètres et a été lancé sur plusieurs plates-formes, notamment Huggingface, ModelScope, Github et paddlepaddle. Les modèles peuvent être téléchargés localement et affinés en fonction de votre propre ensemble de données utilisateur. Il est en outre formé sur la base de PromptCLUE-large combiné à des centaines de millions de données de dialogue fonctionnel à plusieurs tours.

Ce qui précède prend la plateforme Huggingface comme exemple pour montrer comment utiliser le modèle localement. Recherchez ChatYuan sur la plateforme, chargez le modèle et effectuez un packaging simple. Certains paramètres importants sont utilisés, tels que l'opportunité d'échantillonner des échantillons. Si vous devez générer une variété d'échantillons, vous devez échantillonner.

2. Pour former un modèle local basé sur vos propres données

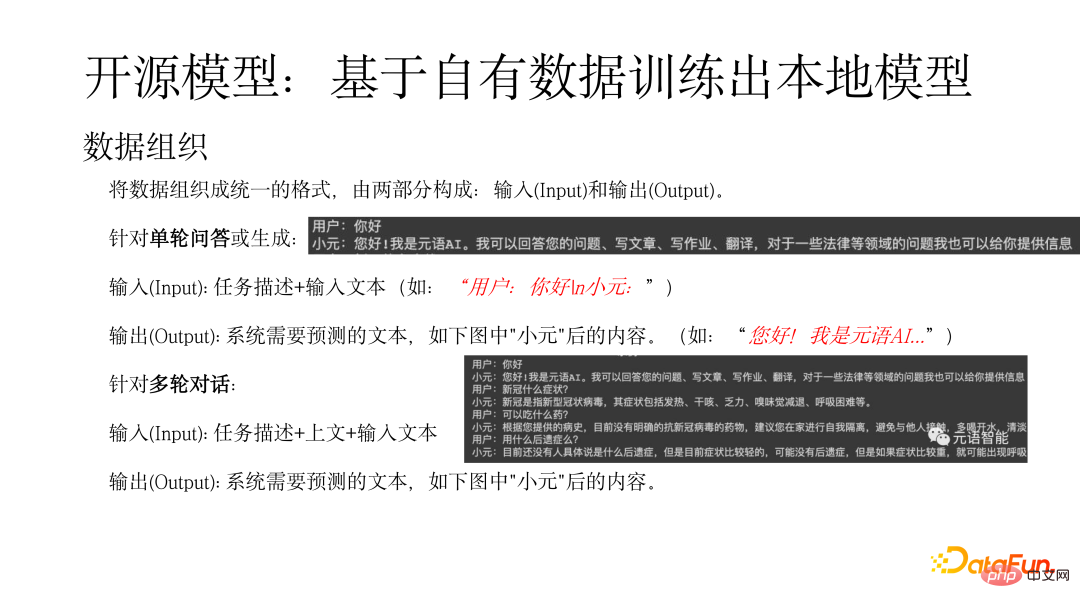

Tout d'abord, vous devez organiser les données sous une forme unifiée, composée de deux parties : l'entrée (Input) et la sortie (Output). Pour une seule série de questions et réponses ou d'entrée générée (Input) : description de la tâche + texte d'entrée (tel que : "Utilisateur : Bonjour n Xiaoyuan :"), la sortie (Output) fait référence au texte que le système doit prédire (tel que comme : "Bonjour ! C'est de l'IA métalangage..."). Pour une entrée de dialogue à plusieurs tours (Input) : description de la tâche + ci-dessus + texte d'entrée, la sortie fait référence au texte que le système doit prédire, comme le contenu après « Xiaoyuan » dans la figure ci-dessous.

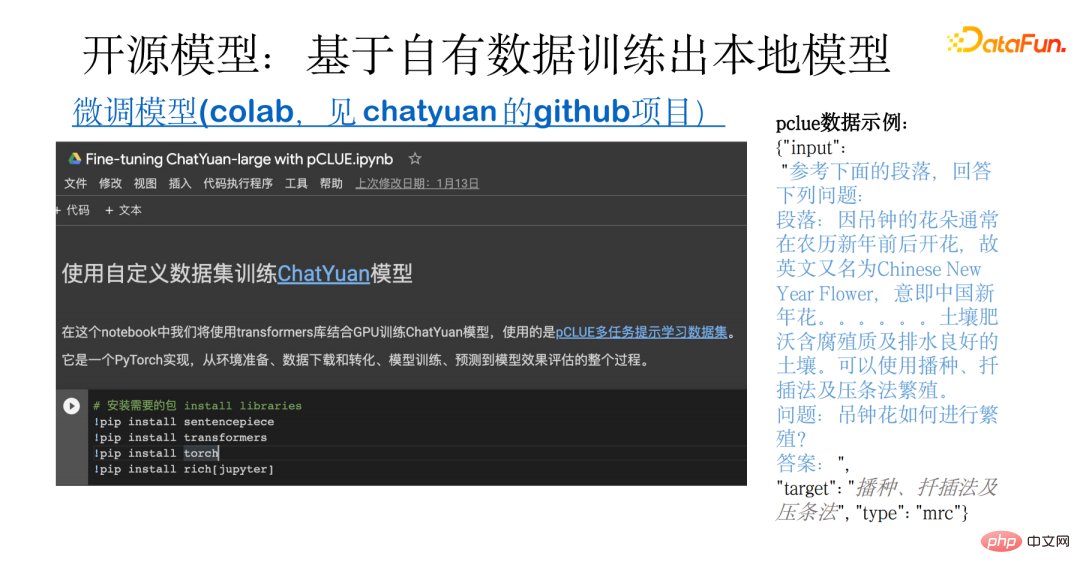

La figure ci-dessous montre un exemple de formation d'un modèle local basé sur vos propres données. Cet exemple couvre l'ensemble du processus, de la préparation des données au téléchargement et à la conversion de données open source, en passant par la formation, la prédiction et l'évaluation du modèle. La base est l'ensemble de données multitâches pCLUE. Les utilisateurs peuvent utiliser leurs propres données pour la formation ou utiliser pCLUE pour une formation préliminaire afin de tester l'effet.

3. Problèmes possibles, lacunes et comment améliorer encore l'effet

ChatYuan et ChatGPT sont tous deux des modèles de conversation fonctionnels à usage général, qui peuvent tous deux être utilisés dans le chat ou dans des domaines professionnels tels que comme le droit et la médecine, les questions-réponses, l'interaction et la génération. Par rapport au modèle ChatGPT, il existe encore un certain écart, qui se reflète principalement dans les aspects suivants :

- En termes de taille du modèle, le nombre de paramètres de ChatGPT est de centaines de milliards, et cela de ChatYuan s'élève à des dizaines de milliards

- Il existe également un grand écart dans la quantité de données apprises, et le modèle ChatYuan est toujours en cours d'apprentissage

- En termes d'apprentissage par renforcement, le Le modèle ChatGPT a introduit l'apprentissage par renforcement des commentaires basé sur l'utilisateur, notre modèle est toujours en cours d'introduction. Vous pouvez rencontrer des problèmes avec l'effet de génération et la longueur du texte lors de l'utilisation du modèle, selon que le format des données est correct, si les échantillons sont échantillonnés pendant le processus de génération, la longueur du résultat de sortie est contrôlé par max_length, etc.

Pour améliorer encore l'effet de modèle, vous pouvez partir des aspects suivants :

(1) Combiner avec les données de l'industrie pour une formation continue, y compris une pré-formation non supervisée, et l'utilisation d'une grande quantité de données de haute qualité Apprentissage supervisé.

(2) L'apprentissage à l'aide de données de commentaires d'utilisateurs réels peut compenser les différences de distribution.

(3) Introduire l'apprentissage par renforcement pour aligner les intentions des utilisateurs.

(4) Choisissez un modèle plus grand De manière générale, plus le modèle est grand, plus la capacité du modèle est forte.

Les nouvelles technologies et scénarios d'utilisation apportés par ChatGPT ont permis aux gens de voir l'énorme potentiel de l'IA. Davantage d'applications seront mises à niveau, créant ainsi des possibilités pour de nouvelles applications.

Yuanyu Intelligence, en tant que fournisseur de services Model-as-a-Service à grande échelle, explore également constamment ce domaine. Les partenaires intéressés sont invités à prêter attention à notre site Web et à notre compte officiel.

C'est tout pour le partage d'aujourd'hui, merci à tous.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI