Maison >Périphériques technologiques >IA >Classification des images de vision par ordinateur

Classification des images de vision par ordinateur

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-07 22:01:011751parcourir

Cet article est réimprimé du compte public WeChat « AI Origin » par l'auteur Beishang. Pour réimprimer cet article, veuillez contacter le compte public AI Yuanqi.

Pouvez-vous dire des chiffres ?

En parlant d'IA, ce à quoi tout le monde pense doit être une créature matérielle intelligente comme MOSS dans "The Wandering Earth 2". Elle semble omnisciente et omnipotente. Tant qu'elle dispose d'Internet, ce sera comme dans Avengers 2. Comme Ultron, il utilise Internet pour se répandre partout, pensant toujours à un plan pour éliminer les êtres humains et parvenir à la « paix mondiale ».

Cependant, en réalité, l'IA à ce stade est encore loin de ce que tout le monde ressent et expérimente dans les œuvres cinématographiques et télévisuelles. Aujourd'hui, prenons la reconnaissance numérique des images comme exemple et explorons sur quoi se base l'IA. existe réellement. L'article sera indexé par quelques questions clés pour vous aider à comprendre étape par étape. Suivez-moi, c'est parti ~

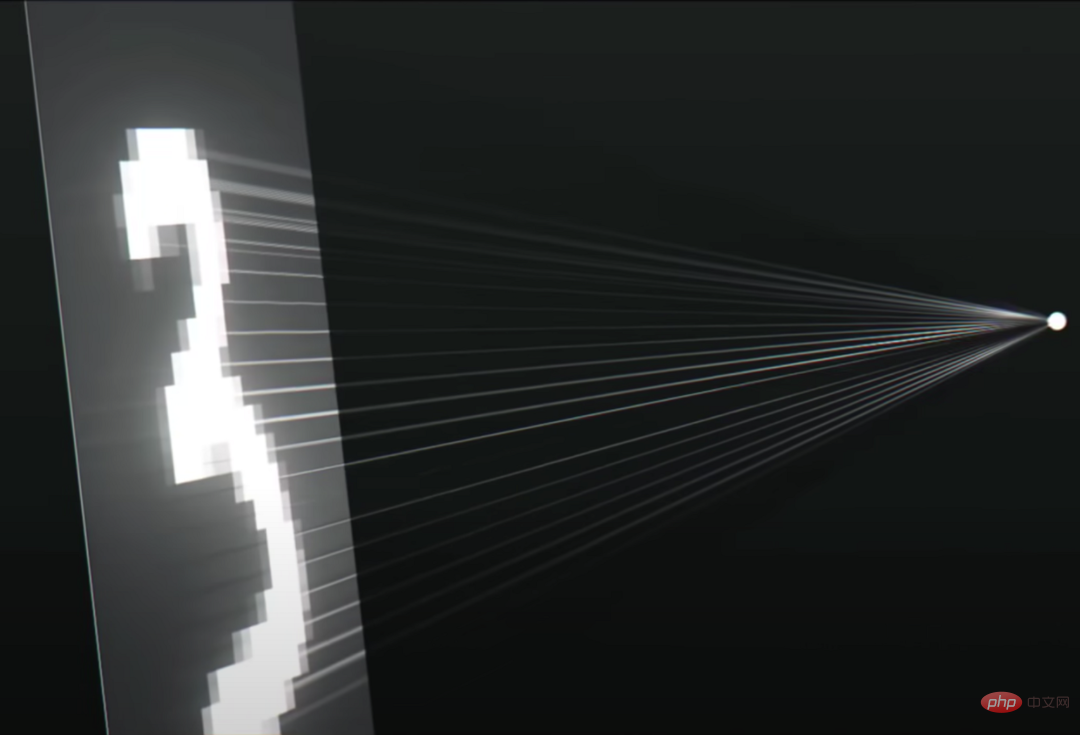

C'est une photo avec des chiffres. Je pense que vous pourrez réagir immédiatement après l'avoir vue. C'est une photo avec le chiffre « 3 » (même si elle est floue).

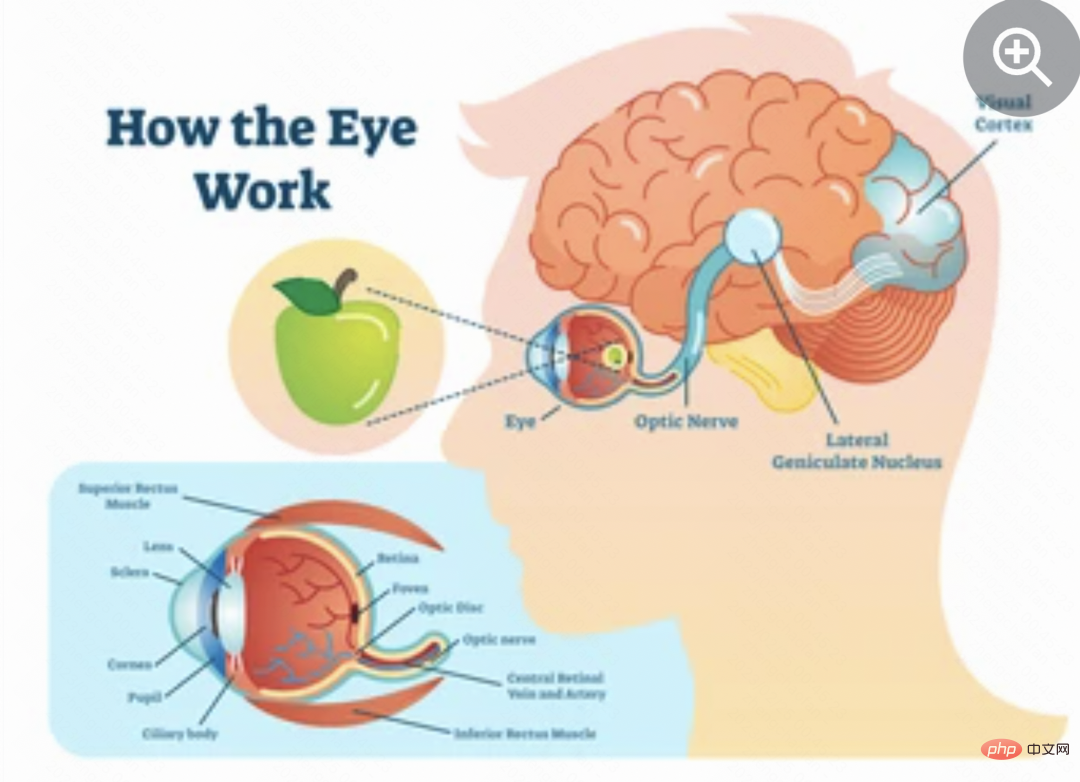

La première question : La vraie intelligence - pourquoi pouvez-vous savoir clairement qu'il s'agit du chiffre « 3 » ? Qu'est-ce que cela signifie?

Lorsque vous regardez cette image, vos yeux convertissent le signal optique en un signal biologique que le cerveau peut reconnaître grâce à la réflexion de la lumière sur la rétine, et stockent temporairement cette partie de l'information (uniquement pour aider à la compréhension, pas réellement ?) dans sur votre rétine. Une fois que le cerveau a reçu le signal, votre petit cerveau intelligent reconnaît rapidement qu'il s'agit du chiffre « 3 ». À ce moment-là, vous avez complètement compris l'image, et c'est un « 3 ». Bien sûr, la base de tout cela est qu'on vous a appris depuis l'enfance que les nombres sous cette forme sont « équivalents » au chiffre 3, et non au 5, au 6 et aux autres nombres.

Deuxième question : Yeux, rétine : quelle forme d'entrée l'ordinateur utilise-t-il pour reconnaître le monde physique ?

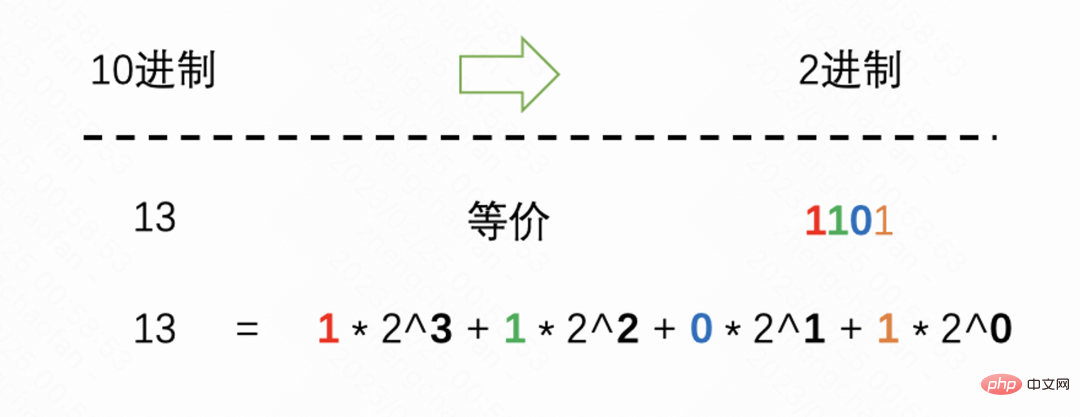

Quelle est la relation entre les ordinateurs et l'IA ? Nous pouvons simplement comprendre que l’IA est une sorte de capacité pseudo-intelligente qui nécessite la puissance de calcul et l’architecture d’un ordinateur, tout comme nous avons nous-mêmes l’intelligence et la vie, mais en fait nous sommes essentiellement des organismes à base de carbone. Comme nous le savons tous, le monde informatique est un monde binaire. En termes simples, c'est 0 ou 1. Je sais que vous devez avoir des doutes en ce moment. Pouvez-vous réaliser autant de fonctions simplement en vous appuyant sur des nombres binaires 0 ou 1 ? Avez-vous une puissance de calcul aussi puissante ? Mais ne vous inquiétez pas, il y a un concept qui doit être clarifié ici, à savoir que le binaire peut représenter des nombres dans n'importe quelle base (vous pouvez d'abord penser que c'est correct, et nous en reparlerons plus tard si vous en avez spécifiquement besoin). Par exemple, le nombre 13 dans notre système décimal couramment utilisé, en binaire, est 1101. Les amis qui souhaitent étudier attentivement peuvent voir l'explication de l'image ci-dessous.

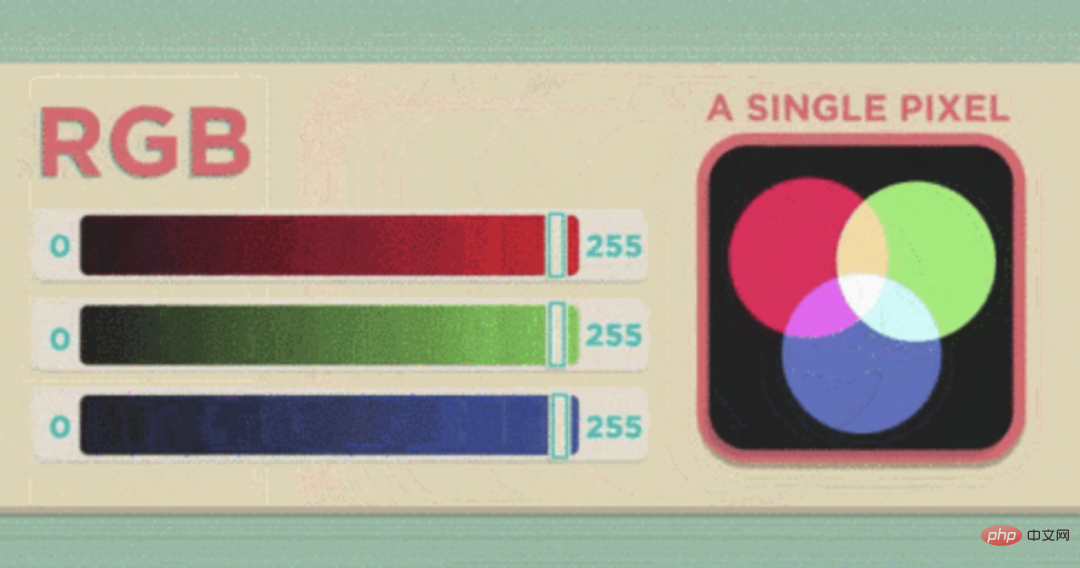

On comprend donc bien que pour un nombre, l'ordinateur peut le "comprendre" grâce au binaire. Si une image peut être convertie en une chaîne de nombres, l'ordinateur pourra-t-il passer d'un idiot qui ne connaît que 0 et 1 à un idiot capable de saisir des informations à partir de l'image (si vous ne la comprenez pas, mettez-la de côté, tout comme un enfant doit d'abord apprendre à manger lorsqu'il grandit). Comme le montre la figure ci-dessous, chaque petite zone de l'image peut être considérée comme un pixel, et un pixel représente une couleur. Comme nous le savons tous, n'importe quelle couleur peut passer par le rouge, le vert, le bleu (bleu), puis. nous pouvons former une liste de nombres dans l'ordre de gauche à droite et de haut en bas, puis envoyer ce contenu à l'ordinateur.

À ce stade, que l'ordinateur le comprenne ou non, nous avons converti l'image en un signal que l'ordinateur peut accepter. Alors, comment le cerveau de l'ordinateur reconnaît-il que le nombre dans l'image est « 3 » ?

La troisième question : ce qu'on appelle l'IA - comment l'ordinateur devrait-il déterminer que le nombre sur cette image est "3"

Donnez à l'ordinateur deux images comme celle-ci. Il peut vous dire que l'image de gauche est le chiffre "3". Pensez-vous qu'il possède une intelligence artificielle ? Vous pensez peut-être que c’est trop naïf, mais même un enfant de 3 ans le sait. Mais si l’image de droite montre 10 000 photos d’oiseaux rares tels que des fous à pattes bleues, et qu’il ne faut que quelques secondes à l’ordinateur pour identifier avec précision diverses créatures rares avec une précision de 99 %, n’est-ce pas ? un peu comme l'IA ?

Méthode de reconnaissance traditionnelle - Plus précisément, nous avons pu convertir l'image en une matrice numérique. La méthode de reconnaissance d'image traditionnelle extraira les caractéristiques de l'image, par exemple en utilisant certaines règles strictes comme caractéristiques. Quant au chiffre « 3 », lorsque nous voyons cette forme dans notre cerveau, nous réagissons inconsciemment en disant qu'il s'agit d'un « 3 », mais pour l'ordinateur, il s'agit d'une chaîne de chiffres. Par conséquent, lorsqu'ils effectuaient des tâches similaires de classification d'images au début, les ingénieurs devaient traiter la séquence numérique mappée sur le chiffre « 3 », ce qui était vraiment un casse-tête. La création de fonctionnalités est donc un processus crucial mais extrêmement lourd dans la reconnaissance et la classification traditionnelles d’images.

L'avantage de la méthode de reconnaissance traditionnelle est que lorsque le résultat de la reconnaissance est erroné, vous pouvez déterminer approximativement la cause de l'erreur en affichant les fonctionnalités. L'inconvénient est que l'ingénierie des fonctionnalités est fastidieuse. Existe-t-il un moyen d'affaiblir l'ingénierie des fonctionnalités (bien que l'ingénierie des fonctionnalités soit également extrêmement importante pour de nombreuses tâches ultérieures) et de fournir une solution de bout en bout. Ce qu'on appelle de bout en bout signifie qu'il me suffit de donner une image numérique et ses résultats de classification, et de laisser l'ordinateur apprendre lui-même la solution de reconnaissance (est-ce un peu comme les idées d'apprentissage humain). Après les changements d’époque et l’amélioration significative de la puissance de calcul des ordinateurs, les algorithmes d’apprentissage profond basés sur les réseaux de neurones ont progressivement été utilisés.

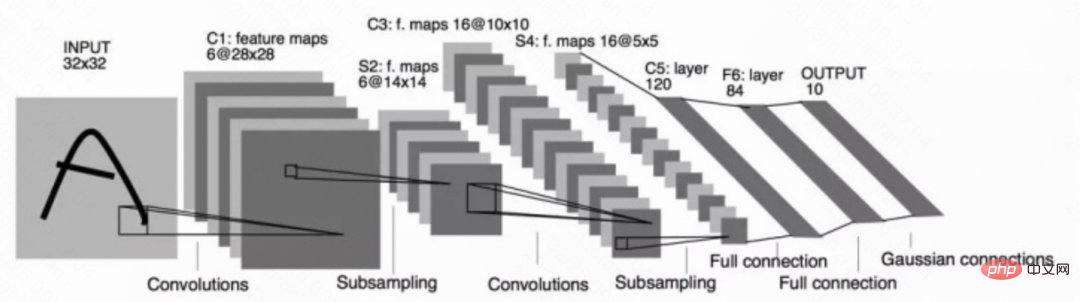

Méthode de reconnaissance des réseaux neuronaux profonds - Ces mots sont très profonds. Ceux qui n'apprennent pas les ordinateurs ou n'utilisent pas d'algorithmes peuvent être directement effrayés. Laissez-moi traduire en une phrase ce qu'est un réseau neuronal profond (dog head.jpg). : Il existe une certaine corrélation non linéaire entre les données d'entrée et l'étiquette spécifiée. Le réseau neuronal utilise plusieurs fonctions non linéaires pour s'adapter approximativement à la corrélation non linéaire mentionnée ci-dessus. Comme indiqué ci-dessous, il s'agit d'un simple réseau neuronal profond. L'image la plus à gauche (lettre « A ») et le côté droit est la structure qui convertit l'image en nombres et effectue des opérations « intelligentes », qui peuvent être comprises comme le « cerveau ». ".

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI