Maison >Périphériques technologiques >IA >Le supercalculateur IA de Google écrase le NVIDIA A100 ! Les performances du TPU v4 ont été multipliées par 10, les détails divulgués pour la première fois

Le supercalculateur IA de Google écrase le NVIDIA A100 ! Les performances du TPU v4 ont été multipliées par 10, les détails divulgués pour la première fois

- PHPzavant

- 2023-04-07 14:54:131383parcourir

Bien que Google ait déployé la puce d'IA la plus puissante de l'époque, TPU v4, dans son propre centre de données dès 2020.

Mais ce n’est que le 4 avril de cette année que Google a annoncé pour la première fois les détails techniques de ce supercalculateur IA.

Adresse papier : https://arxiv.org/abs/2304.01433

Par rapport au TPU v3, les performances du TPU v4 sont 2,1 fois supérieures, et après avoir intégré 4096 puces, les performances du supercalculateur a été amélioré de 10 fois.

De plus, Google affirme également que sa propre puce est plus rapide et plus économe en énergie que NVIDIA A100.

En concurrence avec l'A100, la vitesse est 1,7 fois plus rapide

Dans le document, Google a déclaré que pour des systèmes de taille comparable, le TPU v4 peut fournir des performances 1,7 fois supérieures à celles du Nvidia A100, tout en améliorant également l'efficacité énergétique. 1,9 fois.

De plus, la vitesse de calcul de Google est environ 4,3 fois à 4,5 fois plus rapide que celle de Graphcore IPU Bow.

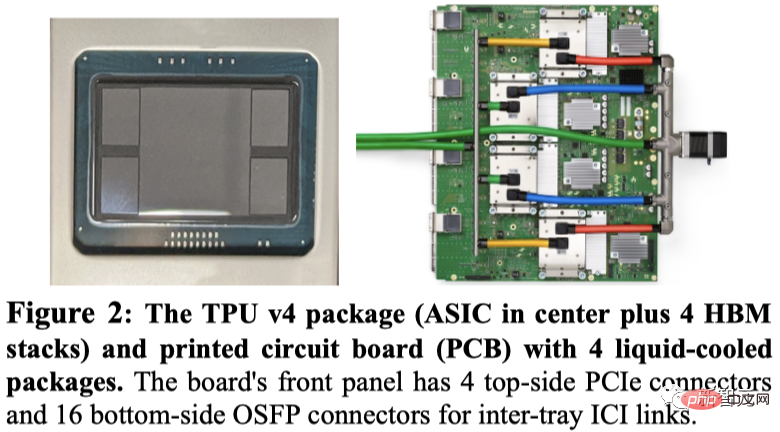

Google a présenté le package TPU v4, ainsi que 4 packages montés sur le circuit imprimé.

Comme le TPU v3, chaque TPU v4 contient deux TensorCore (TC). Chaque TC contient quatre unités de multiplication matricielle (MXU) 128 x 128, une unité de traitement vectoriel (VPU) avec 128 canaux (16 ALU par canal) et 16 Mio de mémoire vectorielle (VMEM).

Deux TC partagent une mémoire commune de 128 MiB (CMEM).

Il convient de noter que la puce A100 a été lancée en même temps que le TPU de quatrième génération de Google, alors comment comparer ses performances spécifiques ?

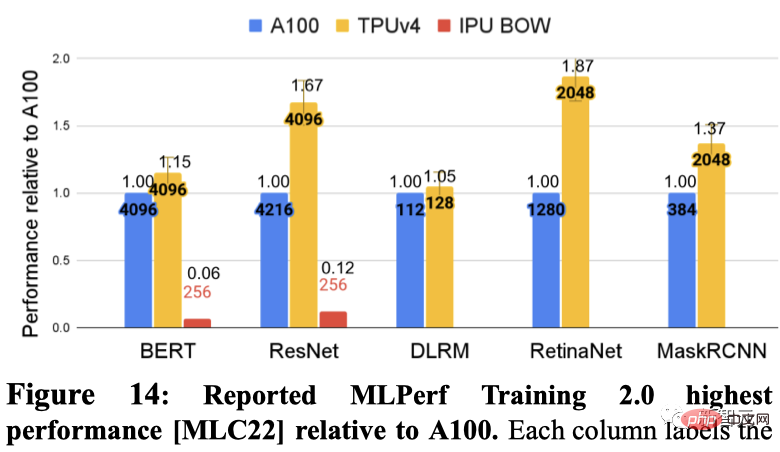

Google a démontré les performances les plus rapides de chaque DSA sur 5 benchmarks MLPerf séparément. Ceux-ci incluent BERT, ResNET, DLRM, RetinaNet et MaskRCNN.

Parmi eux, Graphcore IPU a soumis les résultats sur BERT et ResNET.

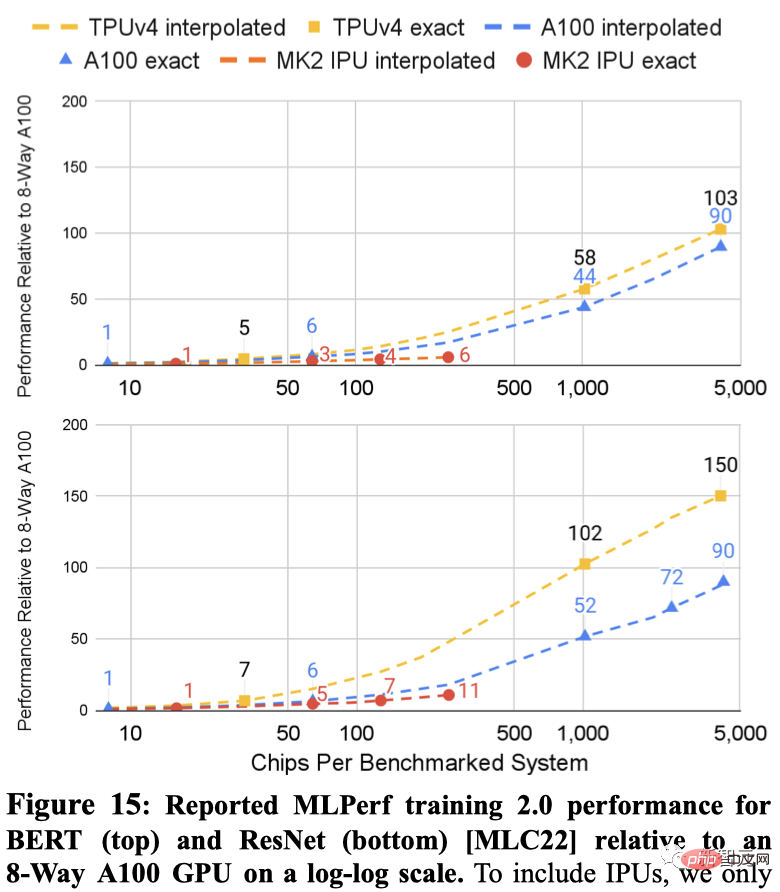

Ce qui suit montre les résultats des deux systèmes sur ResNet et BERT Les lignes pointillées entre les points sont des interpolations basées sur le nombre de chips.

Les résultats MLPerf pour les TPU v4 et A100 s'adaptent à des systèmes plus grands que l'IPU (4 096 puces contre 256 puces).

Pour des systèmes de taille similaire, TPU v4 est 1,15 fois plus rapide que l'A100 sur BERT et environ 4,3 fois plus rapide que l'IPU. Pour ResNet, TPU v4 est respectivement 1,67x et environ 4,5x plus rapide.

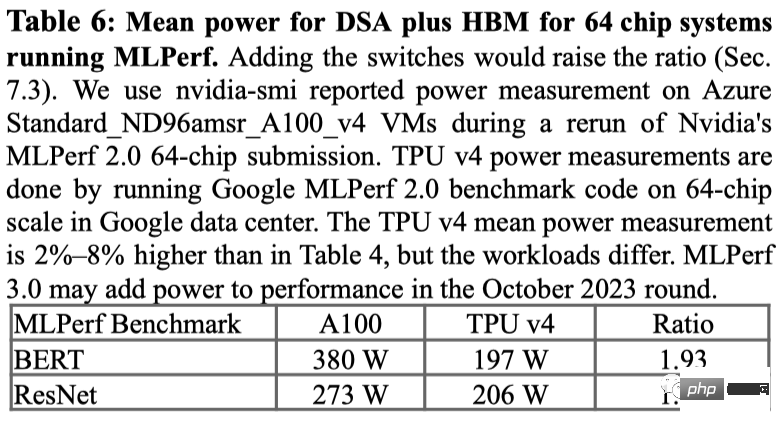

Pour la consommation d'énergie sur le benchmark MLPerf, l'A100 a utilisé en moyenne 1,3 à 1,9 fois plus d'énergie.

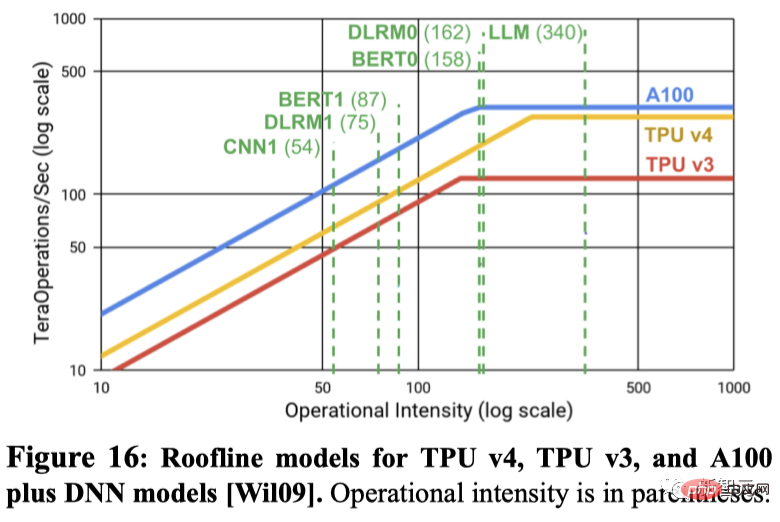

Les pics de FLOPS prédisent-ils les performances réelles ? De nombreuses personnes dans le domaine de l'apprentissage automatique pensent que le pic d'opérations en virgule flottante par seconde est un bon indicateur des performances, mais en réalité ce n'est pas le cas.

Par exemple, TPU v4 est 4,3x à 4,5x plus rapide sur deux benchmarks MLPerf que IPU Bow sur un système de même taille, bien qu'il n'ait qu'un avantage de 1,10x en termes d'opérations de pointe en virgule flottante par seconde.

Un autre exemple est que le pic d'opérations en virgule flottante par seconde de l'A100 est 1,13 fois celui du TPU v4, mais pour le même nombre de puces, le TPU v4 est 1,15 fois à 1,67 fois plus rapide.

Comme indiqué ci-dessous, le modèle Roofline est utilisé pour montrer la relation entre le pic de FLOPS/seconde et la bande passante mémoire.

Alors, la question est : pourquoi Google ne se compare-t-il pas au dernier H100 de Nvidia ?

Google a déclaré que le H100 ayant été fabriqué à l'aide d'une technologie plus récente après le lancement des puces Google, il n'a pas comparé son produit de quatrième génération avec la puce phare H100 actuelle de Nvidia.

Cependant, Google a laissé entendre qu'il développait un nouveau TPU pour concurrencer le Nvidia H100, mais n'a pas fourni de détails. Jouppi, chercheur chez Google, a déclaré dans une interview à Reuters que Google disposait d'une "ligne de production pour les futures puces".

TPU vs GPU

Pendant que ChatGPT et Bard « se battent », deux géants travaillent également dur en coulisses pour les faire fonctionner : le GPU (unité de traitement graphique) alimenté par CUDA de Nvidia et le TPU (Tensor) personnalisé de Google. unité de traitement).

En d'autres termes, il ne s'agit plus de ChatGPT contre Bard, mais de TPU contre GPU et de l'efficacité avec laquelle ils peuvent effectuer une multiplication matricielle.

En raison de son excellente conception en architecture matérielle, le GPU de NVIDIA est très adapté aux tâches de multiplication matricielle - réalisant efficacement un traitement parallèle entre plusieurs cœurs CUDA.

Ainsi, les modèles de formation sur GPU sont devenus un consensus dans le domaine du deep learning depuis 2012, et cela n'a pas changé à ce jour.

Avec le lancement de NVIDIA DGX, NVIDIA est en mesure de fournir des solutions matérielles et logicielles uniques pour presque toutes les tâches d'IA, que les concurrents ne peuvent pas fournir en raison du manque de droits de propriété intellectuelle.

En revanche, Google a lancé l'unité de traitement tensoriel (TPU) de première génération en 2016, qui comprenait non seulement un ASIC (circuit intégré spécifique à l'application) personnalisé optimisé pour le calcul tensoriel, mais ciblait également son propre framework TensorFlow. été optimisé. Cela donne également au TPU un avantage dans d'autres tâches informatiques d'IA en plus de la multiplication matricielle, et peut même accélérer les tâches de réglage fin et d'inférence.

De plus, les chercheurs de Google DeepMind ont également trouvé un moyen de créer un meilleur algorithme de multiplication matricielle : AlphaTensor.

Cependant, même si Google a obtenu de bons résultats grâce à une technologie auto-développée et à des méthodes émergentes d'optimisation informatique de l'IA, la coopération approfondie à long terme entre Microsoft et NVIDIA a simultanément élargi la portée des deux parties en tirant parti de leurs accumulations respectives. dans l’industrie.

Le TPU de quatrième génération

En 2021, lors de la conférence Google I/O, Pichai a annoncé pour la première fois la puce IA TPU v4 de dernière génération de Google.

"C'est le système le plus rapide que nous ayons jamais déployé chez Google et c'est une étape historique pour nous."

Cette amélioration est devenue le supercalculateur IA de l'entreprise. alors que les grands modèles de langage comme Bard de Google ou ChatGPT d'OpenAI ont explosé en taille des paramètres.

Cela signifie qu'ils sont bien plus grands que la capacité qu'une seule puce peut stocker, et la demande de puissance de calcul est un énorme « trou noir ».

Ces grands modèles doivent donc être répartis sur des milliers de puces, puis ces puces doivent travailler ensemble pendant des semaines, voire plus, pour entraîner le modèle.

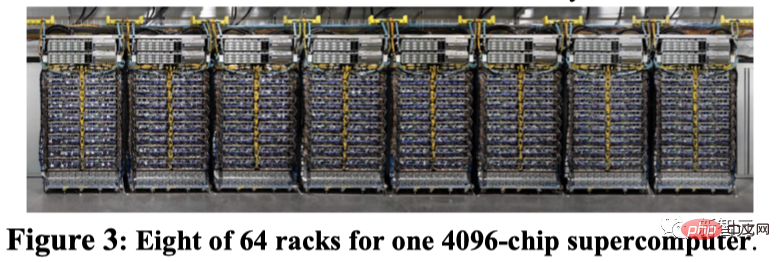

Actuellement, PaLM, le plus grand modèle de langage divulgué publiquement par Google à ce jour, compte 540 milliards de paramètres, qui ont été divisés en deux superordinateurs de 4 000 puces pour une formation en 50 jours.

Google a déclaré que son supercalculateur peut facilement reconfigurer les connexions entre les puces pour éviter les problèmes et effectuer des réglages de performances.

Le chercheur Google Norm Jouppi et l'ingénieur émérite de Google David Patterson ont écrit dans un article de blog sur le système :

"La commutation de circuits facilite le contournement des composants défaillants. Cette flexibilité nous permet même de modifier les topologies d'interconnexion ultra-informatiques. pour accélérer les performances des modèles d'apprentissage automatique.

Bien que Google ne publie que maintenant des détails sur son supercalculateur, celui-ci est présent en Oklahoma depuis 2020. Connectez-vous au centre de données du comté de Mayes.

Google a déclaré que Midjourney avait utilisé ce système pour entraîner son modèle, et la dernière version de la V5 permet à tout le monde de voir l'incroyable génération d'images.

Récemment, Pichai a déclaré dans une interview avec le New York Times que Bard serait transféré de LaMDA à PaLM.

Maintenant, avec la bénédiction du supercalculateur TPU v4, Bard ne fera que devenir plus fort.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI