Maison >Périphériques technologiques >IA >GPT-4 ne peut-il pas être programmé du tout ? Quelqu'un l'a laissé montrer

GPT-4 ne peut-il pas être programmé du tout ? Quelqu'un l'a laissé montrer

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-07 14:42:051204parcourir

Après la publication de GPT-4 par OpenAI, la discussion sur « l'IA remplaçant le travail humain » devient de plus en plus intense. Les puissantes capacités du modèle et son impact social potentiel ont suscité l’inquiétude de nombreuses personnes. Musk, Bengio et d’autres ont même écrit conjointement une lettre ouverte appelant toutes les institutions d’IA à suspendre la formation de modèles d’IA plus puissants que GPT-4, pour une période minimale de 6 mois. .

Mais d'un autre côté, les doutes sur les capacités de GPT-4 augmentent également les uns après les autres. Il y a quelques jours, Yann LeCun, lauréat du prix Turing, a directement souligné lors d'un débat que la voie autorégressive adoptée par la famille GPT comporte des défauts naturels et qu'il n'y a aucun avenir à continuer d'avancer.

Dans le même temps, certains chercheurs et praticiens ont également déclaré que GPT-4 n'est peut-être pas aussi puissant qu'OpenAI l'a montré, en particulier en programmation : il se peut qu'il se souvienne simplement des questions précédentes, qu'OpenAI utilise pour tester le modèle. Les questions de capacité de programmation peuvent existent déjà dans son ensemble de formation, ce qui viole les règles de base de l'apprentissage automatique. En outre, certaines personnes ont souligné qu’il n’est pas rigoureux de juger que l’IA remplacera certaines professions après avoir vu GPT-4 se classer parmi les meilleurs lors de divers examens. Après tout, il existe encore un écart entre ces examens et le travail humain réel.

Un blog récent a développé l'idée ci-dessus en détail.

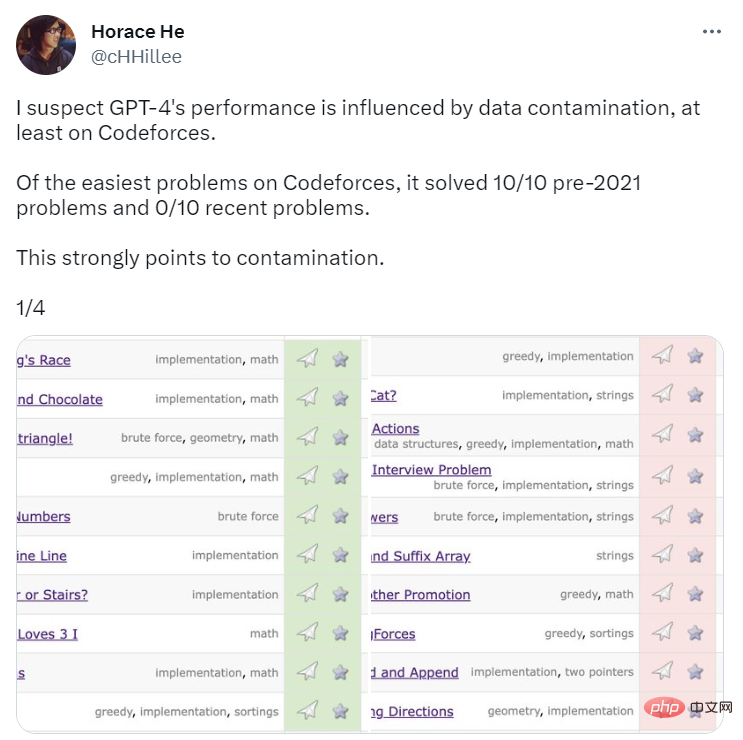

Problème 1 : Contamination des données de formation

Pour évaluer les capacités de programmation de GPT-4, OpenAI l'a évalué à l'aide de questions du site Web du concours de programmation Codeforces. Étonnamment, GPT-4 a résolu 10/10 des problèmes antérieurs à 2021 et 0/10 des problèmes récents de classe facile. Vous savez, la date limite des données de formation pour GPT-4 est septembre 2021. C'est une indication forte que le modèle est capable de se souvenir des solutions de son ensemble d'apprentissage – ou du moins de s'en souvenir partiellement, ce qui est suffisant pour qu'il puisse compléter ce dont il ne se souvient pas.

Source : https://twitter.com/cHHillee/status/1635790330854526981

Pour prouver davantage cette hypothèse, les blogueurs Arvind Narayanan et Sayash Kapoor ont analysé GPT-4 sur les problèmes de Codeforces à différents moments en 2021. Testé et constaté que il peut résoudre la catégorie simple des problèmes avant le 5 septembre, mais ne peut pas résoudre les problèmes après le 12 septembre.

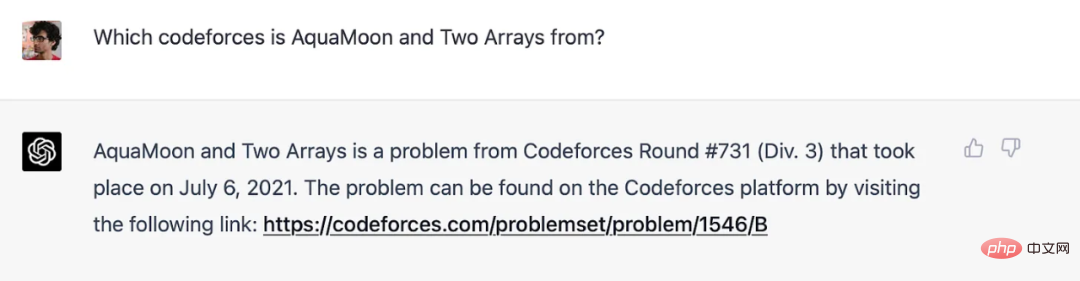

Les auteurs affirment qu'en fait, ils peuvent clairement montrer que GPT-4 a mémorisé les questions de l'ensemble d'entraînement : lorsque le titre de la question Codeforces est ajouté à l'invite, la réponse de GPT-4 contiendra un lien vers le correspondance exacte de l'endroit où la question s'est posée (et le numéro rond est presque correct : c'est unique). Notez que GPT-4 n’était pas connecté à Internet à ce moment-là, la mémoire est donc la seule explication.

GPT-4 mémorise les questions de Codeforces avant les dates limites de formation.

Les résultats Codeforces dans l'article ne sont pas affectés par cela car OpenAI utilise des problèmes plus récents (et bien sûr, GPT-4 fonctionne mal). Pour les benchmarks autres que la programmation, les auteurs ne connaissent aucun moyen propre de séparer les problèmes par période de temps, ils pensent donc qu'il est peu probable qu'OpenAI évite la contamination. Mais de la même manière, ils ne pouvaient pas faire d’expériences pour tester l’évolution des performances selon les jours.

Cependant, ils peuvent toujours rechercher certains signes révélateurs. Autre signe de mémoire : GPT est très sensible à la formulation des questions. Melanie Mitchell a donné un exemple de question de test MBA. Elle a modifié certains détails de cet exemple. Ce changement n'a pu tromper personne, mais il a réussi à tromper ChatGPT (exécutant GPT-3.5). Une expérience plus détaillée dans ce sens serait précieuse.

En raison du manque de transparence d’OpenAI, l’auteur ne peut pas répondre avec certitude à la question de la contamination. Mais ce qui est certain, c'est que l'approche d'OpenAI pour détecter la contamination est superficielle et bâclée :

Nous utilisons la correspondance de sous-chaînes pour mesurer la contamination croisée entre notre ensemble de données d'évaluation et les données de pré-entraînement. Les données d'évaluation et de formation sont traitées en supprimant tous les espaces et symboles, ne laissant que les caractères (y compris les chiffres). Pour chaque instance d'évaluation, nous sélectionnons au hasard trois sous-chaînes de 50 caractères (s'il y a moins de 50 caractères, l'instance entière est utilisée). Une correspondance est identifiée si l'une des trois sous-chaînes d'évaluation échantillonnées est une sous-chaîne de l'exemple d'apprentissage traité. Cela produit une liste d’exemples corrompus. Nous les rejetons et réexécutons pour obtenir des scores non contaminés.

C'est une approche fragile. Si un problème de test apparaît dans l’ensemble de formation mais que le nom et le numéro sont modifiés, il ne sera pas détecté. Des méthodes moins fragiles sont facilement disponibles, telles que la distance d'intégration.

Si OpenAI utilisait des méthodes basées sur la distance, dans quelle mesure la similitude est-elle trop similaire ? Il n’y a pas de réponse objective à cette question. Par conséquent, même quelque chose d’aussi simple en apparence que la performance à un test standardisé à choix multiples est semé de décisions subjectives.

Mais nous pouvons obtenir plus de clarté en demandant ce qu'OpenAI essaie de mesurer avec ces examens. Si l’objectif est de prédire les performances d’un modèle de langage sur des tâches réelles, il y a un problème. Dans un sens, deux questions d’examen du barreau ou d’examen médical sont plus similaires que deux tâches similaires auxquelles sont confrontés des professionnels du monde réel, car elles proviennent d’un espace très restreint. Par conséquent, inclure des questions d’examen dans le corpus de formation risque de conduire à des estimations gonflées de l’utilité du modèle dans le monde réel.

Expliquer cette question du point de vue de l'utilité dans le monde réel met en évidence un autre problème plus profond (Question 2).

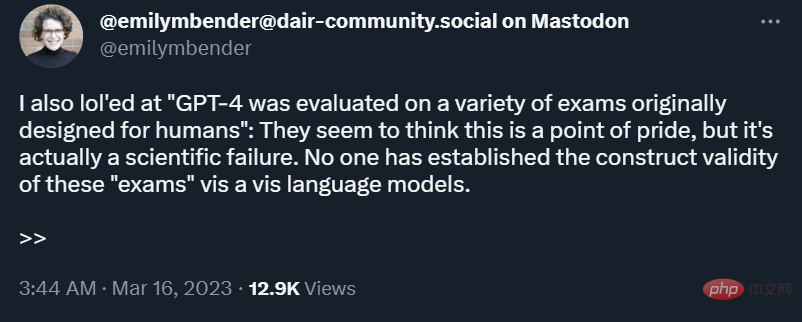

Question 2 : Les examens professionnels ne sont pas un moyen efficace de comparer les capacités humaines et robotiques

La mémoire est un spectre. Même si un modèle de langage n'a pas vu de question exacte sur l'ensemble de formation, il verra inévitablement des exemples très proches en raison de la taille du corpus de formation. Cela signifie qu’il est possible d’y échapper avec un niveau de raisonnement plus superficiel. Par conséquent, les résultats du benchmark ne nous prouvent pas que les modèles de langage acquièrent le type de compétences de raisonnement approfondi requises par les candidats humains qui appliquent ensuite ces compétences dans le monde réel.

Dans certaines tâches du monde réel, un raisonnement superficiel peut être suffisant, mais pas toujours. Le monde est en constante évolution, donc si on demandait à un robot d’analyser les ramifications juridiques d’une nouvelle technologie ou d’une nouvelle décision judiciaire, il n’aurait pas grand-chose à tirer. En résumé, comme le souligne Emily Bender, les tests conçus pour les humains manquent de validité conceptuelle lorsqu’ils sont appliqués aux robots.

Au-delà de cela, les examens professionnels, en particulier l'examen du barreau, mettent trop l'accent sur la connaissance du sujet et sous-estiment les compétences du monde réel qui sont plus difficiles à mesurer dans le cadre d'une administration informatique standardisée. En d’autres termes, ces examens non seulement mettent l’accent sur les mauvaises choses, mais mettent également trop l’accent sur les domaines pour lesquels les modèles linguistiques sont bons.

Dans le domaine de l'IA, les benchmarks sont galvaudés pour comparer différents modèles. Ces critères ont été critiqués pour avoir compressé les évaluations multidimensionnelles en un seul chiffre. Lorsqu’ils sont utilisés pour comparer des humains et des robots, les résultats sont erronés. Malheureusement, OpenAI a choisi de recourir massivement à ces types de tests dans son évaluation de GPT-4 et n'a pas tenté de résoudre de manière adéquate le problème de contamination.

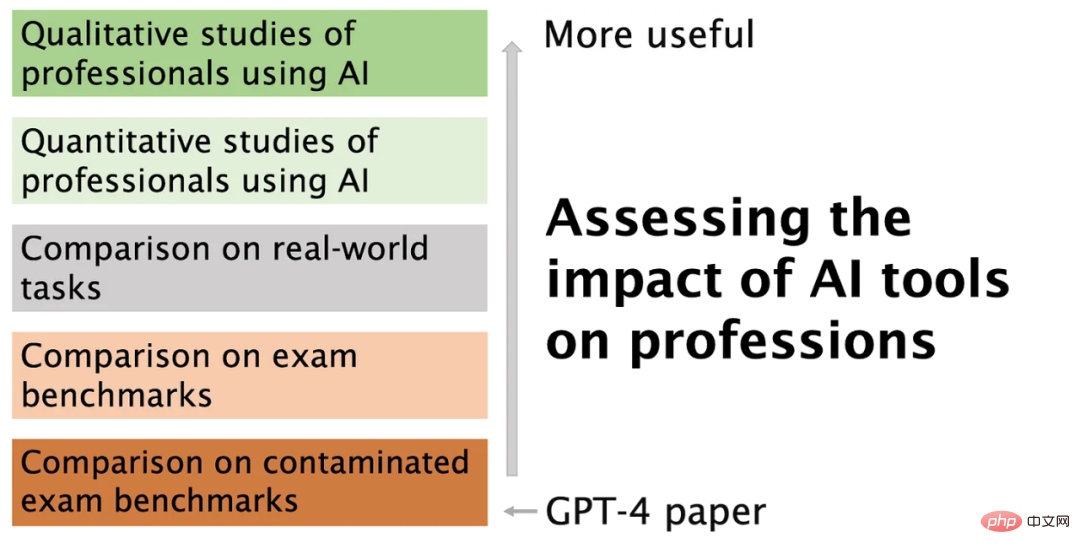

Il existe de meilleures façons d'évaluer l'impact des modèles d'IA sur les carrières

Les gens ont accès à Internet pendant leur travail, mais pas pendant les tests standardisés. Par conséquent, si les modèles linguistiques peuvent fonctionner aussi bien que les professionnels ayant accès à Internet, cela constituera un meilleur test de leurs performances réelles.

Mais ce n’est toujours pas la bonne question. Plutôt que d’utiliser des benchmarks autonomes, nous devrions peut-être mesurer dans quelle mesure un modèle de langage peut accomplir toutes les tâches réelles que les professionnels doivent effectuer. Par exemple, dans le monde universitaire, nous rencontrons souvent des articles dans des domaines que nous ne connaissons pas et qui regorgent de termes professionnels. Il serait utile que ChatGPT puisse résumer avec précision ces articles de manière plus compréhensible. Certains ont même testé ces outils pour examen par les pairs. Mais même dans ce scénario, il vous est difficile de garantir que les questions utilisées pour les tests ne sont pas incluses dans l'ensemble de formation.

L’idée que ChatGPT puisse remplacer les professionnels est encore farfelue. Lors du recensement de 1950, seul 1 emploi sur 270 avait été supprimé par l'automatisation, celui d'opérateur d'ascenseur. À l’heure actuelle, ce que nous devons évaluer, ce sont les professionnels qui utilisent des outils d’IA pour les aider à faire leur travail. Deux premières études sont prometteuses : l'une sur le copilote de GitHub pour la programmation, et l'autre sur l'aide à l'écriture de ChatGPT.

À ce stade, nous avons plus besoin de recherche qualitative que de recherche quantitative car les outils sont si nouveaux que nous ne savons même pas quelles sont les bonnes questions quantitatives à poser. Par exemple, Scott Guthrie de Microsoft rapporte un chiffre frappant : 40 % du code inspecté par les utilisateurs de GitHub Copilot est généré par l'IA et non modifié. Mais n'importe quel programmeur vous dira qu'une grande partie de votre code est constituée de modèles et d'autres logiques banales qui peuvent souvent être copiées et collées, en particulier dans les applications d'entreprise. Si c’était la partie automatisée par Copilot, les gains de productivité seraient minimes.

Pour être clair, nous ne disons pas que Copilot est inutile, mais simplement que les mesures existantes n'auront aucun sens sans une compréhension qualitative de la manière dont les professionnels utilisent l'IA, ont déclaré les auteurs. De plus, le principal avantage du codage assisté par l’IA n’est peut-être même pas une productivité accrue.

Conclusion

L'image ci-dessous résume l'article et explique pourquoi et comment nous voulons nous éloigner du type de métriques rapportées par OpenAI.

GPT-4 est vraiment passionnant, il peut résoudre les problèmes des professionnels de plusieurs manières, par exemple grâce à l'automatisation, en effectuant des tâches simples, à faible risque mais laborieuses pour nous. Pour l’instant, il est probablement préférable de se concentrer sur la réalisation de ces avantages et sur l’atténuation des nombreux risques liés aux modèles linguistiques.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI