Maison >Périphériques technologiques >IA >Un remplacement de ChatGPT qui peut être exécuté sur un ordinateur portable est ici, avec un rapport technique complet en pièce jointe

Un remplacement de ChatGPT qui peut être exécuté sur un ordinateur portable est ici, avec un rapport technique complet en pièce jointe

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBavant

- 2023-04-04 12:15:131203parcourir

GPT4All est un chatbot formé sur la base d'une grande quantité de données d'assistant propres (y compris du code, des histoires et des conversations). Les données comprennent environ 800 000 éléments de données générées par GPT-3.5-Turbo. Il est complété sur la base de LLaMa et peut fonctionner sur M1. Mac, Windows et autres environnements. Comme son nom l’indique, le moment est peut-être venu où tout le monde peut utiliser le GPT personnel.

Depuis qu'OpenAI a publié ChatGPT, les chatbots sont devenus de plus en plus populaires ces derniers mois.

Bien que ChatGPT soit puissant, il est presque impossible pour OpenAI de l'ouvrir en source. De nombreuses personnes travaillent sur l'open source, comme LLaMA, qui a été open source par Meta il y a quelque temps. Il s'agit d'un terme général désignant une série de modèles avec des quantités de paramètres allant de 7 milliards à 65 milliards. Parmi eux, le modèle LLaMA à 13 milliards de paramètres peut surpasser le paramètre GPT-3 à 175 milliards « sur la plupart des benchmarks ».

L'open source de LLaMA a profité à de nombreux chercheurs. Par exemple, Stanford a ajouté le réglage des instructions à LLaMA et formé un nouveau modèle de 7 milliards de paramètres appelé Alpaca (basé sur LLaMA 7B). Les résultats montrent que les performances d'Alpaca, un modèle léger avec seulement 7 paramètres B, sont comparables à des modèles de langage à très grande échelle tels que GPT-3.5.

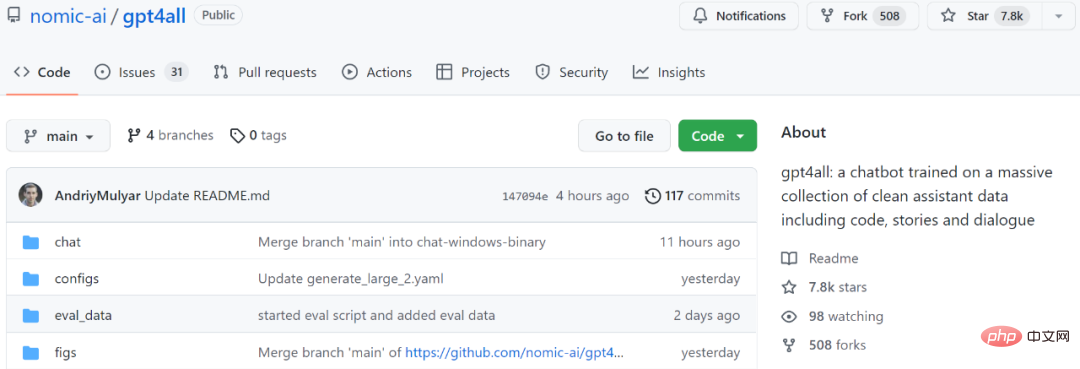

Pour un autre exemple, le modèle que nous allons présenter ensuite, GPT4All, est également un nouveau modèle de langage 7B basé sur LLaMA. Deux jours après le lancement du projet, le nombre d'étoiles a dépassé les 7,8k.

Adresse du projet : https://github.com/nomic-ai/gpt4all

En termes simples, GPT4All est formé sur 800 000 éléments de données de GPT-3.5-Turbo, y compris des questions textuelles, des descriptions d'histoires, etc. Tournez le dialogue et le code.

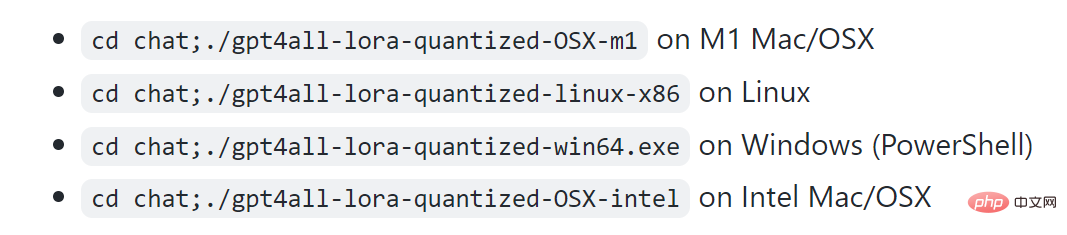

Selon le projet, M1 peut fonctionner sous Mac, Windows et d'autres environnements.

Jetons d'abord un coup d'œil à l'effet. Comme le montre la figure ci-dessous, les utilisateurs peuvent communiquer avec GPT4All sans aucune barrière, par exemple en demandant au modèle : « Puis-je exécuter un grand modèle de langage sur un ordinateur portable ? » La réponse de GPT4All est : « Oui, vous pouvez utiliser un ordinateur portable pour vous entraîner et testez des réseaux de neurones ou des modèles d'apprentissage automatique pour d'autres langues naturelles (comme l'anglais ou le chinois). Surtout, vous avez besoin de suffisamment de mémoire disponible (RAM) pour s'adapter à la taille de ces modèles..."

Ensuite, si vous ne le faites pas). Si vous ne savez pas exactement de quelle quantité de mémoire vous avez besoin, vous pouvez également continuer à demander à GPT4All, et il vous donnera ensuite une réponse. À en juger par les résultats, la capacité de GPT4All à mener plusieurs cycles de dialogue est toujours très forte.

Échantillonnage en temps réel sur Mac M1

Certaines personnes appellent cette recherche "un changement de jeu. Avec la bénédiction de GPT4All, vous pouvez désormais exécuter GPT localement sur MacBook."

Similaire à GPT-4, GPT4All fournit également un « rapport technique ».

Adresse du rapport technique : https://s3.amazonaws.com/static.nomic.ai/gpt4all/2023_GPT4All_Technical_Report.pdf

Ce rapport technique préliminaire décrit brièvement les détails de construction de GPT4All. Les chercheurs ont divulgué les données collectées, les procédures de traitement des données, le code de formation et les poids finaux du modèle pour promouvoir la recherche ouverte et la reproductibilité. Ils ont également publié une version quantifiée 4 bits du modèle, ce qui signifie que presque tout le monde peut exécuter le modèle sur un processeur.

Ensuite, voyons ce qui est écrit dans ce rapport.

Rapport technique GPT4All

1. Collecte et tri des données

Du 20 mars 2023 au 26 mars 2023, les chercheurs ont utilisé l'API GPT-3.5-Turbo OpenAI pour collecter environ 1 million de paires de réponses aux invites.

Tout d’abord, les chercheurs ont collecté différents échantillons de questions/invites en exploitant trois ensembles de données accessibles au public :

- Sous-ensemble chip2 unifié de LAION OIG

- Un ensemble de sous-échantillons aléatoires de questions de codage de questions Stackoverflow

- Ensemble de sous-échantillons Bigscience/P3 pour le réglage des instructions

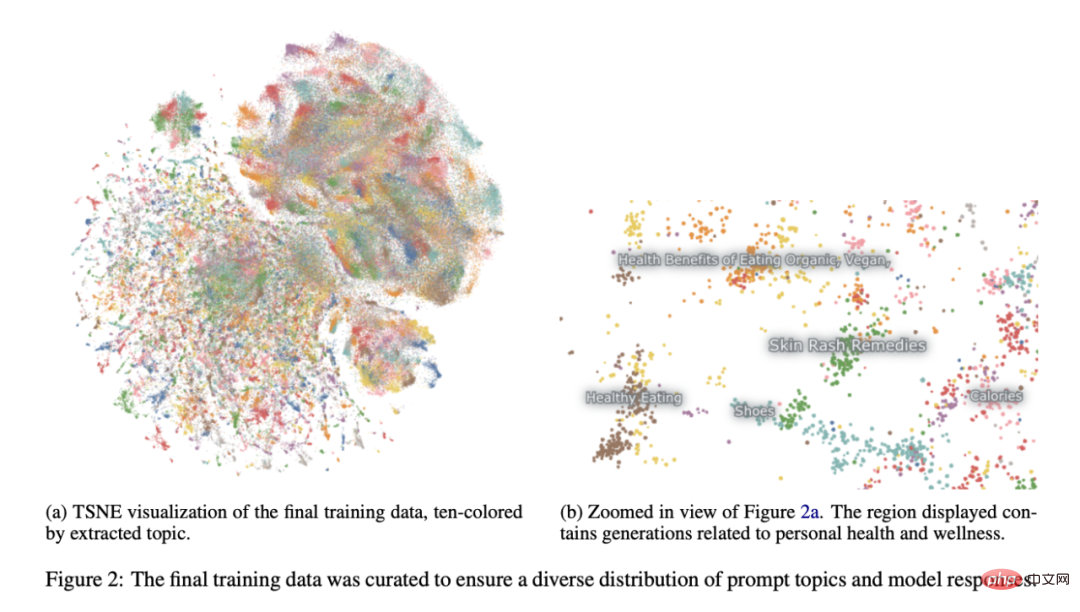

Reportez-vous au projet Alpaca de l'Université de Stanford (Taori et al., 2023), les chercheurs ont payé des sommes considérables attention à la préparation et à la conservation des données. Après avoir collecté l'ensemble de données initial de paires générées par des invites, ils ont chargé les données dans Atlas pour les organiser et les nettoyer, en supprimant tous les échantillons dans lesquels GPT-3.5-Turbo n'a pas répondu aux invites et a produit une sortie mal formée. Cela réduit le nombre total d’échantillons à 806 199 paires générées par des invites de haute qualité. Ensuite, nous avons supprimé l'intégralité du sous-ensemble Bigscience/P3 de l'ensemble de données de formation final, car sa diversité de sortie était très faible. P3 contient de nombreuses invites homogènes qui génèrent des réponses courtes et homogènes de GPT-3.5-Turbo.

Cette méthode d'élimination a abouti à un sous-ensemble final de 437 605 paires générées par des invites, comme le montre la figure 2.

Formation de modèles

Les chercheurs ont affiné plusieurs modèles dans une instance de LLaMA 7B (Touvron et al., 2023). Le modèle associé à leur première diffusion publique a été formé avec LoRA (Hu et al., 2021) en 4 époques sur 437 605 exemples post-traités. Les hyperparamètres détaillés du modèle et le code de formation peuvent être trouvés dans la bibliothèque de ressources appropriée et dans les journaux de formation du modèle.

Reproductibilité

Les chercheurs ont publié toutes les données (y compris les générations P3 inutilisées), le code de formation et les poids du modèle afin que la communauté puisse les reproduire. Les chercheurs intéressés peuvent trouver les dernières données, les détails de la formation et les points de contrôle dans le référentiel Git.

Coût

Il a fallu environ quatre jours aux chercheurs pour construire ces modèles, et le coût du GPU était de 800 $ (loué auprès de Lambda Labs et Paperspace, y compris plusieurs formations ayant échoué), plus 500 $ de frais supplémentaires pour l'API OpenAI.

Le modèle final publié, gpt4all-lora, peut être formé en 8 heures environ sur le DGX A100 8x 80 Go de Lambda Labs, pour un coût total de 100 $.

Ce modèle peut être exécuté sur un ordinateur portable ordinaire. Comme l'a dit un internaute : "Il n'y a aucun coût sauf la facture d'électricité." Une évaluation préliminaire du modèle a été réalisée sur des données d'évaluation humaine. Le rapport compare également la perplexité de ce modèle en matière de vérité terrain avec le modèle public d'alpaga-lora le plus connu (contribué par l'utilisateur de huggingface chainyo). Ils ont constaté que tous les modèles présentaient de très grandes perplexités sur un petit nombre de tâches et rapportaient des perplexités allant jusqu'à 100. Les modèles affinés sur cet ensemble de données collectées ont montré une perplexité moindre dans l'évaluation de l'auto-instruction par rapport à Alpaca. Les chercheurs affirment que cette évaluation n'est pas exhaustive et qu'il y a encore place à une évaluation plus approfondie - ils invitent les lecteurs à exécuter le modèle sur un processeur local (documentation disponible sur Github) et à obtenir une compréhension qualitative de ses capacités.

Enfin, il est important de noter que les auteurs ont publié des données et des détails de formation dans l'espoir que cela accélérera la recherche ouverte LLM, notamment dans les domaines de l'alignement et de l'interprétabilité. Les poids et données des modèles GPT4All sont uniquement destinés à des fins de recherche et sont sous licence contre toute utilisation commerciale. GPT4All est basé sur LLaMA, qui dispose d'une licence non commerciale. Les données de l'assistant ont été collectées à partir du GPT-3.5-Turbo d'OpenAI, dont les conditions d'utilisation interdisent le développement de modèles qui concurrencent commercialement OpenAI.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI