Maison >Périphériques technologiques >IA >Le gars de Hangzhou Electronics est le premier à bénéficier de la fonction de lecture d'images GPT. Une seule carte peut réaliser le nouveau SOTA. Le code est open source.

Le gars de Hangzhou Electronics est le premier à bénéficier de la fonction de lecture d'images GPT. Une seule carte peut réaliser le nouveau SOTA. Le code est open source.

- 青灯夜游avant

- 2023-03-31 22:42:151957parcourir

Cet article a été accepté par CVPR2023.

GPT-4, capable de lire les images, est sorti ! Mais il faut faire la queue pour l'utiliser. . .

Pourquoi ne pas essayer ceci d'abord~

Ajoutez un petit modèle, vous pouvez créer de grands modèles de langage tels que ChatGPT et GPT-3 qui ne peuvent comprendre facilement que le texte lire les images, et toutes sortes de détails délicats peuvent être résolus Capable de pincer d'une seule main.

Et l'entraînement de ce petit modèlepeut se faire avec une seule carte (une RTX 3090).

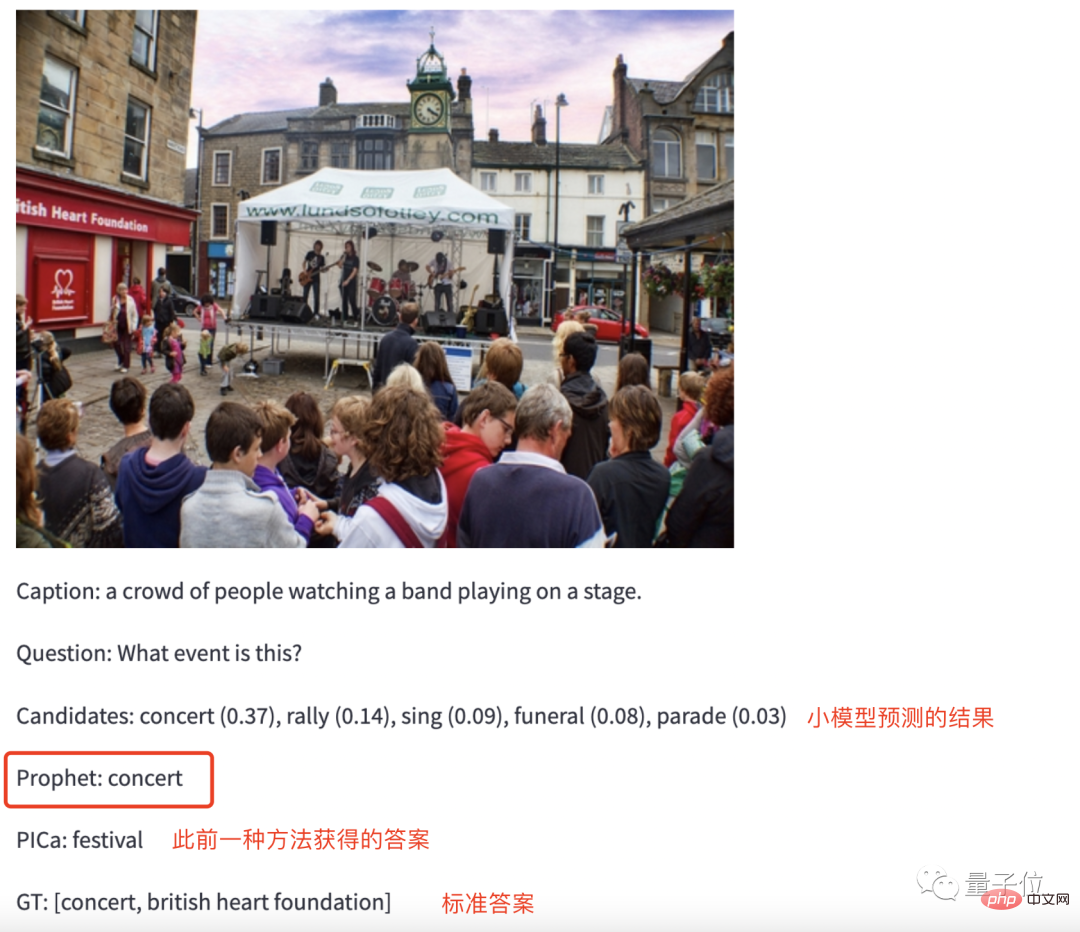

Pour l'effet, il suffit de regarder la photo.

Par exemple, saisissez une image d'une « scène musicale » dans le GPT-3 formé et demandez-lui : Quelles activités ont lieu sur la scène ?

Sans aucune hésitation, GPT-3 a donné la réponse à Concert.

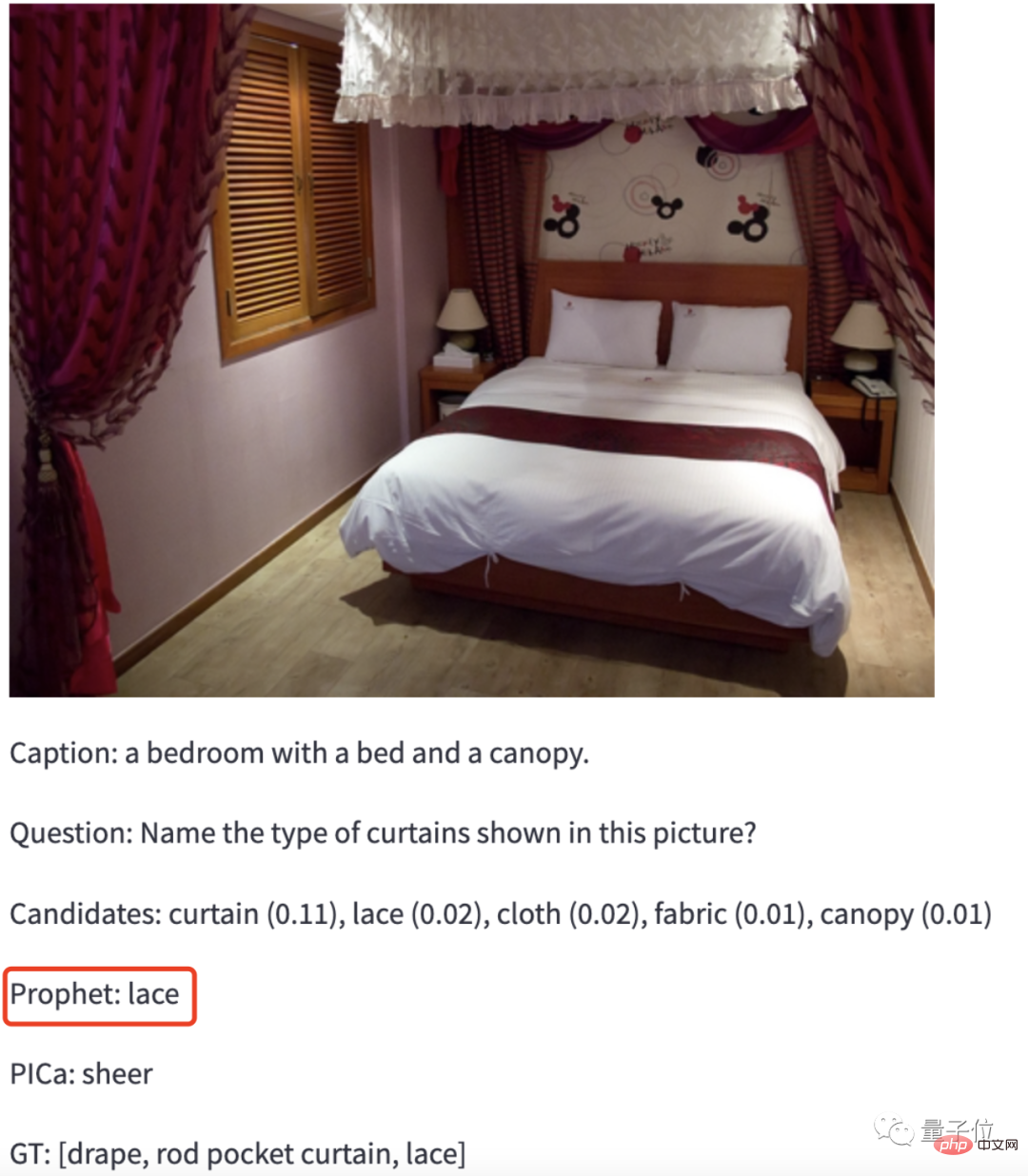

Pour rendre les choses un peu plus difficiles, donnez à GPT-3 une photo de Jiang Zi et laissez-le identifier de quel type de matériau est le rideau sur la photo.

GPT-3 : Dentelle.

Bingo ! (On dirait qu'il y a quelque chose sur lui)

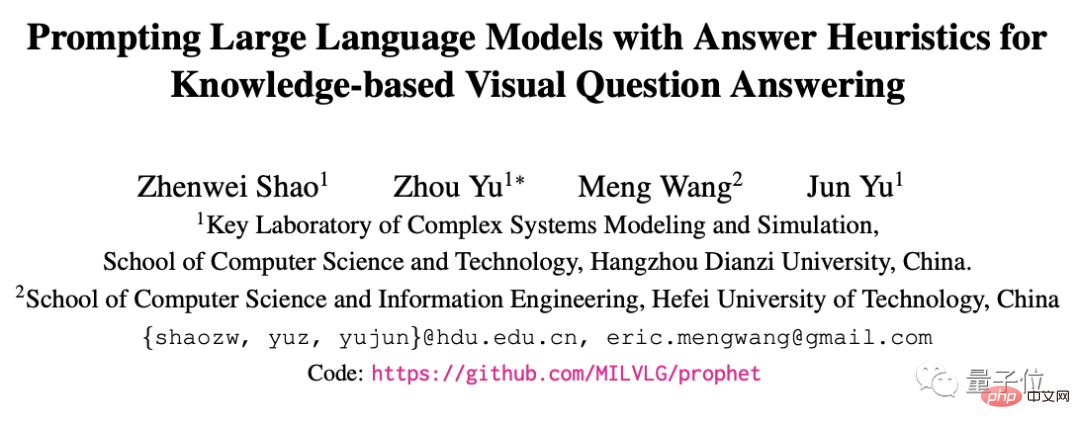

Cette méthode est la dernière réalisation d'une équipe de l'Université des sciences et technologies électroniques de Hangzhou et de l'Université de technologie de Hefei : Prophet Ils ont commencé ce travail il y a six mois.

Le premier auteur de l'article est Shao Zhenwei, un étudiant diplômé de l'Université Dianzi de Hangzhou. On lui a diagnostiqué une « atrophie musculaire spinale progressive » à l'âge d'un an. Il a malheureusement raté l'Université du Zhejiang lors de l'examen d'entrée à l'université et a choisi Hangzhou. Université des sciences et technologies électroniques, proche de chez moi.

Cet article a été accepté par CVPR2023.

Réalisation d'un nouveau SOTA dans les tâches multimodales

Sans plus tarder, examinons directement les capacités de lecture d'images de GPT-3 avec le support de la méthode Prophet.

Jetons d’abord un coup d’œil à ses résultats de tests sur l’ensemble de données.

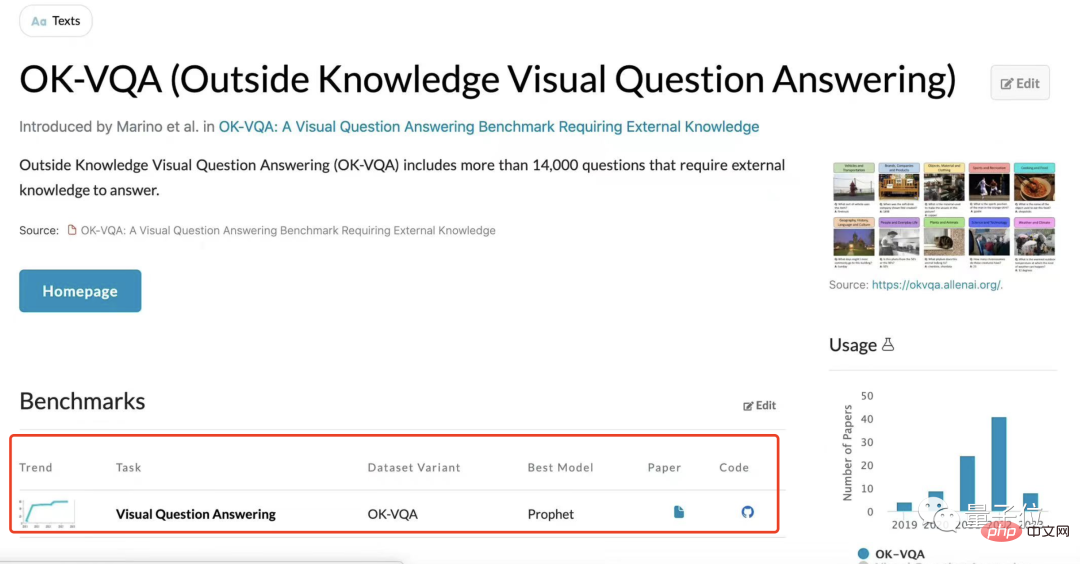

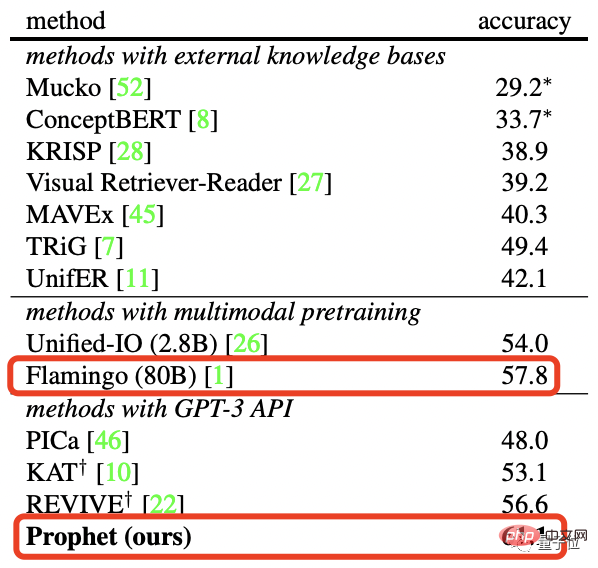

L'équipe de recherche a testé Prophet sur deux ensembles de données visuelles de questions et réponses basées sur des connaissances externes, OK-VQA et A-OKVQA, et tous deux ont créé un nouveau SOTA.

Plus précisément, sur l'ensemble de données OK-VQA, comparé au grand modèle Flamingo de Deepmind avec des paramètres 80B, Prophet a atteint une précision de 61,1 %, battant avec succès Flamingo (57,8 %).

Et en termes de ressources de puissance de calcul requises, Prophet « bat » également Flamingo.

Flamingo-80B doit être formé 15 jours sur des 1536 cartes graphiques TPUv4, tandis que Prophet n'a besoin que de une carte graphique RTX-3090 pour entraîner le modèle VQA 4 jours, puis appeler l'API OpenAI un un certain nombre de fois.

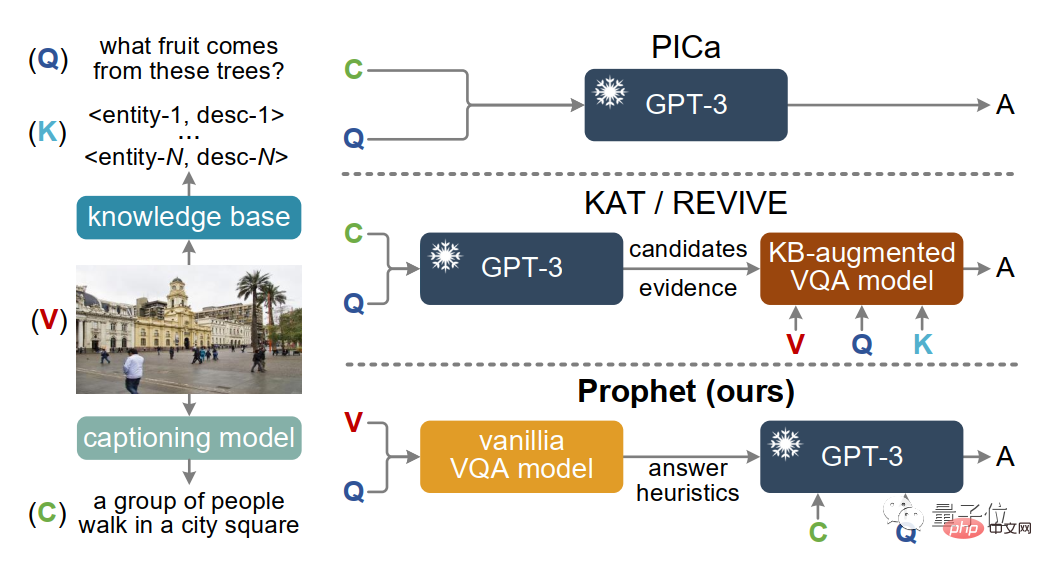

En fait, des méthodes comme Prophet ont déjà été utilisées pour aider GPT-3 à gérer des tâches intermodales, telles que PICa, et plus tard KAT et REVIVE.

Cependant, ils peuvent ne pas être satisfaisants dans la gestion de certains détails.

Donnez-moi une châtaigne, laissez-les lire ensemble l'image ci-dessous, puis répondez à la question : Quel genre de fruit l'arbre sur l'image portera-t-il ?

La seule information extraite de la photo par PICa, KAT et REVIVE est : un groupe de personnes marchant sur la place, ignorant complètement qu'il y a un cocotier derrière. La réponse finale ne peut être que devinée.

Avec Prophet, cette situation ne se produira pas. Cela résout le problème de l'insuffisance des informations d'image extraites par la méthode ci-dessus et stimule davantage le potentiel de GPT-3.

Alors, comment le Prophète fait-il ?

Petit modèle + grand modèle

Extraire efficacement les informations et répondre aux questions avec précision s'appuie sur son cadre unique unique pour pouvoir le faire.

Ces deux étapes ont également une division claire du travail :

- Phase 1 : Donnez des réponses éclairantes basées sur les questions ;

- Phase 2 : Ces réponses limiteront la portée pour donner à GPT-3 suffisamment de marge pour réaliser son potentiel.

Tout d'abord, dans la première étape, l'équipe de recherche a formé un modèle MCAN amélioré (un modèle VQA) par rapport à un ensemble de données VQA de connaissances externes spécifiques.

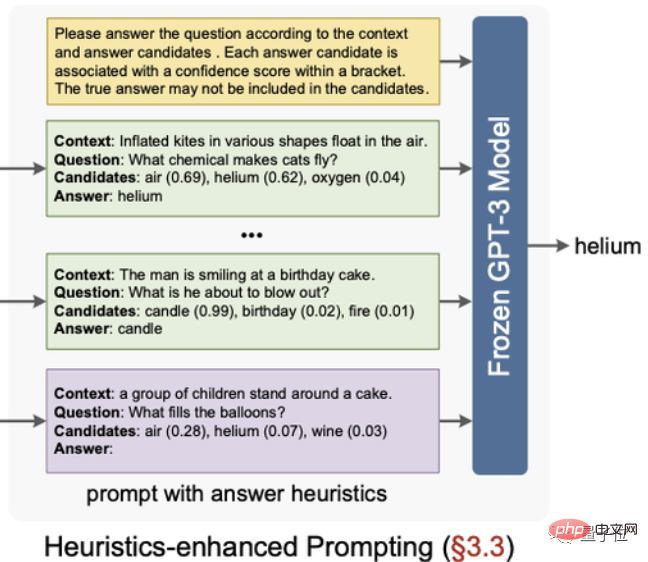

Après avoir entraîné le modèle, extrayez-en deux réponses heuristiques : des candidats aux réponses et des exemples sensibles aux réponses.

Parmi eux, les réponses candidates sont triées en fonction du niveau de confiance obtenu par la couche de classification du modèle, et les 10 premiers sont sélectionnés.

Exemple de sensibilisation aux réponses fait référence à l'utilisation des fonctionnalités situées avant la couche de classification du modèle comme fonctionnalités de réponse potentielles de l'échantillon, l'échantillon étiqueté le plus similaire dans cet espace de fonctionnalités.

La prochaine étape est la deuxième étape. Cette étape est relativement simple et grossière.

Organisez les « réponses inspirantes » obtenues à l'étape précédente en invites, puis saisissez les invites dans GPT-3 et complétez les questions visuelles et répondez aux questions sous certaines invites.

Cependant, bien que quelques indices de réponse aient été donnés à l'étape précédente, cela ne signifie pas que GPT-3 se limitera à ces réponses.

Si la confiance dans la réponse donnée par l'invite est trop faible ou si la bonne réponse ne figure pas parmi ces invites, il est tout à fait possible que GPT-3 génère une nouvelle réponse.

Équipe de recherche

Bien entendu, outre les résultats de la recherche, il faut également mentionner l'équipe à l'origine de cette étude.

Le premier auteurShao Zhenwei a reçu un diagnostic d'amyotrophie spinale progressive lorsqu'il avait 1 an. Il s'agit d'un handicap de premier niveau des membres. Il n'a pas la capacité de prendre soin de lui-même. soin de sa mère pour la vie et les études.

Cependant, malgré ses limitations physiques, la soif de connaissances de Shao Zhenwei ne s'est pas affaiblie.

Lors de l'examen d'entrée à l'université de 2017, il a obtenu un score élevé de 644 points et a été admis à la majeure en informatique de l'Université des sciences et technologies électroniques de Hangzhou avec la première place.

Au cours de cette période, il a également remporté des distinctions telles que l'Étoile d'auto-amélioration des étudiants chinois 2018, la bourse nationale 2020 et le Diplômé exceptionnel de la province du Zhejiang 2021.

Au cours de ses études de premier cycle, Shao Zhenwei avait déjà commencé à mener des activités de recherche scientifique avec le professeur Yu Zhou.

En 2021, Shao Zhenwei a eu une rencontre fortuite avec l'Université du Zhejiang alors qu'il se préparait à être promu aux études supérieures, il est donc resté à l'école et a rejoint le groupe de recherche du professeur Yu Zhou pour poursuivre une maîtrise. Il est actuellement en deuxième année. année d'études supérieures, et sa direction de recherche est l'apprentissage intermodal.

Le professeur Yu Zhou est le deuxième auteur et auteur correspondant de ce document de recherche. Il est le plus jeune professeur de l'École d'informatique de l'Université de Hangzhou Dianping et directeur adjoint du laboratoire « Modélisation et simulation de systèmes complexes ». Ministère de l'Éducation.

Depuis longtemps, Yu Zhou s'est spécialisé dans la direction intelligence multimodale et a conduit l'équipe de recherche à remporter à plusieurs reprises la première et la deuxième place du défi international de réponses visuelles aux questions VQA Challenge.

La plupart des membres de l'équipe de recherche se trouvent au Hangzhou Electronics Media Intelligence Laboratory (MIL).

Le laboratoire est dirigé par le professeur Yu Jun, un universitaire national exceptionnel. Ces dernières années, le laboratoire a publié une série d'articles de conférences de haut niveau (TPAMI, IJCV, CVPR, etc.) axés sur l'apprentissage multimodal, et a remporté à plusieurs reprises le meilleur prix lors des conférences de revues IEEE.

Le laboratoire a accueilli plus de 20 projets nationaux tels que le plan national clé de R&D et la Fondation nationale des sciences naturelles de Chine. Il a remporté le premier prix du prix provincial des sciences naturelles du Zhejiang et le deuxième prix du prix éducatif des sciences naturelles.

Ce qui précède est le contenu détaillé de. pour plus d'informations, suivez d'autres articles connexes sur le site Web de PHP en chinois!

Articles Liés

Voir plus- Tendances technologiques à surveiller en 2023

- Comment l'intelligence artificielle apporte un nouveau travail quotidien aux équipes des centres de données

- L'intelligence artificielle ou l'automatisation peuvent-elles résoudre le problème de la faible efficacité énergétique des bâtiments ?

- Co-fondateur d'OpenAI interviewé par Huang Renxun : les capacités de raisonnement de GPT-4 n'ont pas encore atteint les attentes

- Bing de Microsoft surpasse Google en termes de trafic de recherche grâce à la technologie OpenAI